一、初识 LangChain:架构、应用与开发环境部署

在大模型时代,光有强大的 LLM 还不够,如何让模型动起来、用起来才是关键。LangChain 正是为此而生的利器。它像是一座桥,把语言模型和真实世界连接起来——能调用外部 API、访问数据库、记住上下文,还能像人一样规划任务。无论你想做智能问答、自动化助手,还是企业级 RAG 系统,LangChain 都能让复杂的 AI 应用开发变得像“搭积木”一样简单、高效。

随着大型语言模型技术的飞速发展,如何高效地构建基于这些强大模型的复杂、可交互的应用,成为了开发者的核心挑战。LangChain应运而生,它不仅仅是一个简单的 API 封装,而是一个功能强大的开源框架,旨在简化和加速 LLM 驱动的应用程序的开发。

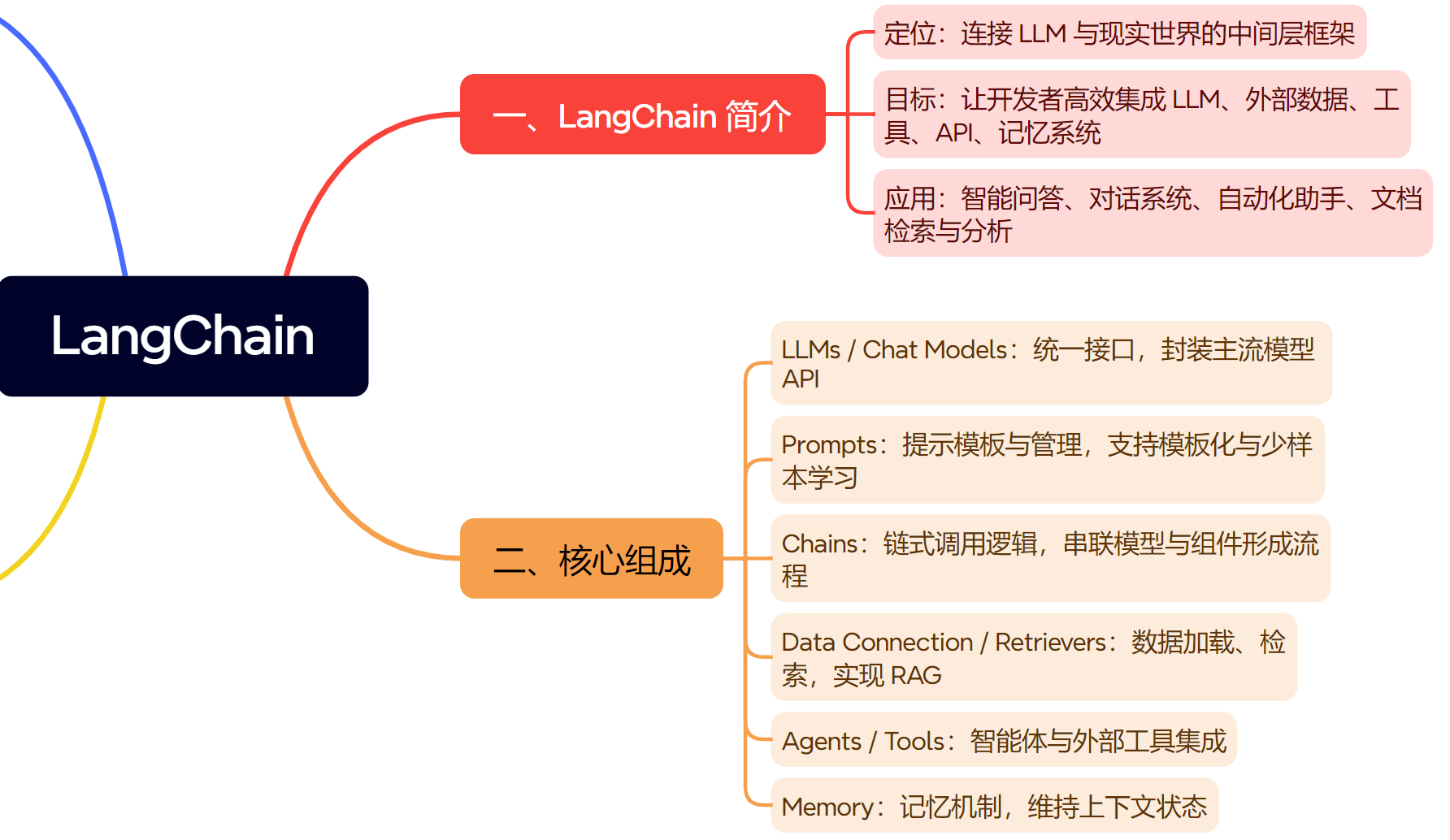

思维导图

一、LangChain 简介

LangChain 是一个用于构建基于大型语言模型的应用框架。它的核心目标是帮助开发者更高效地将 LLM 与外部数据、工具、API、记忆系统结合,从而实现智能化、可交互的应用,如智能问答、对话系统、自动化助手、文档检索与分析系统等。一句话总结,LangChain 是连接 LLM 与现实世界的“中间层”框架。

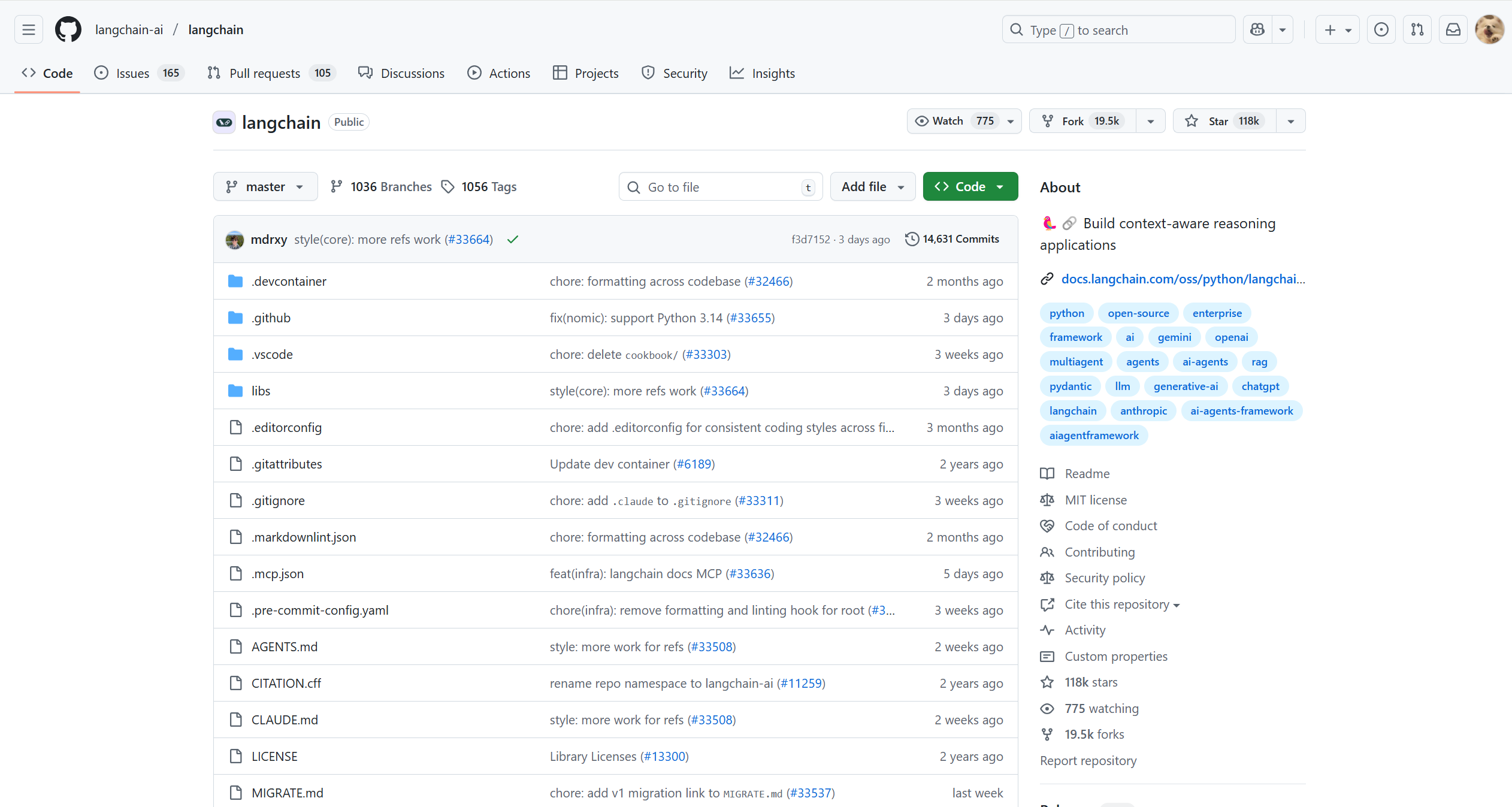

GitHub 官方仓库: https://github.com/langchain-ai/langchain

官方文档: https://docs.langchain.com/

二、LangChain 的核心组成

LangChain 的整体架构可以分为以下六个主要模块,它们协同工作,构成了一个完整的 LLM 应用开发工具链。

| 核心模块 | 简介 | 作用 |

|---|---|---|

| LLMs / Chat Models | 语言模型的统一接口。 | 封装各类 LLM/聊天模型 (如OpenAI, HuggingFace) 的 API,提供标准化的调用方式。 |

| Prompts | 提示模板与管理。 | 动态构建和管理输入给 LLM 的提示,支持模板化和少量示例学习 (Few-shot)。 |

| Chains | 链式调用逻辑。 | 将多个 LLM 调用或与其他组件的调用串联起来,形成一个连贯的处理流程。 |

| Data Connection / Retrievers | 数据连接器与检索器。 | 负责加载、转换、存储和检索外部数据,是实现 RAG (检索增强生成) 的关键。 |

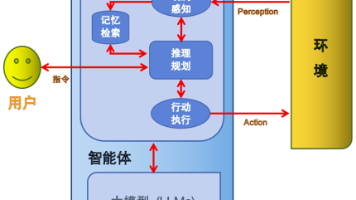

| Agents / Tools | 智能体与工具。 | 赋予 LLM 决策能力和使用外部工具 (如搜索引擎、计算器、API) 的能力。 |

| Memory | 记忆机制。 | 在链或智能体的多次调用之间持久化状态,实现对话的上下文记忆。 |

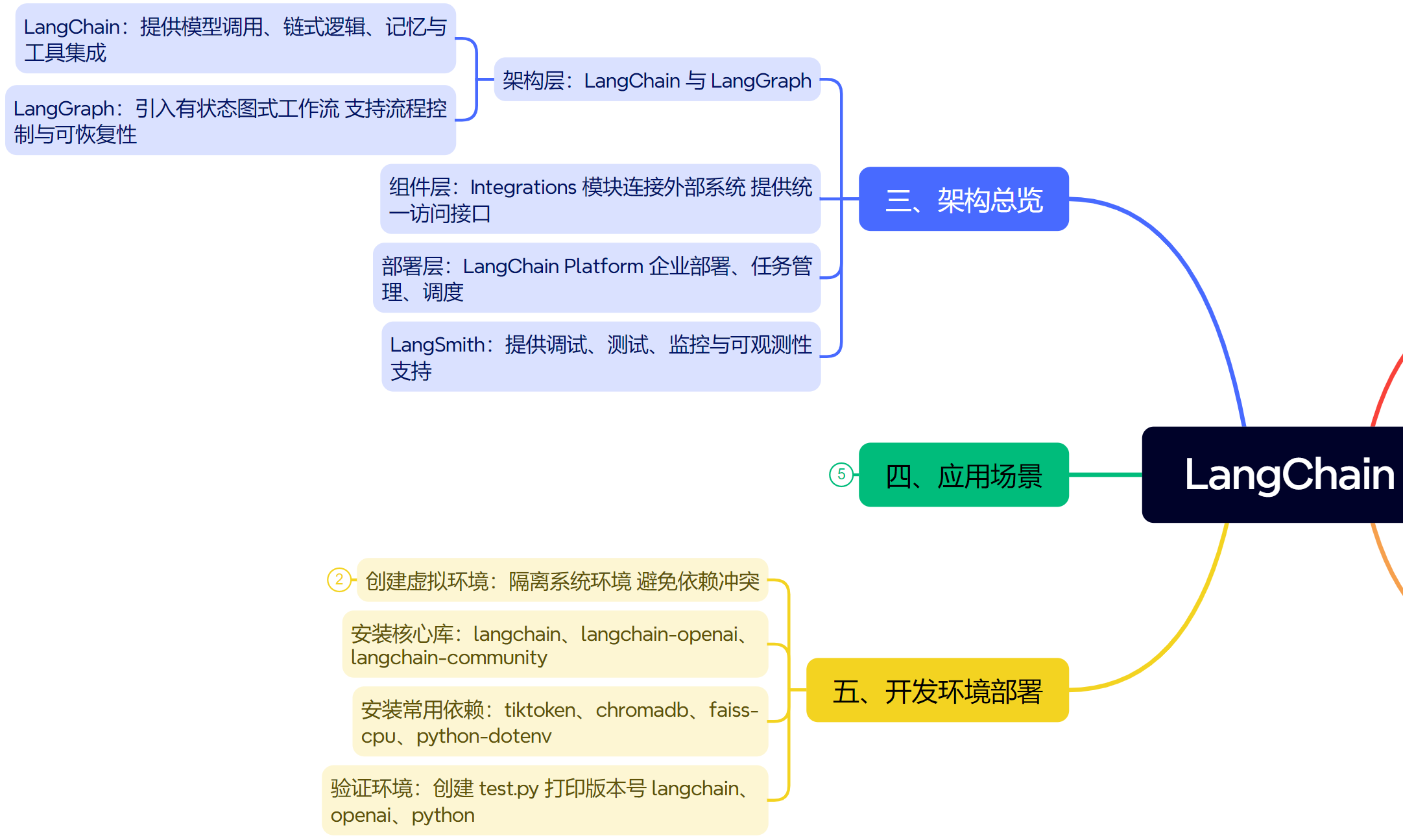

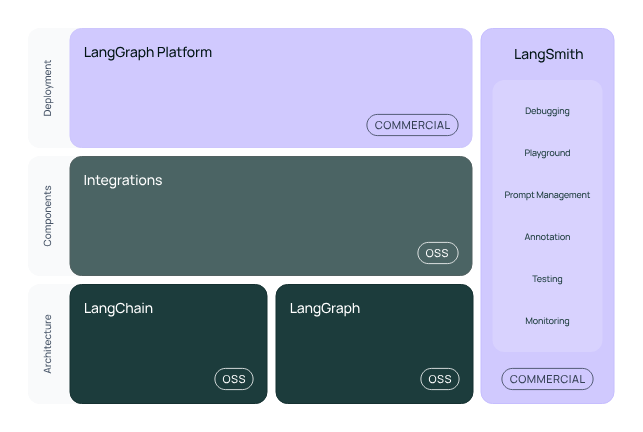

三、LangChain 架构总览

LangChain的生态分为三个主要层级:架构层 (Architecture)、组件层 (Components) 与 部署层 (Deployment),并配套有开发与调试平台 LangSmith。

1. 架构层 (Architecture)

该层是开源核心,由 LangChain 与 LangGraph 组成。

- LangChain: 提供语言模型调用、链式逻辑、记忆与工具集成等基础能力。

- LangGraph: 扩展了 LangChain 的执行模型,引入有状态的图式工作流,使得复杂任务具备流程控制与可恢复性。

2. 组件层 (Components)

这一层通过 Integrations 模块实现对外部系统的连接,包括向量数据库、检索引擎、API 接口、文件加载器等。它为上层工作流提供数据和工具的统一访问接口,是连接底层逻辑与外部生态的中间层。

3. 部署层 (Deployment)

部署层由 LangChain Platform (商业版) 构成,用于企业级部署、任务管理与执行调度。它提供可视化工作流管理、可扩展执行环境和生产级 API 服务。

4. LangSmith 平台

LangSmith 与上述三层并行,提供开发和监控支持,包括调试、Prompt 管理、测试、注释与可观测性分析等功能。它是 LangChain 应用从开发到生产的重要支撑平台。

四、LangChain 应用场景

LangChain 广泛应用于:

智能问答系统 (QA Chatbot): 基于通用知识或特定领域知识构建对话机器人。

私有知识库问答 (RAG): 结合企业内部文档、数据库,构建能够回答私有问题的智能系统。

自动化办公助手: 集成邮件、日历、CRM等办公系统的API,实现任务的自动化处理。

文档摘要与分析: 对长文档、财报、法律文件进行快速摘要和信息提取。

多步任务规划 (Agent 工作流): 让 LLM 自主规划步骤、调用工具,完成复杂任务,如“帮我规划一次旅行”。

五、LangChain 开发环境部署教程

我们将在本地使用 Python 虚拟环境来搭建一个干净的 LangChain 开发环境。

1. 创建并激活虚拟环境

首先,在你选择的项目目录下,创建一个新的 Python 虚拟环境。这可以避免与系统 Python 环境的包发生冲突。

# 创建名为 .venv 的虚拟环境

python -m venv .venv

# 激活虚拟环境

# Windows (PowerShell):

.venv\Scripts\Activate.ps1

# Linux/macOS:

source .venv/bin/activate

激活后,你的命令行提示符前通常会出现 (.venv) 字样。

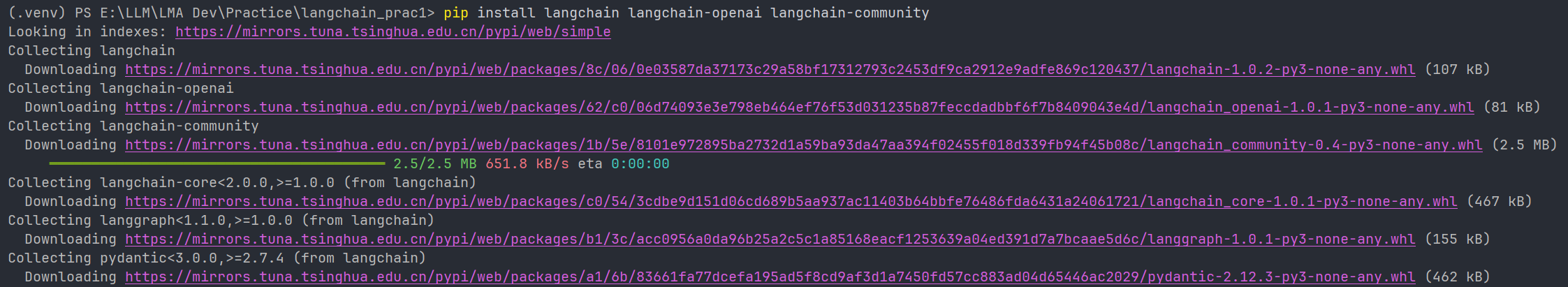

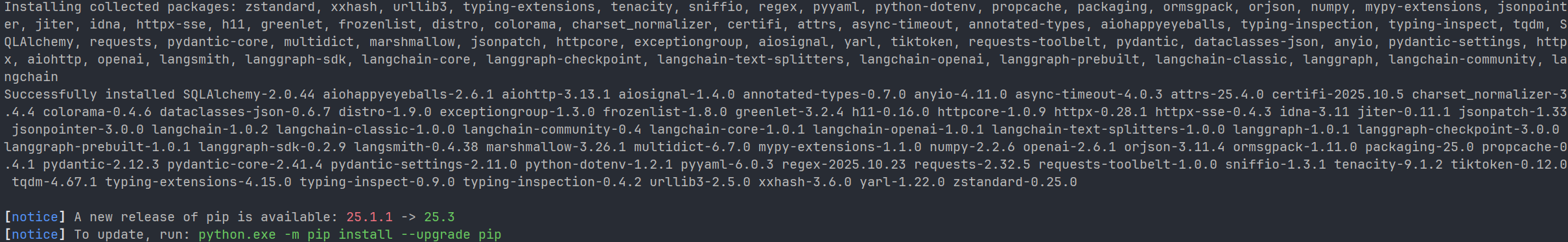

2. 安装 LangChain 核心库

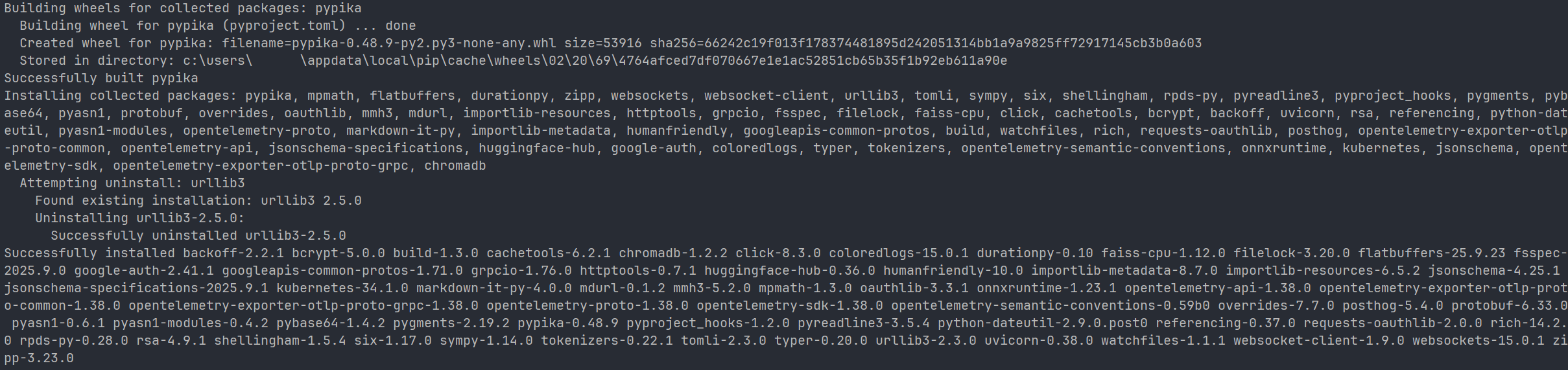

LangChain 被设计为模块化的。我们将安装 langchain (核心), langchain-openai (与OpenAI模型交互) 和 langchain-community (社区维护的集成)。

# 使用国内镜像源加速安装

pip install langchain langchain-openai langchain-community -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

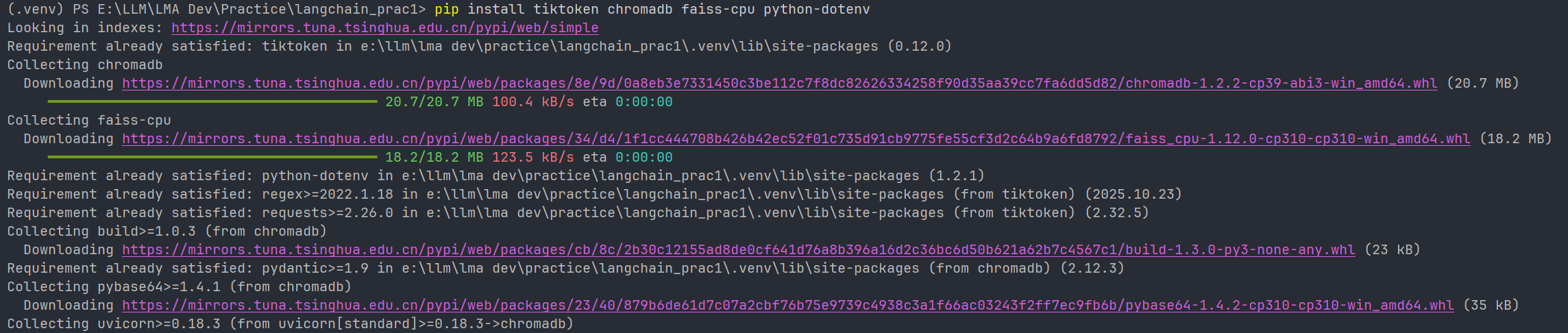

3. 安装常用依赖 (以RAG为例)

一个非常常见的应用场景是RAG (Retrieval-Augmented Generation),即基于外部文档的问答。这通常需要额外的依赖:

tiktoken: OpenAI 用于计算文本 token 数量的工具。chromadb: 一个开源的向量数据库,用于存储文档嵌入向量。faiss-cpu: Facebook AI 开发的高效向量相似度搜索库。python-dotenv: 用于从.env文件中加载环境变量 (如 API 密钥)。

pip install tiktoken chromadb faiss-cpu python-dotenv -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

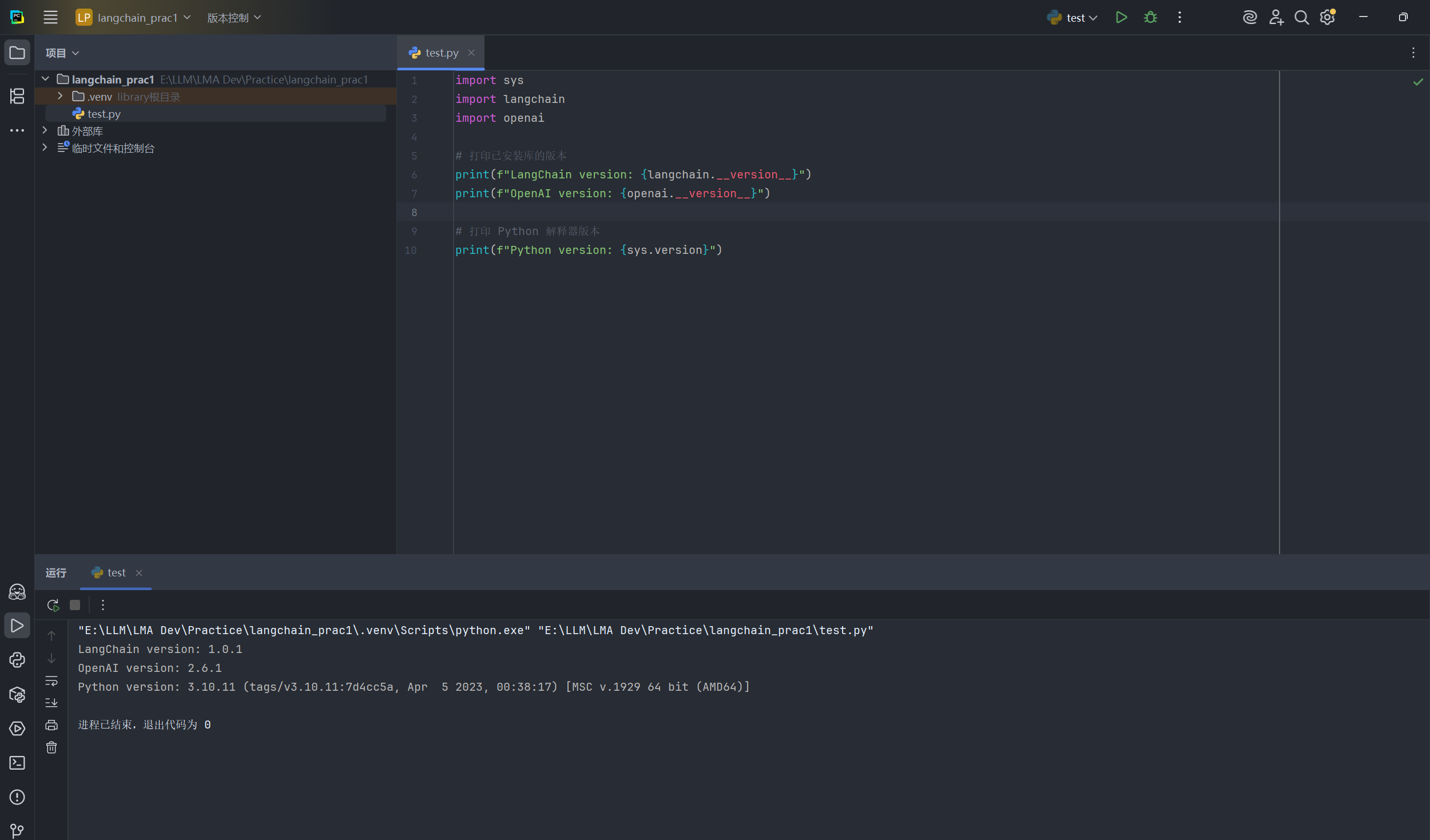

4. 验证开发环境

最后,我们创建一个简单的 Python 脚本 test.py 来验证所有安装是否成功。

test.py 内容:

import sys

import langchain

import openai

# 打印已安装库的版本

print(f"LangChain version: {langchain.__version__}")

print(f"OpenAI version: {openai.__version__}")

# 打印 Python 解释器版本

print(f"Python version: {sys.version}")

在你的 IDE (如 VS Code) 或终端中运行这个脚本。

python test.py

如果一切正常,它会打印出 langchain, openai 和 python 的版本信息,证明你的开发环境已经准备就绪!

日期:2025年10月27日

专栏:LangChain

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)