当前计算机视觉与机器人结合的方向有什么热点和重点?

2025年10月,计算机视觉与机器人技术深度融合,呈现三大趋势:1)感知能力从物体识别向全景场景理解升级,360度视觉技术(如PANORAMA系统)和WildFusion多模态融合方案显著提升机器人环境适应力;2)决策效率突破,阿里RynnVLA-001大模型与轻量化SmolVLA实现类人响应速度;3)动态卷积技术(如清华DSConv)优化管状结构识别,MobileALOHA机器人通过模仿学习实现

目前是2025年10月,CV领域相比之前已经有很多产业化应用了。

当前计算机视觉

与机器人结合呈现的趋势:

感知能力泛化

从物体识别向场景理解演进,360 度视觉

、动态卷积

等技术推动机器人适应开放环境。

决策效率提升

具身智能大模型

(如 RynnVLA-001)和轻量化部署方案(如 SmolVLA),使机器人响应速度接近人类水平。

先来看看360 度全景视觉技术

本质上是全景视觉技术从理论框架到工程实践的递进,

PANORAMA

通过系统性架构设计解决全向感知的基础问题,

WildFusion

则通过多模态融合和硬件创新突破复杂环境下的落地瓶颈。

PANORAMA: The Rise of Omnidirectional Vision in the Embodied AI Era

香港科技大学团队在 2025 年 9 月发布的PANORAMA 系统,首次实现机器人全方位环境感知。该技术通过球面卷积神经网络、动态伪标签更新、边缘计算优化方面的创新解决传统视觉局限。

arxiv.org/pdf/2509.12989

摘要:全向视觉,即通过 360 度视觉感知环境,已在机器人、工业检测、环境监测等领域变得愈发关键。与传统针孔视觉相比,全向视觉能提供整体环境感知,大幅提升场景感知的完整性与决策的可靠性。然而,该领域的基础性研究在过去一直落后于传统针孔视觉。

本报告介绍了具身智能时代的一个新兴趋势:在日益增长的工业需求与学术关注推动下,全向视觉正快速发展。我们重点阐述了全向生成、全向感知、全向理解及相关数据集等方向的近期突破。结合学术界与工业界的洞见,我们提出了具身智能时代下一种理想的全景系统架构:PANORAMA,该架构包含四个核心子系统。此外,我们还就全景视觉与具身智能交叉领域的新兴趋势、跨领域影响,以及未来路线图与待解决的挑战,给出了深入见解。

本报告综合梳理了该领域最先进的进展,并勾勒出在具身智能时代构建稳健、通用全向人工智能系统的未来研究挑战与机遇。

这个感知框架的验证和应用案例可以参考:

杜克大学开发的WildFusion 框架,结合全景视觉与振动传感器,使四足机器人在灾区废墟中导航成功率提升 40%,2025 年 9 月通过 ICRA 2025 技术验证。

WildFusion: Multimodal Implicit 3D Reconstructions in the Wild

arxiv.org/abs/2409.19904

摘要:我们提出了 WildFusion 这一新颖方法,该方法基于多模态隐式神经表征,用于非结构化野外环境中的 3D 场景重建。WildFusion 整合了来自激光雷达(LiDAR)、RGB 相机、接触式麦克风、触觉传感器及惯性测量单元(IMU)的信号。这种多模态融合可生成全面、连续的环境表征,涵盖像素级几何结构、颜色、语义信息及可通行性。

通过在复杂森林环境中开展四足机器人导航的真实场景实验,WildFusion 展现出更优的路径选择能力,其核心在于能精准预测环境的可通行性。我们的研究结果表明,该方法在推动复杂户外地形下机器人导航与 3D 建图技术发展方面具有显著潜力。

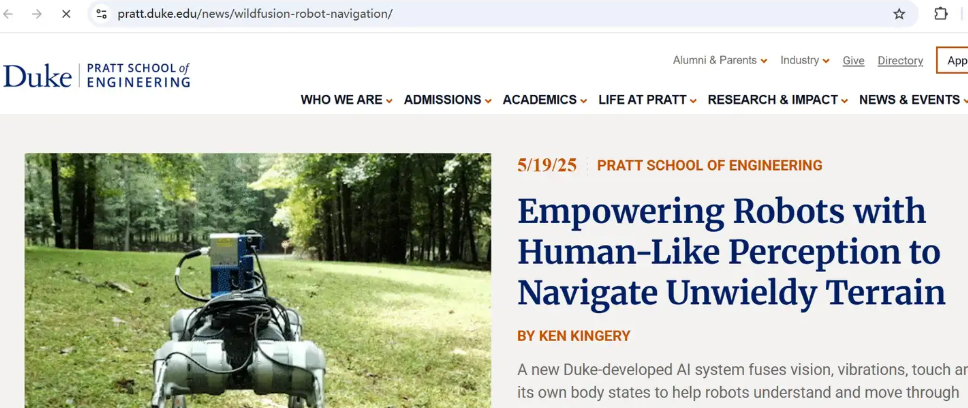

杜克大学的项目介绍

pratt.duke.edu/news/wildfusion-robot-navigation/

接着来看看,动态卷积与拓扑约束

Dynamic Snake Convolution based on Topological Geometric Constraints for Tubular Structure Segmentation

清华大学团队在 2025 年 9 月提出的动态蛇形卷积(DSConv),解决了医疗影像中管状结构分割难题。

arxiv.org/abs/2307.08388

摘要:对血管、道路等拓扑管状结构的精准分割,在多个领域都至关重要,它能保障下游任务的准确性与效率。然而,该任务受多种因素影响而变得复杂,包括局部结构纤细、全局形态多变等问题。

在本研究中,我们关注到管状结构的特殊性,并利用这一特性指导所提出的DSCNet(动态蛇形卷积网络),在特征提取、特征融合、损失约束三个阶段同步提升感知性能:

首先,我们提出动态蛇形卷积,通过自适应聚焦于纤细、弯曲的局部结构,精准捕捉管状结构特征;其次,我们提出多视角特征融合策略,在特征融合过程中补充对多视角特征的关注,确保保留不同全局形态下的关键信息;最后,我们提出基于持久同调的连续性约束损失函数,以更好地约束分割结果的拓扑连续性。

在2D和3D数据集上的实验表明,与多种现有方法相比,我们的DSCNet在管状结构分割任务中实现了更高的准确性与连续性。

以及具身智能大模型开源

2025 年 9 月,阿里达摩院开源的RynnVLA-001和 Hugging Face 发布的SmolVLA,加快了机器人通用化进程。而斯坦福的Mobile ALOHA 机器人在前者基础上更进一步。

RynnVLA-001: Human Demonstration-Enhanced Vision-Language-Action Model for Robotic Manipulation

arxiv.org/abs/2509.15212

摘要:本文提出了 RynnVLA-001:一款基于大规模人类演示视频生成式预训练构建的视觉 - 语言 - 动作(VLA)模型。我们提出了一种新颖的两阶段预训练方法:

第一阶段为第一视角视频生成式预训练,在 1200 万条第一视角操作视频上训练图像到视频(Image-to-Video)模型,使其能以初始帧和语言指令为条件,预测后续帧内容;第二阶段为人类中心轨迹感知建模,通过联合预测未来关键点轨迹对第一阶段模型进行扩展,从而有效衔接视觉帧预测与动作预测。

此外,为提升动作表征能力,我们提出了ActionVAE(动作变分自编码器):该模型将动作序列压缩为紧凑的 latent 嵌入,降低了 VLA 模型输出空间的复杂度。

在相同的下游机器人数据集上进行微调后,RynnVLA-001 的性能优于当前最先进的基准模型。这表明,本文提出的预训练策略能为 VLA 模型提供更有效的初始化,从而提升其在机器人任务中的表现。

SmolVLA: A Vision-Language-Action Model for Affordable and Efficient Robotics

arxiv.org/abs/2506.01844

摘要:在大规模多模态数据集上预训练的视觉 - 语言模型(VLMs),编码了丰富的视觉与语言知识,使其成为机器人领域的坚实基础。相较于从零开始训练机器人策略,近期研究通过将 VLMs 适配为视觉 - 语言 - 动作(VLA)模型,实现了自然语言驱动的感知与控制。

然而,现有 VLA 模型通常规模庞大,参数往往达数十亿,这导致训练成本高昂,且在实际场景中的部署能力受限。此外,这些模型依赖学术或工业数据集,忽视了低成本机器人平台所积累的、日益丰富的社区采集数据。

本研究中,我们提出SmolVLA:一款小型、高效且社区驱动的 VLA 模型。该模型大幅降低了训练与推理成本,同时保持了具有竞争力的性能。SmolVLA 的设计目标是:可在单块 GPU 上完成训练,并能部署于消费级 GPU 甚至 CPU。

为进一步提升响应速度,我们引入异步推理栈:将感知、动作预测与动作执行解耦,通过分块动作生成实现更高的控制频率。尽管尺寸紧凑,SmolVLA 的性能仍可与规模大 10 倍的 VLA 模型相媲美。

Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation

斯坦福的Mobile ALOHA 机器人,通过模仿学习实现自主乘电梯,成功率从 95% 提升至 98%,2025 年 9 月新增自动按楼层按钮功能。

arxiv.org/abs/2401.02117

摘要:基于人类演示的模仿学习在机器人领域已展现出出色性能,但多数研究成果仅聚焦于桌面操作,缺乏完成通用实用任务所需的移动能力与灵活性。

本研究中,我们开发了一套用于模仿移动操作任务的系统,该类任务需机器人具备双臂协作能力与全身控制能力。首先,我们提出了Mobile ALOHA:一款用于数据采集的低成本全身遥操作系统。它在原有 ALOHA 系统的基础上,新增了移动底座与全身遥操作交互界面。

利用 Mobile ALOHA 采集的数据,我们进一步开展有监督行为克隆训练,并发现:与现有静态 ALOHA 数据集联合训练,能显著提升移动操作任务的性能。在每个任务仅需 50 组演示数据的情况下,联合训练可将成功率最高提升至 90%,使 Mobile ALOHA 能够自主完成复杂的移动操作任务,例如炒虾仁并装盘、打开双门壁柜存放沉重炊具、呼叫并进入电梯,以及用厨房水龙头轻轻冲洗用过的平底锅。

最后,多模态融合新框架

2025 年发布的APEX 2.0 框架,在 Unitree Go2 机器人上实现更高效的强化学习:

APEX: Action Priors Enable Efficient Exploration for Skill Imitation on Articulated Robots,四足机器人通过这种方法在硬件上实现了 3.3 米 / 秒的高速奔跑。

arxiv.org/pdf/2505.10022

摘要:模仿学习为机器人培养规范的复杂行为、直接从自然演示中获益提供了有效途径。当前主流的模仿学习(IL)方法通常采用对抗性运动先验(AMP),这类方法尽管效果显著,但存在两个关键局限:一是易出现模式崩溃,这往往导致模型过拟合于仿真环境,进而扩大仿真到现实的差距;二是难以高效学习多样化行为。

为克服这些局限,我们提出了 APEX(动作先验赋能高效探索,Action Priors enable Efficient Exploration),这是一种简洁且通用的模仿学习框架,它将演示数据直接集成到强化学习(RL)中,在以专家先验为行为基础的同时,保持高强度探索。为实现这一目标,我们结合了衰减式动作先验(该先验起初将探索偏向专家演示,随后逐步允许策略自主探索),并辅以多评论家强化学习框架,该框架可有效平衡风格一致性与任务性能。

我们的方法实现了样本高效的模仿学习,且能在单一策略中习得多样化技能。APEX 可适配不同速度,并能在复杂任务(如粗糙地形导航、爬楼梯)中保持与参考演示相似的风格,而其仅需以平坦地形运动学数据作为先验。我们在 Unitree Go2 四足机器人上开展了大量硬件实验,对该框架进行验证。结果显示,APEX 能让机器人产生多样化且灵活的运动步态,实现步态的自然过渡;据我们所知,该方法还创下了该平台的最高速度记录(仿真到仿真迁移中可达约 4.5 米 / 秒,硬件平台上峰值速度约为 3.3 米 / 秒)。

我们的研究结果表明,APEX 可作为现有模仿学习方法的有力替代方案,在效率、适应性及真实场景性能方面均展现出更优表现。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)