大模型的算力需求:训练一个千亿模型需要多少 GPU?

千亿参数大模型训练算力需求分析 本文系统分析了训练千亿参数大模型(如GPT-3、LLaMA 2)的算力需求。关键点包括: 内存需求:FP16精度的千亿参数模型基础存储需200GB,训练时总内存需求达500-700GB,包括参数、梯度、优化器状态和激活值。 计算复杂度:基于DeepMind公式,训练计算量≈6×参数数量×训练tokens,千亿模型训练需约1.8×10^20 FLOPs。 GPU配置:

一、算力需求概述

1.1 千亿参数模型的规模概念

千亿参数模型通常指参数量在1000亿(100B)左右的模型,如GPT-3(175B)、LLaMA 2(70B)等。理解这个规模需要一些直观的对比:

参数量的物理意义:

- 1000亿参数 = 100,000,000,000个浮点数

- FP16精度存储:约200GB显存

- 训练时激活内存:额外需要300-500GB

- 总内存需求:500-700GB

# 千亿参数模型的存储需求计算

def calculate_model_memory(parameters=100e9, precision='fp16'):

"""计算模型参数的内存占用"""

bytes_per_parameter = {

'fp32': 4, # 32位浮点数

'fp16': 2, # 16位浮点数

'bf16': 2, # 脑浮点数16位

'int8': 1 # 8位整数

}

memory_gb = (parameters * bytes_per_parameter[precision]) / (1024**3)

return memory_gb

# 计算基础存储需求

base_memory = calculate_model_memory(100e9, 'fp16')

print(f"千亿参数FP16精度基础存储: {base_memory:.1f} GB")

1.2 算力需求的核心组成

训练千亿模型的总算力需求主要由三部分组成:

总算力需求 = 前向传播计算 + 反向传播计算 + 优化器状态

其中反向传播的计算量通常是前向传播的2-3倍。

二、计算复杂度分析

2.1 FLOPs计算原理

大模型训练的计算复杂度可以用FLOPs(浮点运算次数)来度量:

def estimate_training_flops(parameters, tokens):

"""

估算训练总计算量

根据DeepMind的公式:训练FLOPs ≈ 6 * 参数数量 * 训练tokens

"""

total_flops = 6 * parameters * tokens

return total_flops

# 千亿模型的典型计算量

model_parameters = 100e9 # 1000亿参数

training_tokens = 300e9 # 3000亿tokens(根据Chinchilla定律)

total_training_flops = estimate_training_flops(model_parameters, training_tokens)

print(f"训练总计算量: {total_training_flops:.2e} FLOPs")

2.2 实际计算需求分解

千亿模型训练的计算分解:

- 前向传播:2 * 参数数量 * 序列长度

- 反向传播:4 * 参数数量 * 序列长度

- 优化器状态:额外的内存和计算开销

- 通信开销:分布式训练中的梯度同步

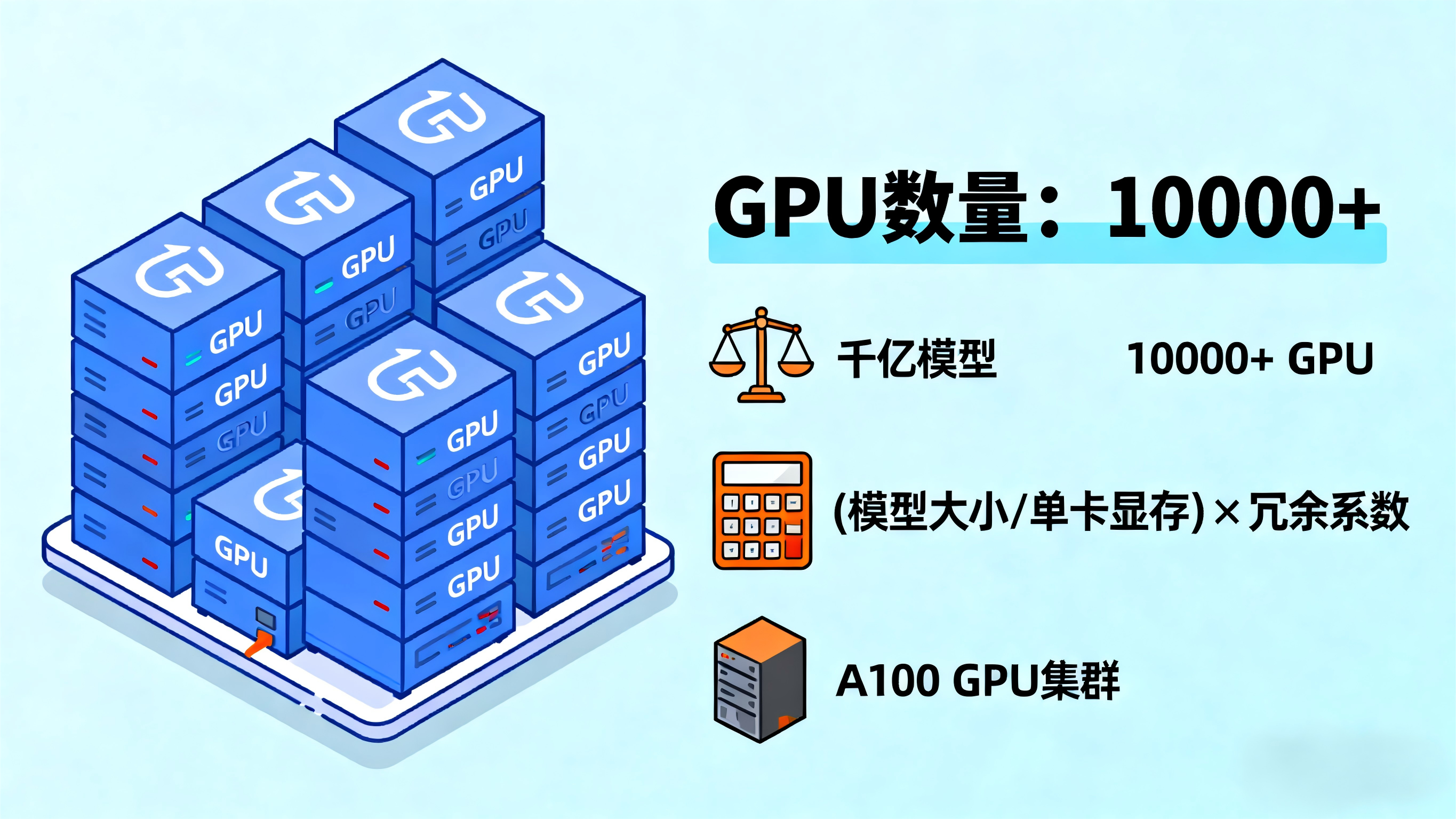

三、GPU需求计算

3.1 内存需求分析

训练千亿模型面临的首要挑战是内存需求:

class MemoryCalculator:

def __init__(self, model_parameters=100e9):

self.model_parameters = model_parameters

def calculate_training_memory(self, batch_size=1, seq_len=2048):

"""计算训练时的总内存需求"""

memory_components = {}

# 1. 模型参数(FP16)

memory_components['model_params'] = self.model_parameters * 2 / (1024**3)

# 2. 梯度(与参数同样大小)

memory_components['gradients'] = self.model_parameters * 2 / (1024**3)

# 3. 优化器状态(Adam优化器:参数、动量、方差)

memory_components['optimizer_states'] = self.model_parameters * 8 / (1024**3)

# 4. 激活值(近似计算)

# 每层激活值 ≈ batch_size * seq_len * hidden_size

hidden_size = 12288 # 典型值

num_layers = 80 # 典型值

activation_memory = batch_size * seq_len * hidden_size * num_layers * 2 / (1024**3)

memory_components['activations'] = activation_memory

# 5. 临时缓冲区等

memory_components['overhead'] = 10 # GB

total_memory = sum(memory_components.values())

return total_memory, memory_components

calculator = MemoryCalculator(100e9)

total_memory, breakdown = calculator.calculate_training_memory()

print(f"训练总内存需求: {total_memory:.1f} GB")

print("内存分布:", breakdown)

3.2 GPU配置方案

基于内存需求,我们可以设计不同的GPU配置方案:

class GPUConfigurations:

def __init__(self):

self.gpu_specs = {

'A100-80GB': {'memory': 80, 'flops': 312e12},

'H100-80GB': {'memory': 80, 'flops': 989e12},

'V100-32GB': {'memory': 32, 'flops': 125e12}

}

def estimate_gpu_requirements(self, total_memory_required):

"""估算需要的GPU数量"""

requirements = {}

for gpu_type, specs in self.gpu_specs.items():

# 基于内存的估算

gpus_by_memory = ceil(total_memory_required / specs['memory'])

# 基于计算效率的调整(考虑并行效率)

efficient_gpus = gpus_by_memory * 1.2 # 20%余量

requirements[gpu_type] = {

'minimum_gpus': gpus_by_memory,

'recommended_gpus': int(efficient_gpus),

'total_memory': gpus_by_memory * specs['memory']

}

return requirements

configs = GPUConfigurations()

gpu_requirements = configs.estimate_gpu_requirements(total_memory)

四、实际训练配置案例

4.1 典型千亿模型训练配置

基于公开的千亿模型训练经验,我们可以总结出典型的硬件配置:

GPT-3 175B训练配置:

- GPU数量:1024张 A100(早期版本)

- 训练时间:约3个月

- 总算力消耗:约3.14e23 FLOPs

- 批大小:3.2M tokens(约1570个序列)

LLaMA 2 70B训练配置:

- GPU数量:2048张 A100

- 训练时间:约21天

- 训练数据:2T tokens

- 优化技术:更高效的并行策略

4.2 分布式训练策略

训练千亿模型必须使用分布式训练,主要并行策略:

class DistributedTrainingConfig:

def __init__(self, total_parameters=100e9):

self.total_parameters = total_parameters

def data_parallel_requirements(self, gpu_memory):

"""数据并行需要的GPU数量"""

# 每个GPU需要存储完整的模型副本

model_memory_gb = self.total_parameters * 2 / (1024**3) # FP16

gpus_needed = ceil(model_memory_gb / gpu_memory)

return gpus_needed

def model_parallel_requirements(self, gpu_memory):

"""模型并行配置"""

# 将模型分层到多个GPU上

layers_per_gpu = 4 # 假设每GPU放4层

hidden_size = 12288

# 计算每层的内存需求

layer_memory = self.calculate_layer_memory(hidden_size)

gpus_needed = ceil(layer_memory * layers_per_gpu / gpu_memory)

return gpus_needed

def pipeline_parallel_requirements(self, sequence_length=2048, batch_size=1):

"""流水线并行配置"""

# 将模型按层分段,不同段放在不同GPU上

# 需要平衡计算和通信开销

optimal_stages = 8 # 经验值

return optimal_stages

def calculate_hybrid_parallelism(self, available_gpus=128):

"""混合并行策略计算"""

config = {

'tensor_parallel': 8, # 8路张量并行

'pipeline_parallel': 4, # 4阶段流水线并行

'data_parallel': 4, # 4路数据并行

'total_gpus': 8 * 4 * 4 # 128张GPU

}

return config

五、成本分析

5.1 硬件成本估算

class CostCalculator:

def __init__(self):

self.hardware_costs = {

'A100-80GB': 15000, # 每张卡价格(美元)

'H100-80GB': 30000,

'DGX_Station': 150000, # 4*A100工作站

'DGX_A100': 200000, # 8*A100服务器

}

self.cloud_costs = {

'A100_cloud_hourly': 10, # 云服务每小时价格

'H100_cloud_hourly': 20,

}

def calculate_training_cost(self, gpu_type, gpu_count, training_days):

"""计算训练总成本"""

if gpu_type in self.hardware_costs:

# 硬件采购成本

hardware_cost = self.hardware_costs[gpu_type] * gpu_count

# 考虑硬件折旧(3年周期)

depreciation = hardware_cost / (3 * 365)

electricity = gpu_count * 0.4 * 24 * training_days # 电力成本

total_cost = depreciation * training_days + electricity

else:

# 云服务成本

hourly_rate = self.cloud_costs.get(gpu_type + '_cloud_hourly', 10)

total_hours = training_days * 24

total_cost = hourly_rate * total_hours * gpu_count

return total_cost

calculator = CostCalculator()

# 示例:使用128张A100训练30天

a100_cost = calculator.calculate_training_cost('A100-80GB', 128, 30)

print(f"128张A100训练30天成本: ${a100_cost:,.0f}")

5.2 不同规模的配置方案

基于实际项目经验,不同预算下的推荐配置:

预算 100万美元:

- GPU数量:64张 A100

- 训练时间:6-9个月

- 适合:70B参数模型

预算 500万美元:

- GPU数量:256张 A100 或 128张 H100

- 训练时间:2-3个月

- 适合:100-200B参数模型

预算 1000万美元:

- GPU数量:512张 H100

- 训练时间:1-2个月

- 适合:200-500B参数模型

六、优化技术与趋势

6.1 减少算力需求的技术

现代训练中采用多种技术来降低算力需求:

混合精度训练:

- FP16/BF16减少内存占用和计算量

- 保持FP32主权重用于精度

梯度检查点:

- 用计算换内存,减少激活值存储

- 典型配置可减少60-70%内存

模型压缩:

- 知识蒸馏

- 参数共享

- 稀疏训练

6.2 新兴硬件的影响

新硬件正在改变算力需求格局:

def compare_hardware_generations():

"""比较不同代际硬件的效率"""

generations = {

'V100': {

'memory': 32, # GB

'flops': 125, # TFLOPS

'efficiency': 1.0 # 基准

},

'A100': {

'memory': 80,

'flops': 312,

'efficiency': 2.5 # 相对于V100

},

'H100': {

'memory': 80,

'flops': 989,

'efficiency': 7.9

}

}

return generations

七、实际建议与决策框架

7.1 GPU数量决策指南

基于项目需求选择合适规模:

class GPURecommendation:

def recommend_configuration(self, budget, timeline, model_size):

"""基于约束推荐GPU配置"""

recommendations = []

# 基于预算的推荐

if budget < 500000: # 50万美元以下

recommendations.append({

'strategy': '云服务 + 小规模',

'gpu_count': 16,

'estimated_time': '6-12个月',

'cost': f'${budget:,.0f}'

})

elif budget < 2000000: # 200万美元以下

recommendations.append({

'strategy': '混合采购 + 云服务',

'gpu_count': 64,

'estimated_time': '3-6个月',

'cost': f'${budget:,.0f}'

})

else: # 200万美元以上

recommendations.append({

'strategy': '大规模集群',

'gpu_count': 256,

'estimated_time': '1-3个月',

'cost': f'${budget:,.0f}'

})

return recommendations

7.2 实际部署考虑

基础设施需求:

- 网络:至少100Gbps InfiniBand

- 存储:高速并行文件系统

- 电力:每机柜20-40kW

- 冷却:液冷或高效风冷

团队要求:

- 分布式训练专家

- MLOps工程师

- 系统管理员

- 领域专家

八、未来趋势

8.1 算力需求演进

大模型训练的算力需求仍在快速增长:

- 2018年:GPT-1,1.17B参数,数十张GPU

- 2020年:GPT-3,175B参数,千张GPU

- 2023年:万亿参数模型,数千张GPU

- 2025年(预测):十万亿参数,万张GPU级别

8.2 技术发展方向

硬件创新:

- 专用AI芯片

- 光学计算

- 存内计算

算法优化:

- 更高效的模型架构

- 稀疏激活

- 更好的并行策略

结论

训练一个千亿参数模型通常需要128-512张现代GPU(如A100/H100),具体数量取决于:

- 模型架构:参数数量、层数、隐藏维度

- 训练策略:并行方式、批大小、序列长度

- 硬件配置:单卡内存、互联带宽

- 时间预算:训练时长要求

- 资金预算:硬件采购或云服务成本

对于大多数组织,建议从云服务开始,逐步积累经验后再考虑硬件投资。随着技术发展,训练效率正在快速提升,但算力需求仍然是进入大模型领域的主要门槛。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)