大模型终极入门:从数学公式到语言“理解”,看懂这篇就够了!

不知你是否曾有这样的困惑:为什么一堆奇奇怪怪的矩阵计算,就能让机器“理解”文本,甚至流畅地与我们对话?今天,就让我们一同拆解这个黑箱,探寻大模型“智商”背后的数学本质。

不知你是否曾有这样的困惑:为什么一堆奇奇怪怪的矩阵计算,就能让机器“理解”文本,甚至流畅地与我们对话?今天,就让我们一同拆解这个黑箱,探寻大模型“智商”背后的数学本质。

核心谜题:数学公式如何产生“理解”?

01

当你看到“今天天气很好,我们去公园…”时,你会自然地预测下一个词是“散步”。这不是什么超能力,而是基于你对语言规律和生活经验的理解。

那么,大模型是如何做到这一点的呢?它真的“理解”了文本吗?

核心答案: 模型并没有像人类一样“理解”文本。它是在学习一个极其复杂的数学映射函数。这个函数在训练数据上表现得如此之好,以至于它的行为看起来像是“理解”了。

数学本质:万能函数逼近器

02

这一切的基石,是一个被称为“万能函数逼近定理”的数学原理。简单来说,只要有足够的层数和神经元,神经网络可以以任意精度逼近任何一个复杂的函数。

- 线性变换的局限

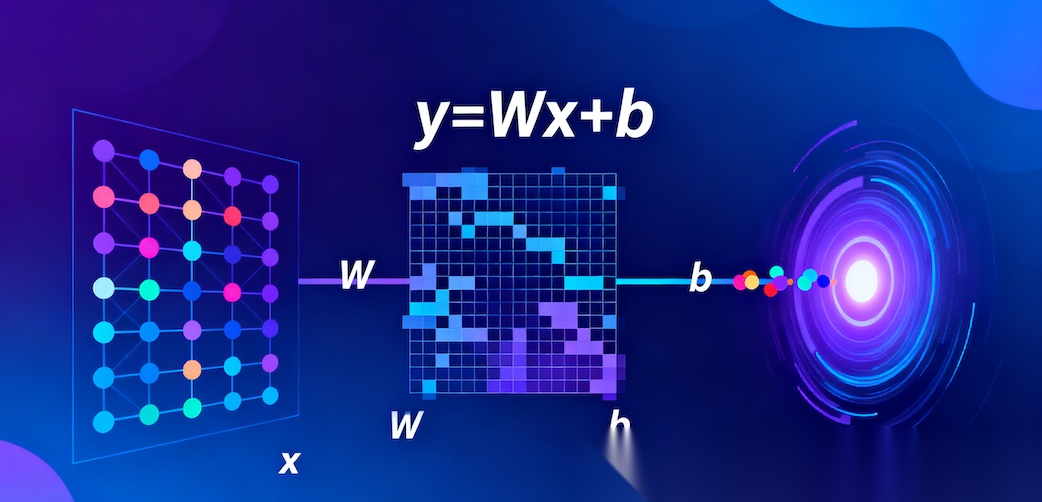

纯线性运算(y = Wx + b)无论堆叠多少层,最终效果都等价于一个巨大的线性变换。这意味着它连简单的“异或”问题都解决不了。

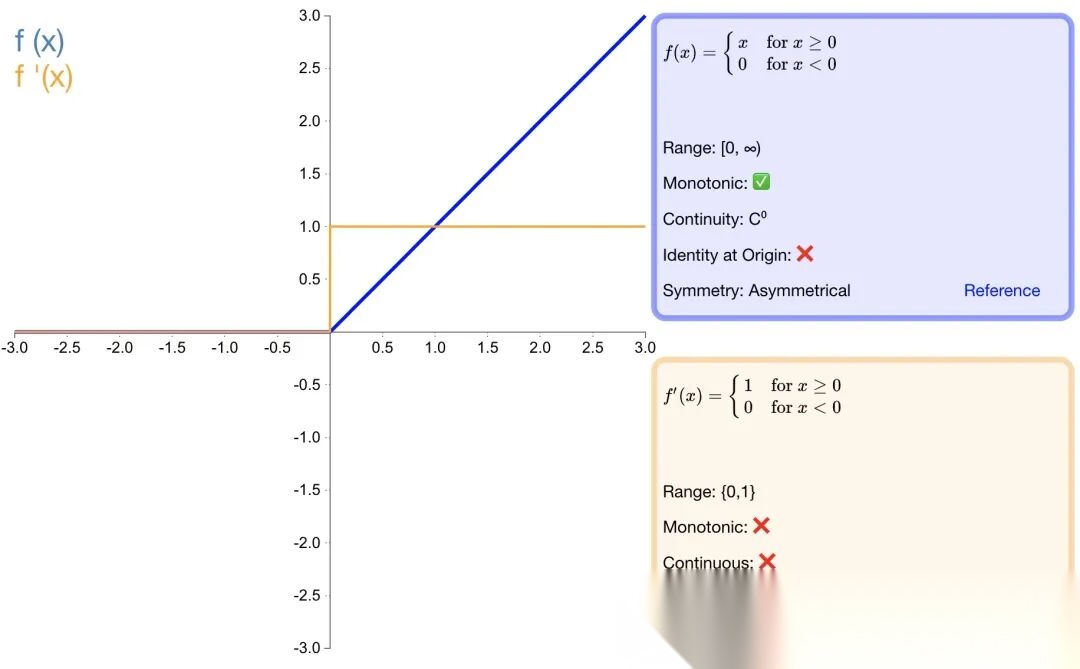

- 非线性激活的魔力

激活函数(如ReLU)引入了弯曲和断裂。这允许模型将原始输入空间进行“扭曲”、“折叠”和“切割”。

生动的比喻:

想象一张平铺的二维纸。线性变换只能对这张纸进行旋转、缩放、剪切。而非线性变换允许你将这张纸撕破、揉皱、折叠。通过多层这样的操作,你可以将这张纸变成复杂的多维折纸雕塑。

大模型正式运用线性变换,叠加非线性激活函数(Softmax, ReLU),对自然语言处理。每个词由其词向量表示,一句话就是这些词向量在空间中的一组点。神经网络通过调整其权重参数(W,b),学习将这个“空间形态”映射到期望的输出概率分布上。当你把大模型理解成这个数学公式 y = Wx + b,根据输入x,求y的过程,不就是推理吗,这个时候有没有发现思路就打开了😄

架构演进:从简单层到Transformer的“本质”

03

大模型的能力飞跃,并非简单的参数堆砌,而是一场关于“计算权力”如何分配的深刻变革。

- 基础层:权力的基石,像不像大力出奇迹

-

全连接层实现“特征组合”

-

深度堆叠实现“层次化抽象”

- Transformer的革命:从“序列”到“注意力”

传统RNN处理序列是一个接一个一个地看,离得远的词容易被忘记。Transformer的自注意力机制让序列中的任何一个词,都能直接与序列中的所有其他词进行“信息交换”。

Self-Attention的核心(QKV模型):

-

Query是提出查询(需要什么信息) -

Key是发布公告(有什么信息) -

Value是真正的价值(信息的本质内容)

这种分离赋予了模型极大的灵活性。同一个信息源,可以根据不同的查询,被赋予不同的权重来使用。说的直白点,它可以用数学公式更好的对输入x进行“加工”。

- 批判性视角:Transformer的代价

Self-Attention的复杂度是序列长度的平方 O(n²),处理长文本时计算开销巨大,就是太费算力,那就想招吧,后面就有了KV cache。

- 回归本质:线性变换的系数集合

Transformer 中所有可训练参数(包括 MHA 的投影矩阵、FFN 的权重 / 偏置、层归一化参数等),数学上均是线性变换的系数集合,最终通过梯度下降优化,目标是让这些系数定义的 “变换规则” 逼近 “输入 X→真实输出 y” 的潜在规律。

-

权重(W):对应线性变换 y = Wx 中的系数矩阵,用于实现特征的维度映射(如将 d_model 维特征映 射到 d_k 维)或特征间的关联计算(如 MHA 中 Query 与 Key 的相似度)。

-

偏置(b):对应线性变换

y = Wx + b中的常数项,用于调整线性变换的偏移量,补偿特征分布的偏移,本质是扩展线性变换的表达范围。

参数的灵魂:权重与偏置——模型知识的载体

04

在大模型中,我们谈论的“参数”,本质上就是权重(Weights)和偏置(Biases)。它们是模型从数据中学到的“经验”本身,是其推理能力的核心载体。

- 权重:关联强度的调节器

-

作用:衡量不同输入特征之间的关联强度。例如,在“苹果很好吃”中,权重会学习到“苹果”与“吃”之间存在强关联,而与“编程”关联较弱。

-

意义:模型通过训练调整成千上万的权重,最终让重要的连接“加强”,不重要的连接“减弱”,从而编码了复杂的语言规律。

- 偏置:激活阈值的调节器

-

作用:类似于线性方程中的常数项,用于调整神经元的激活阈值,让模型更灵活地拟合数据。

-

意义:即使所有输入都为0,偏置也能让神经元有机会被激活,增加了模型的表达能力。

- 知识的凝结过程

训练完成后,硬盘上保存的模型文件,主要内容就是所有这些权重和偏置的数值。推理的本质,就是加载这些凝固的“知识”,用它们来处理新的输入。

# 一个简化的线性层展示了参数如何工作class LinearLayer: def __init__(self, input_size, output_size): # 权重矩阵W:核心参数,决定特征如何转换 self.weights = torch.randn(output_size, input_size) * 0.1 # 偏置向量b:辅助参数,调节输出基准 self.bias = torch.zeros(output_size) def forward(self, x): # 推理时的核心计算:y = Wx + b return torch.matmul(x, self.weights.T) + self.bias

训练与推理:从“学习规律”到“应用规律”

05

训练的本质:寻找最优的 W 和 b

训练过程可以想象成一位学徒在海量临摹字帖,最终掌握书法精髓的过程。

- 初始化:一张白纸

所有参数(权重矩阵 W 和偏置 b)被随机初始化

- 核心算法:梯度下降与反向传播

# 训练循环的核心逻辑for batch in data_loader: # 前向传播:用当前的W和b计算预测 logits = model(batch.input_ids) # 计算损失:预测与真实的差距 loss = loss_fn(logits, batch.target_ids) # 反向传播:计算梯度 loss.backward() # 参数更新:调整所有W和b optimizer.step()

这个过程在数十亿文本数据上重复无数次。最终,W 和 b 不再随机,它们凝结了从海量数据中提炼出的语言规律。

推理的本质:应用学到的 W 和 b

训练结束后,我们得到一组固定的、最优的 W 和 b。推理就是冻结这些参数,为新输入服务。“冻结”是什么意思呢,咱们在上一篇讨论LoRA聊过,简单点说就是参数不参与梯度的计算,也就不会更新参数的权重w和偏置b。

- 输入 X:特征矩阵

你的输入提示被转化为特征矩阵,就是能看的东西太少了, 放大一些,多看看

- 执行计算:前向传播

# 推理过程def inference(model, input_text): # 将文本转化为特征矩阵X input_ids = tokenizer.encode(input_text) # 前向传播(不计算梯度) with torch.no_grad(): logits = model(input_ids) # 输出下一个词的概率分布 return F.softmax(logits, dim=-1)

- 输出 Y:预测下一个词

概率最高的词被选择作为输出,然后循环这个过程,生成连贯文本。如果想了解整个过程中的矩阵变换,包括编码器,解码器的流程

重新理解“理解”

06

当我们说模型“理解”文本时,实际上是指:

- 模式识别专家:在海量数据中识别统计规律,通过参数调整来提取特征,是不是理解更深刻了。

- 概率预测机器:基于模式计算下一个词的概率分布,有没有发现看似挺玄到东西,实际就是数学公式的变换。

- 函数逼近高手:通过数学函数逼近语言生成规律,像不像先算出函数的系数,然后套用公式计算,说到底原来也挺“简单”😂。

模型的“智商”源于:

-

海量数据中的统计规律,还是那就话“大力出奇迹”

-

万能函数逼近器的学习能力,还是那个公式。

-

大规模优化的参数调整,还是熟悉的配方。

总结:智能的数学之美

07

下次当你看到大模型流畅地生成文本时,你知道这背后并不是魔法,而是一个精密的数学机器在执行复杂的空间变换和概率计算。所有的“智慧”,都编码在那些看似平凡的 W 和 b 参数之中。

这种理解虽然与人类不同,但在效果上却产生了令人惊叹的相似性。这正是深度学习的魅力所在——用数学之美,复现智能之妙。

如何学习大模型 AI ?

我国在AI大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着Al技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国Al产业的创新步伐。加强人才培养,优化教育体系,国际合作并进,是破解困局、推动AI发展的关键。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

2025最新大模型学习路线

明确的学习路线至关重要。它能指引新人起点、规划学习顺序、明确核心知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

对于从来没有接触过AI大模型的同学,我帮大家准备了从零基础到精通学习成长路线图以及学习规划。可以说是最科学最系统的学习路线。

针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

大模型经典PDF书籍

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路!

配套大模型项目实战

所有视频教程所涉及的实战项目和项目源码等

博主介绍+AI项目案例集锦

MoPaaS专注于Al技术能力建设与应用场景开发,与智学优课联合孵化,培养适合未来发展需求的技术性人才和应用型领袖。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

为什么要学习大模型?

2025人工智能大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

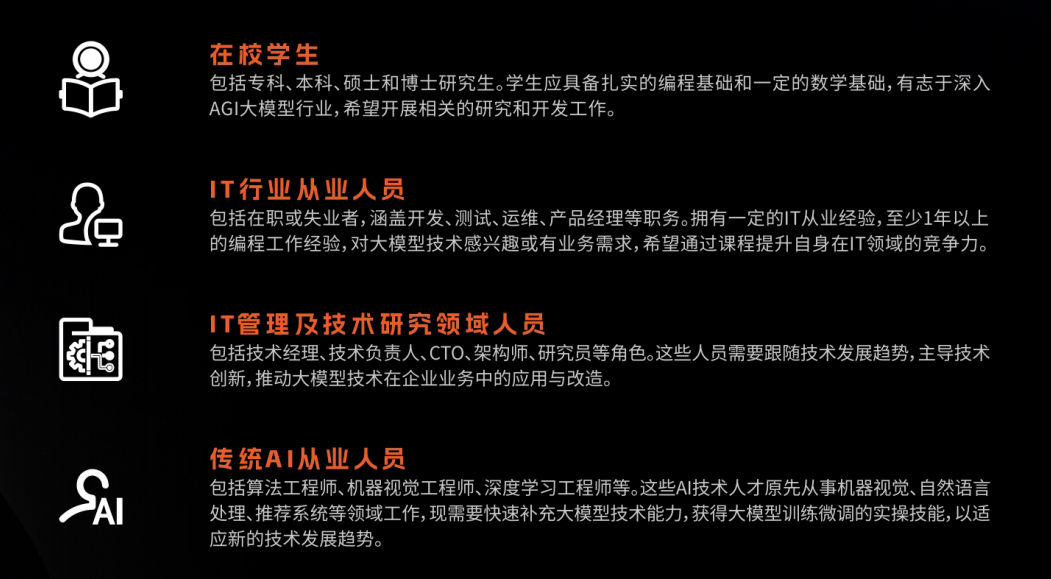

适合人群

- 在校学生:包括专科、本科、硕士和博士研究生。学生应具备扎实的编程基础和一定的数学基础,有志于深入AGI大模型行业,希望开展相关的研究和开发工作。

- IT行业从业人员:包括在职或失业者,涵盖开发、测试、运维、产品经理等职务。拥有一定的IT从业经验,至少1年以上的编程工作经验,对大模型技术感兴趣或有业务需求,希望通过课程提升自身在IT领域的竞争力。

- IT管理及技术研究领域人员:包括技术经理、技术负责人、CTO、架构师、研究员等角色。这些人员需要跟随技术发展趋势,主导技术创新,推动大模型技术在企业业务中的应用与改造。

- 传统AI从业人员:包括算法工程师、机器视觉工程师、深度学习工程师等。这些AI技术人才原先从事机器视觉、自然语言处理、推荐系统等领域工作,现需要快速补充大模型技术能力,获得大模型训练微调的实操技能,以适应新的技术发展趋势。

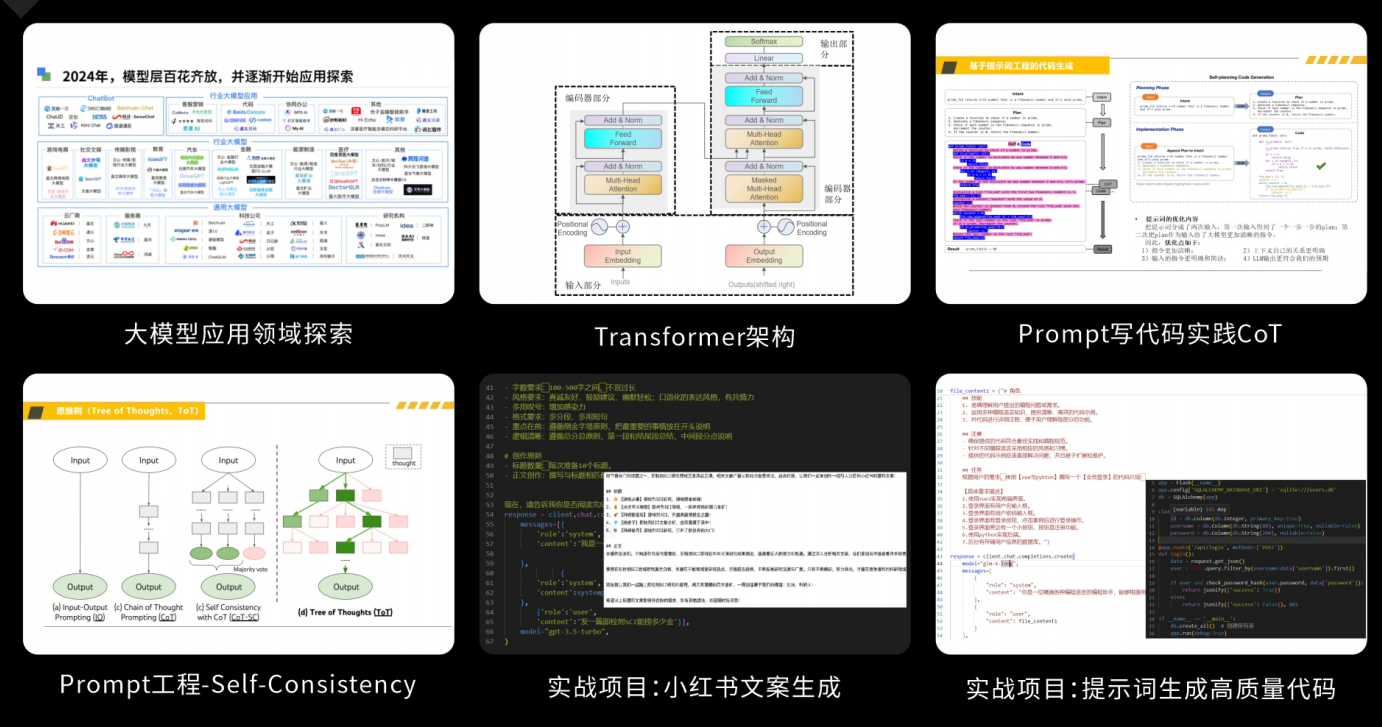

课程精彩瞬间

大模型核心原理与Prompt:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为Al应用开发打下坚实基础。

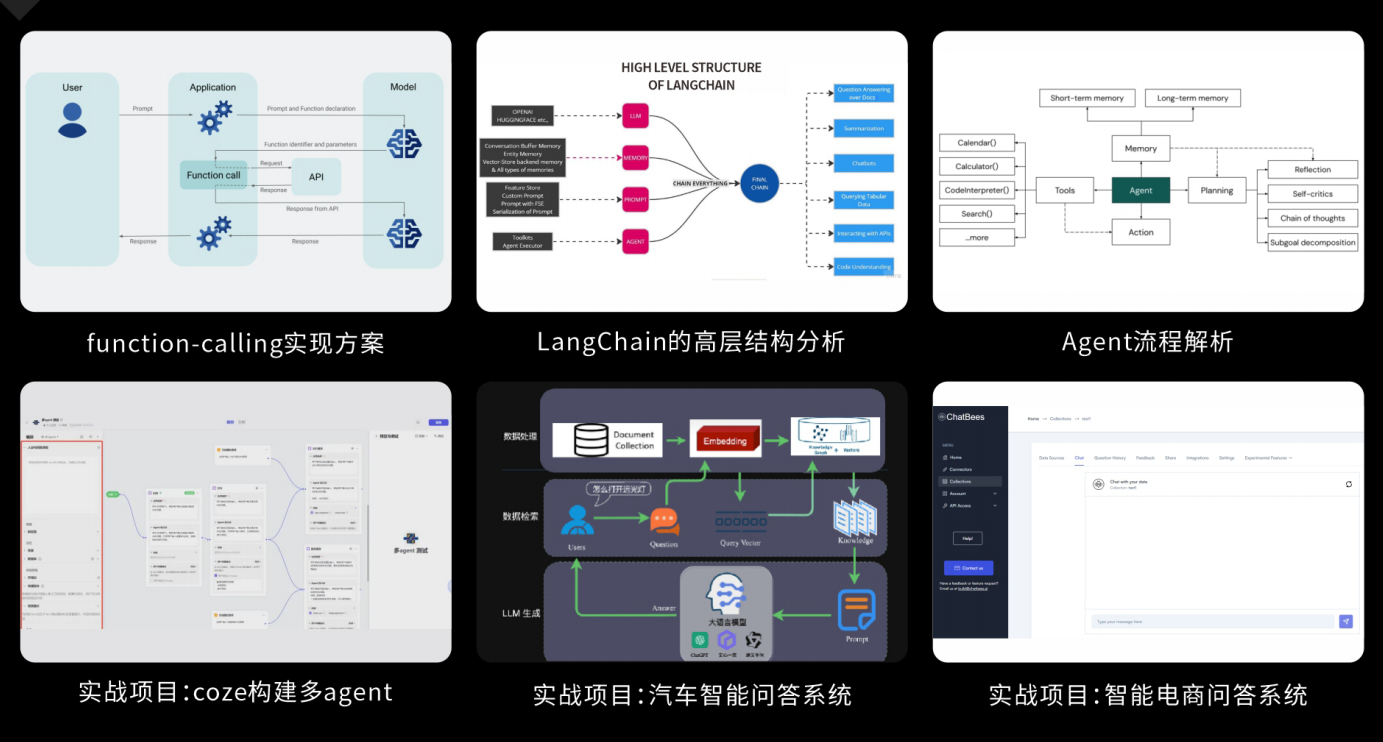

RAG应用开发工程:掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

Agent应用架构进阶实践:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

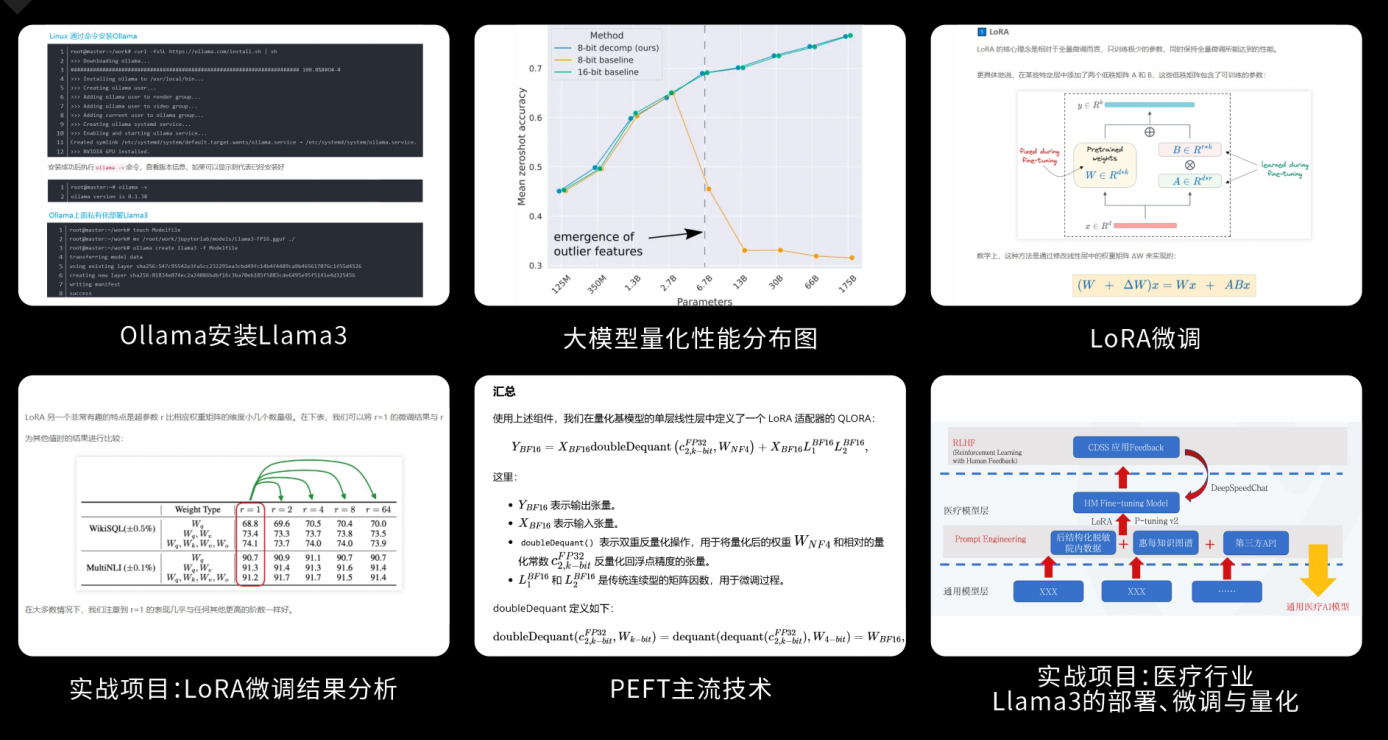

模型微调与私有化大模型:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

顶尖师资,深耕AI大模型前沿技术

实战专家亲授,让你少走弯路

一对一学习规划,职业生涯指导

- 真实商业项目实训

- 大厂绿色直通车

人才库优秀学员参与真实商业项目实训

以商业交付标准作为学习标准,具备真实大模型项目实践操作经验可写入简历,支持项目背调

大厂绿色直通车,冲击行业高薪岗位

文中涉及到的完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献263条内容

已为社区贡献263条内容

所有评论(0)