字节跳动新模型Seed3D 1.0实测来了!

不得不说,国产大模型真是有点百花齐放的意思了。

不得不说,国产大模型真是有点百花齐放的意思了。

字节跳动Seed团队又发布了新一代3D生成大模型Seed3D 1.0

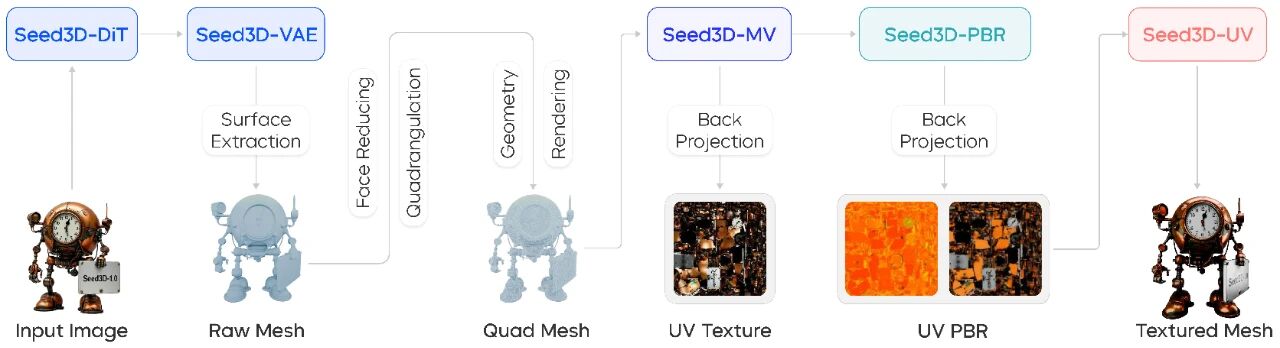

10月23日,字节跳动Seed团队又发布了新一代3D生成大模型Seed3D 1.0!官方称,这款3D基础模型兼具物理模拟精确性与可扩展性,能够实现“单张2D图像到仿真级3D资产”的端到端生成。也就是说,没有什么复杂的操作,普通用户仅凭一张照片,就能快速获得包含精细几何、真实纹理和基于物理渲染(PBR)材质的完整3D模型。

该模型基于创新的Diffusion Transformer架构,通过大规模数据训练完成,可实现3D生成的多视角一致性和材质真实感。此外,通过Seed3D 1.0生成的3D模型能够无缝导入Isaac Sim等仿真引擎,仅需少量适配工作即可支持具身智能大模型训练。在分步场景生成中,Seed3D 1.0还能从单个物体生成,拓展至构建完整的3D场景。

为了展示实力,研发团队选取了43张输入图像,从6个关键维度,对6种不同的3D生成方法进行对比分析。结果显示,Seed3D 1.0在所有维度上都表现出优良的性能,不仅能够精准还原物体的几何结构,还能还原参考图的多种纹理样式、空间关系等。

进入火山引擎的体验入口后,整个操作步骤可以说是非常简单:选择视觉模型Seed3D 1.0→上传图片→点击生成,全程无需任何专业设置,界面设计也非常清爽,没有复杂的参数调节面板,即使是完全不懂3D建模的新手,也能在1分钟内完成操作。左侧功能栏可以选择默认纹理或是白模、线框,也可以关闭自动旋转,方便用户检查细节。

这里要提醒一下准备体验的小伙伴们,如果登入体验中心后,出现Seed3D 1.0上传图片后页面加载非常慢的情况,记得在火山引擎左侧工具栏-开通管理中,查看一下是否开通服务,没有的话需要手动开通。

目前未开通状态下,走的是另一个链路的任务生成,排队现象比较严重。开通服务后,用户有200万tokens的免费额度可用,在默认参数配置下,大约可支持100次普通3D模型生成!

几何生成

根据官方数据看呢,Seed3D 1.0在几何生成的评估中取得了更高的ULIP-I和Uni3D-I得分,生成的几何结构与输入图像之间达到了高精度对齐。所以,本轮测试我选用了一张纸箱上的足球图和一张雕刻精美复杂的人形手办图,看看Seed3D 1.0表现如何!

可以看到,Seed3D 1.0是还原了左图足球形状的,不过我本意是想让它把纸箱、羽毛球筒都一并还原,重新试了几遍后发现不行,它还是只能识别到足球,那就看足球吧!视频中的旋转效果很明显不对,足球的黑色五边形部分是错乱的,而且球面上的光影也比较暗,光线生硬,整体表现我只能给它60分。看来,Seed3D 1.0在还原形态上有一定基础,但对图案分布复杂的主体识别就没那么精准了。

接下来我还测试了一款小鹿女手办,这次Seed3D 1.0的还原度还是比较高的,鹿角形状、人物服饰和底座的波浪细节都相差不大,可惜有一点点色差,仔细看腿部的还原也不是很流畅,但问题不大,是90分的水准~

PBR材质生成

作为3D模型的 “质感灵魂”,PBR 材质的还原度直接决定了模型的真实感上限 —— 毕竟再精准的几何结构,配上模糊的纹理也会瞬间拉胯。官方强调Seed3D 1.0能生成 “基于物理渲染的真实材质”,并且放出了各种瓷器、碟盘的演示,效果都很好,所以这里我用了一个亮面手提包进行测试,看看是不是这么回事儿~

对电商类企业来说,这个功能确实很实用。传统PBR材质制作需要掌握光照物理原理、熟练使用Substance Painter等专业工具,往往要花费数小时甚至数天打磨参数,而现在只需要一张照片就能在分钟级获得接近商业标准的材质效果,生成带真实质感的3D产品,实现720°线上展示,让消费者直观感受细节。各位老板们,心动了吗!

用于仿真的资产生成

这部分就是我们前面说到的,具身智能大模型训练。为了将3D模型导入仿真器,Seed3D 1.0会利用视觉语言模型(VLM)估算并调整每个模型的尺度,使其符合真实世界的物理尺寸,同时,Isaac Sim能够从水密的流形几何体中自动生成碰撞网格,并应用默认的物理属性(如摩擦系数),从而无需手动调优即可实现即时物理仿真。

这里,我第一时间想到的就是工业零部件的应用,所以我找了一张带螺纹孔的齿轮图,齿数16,模数2,齿宽 10cm,让Seed3D 1.0生成试试。

视频里可以看到,生成的齿轮数16这里是对了的,模数2只对了一面,另一面没有识别到,而且内圈的孔数原图只有4个,Seed3D 1.0生成的则是一面4个一面5个。这个缺陷对于像工业这类有高精细度要求的场景来说,显然无法满足需求。看来,Seed3D 1.0目前的舒适区还是更偏向于日常绘图使用。

场景生成

最后这一关,要考验的是Seed3D 1.0的“理解能力”了。参考官方演示的视频,Seed3D 1.0会利用VLM提取图片中的物体实例及其空间关系,为每个被定位的物体生成相应的几何结构与材质信息。最后,根据 VLM 预测的空间布局,将所有生成的物体进行组合与摆放。

这是我最期待的功能,所以我赶紧找了张办公室区域图“喂”给它。从画面看来,Seed3D 1.0对空间分布的识别还是很准确的,桌椅的位置摆放都没有出错。不过,这破破烂烂的椅子背、悬空的电脑、绿植们……是在演恐怖片吗?

总结来说呢,Seed3D 1.0给我的最大感受是定位清晰,但有待改进。

对于电商商家、短视频创作者、自媒体人这类非专业用户来说,它的价值不言而喻 —— 无需学习复杂的建模软件,不用投入大量时间打磨细节,一张照片就能快速产出可用的3D素材,无论是用于商品展示、短视频场景搭建,还是内容创作的创意原型,都能极大压缩制作周期和成本。

但如果把目光投向更广阔的行业应用,Seed3D 1.0 的短板也同样明显。在工业设计、精密制造、建筑建模等对精度要求极高的场景中,它目前的细节还原能力还远远不够 —— 就像我们测试的齿轮模型,哪怕只是一个孔位的误差,都可能导致其无法满足实际需求。而在复杂场景生成上,对多物体识别、空间逻辑的把控不足,也让它暂时难以胜任更高级的场景搭建任务。

不过,我们也不能用 “完美标准” 看待一款刚发布的 1.0 版本模型。回顾 AI 图像生成的发展路径,从最初的模糊失真到如今的以假乱真,仅用了短短几年时间。Seed3D 1.0 如今展现出的PBR材质还原优势和清晰的产品定位,已经为后续迭代奠定了良好基础。随着训练数据的积累、算法的优化,相信未来它在精度控制、多物体识别等方面的提升值得期待。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)