Linux服务器编程实践99-Proactor事件处理模式:基于异步I/O的工作流程

本文深入探讨了Linux服务器编程中的Proactor模式及其实现。Proactor模式通过异步I/O机制,将I/O操作交由内核执行,工作线程仅处理业务逻辑,实现了I/O处理与业务逻辑的完全解耦。文章详细解析了Linux的aio系列函数、Proactor工作流程和代码实现,并对比了Reactor模式,指出Proactor在高并发场景下的优势:零拷贝潜力、低线程同步开销和更好的并发支持。最后给出了内

在Linux服务器编程中,事件处理模式直接决定了程序的性能和资源利用率。Reactor模式作为同步I/O场景下的经典方案,已被广泛应用,但在高并发、大吞吐量场景中,基于异步I/O的Proactor模式更能发挥内核优势。本文将从Proactor模式的核心原理出发,结合Linux异步I/O接口(aio系列函数),详解其工作流程,并通过代码示例和可视化图表,帮助开发者理解如何在实际项目中落地该模式。

一、Proactor模式的核心思想

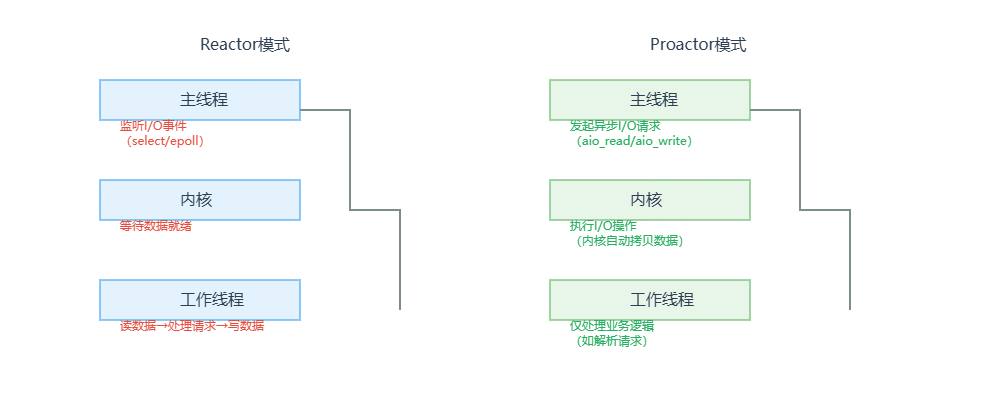

Proactor模式与Reactor模式的本质区别在于:谁来完成I/O操作。

- Reactor模式:主线程(I/O处理单元)仅负责监听I/O事件就绪,实际的读写操作由工作线程(逻辑单元)完成,属于“同步I/O驱动”。

- Proactor模式:主线程将I/O操作(读/写)完全交给内核执行,工作线程仅负责处理业务逻辑(如解析请求、生成响应),属于“异步I/O驱动”。

这种分工使得Proactor模式更符合“服务器编程框架”的解耦思想——I/O处理单元(内核+主线程)专注于数据传输,逻辑单元专注于业务计算,避免了线程间的数据拷贝和同步开销。

图1:Proactor与Reactor模式分工对比

二、Linux异步I/O基础:aio系列函数

要实现Proactor模式,首先需要掌握Linux提供的异步I/O接口。核心函数定义在aio.h头文件中,主要包括异步读(aio_read)、异步写(aio_write)和事件通知(基于信号或回调)。

2.1 关键数据结构与函数

| 组件 | 作用 | 核心参数/字段 |

|---|---|---|

struct aiocb |

异步I/O控制块,描述I/O操作的详细信息 | aio_fildes(目标文件描述符)、aio_buf(用户缓冲区)、aio_nbytes(传输字节数)、aio_sigevent(事件通知方式) |

struct sigevent |

定义I/O完成后的通知方式 | sigev_notify(通知类型:信号/线程)、sigev_signo(信号编号)、sigev_value(传递给信号处理函数的数据) |

aio_read() |

发起异步读请求 | 指向aiocb的指针,成功返回0,失败返回-1 |

aio_write() |

发起异步写请求 | 与aio_read()参数一致 |

aio_error() |

查询异步I/O操作的状态 | 指向aiocb的指针,返回0表示完成,其他值表示错误 |

2.2 事件通知方式

Linux异步I/O支持两种通知方式,适用于不同场景:

- 信号通知:I/O完成后,内核发送指定信号(如

SIGIO)给进程,进程通过信号处理函数触发后续逻辑。优点是轻量,缺点是信号处理函数中不能执行复杂操作(如内存分配)。 - 线程通知:I/O完成后,内核创建一个新线程执行预设的回调函数。优点是可以处理复杂逻辑,缺点是线程创建有一定开销。

注意:实际项目中,信号通知更常用,因为线程通知可能导致线程数量失控。本文以“信号通知”为例展开。

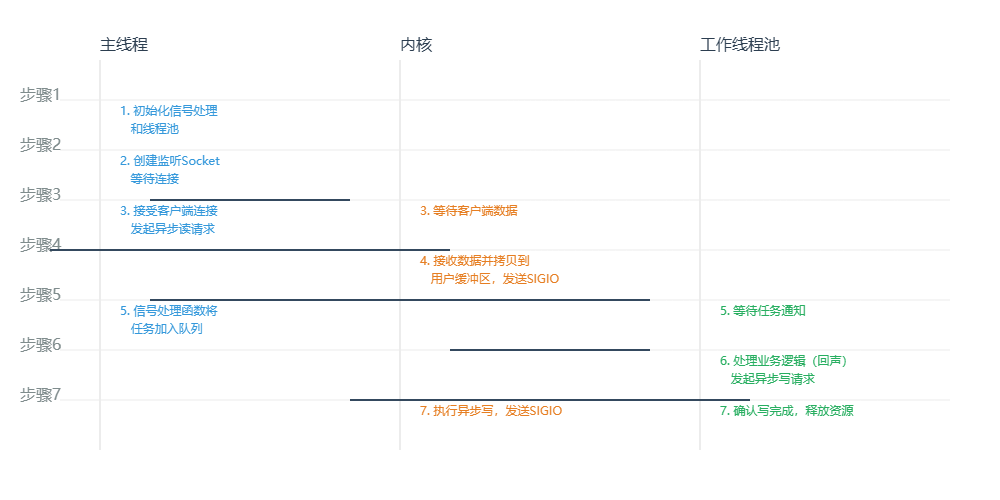

三、Proactor模式完整工作流程

基于Linux异步I/O接口,Proactor模式的工作流程可分为7个步骤,涉及主线程(I/O调度)、内核(I/O执行)和工作线程(业务处理)三个角色。

图2:Proactor模式工作流程时序图

3.1 步骤拆解与代码示例

以下以“回声服务器”为例,展示Proactor模式的代码实现(仅核心逻辑,完整代码需包含错误处理和线程池管理)。

步骤1:初始化信号处理与线程池

主线程首先注册信号处理函数(用于接收I/O完成通知),并初始化工作线程池(用于处理业务逻辑)。

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <signal.h>

#include <aio.h>

#include <pthread.h>

#include <sys/socket.h>

#include <netinet/in.h>

#define BUF_SIZE 1024

#define THREAD_POOL_SIZE 4

// 工作线程池(简化版)

pthread_t thread_pool[THREAD_POOL_SIZE];

pthread_mutex_t pool_mutex;

pthread_cond_t pool_cond;

struct aiocb* task_queue[1024];

int queue_size = 0;

// 信号处理函数:I/O完成后触发,将任务加入队列

void aio_signal_handler(int sig, siginfo_t* si, void* uc) {

if (sig != SIGIO) return;

// 从sigev_value中获取aiocb指针

struct aiocb* cb = (struct aiocb*)si->si_value.sival_ptr;

pthread_mutex_lock(&pool_mutex);

task_queue[queue_size++] = cb;

pthread_cond_signal(&pool_cond);

pthread_mutex_unlock(&pool_mutex);

}

// 工作线程:处理业务逻辑(回声服务)

void* worker_thread(void* arg) {

while (1) {

pthread_mutex_lock(&pool_mutex);

while (queue_size == 0) {

pthread_cond_wait(&pool_cond, &pool_mutex);

}

// 从队列取出任务

struct aiocb* cb = task_queue[--queue_size];

pthread_mutex_unlock(&pool_mutex);

// 1. 检查I/O操作状态

int err = aio_error(cb);

if (err != 0) {

perror("aio_error");

continue;

}

// 2. 获取实际传输的字节数

ssize_t n = aio_return(cb);

if (n <= 0) {

close(cb->aio_fildes);

free(cb);

continue;

}

// 3. 业务逻辑:回声(将收到的数据原样发回)

printf("Received: %.*s\n", (int)n, (char*)cb->aio_buf);

// 重新初始化aiocb,发起异步写

cb->aio_nbytes = n;

aio_write(cb);

}

return NULL;

}

// 初始化线程池

void init_thread_pool() {

pthread_mutex_init(&pool_mutex, NULL);

pthread_cond_init(&pool_cond, NULL);

for (int i = 0; i < THREAD_POOL_SIZE; i++) {

pthread_create(&thread_pool[i], NULL, worker_thread, NULL);

}

}步骤2:主线程创建监听Socket

主线程创建TCP监听Socket,等待客户端连接(同步操作,仅执行一次)。

int create_listen_socket(int port) {

int listen_fd = socket(AF_INET, SOCK_STREAM, 0);

struct sockaddr_in addr;

memset(&addr, 0, sizeof(addr));

addr.sin_family = AF_INET;

addr.sin_addr.s_addr = htonl(INADDR_ANY);

addr.sin_port = htons(port);

bind(listen_fd, (struct sockaddr*)&addr, sizeof(addr));

listen(listen_fd, 10);

return listen_fd;

}步骤3:主线程接受连接并发起异步读

主线程接受客户端连接后,为每个连接分配aiocb结构,配置异步读请求(指定信号通知方式),并将请求提交给内核。

void handle_new_connection(int listen_fd) {

struct sockaddr_in client_addr;

socklen_t addr_len = sizeof(client_addr);

int conn_fd = accept(listen_fd, (struct sockaddr*)&client_addr, &addr_len);

if (conn_fd < 0) {

perror("accept");

return;

}

// 分配aiocb结构(实际项目中应使用内存池)

struct aiocb* cb = malloc(sizeof(struct aiocb));

memset(cb, 0, sizeof(struct aiocb));

// 分配用户缓冲区

char* buf = malloc(BUF_SIZE);

memset(buf, 0, BUF_SIZE);

// 配置aiocb

cb->aio_fildes = conn_fd;

cb->aio_buf = buf;

cb->aio_nbytes = BUF_SIZE;

cb->aio_offset = 0; // 文件偏移(Socket忽略)

// 配置信号通知:I/O完成后发送SIGIO信号

struct sigevent sev;

memset(&sev, 0, sizeof(sev));

sev.sigev_notify = SIGEV_SIGNAL;

sev.sigev_signo = SIGIO;

sev.sigev_value.sival_ptr = cb; // 将aiocb指针传递给信号处理函数

cb->aio_sigevent = sev;

// 发起异步读请求

if (aio_read(cb) < 0) {

perror("aio_read");

free(buf);

free(cb);

close(conn_fd);

}

}步骤4:内核执行异步读并通知主线程

内核接收到客户端数据后,自动将数据从内核缓冲区拷贝到aiocb->aio_buf,然后发送SIGIO信号给进程。

步骤5:信号处理函数将任务加入队列

信号处理函数(aio_signal_handler)被触发,从siginfo_t中提取aiocb指针,将其加入任务队列,并唤醒工作线程。

步骤6:工作线程处理业务逻辑并发起异步写

工作线程被唤醒后,从队列取出aiocb,检查I/O完成状态,执行“回声”逻辑(将数据原样返回),并通过aio_write发起异步写请求。

步骤7:内核执行异步写并释放资源

内核完成异步写后,再次发送SIGIO信号。工作线程检查到写操作完成后,可选择关闭连接或继续等待下一次读请求(本例中继续等待)。

四、Proactor模式的优势与适用场景

4.1 核心优势

- 零拷贝潜力:内核直接完成数据拷贝(内核缓冲区↔用户缓冲区),避免了Reactor模式中“主线程读数据→工作线程处理→主线程写数据”的多次拷贝。

- 低线程同步开销:工作线程仅处理业务逻辑,不涉及I/O操作,无需与主线程同步文件描述符或缓冲区,减少了锁竞争。

- 高并发支持:异步I/O由内核调度,主线程可同时管理数千个连接,无需创建大量线程(Reactor模式常需线程池配合)。

4.2 适用场景

- 高并发、大吞吐量的服务器(如HTTP服务器、消息队列)。

- I/O密集型场景(如文件传输、数据库代理),CPU计算相对简单。

- 需要减少线程上下文切换的场景(如内核版本≥2.6.33,支持

io_setup等高效接口)。

五、注意事项与优化建议

5.1 避免常见坑点

- 内存管理:

aiocb和用户缓冲区需手动管理,建议使用内存池避免频繁malloc/free。 - 信号安全:信号处理函数中仅能执行异步安全操作(如

pthread_mutex_lock),不能调用printf、malloc等非异步安全函数。 - 错误处理:需通过

aio_error()和aio_return()检查I/O状态,避免直接使用返回值判断。

5.2 性能优化方向

- 使用内存池:预分配

aiocb和缓冲区,减少系统调用开销。 - 批量I/O:结合

aio_suspend()批量等待多个I/O完成,减少信号触发频率。 - 内核参数调优:调整

/proc/sys/net/core/somaxconn(最大监听队列)、/proc/sys/net/ipv4/tcp_max_syn_backlog(半连接队列)等参数。

六、总结

Proactor模式通过“内核执行I/O+线程处理业务”的分工,充分发挥了Linux异步I/O的优势,特别适合高并发、I/O密集型场景。相比Reactor模式,它减少了线程间的数据交互和同步开销,但实现复杂度更高,需要开发者深入理解内核异步I/O机制。

在实际项目中,需根据业务场景选择合适的事件处理模式:简单场景(如小并发服务)可使用Reactor模式,复杂高并发场景(如分布式网关)则推荐Proactor模式。同时,结合线程池、内存池等优化手段,可进一步提升服务器的性能和稳定性。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)