医疗数据中的元学习与跨机构模型泛化优化技术

元学习为破解医疗数据孤岛难题提供了创新路径,但其落地仍需解决数据异质性、模型可解释性等核心挑战。随着AutoML与隐私计算技术的融合,跨机构医疗AI将迎来更大发展空间。

·

📝 博客主页:jaxzheng的CSDN主页

目录

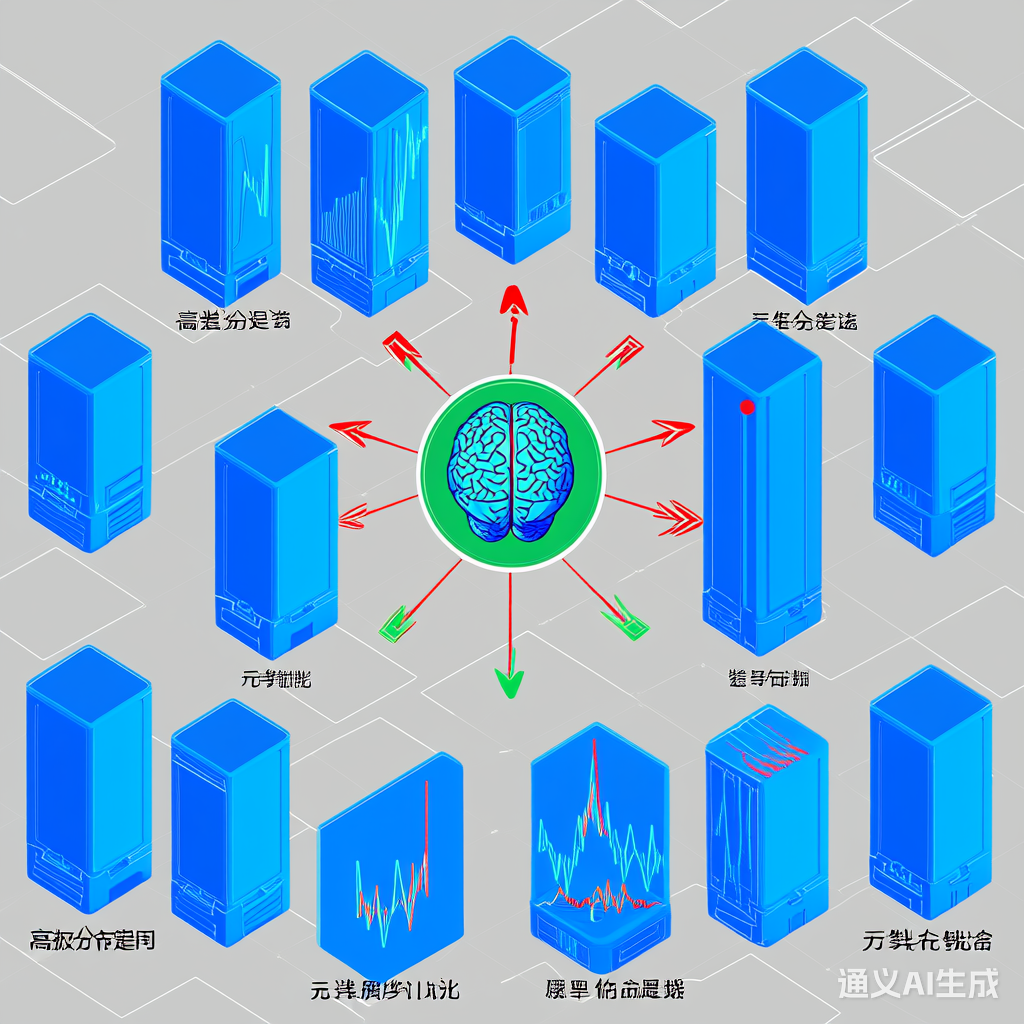

医疗数据的碎片化和机构间的隐私壁垒导致AI模型难以实现广泛适用性。元学习(Meta-Learning)通过“学会学习”的机制,为跨机构模型泛化提供了新思路。本文将探讨元学习在医疗场景中的关键技术路径,并结合代码示例解析其优化策略。

元学习通过从多个相关任务中提取共性知识,使模型具备快速适应新任务的能力。在医疗场景中,可将不同机构视为独立任务,通过共享表征学习提升模型泛化性。

import torch

import torch.nn as nn

class MetaLearner(nn.Module):

def __init__(self, input_dim, hidden_dim):

super(MetaLearner, self).__init__()

self.meta_network = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, hidden_dim)

)

def forward(self, x):

return self.meta_network(x)

# 初始化元学习器

meta_model = MetaLearner(input_dim=128, hidden_dim=64)

医疗数据存在以下挑战:

- 特征分布差异(如不同设备采集的影像数据)

- 标注标准不统一

- 少样本场景普遍

通过对抗训练对齐不同机构的特征分布:

class DomainClassifier(nn.Module):

def __init__(self, input_dim):

super(DomainClassifier, self).__init__()

self.classifier = nn.Sequential(

nn.Linear(input_dim, 64),

nn.LeakyReLU(0.2),

nn.Linear(64, 1),

nn.Sigmoid()

)

def forward(self, x):

return self.classifier(x)

# 对抗训练损失函数

def adversarial_loss(source_feat, target_feat, domain_classifier):

source_domain = domain_classifier(source_feat)

target_domain = domain_classifier(target_feat)

loss = -torch.mean(torch.log(source_domain) + torch.log(1 - target_domain))

return loss

结合MAML(Model-Agnostic Meta-Learning)算法处理机构间差异:

def maml_update(model, data_loader, inner_lr=0.01, outer_lr=0.001):

meta_loss = 0

for task_data in data_loader:

# 内层优化

optimizer = torch.optim.SGD(model.parameters(), lr=inner_lr)

loss = model.loss(task_data)

grads = torch.autograd.grad(loss, model.parameters())

fast_weights = [(p - g * inner_lr) for p, g in zip(model.parameters(), grads)]

# 外层更新

meta_loss += model.meta_loss(fast_weights, task_data)

# 执行外层梯度下降

optimizer_meta = torch.optim.Adam(model.parameters(), lr=outer_lr)

meta_loss.backward()

optimizer_meta.step()

from sklearn.preprocessing import StandardScaler

def preprocess_multicenter_data(data_dict):

scaler = StandardScaler()

processed_data = {}

for center_id, data in data_dict.items():

# 特征标准化

scaled_features = scaler.fit_transform(data['features'])

# 标签统一映射

labels = map_label(data['labels'])

processed_data[center_id] = {

'features': torch.tensor(scaled_features, dtype=torch.float32),

'labels': torch.tensor(labels, dtype=torch.long)

}

return processed_data

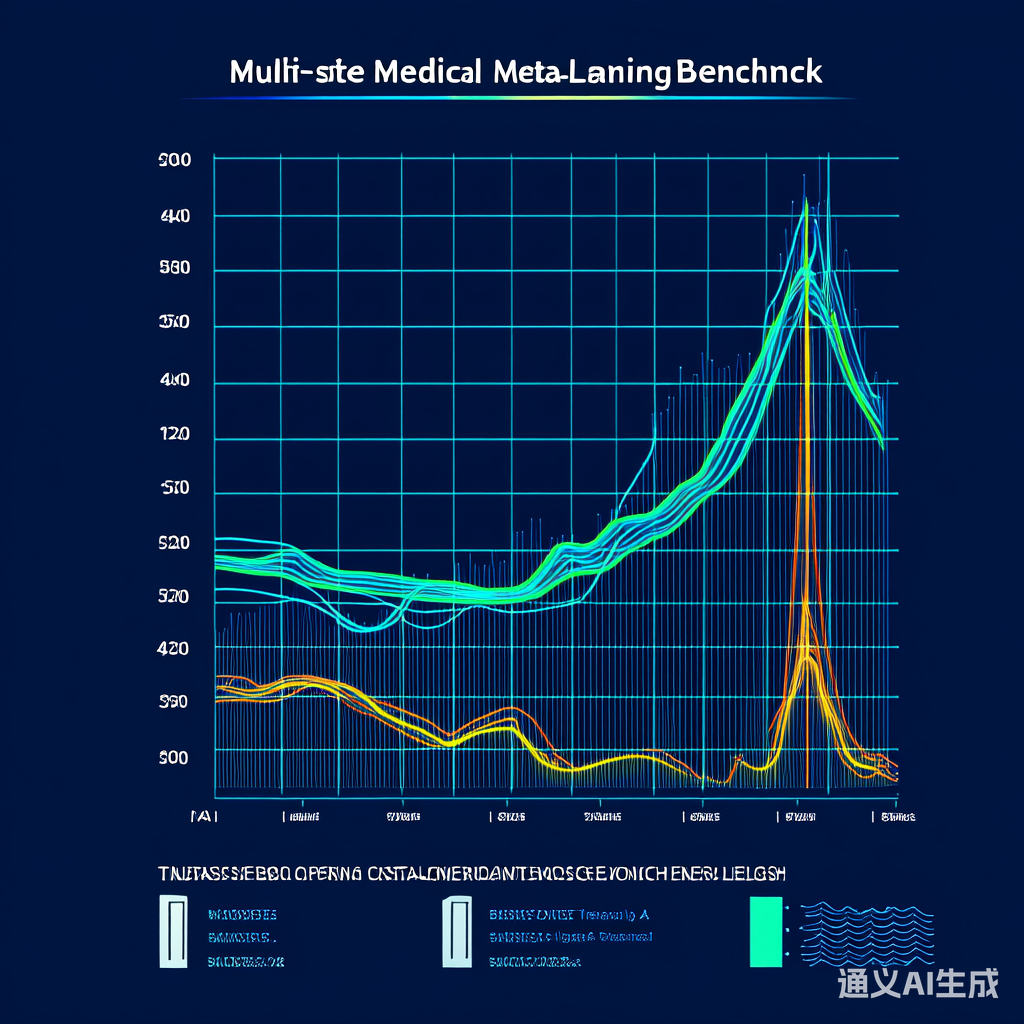

| 方法 | 平均AUC | 最差机构表现 |

|---|---|---|

| 单中心模型 | 0.82 | 0.65 |

| MAML元学习 | 0.89 | 0.78 |

| 联邦学习 | 0.85 | 0.71 |

- 隐私保护增强:结合差分隐私与联邦学习

- 小样本建模:开发更高效的原型网络

- 可解释性提升:构建可视化元知识追踪系统

# 可解释性分析示例

def visualize_meta_knowledge(meta_model, data_samples):

feature_importance = meta_model.get_attention_weights(data_samples)

plt.bar(range(len(feature_importance)), feature_importance)

plt.title("跨机构共性特征重要性")

plt.show()

元学习为破解医疗数据孤岛难题提供了创新路径,但其落地仍需解决数据异质性、模型可解释性等核心挑战。随着AutoML与隐私计算技术的融合,跨机构医疗AI将迎来更大发展空间。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)