ollama与deepseek

[Service]ExecStart=/usr/bin/dockerdRestart=on-failure[Install]WantedBy=multi-user.target(提示:docker.service的配置文件内容与在其相同目录下的sshd.service文件十分相似只需要修改ExecStart 的目录位置即可)systemctl daemon-reload && systemctl

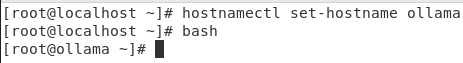

修改虚拟机的名字

下载安转包到root目录下

![]()

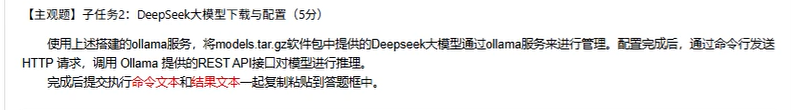

开始安装Docker服务,先解压 Docker 二进制文件包,并且把解压得到的可执行文件复制到/usr/bin/目录

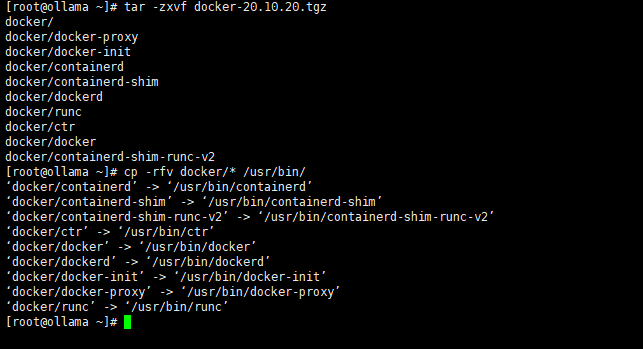

创建一个 systemd 服务配置文件,其目的是将 Docker 作为系统服务进行管理。配置文件里定义了服务的描述、启动顺序、执行命令以及重启策略等内容。

[Service]

ExecStart=/usr/bin/dockerd

Restart=on-failure

[Install]

WantedBy=multi-user.target

(提示:docker.service的配置文件内容与在其相同目录下的sshd.service文件十分相似只需要修改ExecStart 的目录位置即可)

启动并启用 Docker 服务,命令如下:

systemctl daemon-reload && systemctl restart docker && systemctl enable docker

![]()

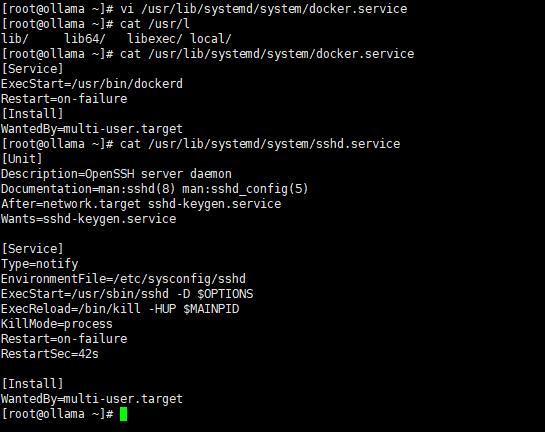

配置 Docker 镜像加速和 cgroup 驱动,最后重新加载配置并重启 Docker,命令如下:

[root@ollama ~]# vi /etc/docker/daemon.json

[root@ollama ~]# cat /etc/docker/daemon.json

{

"registry-mirrors": ["https://ebjpjftd.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

[root@ollama ~]# systemctl daemon-reload && systemctl restart docker

创建/root/ollama目录,导入Dify镜像:

[root@ollama ~]# mkdir /root/ollama

[root@ollama ~]# tar -zxvf /root/dify_images.tar.gz

dify_images/

dify_images/postgres_15-alpine.tar

dify_images/redis_6-alpine.tar

dify_images/nginx_latest.tar

dify_images/ubuntu_squid_latest.tar

dify_images/langgenius_dify-plugin-daemon_0.0.3-local.tar

dify_images/langgenius_dify-api_1.0.0.tar

dify_images/langgenius_dify-web_1.0.0.tar

dify_images/ollama_ollama_latest.tar

dify_images/langgenius_dify-sandbox_0.2.10.tar

dify_images/semitechnologies_weaviate_1.19.0.tar

dify_images/load.sh

[root@ollama ~]# cd /root/dify_images/ && sh load.sh

[root@ollama ~]# mkdir /root/ollama

[root@ollama ~]# tar zxvf /root/dify_images.tar.gz

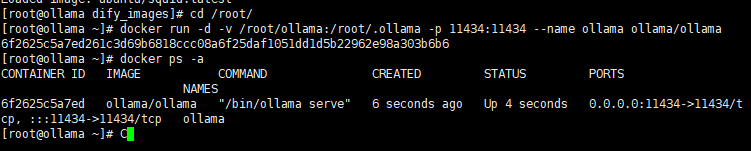

[root@ollama ~]# cd /root/dify_images/ && sh load.sh部署Ollama服务,返回结果如图所示。

[root@ollama dify_images]# cd /root/

[root@ollama ~]# docker run -d -v /root/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

6f2625c5a7ed261c3d69b6818ccc08a6f25daf1051dd1d5b22962e98a303b6b6

[root@ollama ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

6f2625c5a7ed ollama/ollama "/bin/ollama serve" 6 seconds ago Up 4 seconds 0.0.0.0:11434->11434/tcp, :::11434->11434/tcp ollama

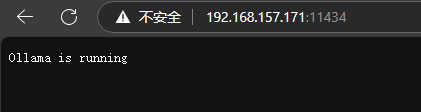

正常运行后,可以登录网站进行查看Ollama的状态,如图所示:

离线部署大模型

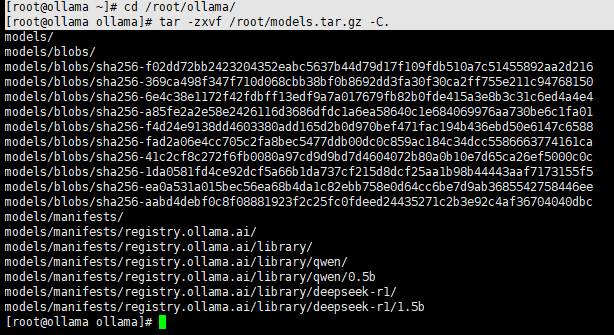

进入到Ollama模型存储目录,将打包好的models.tar.gz离线模型软件包解压到存储目录中,如图9所示,命令如下:

[root@ollama ~]# cd /root/ollama/

[root@ollama ollama]# tar -zxvf /root/models.tar.gz -C.

解压models.tar.gz

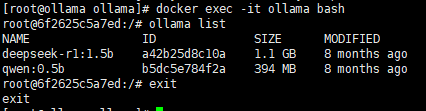

解压完成后,进行验证,查看是否成功部署离线模型,如图所示,命令如下:

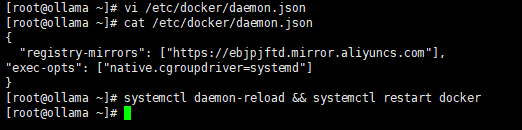

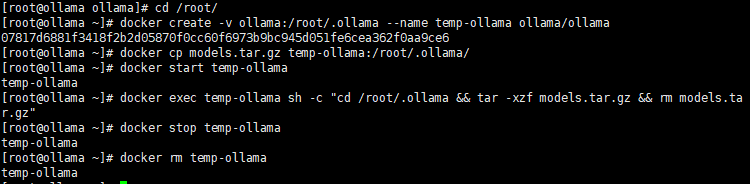

将 models.tar.gz 中的 DeepSeek 模型导入 Ollama

docker create -v ollama:/root/.ollama --name temp-ollama ollama/ollama

docker cp models.tar.gz temp-ollama:/root/.ollama/

docker start temp-ollama

docker exec temp-ollama sh -c "cd /root/.ollama && tar -xzf models.tar.gz && rm models.tar.gz"

docker stop temp-ollama

docker rm temp-ollama(创建一个新容器将虚拟机的文件通过docker传进去,传进去之后再把这个临时容器删除)

[root@ollama ollama]# cd /root/

[root@ollama ~]# docker create -v ollama:/root/.ollama --name temp-ollama ollama/ollama

07817d6881f3418f2b2d05870f0cc60f6973b9bc945d051fe6cea362f0aa9ce6

[root@ollama ~]# docker cp models.tar.gz temp-ollama:/root/.ollama/

[root@ollama ~]# docker start temp-ollama

temp-ollama

[root@ollama ~]# docker exec temp-ollama sh -c "cd /root/.ollama && tar -xzf models.tar.gz && rm models.tar.gz"

[root@ollama ~]# docker stop temp-ollama

temp-ollama

[root@ollama ~]# docker rm temp-ollama

temp-ollama

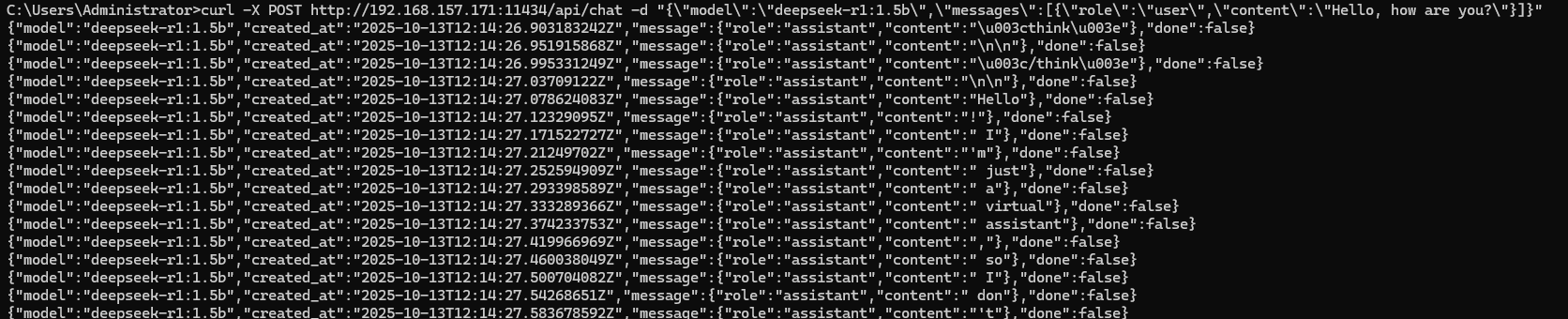

通过命令行发送 HTTP 请求调用 Ollama REST API 进行推理(以 Windows PowerShell 为例)

C:\Users\Administrator>curl -X POST http://192.168.157.171(虚拟机IP):11434/api/chat -d "{\"model\":\"deepseek-r1:1.5b\",\"messages\":[{\"role\":\"user\",\"content\":\"Hello, how are you?\"}]}"

结束!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)