VLA-LPAF:视觉-语言-动作模型的轻量级视角-自适应融合,实现更不受约束的机器人操作

25年9月来自理想汽车的论文“VLA-LPAF: Lightweight Perspective-Adaptive Fusion for Vision-Language-Action to Enable More Unconstrained Robotic Manipulation”。视觉-语言-动作 (VLA) 模型可以根据对周围环境的视觉观察来遵循文本指令。这种将多模态输入映射到动作的能力,源

25年9月来自理想汽车的论文“VLA-LPAF: Lightweight Perspective-Adaptive Fusion for Vision-Language-Action to Enable More Unconstrained Robotic Manipulation”。

视觉-语言-动作 (VLA) 模型可以根据对周围环境的视觉观察来遵循文本指令。这种将多模态输入映射到动作的能力,源于对 VLA 模型在大量标准演示上的训练。这些由第三人称全局和腕上本地摄像机捕捉的视觉观察在不同环境中不可避免地在数量和视角上有所不同,导致视觉特征存在显著差异。这种视角异质性限制 VLA 模型的通用性。鉴于此,本文首先提出轻量级模块 VLA-LPAF,以仅使用 2D 数据来提高 VLA 模型的视角自适应性。VLA-LPAF 使用来自单个视图的图像进行微调,并融合潜空间中的其他多视图观察,从而有效且高效地弥合由视角不一致造成的差距。用 VLA 模型 RoboFlamingo 实例化 VLA-LPAF 框架以构建 RoboFlamingo-LPAF。实验表明,RoboFlamingo-LPAF 在 CALVIN 数据集上平均任务成功率提升约 8%,在 LIBERO 数据集上平均任务成功率提升约 15%,在自定义模拟基准数据集上平均任务成功率提升约 30%。

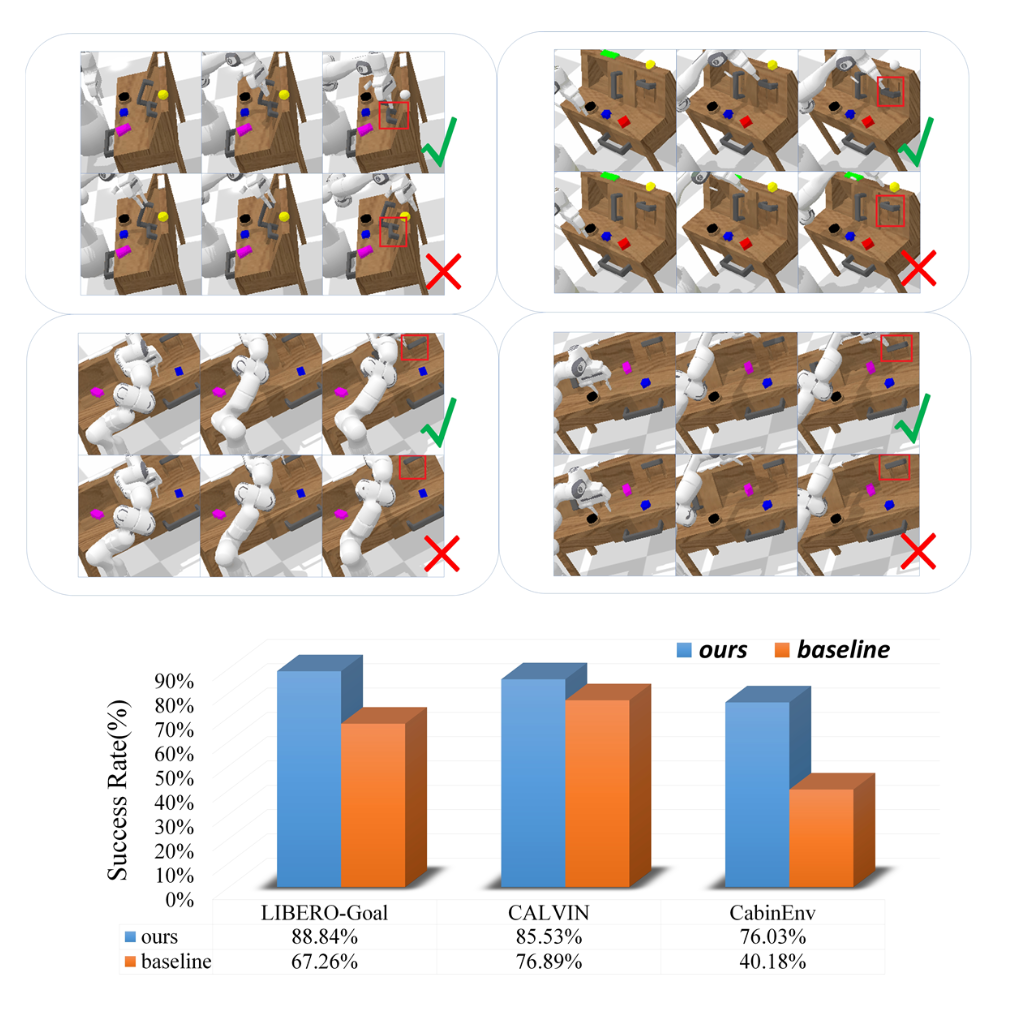

如图所示:在 CALVIN 模拟器中生成各种 2D 视角,比较结果表明,如果VLA 模型 RoboFlamingo 在提出的 VLA-LPAF 框架下构建,其能够执行这些任务。

针对 VLA 中多视角错位导致泛化性能下降问题的研究有:

• 通过数据收集:[26] 等解决方案基于 3D 统一进行数据集收集和合并,这需要大量工作来转换这些数据集的维度。在少数尝试从 2D 模态角度解决此问题的研究当中,[24] 只是通过在更多视角进行额外采集来收集观测图像,以提高模型的视角自适应性。

• 通过数据重渲染:[7, 8, 13] 等以多视角图像作为输入的 VLA 架构通过重新渲染重建的环境 3D 点云,从虚拟视角获取额外的观测视角。这些方法通常使用现成的 RGBD 相机获取深度信息并对场景进行 3D 重建。然后根据特定数量和视角要求在内部放置虚拟相机,以提供补充视角。

•本文的解决方案:如图所示,提出的 VLA-LPAF 框架通过有效融合透视信息,总体上提高 VLA 模型的泛化能力。与 [24] 不同,当添加其他视点的图像时,会按比例减少在原始视点捕获的图像数量,通过潜空间中的特征对齐保留透视多样性。在信息融合方面,[28] 采用类似的系统硬件设置,将来自多个视图的机械臂坐标系集成到统一的以相机为中心的坐标系中。这种方法减轻 VLA 模型通过 2D 图像进行映射操作的计算负担。然而,它不同于在潜空间中进行的纯基于 2D 融合方法。基于 3D 模态输入的 VLA 方案(如 [7、8、22、23])也应用融合的多透视图像,通过重渲染技术增强空间推理能力。与它们相比,本文提出的 VLA-LPAF 提供一个更轻量级的框架,仅涉及 2D 数据。

问题定义

VLA 模型通常可以看作是一个策略模型 π_θ(a_t | o_t, l),其主干 LLM π_θ 将语言指令 l 和在时间 t 观察的图像 o_t 多模态组合映射到未来可执行的动作 a_t 或动作块 {a_t},t=0~T。为简便起见,假设策略模型 π_θ 每次生成一个动作 a_t。

因此,第 s 个任务的第 i 条轨迹由每个时间步的动作、文本指令和观察的图像组成,表示为 τ_i = {a_t_s, o_t_s, l_s}。将训练数据集 τ = {{a_t_s, o_ts_s, l_i}} 中所有 S 个示例任务的轨迹视为专家行为,VLA 模型应克隆这些行为,并根据定义的损失函数迭代优化 π_θ(a_t | o_t, l) 中的网络参数 θ。

如果全局摄像机在用于微调的训练数据集 D_R 和用于部署的测试集 D_test 之间的安装位置不同,则从数据集中其他视角观察的图像 {oM_t} 与训练集中的图像 {oR_i} 之间的视觉特征差异将使 π_θ(a_t | o_t, l) 产生混淆,从而导致这些 OOD 案例的精度下降。 [24] 解决了这个问题,方法是将 D_R(为简便起见,后面称为参考视角)与从类似于 D_test(为简便起见,后面称为辅助视角)的 OOD 视角捕获的 2D 图像数据相加,并利用混合多视角数据集 D_M 对 π_θ(a_t | o_t,l) 进行微调,以缓解这个问题。

为了确保训练效率,[24] 按比例减少视觉特征 token 的数量,以平衡数据集的总大小。如前所述,这种操作提高了 OOD 案例的视角自适应性,但代价是牺牲了平均泛化性能。相比之下,本文 VLA-LPAF 构建一个基于 MLP 的轻量级可学习融合模块 F_θ′,该模块将从多视角观察图像 {oM_t} 中提取的潜特征进行对齐。

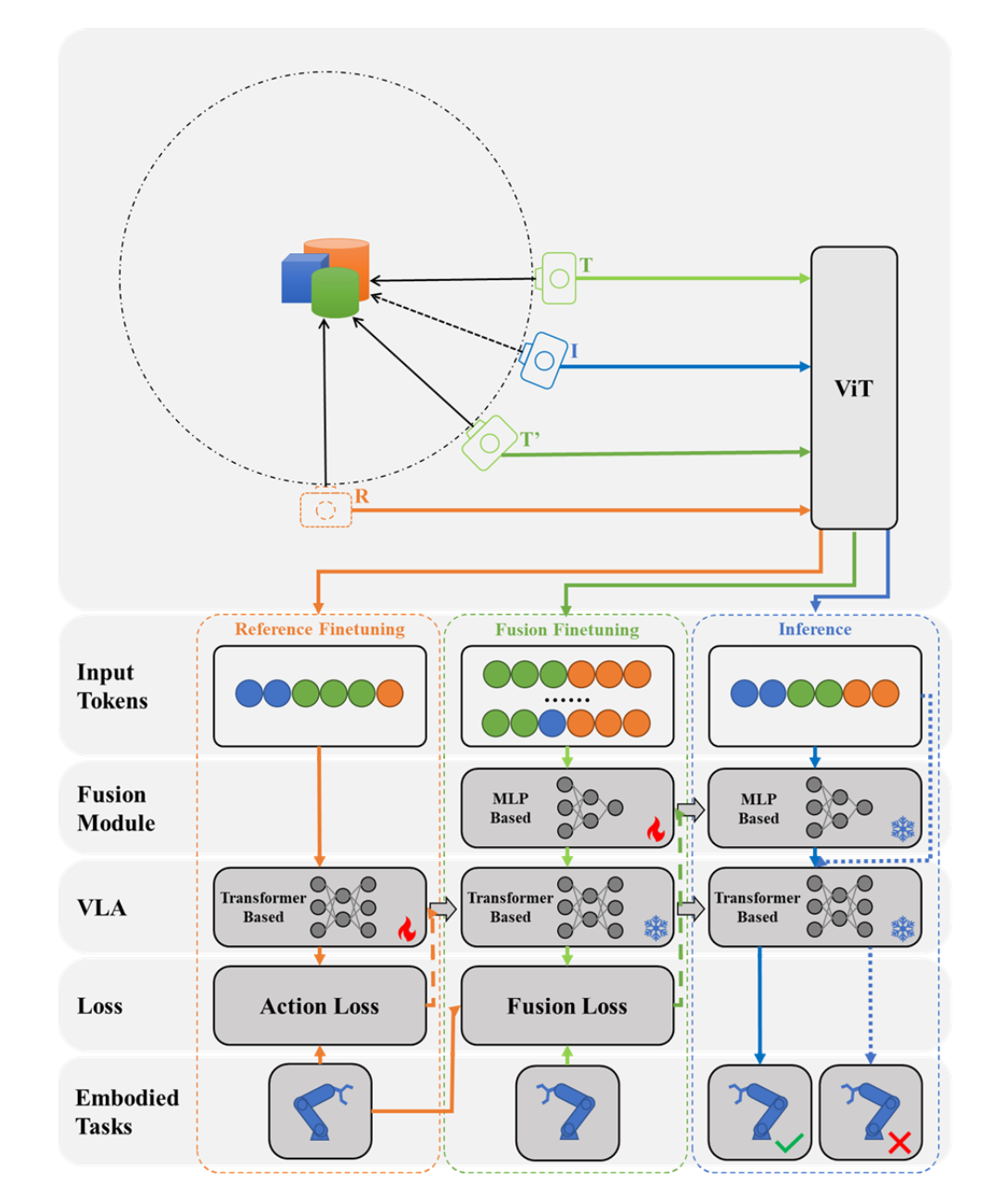

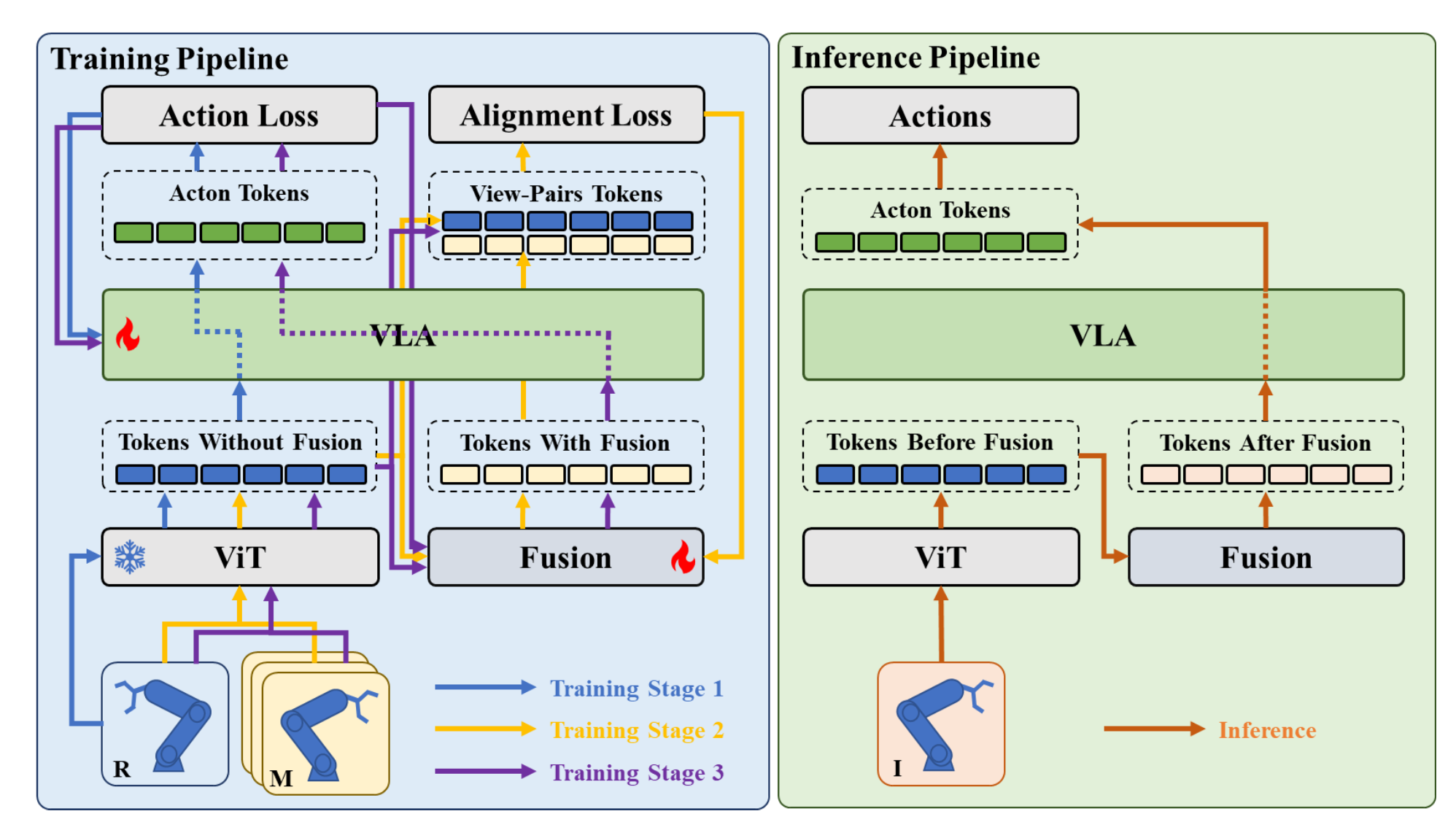

架构概述

除了常见 VLA 模型的必备组件外,VLA-LPAF 框架还包含一个额外的二维视角融合模块。在 VLA-LPAF 的训练阶段,依次使用仅包含参考视角的单视角数据集 D_R 和包含其他辅助视角的多视角数据集 D_M。分别在不同阶段对主干 LLM π_θ 和融合模块 F_θ′ 进行微调。在推理阶段,将观测的二维图像(包含全局图像和腕部图像)集 {o^G, L^_t} 编码、连接并融合到与参考视角对齐的潜空间中,然后将其发送到下游模块进行动作生成。VLA-LPAF 的通用训练和推理流程如图所示。

通过潜空间中的视角融合进行对齐

VLA-LPAF 的核心是融合模块,该模块根据参考视角和辅助视角的二维图像之间的潜视觉特征进行对齐。为了保持整个框架的轻量级特性,采用计算高效的 MLP 结构来构建融合模块。由于缺乏深度模态,选择由 ViT 编码器提取的潜特征,并基于 MLP 结构隐式地建立参考特征和辅助特征之间的适当关联。

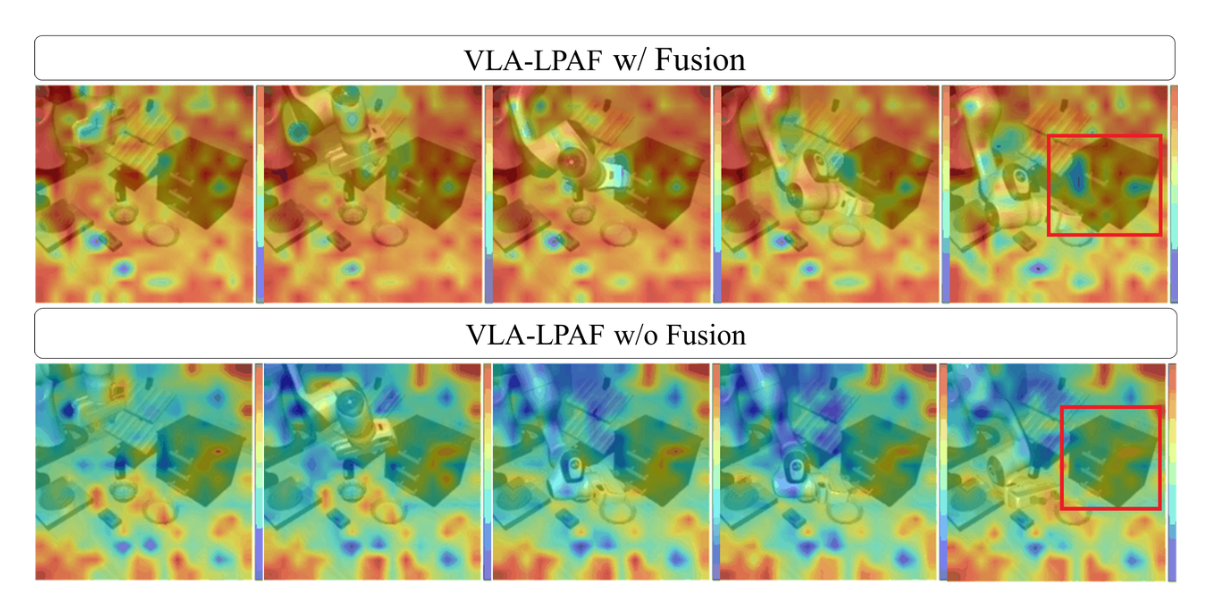

还通过可视化证明融合模块的有效性。如图所示的对比热图所示,融合模块中激活参数所表示的区域与目标正确地关联,而这些目标也与从不同视角执行具身任务密切相关。

训练策略

为提出的 VLA-LPAF 设计一个三阶段训练流程,以确保框架的每个主要组件都得到充分且全面的训练:

• 仅用于动作的单视图阶段:在此阶段,遵循标准的 VLA 微调原则。对于所有任务,仅使用来自 D_R 的观测值,并以任务指令 l 作为输入,并训练损失函数监督的策略模型 π_θ。在此阶段,冻结 ViT 主干,并仅微调 LLM 参数 θ。

• 仅用于融合的多视图阶段:在此阶段,训练融合模块,以使用 D_R 和 D_M 来增强视点对齐能力。为了保持 VLA-LPAF 的轻量级特性,除了原始的二维图像外,没有引入任何额外的工具或模态。因此,无法像 [22] 或 [26] 等针孔模型那样,通过相机参数精确地对齐异构视点之间的图像空间。受 [19] 结论的启发,即由多个 MLP 层组成的网络可以有效地将视觉特征投射到潜空间中的语言特征空间,采用类似的架构来执行这些从不同视角编码的观测图像之间对齐。在此阶段,仅使用损失来训练融合模块 θ′ 的参数。具体来说,应用渐进式策略来完成融合模块的训练,该策略逐步整合来自 D_M 的多视图数据,以减轻对齐模块的学习负担。这种方法比将所有数据都暴露给融合模块产生了更好的性能。

• 同时进行动作和融合的多视图阶段:在此阶段,整合上述两个阶段中学习的能力,并同时通过动作损失和对齐损失来调整 θ 和 θ′。

实现细节

为了回答以下问题,首先使用 RoboFlamingo [16] 实例化 VLA-LPAF 框架,生成 VLA 模型 RoboFlamingo-LPAF 进行实验。用 CALVIN [17]、LIBERO [21] 以及定制的 CabinEnv 模拟数据集,在由 8 块 NVIDIA A800 80 GB GPU 组成的集群上对其进行微调。CabinEnv 基于模拟的座舱环境,包含两个任务:按下按钮和扳动控制杆。

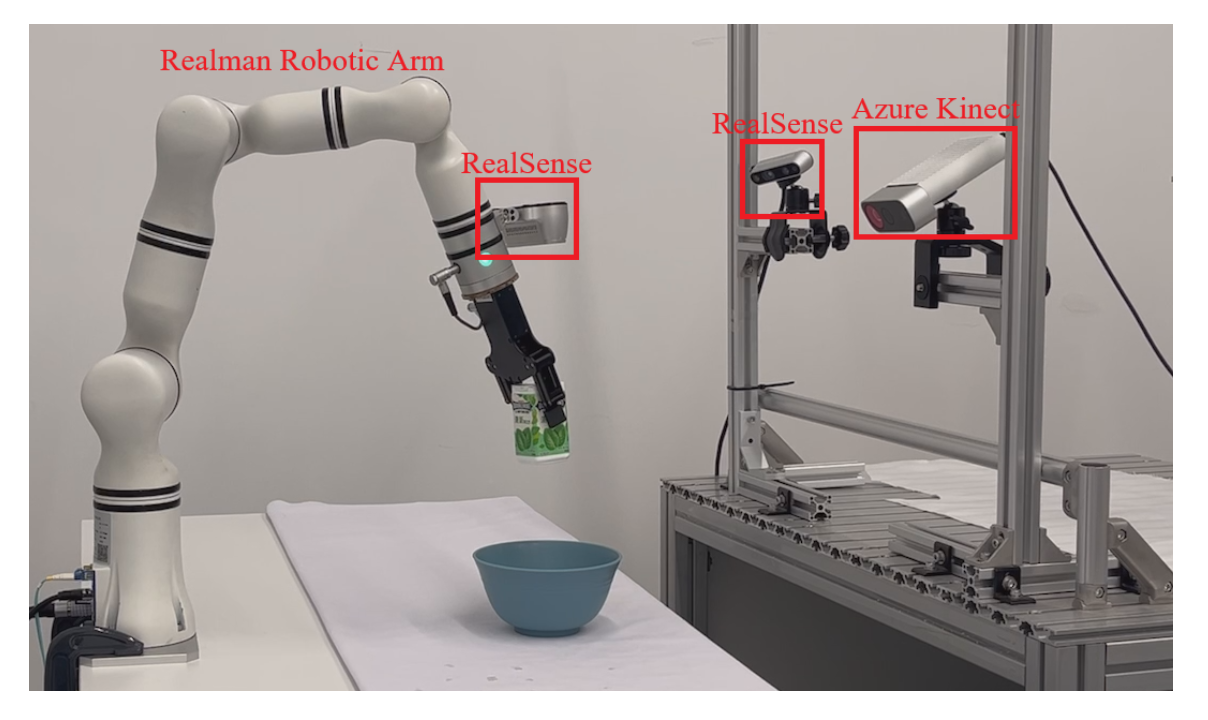

如图所示,用Realman RML系列机械臂搭建一个单臂机器人平台,并部署RoboFlamingo-LPAF模型来评估其在实际任务中的表现。用英特尔RealSense D415作为全局参考摄像头,并使用腕式2D观测摄像头。Azure Kinect用作全局辅助2D观测摄像头。来自不同视角的输入图像被调整为统一的224×224分辨率。由于只专注于验证模型的多视角适应性,因此仅关注模型的多视角适应性。

更多推荐

已为社区贡献129条内容

已为社区贡献129条内容

所有评论(0)