无缝集成,高效输出:我的GMI Cloud AI初体验

体验了一段时间这个GMI Cloud平台,整体感受还是挺不错的!它确实解决了我之前用AI模型时的一些痛点。首先,最大的感受就是:省心!以前想用不同的AI模型,得在各个平台之间反复横跳,每个都要注册、搞API密钥、研究怎么接入,确实麻烦。GMI Cloud就像个'AI模型大超市',把这些主流模型都集成进来了。一个账号就能直接使用,各种模型配置都是现成的,文档也写得比较清楚。其次,功能比较全面,是个'

前言

当前,大模型技术迭代日新月异,每周都有新的模型或版本发布(如GPT-4系列、Claude系列、Qwen系列等)。对于企业和开发者而言,这带来了巨大的机遇,同时也伴随着显著的痛点:

-

模型选择与迭代成本高: 频繁评估、切换和接入不同模型需要投入大量开发和运维资源。

-

AI Agent开发的复杂性: 构建一个真正有用的AI Agent不仅仅是调用一次API,它往往需要串联多个步骤(如语音转文本、文本总结、情感分析)、处理多模态数据(音频、视频、文本),并对输出质量有极高要求。

-

成本控制: 官方API的token计价方式在大量处理长视频、长音频内容时成本会急剧攀升。

最近在朋友推荐下发现了GMI Cloud平台,试用了一段时间后发现它能很好地解决这些痛点,今天就带大家一起来体验一下!

体验之旅

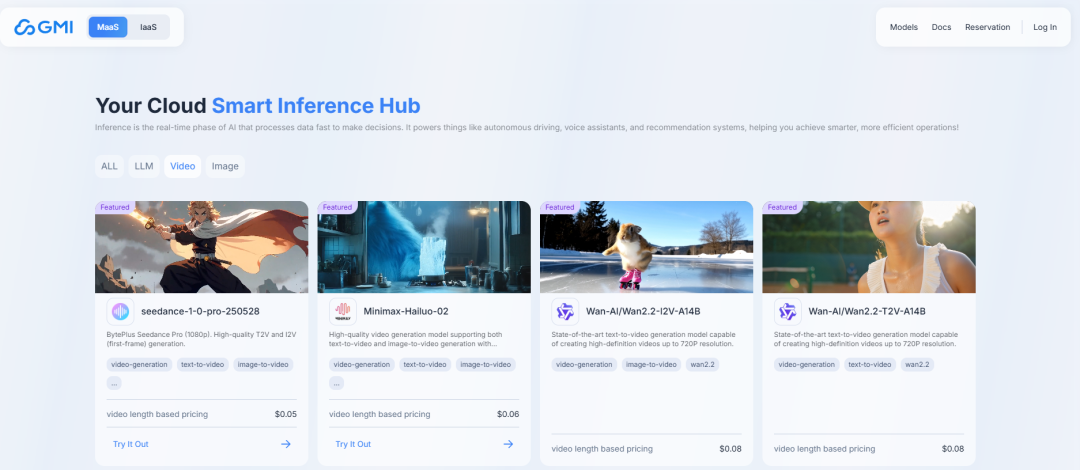

正如大家看到的一样,该平台支持大语言模型、视频模型和图片模型,集成了包括DeepSeek、OpenAI、Qwen、Meta等市面上最常见的大模型。所以无论你是需要生成图片还是视频,在这里都能找到合适的选择,确实省去了在不同平台间反复切换的麻烦。

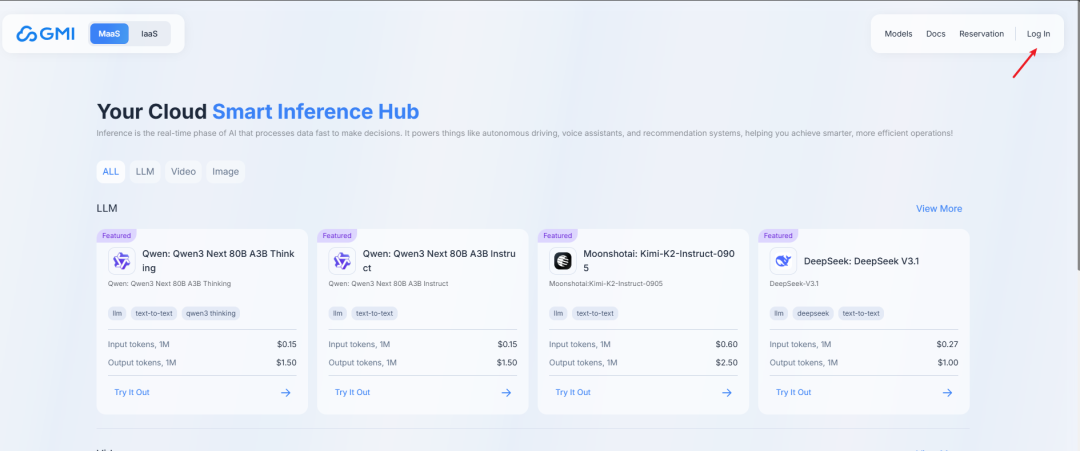

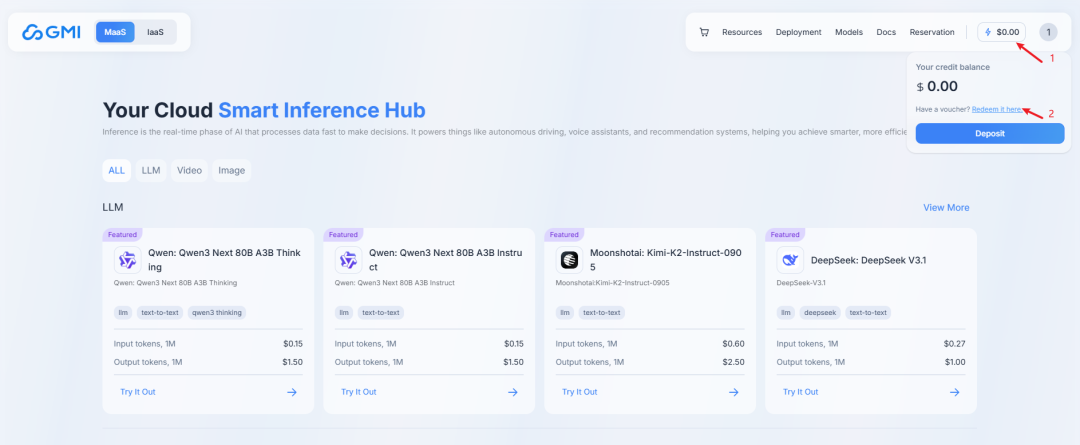

目前有免费的体验额度,我也发现了一个兑换码TRYIENOW,可以兑换解锁5美金使用额度,根据以下步骤领取吧。

领取Token

官网登录,未注册的先点击注册

点击右上角余额,再点击Redeem it here,然后输入兑换码就可以领取免费的使用额度了

也如其他大模型一样,在体验之前,需要进行简单的配置——配置API密钥。比较省心的是,只需要配一次密钥,旗下的所有产品就都能用了,不用来回折腾。

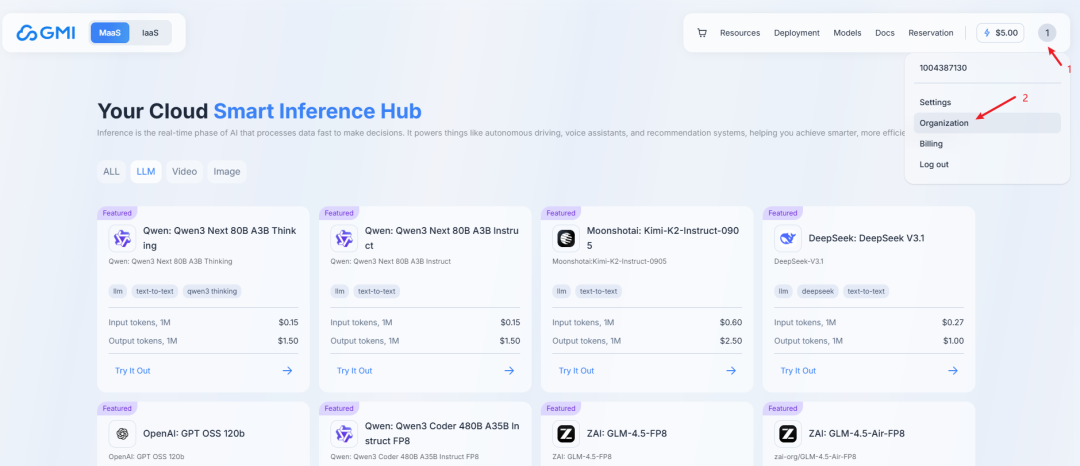

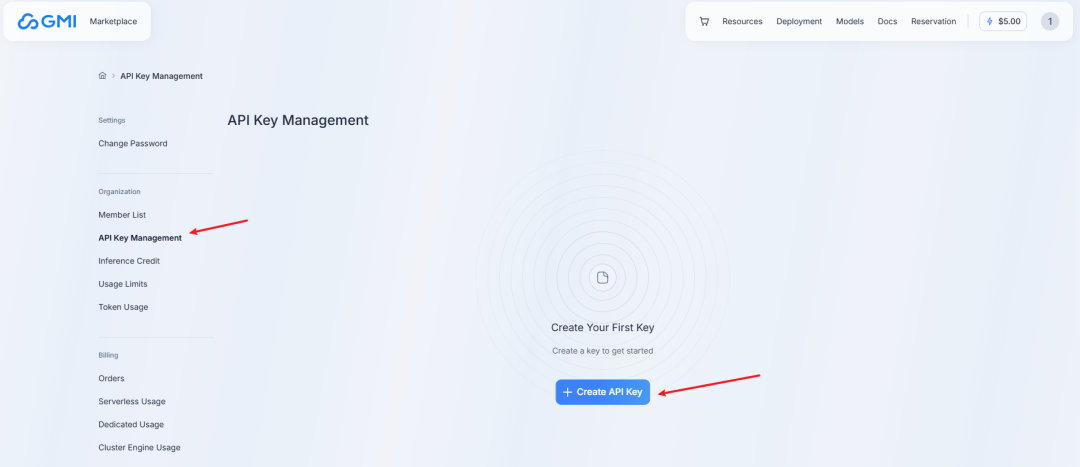

配置API密钥

导航到控制台中的组织设置

转到 API 密钥部分,创建用于编程访问的新 API 密钥

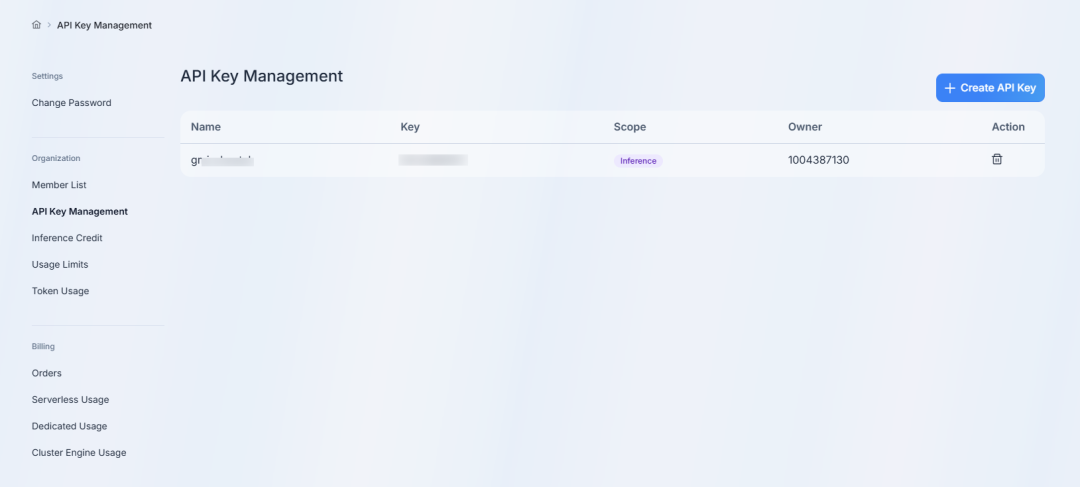

安全地保存 API 密钥(它只会显示一次),如图,我们就创建完了

LLM体验

DeepSeek-V3.1 是 DeepSeek 旗舰开放权重 LLM 的最新升级。Instruct 模型现已完全集成到 GMI Cloud 推理引擎中。它支持 128K 令牌上下文处理、开源可访问性以及更好地集成使用工具的 AI 代理。

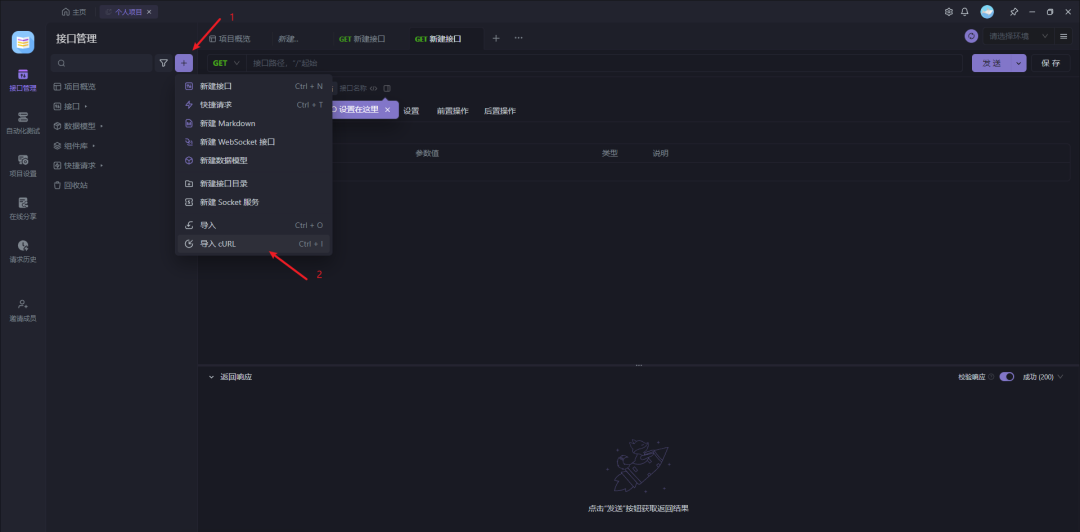

接下来演示下如何通过API调用的方式使用LLM,我在ApiFox中模拟一下

curl --request POST \

--url https://api.gmi-serving.com/v1/chat/completions \

-H 'Content-Type: application/json' \

-H 'Authorization: Bearer *************' \

--data '{

"model": "deepseek-ai/DeepSeek-V3.1",

"messages": [

{"role": "system", "content": "你是一个AI助手"},

{"role": "user", "content": "列出中国十个最值得出游的城市和他们的特色"}

],

"temperature": 0,

"max_tokens": 500

}'

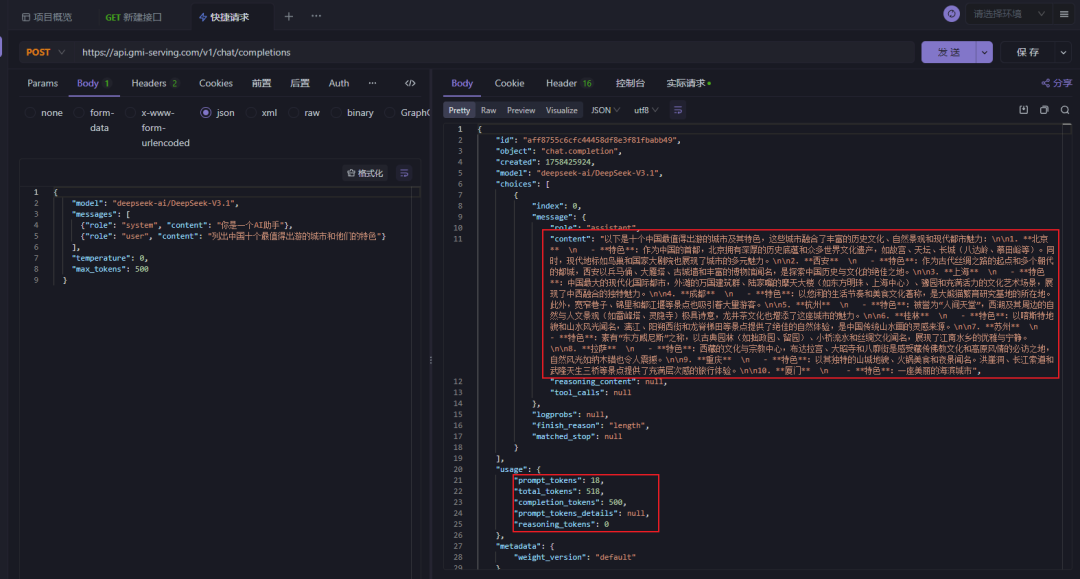

给大家展示一下演示结果,返回的报文中既有模型的分析结果,还有token的使用情况,十分详细。

从演示中能看出,集成过程确实比较友好,几步就能完成接入,大幅降低了技术门槛,让开发者能快速上手构建智能应用。API返回结果采用标准的JSON格式,结构清晰、通用性强,能够轻松被各种编程语言和系统解析处理。

视频生成探索

相信大家在工作中经常会用到视频生成这个功能,比如制作宣传视频、产品演示,甚至是短视频内容。Seedance 1.0 是字节跳动的旗舰双语视频生成基础模型,它现在可以在 GMI Cloud 推理引擎上使用。

我们也同样在ApiFox中进行演示

curl -X POST "https://console.gmicloud.ai/api/v1/ie/requestqueue/apikey/requests" \

-H "Authorization: Bearer YOUR_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "seedance-1-0-pro-250528",

"payload": {

"prompt": "The head gradually rises, revealing the climber`s back.",

"first_frame": "https://storage.googleapis.com/gmi-video-assests-prod/public-assets/person-walking-winter-snow-boots-1193959625-770x533-1_jpg.jpeg",

"duration": 8,

"resolution": "720p",

"ratio": "16:9",

"camerafixed": false,

"seed": 42,

"watermark": false

}

}'

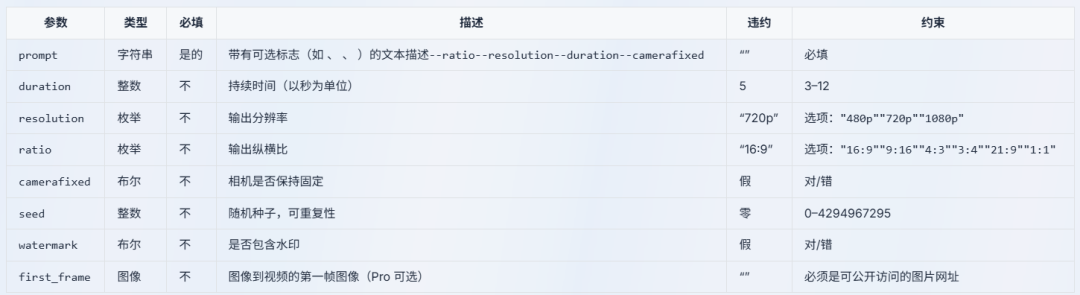

参数介绍如下

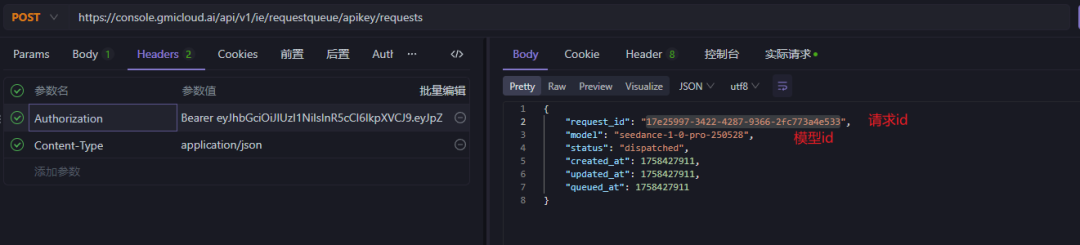

模拟请求如下

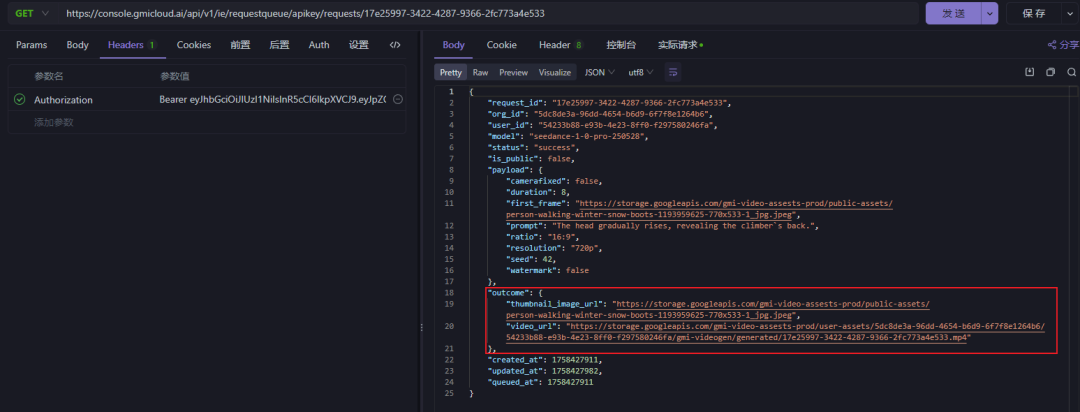

然后我们拿着请求id去查询一下视频是否生成

curl -X GET "https://console.gmicloud.ai/api/v1/ie/requestqueue/apikey/requests/17e25997-3422-4287-9366-2fc773a4e533" \

-H "Authorization: Bearer YOUR_API_KEY"

以下请求中的红框部分就是我们生成的视频了,包括封面和视频链接,我们打开查看一下

封面图

视频

,时长00:08

专用部署尝试

虽然说标准化的API具有快速集成、按需付费和免维护等优点,是高效且经济的选择。但是对于高并发、大数据量、延迟极其敏感的业务场景来说,可能会遇到性能、成本和控制力方面的瓶颈。此时,专用部署就展现出了不可替代的优势:它提供独享的算力,保障高性能和稳定低延迟,在大规模使用时能有效控制总体成本,同时提供完全的数据隔离和合规保障。

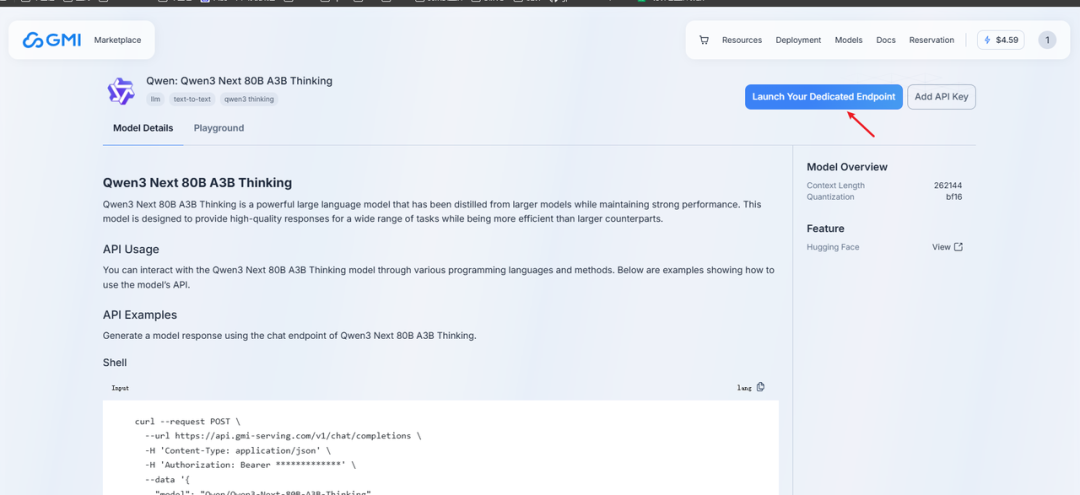

为了体验更稳定的服务,我尝试了GMI Cloud的H200专用服务器部署功能。

点击大模型左上角的 Launch Your Dedicated Endpoint

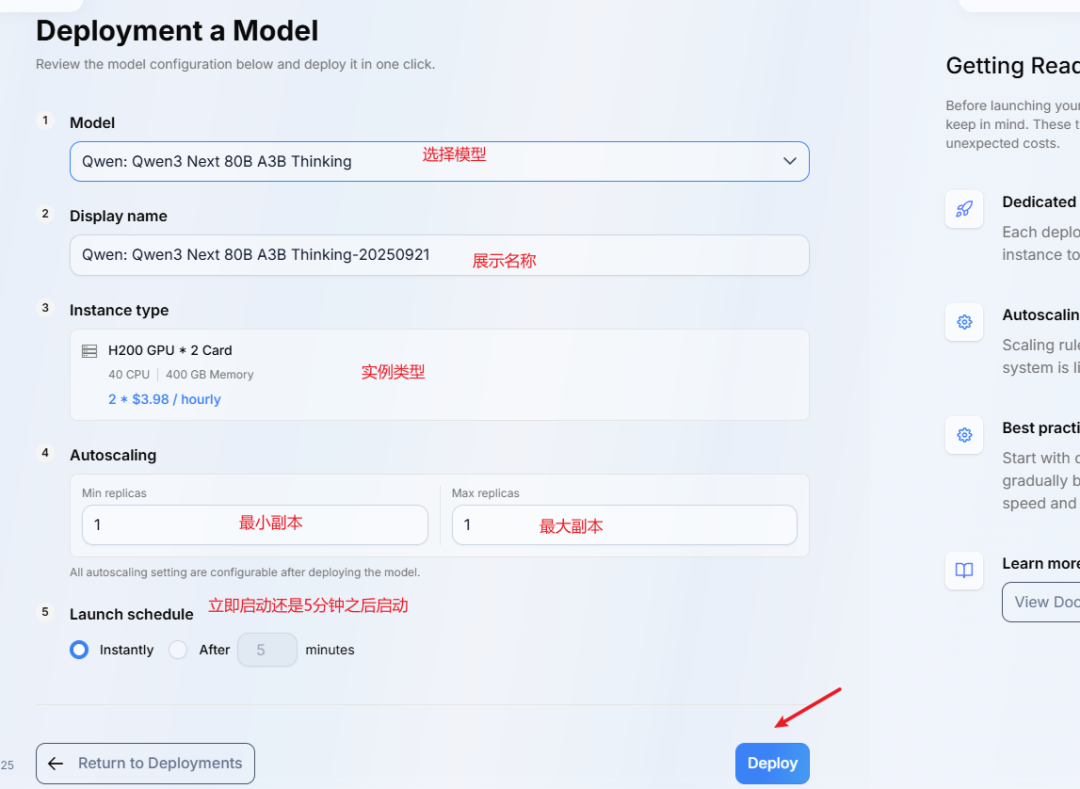

设置参数之后点击deploy进行部署

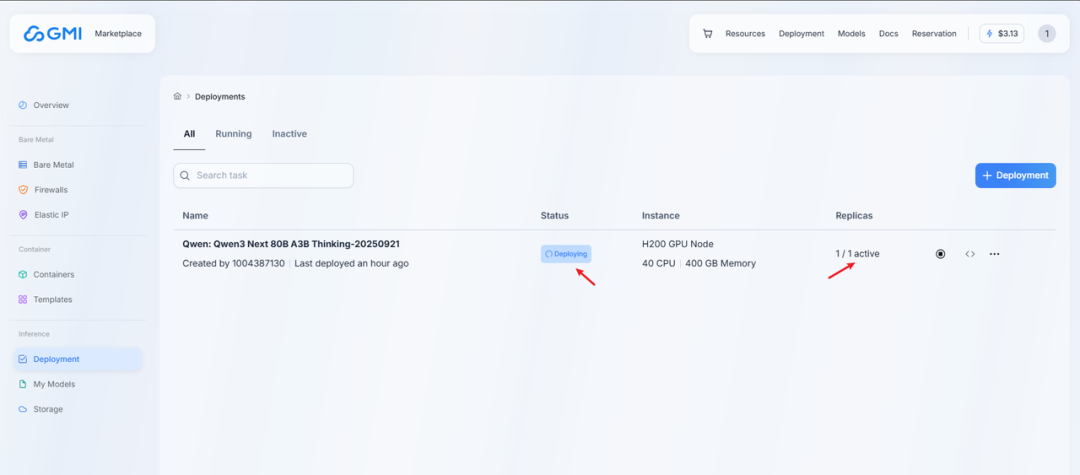

查看部署状态

GMI Cloud的专用部署确实比较简单便捷,整个流程还算顺畅。

使用总结

体验了一段时间这个GMI Cloud平台,整体感受还是挺不错的!它确实解决了我之前用AI模型时的一些痛点。 首先,最大的感受就是:省心!以前想用不同的AI模型,得在各个平台之间反复横跳,每个都要注册、搞API密钥、研究怎么接入,确实麻烦。GMI Cloud就像个'AI模型大超市',把这些主流模型都集成进来了。一个账号就能直接使用,各种模型配置都是现成的,文档也写得比较清楚。

其次,功能比较全面,是个'多面手'。它不仅支持最基础的文本对话,还能搞视频生成!这意味着,无论是想做个聊天应用、自动生成内容的工具,还是做视频相关的应用,在一个平台上就能搞定大部分需求。

再说说实际使用体验:速度和质量都还可以!背后应该是用了不错的算力支持,模型响应速度比较快,出来的内容质量也挺好的,感觉和直接使用官方接口效果差不多。专为AI应用打造,支持专用部署,对于有数据安全要求的项目来说比较有用。

最后,成本控制方面做得不错。可以按需付费,用了多少算多少,不会造成浪费。而且所有模型都能在一个后台统一管理和监控,花费情况一目了然。

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)