LLM+KG融合技术全解析:解决大模型幻觉与知识过时问题,必看收藏!

文章深入探讨了大语言模型(LLM)与知识图谱(KG)的融合技术,旨在解决大模型存在的幻觉、知识过时和推理能力不足等核心问题。从技术演进看,正从"单向增强"走向"双向协同"新范式,在医疗、法律等垂直领域展现巨大价值。文章系统分析了多种融合方法、评估体系及未来挑战,为解决多跳推理瓶颈和实现"零幻觉"可追溯生成提供了技术路径,是学习大模型与知识图谱融合的优质指南。

简介

文章深入探讨了大语言模型(LLM)与知识图谱(KG)的融合技术,旨在解决大模型存在的幻觉、知识过时和推理能力不足等核心问题。从技术演进看,正从"单向增强"走向"双向协同"新范式,在医疗、法律等垂直领域展现巨大价值。文章系统分析了多种融合方法、评估体系及未来挑战,为解决多跳推理瓶颈和实现"零幻觉"可追溯生成提供了技术路径,是学习大模型与知识图谱融合的优质指南。

从技术演进看,我们正从早期的"单向增强"(RAG检索、知识注入)走向"双向协同"新范式——LLMs驱动KG动态演化,KG引导LLMs可控推理。特别在医疗、法律等垂直领域,这种融合展现出巨大价值:通过结构化推理链、符号约束解码等技术,不仅解决了传统RAG的多跳推理瓶颈,更实现了"零幻觉"的可追溯生成。今天阿东从多个维度带你了解一下KG+LLM的现状以及未来可以继续做的方向!!!

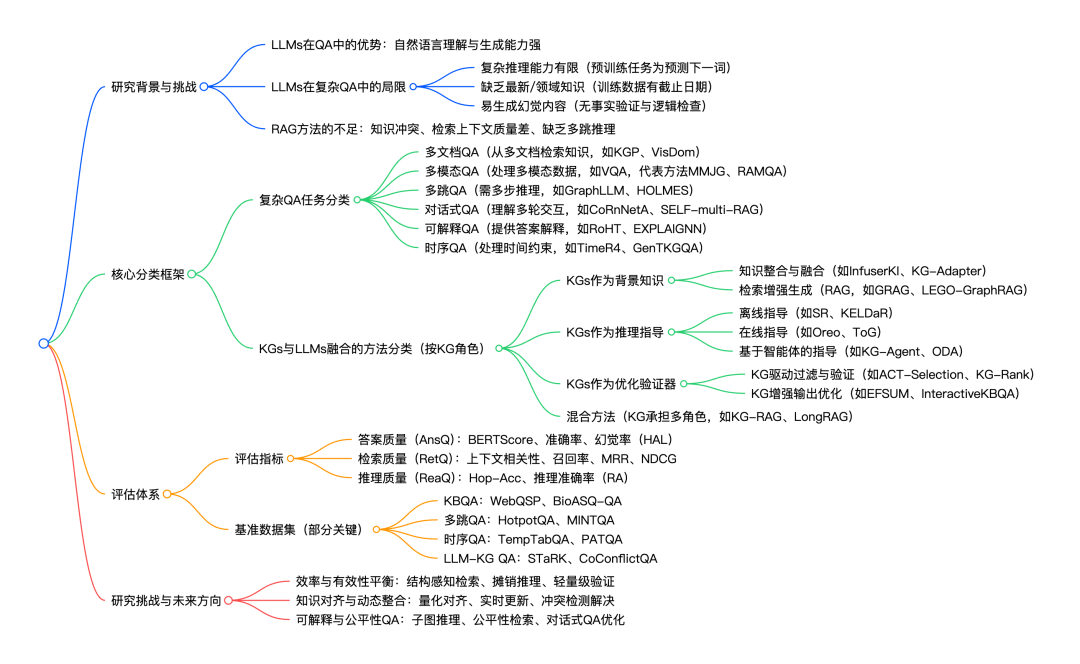

一、思维导图

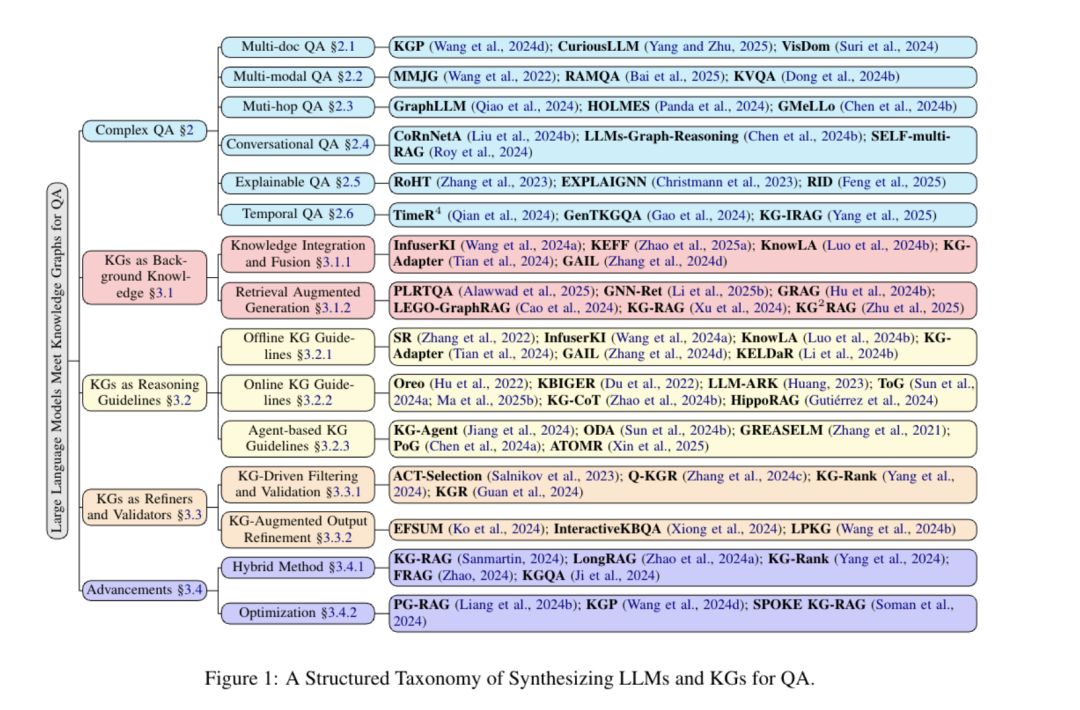

二、详细总结

2.1 研究背景与核心问题

2.1.1 LLMs在QA中的现状

- 优势:LLMs凭借出色的自然语言理解与生成能力,在KBQA、KGQA、CDQA等基础QA任务中表现优异。

- 局限:面对复杂QA任务时存在三大核心问题:

- 推理能力不足:预训练任务为“预测文本序列下一词”,导致复杂逻辑推理能力薄弱。

- 知识时效性与领域性缺失:训练数据有固定截止日期,无法提供最新知识或特定领域(如医疗、法律)知识。

- 幻觉问题:缺乏事实验证与逻辑一致性检查,易生成虚假或矛盾内容。

2.1.2 RAG方法的缺陷

检索增强生成(RAG)通过从文档检索上下文辅助LLMs,但仍存在:

- 知识冲突:LLMs内部知识与外部检索知识不一致,导致答案矛盾。

- 检索质量差:生成答案的准确性依赖检索上下文的相关性,无关上下文会引发错误。

- 缺乏多跳推理:无法处理需全局/总结性上下文的问题,难以完成多步推理。

2.2 复杂QA任务分类及典型方法

复杂QA需处理知识融合、多步推理等问题,研究将其分为6类,各类任务及代表方法如下表:

| 复杂QA类型 | 核心挑战 | 代表方法 | 方法亮点 |

|---|---|---|---|

| 多文档QA | 从多文档高效检索相关知识,降低延迟 | KGP(Wang et al., 2024d) | 引入LLM-based图遍历智能体检索KG知识 |

| VisDom(Suri et al., 2024) | 融合多模态知识,基于CoT推理的多模态RAG | ||

| 多模态QA | 跨模态知识检索与融合(如文本+图像) | MMJG(Wang et al., 2022) | 基于知识感知注意力的自适应知识选择 |

| RAMQA(Bai et al., 2025) | 多任务学习整合排序与生成模型训练 | ||

| 多跳QA | 分解复杂问题为单跳子问题,多步推理 | GraphLLM(Qiao et al., 2024) | LLM分解问题,GNN检索子图进行推理 |

| GMeLLo(Chen et al., 2024b) | 提取事实三元组/关系链,整合KG与LLM知识 | ||

| 对话式QA | 理解多轮交互上下文,优化答案连贯性 | CoRnNetA(Liu et al., 2024b) | LLM重写问题,强化学习优化交互理解 |

| SELF-multi-RAG(Roy et al., 2024) | 检索对话历史摘要,复用知识增强生成 | ||

| 可解释QA | 提供答案的事实依据与推理过程 | RoHT(Zhang et al., 2023) | 构建分层问题分解树(HQDT),概率推理 |

| EXPLAIGNN(Christmann et al., 2023) | 构建异构图,基于GNN生成解释证据 | ||

| 时序QA | 理解时间约束,整合时序知识推理 | TimeR4(Qian et al., 2024) | “检索-再检索-重排序”流水线,时序知识微调 |

| KG-IRAG(Yang et al., 2025) | 增量检索知识,评估 sufficiency,处理时间敏感问题 |

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

2.3 KGs与LLMs融合的方法分类(按KG角色)

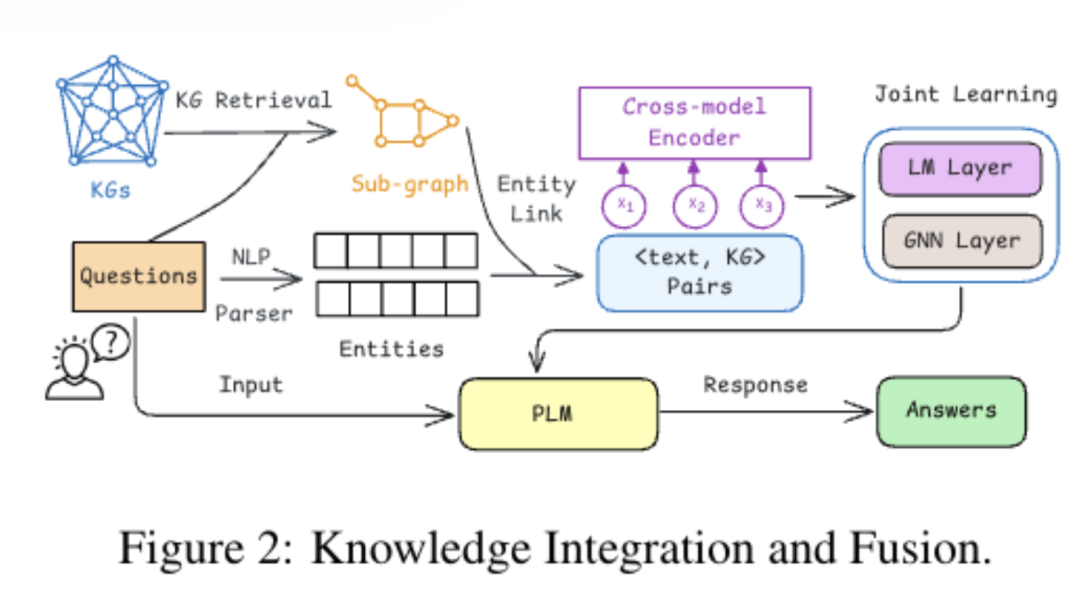

2.3.1 KGs作为背景知识

- 核心目标:为LLMs提供结构化事实知识,弥补其知识缺口。

- 两大技术范式:

- 知识整合与融合:将KG知识融入LLMs,代表方法如下表:

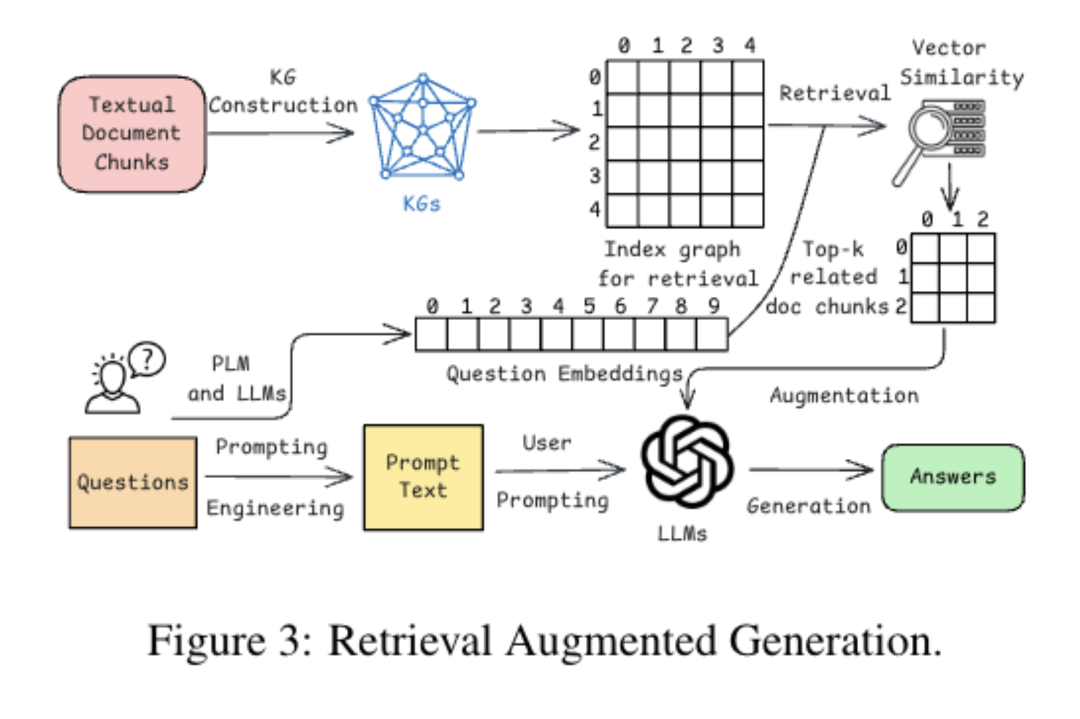

- 检索增强生成(RAG):从KG检索子图辅助生成,代表方法:

-

GRAG(Hu et al., 2024b):检索Top-k子图,GNN对齐图嵌入与文本嵌入。

-

LEGO-GraphRAG(Cao et al., 2024):分解检索为“子图提取-路径过滤-路径优化”,提升推理能力。

-

KG²RAG(Zhu et al., 2025):检索KG子图,扩展文本块以增强生成。

-

方法 核心技术 所用LLM 所用KG 适用QA类型 InfuserKI(Wang et al., 2024a) 自适应知识选择与过滤 Llama-2-7B UMLS、Movie KG KGQA KG-Adapter(Tian et al., 2024) 参数高效微调+联合推理 Llama-2-7B-base ConceptNet、Freebase KGQA、MCQA GAIL(Zhang et al., 2024d) GAIL微调 Llama-2-7B、BERTa Freebase KGQA

- 优势:知识覆盖范围广;局限:知识静态,难更新;KG需求:高领域覆盖率。

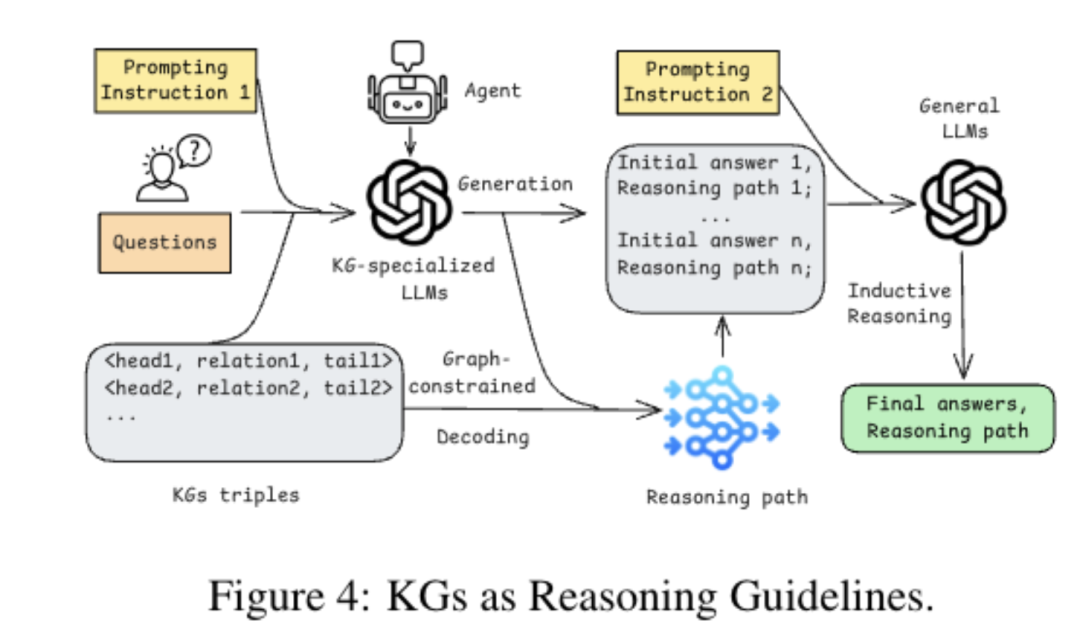

2.3.2 KGs作为推理指导

- 核心目标:为LLMs提供推理路径或约束,提升复杂推理能力。

- 三类实现方式:

- 离线指导:推理前提供KG路径/子图,如SR(训练独立子图检索器)、KELDaR(提取子图增强LLM)。

- 在线指导:推理中动态引导,如Oreo(KG随机游走推理)、ToG(LLM迭代beam search遍历KG)。

- 基于智能体的指导:将KG整合进智能体系统,如KG-Agent(多工具整合,自主选工具)、ODA(全局观察驱动推理)。

- 优势:支持多跳推理;局限:计算开销大;KG需求:丰富的关系路径。

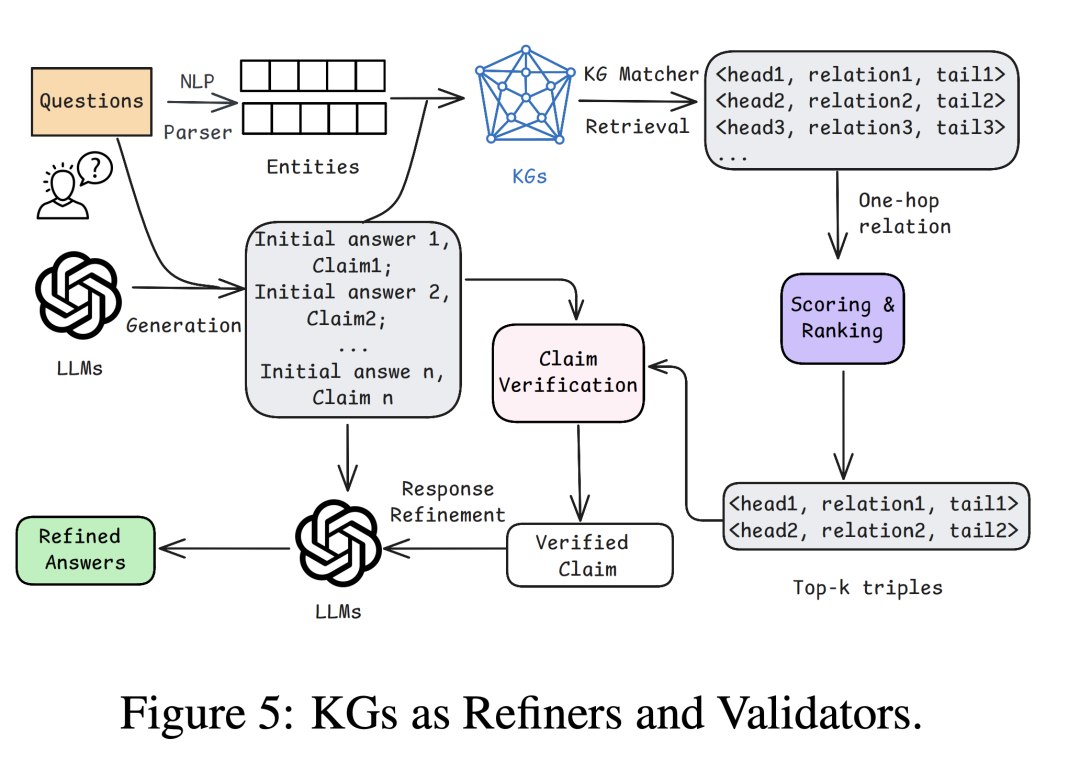

2.3.3 KGs作为优化验证器

- 核心目标:过滤LLM错误输出,验证答案事实性,提升可靠性。

- 两大技术方向:

- KG驱动过滤与验证:如ACT-Selection(基于Wikidata类型过滤答案)、KG-Rank(医疗KG+重排序提升可信度)。

- KG增强输出优化:如EFSUM(KG事实总结优化零样本QA)、InteractiveKBQA(多轮交互优化输出)。

- 优势:减少幻觉;局限:验证延迟;KG需求:高准确性与时效性。

2.3.4 混合方法

- 核心特点:KG同时承担多种角色(如背景知识+推理指导+验证),代表方法:

- KG-RAG(Sanmartin, 2024):Chain-of-Explorations排序KG节点,选相关知识喂给LLM。

- LongRAG(Zhao et al., 2024a):混合检索器选Top-k块,CoT过滤,KG提示增强生成。

- 优势:弥补单一方法局限;局限:计算成本高;KG需求:动态适应性。

2.4 评估体系

2.4.1 评估指标

| 指标类别 | 具体指标 | 作用 |

|---|---|---|

| 答案质量(AnsQ) | BERTScore、准确率、幻觉率(HAL)、人类验证完整性(HVC) | 衡量答案正确性、忠实性 |

| 检索质量(RetQ) | 上下文相关性、召回率、MRR、NDCG | 衡量检索上下文的相关性与完整性 |

| 推理质量(ReaQ) | Hop-Acc、推理准确率(RA) | 衡量多跳推理的正确性 |

2.4.2 关键基准数据集

| 数据集类别 | 代表数据集 | 核心特点 |

|---|---|---|

| KBQA | WebQSP(tau Yih et al., 2016) | 含SPARQL查询,用于KG-based QA |

| 多跳QA | HotpotQA、MINTQA(He et al., 2024) | MINTQA支持评估LLMs对新/长尾知识的处理 |

| 时序QA | TempTabQA(Gupta et al., 2023)、PATQA(Meem et al., 2024) | 处理半结构化表格/ Wikidata的时序问题 |

| LLM-KG QA | STaRK(Wu et al., 2024a)、CoConflictQA(Huang et al., 2025) | 评估LLM-KG融合的检索性能/上下文忠实性 |

2.5 挑战与未来方向

效率与有效性平衡:

- 瓶颈:结构感知检索(需保留KG拓扑信息)、摊销推理(减少重复KG查询)、轻量级验证(替代LLM验证)。

- 方向:分层图分区、子图缓存、概率逻辑程序验证。

知识对齐与动态整合:

- 瓶颈:缺乏量化对齐指标、KG知识过时、知识冲突。

- 方向:对比探测量化对齐、参数高效更新(如LoRA)、贝叶斯信任网络解决冲突。

可解释与公平性QA:

- 瓶颈:子图推理成本高、KG知识偏见、单轮QA局限。

- 方向:结构感知子图检索、公平性重排序、多轮对话式QA。

- 关键问题及答案

问题1:在LLMs与KGs融合的QA方法中,KG承担“背景知识”角色时,核心技术范式有哪些?各自的优势是什么?

答案:KG承担“背景知识”角色时,核心技术范式为知识整合与融合和检索增强生成(RAG) 两类:

- 知识整合与融合:通过参数高效微调(如KG-Adapter)、自适应知识选择(如InfuserKI)等方式,将KG知识直接融入LLMs的参数或训练过程;优势:实现LLMs与KG知识的深度耦合,无需额外检索步骤,响应速度快,适合领域内固定知识的QA任务。

- 检索增强生成(RAG):从KG中检索与问题相关的子图(如GRAG检索Top-k子图、LEGO-GraphRAG分解检索流程),将子图转化为文本上下文后输入LLMs;优势:知识可动态更新(只需更新KG),避免LLMs重训练,适合开放域或知识频繁变化的QA任务(如实时资讯QA)。

问题2:针对“多跳QA”这类复杂任务,LLMs与KGs融合的方法如何解决其“多步推理”的核心挑战?

答案:多跳QA需将复杂问题分解为单跳子问题并逐步推理,LLMs与KGs融合主要通过以下方式解决该挑战:

- 问题分解与子图检索结合:利用LLMs的自然语言理解能力分解问题(如GraphLLM将多跳问题拆分为单跳子问题),同时通过GNN或KG检索器获取每个子问题对应的KG子图,基于子图知识生成子答案,最终整合为总答案;

- 超关系KG增强推理:构建包含实体、关系及额外属性的超关系KG(如HOLMES基于实体-文档图构建超关系KG),为每一步推理提供更丰富的上下文,减少推理歧义;

- 事实链提取与推理引导:从KG中提取实体间的关系链(如GMeLLo提取事实三元组和关系链),将其作为推理线索输入LLMs,引导LLMs按“关系链顺序”完成多步推理,避免推理路径偏离。

问题3:当前LLMs与KGs融合的QA系统在“知识时效性”和“推理效率”上存在哪些瓶颈?有哪些潜在的解决思路?

答案:

(1)知识时效性瓶颈及解决思路

- 瓶颈:LLMs训练数据有截止日期,无法获取最新知识;KG虽可更新,但LLMs与KG知识对齐困难,易出现“知识冲突”(如LLMs旧知识与KG新知识矛盾)。

- 解决思路:

- 动态KG更新与检索:采用“流式KG”存储实时知识,RAG过程中优先检索最新子图(如KG-IRAG的增量检索机制);

- 参数高效知识注入:通过LoRA等轻量级微调模块,将KG中的新知识注入LLMs(如LoRA模块按“KG更新增量”调整参数),无需全量重训练;

- 冲突检测与解决:引入贝叶斯信任网络或多源知识蒸馏(如PIP-KAG的参数剪枝),量化LLMs与KG知识的置信度,选择高置信度知识生成答案。

(2)推理效率瓶颈及解决思路

- 瓶颈:多跳推理需频繁遍历大规模KG,导致计算开销大、 latency高;同时,检索子图时易获取冗余信息,增加LLMs处理负担。

- 解决思路:

- 结构感知检索优化:采用分层图分区(如KG-Retriever的分层索引图)或动态邻居扩展,减少KG遍历范围,提升检索速度;

- 推理结果缓存与复用:缓存高频问题的推理路径和子图(如摊销推理中的中间嵌入缓存),避免重复检索和推理;

- 轻量级推理验证:用概率逻辑程序或布隆过滤器替代LLMs进行答案验证(如轻量级验证模块),降低验证阶段的计算成本。

三、大语言模型与知识图谱融合的发展趋势

大语言模型(LLMs)与知识图谱(KGs)的融合,本质是参数化知识(LLMs)与符号化知识(KGs)的优势互补,旨在解决LLMs的“幻觉”、知识过时、推理黑箱问题,以及KGs的构建效率低、泛化能力弱等局限。结合最新研究进展与技术实践,二者融合的发展趋势可概括为以下五大核心方向:

01.技术范式:从“单向增强”走向“双向协同”

早期融合以“单向赋能”为主(如KG增强LLMs的事实性,或LLMs辅助KG构建),未来将进入深度双向协同阶段,形成“LLMs与KGs动态交互、迭代优化”的闭环范式:

-

LLMs驱动KG的动态演化

-

传统KG构建依赖人工规则或标注数据,效率低且难以应对动态知识(如新兴实体、实时事件)。未来LLMs将全面接管KG的“全生命周期自动化”:从无监督知识抽取(如利用LLMs的零样本能力提取实体/关系,如清华大学ADELIE模型通过指令微调提升信息抽取精度),到动态图谱补全(如浙江大学KoPA模型利用LLMs捕捉KG结构信息,实现新关系预测),再到冲突自动修复(如东南大学unKR工具通过LLMs评估不确定性知识,修正KG错误)。

-

典型案例:南京大学KG-ICL模型通过“提示图(Prompt Graph)”编码,让LLMs无需重新训练即可适配新实体/新图谱,实现KG的“即插即用”更新。

-

KG引导LLMs的可控生成与推理

-

突破传统“检索增强生成(RAG)”的静态检索局限,未来KG将深度介入LLMs的推理过程:通过结构化推理链引导(如CoTKR模型交替生成推理路径与知识,优化多跳QA)、符号约束解码(如ToG模型让LLMs在KG上迭代beam search,避免推理偏离),实现“可解释、可追溯”的生成。

-

进阶方向:利用KG构建“知识反馈闭环”,如用户反馈触发KG三元组增删,进而动态调整LLMs的生成偏好(而非修改模型参数),降低知识更新成本。

-

神经符号交互的深度融合

-

借鉴“双系统理论”(系统1:LLMs的直觉快思考;系统2:KG的逻辑慢思考),未来将出现更多神经符号混合模型:LLMs负责自然语言理解与初步推理,KG负责逻辑校验与结构化知识补充,二者通过双向注意力、图神经网络(GNN)实现跨模态信息交互(如GREASELM模型融合LM与GNN的编码表示)。

-

关键突破点:打破“参数化知识”与“符号化知识”的边界,如KEPLER模型将KG嵌入目标与LLM预训练目标结合,实现文本与图谱的统一表示。

02.应用场景:从“通用领域”聚焦“高价值垂直场景”

融合技术将从通用问答、文本生成等场景,向对可信度、可解释性要求极高的垂直领域深度渗透,成为解决行业痛点的核心方案:

-

医疗健康领域

-

需求:医疗诊断、药物推荐需“零幻觉”且可追溯事实依据。

-

融合路径:通过医疗KG(如UMLS、DrugBank)约束LLMs生成,如MedRAG模型利用KG提取推理线索,辅助LLMs生成诊断建议;同时,LLMs自动抽取电子病历(EMR)中的病症-药物关系,更新医疗KG,形成“临床知识闭环”。

-

法律与金融领域

-

需求:法律判决、金融分析需严格遵循法规/事实,且推理过程可审计。

-

融合路径:构建领域专属KG(如法律条文KG、金融实体关系KG),LLMs在生成法律意见或投资报告时,需从KG中检索法条、案例或企业关联关系作为支撑(如Fact Finder工具通过医疗KG检索提升LLMs回答的完整性);同时,利用LLMs自动抽取法律文书中的权责关系、金融新闻中的事件关联,加速领域KG构建。

-

多模态与跨域场景

-

需求:处理图像、视频等多模态数据,或跨领域知识融合(如生物医学+文献检索)。

-

融合路径:发展多模态知识图谱(如包含图像实体、文本描述、属性关系的KG),LLMs负责多模态内容理解(如从图像中识别实体),KG负责多模态知识的结构化组织与跨域关联(如M3SciQA数据集的多模态QA任务);未来还将支持“文本-图像-图谱”的联合推理,如VisDom模型融合多模态RAG与KG推理,处理含视觉元素的多文档QA。

03.技术优化:从“追求性能”转向“效率与性能平衡”

随着融合规模扩大(如大规模KG、长上下文LLMs),效率瓶颈(检索耗时、计算成本高)成为核心挑战,未来技术优化将聚焦“轻量化、高效化”:

-

KG检索与存储优化

-

传统GraphRAG因遍历大规模KG导致查询缓慢,未来将通过“核心图构建”(如基于KNN中心性筛选核心文本块,减小图规模)、“分层索引”(如KG-Retriever的 hierarchical index graph)、“动态邻居扩展”(仅检索与问题相关的子图),提升检索效率;同时,采用YAML/JSON等压缩格式表示KG三元组,降低LLMs的Token消耗。

-

LLM推理成本控制

-

针对LLM调用成本高的问题,未来将出现“轻量化验证模块”(如用概率逻辑程序、布隆过滤器替代LLMs进行事实校验)、“按需检索触发”(如DeepSeek模型动态判定“何时检索KG、何时直接生成”),减少不必要的KG交互与LLM调用;同时,参数高效微调(如LoRA、KG-Adapter)将成为主流,仅通过少量适配器参数融合KG知识,避免全量重训练。

-

资源约束下的适配方案

-

面向边缘设备、低算力场景,将发展“蒸馏式融合模型”:先在大规模KG与LLM上训练复杂融合模型,再蒸馏为轻量级模型(如GAIL微调的低资源KGQA模型);同时,利用“知识蒸馏+KG压缩”,保留核心知识的同时减小模型与图谱体积。

04.关键技术突破方向:聚焦“未解决的核心痛点”

未来研究将集中攻克当前融合技术的三大瓶颈,推动领域从“可用”走向“好用”:

- 幻觉检测与知识冲突解决

- 利用KG构建“事实校验库”,如KGR模型自动抽取LLM生成中的事实陈述,与KG比对并修正;

- 引入“多源知识置信度评估”,如贝叶斯信任网络量化LLMs与KG知识的可信度,优先选择高置信度信息;

- 发展“冲突自适应策略”,如PIP-KAG模型通过参数剪枝缓解KG与LLMs的知识冲突。

-

核心痛点:LLMs生成内容与KG事实冲突,或KG自身存在知识缺失/矛盾。

-

突破路径:

-

动态知识对齐与更新

- 量化知识对齐度:设计“结构兼容性+语义重叠”双维度指标,如对比学习生成反事实样本,评估LLMs与KG的知识偏差;

- 实时知识注入:采用“流式KG+检索时补丁”,如KG-IRAG的增量检索机制,让LLMs动态获取最新知识;

- 图谱级泛化:如KG-ICL模型通过提示向量初始化实体/关系嵌入,实现对新图谱的零样本适配。

-

核心痛点:KG知识过时(如新增实体、关系变化),且LLMs与KG的知识表征难以实时对齐。

-

突破路径:

-

多模态与复杂推理能力扩展

- 多模态KG理解:研发能处理图像实体、视频事件的LLMs,如KVQA模型通过两阶段提示融合多模态知识;

- 时序与因果推理:构建时序KG(如包含时间戳的事件关系),LLMs结合KG中的时间约束进行推理(如TimeR4模型的时序知识微调);

- 复杂任务分解:如KELDaR模型将复杂问题拆解为分解树,在KG上执行原子检索,提升推理效率。

- 核心痛点:现有融合技术难以处理图像、音频等多模态KG,且复杂推理(如时序推理、因果推理)能力薄弱。

- 突破路径:

05.生态建设:从“单一技术”走向“开源协作生态”

融合技术的落地依赖“数据-模型-工具”的全链条支撑,未来将形成以开放知识图谱生态为核心的协作体系:

-

开放KG资源的标准化

-

现状:领域KG分散且格式不统一,导致融合技术难以复用。

-

趋势:以OpenKG为代表的社区将推动KG数据的开放共享与标准化(如统一三元组格式、领域本体),同时建立“KG质量评估体系”(如事实准确率、覆盖率),为LLMs提供高质量知识源。

-

融合工具链的模块化与低代码化

-

需求:降低企业应用融合技术的门槛,无需深入理解LLM与KG细节。

-

发展方向:出现更多“模块化融合框架”,如KAG框架提供“KG构建-检索-推理”全流程组件,用户可按需组合;同时,低代码平台将支持“拖拽式”配置KG与LLM的交互逻辑(如GraphRAG-QA的可视化查询引擎)。

-

跨学科协作与评估基准统一

-

挑战:现有评估指标分散(如AnsQ、RetQ、ReaQ),且缺乏统一数据集。

-

趋势:学术与工业界将联合制定“LLM+KG融合评估基准”,涵盖事实准确性、推理效率、可解释性等维度(如STaRK、CoConflictQA数据集);同时,跨领域专家(如NLP、知识工程、领域专家)协作,推动融合技术在垂直场景的落地标准制定。

ref:Large Language Models Meet Knowledge Graphs for Question Answering: Synthesis and Opportunities

paper: https://arxiv.org/pdf/2505.20099v2

{

"target":"简单认识我",

"selfInfo":{

"genInfo":"大厂面试官,中科院自动化所硕士,从事数据闭环业务、RAG、Agent等,承担技术+平台的偏综合性角色。善于调研、总结和规划,善于统筹和协同,喜欢技术,喜欢阅读新技术和产品的文章与论文",

"contactInfo":"abc061200x, v-adding disabled",

"slogan":"简单、高效、做正确的事",

"extInfo":"喜欢看电影、喜欢旅游、户外徒步、阅读和学习,不抽烟、不喝酒,无不良嗜好"

}

}

er: https://arxiv.org/pdf/2505.20099v2

```plaintext

{

"target":"简单认识我",

"selfInfo":{

"genInfo":"大厂面试官,中科院自动化所硕士,从事数据闭环业务、RAG、Agent等,承担技术+平台的偏综合性角色。善于调研、总结和规划,善于统筹和协同,喜欢技术,喜欢阅读新技术和产品的文章与论文",

"contactInfo":"abc061200x, v-adding disabled",

"slogan":"简单、高效、做正确的事",

"extInfo":"喜欢看电影、喜欢旅游、户外徒步、阅读和学习,不抽烟、不喝酒,无不良嗜好"

}

}

四、AI大模型学习和面试资源

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献301条内容

已为社区贡献301条内容

所有评论(0)