《深入Java并发编程从锁优化到无锁设计的艺术与实践》

从粗粒度的锁到精细化的锁优化,再到彻底摒弃互斥的无锁设计,Java并发编程的发展历程体现了开发者对性能极致追求的艺术与实践。理解各种同步机制的底层原理与适用场景,是构建高性能、高可伸缩性Java应用的基石。在未来,随着硬件架构的持续演进,如非易失性内存(NVM)的普及,无锁和 wait-free 算法或许将扮演越来越重要的角色。

深入Java并发编程:从锁优化到无锁设计的艺术与实践

并发编程的挑战与锁的引入

在多核处理器成为主流的今天,Java并发编程是提升应用性能的关键手段。然而,多线程环境下对共享资源的访问却带来了数据一致性的巨大挑战。为了应对这一挑战,锁(Lock)成为了最直观和常用的同步机制。从最初的synchronized关键字到java.util.concurrent.locks包中的显式锁,它们通过互斥(Mutual Exclusion)确保了临界区代码的线程安全。

传统锁机制的瓶颈与性能开销

尽管锁解决了线程安全问题,但其本身也引入了显著的性能开销。这主要包括线程挂起与恢复带来的上下文切换(Context Switch)成本,以及线程在等待锁时无法执行任何有用工作的阻塞(Blocking)问题。在高并发场景下,激烈的锁竞争会成为系统的瓶颈,导致可伸缩性(Scalability)急剧下降。

锁优化技术:减少竞争与开销

为了缓解锁带来的性能问题,开发者们探索出了一系列锁优化技术。减小锁的粒度(Lock Splitting)和锁粗化(Lock Coarsening)分别从不同角度调整锁的范围以减少竞争频率。读写锁(ReadWriteLock)则通过区分读写操作,允许多个读线程并行访问,只在写操作时互斥,从而提升了读多写少场景的性能。此外,乐观锁策略,如版本号或CAS(Compare-And-Swap)机制,也在特定场景下被用于减少阻塞。

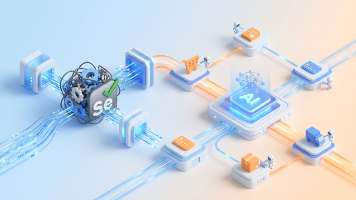

无锁编程:超越互斥的思维

无锁(Lock-Free)编程是并发设计的更高境界,它通过原子性的低级硬件指令(如CAS)来构建线程安全的数据结构,从而完全避免了互斥锁带来的阻塞、死锁和优先级反转等问题。无锁算法的核心思想是:一个线程的失败或挂起不应影响其他线程完成操作。它通常表现为一个循环,线程不断尝试更新值,直到CAS操作成功。虽然设计复杂,但在高竞争环境下能提供更好的吞吐量和可预测的性能。

Java中的无锁实践:原子类与并发容器

Java并发包(java.util.concurrent.atomic)提供了一系列原子变量类(如AtomicInteger, AtomicReference),这些类内部使用CAS指令实现了无锁的线程安全更新,是实践无锁编程的基础构件。更进一步,诸如ConcurrentLinkedQueue之类的并发容器,则实现了更为复杂的无锁算法(如Michael-Scott非阻塞队列算法),为开发者提供了高性能的、可直接使用的线程安全数据结构。

选择权衡:在锁与无锁之间

选择锁还是无锁并非一个绝对的是非题,而是一门需要权衡的艺术。锁的实现相对简单直观,在低至中度竞争条件下表现良好。而无锁编程虽然能提供更高的吞吐量和更强的抗干扰能力,但其代码复杂度高,且可能引发ABA问题,并因为 constant retry 而导致CPU资源消耗增加。因此,决策应基于具体的应用场景、竞争激烈程度以及开发维护成本来综合判断。

结语:迈向高性能并发系统

从粗粒度的锁到精细化的锁优化,再到彻底摒弃互斥的无锁设计,Java并发编程的发展历程体现了开发者对性能极致追求的艺术与实践。理解各种同步机制的底层原理与适用场景,是构建高性能、高可伸缩性Java应用的基石。在未来,随着硬件架构的持续演进,如非易失性内存(NVM)的普及,无锁和 wait-free 算法或许将扮演越来越重要的角色。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)