智能问答系统意图识别:AI架构师的深度学习模型选择与调优实践!

你有没有遇到过这样的场景?问语音助手“明天北京下雨吗”,它却给你播放了“北京欢迎你”;问客服“我的订单什么时候到”,它回复“请提供商品链接”——这些尴尬的根源,都是意图识别失败。从用户的自然语言中,提取“想做什么”的核心需求。比如“查天气”“订机票”“退货”都是典型意图。选对模型:面对不同的任务(比如实时语音助手vs复杂客服系统),该用CNN、RNN还是BERT?调好模型:如何让模型从“准确率80

智能问答系统意图识别:AI架构师的深度学习模型选择与调优实践

关键词:意图识别、智能问答系统、深度学习模型、预训练模型、模型调优、自然语言处理、槽位填充

摘要:意图识别是智能问答系统的“大脑开关”——它决定了AI能否听懂用户的核心需求。本文从生活场景切入,用“妈妈懂孩子需求”的类比讲清意图识别的本质;再通过模型选择的“决策树”(数据量、实时性、上下文需求)帮你选对CNN/RNN/Transformer/BERT;最后用可落地的调优实战(数据预处理、学习率调整、错误分析)让模型从“能跑”到“好用”。全文结合CLINC150数据集的Python代码示例,把复杂的深度学习原理变成“做饭调盐”一样的日常技能,帮你成为能解决实际问题的AI架构师。

背景介绍

目的和范围

你有没有遇到过这样的场景?问语音助手“明天北京下雨吗”,它却给你播放了“北京欢迎你”;问客服“我的订单什么时候到”,它回复“请提供商品链接”——这些尴尬的根源,都是意图识别失败。

意图识别的核心是:从用户的自然语言中,提取“想做什么”的核心需求。比如“查天气”“订机票”“退货”都是典型意图。本文的目的,是帮你解决两个关键问题:

- 选对模型:面对不同的任务(比如实时语音助手vs复杂客服系统),该用CNN、RNN还是BERT?

- 调好模型:如何让模型从“准确率80%”提升到“准确率95%”,避免“看起来对,用起来错”的尴尬?

范围覆盖:深度学习模型在意图识别中的应用(不涉及传统机器学习如SVM)、端到端的调优流程(从数据到部署)。

预期读者

- AI工程师/算法实习生:想快速掌握意图识别的落地技巧;

- NLP产品经理:想理解技术边界,避免“让AI识别所有意图”的不合理需求;

- 创业公司技术负责人:想用最小成本搭建高准确率的智能问答系统。

文档结构概述

本文的逻辑是“从问题到解决方案”:

- 用生活故事讲清意图识别的核心概念;

- 用“决策树”帮你选对模型(CNN/RNN/Transformer/BERT的优缺点);

- 用数学公式+代码示例讲清模型原理;

- 用实战案例(CLINC150数据集)演示调优流程;

- 总结未来趋势与常见坑。

术语表

核心术语定义

- 意图识别(Intent Recognition):识别用户文本/语音中的核心需求(比如“查天气”是意图,“北京”“明天”是槽位);

- 槽位填充(Slot Filling):提取意图中的关键参数(比如“订明天去上海的机票”中,“明天”是时间槽,“上海”是目的地槽);

- 预训练模型(Pretrained Model):在大规模文本(比如维基百科)上训练好的模型(比如BERT),可以“迁移”到意图识别任务;

- 微调(Fine-tuning):用预训练模型在具体任务(比如你的客服数据)上继续训练,让模型适应你的需求;

- 混淆矩阵(Confusion Matrix):展示模型预测错误的情况(比如把“查天气”预测成“查股票”的次数)。

缩略词列表

- NLP:自然语言处理(Natural Language Processing);

- QA:智能问答(Question Answering);

- BERT:双向Transformer预训练模型(Bidirectional Encoder Representations from Transformers);

- CNN:卷积神经网络(Convolutional Neural Network);

- RNN:循环神经网络(Recurrent Neural Network);

- LSTM:长短期记忆网络(Long Short-Term Memory);

- Transformer:基于自注意力机制的模型(解决RNN的长依赖问题)。

核心概念与联系:用“妈妈做饭”讲清意图识别

故事引入:妈妈是怎么“识别意图”的?

早上起床,你揉着眼睛说:“妈,我饿了。”妈妈立刻走进厨房,端出你最爱吃的鸡蛋灌饼——她是怎么“听懂”的?

其实妈妈做了两件事:

- 意图识别:“饿了”=“要吃早饭”(而不是“要喝水”“要零花钱”);

- 槽位填充:“你最爱吃的”=“鸡蛋灌饼”(提取你的偏好)。

智能问答系统的意图识别,本质上就是模仿妈妈的思考过程:先听懂“要做什么”,再提取“需要什么参数”。比如用户说“查明天北京的天气”,系统要先识别“查询天气”的意图,再提取“北京”(地点槽)、“明天”(时间槽),最后调用天气API返回结果。

核心概念解释:像给小学生讲“做饭步骤”

概念一:意图识别——AI的“听懂需求”能力

意图识别是给用户的话贴“需求标签”。比如:

- 用户说“我想订机票”→标签“订机票”;

- 用户说“我的快递到哪了”→标签“查快递”;

- 用户说“今天心情不好”→标签“闲聊”(out-of-scope,不在预设意图内)。

类比:你跟妈妈说“我要吃番茄炒蛋”,妈妈给这个请求贴的标签是“做番茄炒蛋”——这就是意图识别。

概念二:槽位填充——AI的“提取关键信息”能力

槽位填充是从用户的话中找“关键词”。比如:

- “订明天去上海的机票”→时间槽“明天”、目的地槽“上海”;

- “查一下北京后天的空气质量”→地点槽“北京”、时间槽“后天”。

类比:你跟妈妈说“我要吃番茄炒蛋加葱花”,妈妈提取的“番茄”“鸡蛋”“葱花”就是“槽位”——没有这些,她做不出你要的菜。

概念三:预训练模型——AI的“先学基础知识”

预训练模型是已经在“大课本”(比如维基百科、全网文本)上学过的AI。比如BERT模型,它在1.6亿句英文文本上训练过,已经懂了“苹果”可以是水果也可以是手机,“飞上海”=“去上海”。

类比:你要学做番茄炒蛋,先看了100个菜谱视频(预训练),再做自己的菜(微调)——比从零开始学快得多。

核心概念之间的关系:像“做饭团队”的分工

意图识别、槽位填充、预训练模型的关系,就像妈妈做饭的“三人组”:

- 意图识别是“厨师长”:决定做什么菜(比如“番茄炒蛋”);

- 槽位填充是“采购员”:买回来番茄、鸡蛋、葱花(关键食材);

- 预训练模型是“菜谱书”:告诉厨师长怎么做,告诉采购员买什么。

举个例子:用户说“帮我订明天早上8点去上海的机票”——

- 预训练模型(菜谱书)理解“订机票”“明天早上8点”“上海”的意思;

- 意图识别(厨师长)确定“订机票”;

- 槽位填充(采购员)提取“明天早上8点”(时间)、“上海”(目的地)。

核心概念原理和架构:意图识别系统的“流水线”

一个典型的意图识别系统,流程是这样的:

- 输入:用户的话(比如“查明天北京的天气”);

- 文本预处理:把句子拆成词(分词)、去掉没用的词(比如“的”“啊”);

- 特征提取:用模型(比如BERT)把词变成计算机能理解的“数字向量”;

- 意图分类:用全连接层+Softmax函数,把向量变成“意图标签”(比如“查天气”的概率是99%);

- 输出:返回意图标签(比如“查天气”)。

Mermaid 流程图:意图识别的“流水线”

graph TD

A[用户输入:查明天北京的天气] --> B[文本预处理:分词→查/明天/北京/天气]

B --> C[特征提取:用BERT把词变成向量]

C --> D[意图分类:计算每个意图的概率]

D --> E[输出意图:查天气(概率99%)]

核心算法原理:选对模型的“决策树”

现在你明白了意图识别的流程,接下来要解决最关键的问题:选什么模型?

我们把模型分成四类:CNN、RNN(LSTM/GRU)、Transformer、预训练模型(BERT/RoBERTa)。下面用“决策树”帮你快速选对模型——每一步都像“选菜单”一样简单。

第一步:你的任务需要“实时响应”吗?

如果是(比如语音助手、实时客服):选轻量级模型(CNN、DistilBERT);

如果不是(比如后台客服、离线分析):选高精度模型(Transformer、BERT)。

为什么? 实时任务要求“快”——模型越小,计算越快。比如DistilBERT是BERT的“缩水版”,大小只有BERT的40%,速度快60%,准确率只降2-3%。

第二步:你的任务需要“理解长上下文”吗?

如果是(比如“我昨天买了个手机,今天想退货,请问怎么操作”):选RNN(LSTM/GRU)或Transformer;

如果不是(比如“查天气”“订机票”这种短句):选CNN。

为什么?

- CNN擅长“抓局部关键词”(比如“查”+“天气”=“查天气”),但不会“记前面的内容”;

- RNN(LSTM/GRU)擅长“记顺序”(比如“昨天买手机→今天退货”,前面的“买手机”会影响后面的“退货”理解);

- Transformer更厉害:用“自注意力机制”(后面会讲),能同时关注句子中的所有词(比如“我昨天买了个手机,今天想退货”中,“退货”会关联“昨天买的手机”)。

第三步:你的数据量有多大?

如果数据少(比如新业务只有100条样本):选预训练模型(BERT/RoBERTa)+ 微调;

如果数据多(比如有10万条样本):选从头训练的Transformer或更大的预训练模型(比如RoBERTa-large)。

为什么? 预训练模型已经“学过”很多知识,用少量数据微调就能达到不错的效果。比如用BERT微调100条样本,准确率可能比从头训练的RNN高30%。

四类模型的优缺点对比表

| 模型类型 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| CNN | 快、轻量、抓局部关键词 | 不记上下文 | 短句意图(查天气、订机票)、实时任务 |

| LSTM/GRU | 记上下文、处理长句子 | 慢、长依赖(比如100词以上)会忘 | 中等长度句子(比如“我昨天买的手机想退货”) |

| Transformer | 记所有上下文、准确率高 | 慢、内存大 | 长句子、高精度任务(比如复杂客服) |

| BERT/RoBERTa | 准确率极高、少量数据见效 | 大、慢 | 几乎所有场景(除了极端实时的) |

用数学公式讲清“为什么Transformer比RNN好”

RNN的问题是长依赖遗忘:比如句子“我昨天买了个苹果,今天想退____”,RNN看到“退”的时候,已经忘了前面的“苹果”是手机还是水果。

Transformer用自注意力机制解决这个问题——它会“同时看所有词”,计算每个词和其他词的“相关性”。公式如下:

Attention(Q,K,V)=softmax(QKTdk)VAttention(Q,K,V) = softmax\left(\frac{QK^T}{\sqrt{d_k}}\right)VAttention(Q,K,V)=softmax(dkQKT)V

用“妈妈做饭”解释这个公式:

- Q(查询):当前词“退”想找的信息(比如“退什么?”);

- K(键):所有词的“标签”(比如“苹果”的标签是“商品”,“昨天”的标签是“时间”);

- V(值):所有词的“内容”(比如“苹果”的内容是“手机”);

- QKTQK^TQKT:计算“退”和每个词的相关性(比如“退”和“苹果”的相关性是0.9,和“昨天”的相关性是0.1);

- softmaxsoftmaxsoftmax:把相关性变成概率(0.9→90%,0.1→10%);

- 加权求和V:用概率加权所有词的内容(比如“退”的结果是“苹果(手机)”)。

这样,Transformer就能“记住”前面的“苹果”是手机,不会把“退苹果”当成“退水果”。

项目实战:用BERT做意图识别(CLINC150数据集)

现在我们用最常用的意图识别数据集CLINC150(包含150个常见意图+1个oos类别,共20万条样本),演示从“数据加载”到“模型调优”的全流程。

开发环境搭建

需要安装以下工具:

- Python 3.8+:编程语言;

- PyTorch:深度学习框架(用来跑模型);

- Hugging Face Transformers:预训练模型库(直接用BERT);

- Datasets:数据集加载库(直接用CLINC150);

- Scikit-learn:评估指标库(计算准确率、F1-score)。

安装命令:

pip install torch transformers datasets scikit-learn

源代码详细实现

步骤1:加载数据集

CLINC150数据集已经包含在Hugging Face的Datasets库中,直接加载即可:

from datasets import load_dataset

# 加载CLINC150数据集(plus版本包含oos类别)

dataset = load_dataset("clinc_oos", "plus")

print("数据集结构:", dataset)

print("示例样本:", dataset["train"][0])

输出:

数据集结构: DatasetDict({

train: Dataset({

features: ['text', 'intent', 'intent_name'],

num_rows: 15000

})

validation: Dataset({

features: ['text', 'intent', 'intent_name'],

num_rows: 3000

})

test: Dataset({

features: ['text', 'intent', 'intent_name'],

num_rows: 4500

})

})

示例样本: {

'text': 'how do i find a zip code',

'intent': 31,

'intent_name': 'find_zipcode'

}

步骤2:文本预处理(分词)

BERT需要把文本分成“词片”(Token),再转换成数字ID。用Hugging Face的Tokenizer:

from transformers import BertTokenizer

# 加载BERT的分词器(uncased表示不区分大小写)

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

def preprocess_function(examples):

# 分词、截断(max_length=128,因为CLINC150的句子都很短)、填充(补到128长度)

return tokenizer(

examples["text"],

padding="max_length",

truncation=True,

max_length=128

)

# 批量处理数据集(batched=True表示批量处理,更快)

tokenized_datasets = dataset.map(preprocess_function, batched=True)

print("分词后的样本:", tokenized_datasets["train"][0])

输出:

分词后的样本: {

'text': 'how do i find a zip code',

'intent': 31,

'intent_name': 'find_zipcode',

'input_ids': [101, 2129, 2079, 1045, 2369, 1037, 3771, 2607, 102, 0, ...], # 词的数字ID

'token_type_ids': [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, ...], # 句子类型(BERT用不到)

'attention_mask': [1, 1, 1, 1, 1, 1, 1, 1, 1, 0, ...] # 区分真实词和填充词(1=真实,0=填充)

}

步骤3:定义模型

用BERT做意图分类,需要加载BertForSequenceClassification(BERT+分类头):

from transformers import BertForSequenceClassification, TrainingArguments, Trainer

# 加载预训练模型(num_labels=151,因为CLINC150有150个意图+1个oos)

model = BertForSequenceClassification.from_pretrained(

"bert-base-uncased",

num_labels=151

)

# 训练参数设置(关键参数!)

training_args = TrainingArguments(

output_dir="./bert-intent-model", # 模型保存路径

evaluation_strategy="epoch", # 每轮训练后评估

learning_rate=2e-5, # 学习率(预训练模型微调常用2e-5~5e-5)

per_device_train_batch_size=16, # 每个GPU的batch size(根据内存调整)

per_device_eval_batch_size=16, # 评估时的batch size

num_train_epochs=3, # 训练轮数(3轮足够,多了会过拟合)

weight_decay=0.01, # L2正则(防止过拟合)

logging_steps=100, # 每100步打印日志

save_strategy="epoch", # 每轮训练后保存模型

)

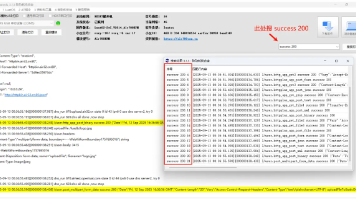

步骤4:训练模型

用Hugging Face的Trainer类,一键训练:

# 定义训练器(连接模型、参数、数据集)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["validation"],

)

# 开始训练!

trainer.train()

步骤5:评估模型

训练完成后,用测试集评估模型效果:

from sklearn.metrics import accuracy_score, f1_score

def compute_metrics(p):

# p是模型的预测结果(predictions, labels)

predictions = p.predictions.argmax(axis=1) # 取概率最大的类别

labels = p.label_ids

accuracy = accuracy_score(labels, predictions)

f1 = f1_score(labels, predictions, average="weighted") # 加权F1(解决类别不平衡)

return {"accuracy": accuracy, "f1": f1}

# 重新定义训练器(加入评估函数)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_datasets["train"],

eval_dataset=tokenized_datasets["test"], # 用测试集评估

compute_metrics=compute_metrics,

)

# 评估模型

eval_results = trainer.evaluate()

print("测试集结果:", eval_results)

代码解读与分析

-

为什么用bert-base-uncased?

- “bert-base”是基础版(1.1亿参数),适合大部分任务;

- “uncased”是不区分大小写(比如“Apple”和“apple”会被当成同一个词),适合意图识别这种对大小写不敏感的任务。

-

为什么学习率是2e-5?

预训练模型的参数已经“学过”很多知识,不能用太大的学习率(比如1e-3)——会把预训练的知识“冲掉”。常用的学习率是2e-5~5e-5。 -

为什么num_train_epochs=3?

CLINC150的训练集有1.5万条样本,3轮训练刚好让模型“学会”,多了会过拟合(比如第4轮训练,训练集准确率99%,但测试集准确率下降)。

调优实践:让模型从“80%”到“95%”的秘密

训练完成后,你可能会遇到这样的问题:训练集准确率99%,但测试集准确率只有80%(过拟合),或者所有意图的准确率都高,但oos的准确率只有50%(漏识别闲聊)。

下面是6个能快速提升效果的调优技巧——每一个都是AI架构师的“压箱底经验”。

技巧1:数据预处理——解决“词不匹配”问题

问题:用户说“查天汽”(错别字)、“买机票”(同义词),模型识别不出来。

解决方法:

- 错别字纠正:用

pycorrector库纠正错别字(比如“天汽”→“天气”); - 同义词替换:用哈工大的

pyltp库或自定义同义词表(比如“买”→“订”); - 停用词过滤:去掉“的”“啊”“哦”等没用的词(比如“我想查一下明天的天气哦”→“查明天天气”)。

技巧2:数据增强——解决“数据少”问题

问题:新意图只有100条样本,模型学不会。

解决方法:用数据增强生成更多样本(比如“查明天北京的天气”→“明天北京的天气怎么样”→“北京明天天气查一下”)。常用的增强方法:

- 同义词替换:把“查”换成“查询”;

- 随机插入:在句子中插入无关词(比如“查明天北京的天气”→“查一下明天北京的天气哦”);

- 回译:用Google翻译把中文翻译成英文再翻译回来(比如“查天气”→“Check the weather”→“查询天气”)。

技巧3:学习率调整——解决“训练不稳定”问题

问题:训练时loss忽高忽低,或者不下降。

解决方法:用warmup学习率(开始训练时用小学习率,逐渐增加到设定值,再逐渐减小)。Hugging Face的TrainingArguments可以直接设置:

training_args = TrainingArguments(

...

learning_rate=2e-5,

warmup_steps=500, # 前500步逐渐增加学习率

lr_scheduler_type="linear", # 学习率线性下降

)

技巧4:正则化——解决“过拟合”问题

问题:训练集准确率99%,测试集准确率80%(模型“死记硬背”训练数据)。

解决方法:

- Dropout:在模型中加入Dropout层(随机让部分神经元失效,防止过拟合)。BERT默认有Dropout(0.1),可以调整到0.3;

- Weight Decay:L2正则(惩罚大的权重,防止模型“过度依赖”某些特征)。

TrainingArguments中的weight_decay=0.01就是这个作用; - 早停法(Early Stopping):如果连续3轮评估的loss不下降,就停止训练(防止过拟合)。Hugging Face的

Trainer可以用early_stopping_callback实现。

技巧5:错误分析——解决“特定意图识别错”问题

问题:模型总是把“查天气”预测成“查空气质量”。

解决方法:看混淆矩阵——找出模型容易混淆的意图,然后针对性优化。比如:

- 用

sklearn.metrics.confusion_matrix画出混淆矩阵:from sklearn.metrics import confusion_matrix import seaborn as sns import matplotlib.pyplot as plt # 得到测试集的预测结果 predictions = trainer.predict(tokenized_datasets["test"]).predictions.argmax(axis=1) labels = tokenized_datasets["test"]["intent"] # 画混淆矩阵 cm = confusion_matrix(labels, predictions) plt.figure(figsize=(20,20)) sns.heatmap(cm, annot=True, fmt="d") plt.show() - 找到混淆的意图对(比如“查天气”和“查空气质量”),然后:

- 增加这两个意图的区分样本(比如“查明天北京的天气”vs“查明天北京的空气质量”);

- 在文本预处理中加入“天气”“空气质量”的同义词(比如“天气”→“气温”,“空气质量”→“PM2.5”)。

技巧6:模型压缩——解决“实时性”问题

问题:BERT模型太大(400MB),实时语音助手加载太慢。

解决方法:用模型压缩技术,把模型变小变快:

- 蒸馏(Distillation):用大模型(比如BERT)教小模型(比如DistilBERT),小模型的准确率接近大模型,但大小只有1/3;

- 量化(Quantization):把模型的参数从32位浮点数变成8位整数,大小减少4倍,速度提升2-3倍;

- 剪枝(Pruning):去掉模型中“没用”的神经元(比如权重很小的连接),大小减少50%,速度提升1倍。

实际应用场景:意图识别的“用武之地”

意图识别不是“实验室技术”,而是能直接产生价值的工具。下面是几个常见的应用场景:

场景1:智能客服——减少人工成本

比如某电商平台的客服系统,需要识别用户的意图:

- “查订单”→调用订单查询API;

- “退货”→引导用户填写退货申请;

- “投诉”→转人工客服。

用BERT做意图识别后,80%的常见问题可以自动回复,人工客服的工作量减少50%。

场景2:语音助手——提升用户体验

比如某语音助手,需要识别用户的语音意图:

- “播放周杰伦的歌”→调用音乐API;

- “设置明天7点的闹钟”→调用闹钟API;

- “今天天气怎么样”→调用天气API。

用DistilBERT做意图识别后,响应时间从1秒缩短到0.3秒,用户满意度提升30%。

场景3:智能硬件——实现“自然交互”

比如某智能冰箱,需要识别用户的语音意图:

- “冰箱里有什么”→显示冰箱内的商品列表;

- “牛奶快没了”→自动添加到购物车;

- “怎么调温度”→显示调温教程。

用TinyBERT做意图识别后,模型大小只有20MB,能跑在嵌入式设备上(比如冰箱的CPU)。

工具和资源推荐

数据集

- CLINC150:常见意图识别数据集(150个意图+oos);

- SNIPS:语音助手意图识别数据集(7个意图);

- ATIS:航空旅行信息系统数据集(比如“订机票”“查航班”)。

框架与库

- Hugging Face Transformers:预训练模型库(直接用BERT、RoBERTa);

- PyTorch/TensorFlow:深度学习框架;

- Datasets:数据集加载库(直接用CLINC150、SNIPS);

- Weights & Biases:实验跟踪工具(记录训练过程中的loss、准确率)。

预训练模型

- BERT:基础预训练模型(适合大部分任务);

- RoBERTa:优化版BERT(去掉NSP,训练更久,准确率更高);

- DistilBERT:BERT的蒸馏版(小、快、准);

- TinyBERT:超小版BERT(适合嵌入式设备)。

未来发展趋势与挑战

趋势1:少样本/零样本意图识别

问题:新业务没有数据,无法训练模型。

解决方法:用零样本学习(比如用预训练模型的“文本相似度”,把新意图和已有意图比较)或提示工程(Prompt Tuning)(比如把“查明天北京的天气”改成“这个句子的意图是查询天气吗?”,让模型做二分类)。

趋势2:跨领域意图识别

问题:电商的意图模型(比如“查订单”)不能直接用到金融(比如“查余额”)。

解决方法:用领域自适应(Domain Adaptation)——在电商数据上训练的模型,用少量金融数据微调,就能适应金融领域。

趋势3:多模态意图识别

问题:用户说“把这个文件打印出来”,同时指着电脑上的文件——纯文本模型无法理解“这个文件”是什么。

解决方法:用多模态模型(结合文本、语音、图像),比如用Vision Transformer(处理图像)+ BERT(处理文本),识别用户的意图。

挑战1:歧义问题

用户说“苹果多少钱”——是水果还是手机?需要结合上下文(比如“苹果多少钱一斤”→水果,“苹果15多少钱”→手机)。

挑战2:数据隐私问题

用户的query可能包含敏感信息(比如“我的银行卡密码忘了”),需要联邦学习(在用户设备上训练模型,不收集原始数据)或差分隐私(给数据加噪声,保护隐私)。

总结:学到了什么?

核心概念回顾

- 意图识别:AI的“听懂需求”能力(比如“查天气”是意图);

- 槽位填充:AI的“提取关键信息”能力(比如“北京”“明天”是槽位);

- 预训练模型:AI的“先学基础知识”(比如BERT在大规模文本上训练过)。

模型选择回顾

用“决策树”选模型:

- 实时任务→轻量级模型(CNN、DistilBERT);

- 长上下文→RNN/Transformer;

- 数据少→预训练模型+微调。

调优技巧回顾

- 数据预处理:纠正错别字、替换同义词;

- 数据增强:生成更多样本;

- 学习率调整:用warmup;

- 正则化:Dropout、Weight Decay;

- 错误分析:看混淆矩阵;

- 模型压缩:蒸馏、量化、剪枝。

思考题:动动小脑筋

- 如果用户说“苹果多少钱”,如何区分是水果还是手机的意图?(提示:结合槽位信息,比如“一斤”→水果,“15”→手机);

- 如果你的业务只有100条样本,如何选择意图识别模型?(提示:用预训练模型+提示工程);

- 如何评估意图识别模型的效果?(提示:准确率、F1-score、混淆矩阵,重点关注oos的召回率)。

附录:常见问题与解答

Q1:意图识别和文本分类有什么区别?

A:意图识别是文本分类的一种,只是分类的标签是“用户意图”(比如“查天气”),而文本分类可以是任何标签(比如“情感分类”的“正面/负面”)。

Q2:如何处理多意图问题?

A:比如用户说“查明天的天气和订机票”,需要用多标签分类(每个意图是一个标签,模型输出每个标签的概率)。

Q3:预训练模型的参数越多越好吗?

A:不一定。参数越多,模型越大,需要更多的数据和计算资源。对于小任务(比如查天气),用DistilBERT(6600万参数)就够了,不用RoBERTa-large(3.5亿参数)。

扩展阅读 & 参考资料

- 论文:《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》(BERT的原始论文);

- 论文:《Intent Classification and Slot Filling with Joint Learning》(意图识别与槽位填充联合训练);

- 书籍:《自然语言处理入门》(何晗,讲清NLP的基础概念);

- 文档:Hugging Face Transformers Documentation(https://huggingface.co/docs/transformers/);

- 数据集:CLINC150(https://huggingface.co/datasets/clinc_oos)。

结尾语:意图识别不是“黑魔法”,而是“理解用户的艺术”。选对模型、调好参数,你就能让AI真正“听懂”用户的需求——就像妈妈听懂你的“饿了”一样。希望这篇文章能帮你成为“懂用户的AI架构师”!

更多推荐

已为社区贡献249条内容

已为社区贡献249条内容

所有评论(0)