RLPT:大语言模型的新进化之路,无需人工标注的强化学习范式

RLPT:基于预训练数据的强化学习新范式 这篇论文提出了一种名为RLPT的创新训练方法,通过强化学习方式在预训练数据上实现无监督学习。该方法设计了"下一段推理"任务和"前缀奖励"机制,让语言模型像完成"完形填空"游戏一样自我挑战,无需人工标注即可提升推理能力。实验证明,RLPT能显著提升模型在知识问答(如MMLU、GPQA)和数学竞赛题(

RLPT是一种创新的大语言模型训练范式,通过强化学习在预训练数据上实现无监督学习。它设计了"下一段推理"任务和"前缀奖励"机制,让模型像做游戏一样自我挑战,无需人工标注。实验证明RLPT能显著提升模型在知识问答和数学推理等任务上的表现,并具有良好的扩展性,为解决大模型面临的数据瓶颈问题提供了新思路。

- 论文:Reinforcement Learning on Pre-Training Data

- 链接:https://arxiv.org/pdf/2509.19249

这篇论文正是针对这一核心挑战提出的创新解决方案。它引入了一种名为 RLPT 的新训练范式。简单来说,RLPT 的核心思想是:让模型像做“完形填空”或“预测下文”的游戏一样,在预训练文本上进行自我挑战,并根据“猜”得对不对来获得奖励,从而通过强化学习的方式自主学习。 最关键的是,整个过程完全不需要人工标注!论文通过大量实验证明,RLPT 能显著提升模型在通用知识问答和复杂数学推理等任务上的表现,并且展现出良好的扩展性,意味着投入更多计算资源,性能还能继续提升。接下来,我们将深入浅出地解读这项研究。

研究动机:为何需要新的扩展范式?

想象一下,你要训练一个超级聪明的学生。传统方法是给他越来越多的教科书(数据)和让他做越来越难的习题(模型变大)。但问题是,顶尖的教科书就那么多,习题册也总有做完的一天。这就是当前大语言模型面临的“数据墙”困境。虽然计算能力(相当于学习时间和脑力)还在增长,但高质量的“学习材料”已经快跟不上了。

另一方面,我们希望这个学生不仅能记忆知识,更能举一反三,拥有强大的逻辑推理能力。现有的强化学习方法,好比请了一位昂贵的家教(人类标注员),对学生的每一步推理进行点评和指导。效果虽好,但家教无法覆盖所有知识领域,也无法24小时陪练,成本极高,难以规模化。

因此,论文的动机非常明确:能否设计一种方法,让学生(模型)能够利用图书馆里海量的、无标签的普通书籍(预训练数据),进行自主的、探索性的学习,并且像强化学习那样锻炼出强大的推理能力,同时还不依赖昂贵的家教(人工标注)? RLPT 正是为了回答这个问题而生。它旨在打破数据瓶颈和标注依赖,为LLMs的持续进化开辟一条新的道路。

RLPT 方法核心:如何实现无监督的强化学习?

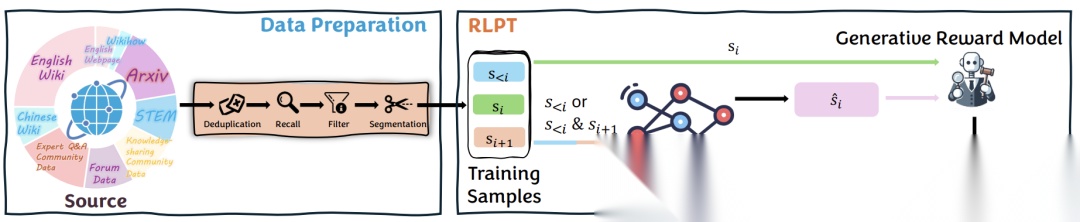

RLPT 的完整流程可以概括为:准备数据 -> 定义任务 -> 模型尝试完成任务 -> 自动评分 -> 模型根据得分优化自己。下面我们拆解每个关键部分。

整体框架概览

RLPT 的训练过程始于原始的互联网文本。这些文本经过清洗和分段后,构成训练样本。模型的任务是根据上下文预测被掩盖或后续的文本段。一个专门的“评分员”模型会判断模型的预测是否在语义上与正确答案匹配,并给出奖励(0或1)。模型则利用这个奖励信号,通过强化学习算法来更新自身的参数,从而学习如何做出更好的预测。

RLPT从原始数据到训练样本构建,再到模型预测和奖励计算的全过程

数据准备

工欲善其事,必先利其器。RLPT 使用的数据来源于维基百科、arXiv 学术论文、高质量对话记录等。研究人员对这些原始数据进行了严格的“精加工”:

- 去重:删除重复或高度相似的内容,避免模型“偏食”。

- 隐私保护:检测并屏蔽个人信息。

- 去污染:确保评估用的测试题不会出现在训练数据中,保证评估的公平性。

- 质量过滤:结合规则和模型,剔除低质量、不适宜的内容。 此外,还引入了一些高质量的数学问答数据,专门用于增强模型的推理能力。这套数据预处理流程确保了RLPT是在一个干净、多样、高质量的数据基础上进行学习。

核心创新:下一段推理目标

这是RLPT的灵魂所在。它不再像传统预训练那样逐词预测,而是升级为“段”级预测。这里的“段”通常指一个完整的句子。论文设计了两种具体的游戏规则:

- 自回归段推理(ASR):这很像我们平时的阅读预测。给定一段上文,让模型预测下一个最可能的句子。例如,上下文是“今天阳光明媚,气温达到了35摄氏度……”,模型需要生成“因此,人们纷纷前往海滩消暑”这样的句子。这个任务锻炼的是模型顺向生成和推理的能力。

- 提示词示例:论文中设计了清晰的指令,要求模型逐步推理,并将最终答案用特殊标签括起来。

- 中间段推理(MSR):这更像完形填空。给模型一段文字,但中间挖掉一个句子,同时提供这个句子之后的内容作为提示,让模型根据上下文来填补空白。例如,给出“___。因此,实验得出结论:该药物有效。”,模型需要推断出空白处可能是“临床试验数据显示,服用该药物的患者组康复率显著高于对照组”。这个任务迫使模型利用双向信息进行深度理解,对于代码补全等任务尤其有用。

- 提示词示例:论文中也有相应的指令模板。

在训练中,RLPT 会交替使用 ASR 和 MSR 任务,让模型全面掌握语言的理解和生成。

奖励模型设计:如何判断“猜对了”?

这是实现无监督强化学习的关键。既然没有老师(人类标注员)来判卷,就需要一个“自动评分员”。论文采用了一个生成式奖励模型来担任这个角色。它的任务是判断模型预测的段落是否是真实段落的一个有效的、语义相符的前缀。

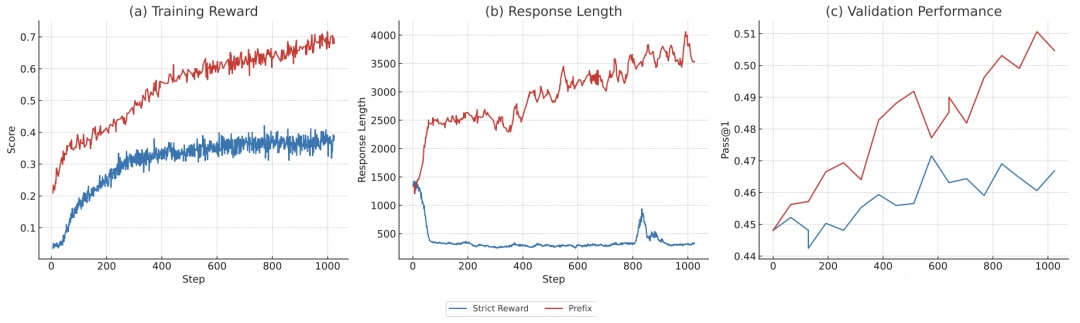

- 初始挑战:最初,研究人员要求预测段必须和真实段完全语义匹配。但这太严格了!模型可能一口气预测了后面两个句子的内容,虽然意思没错,但因为和单个真实句子对不上,就被判为错误。这导致奖励信号非常稀疏,训练困难。

- 巧妙解决方案:前缀奖励:为了解决这个问题,论文提出了一个更聪明的评分规则:只要模型预测的段落,是后续真实内容(可能包含多个句子)的一个合乎情理的“开头”,并且语义一致,就算正确。这就好比,学生预测故事结局是“王子与公主幸福地生活在一起”,而原文是“王子与公主从此过上了幸福美满的生活”,虽然措辞不完全一样,但核心意思一致,就应该给分。这种“前缀奖励”大大缓解了训练信号稀疏的问题,使学习过程更稳定、更有效。

-

: 模型的完整输出。

-

: 从输出中提取的预测段。

-

: 真实的参考段。

-

: 生成式奖励模型,输出1或0。

-

公式核心思想:这个函数将复杂的语义一致性判断封装在 (G_{rm}) 中,为强化学习提供了一个清晰、二元的奖励信号。模型的目标就是最大化获得奖励的期望。

-

奖励函数公式:

对比“严格奖励”和“前缀奖励”

训练目标与细节

RLPT 的最终训练目标是最大化在 ASR 和 MSR 任务上获得的期望奖励。

- : 模型参数。

- /: 分别在 ASR 和 MSR 任务上的期望。

- : 一个超参数,用于平衡两个任务的重要性。

- 核心作用:这个目标函数明确地引导模型优化参数,使其在两种段预测任务上都表现更好。

训练过程还包括一个“冷启动”阶段,即先用一些指令遵循数据对基础模型进行微调,确保它能够理解并执行ASR/MSR任务的指令。训练中使用的是GRPO等策略梯度算法。

实验验证:RLPT 效果如何?

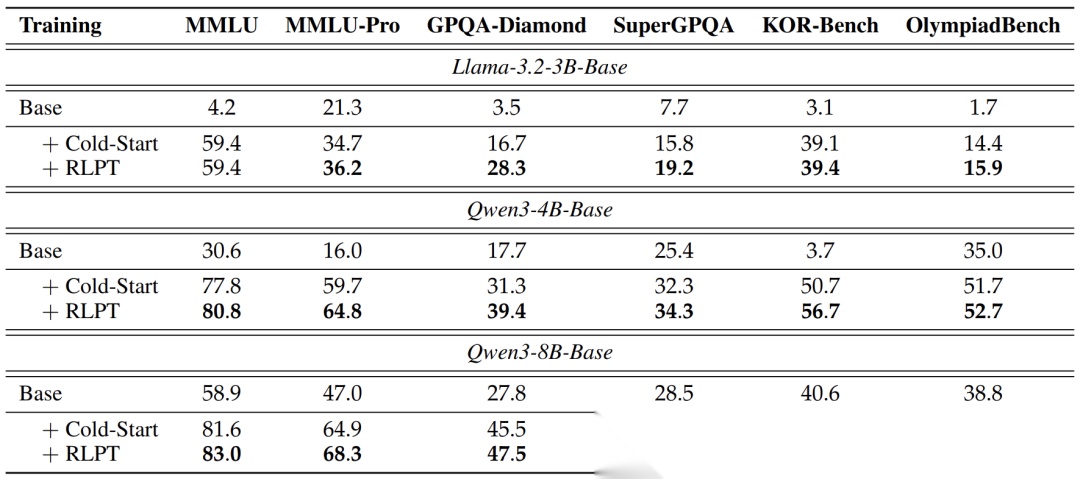

论文在多个模型(如Qwen3-4B/8B, Llama3.2-3B)和多个极具挑战性的基准上进行了全面评估。

实验设置

评估分为两大领域:

- 通用领域:测试模型的世界知识、理解能力,使用的基准包括MMLU(大学水平多选题)、MMLU-Pro(更难的MMLU)、GPQA(博士水平QA)、KOR-Bench(知识正交推理)等,以准确率为指标。

- 数学推理:测试复杂的数学问题解决能力,使用的基准包括MATH、AIME(美国数学邀请赛)等,采用Pass@k指标(生成k个答案,至少有一个正确的概率)。

主要结果展示与分析

RLPT在不同模型、不同通用领域基准上带来的显著性能提升

- 通用领域性能:结果非常亮眼。以Qwen3-4B模型为例,经过RLPT训练后,在MMLU、MMLU-Pro、GPQA-Diamond和KOR-Bench上分别绝对提升了3.0%、5.1%、8.1%和6.0%。在更大的Qwen3-8B和不同家族的Llama3.2-3B模型上也观察到了一致的提升。这表明RLPT能有效激发预训练数据中蕴含的广泛知识。

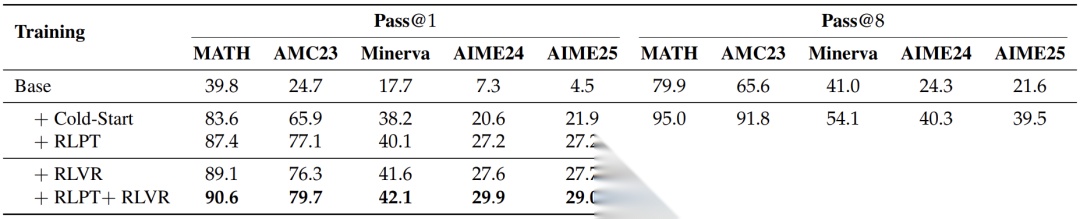

在数学推理任务上,RLPT以及后续结合RLVR所带来的显著增益。

- 数学推理性能:提升更为惊人。在非常难的AIME24和AIME25竞赛题上,RLPT使Qwen3-4B的Pass@1分别提升了6.6%和5.3%。更重要的是,当把RLPT作为基础,再进行需要人工验证的RLVR训练时,性能还能进一步提升(例如,AIME24上Pass@1再升2.3%)。这说明RLPT为模型打下了强大的推理基础,使得后续的精细调优事半功倍。

深入分析

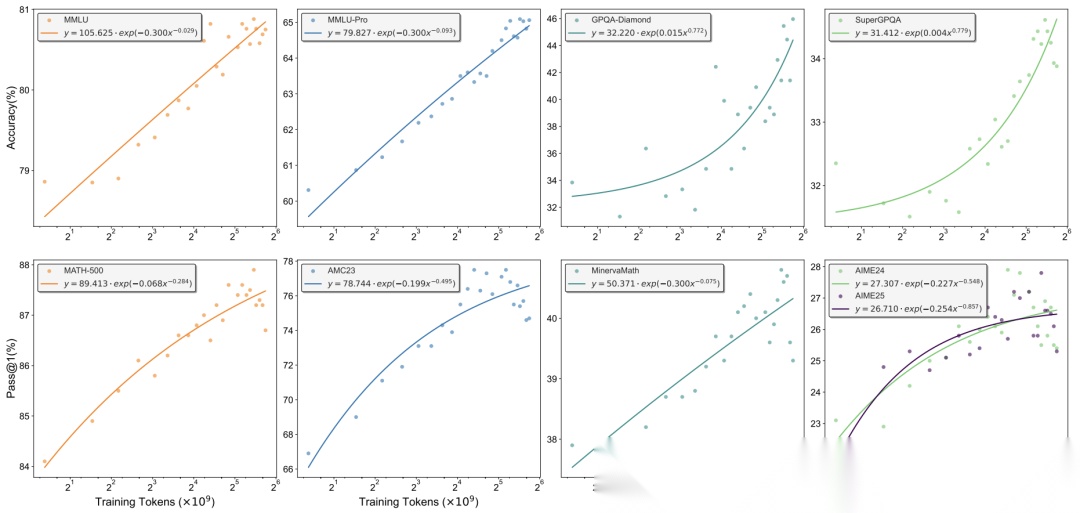

- 扩展性质:研究发现,RLPT的性能随着训练计算量(消耗的token数)的增加,遵循“幂律”增长。这意味着,投入更多的计算资源进行RLPT训练,模型性能很可能还会持续提高,这是一个非常积极的信号。

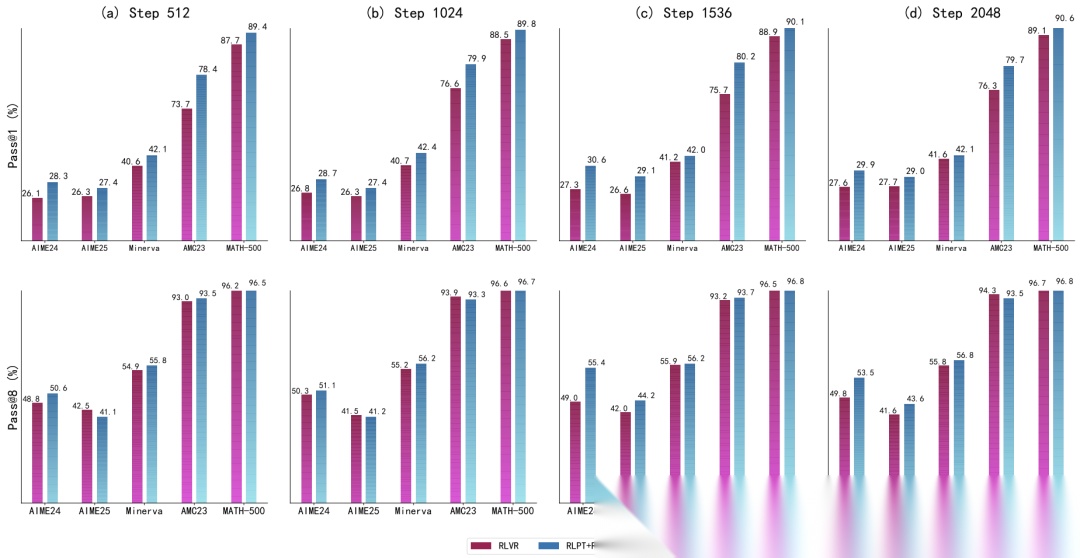

对比直接做RLVR和以RLPT为基础再做RLVR的扩展曲线

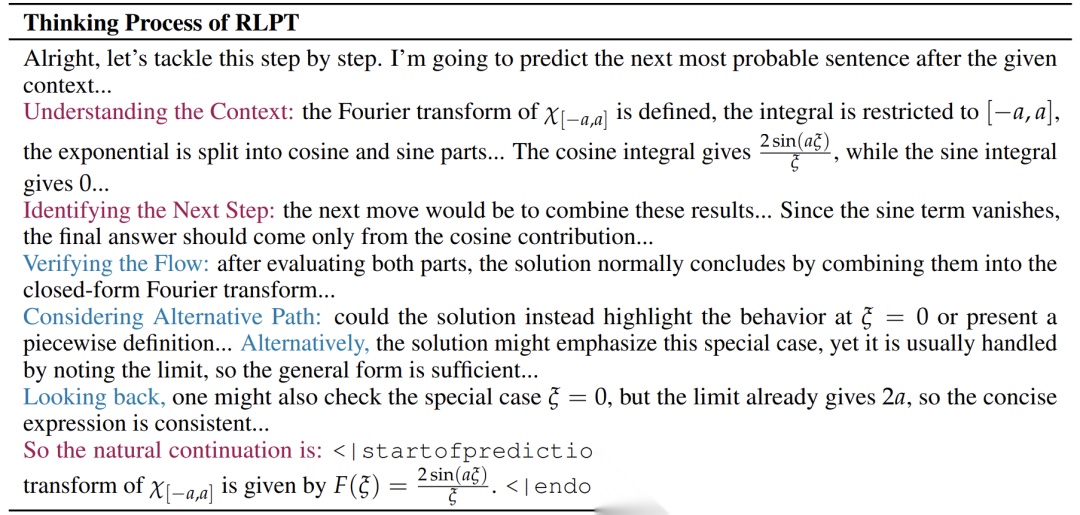

- 思维模式:论文还通过示例展示了模型在RLPT任务中的思考过程。模型会先理解上下文,确定下一步该做什么,提出候选方案,进行验证,甚至尝试不同路径和回溯。这种结构化的、多步骤的推理模式,与人类解决复杂问题时的思考方式非常相似,这从侧面解释了为什么RLPT能有效提升推理能力。

一个RLPT模型的完整推理链

结论

总而言之,这篇论文提出的RLPT方法,是大型语言模型训练领域的一次重要创新。它成功地将强化学习的优势与海量预训练数据的潜力结合起来,创造了一种高效、可扩展且不依赖人工标注的训练新范式。通过“下一段推理”这一核心设计,RLPT激励模型进行深度思考和探索,显著提升了其在知识问答和复杂数学推理等任务上的表现。实验证明其具备良好的扩展规律,未来发展前景广阔。

未来的研究方向可能包括探索更精细的“段”定义(如逻辑步骤而非简单句子),将RLPT应用于多模态数据,以及研究如何与其他先进训练技术更紧密地结合。RLPT为我们打开了一扇新的大门,让我们看到大语言模型的进化之路依然充满无限可能。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献221条内容

已为社区贡献221条内容

所有评论(0)