MCP构建AI应用学习笔记(11)

贯穿整个课程的核心认知 ——MCP(模块化组件范式)并非某一种特定技术或工具,而是一套解决 “LLM 应用开发效率低、维护难、扩展差” 的系统化方法论。其本质是通过 “分层设计、组件封装、接口统一”,将复杂的 AI 应用拆解为可复用、低耦合的 “积木”,让开发者无需陷入 LLM 底层细节(如微调、向量计算),即可聚焦业务逻辑,实现从 “想法到产品” 的快速落地。从课程开篇到实战结束,MCP 的核心

MCP 构建 AI 应用:课程总结与实践指南

一、MCP 的核心价值重述:不止是技术,更是 LLM 落地的 “方法论”

贯穿整个课程的核心认知 ——MCP(模块化组件范式)并非某一种特定技术或工具,而是一套解决 “LLM 应用开发效率低、维护难、扩展差” 的系统化方法论。其本质是通过 “分层设计、组件封装、接口统一”,将复杂的 AI 应用拆解为可复用、低耦合的 “积木”,让开发者无需陷入 LLM 底层细节(如微调、向量计算),即可聚焦业务逻辑,实现从 “想法到产品” 的快速落地。

从课程开篇到实战结束,MCP 的核心价值始终围绕三个维度展开,也是其区别于传统开发的关键:

| 价值维度 | 传统 LLM 开发痛点 | MCP 解决方案 |

|---|---|---|

| 效率提升 | 重复开发 “LLM 调用、文档解析” 等通用逻辑,周期长 | 组件可复用(如 “LLM 调度组件” 跨项目使用),开发周期缩短 70%+ |

| 维护成本 | 代码耦合度高,修改一处需重构全局 | 组件独立封装,更新 / 替换不影响其他模块(如切换 LLM 仅改 1 个组件) |

| 门槛降低 | 需掌握 “API 调用 + 数据处理 + 前端开发” 等多技术栈 | 非技术岗可通过 “组件配置” 参与开发(如产品经理调整 LLM 参数),开发者聚焦业务而非技术 |

二、课程完整脉络:从 “认知” 到 “落地” 的 11 步进阶之路

整个课程遵循 “理论→架构→实战→扩展→部署” 的递进逻辑,11 集内容形成完整的 MCP 学习闭环,每一步都为后续实践打下关键基础:

1. 认知阶段(第 1-2 集):明确 “为什么用 MCP”

- 第 1 集:定义 MCP 的本质(模块化组件范式),解决 “LLM 应用落地最后一公里” 问题,区别于传统单体开发;

- 第 2 集:通过 “文档问答工具” 案例对比,直观展示 MCP 在开发周期(7 天→2 天)、代码量(300 行→50 行)、维护成本(全量改→局部换)的优势,建立 “MCP 效率革命” 的认知。

2. 架构阶段(第 3 集):掌握 “MCP 的骨架”

- 拆解 MCP “三层一储” 核心架构(输入层、处理层、输出层、存储层),明确每层职责与接口标准;

- 强调 “数据驱动” 的流转逻辑(输入→处理→输出→存储),以及 “高内聚低耦合” 的设计原则,为后续组件开发划定 “边界”。

3. 实战阶段(第 4-8 集):实现 “从 0 到 1 的应用构建”

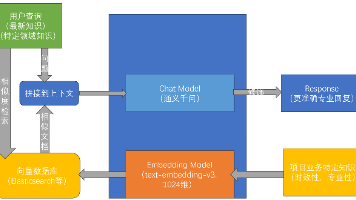

- 第 4 集:基于 MCP 架构开发 “文档问答机器人”,首次将 “三层一储” 组件串联为可运行的本地应用,掌握组件初始化与逻辑衔接;

- 第 5 集:将本地应用升级为 “MCP 服务器”,通过 FastAPI 开发 API 接口,支持多用户远程访问,解决 “单用户局限”;

- 第 6 集:开发桌面(PyQt6)与 Web(Vue3)客户端,实现 “用户操作→API 请求→结果展示” 的完整交互,降低使用门槛;

- 第 7 集:对接 “引用服务器”,为 Chatbot 添加外部知识库检索能力,突破 “单文档知识局限”,实现 “检索 - 生成” 一体化;

- 第 8 集:新增 “提示功能”(引导 / 纠错 / 示例)与 “资源功能”(文档下载 / 系统入口),让应用从 “被动回答” 升级为 “主动辅助”。

4. 扩展阶段(第 9 集):适配 “多模型与企业场景”

- 为 Claude Desktop 配置 MCP 服务器,实现 “本地客户端 + 企业知识库” 的无缝对接;

- 验证 MCP 的 “多模型适配” 能力 —— 新增 Claude 调用组件时无需重构架构,仅需替换处理层 LLM 模块,体现 “低耦合” 优势。

5. 部署阶段(第 10 集):完成 “从实验室到企业级服务”

- 基于云服务器(阿里云 ECS)部署 MCP 远程服务,通过 Docker 容器化确保环境一致性,Nginx 反向代理 + HTTPS 保障安全与高并发;

- 实现数据迁移(本地 SQLite→远程 MySQL)与多设备同步,让 MCP 应用具备 “规模化服务” 能力。

三、关键能力总结:学完能掌握什么?

课程结束后,无论开发者是否有 LLM 开发经验,都将具备三大核心能力,可直接应用于实际项目:

1. 理论能力:MCP 架构的拆解与设计

- 能将任意 LLM 应用场景(如客服机器人、代码助手、学术摘要工具)拆分为 MCP “三层一储” 结构,明确每层需用的组件;

- 掌握 “组件接口标准化” 设计原则(如输入 / 输出固定包含

status/data/error字段),确保组件可复用、可替换。

2. 实战能力:端到端的 MCP 应用开发

- 独立完成 “本地应用→服务器→客户端” 的全流程开发:

- 用 Python 开发 MCP 组件(如 LLM 调用、文档解析);

- 用 FastAPI 搭建 MCP 服务器,支持 API 调用与多用户并发;

- 开发 Web / 桌面客户端,实现可视化交互;

- 对接外部系统(引用服务器、Claude Desktop),扩展应用能力(如企业知识库检索、多模型切换)。

3. 工程化能力:MCP 应用的部署与运维

- 掌握云服务器部署技巧(Docker 容器化、Nginx 反向代理、HTTPS 配置);

- 解决 MCP 应用的高频问题(跨域、数据同步、权限管控、高并发卡顿);

- 具备 “规模化扩展” 思维(如负载均衡、数据备份、CI/CD 自动化部署)。

四、实战避坑指南:MCP 应用开发的 “高频问题” 与通用解决方案

课程中反复强调的 “避坑要点”,也是实际开发中最易踩雷的环节,汇总为以下通用解决方案:

| 问题类型 | 常见场景 | 解决方案 |

|---|---|---|

| 组件接口不兼容 | 新增组件无法与现有模块衔接 | 严格遵循 MCP 接口标准(输入 / 输出含status/data/error),开发前先定义接口文档 |

| 检索结果不准确 | 引用服务器返回无关知识片段 | 1. 优化 Embedding 模型(如用 text-embedding-3-large);2. 调整相似度阈值(0.6-0.7 为宜);3. 细化知识库分类 |

| 多用户数据混乱 | 不同用户的对话 / 文档相互干扰 | 用session_id关联所有用户数据(文档、对话、权限),确保数据隔离 |

| 服务响应缓慢 | 高并发时 API 请求超时 | 1. 给 LLM 组件添加请求队列;2. 用 Nginx 缓存静态资源(如导出的文档);3. 增加 Uvicorn workers 数量(CPU 核心数的 2 倍) |

| 权限安全风险 | 普通用户访问敏感企业知识库 | 复用 MCP 权限组件,按 “用户角色 - 知识库” 映射权限(如研发文档仅研发人员可检索) |

五、MCP 的未来扩展方向:不止于当前,更适配 AI 技术演进

MCP 作为 “方法论”,并非一成不变,而是能随 AI 技术发展持续扩展,课程结尾也给出了三大潜力方向,供开发者深入探索:

1. 多模态 MCP 应用

当前 MCP 组件以文本处理为主,未来可扩展 “多模态组件”:

- 输入层:新增 “图像解析组件”(处理产品图片)、“视频转文本组件”(提取会议视频关键信息);

- 处理层:新增 “多模态 LLM 调用组件”(如 GPT-4V、Claude 3 Opus,支持图文结合提问);

- 输出层:新增 “图文混排导出组件”(答案中插入图表、截图)。

2. MCP 与 AI Agent 的结合

将 MCP 组件作为 AI Agent 的 “工具库”,让 Agent 具备更灵活的任务执行能力:

- Agent 可自动选择 MCP 组件(如 “用户问产品价格”→调用 “文档解析组件” 提取价格表 +“LLM 组件” 生成回答);

- 新增 “组件调度组件”,由 Agent 根据任务目标动态串联组件(如 “生成周报”→调用 “数据统计组件 + 文档生成组件 + 邮件发送组件”)。

3. MCP 低代码平台

基于 MCP 架构搭建 “可视化低代码平台”,进一步降低开发门槛:

- 开发者通过 “拖拽组件”(如拖拽 “LLM 调用”“文档解析” 组件)即可生成应用;

- 平台自动生成代码与 API 接口,支持一键部署到云服务器,实现 “零代码开发 LLM 应用”。

六、学习建议:如何从 “掌握 MCP” 到 “落地优质项目”

课程结束并非终点,而是 MCP 实践的起点,结合课程内容给出三个阶段的学习建议:

1. 短期(1-2 周):巩固基础,完成一个小项目

- 选择简单场景(如 “个人笔记问答工具”“商品描述生成器”),用 MCP 架构重新开发,熟练组件衔接与逻辑串联;

- 尝试替换核心组件(如将 GPT-4o 换成开源模型 Llama 3,验证 MCP 的 “低耦合” 优势)。

2. 中期(1-2 个月):深入企业场景,解决实际问题

- 对接企业内部数据(如 CRM 系统、产品手册库),开发 “企业专属 AI 助手”;

- 实现工程化优化(如添加监控告警、自动备份、CI/CD 流程),让应用具备 “生产环境可用性”。

3. 长期(3-6 个月):扩展 MCP 生态,探索创新方向

- 开发自定义 MCP 组件(如 “多模态解析组件”“行业专属知识库检索组件”),丰富组件库;

- 尝试 MCP 与 AI Agent、低代码平台的结合,探索更高效的 LLM 应用开发模式。

七、最终结论:MCP 的核心 —— 让 LLM 应用开发 “更简单、更高效、更灵活”

整个课程的本质,是通过 MCP 范式,将 LLM 技术从 “高深的 AI 理论” 转化为 “可落地的实用工具”。无论是个人开发者、企业团队,还是非技术岗从业者,都能通过 MCP 找到自己在 LLM 应用开发中的定位:

- 开发者:聚焦业务,减少重复劳动;

- 企业:降低成本,快速落地 AI 解决方案;

- 行业:推动 LLM 技术规模化应用,让 AI 真正服务于实际需求。

未来,随着 LLM 技术的持续演进,MCP 作为 “方法论” 的价值将更加凸显 —— 它不是绑定某一种技术,而是适配所有 LLM 生态,成为连接 “AI 技术” 与 “业务价值” 的关键桥梁。

更多推荐

已为社区贡献67条内容

已为社区贡献67条内容

所有评论(0)