【AI论文】OmniInsert:借助扩散变换器模型实现任意参考对象的无掩码视频插入

本研究提出OmniInsert框架解决无掩码视频插入三大挑战:数据稀缺、主场景平衡与和谐融合。创新点包括:1)自动构建跨配对数据集的InsertPipe;2)条件特定特征注入机制与渐进式训练策略;3)主体聚焦损失和插入偏好优化。实验表明,在InsertBench基准测试中,OmniInsert在主体一致性(CLIP-I/DINO-I领先6.3%/9.6%)、视频质量等指标上均优于商业解决方案。局限

摘要:近期基于扩散模型在视频插入领域取得的进展令人瞩目。然而,现有方法依赖复杂的控制信号,却难以保证主体一致性,限制了其实际应用。本文聚焦于无掩码视频插入任务,旨在解决三大关键挑战:数据稀缺、主体与场景平衡以及插入内容的和谐融合。为应对数据稀缺问题,我们提出了一种新型数据流水线InsertPipe,可自动构建多样化的跨配对数据集。基于该数据流水线,我们开发了OmniInsert——一种新颖的统一框架,支持从单一或多个主体参考中实现无掩码视频插入。具体而言,为保持主体与场景的平衡,我们引入了一种简单而有效的条件特定特征注入机制,以明确注入多源条件,并提出了一种新型渐进式训练策略,使模型能够平衡来自主体和源视频的特征注入。同时,我们设计了主体聚焦损失函数,以提升主体的细节表现。为进一步增强插入内容的和谐融合,我们提出了插入偏好优化方法,通过模拟人类偏好来优化模型,并在参考过程中引入上下文感知重表述模块,使主体无缝融入原始场景。为解决该领域缺乏基准测试的问题,我们推出了InsertBench——一个包含多样化场景和精心挑选主体的综合基准测试集。在InsertBench上的评估表明,OmniInsert的性能优于当前最先进的闭源商业解决方案。相关代码即将开源。Huggingface链接:Paper page,论文链接:2509.17627

研究背景和目的

研究背景:

随着深度学习技术的飞速发展,视频生成和编辑领域取得了显著进展。

特别是基于扩散模型(Diffusion Models)的视频生成方法,因其能够生成高质量、连贯的视频内容而备受关注。然而,在视频插入(Video Insertion, VI)任务中,即将一个参考主体自然地插入到源视频中,现有方法仍面临诸多挑战。首先,数据稀缺性问题严重,缺乏成对的插入前后视频及相应的主体参考,限制了模型的训练效果。其次,主体与场景的平衡问题突出,如何在保持未编辑区域不变的同时确保插入主体的一致性,是当前方法亟待解决的问题。最后,插入和谐化不足,现有方法往往难以实现插入主体与原始场景的自然交互,导致生成结果显得不真实。

研究目的:

本研究旨在解决视频插入任务中的上述挑战,提出一种无需掩码的视频插入方法(Mask-free Video Insertion, MVI),通过以下目标实现:

- 解决数据稀缺性:提出一种新的数据管道InsertPipe,自动构建多样化的跨配对数据,以缓解数据稀缺问题。

- 保持主体与场景的平衡:引入条件特定特征注入机制(Condition-Specific Feature Injection, CFI)和渐进式训练策略(Progressive Training, PT),以维护插入主体与未编辑区域的一致性。

- 提升插入和谐化:设计主体聚焦损失(Subject-Focused Loss, SL)和插入偏好优化方法(Insertive Preference Optimization, IPO),以及上下文感知重述模块(Context-Aware Rephraser, CAR),以增强插入结果的和谐性和真实性。

- 建立基准测试:引入一个全面的基准测试InsertBench,用于评估MVI任务的性能,推动该领域的研究进展。

研究方法

数据管道构建(InsertPipe):

为了解决数据稀缺问题,我们设计了InsertPipe数据管道,包含三条数据生成管线:

- RealCapture Pipe:利用现有真实世界视频,通过检测、跟踪和视频擦除工具构建成对视频。同时,利用视觉语言模型(VLM)和大型语言模型(LLM)生成详细的字幕和检测提示,确保数据的多样性和复杂性。

- SynthGen Pipe:利用LLM生成多样化的提示,结合图像生成、图像编辑、视频生成和主体移除技术,自动构建大规模跨配对数据集。通过图像生成、视频生成和主体移除技术,确保数据集的场景多样性和一致性。

- SimInteract Pipe:基于渲染引擎生成定制数据,模拟复杂场景下的主体交互,进一步提升数据的复杂性和多样性。

模型架构(OmniInsert):

我们提出了OmniInsert框架,一个无需掩码的视频插入统一框架,支持单主体和多主体参考。

该框架包含以下关键组件:

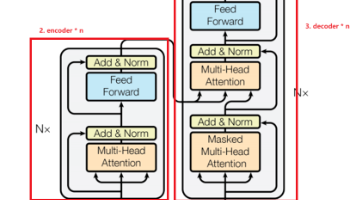

- 条件特定特征注入机制(CFI):在模型架构中明确区分视频条件和主体条件的注入方式,确保不同条件的高效融合。

- 渐进式训练策略(PT):采用四阶段训练策略,从仅主体插入到完整MVI任务的预训练,再到高保真度数据集上的模型优化,最后通过人类偏好模拟进行偏好优化。

- 主体聚焦损失(SL):设计特定损失函数,引导模型关注主体区域的细节表现,提升主体一致性。

- 插入偏好优化(IPO):利用少量人类标注的偏好数据,通过偏好优化方法,引导模型生成更符合人类偏好的插入结果。

- 上下文感知重述模块(CAR):在推理阶段引入VLM生成详细的上下文感知提示,引导模型实现更无缝和合理的插入。

研究结果

定量分析:

在InsertBench基准测试上,OmniInsert相比现有最先进的商业解决方案(如Pika-Pro和Kling)表现出色。具体指标如下:

- 主体一致性:CLIP-I和DINO-I指标上,OmniInsert分别领先6.3%和9.6%。

- 文本视频对齐:ViCLIP-T指标上,OmniInsert领先3.4%。

- 视频质量:动态质量、图像质量、美学和一致性等指标上,OmniInsert均领先。

定性分析:

通过视觉比较可以看出,OmniInsert在主体背景一致性、提示跟随和插入合理性方面均优于基线方法。具体表现为:

- 主体保真度:OmniInsert能更好地保持主体身份和背景不变性,而基线方法往往出现主体失真或插入不自然的问题。

- 提示跟随:OmniInsert能更准确地跟随文本提示,生成与提示更匹配的结果。

- 插入合理性:OmniInsert的插入结果在视觉上更合理,主体与场景的交互更自然。

用户研究:

我们邀请了30名志愿者对40个测试样本进行评估,从主体一致性、文本对齐、插入理性和综合评价四个维度进行比较。

结果显示,OmniInsert在所有维度上均显著优于基线方法。

研究局限

尽管OmniInsert在视频插入任务中取得了显著进展,但仍存在以下局限:

- 颜色保真度和物理合理性:有时生成结果会出现轻微的颜色差异和物理上不合理的现象,如模型穿透等。尽管IPO阶段已显著减少这些问题,但完全解决仍具挑战性。

- 推理速度:标准视频扩散模型基线下,OmniInsert的推理时间约为90秒(480P分辨率,121帧视频)。虽然优于基线方法,但仍有提升空间。

- 数据多样性:尽管InsertPipe数据管道覆盖了广泛场景和主体类别,但在极端或高度专业化的场景中,模型的鲁棒性可能受限。

未来研究方向

针对上述局限,未来研究可以从以下方向展开:

- 改进颜色保真度和物理合理性:引入更先进的偏好优化技术和物理引擎,进一步提升生成结果的质量和合理性。

- 提升推理速度:应用通用的视频扩散模型加速技术,减少推理时间,提高实际应用中的效率。

- 增强数据多样性:探索更多样化的数据来源和合成方法,特别是极端或专业场景下的数据生成,以提升模型的泛化能力。

- 多模态数据利用:结合音频、文本等多模态信息,提供更丰富的上下文提示,引导模型生成更自然和合理的插入结果。

- 实时交互和动态调整:研究实时交互机制,允许用户在推理阶段动态调整提示,实现更个性化和可控的视频插入。

更多推荐

已为社区贡献150条内容

已为社区贡献150条内容

所有评论(0)