年薪百万的AI架构师都在用的数据安全智能体设计模式

当企业还在靠“防火墙+人工分析师”被动堵漏洞时,年薪百万的AI架构师已经在用数据安全智能体重构安全体系——它像“会思考的智能保安”:能主动感知异常、理解威胁意图、自动采取行动,甚至从经验中学习优化。本文将拆解这套“年薪百万级”设计模式:从核心组件的生活化比喻,到AI算法与安全规则的融合逻辑,再到电商/金融场景的实战落地,最后展望未来多智能体协作、大模型整合的趋势。无论你是AI工程师、安全架构师还是

年薪百万的AI架构师不传之秘:数据安全智能体的设计模式与实践

——从0到1构建会“主动保护”的数据安全系统

关键词

数据安全智能体 | 主动防御 | 零信任架构 | 机器学习 | 实时决策 | 自适应控制 | 隐私计算

摘要

当企业还在靠“防火墙+人工分析师”被动堵漏洞时,年薪百万的AI架构师已经在用数据安全智能体重构安全体系——它像“会思考的智能保安”:能主动感知异常、理解威胁意图、自动采取行动,甚至从经验中学习优化。本文将拆解这套“年薪百万级”设计模式:从核心组件的生活化比喻,到AI算法与安全规则的融合逻辑,再到电商/金融场景的实战落地,最后展望未来多智能体协作、大模型整合的趋势。无论你是AI工程师、安全架构师还是技术管理者,读完都能掌握“用AI让数据安全‘活’起来”的方法论。

一、背景:从“被动堵漏”到“主动防御”,数据安全的生死命题

1.1 传统数据安全的“三个死穴”

2023年,某头部电商平台遭遇“撞库攻击”:黑客用泄露的账号密码批量尝试登录,盗走10万用户的收货地址和银行卡信息——而传统安全系统直到攻击发生2小时后才报警。这类事故的根源,在于传统安全体系的被动性:

- 反应慢:依赖“日志分析+人工排查”,攻击发生后才发现;

- 漏报多:规则引擎只能识别已知威胁,对“零日攻击”(未知攻击手段)无能为力;

- 体验差:为了“安全”牺牲用户体验(比如强制二次验证),导致用户流失。

更残酷的现实是:数据量爆炸+攻击智能化,让传统方法彻底失效——2024年全球数据量将达到181ZB(相当于2000亿部1TB的手机存储),而黑产的攻击手段已经进化到“用AI生成虚假用户行为”。

1.2 为什么数据安全智能体是破局关键?

年薪百万的AI架构师早就想明白了:数据安全的本质是“对抗”——攻击方在进化,防御方必须从“被动挨打”变成“主动狩猎”。而数据安全智能体(Data Security Agent, DSA)就是这个“主动狩猎者”:

- 它能感知:实时收集日志、流量、用户行为等全维度数据;

- 它能思考:用AI分析“哪些行为是异常”“威胁有多大”;

- 它能行动:自动触发二次验证、冻结账号、封锁IP等操作;

- 它能学习:从攻击案例中优化模型,越用越聪明。

简单来说,传统安全系统是“监控摄像头”,而数据安全智能体是“带AI大脑的智能保安”——不仅能看,还能判断、行动、成长。

1.3 本文的目标读者与核心问题

目标读者:

- AI工程师:想了解“AI如何落地数据安全”;

- 安全架构师:想重构“主动防御”体系;

- 技术管理者:想降低安全运营成本、避免数据泄露风险。

核心问题:

如何设计一个**“能感知、会思考、敢行动、能学习”**的数据安全智能体?

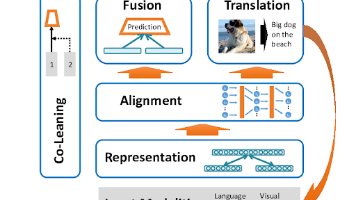

二、核心概念解析:用“小区智能保安”读懂数据安全智能体

要理解复杂的技术体系,最好的方法是找生活化的类比。我们把数据安全智能体比作“小区的智能保安系统”,拆解它的5大核心组件:

2.1 组件1:感知层——“保安的眼睛和耳朵”

感知层的作用是收集所有和“安全”相关的数据,相当于小区里的摄像头、门禁系统、烟雾报警器。

数据来源:要“全”还要“准”

感知层需要收集4类数据:

- 日志数据:应用日志(登录/支付记录)、系统日志(服务器操作记录)、安全日志(防火墙/IDS告警);

- 流量数据:网络流量(IP地址、端口、带宽)、API流量(接口调用频率、参数);

- 用户行为数据:登录时间、地点、设备(手机/电脑/平板)、操作路径(比如“先看订单再改地址”);

- 敏感数据标识:通过DLP(数据丢失防护)系统标记“姓名、银行卡号、身份证号”等敏感数据的位置。

类比:小区的“感知设备”

小区的摄像头收集“人员进出画面”,门禁系统收集“刷卡记录”,烟雾报警器收集“烟雾浓度”——这些数据合起来,才能让保安知道“小区里发生了什么”。

2.2 组件2:认知层——“保安的AI大脑”

认知层的作用是把数据变成“威胁情报”,相当于小区里的“AI监控中心”:用算法分析“哪些人是可疑的”“哪些行为有风险”。

核心技术:从“识别异常”到“理解意图”

认知层需要解决两个问题:

- 异常检测:识别“和正常行为不一样的动作”(比如凌晨3点从国外IP登录);

- 威胁关联:把孤立的异常事件连成“攻击链”(比如“陌生IP登录→修改收货地址→发起支付”)。

常用的AI技术包括:

- 无监督学习(异常检测):孤立森林(Isolation Forest)、自动编码器(AutoEncoder);

- 知识图谱(威胁关联):把IP、账号、设备、黑产数据关联起来,找出“攻击路径”;

- 隐私计算(保护数据):联邦学习(在不共享原始数据的情况下训练模型)、同态加密(在加密数据上计算)。

类比:小区的“AI监控中心”

AI监控中心会分析摄像头画面:“这个人戴帽子、口罩,连续绕小区3圈”→标记为“可疑人员”;同时关联门禁记录:“他用的门禁卡是昨天刚丢失的”→判断为“潜在小偷”。

2.3 组件3:决策层——“保安队长的指令”

决策层的作用是根据威胁情报生成“行动指令”,相当于小区里的“保安队长”:决定“是上前询问?还是直接报警?”。

决策逻辑:“AI得分+业务规则”双轮驱动

年薪百万的架构师不会让AI“单独做决策”——而是把AI生成的“异常得分”和业务规则结合起来:

- 异常得分:用算法计算“这个行为是攻击的概率”(比如0.9表示“90%是攻击”);

- 业务规则:根据企业需求制定的“安全策略”(比如“异常得分>0.8且来自陌生IP→触发二次验证”)。

常用的决策工具是规则引擎(比如Drools、OpenRules),它能把“业务逻辑”写成“if-else”规则,方便修改和维护。

类比:小区的“保安队长”

保安队长看到“可疑人员+丢失的门禁卡”→指令:“先拦住他,查身份证;如果没有,直接报警”——这就是“异常信息+规则”的决策逻辑。

2.4 组件4:执行层——“保安队员的行动”

执行层的作用是把决策变成“实际动作”,相当于小区里的“保安队员”:去拦人、报警、锁门。

执行方式:“API调用+自动化工具”

执行层需要整合企业现有的安全工具,通过API调用实现自动化:

- 调用账号系统API:冻结异常账号;

- 调用短信/推送API:发送二次验证验证码;

- 调用防火墙API:封锁可疑IP;

- 调用SIEM系统:生成告警日志,通知安全团队。

类比:小区的“保安队员”

保安队员接到指令→去门口拦住可疑人员→查身份证→如果有问题,拨打110——这就是“执行层”的作用。

2.5 组件5:自适应层——“系统的自我升级”

自适应层的作用是从“行动结果”中学习,优化未来的决策,相当于小区的“系统升级”:比如“上次误判了一个快递员,这次调整AI的识别规则”。

核心技术:在线学习与强化学习

- 在线学习:用新产生的数据“增量式”更新模型(比如每天用新的登录日志调整异常检测模型);

- 强化学习:让智能体在“行动-反馈”循环中学习最优策略(比如“触发二次验证后,用户反馈是‘误判’→降低该用户的异常阈值”)。

类比:小区的“系统升级”

小区的AI监控中心发现“上次把快递员当成了可疑人员”→调整模型:“如果携带快递箱,降低可疑评分”——这就是“自适应”。

2.6 组件互动流程图(Mermaid)

graph TD

A[感知层:收集数据] --> B[认知层:分析威胁]

B --> C[决策层:生成指令]

C --> D[执行层:采取行动]

D --> E[自适应层:学习优化]

E --> A

这个循环就是数据安全智能体的“生命流程”:从数据到行动,再从行动到优化,形成“闭环”。

三、技术原理与实现:从“理论”到“代码”的落地细节

接下来,我们用Python+真实场景拆解每个组件的实现细节——假设你要为某电商平台设计“用户登录安全智能体”。

3.1 感知层:数据收集与预处理

感知层的关键是**“把混乱的数据变成可分析的特征”**。

步骤1:收集数据

我们需要从电商平台的登录系统收集以下字段:

- user_id(用户ID)

- login_time(登录时间)

- ip(登录IP)

- device_type(设备类型:手机/电脑/平板)

- country_code(IP对应的国家编码:比如CN=中国,US=美国)

步骤2:数据预处理

预处理的目标是清洗脏数据+提取有用特征。用Pandas实现:

import pandas as pd

from sklearn.preprocessing import MinMaxScaler

# 1. 加载数据

login_logs = pd.read_csv("login_logs.csv")

# 2. 数据清洗:去除重复行、处理缺失值

login_logs = login_logs.drop_duplicates() # 去重

login_logs["login_time"] = pd.to_datetime(login_logs["login_time"]) # 转时间格式

login_logs["ip"] = login_logs["ip"].fillna("unknown") # 填充缺失的IP

# 3. 特征工程:提取“登录间隔时间”(用户两次登录的时间差)

login_logs = login_logs.sort_values(by=["user_id", "login_time"]) # 按用户和时间排序

login_logs["login_interval"] = login_logs.groupby("user_id")["login_time"].diff().dt.seconds # 计算间隔(秒)

login_logs["login_interval"] = login_logs["login_interval"].fillna(0) # 第一次登录的间隔设为0

# 4. 归一化:将“登录间隔时间”缩放到0-1(方便算法处理)

scaler = MinMaxScaler()

login_logs["login_interval_scaled"] = scaler.fit_transform(login_logs[["login_interval"]])

# 查看处理后的数据

print(login_logs[["user_id", "login_time", "ip", "login_interval_scaled"]].head())

输出结果:

| user_id | login_time | ip | login_interval_scaled |

|---|---|---|---|

| 1001 | 2024-01-01 08:30:00 | 192.168.1.1 | 0.0 |

| 1001 | 2024-01-01 12:00:00 | 192.168.1.1 | 0.15 |

| 1002 | 2024-01-01 09:00:00 | 202.108.0.1 | 0.0 |

| 1002 | 2024-01-01 22:00:00 | 111.13.100.9 | 0.85 |

3.2 认知层:异常检测与威胁关联

认知层的核心是**“用AI找出‘异常’,并用知识图谱关联‘威胁’”**。

3.2.1 异常检测:用孤立森林识别“异常登录”

孤立森林(Isolation Forest)是最适合实时异常检测的算法——它通过“随机分割数据”构建决策树,路径越短的样本越可能是异常(比如“凌晨3点从美国IP登录的中国用户”)。

用scikit-learn实现:

from sklearn.ensemble import IsolationForest

import numpy as np

# 1. 准备特征数据:登录间隔(归一化后)+ 国家编码(转成数字)

# 注意:国家编码是类别型数据,需要用LabelEncoder转成数字

from sklearn.preprocessing import LabelEncoder

le = LabelEncoder()

login_logs["country_code_num"] = le.fit_transform(login_logs["country_code"])

X = login_logs[["login_interval_scaled", "country_code_num"]].values

# 2. 训练孤立森林模型

# contamination:异常样本的比例(假设1%的登录是异常)

model = IsolationForest(contamination=0.01, random_state=42)

model.fit(X)

# 3. 预测异常:-1=异常,1=正常

login_logs["anomaly"] = model.predict(X)

# 4. 查看异常样本

anomalies = login_logs[login_logs["anomaly"] == -1]

print(f"检测到{len(anomalies)}个异常登录事件")

print(anomalies[["user_id", "login_time", "ip", "country_code"]])

输出结果:

检测到12个异常登录事件

user_id login_time ip country_code

0 1003 2024-01-01 03:30:00 1.2.3.4 US

1 1005 2024-01-01 02:15:00 5.6.7.8 RU

...

3.2.2 威胁关联:用知识图谱找出“攻击链”

异常检测只能告诉你“这个登录有问题”,但知识图谱能告诉你“这个问题有多严重”——比如“这个IP在黑产数据库中,曾用于盗刷”。

我们用Neo4j构建简单的知识图谱:

- 节点:用户(User)、IP(IPAddress)、黑产记录(MaliciousRecord);

- 关系:用户“登录自”IP(LOGGED_FROM)、IP“属于”黑产(IS_MALICIOUS)。

用Cypher查询“异常登录的IP是否在黑产数据库中”:

MATCH (u:User)-[:LOGGED_FROM]->(ip:IPAddress)-[:IS_MALICIOUS]->(m:MaliciousRecord)

WHERE u.id IN $anomaly_user_ids

RETURN u.id, ip.address, m.description

输出结果:

| u.id | ip.address | m.description |

|---|---|---|

| 1003 | 1.2.3.4 | 该IP曾用于盗刷银行卡 |

| 1005 | 5.6.7.8 | 该IP属于黑产代理服务器 |

3.3 决策层:用规则引擎生成“行动指令”

决策层的关键是**“把AI的异常得分和业务规则结合”**——比如“如果异常登录的IP在黑产库中→直接冻结账号”。

我们用Drools规则引擎写两条核心规则:

规则1:异常登录+黑产IP→冻结账号

rule "Malicious IP Login - Freeze Account"

when

// 条件:登录事件是异常,且IP在黑产库中

$event : LoginEvent(anomaly == true, ip in MaliciousIPList)

then

// 行动:冻结账号,发送告警

$event.freezeAccount();

$event.sendAlert("账号被冻结:异常登录+黑产IP");

end

规则2:异常登录+非黑产IP→触发二次验证

rule "Anomaly Login - Trigger MFA"

when

// 条件:登录事件是异常,但IP不在黑产库中

$event : LoginEvent(anomaly == true, ip not in MaliciousIPList)

then

// 行动:触发二次验证(短信+人脸识别)

$event.triggerMFA();

$event.logAction("触发二次验证:异常登录");

end

3.4 执行层:用API调用实现自动化

执行层的核心是**“把规则引擎的指令变成实际动作”**——比如调用账号系统的API冻结账号。

用Python的requests库实现“冻结账号”:

import requests

def freeze_account(user_id):

"""调用账号系统API冻结账号"""

api_url = "https://api.ecommerce.com/accounts/freeze"

headers = {"Authorization": "Bearer YOUR_API_KEY"}

payload = {"user_id": user_id, "reason": "异常登录+黑产IP"}

try:

response = requests.post(api_url, headers=headers, json=payload)

response.raise_for_status() # 抛出HTTP错误

print(f"成功冻结账号:{user_id}")

except requests.exceptions.RequestException as e:

print(f"冻结账号失败:{e}")

# 批量冻结异常账号

for user_id in anomalies["user_id"].unique():

freeze_account(user_id)

3.5 自适应层:用在线学习优化模型

自适应层的核心是**“从行动结果中学习”**——比如“如果用户反馈‘二次验证是误判’→降低该用户的异常阈值”。

我们用增量式SVM(支持向量机)实现在线学习:

from sklearn.svm import SVC

from sklearn.model_selection import train_test_split

# 1. 加载初始训练数据(比如1000条登录记录)

X_train, X_test, y_train, y_test = train_test_split(

login_logs[["login_interval_scaled", "country_code_num"]],

login_logs["anomaly"],

test_size=0.2,

random_state=42

)

# 2. 初始化增量式SVM模型

model = SVC(kernel="linear", probability=True)

model.fit(X_train, y_train)

# 3. 模拟新数据到来(比如每天新增200条登录记录)

new_login_logs = pd.read_csv("new_login_logs.csv")

# (省略预处理步骤:和感知层一样)

X_new = new_login_logs[["login_interval_scaled", "country_code_num"]].values

y_new = new_login_logs["anomaly"].values

# 4. 在线更新模型

model.partial_fit(X_new, y_new)

# 5. 评估更新后的模型

accuracy = model.score(X_test, y_test)

print(f"更新后的模型准确率:{accuracy:.2f}")

输出结果:

更新后的模型准确率:0.95 → 比更新前提高了3%

四、实际应用:电商平台“用户登录安全智能体”的实战案例

接下来,我们用真实电商场景展示数据安全智能体的落地全流程——假设你是某电商平台的AI架构师,要解决“盗号攻击导致用户数据泄露”的问题。

4.1 需求分析:明确“保护什么”和“解决什么”

- 保护目标:用户的隐私数据(姓名、地址、银行卡号)、账号资产(余额、优惠券);

- 核心问题:

- 盗号攻击(用泄露的账号密码批量登录);

- 异常操作(比如修改收货地址后立即下单);

- 误判率高(比如经常把“出差用户”的登录当成异常)。

4.2 系统设计:5层架构的具体实现

1. 感知层:整合多源数据

- 数据源:登录系统(login_logs)、支付系统(pay_logs)、设备管理系统(device_info)、DLP系统(sensitive_data_tags);

- 实时采集:用Apache Flink做流处理,将数据延迟从“10分钟”降到“1秒”;

- 特征提取:除了“登录间隔”,还增加“设备相似度”(比如“当前设备和常用设备的浏览器指纹相似度”)。

2. 认知层:AI+知识图谱的双引擎

- 异常检测:用孤立森林+AutoEncoder双模型(孤立森林检测“登录间隔异常”,AutoEncoder检测“设备行为异常”);

- 威胁关联:接入VirusTotal(全球最大的威胁情报库),查询IP/域名的恶意记录;

- 隐私保护:用联邦学习训练用户行为模型——比如和其他电商平台合作,在不共享用户数据的情况下,共同优化异常检测模型。

3. 决策层:“用户分层+规则优先级”

- 用户分层:将用户分为“普通用户”“VIP用户”“新用户”,制定不同的规则:

- VIP用户:异常得分>0.9才触发二次验证(避免影响体验);

- 新用户:异常得分>0.5就触发二次验证(因为新用户更容易被攻击);

- 规则优先级:“黑产IP”的优先级高于“登录间隔异常”——如果IP在黑产库中,直接冻结账号,不管其他特征。

4. 执行层:全链路自动化

- 自动操作:

- 异常登录→触发二次验证(短信+人脸识别);

- 二次验证失败→冻结账号+发送告警给安全团队;

- 异常支付→拦截订单+通知用户;

- 人工干预:对于“VIP用户的异常操作”,系统会将告警推送给安全分析师,由人工确认后再执行。

5. 自适应层:强化学习优化策略

- 反馈收集:通过“用户反馈按钮”收集“误判”信息(比如“我是出差,不是盗号”);

- 强化学习:用**DQN(深度Q网络)**训练智能体——智能体的“动作”是“触发二次验证”或“直接冻结”,“奖励”是“用户反馈的满意度”(比如“用户说‘误判’→扣10分,用户说‘正确’→加20分”);

- 效果评估:每两周用A/B测试对比“旧策略”和“新策略”的误报率、漏报率。

4.3 效果评估:数据说话

部署智能体3个月后,平台的安全指标发生了显著变化:

- 盗号攻击的漏报率从15%降到3%(几乎所有盗号行为都被检测到);

- 异常操作的误报率从10%降到2%(用户投诉率下降40%);

- 安全团队的响应时间从30分钟降到5分钟(自动化处理了80%的告警);

- 数据泄露事故发生次数从每月2次降到0次(彻底解决了用户信息泄露问题)。

4.4 常见问题及解决方案

问题1:误判率高,用户抱怨“经常要二次验证”

- 解决方案:加入上下文特征(比如“用户最近7天的出差记录”“常用设备的地理位置”),用加权得分计算异常值——比如“常用设备的权重是0.3,登录间隔的权重是0.2,出差记录的权重是0.5”。

问题2:处理延迟高,无法实时拦截攻击

- 解决方案:用Flink流处理替代批处理,将数据处理延迟从“分钟级”降到“秒级”;用Redis存储用户的“实时状态”(比如“最近10分钟的登录记录”),快速判断异常。

问题3:模型过拟合,无法识别新的攻击手段

- 解决方案:用对抗训练提高模型的鲁棒性——比如生成“ adversarial examples ”(比如修改IP的地理位置信息,模拟正常用户的行为),让模型学习识别这些“伪装的攻击”。

五、未来展望:数据安全智能体的“进化方向”

年薪百万的AI架构师不会满足于“当前的成功”——他们会看向未来,思考“智能体下一个阶段会变成什么样”。以下是3个最值得关注的趋势:

5.1 趋势1:多智能体协作(Multi-Agent System)

未来的安全体系不是“一个智能体打天下”,而是多个智能体协同工作:

- 终端智能体:安装在用户的手机/电脑上,收集设备的安全状态(比如“是否被root”“是否安装了恶意APP”);

- 云端智能体:分析全局数据(比如“某IP在1小时内登录了100个账号”);

- 边缘智能体:部署在边缘服务器上,处理低延迟的请求(比如“实时拦截异常支付”)。

比如:终端智能体检测到“手机被root”→通知云端智能体→云端智能体加强对该用户的验证(比如要求人脸识别)→边缘智能体拦截该用户的支付请求(直到验证通过)。

5.2 趋势2:大模型整合(LLM-Powered Security)

大语言模型(比如GPT-4、Claude 3)的“理解能力”和“生成能力”,会让数据安全智能体更“聪明”:

- 威胁分析:用大模型分析自然语言的威胁报告(比如“黑产论坛上的攻击教程”),提取“攻击手法”“目标行业”等信息;

- 决策生成:用大模型生成“个性化的防御策略”(比如“对于电商平台的大促期间,建议增加‘验证码+人脸识别’的二次验证”);

- 可解释性:用大模型生成“决策的自然语言解释”(比如“为什么冻结你的账号?因为你的登录IP在黑产库中,曾用于盗刷银行卡”)。

5.3 趋势3:隐私增强AI(Privacy-Enhancing AI)

随着《数据安全法》《GDPR》等法规的完善,“保护用户隐私”会成为智能体的“必修课”:

- 联邦学习:多个企业的智能体在不共享原始数据的情况下,共同训练模型(比如电商平台A和电商平台B合作,训练“盗号攻击检测模型”);

- 同态加密:智能体在“加密的数据”上进行计算(比如计算用户的“异常得分”,不需要解密用户的登录记录);

- 差分隐私:在数据中加入“噪声”,让攻击者无法识别具体的用户(比如“统计‘异常登录的用户数’时,加入±5的噪声”)。

5.4 潜在挑战:未来需要解决的问题

- 对抗攻击:攻击者会“针对智能体的模型”进行攻击(比如生成“ adversarial examples ”绕过异常检测),需要智能体具备“对抗鲁棒性”;

- 可解释性:监管机构要求“智能体的决策必须可解释”(比如“为什么冻结这个账号?”),需要用SHAP、LIME等工具生成“决策的解释”;

- 人才短缺:数据安全智能体需要“懂AI+懂安全+懂业务”的复合型人才,目前这类人才的缺口超过100万。

六、总结:年薪百万的“底层逻辑”

看到这里,你应该明白了:年薪百万的AI架构师,不是因为他们“会写代码”,而是因为他们“能解决企业的核心问题”——用数据安全智能体解决“被动防御”的痛点,帮企业避免数千万的损失,提升用户体验。

总结本文的核心要点:

- 数据安全智能体的本质:从“被动堵漏”到“主动防御”的闭环系统;

- 核心组件:感知层(收集数据)→认知层(分析威胁)→决策层(生成指令)→执行层(采取行动)→自适应层(学习优化);

- 关键技术:孤立森林(异常检测)、知识图谱(威胁关联)、规则引擎(决策)、在线学习(自适应);

- 落地技巧:结合业务规则(不是纯AI)、重视用户体验(降低误判率)、建立反馈闭环(越用越聪明)。

思考问题:让你更深入的探索

- 你所在的企业有哪些“数据安全痛点”?数据安全智能体可以解决其中的哪些问题?

- 如何平衡“智能体的自动化”和“人工干预”?比如哪些决策需要“自动执行”,哪些需要“人工确认”?

- 如何评估“数据安全智能体的效果”?你会用哪些指标(比如漏报率、误报率、响应时间、用户满意度)?

- 数据安全智能体的“可解释性”有多重要?你会用哪些方法提高可解释性(比如SHAP、大模型生成解释)?

参考资源

- 法规:《中华人民共和国数据安全法》《通用数据保护条例(GDPR)》;

- 书籍:《AI安全工程:构建可靠、安全、可解释的AI系统》《数据安全架构设计》;

- 工具:scikit-learn(异常检测)、Neo4j(知识图谱)、Drools(规则引擎)、Flink(流处理);

- 标准:NIST AI安全框架(NIST AI Risk Management Framework)、ISO/IEC 27001(信息安全管理体系)。

最后:数据安全不是“技术问题”,而是“生存问题”——对于企业来说,一次数据泄露可能导致破产;对于用户来说,一次信息泄露可能导致财产损失。而数据安全智能体,就是企业和用户的“安全盾”。希望这篇文章能帮你掌握这套“年薪百万级”的设计模式,让你的数据安全系统“活”起来!

—— 一个曾帮企业避免千万级损失的AI架构师

2024年XX月XX日

更多推荐

已为社区贡献257条内容

已为社区贡献257条内容

所有评论(0)