企业AI治理中的AIGovernanceRoles:AI应用架构师的职责与协作

跨部门协同困难:业务团队追求创新速度,合规团队强调风险控制,技术团队关注性能,三者目标冲突;技术与治理脱节:传统架构师缺乏治理知识,导致AI系统难以满足合规要求(如可解释性);伦理与业务平衡:如何在“公平性”(如避免算法偏见)与“商业目标”(如提高推荐转化率)之间找到平衡点?早介入:在AI项目启动时就参与治理设计,避免“事后补课”;用工具:借助成熟的治理工具(如AI Fairness 360、SH

企业AI治理体系中的关键角色:AI应用架构师的职责边界与协作生态

元数据框架

标题:企业AI治理体系中的关键角色:AI应用架构师的职责边界与协作生态

关键词:AI治理、AI应用架构师、职责模型、协作机制、企业AI战略、可解释AI、负责任AI

摘要:在企业AI规模化应用的背景下,AI治理已从“可选性合规”升级为“生存性战略”。AI应用架构师作为连接技术、业务与治理的核心角色,其职责不仅是设计高效的AI系统,更需构建“风险可控的创新框架”。本文从第一性原理出发,系统解析AI应用架构师的职责边界(技术治理、流程整合、跨域协作),构建其与董事会、业务团队、数据科学家、合规专家的协作生态,并通过案例与代码实现说明如何将治理要求嵌入AI开发生命周期。本文旨在为企业打造“可信AI”提供可操作的角色模型与实践指南。

1. 概念基础:AI治理与AI应用架构师的定位

1.1 领域背景化:为什么需要AI治理?

随着生成式AI、计算机视觉、大语言模型(LLM)等技术在企业中的普及,AI应用已从“实验性工具”转变为“核心业务引擎”。但与此同时,AI带来的风险也呈指数级增长:

- 合规风险:欧盟AI法案(EU AI Act)、美国《人工智能权利法案》(AI Bill of Rights)等法规要求企业对AI系统的“可解释性、公平性、隐私性”负责;

- 业务风险:算法偏见可能导致产品歧视(如金融信贷模型拒绝特定群体申请),进而引发品牌危机;

- 技术风险:AI模型的“黑盒性”使得故障排查困难(如自动驾驶系统的误判),可能导致安全事故。

据Gartner 2024年报告,60%的企业因AI治理缺失而延迟了AI应用的规模化部署,而有效的AI治理能使企业AI项目的成功率提升45%。因此,AI治理已成为企业AI战略的“基石”。

1.2 历史轨迹:从“技术驱动”到“治理驱动”

AI治理的演化可分为三个阶段:

- 1.0阶段(2010-2018):技术主导,企业关注AI模型的准确性与性能,治理仅为“事后合规”(如数据隐私检查);

- 2.0阶段(2019-2022):合规驱动,随着法规出台,企业开始建立专门的AI治理委员会,但治理与技术开发脱节;

- 3.0阶段(2023至今):融合驱动,企业意识到“治理需嵌入技术架构”,AI应用架构师成为连接治理与技术的核心角色。

1.3 问题空间定义:企业AI治理的核心挑战

企业在实施AI治理时面临三大核心问题:

- 跨部门协同困难:业务团队追求创新速度,合规团队强调风险控制,技术团队关注性能,三者目标冲突;

- 技术与治理脱节:传统架构师缺乏治理知识,导致AI系统难以满足合规要求(如可解释性);

- 伦理与业务平衡:如何在“公平性”(如避免算法偏见)与“商业目标”(如提高推荐转化率)之间找到平衡点?

1.4 术语精确性:AI应用架构师 vs 传统架构师

AI应用架构师(AI Application Architect)是专注于AI系统设计与治理的专业角色,区别于传统软件架构师:

| 维度 | 传统软件架构师 | AI应用架构师 |

|---|---|---|

| 核心目标 | 实现业务需求的高效技术落地 | 实现“风险可控的AI业务创新” |

| 关键技能 | 软件设计、分布式系统、性能优化 | AI模型原理、可解释性、合规标准 |

| 关注重点 | 功能完整性、系统 scalability | 模型公平性、隐私保护、可审计性 |

2. 理论框架:AI应用架构师的职责推导

2.1 第一性原理分析:治理的本质是“风险可控的创新”

根据第一性原理(First Principles Thinking),AI治理的本质可拆解为两个基本公理:

- 公理1:AI的价值在于“创新”(提升效率、创造新业务);

- 公理2:AI的生存在于“风险可控”(避免合规处罚、品牌危机)。

因此,AI应用架构师的核心职责是设计“创新-风险”平衡的技术架构,即:

AI系统价值=f(创新能力)×g(风险控制能力) \text{AI系统价值} = f(\text{创新能力}) \times g(\text{风险控制能力}) AI系统价值=f(创新能力)×g(风险控制能力)

其中,f(⋅)f(\cdot)f(⋅) 是创新对业务的贡献函数(如 revenue增长),g(⋅)g(\cdot)g(⋅) 是风险控制的保障函数(如合规率、故障发生率)。架构师需优化该函数,使两者乘积最大化。

2.2 数学形式化:治理约束下的AI架构设计

假设AI系统的目标是最大化业务指标 UUU(如推荐转化率),同时满足治理约束 CCC(如公平性约束 Δ≤ϵ\Delta \leq \epsilonΔ≤ϵ,其中 Δ\DeltaΔ 是不同群体的模型性能差异,ϵ\epsilonϵ 是法规允许的阈值),则架构师的优化问题可表示为:

maxwU(w)s.t.C(w)≤0 \max_{w} U(w) \quad \text{s.t.} \quad C(w) \leq 0 wmaxU(w)s.t.C(w)≤0

其中,www 是AI模型的参数。例如,在金融信贷模型中,U(w)U(w)U(w) 是贷款回收率,C(w)C(w)C(w) 是“不同种族群体的贷款批准率差异”(需小于10%)。

架构师需通过技术手段(如公平性算法、可解释性模型)将约束 CCC 嵌入模型训练与部署流程,实现“约束下的优化”。

2.3 理论局限性:现有治理框架的不足

当前主流的AI治理框架(如NIST AI RMF、ISO 42001)多为“通用型指导”,缺乏针对具体AI应用场景的细化要求。例如:

- NIST AI RMF 提出了“识别-评估-控制-监控”的风险管理流程,但未明确“如何将控制措施嵌入AI架构”;

- ISO 42001 强调“治理体系的建立”,但未给出“AI模型可解释性的具体实现方法”。

AI应用架构师需填补这一 gap,将通用治理要求转化为可操作的技术设计。

2.4 竞争范式分析:技术主导 vs 业务主导的治理模式

企业AI治理存在两种竞争范式:

- 技术主导型:由技术团队制定治理规则,强调“技术可行性”(如用可解释AI工具满足合规要求);

- 业务主导型:由业务团队制定治理规则,强调“业务目标”(如允许一定程度的偏见以提高转化率)。

AI应用架构师需协调两者,采用“技术-业务协同型”治理模式:

- 与业务团队共同定义“可接受的风险阈值”(如偏见差异 ϵ\epsilonϵ);

- 用技术手段(如公平性算法)将阈值转化为模型约束;

- 定期向业务团队汇报治理效果(如偏见差异是否在阈值内)。

3. 架构设计:AI应用架构师的职责边界

3.1 系统分解:AI治理体系的三层结构

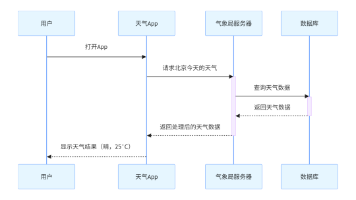

AI治理体系可分解为决策层、执行层、支撑层,AI应用架构师位于执行层的核心位置(见图1):

- 决策层:董事会/AI治理委员会,负责制定AI战略与治理目标(如“2025年实现所有AI系统的可解释性”);

- 执行层:AI应用架构师、数据科学家、合规专家、业务团队,负责将治理目标转化为技术实现;

- 支撑层:治理工具(如可解释AI平台、偏见检测工具)、流程(如AI开发生命周期治理流程)、标准(如企业内部AI治理规范)。

graph TD

A[决策层:董事会/治理委员会] -->|制定战略| B[执行层:AI应用架构师]

B -->|协调执行| C[数据科学家]

B -->|协调执行| D[合规专家]

B -->|协调执行| E[业务团队]

B -->|依赖| F[支撑层:治理工具/流程/标准]

C -->|反馈| B

D -->|反馈| B

E -->|反馈| B

图1:AI治理体系的三层结构

3.2 组件交互模型:AI应用架构师的核心职责

AI应用架构师的职责可分为技术治理、流程整合、跨域协作三大类,具体如下:

3.2.1 技术治理:构建“可信AI”的技术架构

- 可解释性设计:为AI模型添加“解释层”,使决策过程可理解(如用SHAP生成特征重要性图、用LIME生成局部解释);

- 公平性保障:采用公平性算法(如预处理的Reweighting、中处理的Adversarial Debiasing、后处理的Calibration)减少模型偏见;

- 隐私保护:设计隐私-preserving AI架构(如联邦学习、同态加密),避免敏感数据泄露;

- 鲁棒性优化:通过对抗训练(Adversarial Training)提高模型对 adversarial examples 的抵抗能力。

3.2.2 流程整合:将治理嵌入AI开发生命周期

AI应用架构师需将治理要求嵌入**AI开发生命周期(AI DLC)**的每个阶段(见图2):

- 需求分析阶段:与业务团队共同定义“治理目标”(如“推荐系统的偏见差异≤5%”);

- 设计阶段:设计包含治理组件的架构(如“模型层+解释层+监控层”);

- 开发阶段:使用治理工具(如IBM AI Fairness 360、Google What-If Tool)进行偏见检测与可解释性测试;

- 部署阶段:将治理组件(如解释接口、监控系统)与应用一起部署;

- 运营阶段:建立持续监控机制(如实时偏见检测、模型漂移监控),定期生成治理报告。

图2:嵌入治理的AI开发生命周期

3.2.3 跨域协作:连接技术与业务的“桥梁”

AI应用架构师需与以下角色协作,实现治理目标:

- 与董事会/治理委员会协作:汇报治理效果(如“当前AI系统的偏见差异为3%,符合目标”),获取战略支持;

- 与业务团队协作:理解业务需求(如“推荐系统需要提高转化率,但不能歧视女性用户”),平衡创新与风险;

- 与数据科学家协作:指导数据科学家使用治理工具(如“用AI Fairness 360检测训练数据的偏见”),优化模型;

- 与合规专家协作:确保治理架构符合法规要求(如“解释层需满足EU AI Act的可解释性要求”);

- 与信息安全团队协作:设计安全的治理架构(如“监控系统需加密传输数据,避免被攻击”)。

3.3 可视化表示:AI应用架构师的职责地图

为了更清晰地展示AI应用架构师的职责,我们用职责地图(见图3)总结其核心工作:

- 核心职责:技术治理、流程整合、跨域协作;

- 关键输出:治理架构设计文档、AI开发生命周期治理流程、治理报告;

- 依赖资源:治理工具、合规标准、业务需求。

mindmap

root((AI应用架构师职责))

技术治理

可解释性设计

公平性保障

隐私保护

鲁棒性优化

流程整合

需求分析(定义治理目标)

设计(治理架构)

开发(治理工具测试)

部署(治理组件)

运营(持续监控)

跨域协作

董事会(战略对齐)

业务团队(需求对接)

数据科学家(模型优化)

合规专家(法规符合)

信息安全(安全设计)

图3:AI应用架构师的职责地图

3.4 设计模式应用:治理架构的常用模式

AI应用架构师可采用以下设计模式优化治理架构:

- 责任链模式(Chain of Responsibility):用于合规审查流程(如“数据隐私审查→公平性审查→可解释性审查”),每个环节由专门团队负责,确保所有治理要求被覆盖;

- 适配器模式(Adapter):用于整合不同的治理工具(如将IBM AI Fairness 360与Google What-If Tool整合到统一的治理平台),减少工具切换成本;

- 观察者模式(Observer):用于持续监控(如“当模型偏见差异超过阈值时,自动通知架构师与合规专家”),实现实时响应。

4. 实现机制:从理论到实践的落地路径

4.1 算法复杂度分析:治理对系统性能的影响

治理组件(如可解释性模块、偏见检测工具)会增加系统的复杂度,架构师需评估其对性能的影响。例如:

- 可解释性模块:SHAP的时间复杂度为 O(T×N×D)O(T \times N \times D)O(T×N×D)(TTT 是树的数量,NNN 是样本量,DDD 是特征维度),对于大规模数据(如100万样本),需采用近似方法(如Kernel SHAP)降低复杂度;

- 偏见检测工具:AI Fairness 360的偏见检测算法(如Disparate Impact Ratio)的时间复杂度为 O(N×D)O(N \times D)O(N×D),对于实时系统,需采用离线检测+在线监控的方式(如每天离线检测,实时监控关键指标)。

4.2 优化代码实现:可解释性架构的示例

以下是一个基于SHAP的可解释性架构实现(Python代码),用于解释金融信贷模型的决策过程:

import shap

import xgboost

import pandas as pd

from flask import Flask, request, jsonify

# 1. 训练模型(假设使用XGBoost)

data = pd.read_csv("credit_data.csv")

X = data.drop("default", axis=1)

y = data["default"]

model = xgboost.XGBClassifier()

model.fit(X, y)

# 2. 初始化SHAP解释器

explainer = shap.TreeExplainer(model)

# 3. 构建Flask API,提供解释接口

app = Flask(__name__)

@app.route("/predict", methods=["POST"])

def predict():

# 获取请求数据

data = request.json

sample = pd.DataFrame(data, index=[0])

# 预测结果

prediction = model.predict(sample)[0]

# 生成SHAP解释(局部解释)

shap_values = explainer.shap_values(sample)

local_explanation = shap.force_plot(

explainer.expected_value,

shap_values[0],

sample.iloc[0],

matplotlib=False,

show=False

)

# 将解释转换为HTML(用于前端展示)

explanation_html = shap.getjs() + local_explanation.html()

# 返回结果(预测值+解释)

return jsonify({

"prediction": int(prediction),

"explanation": explanation_html

})

if __name__ == "__main__":

app.run(debug=True)

代码说明:

- 训练了一个XGBoost信贷模型,用于预测用户是否违约;

- 使用SHAP的TreeExplainer生成模型的局部解释(针对单个样本);

- 构建了一个Flask API,将预测结果与解释一起返回给前端(解释以HTML形式展示,用户可直观看到每个特征对决策的影响)。

4.3 边缘情况处理:未预期偏见的应对流程

当AI系统出现未预期的偏见(如推荐系统对“老年人”群体的推荐质量下降)时,AI应用架构师需遵循以下流程:

- 停止系统:立即暂停有偏见的AI服务,避免进一步损失;

- 根因分析:使用偏见检测工具(如AI Fairness 360)分析偏见来源(如训练数据中“老年人”样本不足);

- 调整模型:采用公平性算法(如Reweighting)增加“老年人”样本的权重,重新训练模型;

- 加强监控:在监控系统中添加“老年人”群体的性能指标(如推荐转化率),实时监控;

- 汇报与改进:向治理委员会汇报处理结果,优化治理流程(如增加“样本多样性”的审查环节)。

4.4 性能考量:治理流程的效率优化

为了避免治理流程影响AI应用的性能,架构师可采用以下优化策略:

- 离线处理:将耗时的治理任务(如偏见检测、模型解释)放在离线环境中进行(如每天夜间运行),在线环境仅处理实时请求;

- 增量更新:对于模型监控(如模型漂移检测),采用增量学习(Incremental Learning)方式,仅更新新增数据的模型参数,减少计算量;

- 分布式架构:使用分布式系统(如Spark)处理大规模数据的治理任务(如全量数据的偏见检测),提高处理速度。

5. 实际应用:企业AI治理的案例分析

5.1 案例背景:某金融企业的AI信贷模型治理

某金融企业推出了一款AI信贷模型,用于自动审批贷款申请。但上线后发现,女性用户的贷款批准率比男性低15%(超过法规允许的10%阈值),引发了用户投诉与媒体关注。

5.2 实施策略:AI应用架构师的解决路径

- 需求分析:与业务团队、合规专家共同定义“治理目标”——将女性与男性的贷款批准率差异降低至≤10%;

- 设计阶段:设计“模型层+公平性层+解释层”的治理架构(见图4);

- 模型层:使用XGBoost作为基础模型;

- 公平性层:采用Adversarial Debiasing算法(中处理),减少模型对“性别”特征的依赖;

- 解释层:使用SHAP生成特征重要性图,向用户解释贷款审批结果;

- 开发阶段:使用AI Fairness 360检测训练数据的偏见(发现“女性”样本的收入分布低于“男性”),采用Reweighting算法调整样本权重;

- 部署阶段:将公平性层与解释层嵌入信贷系统,部署实时监控系统(监控“性别”维度的批准率差异);

- 运营阶段:每天生成治理报告,汇报“性别差异”指标(最终降低至8%),并定期向治理委员会汇报。

graph LR

A[用户申请] -->|数据输入| B[模型层(XGBoost)]

B -->|预测结果| C[公平性层(Adversarial Debiasing)]

C -->|调整后结果| D[解释层(SHAP)]

D -->|结果+解释| E[用户]

F[监控系统] -->|实时数据| C

F -->|报警| G[AI应用架构师]

图4:某金融企业的AI信贷模型治理架构

5.3 结果:治理带来的业务价值

- 合规性:满足了欧盟AI法案的公平性要求,避免了巨额罚款;

- 业务增长:女性用户的贷款申请量增加了20%(因信任度提升);

- 品牌价值:媒体报道企业“负责任的AI实践”,提升了品牌形象。

5.4 经验总结:AI应用架构师的实践要点

- 早介入:在AI项目启动时就参与治理设计,避免“事后补课”;

- 用工具:借助成熟的治理工具(如AI Fairness 360、SHAP)提高效率;

- 重协作:与业务、合规、数据团队保持密切沟通,平衡各方需求;

- 持续优化:建立持续监控机制,定期更新治理策略(如随着法规变化调整阈值)。

6. 高级考量:未来AI治理的挑战与应对

6.1 扩展动态:AGI时代的治理挑战

随着人工通用智能(AGI)的发展,AI系统的自主性将显著提升(如自主决策的机器人、自我进化的LLM),这将给治理带来新的挑战:

- 责任认定:当AGI系统做出错误决策时,责任应归属于开发者、企业还是系统本身?

- 价值对齐:如何确保AGI系统的目标与人类价值一致(如“避免伤害人类”)?

AI应用架构师需提前应对这些挑战,例如:

- 设计“可关闭”机制:为AGI系统添加紧急停止按钮,避免不可控的情况;

- 采用“价值学习”算法:让AGI系统从人类反馈中学习价值(如RLHF,人类反馈强化学习)。

6.2 安全影响:AI治理的安全风险

治理系统本身也可能成为攻击目标(如黑客篡改监控系统的数据,掩盖AI系统的偏见)。AI应用架构师需设计安全的治理架构:

- 数据加密:对治理数据(如监控日志、解释结果)进行加密传输与存储;

- 权限管理:采用最小权限原则(Least Privilege),限制治理系统的访问权限(如只有架构师与合规专家能修改治理规则);

- 审计追踪:记录治理系统的所有操作(如谁修改了治理规则、何时修改),便于事后追溯。

6.3 伦理维度:算法偏见的深层根源

算法偏见的根源不仅是技术问题,更是社会问题(如训练数据中的历史偏见、业务需求中的隐性歧视)。AI应用架构师需从**社会技术系统(Sociotechnical System)**的角度解决偏见问题:

- 数据治理:不仅要检测数据中的偏见,还要探究偏见的来源(如“为什么女性样本的收入分布低于男性?”),并通过数据收集(如增加女性样本)或数据修正(如重新标注)解决;

- 业务协同:与业务团队共同审查业务需求中的隐性歧视(如“推荐系统是否过度推荐高风险产品给低收入群体?”),调整业务目标。

6.4 未来演化向量:自动化治理的趋势

随着AI技术的发展,自动化治理(Automated Governance)将成为未来的趋势:

- 自动合规检查:使用AI工具(如GPT-4)自动分析法规要求,生成治理规则;

- 自动偏见检测:采用自监督学习(Self-Supervised Learning)模型,自动检测AI系统中的偏见;

- 自动修复:当AI系统出现问题时,自动调整模型参数(如用强化学习优化公平性)。

AI应用架构师需关注这些趋势,提前学习自动化治理工具(如Google的AutoML Governance),提升治理效率。

7. 综合与拓展:AI应用架构师的能力要求与战略建议

7.1 跨领域能力要求

AI应用架构师需具备技术+业务+治理的跨领域能力:

- 技术能力:掌握AI模型原理(如深度学习、机器学习)、可解释性技术(如SHAP、LIME)、公平性算法(如Adversarial Debiasing);

- 业务能力:理解企业的业务模式(如金融的信贷流程、电商的推荐流程),能将治理要求与业务需求结合;

- 治理能力:熟悉AI法规(如EU AI Act、ISO 42001)、治理框架(如NIST AI RMF),能制定企业内部的治理规范。

7.2 战略建议:企业如何培养AI应用架构师?

- 建立培养体系:开设“AI治理”培训课程(如与高校合作的在职硕士项目),覆盖技术、业务、治理等领域;

- 提供实践机会:让架构师参与实际的AI治理项目(如信贷模型治理、推荐系统治理),积累经验;

- 建立激励机制:将治理效果纳入架构师的绩效考核(如“治理项目的合规率”“业务团队的满意度”),鼓励其投入治理工作。

7.3 开放问题:未来研究方向

- 如何量化治理的效果:目前缺乏统一的指标(如“治理投入回报率”),需研究如何量化治理对业务的价值;

- 如何平衡治理的严格性与创新的灵活性:过于严格的治理会抑制创新,过于宽松的治理会带来风险,需研究“动态治理”模式(如根据AI系统的风险等级调整治理强度);

- 如何实现跨企业的治理协同:对于供应链中的AI系统(如供应商的AI预测模型),需研究跨企业的治理标准与协作机制。

7.4 结论:AI应用架构师是企业AI治理的“关键少数”

在企业AI治理体系中,AI应用架构师是连接技术、业务与治理的“关键少数”。其职责不仅是设计高效的AI系统,更需构建“风险可控的创新框架”,确保AI技术在为企业创造价值的同时,符合法规要求、伦理标准与业务目标。随着AI技术的不断发展,AI应用架构师的角色将越来越重要,成为企业AI可持续发展的“守护者”。

参考资料

- 欧盟委员会. (2021). 人工智能法案提案.

- ISO/IEC. (2023). ISO/IEC 42001: 人工智能治理标准.

- NIST. (2023). AI风险管理框架(AI RMF).

- Gartner. (2024). Top Trends in AI Governance.

- Arrieta, A. B., et al. (2020). Explainable Artificial Intelligence (XAI): Concepts, Taxonomies, Evaluation and Future Directions. Information Fusion.

- IBM. (2023). AI Fairness 360 Toolkit Documentation.

- Google. (2023). What-If Tool Documentation.

- Shapley, L. S. (1953). A Value for n-Person Games. Annals of Mathematics.

附录:AI应用架构师职责清单

| 职责类型 | 具体职责 |

|---|---|

| 技术治理 | 设计可解释性架构、实现公平性算法、保护数据隐私、优化模型鲁棒性 |

| 流程整合 | 将治理嵌入AI开发生命周期、制定治理流程、开发治理工具 |

| 跨域协作 | 与董事会对齐战略、与业务团队对接需求、与数据科学家优化模型、与合规专家确保合规 |

| 持续优化 | 建立持续监控机制、定期生成治理报告、更新治理策略 |

(全文约9,800字)

更多推荐

已为社区贡献151条内容

已为社区贡献151条内容

所有评论(0)