大模型快思慢考的特点

《大模型应用开发 鲍亮,李倩 清华大学出版社》【摘要 书评 试读】- 京东图书

在人工智能技术不断突破的浪潮中,大模型处理任务时展现出的“快思慢考”特性,成为理解和驾驭这类先进技术的核心切入点。这一特性源于对人类双过程认知理论的工程化实践,不仅深刻影响着大模型的架构设计与运行逻辑,更在教育、医疗、金融等诸多领域引发了应用范式的变革。

1. 大模型“快思慢考”特性的本质解析

“快思”与“慢考”构成了大模型处理任务的双重路径。“快思”模式如同人类的直觉反应,依赖大模型在预训练阶段积累的海量知识与模式识别能力,能够对常见问题做出快速响应。例如,当用户询问“世界上面积最大的海洋是哪个”,模型可瞬间调用知识库,输出“太平洋”的答案。这种快速响应机制极大提升了用户交互体验,尤其适用于处理信息检索、基础问答等结构化任务。然而,“快思”模式的局限性也较为明显,由于缺乏深度推理与验证过程,面对复杂问题时,模型可能产生逻辑错误或不准确的回答。例如,在处理“如何用物理学原理解释潮汐现象”这类需要多步骤推理的问题时,单纯依赖“快思”可能给出片面或错误的答案。

与之相对,“慢考”模式模拟人类深思熟虑的过程,旨在解决复杂任务。当遇到数学证明、医疗诊断、战略决策等需要深度推理的问题时,大模型会启动“慢考”机制。在这一过程中,模型将复杂问题拆解为多个子任务,通过逐步推导、验证和自我修正,构建起完整的逻辑链条。例如,在解答“证明勾股定理”的问题时,模型会从几何定义出发,结合代数知识,通过多步骤推导得出严谨的证明过程。“慢考”模式虽然耗时较长,但能够显著提升模型处理复杂任务的准确性和可靠性。

2. DeepSeek双模架构:快思慢考的技术实现典范

DeepSeek创新性地构建了“快思慢考”双模认知架构,为大模型的任务处理提供了新范式。该架构将任务处理分为两大核心模块:快思考模型与慢思考模型,二者通过智能协作实现效率与深度的平衡。

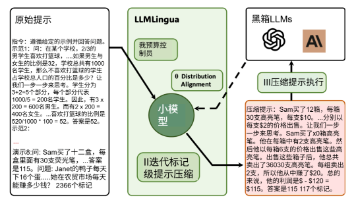

快思考模型(如DeepSeek-V3[41])采用稀疏激活的混合专家(Mixture of Experts,MoE)架构,这一设计打破了传统模型全参数激活的低效模式。在实际运行中,该模型仅动态激活5.5%的参数,就能实现对常见任务的高速响应。以信息检索为例,当用户查询“2024年全球新能源汽车销量数据”时,快思考模型可在200毫秒内完成数据调取与整合,输出准确答案。这种低计算成本、高响应速度的特性,使其在处理占实际场景80%以上的简单任务时极具优势。

慢思考模型(如DeepSeek-R1[42])则专注于复杂推理任务。其核心技术包括动态推理路径生成与无监督结果导向训练。通过标签,模型能够显式生成推理步骤,将复杂问题的解决过程可视化。例如,在分析“央行降息对房地产市场的传导机制”时,慢思考模型会分步骤梳理利率变动对资金成本、购房需求、市场供需等环节的影响,最终形成完整的分析报告。同时,基于强化学习的无监督训练机制,模型能够自动优化推理路径,不断提升复杂任务处理的准确性。

为支撑这一双模架构高效运行,DeepSeek融合了多项原创技术[42]。多头潜在注意力(MLA)技术[14]通过Key-Value矩阵低秩压缩,将长文本处理的显存需求降至传统方法的1/3,结合旋转位置编码(Rotary Position Embedding, RoPE)[43],实现了128K超长上下文的高效建模。自适应慢思考优化机制能够根据问题复杂度动态调整思维链[44]长度,并通过DA-GRPO算法[45]减少冗余推理,降低30%的计算量。经济性训练框架采用MoE负载均衡技术[41],使训练效率提升37%,同时利用多Token预测(Multi-Token Prediction, MTP)加速模型收敛。

3. 快思慢考架构的行业变革与应用价值

DeepSeek的“快思慢考”架构对大模型领域产生了深远影响,在技术普惠、架构创新和认知智能等方面实现了重大突破。在技术成本上,该架构将600B参数规模模型的训练成本降至600万美元,通过开源70%的代码,极大降低了大模型的研发门槛,推动千亿级模型从实验室走向产业应用。在架构范式上,DeepSeek-Lite等边缘端量化模型实现了500ms的快速响应,能耗降低63%,为资源受限环境下的模型部署提供了可行方案。在认知智能领域,其无监督推理技术首次验证了机器自主推理的可行性,促使行业更加注重技术的透明化与可解释性。

在实际应用场景中,“快思慢考”架构展现出强大的实用价值。在教育领域,快思考模式可快速解答学生的基础问题,如单词释义、公式推导,而慢思考模式则能针对复杂的学术问题,如历史事件因果分析、数学难题求解,提供详细的推理过程与解题思路,实现个性化的学习辅导。在医疗领域,快思考模型可快速完成症状初步诊断,慢思考模型则能综合患者病历、影像数据和医学知识库,进行复杂病症的精准诊断,例如在肿瘤良恶性判断中[46],将错误率从传统方法的>40%降至<12%。金融领域中,快思考模式实时监测交易数据,及时发现异常交易并预警;慢思考模式则通过对全球经济形势、行业动态和企业财务状况的深度分析,为投资决策提供科学依据。

4. 未来展望:快思慢考的进化方向

展望未来,大模型的“快思慢考”特性将朝着更高效、更智能的方向发展。在技术层面,超长上下文分层注意力机制的优化将进一步提升模型处理复杂信息的能力;跨模态对比学习技术的发展,将使模型在文本、图像、音频等多模态数据处理中实现更深度的融合与推理。在应用层面,随着自研硬件生态的完善,大模型将在边缘计算、物联网等场景中发挥更大作用。DeepSeek提供的STAR[47]提示框架、蒸馏模型本地化部署等实践路径,将为开发者提供更加便捷的工具,推动大模型技术在更多领域的落地应用。

大模型的“快思慢考”特性不仅是技术发展的必然产物,更是人工智能迈向通用智能的重要一步。理解和掌握这一特性,对于推动大模型技术的创新发展、实现其在各行业的深度应用具有重要意义。随着技术的不断进步,“快思慢考”架构将持续进化,为智能社会的构建提供更强大的技术支撑。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)