年薪百万的金融提示工程架构师都在用的5大核心方法论

提示工程(Prompt Engineering)在金融领域远非简单的“和AI聊天”。它构建着智能投研、风险控制、量化策略的核心引擎。真正顶尖的金融提示工程架构师,凭借一套体系化、高价值的方法论,驱动着模型输出稳定、精准、合规的商业洞见。

好的,这个主题非常精准且具有吸引力!作为一名扎根技术的博主,我会重点拆解这五大方法论的核心精髓,并结合金融行业的特殊性,提供可落地的实战策略。以下是根据您要求撰写的技术博客:

标题:揭秘年薪百万金融提示工程架构师都在用的5大核心方法论

摘要: 提示工程(Prompt Engineering)在金融领域远非简单的“和AI聊天”。它构建着智能投研、风险控制、量化策略的核心引擎。真正顶尖的金融提示工程架构师,凭借一套体系化、高价值的方法论,驱动着模型输出稳定、精准、合规的商业洞见。本文将深度解析他们普遍掌握的五大核心方法论:数据驱动优化、量化策略适配、链式推理增强、系统级可靠设计、监管解释性工程,揭秘百万年薪背后的技术壁垒,助你构建金融级的高性能提示架构。

一、 引言:金融提示工程——模型之上,价值之下

金融行业以其数据密集、高合规性、强时效性、决策责任重大的特点,对AI的应用提出了近乎苛刻的要求。普通的提示工程技巧(如“明确指令”、“提供示例”)在这里只是基本功。真正的金融提示工程架构师需要在模型能力之上,构建一套稳健、高效、可审计、能持续产生商业价值的提示工程体系。这正是他们身价倍增的核心竞争力。

本文将聚焦于实践中被反复验证、由顶尖从业者提炼的五大核心方法论。掌握它们,你就能更高效地设计出能处理复杂金融任务(如宏观经济分析、财报精炼、风险预警提示、合规检查、交易信号生成)的提示工程架构。

二、 正文:5大核心方法论深度解析

方法论 1: 数据驱动提示优化 (Data-Driven Prompt Optimization, DDPO)

- 核心理念: 将提示设计视为一个可度量的实验过程,基于真实金融数据的反馈进行迭代优化。

- 问题痛点: 金融数据噪声大、分布偏移常见(如黑天鹅事件)、模型初始提示表现不稳定。

- 具体做法:

- 基线构建与指标定义: 针对目标任务(如“从财报文本中提取关键财务比率”),设计初始提示,定义清晰、可量化的评估指标(如

准确率、召回率、F1值、关键指标提取完整性、公式计算的正确性)。 - 生成-A/B 测试: 针对同一任务和数据集,设计和部署多个提示变体(如不同的示例选取、语境信息量、指令措辞、输出格式约束)。

- 实时监控 & 反馈闭环: 在线上环境(Sandbox或低风险环境)部署提示,实时监控关键指标。收集用户(分析师)的反馈信号(如修正比例、用户满意率)。利用错误样本进行根因分析(是数据理解问题?逻辑推理问题?格式错误?)。

- 自动化微调 (可选但强有力): 当收集到足够高质量反馈数据(模型错误预测 + 人工修正结果)时,使用类似

P-Tuning、LoRA等技术,高效微调底层大模型(或适配器层)对特定提示模式的理解能力。

- 基线构建与指标定义: 针对目标任务(如“从财报文本中提取关键财务比率”),设计初始提示,定义清晰、可量化的评估指标(如

- 金融价值:

- 最大化特定任务的模型性能,提升分析师效率和数据质量。

- 降低因模型输出错误导致的决策风险。

- 快速适应市场变化和新数据类型。

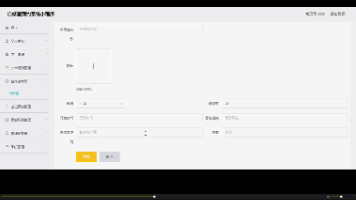

- 案例/可视化:

- (图表示例: 展示不同提示变体在财务比率提取任务上的A/B测试结果对比图:Accuracy, Recall, F1 Score)。

- (图示: DDPO 闭环流程图: 提示设计 -> 部署A/B测试 -> 指标监控 & 反馈收集 -> 根因分析 & 提示/模型迭代)。

- 最佳实践:

- 指标先行: 先定义什么是“好”的输出。

- 数据隔离: 严格区分训练集、验证集、测试集,避免过拟合。

- 关注数据漂移: 持续监控输入数据分布的变化,触发重新评估提示效果。

方法论 2: 量化策略适配层 (Quant Strategy Adaption Layer, QSAL)

- 核心理念: 针对金融领域独特的量化分析范式(如因子模型、统计套利、技术指标计算),设计专门的提示框架和接口,将大模型的自然语言能力无缝转化为量化分析流程中的关键环节。

- 问题痛点: 直接要求大模型生成交易策略或信号风险高、不可控、难以回溯测试和合规审查。模型擅长的理解、生成需要与严格的量化逻辑结合。

- 具体做法:

- 任务分解与角色定义: 将复杂的量化任务分解为LLM更擅长的子任务(如:

因子描述解释->相关新闻/事件提取->短期情绪分析->提供潜在影响预测(非决策))。 - 结构化输出约束: 强制要求LLM的输出严格匹配下游量化系统(Python库如Pandas, NumPy, TA-Lib, Backtrader)或内部研究平台的输入格式(如特定的JSON/CSV Schema)。例如:

输出{“factor”: “Momentum”, “sentiment_score”: 0.75, “related_tickers”: [“AAPL”, “MSFT”], “potential_impact”: “Positively affects tech sector momentum ETFs short-term”}。 - 提示作为“翻译器”: 设计提示,使LLM能够将非结构化的文本信息(如分析师报告、新闻)转化为结构化的量化因子输入数据,或将其推理结论转化为量化模型可以理解的假设/参数。

- 集成到回测框架: 将LLM生成的“信号假设”或“因子解释”作为输入,纳入传统量化回测框架进行严格的验证。LLM建议,量化模型决策。

- 任务分解与角色定义: 将复杂的量化任务分解为LLM更擅长的子任务(如:

- 金融价值:

- 将大模型的NLP优势安全地嵌入量化投研流水线。

- 提升量化策略开发的效率和信息广度。

- 保持量化策略的可回溯性、可解释性和可控性。

- 案例/可视化:

- (代码示例: 一个提示的片段,要求LLM根据新闻标题生成结构化的事件影响分析,用于量化事件驱动策略的回测输入)。

- (架构图: 展示 QSAL 的流程: 市场文本输入 -> LLM+QSAL提示 -> 结构化量化因子/事件 -> 量化策略引擎 -> 回测/执行)。

- 最佳实践:

- LLM做辅助,不做决策: 明确LLM在流程中的角色是提供信息输入或解释,而非直接生成买卖信号。

- 严格定义接口: 输入输出格式必须清晰、无歧义、易于程序化解析。

- 模型选择: 优先选择数学和逻辑推理能力强的金融微调模型(若有)。

方法论 3: 链式推理与自我验证 (Chain-of-Thought & Self-Verification, COT-SV)

- 核心理念: 利用大模型的推理步进能力(Chain-of-Thought)设计提示,引导其分解复杂金融推理任务(如风险评级推导、并购影响分析),并强制要求其对关键中间步骤或最终结论进行交叉检查(Self-Verification),大幅提升输出的逻辑严谨性和准确性。

- 问题痛点: 金融分析需要多步逻辑推导。LLM直接输出结果容易跳过关键推理步骤,产生“幻觉”或隐含错误。一步到位的提示难以审计和验证。

- 具体做法:

- 显式要求思考链: 在提示中直接指令模型:“请一步步推导你的推理过程。首先…其次…然后…基于以上,结论是…”。

- 分解任务: 将复杂问题拆解(如并购分析:行业背景理解 -> 标的公司评估 -> 协同效应分析 -> 潜在风险点 -> 交易影响预测)。

- 集成自我验证点: 在提示链的关键节点设置自我检查:

- 事实核查 (Fact-Check Point): “请基于你之前提到的XXX数据点,再次确认YYY信息的准确性。”

- 逻辑一致性检查 (Logic Consistency Point): “请检查你的推论A和推论B是否存在矛盾?”

- 假设显性化 (Explicit Assumption Point): “在得出此结论前,请明确列出你所依赖的关键假设(如市场环境稳定)。”

- 风险评估钩子 (Risk Flag Point): “请识别当前推理中最不确定或风险最高的环节是什么?”

- 利用工具增强(如RAG): 在关键验证步骤,提示模型结合从知识库检索(Retrieval-Augmented Generation, RAG)到的权威信息(监管文件、历史案例)来支持其验证。

- 金融价值:

- 显著提高复杂推理的准确性,减少隐藏的错误和幻觉。

- 输出结果可审计,推理过程透明化,满足风控和合规要求。

- 帮助人类分析师更快理解模型的逻辑和局限性。

- 案例/可视化:

- (文本示例: 展示一个简化的COT-SV提示在评估一家公司信用风险时的输出,包括推导步骤和嵌入的几个自我验证提问)。

- 最佳实践:

- 清晰界定验证点: 在哪个推理环节验证什么内容必须明确。

- 模型能力匹配: 确保使用支持长上下文和较强推理能力的大模型版本。

- 结合领域知识库: 自我验证不能无中生有,需要锚定在可靠信息源上(RAG是关键搭档)。

方法论 4: 系统级可靠性工程 (System-Level Reliability Engineering, SLRE)

- 核心理念: 超越单个提示,从系统架构高度设计提示工程的冗余、降级和监控机制,确保在面对模型不确定性、输入异常、服务波动时,整体输出满足金融级SLA(服务等级协议)要求。

- 问题痛点: 单个提示失败可能导致严重后果(如错误风险信号传播、合规报告生成失败)。需要系统级方案保障服务连续性。

- 具体做法:

- 输入消毒与健壮性设计:

- 在提示调用前,增加严格的输入预处理层,过滤无关字符、攻击性语言、过长文本、异常数据模式。

- 设计提示本身对噪音和异常输入具备容错性(如“如果无法理解以下文本的核心主题,请直接回答‘信息不足,无法分析’”)。

- 多样性提示与模型投票 (Ensemble):

- 对同一个关键任务,设计多个语义不同但目标一致的提示模板/变体(如不同表达方式的提问)。

- 调用多个同质或异质的大模型服务(即使都基于GPT架构,也可调不同提供商或不同微调版本)。

- 对多个模型的输出进行结果融合(Majority Vote) 或可信度加权平均(Confidence Score Fusion) ,选取共识或高置信度结果。

- 分级降级与后备机制:

- 定义清晰的输出质量/置信度阈值。当主提示/主模型输出的置信度过低时,自动切换到预定义的简化提示/备用模型(如更快、更轻量级但可能能力稍弱的模型),甚至回退到基于规则的专家系统输出标准答案或“系统繁忙/信息不足”提示。

- 对耗时长的复杂提示设计异步调用+超时/取消能力。

- 全面监控告警:

- 监控关键指标:请求成功率、平均响应时间、错误率(按错误类型分类:模型拒绝、格式错误、内容违规、逻辑错误…)。

- 监控置信度分布、输入分布、提示调用频率。

- 设置阈值告警(如错误率连续上升、特定提示超时率过高)。

- 输入消毒与健壮性设计:

- 金融价值:

- 大幅提升提示工程的整体服务可用性和稳定性(满足SLA要求)。

- 最小化单个点故障(一个提示/一次调用失败)对业务的影响。

- 增强对模型波动的抵御能力。

- 为合规和审计提供运行数据。

- 案例/可视化:

- (架构图: 展示一个典型的SLRE架构,包括输入层消毒、提示模板池、多个模型节点、投票/融合层、降级切换逻辑、监控告警模块)。

- 最佳实践:

- 混沌工程思维: 主动注入故障测试系统健壮性。

- 明确SLA定义: 可用性要达到99.9%还是99.99%?决定了冗余投入。

- 成本-收益平衡: 冗余设计会增加成本(多次模型调用),需权衡。

方法论 5: 监管兼容性与解释性工程 (Regulatory Compliance & Explainability Engineering, RC&EE)

- 核心理念: 将金融监管要求(如公平性、无歧视、隐私保护GDPR/CCPA、模型风险管理SR 11-7、欧盟AI法案)和可解释性需求,直接内嵌到提示设计和输出处理中。

- 问题痛点: 模型是黑盒,其输出可能隐含歧视、偏见、泄露隐私或无法解释,导致严重的合规风险和监管处罚。

- 具体做法:

- 提示注入合规规则:

- 公平性约束: “在分析信用申请人时,请仅基于财务因素,避免提及任何可能暗示年龄、性别、种族、邮政编码的词语。”

- 隐私保护: “请在分析以下客户聊天记录时,自动识别并完全遮蔽 (Redact) 所有个人身份信息(姓名、地址、身份证号、银行卡号、电话号码、邮箱地址等)。输出中不得出现任何原始敏感信息。”

- 禁止性内容: “本系统仅供金融专业分析使用。任何关于非法活动、暴力、有害内容的请求将被明确拒绝并记录。”

- 强制解释输出 (XAI Integration):

- 设计提示要求模型提供依据: “请给出你的投资建议,并详细说明所依据的关键数据和逻辑推理步骤。”

- 集成可解释性技术输出: 结合提示调用,使用外部XAI工具(如LIME, SHAP)或调用模型自身的注意力可视化/重要性评分功能,生成对输出的局部解释报告。

- 归因要求: “对于报告中引用的每一个核心数据点或结论,请明确标注其来源(来自财报P10 / 来自新闻链接 / 根据历史数据推演)。”

- 偏见扫描与审计钩子:

- 在提示后处理环节,集成自动化的偏见检测扫描(检查模型输出是否存在特定敏感属性群体的差异性)。

- 在架构上保留输入和输出的完整日志,用于合规审计、追溯和模型评估。

- 提示注入合规规则:

- 金融价值:

- 主动规避法律合规风险,避免天价罚款和声誉损失。

- 满足监管对AI模型透明度和可解释性的强制要求(如欧盟AI法案、美联储模型风险管理指引)。

- 增强用户(内外部客户)对AI生成内容的信任度。

- 为内部审计和监管检查提供证据链。

- 案例/可视化:

- (文本示例: 展示一个严格遵守隐私遮蔽和归因要求的客服对话分析提示的输出结果)。

- (示例图: 一个XAI工具对LLM生成的投资建议所依赖关键词/句子的热力图可视化)。

- 最佳实践:

- 法律团队深度协作: 确保提示中的约束措辞覆盖最新的监管要求。

- XAI常态化: 可解释性报告应是系统默认或可选功能,而非临时添加。

- 审计日志不可篡改: 日志系统需要高安全性。

三、 结论:构筑金融提示工程的护城河

年薪百万的金融提示工程架构师,其价值绝非仅仅是会写Prompt。他们的核心竞争力在于深刻理解金融业务的复杂性、风险特性和监管环境,并运用一套系统化的工程方法论—— DDPO(数据驱动)、QSAL(量化适配)、COT-SV(链式验证)、SLRE(系统可靠)、RC&EE(监管合规) ——将这些理解转化为稳健、高价值、可持续、负责任的提示工程解决方案。

关键启示:

- 价值导向: 提示工程的目标是解决业务痛点、提升效率、创造可见的商业价值,而非技术炫技。紧密与业务(交易、研究、风控、合规)对齐。

- 工程化思维: 将提示设计视为系统工程的一部分,关注可靠性、可维护性、可监控性、可扩展性。

- 复合技能: 顶尖架构师需要融合大模型技术、金融业务知识、软件工程能力、数据科学方法和风险合规意识。

- 持续进化: 模型、数据和监管都在变,方法论也需要持续迭代和优化。

四、 行动号召 (Call to Action)

- 审视你的现有方案: 你目前的提示工程实践,满足了这五大核心方法论的哪些方面?最需要加强的是哪个环节?

- 从小处着手: 选择1-2个方法论,在一个具体的、中等复杂度的金融任务上实践(例如,用 DDPO + COT-SV 改进一个财报总结提示)。开始A/B测试!

- 拥抱系统性建设: 逐步向架构层面引入健壮性、监控和可解释性模块。

- 分享与交流: 你在实施这些方法时遇到了哪些挑战?有何独特心得?欢迎在评论区留言讨论!

- [可选:资源下载] 关注XX公众号,回复“金融提示工程模板”获取本文涉及的典型提示结构和A/B测试框架示例代码。 [替换XX为你的平台]

- 进阶预告: 想了解如何将这五大方法论融入一个完整的、支撑私募基金量化投研流程的提示工程架构案例?敬请期待下篇——《构建面向对冲基金的AI投研大脑:基于五大方法论的实战架构拆解》!

五、 附加部分

- 致谢: 特别感谢在金融科技领域与我深入交流并提供宝贵洞见的一线从业者XXX和YYY。文中观点也深受OpenAI, Anthropic, Cohere等机构技术报告及金融AI领域论文的启发。

- 免责声明: 本文所述方法论为一般性技术分享,不构成任何投资建议。金融领域的AI应用须严格遵守当地法律法规及监管要求。读者自行承担实践责任。

- 作者简介: [你的笔名/真名],资深全栈工程师与技术布道师,专注AI工程化与金融科技创新,拥有XX年行业经验,曾主导多个大型金融机构的智能系统架构设计与实施。

(全文结束)

更多推荐

已为社区贡献119条内容

已为社区贡献119条内容

所有评论(0)