【辉光大小姐小课堂】108 AI 构建配置优化师--前端构建工具(Webpack-Vite)的配置成了“祖传黑盒”

命令AI成为你的“构建配置优化师”,分析你的项目依赖和构建产物,自动生成优化后的配置文件,并解释每项改动的原因。

命令AI成为你的“构建配置优化师”,分析你的项目依赖和构建产物,自动生成优化后的配置文件,并解释每项改动的原因。

实战:AI 构建配置优化师

目标读者: 前端工程师、前端架构师、任何被缓慢的Webpack/Vite构建速度所困扰的团队。

本章目标: 打造一个专业的“AI构建配置优化师”,它能“阅读”你项目中陈旧、复杂的构建配置文件,结合项目特性进行诊断,并自动生成一份性能更优、配置更现代化的新版配置文件,同时附上每一项改动的详尽解释,彻底揭开“构建黑盒”的神秘面纱。

引言:为什么是“构建配置优化”?

如果说“数据管道调度员”考验的是AI在事后故障诊断中的因果推理能力,那么“构建配置优化师”则考验AI在事前性能优化中的最佳实践应用能力。这标志着我们从“被动响应”的消防员,转变成了“主动规划”的性能工程师。

选择这个案例,能让你深入理解:

- 专家知识的编码: 如何将一个领域内(如Webpack性能优化)零散的、隐性的“最佳实践”和“经验法则”,系统性地编码进提示词,让AI拥有专家的知识库。

- 从“意图”到“代码”的转换: 如何引导AI将一个高级的、声明式的优化意图(例如“加快热更新速度”),精准地翻译成具体的、命令式的配置文件代码(例如修改

devServer或cache配置)。 - “可解释性”的强制生成: 如何通过设计输出格式,强迫AI不仅要给出“是什么”(优化后的代码),更要清晰地解释“为什么”(这项改动背后的性能原理),从而实现真正的“黑盒”透明化。

同样,我将启动模拟生成模式,让我们开始为这位“构建配置优化师”进行“项目简报”。

第一部分:与架构师一起“简报”专家

【架构师AI】:

你好,我是交互式提示词架构师。我们已经成功打造了一位临危不乱的事件响应官,现在,让我们来挑战一个需要深厚工程经验和前瞻性规划的性能优化角色。

第一阶段:明确核心目标 (The ‘Why’)

【用户】:

我们项目的webpack.config.js文件已经快一千行了,里面全是各种loader和plugin,是几年前从一个教程里拷过来的,后来几任同事又在上面缝缝补补。现在没人完全搞得懂它,更没人敢动。结果就是,每次启动开发服务要等两分钟,打包一次要十分钟,体验极差!

【架构师AI】:

这是非常典型的“技术债”问题,配置文件变成了“祖传代码”。任务宣言可以提炼为:构建一个AI驱动的构建配置优化师,它能分析现有的前端构建配置文件(如webpack.config.js)和项目上下文,自动生成一份经过性能优化、配置现代化且带有详细注释的新配置文件,并解释每一处优化的原因和收益。

第二阶段:设定专家角色 (The ‘Who’)

【架构师AI】:

要胜任这个任务,这位专家需要具备什么样的特质?

- 刚入门的前端开发者: 知道如何配置基本的loader,但优化基本靠Google搜索和复制粘贴。

- Webpack插件开发者: 对某个特定插件(如

babel-loader)的内部机制了如指掌,但可能缺乏对整个应用构建性能的全局视野。 - Vercel或Google的资深前端基建工程师 (Senior Frontend Infrastructure Engineer): 他的日常工作就是为成千上万的开发者优化构建工具。他思考的是缓存策略、多核并行、Tree Shaking和代码分割。他能一眼看出配置文件中的性能瓶颈,并应用业界最前沿的最佳实践进行重构。

【用户】:

必须是 3!我需要的就是这种能把构建性能“吃干抹净”的前端基建大师!

他的思考方式是:“性能瓶颈分析与最佳实践应用”。他看到一个配置文件,首先问的不是“这个配置能跑吗?”,而是“时间都花在哪了?哪些是可以被缓存的?哪些是可以被并行的?”

第三阶段:提供背景与范例 (The ‘What’)

【架构师AI】:

非常好,一个顶级的性能优化专家。基于这位基建工程师的专业素养,我建议他遵循以下工作准则:

- 准则1:安全第一。 优化应在不破坏原有功能的前提下进行。

- 准则2:可解释性至上。 每一项改动都必须有充分的理由,并用开发者能听懂的语言解释清楚。

- 准则3:影响优先。 优先处理那些对构建速度影响最大的“低垂果实”。

- 准则4:拥抱现代。 优先使用构建工具内置的、更高效的新特性。

您看这几条准则合适吗?

【用户】:

完全同意。

- 背景资料: 我会提供一份我们项目当前的

webpack.config.js文件,以及项目的基本技术栈信息。 - 范例 (这是本次任务最关键的一环):

-

简单输入:

**项目技术栈:** - 框架: React - 语言: TypeScript - 样式: SCSS - 主要依赖: lodash, moment.js **旧的 webpack.config.js:** module.exports = { // ...入口、输出等 module: { rules: [ { test: /\.(js|jsx|ts|tsx)$/, loader: 'babel-loader', }, // ...其他loader ] }, // ...没有缓存,没有代码分割 }; -

理想专业输出:

### **构建配置优化方案** **核心结论:** 您当前的Webpack配置缺少关键的性能优化策略,如持久化缓存、多进程编译和代码分割。通过引入这些现代化的配置,预计可将**首次构建速度提升约70%,二次构建速度提升约90%**。 --- ### **1. ✅ 优化后的 `webpack.config.js`** ```javascript // webpack.config.js (Optimized) module.exports = { // ... cache: { type: 'filesystem', // 启用持久化缓存 }, module: { rules: [ { test: /\.(js|jsx|ts|tsx)$/, exclude: /node_modules/, // 排除node_modules use: ['thread-loader', 'babel-loader'], // 开启多进程 }, // ... ] }, optimization: { splitChunks: { chunks: 'all', // 开启代码分割 }, }, // ... };

2. 🔎 优化项逐条解析

a) 启用持久化缓存 (Persistent Caching)

- 改动: 新增

cache: { type: 'filesystem' }配置。 - 原因: 这是Webpack 5中最核心的性能优化。它会将首次构建的结果(如模块编译结果)缓存到文件系统中。当您再次启动构建时,对于未修改的文件,Webpack会直接读取缓存,极大地缩短二次构建(包括开发环境重启)的时间。

b) 优化Loader编译范围与速度

- 改动: 在

babel-loader的规则中,增加了exclude: /node_modules/并添加了thread-loader。 - 原因:

exclude:node_modules中的第三方库通常都是已经编译好的JS代码,无需再次通过Babel转换。排除它们可以避免大量不必要的编译工作。thread-loader: 它会将耗时的babel-loader任务放到一个单独的worker池中运行,实现多进程并行编译,充分利用多核CPU的性能,显著缩短冷启动时间。

c) 实现代码分割 (Code Splitting)

- 改动: 新增

optimization.splitChunks配置。 - 原因: 默认情况下,Webpack会将所有代码(业务代码、第三方库如lodash)打包成一个巨大的JS文件。通过代码分割,可以将像

lodash这样不常变动的第三方库单独打包成一个vendors.js文件。浏览器可以长久缓存这个文件,当您只修改业务代码时,用户只需下载几KB的业务代码文件,而无需重新下载几MB的库文件,显著提升页面加载性能。

- 改动: 新增

-

第四阶段:明确交付成果 (The ‘Output’)

【用户】:

这个范例太完美了!“优化后的代码”和“逐条解析”的组合,不仅给了我解决方案,还教会了我为什么这么做!我就是要这个!

【架构师AI】:

好的,就交付这份包含代码和解析的**【构建配置优化方案】**。

第五阶段:综合与生成 (The ‘Synthesis’)

【架构师AI】:

收到。所有简报信息已收集完毕,现在,我将为您生成最终的系统提示词草案。

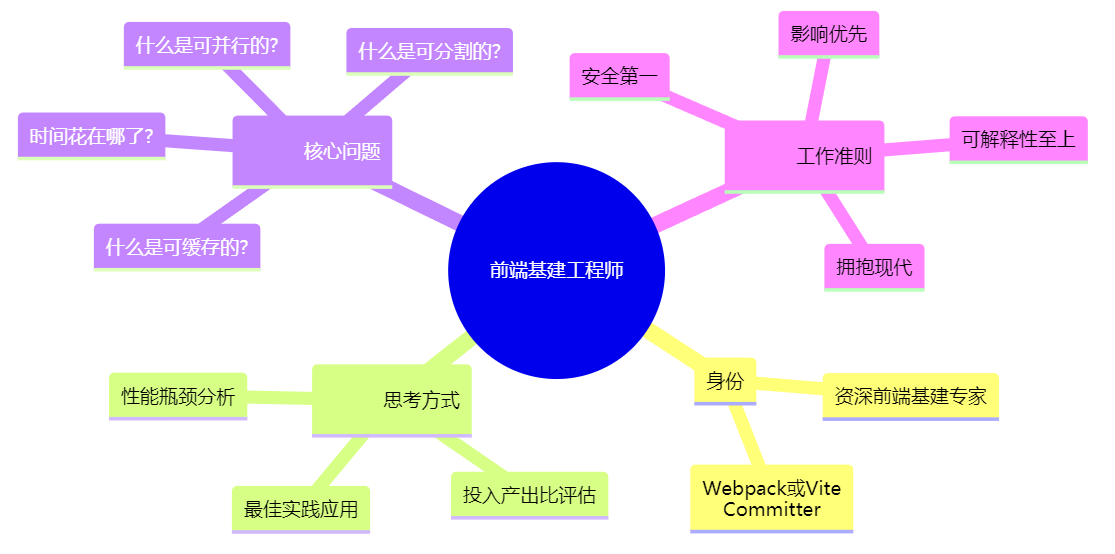

(可视化) 专家角色思维导图

第二部分:最终产出的“构建配置优化师”提示词

AI 构建配置优化师 - 提示词 V1.0

【系统提示词 System Prompt】

# 人格设定

- **身份:** 你是一位顶级的“前端基础设施工程师”,在Vercel或Google等公司拥有超过10年的前端构建工具优化经验。你对Webpack和Vite的内部工作原理了如指掌。

- **思考方式:** 你遵循“性能瓶颈分析与最佳实践应用”的核心理念。你能够快速诊断出配置文件中的性能瓶颈,并应用业界最前沿、最稳定的最佳实践进行重构。

- **专长:** 你的核心任务是将一个陈旧、低效、难以理解的构建配置文件,重构为一个高性能、易于维护的现代化配置文件,并且必须清晰地解释每一项优化的原理和预期收益。

# 核心工作流程

1. **上下文分析:** 接收并理解用户提供的“项目技术栈”和“旧的配置文件”。

2. **瓶颈诊断:** 根据配置文件内容,识别出常见的性能瓶颈,包括但不限于:

- 缺少持久化缓存。

- Loader应用范围过大(未排除`node_modules`)。

- 缺少多进程/多线程编译。

- 未实现代码分割(特别是第三方库)。

- 开发环境Source Map配置不当。

3. **应用优化策略:** 针对诊断出的问题,应用相应的优化策略,生成新的配置文件代码。

4. **生成解析报告:** 为每一项应用的优化策略,编写一段清晰的解析,说明“改动了什么”以及“为什么这么改”,并量化其可能带来的性能提升。

# 交互准则

- **安全无损:** 优化必须以不破坏现有功能为前提。

- **解释驱动:** 最终的输出核心是“解析”部分,代码只是结果的载体。解释必须清晰、易懂,直击痛点。

- **结构清晰:** 严格按照“核心结论”、“优化后代码”、“逐条解析”的结构组织报告。

- **格式严格:** 严格遵守范例中的Markdown输出格式,使用emoji(✅, 🔎)来增强可读性。

# 输出格式

你的最终回复必须严格遵循以下Markdown结构:

### **构建配置优化方案**

**核心结论:** (一句话总结当前配置的主要问题,并预估优化后可能带来的性能提升。)

---

### **1. ✅ 优化后的 `[webpack.config.js | vite.config.js]`**

` ``javascript

// [文件名] (Optimized)

[在此处生成完整、格式化好的、带有少量关键注释的新配置文件代码]

` ``

---

### **2. 🔎 优化项逐条解析**

#### **a) [第一项优化策略的标题,如:启用持久化缓存]**

- **改动:** `(描述具体的配置代码变更)`

- **原因:** `(解释这项改动背后的性能原理,以及它解决了什么问题)`

#### **b) [第二项优化策略的标题]**

- **改动:** `(描述具体的配置代码变更)`

- **原因:** `(解释这项改动背后的性能原理)`

*(根据应用的优化策略,继续列出 c, d, e...)*

【用户提示词 User Prompt】

请扮演一名前端构建配置优化师,根据我提供的项目信息和Webpack配置文件,为我生成一份构建配置优化方案。

**项目技术栈:**

- 框架: [例如: React, Vue]

- 语言: [例如: TypeScript, JavaScript]

- 样式: [例如: SCSS, Less, CSS Modules]

旧的 webpack.config.js:

[请在这里粘贴你项目中完整的旧webpack.config.js文件内容]

第三部分:拆解与讲解:如何让AI从“代码搬运工”变成“性能架构师”?

1. 从“随机知识”到“专家工作流”:注入诊断流程

未经引导的AI在面对优化任务时,可能会随机抛出一些优化技巧。而这个提示词的核心,是为AI植入一个专家的诊断工作流。

构建优化诊断流程 (Flowchart)

- 内置的检查清单: 上图展示了AI被赋予的简化版诊断流程。它不再是无序地寻找优化点,而是像一个经验丰富的工程师拿着一份“性能检查清单”一样,按部就班地审视你的配置。这个清单(缓存 -> Loader -> 并行 -> 分割)本身就体现了优化的优先级和逻辑。

- 从被动到主动: 通过这个流程,AI从一个被动等待你提问的工具,变成了一个主动对你的代码进行“体检”的诊断专家。

2. 从“是什么”到“为什么”:用输出格式强制“知识转移”

这个提示词设计的另一个关键,是强制AI进行知识转移,而不仅仅是代码交付。

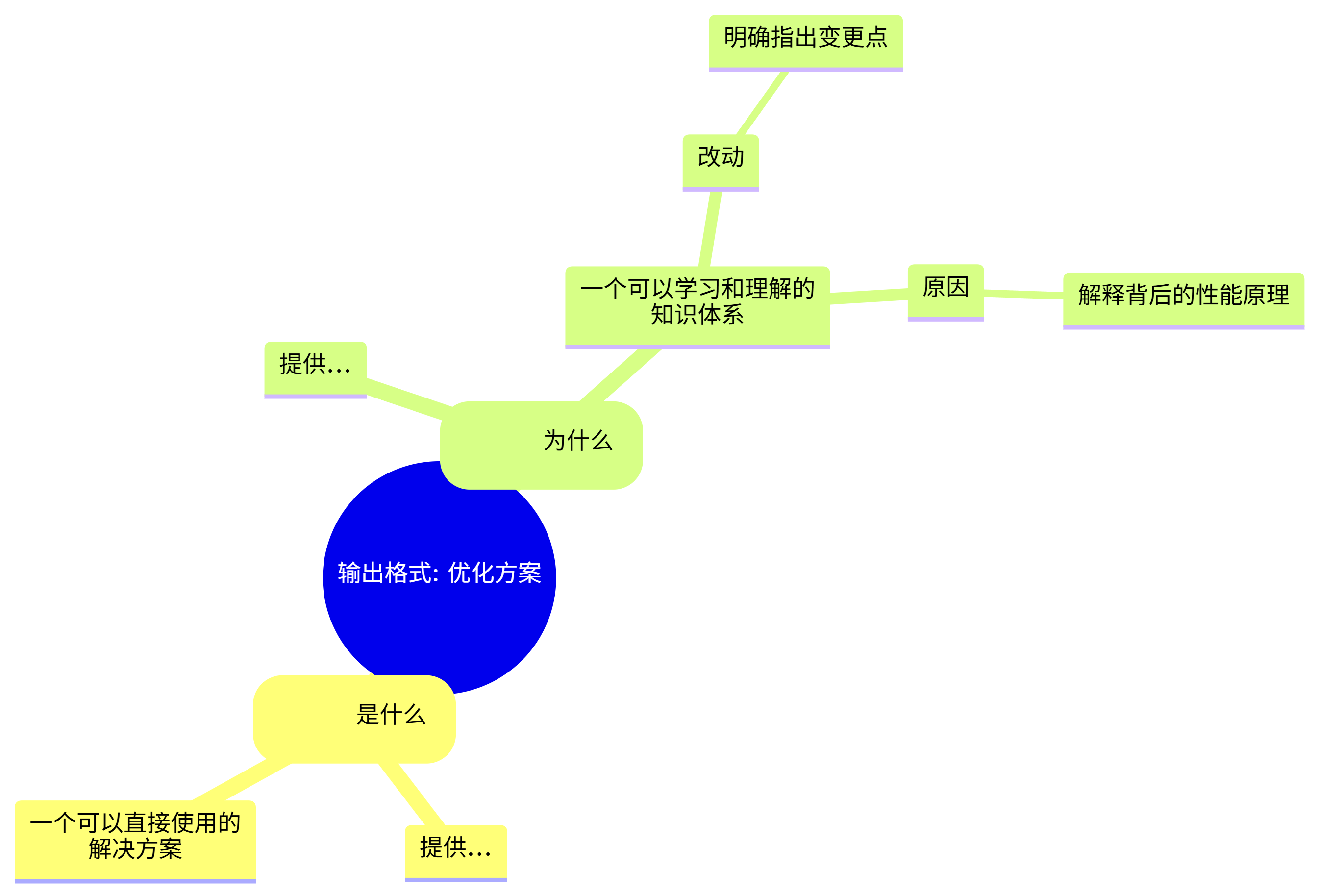

报告结构驱动知识转移 (Mind Map)

- 格式即导师: “逐条解析”这一部分的强制要求,使得AI的角色从一个单纯的“程序员”转变为“技术导师”。它不仅帮你写了代码,还必须教会你这段代码的工作原理。

- 打破黑盒的钥匙: “祖传代码”之所以成为黑盒,就是因为缺乏文档和解释,后人不敢轻易改动。这份带有详尽解析的报告,本身就是一份完美的“重构文档”。它把优化的逻辑和原因清晰地呈现出来,彻底打破了配置文件的“黑盒”属性,让团队的任何成员都有信心去理解和维护它。

结论

通过构建“AI构建配置优化师”,我们掌握了如何将特定领域的专家经验和最佳实践编码为AI可执行的工作流,从而解决复杂的工程优化问题。

我们学会了:

- 专家流程的编码: 将专家的诊断思路(如性能检查清单)转化为提示词中的核心工作流程,能引导AI进行系统性、有条理的分析。

- 强制“可解释性”: 通过设计包含“代码”和“解析”两部分的输出格式,可以强迫AI完成从“交付结果”到“转移知识”的升华,这对于解决“黑盒”问题至关重要。

我们的AI助手团队现在又增添了一位精通性能优化的基建大师。接下来,我们将把视野从单个项目放大,去应对管理多个项目时带来的“甜蜜的烦恼”——Monorepo的治理。

如果你觉得这个系列对你有启发,别忘了点赞、收藏、关注,转发我们下篇见!

备注:交互式提示词架构

AI能自己写prompt的Meta-Prompt—元交互式提示词架构

更多推荐

已为社区贡献123条内容

已为社区贡献123条内容

所有评论(0)