【GitHub项目推荐--Gemini Fullstack LangGraph Quickstart:全栈AI研究代理完全指南】

是一个由Google开发的开源项目,展示了如何使用Gemini 2.5和LangGraph构建强大的全栈研究代理。该项目提供了一个完整的应用程序,包含React前端和基于LangGraph的后端代理,能够执行深入的网络研究和生成有据可查的回答。🔗 GitHub地址🚀 核心价值:全栈AI代理 · 动态研究 · 引用生成 · 开源模板项目背景:AI研究需求:解决传统聊天机器人缺

简介

Gemini Fullstack LangGraph Quickstart 是一个由Google开发的开源项目,展示了如何使用Gemini 2.5和LangGraph构建强大的全栈研究代理。该项目提供了一个完整的应用程序,包含React前端和基于LangGraph的后端代理,能够执行深入的网络研究和生成有据可查的回答。

🔗 GitHub地址:

https://github.com/google-gemini/gemini-fullstack-langgraph-quickstart

🚀 核心价值:

全栈AI代理 · 动态研究 · 引用生成 · 开源模板

项目背景:

-

AI研究需求:解决传统聊天机器人缺乏深入研究能力的问题

-

全栈开发:提供完整的全栈AI应用开发模板

-

Google生态:集成Google Gemini和搜索API生态系统

-

开源社区:为开发者提供高质量的开源参考实现

技术特色:

-

🤖 智能代理:基于LangGraph的智能研究代理

-

🔍 动态研究:实时网络搜索和知识获取

-

📚 引用支持:生成有引用来源的可靠答案

-

⚡ 全栈架构:完整的React前端 + FastAPI后端

-

🎯 迭代优化:多轮研究和反思优化机制

设计理念:

-

研究深度:追求深入和全面的问题研究

-

答案质量:确保回答的准确性和可靠性

-

开发友好:提供易于理解和扩展的代码结构

-

生产就绪:具备生产环境部署能力

-

开放标准:使用主流技术和开放协议

主要功能

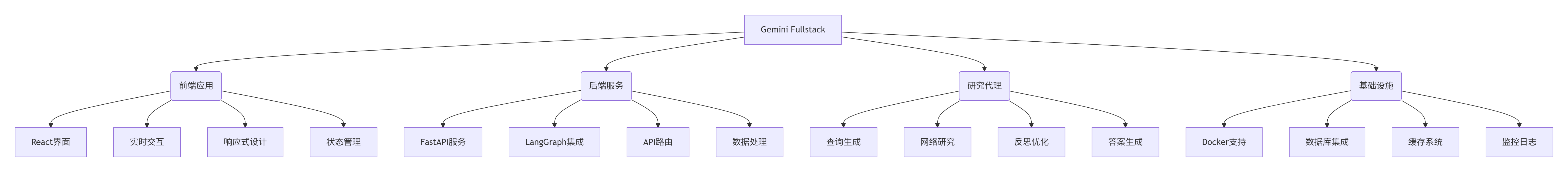

1. 核心架构体系

2. 功能详情

研究代理功能:

-

智能查询生成:基于用户问题动态生成搜索查询

-

多源研究:从多个网络来源收集信息

-

知识缺口分析:识别信息不足并针对性补充研究

-

迭代优化:多轮研究确保答案完整性

-

引用管理:自动管理和标注信息来源

前端功能:

-

用户界面:直观的聊天式界面

-

实时交互:流畅的用户交互体验

-

响应式设计:适配各种设备屏幕

-

状态管理:完善的交互状态管理

-

错误处理:友好的错误提示和恢复

后端功能:

-

API服务:RESTful API接口设计

-

任务管理:异步任务处理和状态跟踪

-

数据处理:高效的数据处理和转换

-

安全认证:API安全认证和权限控制

-

性能优化:请求处理和响应优化

研究能力:

-

深度研究:深入的主题研究和分析

-

实时搜索:实时网络信息获取

-

信息验证:多源信息交叉验证

-

知识合成:信息整合和知识构建

-

质量保证:答案质量和准确性控制

开发特性:

-

热重载:开发环境实时重载

-

调试支持:完整的调试工具链

-

文档生成:自动API文档生成

-

测试框架:单元和集成测试支持

-

部署工具:多种部署方案支持

3. 技术规格

系统要求:

# 开发环境

操作系统: Linux, macOS, Windows 10+

Node.js: 18.x+

Python: 3.11+

内存: 8GB+ RAM

存储: 2GB+ 可用空间

# 生产环境

操作系统: Linux (推荐)

内存: 16GB+ RAM

CPU: 4核+ 现代处理器

存储: 10GB+ SSD存储

网络: 稳定互联网连接API集成:

# 必需API密钥

Google Gemini API: 核心AI模型服务

Google Search API: 网络搜索功能

LangSmith API: 可选的监控和追踪

# 可选集成

Redis: 实时通信和缓存

PostgreSQL: 数据持久化存储

监控服务: 性能监控和日志性能指标:

# 处理性能

响应时间: 5-30秒 (取决于查询复杂度)

并发用户: 10-50+ (取决于硬件配置)

研究深度: 3-5轮迭代研究

引用数量: 3-10个来源引用

# 资源使用

内存占用: 1-4GB (动态调整)

CPU使用: 中等计算负载

网络带宽: 中等网络使用

存储需求: 最小持久化需求支持特性:

-

多语言支持:主要英语,支持其他语言

-

格式输出:文本、Markdown、结构化数据

-

扩展能力:插件化和模块化架构

-

自定义配置:可调整的研究参数

-

质量控制:可配置的质量阈值

安装与配置

1. 环境准备

系统要求:

# 基础软件

Node.js 18.x 或更高版本

Python 3.11 或更高版本

pip 包管理工具

npm 或 yarn 包管理器

# 开发工具

Git 版本控制

Docker (可选,用于容器化)

Docker Compose (可选)

# API账户

Google Cloud 账户 (Gemini API)

Google Search API 访问权限

LangSmith 账户 (可选)账户准备:

# 获取API密钥

1. 访问 Google AI Studio

2. 创建API密钥用于Gemini访问

3. 启用Google Search API服务

4. 获取相应的API配额和权限

# 可选服务

LangSmith账户: 用于高级监控和追踪

Redis云服务: 用于生产环境部署

PostgreSQL数据库: 用于数据持久化2. 安装步骤

克隆仓库:

# 克隆项目仓库

git clone https://github.com/google-gemini/gemini-fullstack-langgraph-quickstart.git

cd gemini-fullstack-langgraph-quickstart

# 或使用GitHub CLI

gh repo clone google-gemini/gemini-fullstack-langgraph-quickstart后端安装:

# 安装Python依赖

cd backend

pip install -r requirements.txt

# 或使用poetry (如可用)

poetry install

# 环境配置

cp .env.example .env

# 编辑.env文件添加API密钥

GEMINI_API_KEY=your_actual_gemini_api_key前端安装:

# 安装Node.js依赖

cd frontend

npm install

# 或使用yarn

yarn install

# 或使用pnpm

pnpm installDocker安装:

# 使用Docker Compose

docker-compose up -d

# 或构建自定义镜像

docker build -t gemini-fullstack .

# 运行容器

docker run -p 5173:5173 -p 2024:2024 gemini-fullstack开发环境启动:

# 使用Makefile (推荐)

make dev

# 或手动启动

# 终端1: 后端服务

cd backend && langgraph dev

# 终端2: 前端服务

cd frontend && npm run dev3. 配置说明

环境变量配置:

# 后端配置 (.env)

GEMINI_API_KEY=your_gemini_api_key

GOOGLE_SEARCH_API_KEY=your_search_api_key

LANGSMITH_API_KEY=your_langsmith_key

REDIS_URL=redis://localhost:6379

DATABASE_URL=postgresql://user:pass@localhost:5432/db

# 前端配置 (环境变量)

VITE_API_URL=http://localhost:2024

VITE_APP_TITLE="Gemini Research Agent"

VITE_APP_VERSION=1.0.0代理参数配置:

# 研究参数

MAX_ITERATIONS=5 # 最大研究迭代次数

MIN_CONFIDENCE=0.7 # 最小置信度阈值

SEARCH_RESULTS=5 # 每次搜索返回结果数

TIMEOUT=30 # 超时时间(秒)

# 模型参数

MODEL_NAME=gemini-2.5

TEMPERATURE=0.3

TOP_P=0.8

MAX_TOKENS=4000部署配置:

# 生产环境配置

NODE_ENV=production

PORT=8123

HOST=0.0.0.0

LOG_LEVEL=info

# 安全配置

CORS_ORIGINS=https://yourdomain.com

RATE_LIMIT=100/1m

API_KEY_HEADER=X-API-Key监控配置:

# LangSmith配置

LANGSMITH_TRACING=true

LANGSMITH_PROJECT=gemini-research

LANGSMITH_ENDPOINT=https://api.langsmith.com

# 日志配置

LOG_FILE=logs/app.log

LOG_ROTATION=100MB

LOG_RETENTION=7d使用指南

1. 基本工作流

使用Gemini Fullstack的基本流程包括:启动服务 → 输入查询 → 自动研究 → 获取答案 → 查看引用。整个过程自动化程度高,用户只需提供问题即可获得深入研究后的答案。

2. 基本使用

启动应用:

# 开发模式启动

make dev

# 访问应用

打开浏览器访问: http://localhost:5173/app

# 或直接访问API

curl http://localhost:2024/health进行研究查询:

# 通过Web界面

1. 在输入框中输入研究问题

2. 点击"发送"或按Enter键

3. 观察实时研究进度

4. 查看最终答案和引用

# 通过API接口

curl -X POST http://localhost:2024/api/research \

-H "Content-Type: application/json" \

-d '{"query": "什么是量子计算?"}'监控研究过程:

# 查看研究状态

GET /api/research/{research_id}

# 获取研究历史

GET /api/history

# 监控系统状态

GET /api/health

GET /api/metrics管理研究会话:

# 创建新会话

POST /api/sessions

# 获取会话列表

GET /api/sessions

# 删除会话

DELETE /api/sessions/{session_id}3. 高级功能

批量研究处理:

# 批量查询研究

POST /api/batch-research

{

"queries": [

"量子计算原理",

"量子计算应用",

"量子计算挑战"

]

}

# 监控批量任务

GET /api/batch/{batch_id}自定义研究参数:

# 自定义研究配置

POST /api/research

{

"query": "你的研究问题",

"config": {

"max_iterations": 3,

"min_confidence": 0.8,

"search_depth": "deep",

"sources": ["academic", "news", "technical"]

}

}导出研究结果:

# 导出为JSON格式

GET /api/research/{id}/export?format=json

# 导出为Markdown

GET /api/research/{id}/export?format=markdown

# 导出为PDF

GET /api/research/{id}/export?format=pdfAPI集成示例:

// JavaScript集成示例

import { ResearchClient } from 'gemini-research-sdk';

const client = new ResearchClient({

apiKey: 'your-api-key',

endpoint: 'https://your-api-endpoint.com'

});

// 进行研究查询

const result = await client.research({

query: '人工智能最新发展',

options: {

maxIterations: 4,

includeSources: true

}

});

console.log(result.answer);

console.log(result.sources);应用场景实例

案例1:学术研究和论文写作辅助

场景:研究人员需要快速获取领域最新信息和参考文献

解决方案:使用Gemini Fullstack进行学术研究辅助。

研究配置:

# 学术研究专用配置

research_mode: "academic"

source_preference: ["scholar", "arxiv", "research_gate"]

min_confidence: 0.8

citation_format: "apa"

# 深度研究参数

max_iterations: 5

search_depth: "deep"

include_citations: true

peer_reviewed: true学术工作流:

-

课题研究:快速了解新研究领域的基本概念和最新进展

-

文献调研:自动查找相关学术论文和研究报告

-

参考文献:生成标准格式的引用和参考文献列表

-

研究摘要:自动生成研究领域的综合摘要

-

趋势分析:识别研究热点和未来发展方向

研究示例:

# 学术研究查询示例

"机器学习在医疗诊断中的最新应用"

"量子计算当前的技术挑战和解决方案"

"气候变化对农业影响的近期研究成果"实施效果:

-

研究效率:大幅减少文献调研时间

-

信息全面:获取多源学术信息

-

引用准确:自动生成标准格式引用

-

趋势把握:及时了解领域最新动态

-

写作支持:为论文写作提供材料支持

案例2:商业情报和市场研究

场景:企业需要监控市场动态和竞争情报

解决方案:使用Gemini Fullstack进行商业情报收集和分析。

商业研究配置:

# 商业情报配置

research_mode: "business"

source_preference: ["news", "reports", "financial", "regulatory"]

min_confidence: 0.75

update_frequency: "daily"

# 监控参数

monitor_keywords: ["竞争对手", "市场趋势", "政策变化"]

alert_threshold: 0.7

report_format: "executive"商业应用:

-

竞争分析:监控竞争对手动态和战略变化

-

市场趋势:追踪行业趋势和市场机会

-

政策监控:关注相关法规和政策变化

-

技术追踪:监控新技术发展和应用

-

风险识别:识别潜在风险和挑战

研究示例:

# 商业研究查询

"电动汽车市场2024年发展趋势"

"人工智能在金融科技中的应用案例"

"全球供应链最新挑战和解决方案"自动化工作流:

# 定时研究任务

0 9 * * 1-5 /自动运行市场研究报告

0 16 * * * /生成每日情报摘要

# 关键事件触发

竞争对手发布新产品 → 自动深度分析

政策法规变化 → 立即影响评估

市场重大事件 → 快速情况报告实施价值:

-

情报及时性:实时获取最新商业信息

-

决策支持:为战略决策提供数据支持

-

风险预警:早期识别风险和机会

-

效率提升:自动化情报收集过程

-

竞争优势:保持市场竞争优势

案例3:技术研究和开发支持

场景:开发团队需要快速了解新技术和解决方案

解决方案:使用Gemini Fullstack进行技术研究和开发支持。

技术研究配置:

# 技术研究配置

research_mode: "technical"

source_preference: ["documentation", "github", "stackoverflow", "blogs"]

min_confidence: 0.7

code_examples: true

# 开发支持参数

include_code: true

practical_examples: true

best_practices: true

performance_considerations: true开发支持场景:

-

技术选型:比较不同技术方案的优缺点

-

问题解决:查找技术问题的解决方案

-

最佳实践:学习特定技术的最佳实践

-

代码示例:获取实际可用的代码示例

-

性能优化:了解性能优化技巧和方法

研究示例:

# 技术研究查询

"React 18新特性及迁移指南"

"Python异步编程最佳实践"

"机器学习模型部署的常见挑战"开发工作流集成:

# IDE集成

通过插件直接在工作环境中进行研究

代码片段直接插入开发环境

技术文档即时查阅

# CI/CD集成

自动化技术债务评估

依赖更新影响分析

安全漏洞研究实施效益:

-

开发效率:快速解决技术问题

-

学习曲线:降低新技术学习成本

-

代码质量:遵循最佳实践提高质量

-

知识共享:促进团队知识积累

-

创新支持:支持技术创新和实验

生态系统与社区

1. 社区资源

获取帮助:

-

📚 官方文档:GitHub README和详细文档

-

💬 社区讨论:GitHub Issues和讨论区

-

🐛 问题报告:通过GitHub Issues报告问题

-

💡 功能建议:提交新功能请求和改进建议

支持渠道:

-

GitHub社区:主要的讨论和支持平台

-

Discord频道:实时交流和帮助

-

示例项目:社区贡献的示例和用例

-

教程资源:视频教程和书面指南

贡献指南:

-

Fork项目仓库

-

创建特性分支 (

git checkout -b feature/AmazingFeature) -

提交更改 (

git commit -m 'Add some AmazingFeature') -

推送到分支 (

git push origin feature/AmazingFeature) -

发起Pull Request

2. 相关工具集成

开发工具集成:

-

VS Code扩展:开发环境直接集成

-

LangChain生态:LangChain工具和组件集成

-

Google Cloud:Google云服务深度集成

-

监控工具:Prometheus, Grafana监控集成

数据源集成:

-

学术数据库:IEEE, ACM, arXiv等学术资源

-

新闻源:主流新闻媒体和行业报道

-

技术资源:GitHub, Stack Overflow, 技术博客

-

商业数据:财报, 市场报告, 行业分析

部署平台:

-

Google Cloud Run:无服务器部署

-

Kubernetes:容器化部署和管理

-

AWS/Azure:主流云平台部署

-

本地部署:企业内部部署方案

总结

Gemini Fullstack LangGraph Quickstart作为一个强大的全栈研究代理框架,为开发者提供了构建智能研究应用的完整解决方案。其基于Google Gemini和LangGraph的技术栈,结合了先进AI能力和实用的研究功能,是开发现代AI应用的理想起点。

核心优势:

-

🚀 研究深度:多轮迭代的深度研究能力

-

🔍 实时信息:基于网络的最新信息获取

-

📚 引用支持:完整的引用和来源管理

-

⚡ 全栈方案:完整的前后端解决方案

-

🆓 开源免费:完全开源,可自由使用和修改

适用场景:

-

学术研究和论文写作辅助

-

商业情报和市场研究分析

-

技术研究和开发支持

-

内容创作和研究支持

-

教育和学习辅助工具

技术特色:

-

智能代理:基于LangGraph的智能研究代理

-

多模态支持:文本、代码、数据多种格式

-

可扩展架构:模块化设计,易于扩展

-

生产就绪:具备生产环境部署能力

-

监控分析:完整的监控和分析能力

🌟 GitHub地址:

https://github.com/google-gemini/gemini-fullstack-langgraph-quickstart

🚀 快速开始:

git clone && make dev💬 社区支持:

通过GitHub Issues获取帮助

立即开始使用Gemini Fullstack,构建智能研究应用!

最佳实践建议:

-

🏁 初学者:从示例查询开始体验功能

-

🔧 开发者:深入研究代码结构和扩展点

-

🏢 企业用户:关注生产环境部署和监控

-

📊 研究人员:利用深度研究功能辅助工作

-

🤝 团队协作:探索团队协作和研究共享

注意事项:

-

⚠️ API限制:注意Gemini API的使用配额和限制

-

🔒 数据隐私:处理敏感数据时注意隐私保护

-

💾 资源管理:监控系统资源使用情况

-

📋 质量验证:重要信息进行人工验证

-

🔄 版本更新:定期更新到最新版本

Gemini Fullstack持续演进和发展,欢迎加入社区共同推动智能研究技术的进步和创新!

更多推荐

已为社区贡献173条内容

已为社区贡献173条内容

所有评论(0)