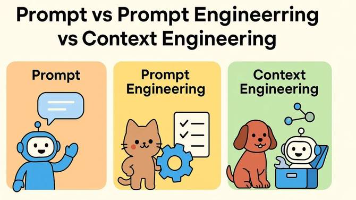

AI原生应用领域知识更新的核心内容

AI技术正以“月级”速度迭代:2023年GPT-4发布仅半年,多模态大模型已能理解视频、图像与文本的复杂关联;2024年,边缘端AI模型参数量从亿级突破至十亿级。传统应用(如早期的外卖APP)通过“功能补丁”更新的模式,已无法满足AI原生应用对“智能水平持续提升”的需求。本文聚焦AI原生应用的“知识更新”这一核心命题,覆盖模型、数据、工具、伦理四大维度,帮助读者掌握AI应用“自进化”的底层逻辑。

AI原生应用领域知识更新的核心内容

关键词:AI原生应用、知识更新、模型迭代、数据飞轮、工具链进化、伦理合规、持续学习

摘要:本文深入解析AI原生应用(AI-Native Application)领域知识更新的核心逻辑与关键内容。通过生活类比、技术原理拆解和实战案例,系统讲解模型迭代、数据飞轮、工具链进化、伦理合规四大核心模块的运作机制,揭示AI原生应用如何通过动态知识更新保持技术前沿性与场景适配性。适合AI开发者、产品经理及技术管理者理解AI应用的“自生长”能力构建方法。

背景介绍

目的和范围

AI技术正以“月级”速度迭代:2023年GPT-4发布仅半年,多模态大模型已能理解视频、图像与文本的复杂关联;2024年,边缘端AI模型参数量从亿级突破至十亿级。传统应用(如早期的外卖APP)通过“功能补丁”更新的模式,已无法满足AI原生应用对“智能水平持续提升”的需求。本文聚焦AI原生应用的“知识更新”这一核心命题,覆盖模型、数据、工具、伦理四大维度,帮助读者掌握AI应用“自进化”的底层逻辑。

预期读者

- AI开发者:想了解如何设计支持动态更新的模型架构;

- 产品经理:需理解知识更新对用户体验的具体影响;

- 技术管理者:关注如何构建高效的AI知识更新体系。

文档结构概述

本文从“为什么需要知识更新”出发,通过“核心概念→原理拆解→实战案例→未来趋势”的逻辑链,逐层解析AI原生应用知识更新的四大核心内容。重点通过“智能咖啡师”的生活化案例贯穿全文,帮助读者建立直观认知。

术语表

| 术语 | 定义 | 类比(生活化解释) |

|---|---|---|

| AI原生应用 | 从设计之初就以AI为核心驱动力的应用,依赖数据/模型/算法的持续进化 | 像会自己学做新咖啡的智能咖啡机 |

| 数据飞轮 | 数据采集→标注→训练→应用→反馈的闭环,推动模型能力螺旋上升 | 水车转动:水流(数据)推动磨坊(模型) |

| 持续学习 | 模型在不遗忘历史知识的前提下,持续从新数据中学习的能力 | 人边工作边学习新技能,不忘记老经验 |

| 工具链进化 | 支持模型开发、部署、更新的工具集(如训练框架、监控平台)的快速迭代 | 咖啡师的工具从手动磨豆机升级为智能磨豆机 |

核心概念与联系

故事引入:智能咖啡师的“成长日记”

想象一家咖啡馆有台“小智”智能咖啡师:

- 第一天:能做美式、拿铁(初始模型);

- 第二周:发现用户爱加椰奶(新数据反馈),学会椰香拿铁(模型更新);

- 第三个月:用摄像头识别用户表情,判断咖啡甜度是否合适(多模态数据接入);

- 半年后:甚至能根据用户的消费记录,提前备好常点的咖啡(个性化推荐能力)。

小智的“成长”不是靠工程师手动改代码,而是通过“自动学习新数据→优化模型→提供更好服务→收集更多反馈”的循环完成的。这就是AI原生应用的知识更新过程——它像一个会自己“长本事”的智能体。

核心概念解释(像给小学生讲故事一样)

核心概念一:模型迭代——智能体的“大脑升级”

模型是AI的“大脑”,存储着“如何解决问题”的知识。比如小智的“做咖啡模型”里,存着“牛奶加热到60℃+浓缩咖啡=拿铁”的知识。但用户口味会变(比如流行生椰拿铁),模型就需要“升级大脑”:用新数据(用户点生椰拿铁的记录)重新训练,学会“椰浆+浓缩咖啡=生椰拿铁”的新规则。

类比:就像小朋友学数学,一开始只会10以内加法(初始模型),后来学了乘法(模型迭代),就能解决更复杂的问题。

核心概念二:数据飞轮——智能体的“能量循环”

数据是AI的“食物”,但不是吃一次就够,而是要“边吃边拉”形成循环。小智每做一杯咖啡,会记录用户的选择(点了生椰拿铁)、反馈(“太甜了”)、甚至拍照(用户皱眉)——这些数据被送回“厨房”(训练系统),用来调整模型;模型变好后,小智能做出更合用户口味的咖啡,用户就更爱用,产生更多数据。这就像水车:水流(数据)推动磨坊(模型),磨坊工作又让水流更大(更多用户使用产生更多数据)。

类比:小朋友每天写作业(产生数据),老师批改后讲新知识点(模型更新),小朋友作业写得更好(能力提升),老师就更愿意多布置有挑战性的作业(更多数据)。

核心概念三:工具链进化——智能体的“工具包升级”

工具链是AI的“工具箱”,包括写代码的框架、训练模型的机器、监控模型的系统等。比如小智一开始用普通电脑训练模型(慢,只能学简单咖啡),后来用GPU集群(快,能学复杂的多口味组合);一开始手动检查模型是否出错(容易漏),后来用自动监控系统(实时报警)。工具链越先进,模型升级就越快、越可靠。

类比:小朋友一开始用铅笔写字(慢,容易错),后来用钢笔(快),再后来用电脑打字(能自动检查错别字),工具越先进,学习效率越高。

核心概念四:伦理合规——智能体的“行为准则”

伦理合规是AI的“行为红线”,规定“什么能做,什么不能做”。比如小智不能偷偷记录用户的身份证号(隐私保护),不能为了多卖咖啡故意推荐高糖饮品(公平性),不能在用户明确拒绝时继续收集人脸数据(用户授权)。这些规则不是写在模型里的,而是像“紧箍咒”一样,约束模型的“学习”和“行动”。

类比:小朋友在学校要遵守校规,不能偷拿同学东西(隐私),不能欺负弱小(公平),要举手发言(规则),这些规矩让小朋友的成长更健康。

核心概念之间的关系(用小学生能理解的比喻)

四个核心概念像四个小伙伴,手拉手合作让AI原生应用“长大”:

- 模型迭代×数据飞轮:数据飞轮给模型迭代“喂新食物”(新数据),模型迭代让数据飞轮“转得更快”(更好的服务带来更多数据)。就像小朋友吃有营养的饭(数据)才能长个子(模型升级),个子长高了(能力提升)就更爱吃饭(更愿意产生数据)。

- 工具链进化×模型迭代:工具链进化给模型迭代“造更快的梯子”(更高效的训练工具),模型迭代让工具链进化“知道该造什么梯子”(新的需求推动工具升级)。就像小朋友要学更高的数学(模型升级),需要更高级的计算器(工具进化);而学更高数学的过程中,又会发现计算器需要加新功能(推动工具进化)。

- 伦理合规×其他三个概念:伦理合规是“大管家”,确保数据飞轮不偷数据(隐私)、模型迭代不学坏(公平)、工具链进化不违规(安全)。就像学校的老师,看着小朋友吃饭(数据)、学习(模型)、用新文具(工具),确保大家都守规矩。

核心概念原理和架构的文本示意图

AI原生应用知识更新的核心架构可概括为“四轮驱动”:

数据飞轮(输入)→ 工具链(处理)→ 模型迭代(输出)→ 伦理合规(约束)→ 数据飞轮(反馈)

每一轮循环中,数据飞轮提供“燃料”,工具链优化“引擎”,模型迭代提升“动力”,伦理合规校准“方向”。

Mermaid 流程图

核心算法原理 & 具体操作步骤

AI原生应用知识更新的核心算法围绕“持续学习”(Continual Learning)展开,目标是让模型在处理新任务时不遗忘旧知识(“灾难性遗忘”问题)。以下以Python代码示例说明关键步骤。

持续学习的核心原理:增量训练

传统模型训练是“一次性考试”:用固定数据集训练后上线。而AI原生应用需要“边考试边学习”,每次遇到新数据(如用户点生椰拿铁的记录),就用新数据+部分旧数据重新训练模型,保留旧知识的同时学习新技能。

具体操作步骤(以推荐系统为例)

- 数据采集:从APP日志中获取用户点击、购买、评价数据;

- 数据清洗:过滤无效数据(如重复点击),处理缺失值(如用户未评分的商品);

- 数据切片:将数据分为“旧数据”(历史数据)和“新数据”(最近1周数据);

- 模型加载:加载已上线的旧模型;

- 增量训练:用旧数据的10% + 新数据的100%训练模型(平衡新旧知识);

- 模型评估:用未参与训练的“验证数据”检查模型是否遗忘旧任务(如是否仍能推荐用户过去喜欢的商品);

- 模型部署:通过A/B测试将新模型上线,监控性能(如点击率是否提升)。

Python代码示例(基于PyTorch的增量训练)

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader, ConcatDataset

# 假设旧模型是一个简单的推荐模型

class RecommendationModel(nn.Module):

def __init__(self):

super().__init__()

self.fc = nn.Linear(10, 2) # 输入10维特征,输出2维(推荐/不推荐)

def forward(self, x):

return self.fc(x)

# 步骤1:加载旧模型和旧数据

old_model = torch.load("old_model.pth")

old_data = torch.load("old_data.pth") # 旧数据集(历史用户行为)

# 步骤2:获取新数据(最近1周用户行为)

new_data = torch.load("new_data.pth")

# 步骤3:组合旧数据的10%和新数据的100%(防止遗忘)

combined_data = ConcatDataset([old_data[:len(old_data)//10], new_data])

data_loader = DataLoader(combined_data, batch_size=32, shuffle=True)

# 步骤4:增量训练(冻结部分旧层,只训练新层)

freeze_layers = [old_model.fc.weight] # 假设旧知识主要存在fc层

for param in freeze_layers:

param.requires_grad = False

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(old_model.parameters(), lr=0.001)

# 训练循环

for epoch in range(3): # 小批量训练避免过拟合

for batch in data_loader:

inputs, labels = batch

outputs = old_model(inputs)

loss = criterion(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 步骤5:保存新模型

torch.save(old_model, "updated_model.pth")

代码解读:

- 通过

ConcatDataset组合新旧数据,避免模型遗忘旧知识; - 冻结部分旧层(

freeze_layers),确保旧知识不被“覆盖”; - 小批量训练(3个epoch)平衡学习速度与稳定性。

数学模型和公式 & 详细讲解 & 举例说明

持续学习的核心数学挑战是解决“灾难性遗忘”(Catastrophic Forgetting),即模型在学习新任务时丢失旧任务的能力。其本质是优化问题中的“非平稳分布”(数据分布随时间变化)。

关键公式:弹性权重整合(Elastic Weight Consolidation, EWC)

EWC通过计算旧任务中参数的重要性(用Fisher信息矩阵衡量),在新任务训练时对重要参数施加惩罚,防止其变化过大。公式如下:

L EWC ( θ ) = L new ( θ ) + λ ∑ i F i 2 ( θ i − θ i old ) 2 \mathcal{L}_{\text{EWC}}(\theta) = \mathcal{L}_{\text{new}}(\theta) + \lambda \sum_i \frac{F_i}{2} (\theta_i - \theta_i^{\text{old}})^2 LEWC(θ)=Lnew(θ)+λi∑2Fi(θi−θiold)2

- L new ( θ ) \mathcal{L}_{\text{new}}(\theta) Lnew(θ):新任务的损失函数;

- F i F_i Fi:参数 θ i \theta_i θi在旧任务中的Fisher信息(重要性);

- λ \lambda λ:平衡新旧任务的超参数;

- θ i old \theta_i^{\text{old}} θiold:旧任务训练后的参数值。

举例:小智的“做咖啡模型”中,“牛奶加热到60℃”是旧任务的关键参数( F i F_i Fi大),学习新任务“椰浆比例”时,这个参数不能变化太大(否则会忘记怎么做拿铁)。EWC通过惩罚项约束其变化,确保旧知识保留。

多模态融合的数学基础:注意力机制

AI原生应用常需融合文本、图像、语音等多模态数据(如小智通过用户表情判断咖啡甜度)。注意力机制(Attention)通过计算不同模态数据的“重要性”,动态调整模型对各模态的关注程度。公式如下:

Attention ( Q , K , V ) = softmax ( Q K T d k ) V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

- Q Q Q(查询)、 K K K(键)、 V V V(值):分别来自不同模态的数据;

- d k \sqrt{d_k} dk:缩放因子,防止内积过大导致梯度消失。

举例:用户点单时说“来杯甜的”(文本),同时皱眉(图像),注意力机制会发现“皱眉”可能表示“其实不想太甜”,因此给图像模态更高的权重,调整推荐的甜度。

项目实战:代码实际案例和详细解释说明

开发环境搭建(以智能推荐系统为例)

- 硬件:AWS GPU实例(p3.2xlarge,含V100显卡,支持快速模型训练);

- 软件:

- 数据采集:Apache Kafka(实时日志采集);

- 数据清洗:Pandas + Spark(处理大规模数据);

- 模型训练:PyTorch + Hugging Face Transformers(支持预训练模型微调);

- 模型部署:TensorFlow Serving(低延迟推理);

- 监控:MLflow(跟踪模型性能)。

源代码详细实现和代码解读(增量学习+多模态融合)

以下是一个简化版的智能推荐系统代码,整合了增量学习和多模态(文本+图像)数据:

import torch

import torch.nn as nn

from torchvision import models

from transformers import BertModel

# 步骤1:定义多模态模型(文本+图像)

class MultiModalModel(nn.Module):

def __init__(self):

super().__init__()

# 图像分支:使用预训练的ResNet

self.image_encoder = models.resnet18(pretrained=True)

self.image_encoder.fc = nn.Linear(512, 256) # 输出256维特征

# 文本分支:使用预训练的BERT

self.text_encoder = BertModel.from_pretrained('bert-base-uncased')

self.text_encoder.pooler = None # 去掉池化层,直接用最后一层输出

# 融合层:注意力机制

self.attention = nn.MultiheadAttention(embed_dim=256, num_heads=4)

self.classifier = nn.Linear(256, 1) # 输出推荐概率

def forward(self, images, texts, text_masks):

# 图像特征提取

image_features = self.image_encoder(images) # (batch_size, 256)

# 文本特征提取(取[CLS] token的输出)

text_outputs = self.text_encoder(input_ids=texts, attention_mask=text_masks)

text_features = text_outputs.last_hidden_state[:, 0, :] # (batch_size, 768)

text_features = nn.Linear(768, 256)(text_features) # 降维到256维

# 注意力融合(将图像和文本视为“查询”和“键值”)

features = torch.stack([image_features, text_features], dim=0) # (2, batch_size, 256)

attn_output, _ = self.attention(features, features, features)

fused_features = attn_output.mean(dim=0) # (batch_size, 256)

# 推荐概率预测

output = self.classifier(fused_features)

return torch.sigmoid(output)

# 步骤2:增量训练逻辑(基于EWC)

def incremental_train(old_model, new_data_loader, old_data_loader, lambda_ewc=100):

# 计算旧任务的Fisher信息(重要参数)

fisher_matrix = compute_fisher(old_model, old_data_loader)

# 冻结旧模型中重要参数的部分梯度

for name, param in old_model.named_parameters():

if name in fisher_matrix and fisher_matrix[name] > 10: # 设定重要性阈值

param.requires_grad = False

# 定义优化器和损失函数

optimizer = torch.optim.Adam(old_model.parameters(), lr=0.0001)

criterion = nn.BCELoss() # 二分类交叉熵

# 训练新数据

old_model.train()

for epoch in range(2):

for batch in new_data_loader:

images, texts, text_masks, labels = batch

outputs = old_model(images, texts, text_masks)

loss = criterion(outputs.squeeze(), labels.float())

# 添加EWC惩罚项(简化版)

for name, param in old_model.named_parameters():

if name in fisher_matrix:

loss += lambda_ewc * fisher_matrix[name] * (param - old_param[name]).pow(2).sum()

optimizer.zero_grad()

loss.backward()

optimizer.step()

return old_model

# 步骤3:计算Fisher信息的辅助函数(简化版)

def compute_fisher(model, data_loader):

fisher = {}

model.eval()

for batch in data_loader:

images, texts, text_masks, labels = batch

outputs = model(images, texts, text_masks)

loss = nn.BCELoss()(outputs.squeeze(), labels.float())

loss.backward()

# 记录参数梯度的平方(近似Fisher信息)

for name, param in model.named_parameters():

if param.grad is not None:

if name not in fisher:

fisher[name] = 0.0

fisher[name] += param.grad.pow(2).mean()

# 归一化

total = sum(fisher.values())

for name in fisher:

fisher[name] /= total

return fisher

代码解读:

MultiModalModel整合了图像(ResNet)和文本(BERT)的特征,通过注意力机制融合,解决“用户说甜但表情嫌甜”的多模态矛盾;incremental_train函数通过EWC算法约束重要参数的变化,防止模型遗忘旧知识(如仍能推荐用户过去喜欢的商品);compute_fisher函数通过计算参数梯度的平方(近似Fisher信息),识别旧任务中的关键参数(如“牛奶温度”对应的参数)。

实际应用场景

AI原生应用的知识更新已渗透到多个领域,以下是三个典型场景:

场景1:智能语音助手(如ChatGPT)

- 知识更新方式:通过用户对话日志(新数据)训练对话模型,同时接入实时信息(如新闻、天气)扩展知识;

- 关键挑战:避免模型生成错误信息(如过时新闻),需结合伦理合规中的“事实核查”机制;

- 效果:用户问“2024年世界杯冠军是谁”,助手能根据最新赛果回答,而非依赖旧数据。

场景2:自动驾驶(如特斯拉FSD)

- 知识更新方式:通过路测车辆采集的新场景数据(如暴雨天、施工路段),增量训练感知与决策模型;

- 关键挑战:确保模型在更新后不遗忘常见场景(如直行、转弯),需严格的“回归测试”;

- 效果:2023年特斯拉通过FSD 12.4版本更新,将施工路段的通行成功率从70%提升至95%。

场景3:医疗诊断(如IBM Watson Health)

- 知识更新方式:结合最新医学论文(文本数据)、患者病历(结构化数据)、影像报告(图像数据)训练诊断模型;

- 关键挑战:需遵守HIPAA(健康保险携带和责任法案)等合规要求,确保患者隐私不泄露;

- 效果:某肿瘤诊断模型通过更新2024年的靶向治疗指南,将肺癌亚型识别准确率从82%提升至89%。

工具和资源推荐

模型训练工具

- Hugging Face Transformers:提供预训练模型(如BERT、GPT)的快速微调接口,支持多模态模型开发;

- MLflow:跟踪模型训练过程,记录参数、指标和日志,方便对比不同版本模型的性能;

- Weights & Biases:可视化训练曲线、数据分布和模型预测结果,快速定位训练问题。

数据管理工具

- DVC(Data Version Control):管理数据版本,支持“数据+代码+模型”的端到端版本控制;

- Apache Airflow:编排数据清洗、标注、训练的流水线,实现自动化数据处理;

- Label Studio:多模态数据标注工具(支持文本、图像、视频),提升标注效率。

伦理合规工具

- IBM AI Fairness 360:检测模型的偏见(如性别、种族歧视),提供修复建议;

- Google Privacy Sandbox:在不泄露用户隐私的前提下,通过联邦学习(Federated Learning)训练模型;

- OpenAI Evals:评估模型的安全性(如是否生成有害内容),支持自定义测试用例。

未来发展趋势与挑战

趋势1:多模态大模型的动态更新

2024年,多模态大模型(如GPT-4V、Gemini)已能理解图像、视频、文本的关联,但如何高效更新这些“千亿参数”模型仍是挑战。未来可能出现“参数高效微调”(Parameter-Efficient Fine-Tuning, PEFT)技术,仅更新少量参数即可实现模型升级,降低计算成本。

趋势2:边缘设备的轻量化更新

随着AI向手机、智能家居渗透,边缘设备(如手机)需在本地完成模型更新(避免上传数据)。未来可能普及“增量模型压缩”技术,将更新包大小从GB级降至MB级,支持“秒级”更新。

趋势3:联邦学习下的隐私保护更新

医疗、金融等敏感领域需在不共享原始数据的前提下更新模型。联邦学习(Federated Learning)允许各机构用本地数据训练“模型更新包”,中央服务器汇总后生成全局模型。未来可能结合同态加密(Homomorphic Encryption),实现“数据可用不可见”的安全更新。

挑战1:更新速度与稳定性的平衡

快速更新可能导致模型“抖动”(如推荐系统突然推荐不相关内容)。需开发“渐进式更新”机制,通过A/B测试逐步替换旧模型,确保用户体验平滑。

挑战2:多源数据的冲突解决

不同来源的数据(如用户点击日志vs.问卷调查)可能矛盾(用户点击了商品但问卷说不喜欢)。未来需研究“数据可信度评估”算法,自动判断哪些数据更值得信任。

总结:学到了什么?

核心概念回顾

- 模型迭代:AI的“大脑升级”,通过新数据学习新技能,同时保留旧知识;

- 数据飞轮:AI的“能量循环”,数据→模型→服务→数据的闭环推动能力螺旋上升;

- 工具链进化:AI的“工具包升级”,更高效的工具支持更快、更可靠的模型更新;

- 伦理合规:AI的“行为准则”,确保更新过程符合隐私、公平、安全要求。

概念关系回顾

四个核心概念像“智能体的四条腿”:

- 数据飞轮提供“动力”,模型迭代输出“能力”,工具链进化增强“效率”,伦理合规保障“方向”;

- 缺少任何一条“腿”,AI原生应用都无法持续“健康成长”。

思考题:动动小脑筋

-

假设你是一个智能教育APP的开发者,用户反馈“APP推荐的题目有时太简单,有时又太难”。你会如何设计知识更新机制?(提示:考虑数据飞轮中的“用户反馈数据”、模型迭代中的“难度预测模型”)

-

如果你负责设计一个医疗AI的知识更新系统,需要遵守哪些伦理合规要求?(提示:HIPAA隐私保护、模型公平性(如不同种族患者的诊断准确率)、可解释性(医生需要知道模型为什么推荐某个治疗方案))

-

边缘设备(如智能手表)的计算能力有限,如何在不上传数据的前提下实现模型更新?(提示:联邦学习、模型压缩、增量更新)

附录:常见问题与解答

Q:模型更新时,如何避免“灾难性遗忘”?

A:可以使用持续学习算法(如EWC、LwF),通过约束重要参数的变化、保留部分旧数据训练等方式,确保模型不忘记旧知识。

Q:数据飞轮需要多大的数据量才能启动?

A:没有固定阈值,但需满足“数据多样性”和“反馈闭环”。例如,推荐系统至少需要10万条用户行为数据(点击、购买、评价)才能初步训练模型,后续通过每天新增的1000条数据持续优化。

Q:伦理合规会限制模型的学习能力吗?

A:短期可能增加开发成本(如需要额外的隐私保护模块),但长期看能提升用户信任度。例如,严格的隐私保护(如匿名化数据)会让用户更愿意使用产品,从而产生更多高质量数据,反哺模型能力提升。

扩展阅读 & 参考资料

- 《持续学习:从理论到实践》(Yao et al., 2023)

- 《AI原生应用设计指南》(O’Reilly, 2024)

- Hugging Face官方文档:https://huggingface.co/docs

- MLflow最佳实践:https://www.mlflow.org/docs

更多推荐

已为社区贡献144条内容

已为社区贡献144条内容

所有评论(0)