人工智能发展简史4:深度学习的复兴与发展(1980-2000 年代)

摘要:20世纪80-90年代,深度学习迎来重要突破。杨立昆提出首个商用卷积神经网络LeNet-5,在手写数字识别上取得突破。同时,为解决序列数据处理问题,研究者提出循环神经网络(RNN)及其改进版LSTM、GRU。然而这一时期的AI发展并非一帆风顺,专家系统的商业化失败导致第二次AI寒冬(1987-1993),神经网络研究虽继续但进展缓慢。这些技术突破为21世纪深度学习的爆发奠定了基础。

深度学习的复兴与发展(1980-2000 年代)

1 卷积神经网络的诞生与早期应用

1980 年代后期,随着反向传播算法的广泛应用,神经网络研究开始复苏。在这一时期,杨立昆(Yann LeCun)在多伦多大学和贝尔实验室工作期间,成为了第一个训练卷积神经网络系统处理手写数字图像的研究者。

图1杨立昆(Yann LeCun)

LeCun 的研究具有开创性意义。他提出的LeNet-5模型于 1998 年正式发表,这是首个成功应用于商业系统的卷积神经网络,主要用于手写数字识别。LeNet-5 包含 3 个部分:2 个卷积层、2 个子采样或池化层和 3 个全连接层,其架构设计体现了局部感受野、权重共享等重要思想。

图 2 LeNet-5s结构图

LeNet-5 在 MNIST 手写数字数据集上达到了 1% 的错误率,在美国邮政服务提供的邮政编码数字上,拒绝率为 9%。这一成果在当时被认为是 20 世纪 90 年代神经网络研究的巅峰,其技术被应用于 AT&T/NCR 阅读手写支票的系统中。

图 3 LeNet-5s识别LeCun当时在贝尔实验室的电话号码

卷积神经网络的创新之处在于其卷积层设计。与传统的全连接网络不同,卷积层中的神经元只与输入数据的局部区域相连,这种设计大大减少了参数数量,同时保持了对空间结构的敏感性。池化层则通过下采样操作进一步减少数据维度,提高了模型的平移不变性。

2 循环神经网络与长短期记忆网络

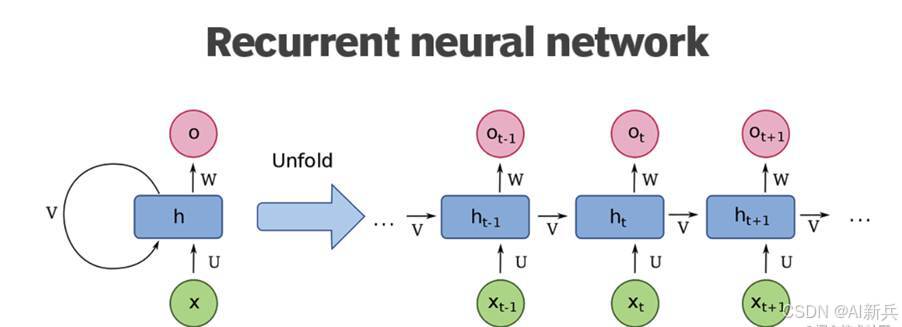

在卷积神经网络取得成功的同时,研究者们开始思考如何处理序列数据。1982-1986 年间,循环神经网络(RNN)被提出,这是一类专门用于处理序列数据的神经网络架构。与前馈网络不同,RNN 具有内部反馈回路,能够记住每个时间步的信息状态。

图 4循环神经网络(RNN)

然而,传统 RNN 存在一个严重问题:梯度消失 / 爆炸问题。当处理长序列时,梯度在反向传播过程中会指数级衰减或增长,导致网络无法学习长距离依赖关系。

为了解决这一问题,1997 年,塞普・霍克赖特(Sepp Hochreiter)和于尔根・施密德胡贝尔(Jürgen Schmidhuber)提出了长短期记忆网络(LSTM)。LSTM 通过引入门控机制解决了梯度问题,其核心单元包含输入门、遗忘门和输出门,能够选择性地保留或丢弃信息的门控机制设计巧妙。输入门决定当前时刻的新信息如何被存储,遗忘门控制历史信息的遗忘程度,输出门则决定当前的输出值。这种机制使得 LSTM 能够有效处理长序列数据,在语音识别、语言建模等任务中取得了显著成功。

2014 年,克劳斯・格雷夫(Klaus Greff)等人进一步提出了门控循环单元(GRU),这是 LSTM 的一个简化版本。GRU 将 LSTM 的三个门简化为更新门和重置门两个,在保持类似性能的同时,参数量减少了 33%,在计算资源受限的场景中表现更优。

3 第二次 AI 寒冬:专家系统的兴衰

就在神经网络研究逐步复苏之际,AI 领域再次陷入了困境。1987 年,AI 硬件市场需求突然下跌,标志着第二次 AI 寒冬(1987-1993 年)的开始。

这一次寒冬的起因是专家系统的商业化失败。专家系统是基于规则的人工智能系统,在 1980 年代曾被寄予厚望。例如,1980 年 DEC 公司部署的专家系统 XCON,年省成本超过 4 亿美元,引发了商业 AI 热潮。然而,专家系统的维护成本高昂,规则库需要人工持续更新,无法适应动态变化的环境

此外,第五代计算机计划的失败、Lisp Machines 和 Connection Machines 等专用硬件的市场失利,以及神经网络虽然有趣但并没有比其他统计方法表现更好等因素,都加剧了人们对 AI 的失望情绪

在这长达六年的寒冬期里,AI 研究再次陷入低潮。许多公司倒闭,研究人员纷纷转行。神经网络研究虽然没有完全停止,但进展缓慢,主要局限于学术领域的理论探索。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)