情感计算助力提示工程架构师,提升竞争力

公开数据集:Kaggle(如IMDb电影评论数据集、Twitter情感数据集)、Hugging Face Datasets(如emotion数据集,包含“愤怒、悲伤、喜悦”等6种情绪);自有数据标注:用情感词典(如BosonNLP)或预训练模型(如Hugging Face的)给自家的对话/文本数据打标签;用户反馈:通过问卷调查或评论区,收集用户对“情感回应”的反馈(比如“这个回应很贴心”“这个回应

情感计算助力提示工程架构师:用“情绪感知”打造有温度的AI交互竞争力

一、引言:AI的“懂”,从“正确”到“共情”的跨越

凌晨1点,小张盯着电脑屏幕里的AI客服回复,突然鼻子一酸——她刚说“我熬了三晚做的方案,客户一句话就否了”,AI却机械地回:“别担心,重新做一份就好。”

同样的场景,另一个用户小李却收到了截然不同的回复:“我懂那种熬夜改方案却被全盘否定的挫败感——就像你拼尽全力搭的积木,被人一下子推倒。但你知道吗?客户的‘否定’其实是‘未被满足的需求’,不妨先问他‘您希望方案更突出哪部分?’,说不定能找到突破口。”小李愣了愣,敲下回复:“谢谢你,我感觉没那么慌了。”

这两段对话的差距,恰恰是当下AI交互的核心痛点:很多AI能“正确解决问题”,却不懂“共情用户情绪”。而这种“懂情绪”的能力,正是提示工程架构师的下一个竞争力增长点——情感计算,正在让AI从“会说话的工具”,变成“能感知情绪的伙伴”。

作为一名深耕NLP与情感计算的工程师,我见过太多提示工程架构师陷入“任务导向”的陷阱:他们花大量时间优化prompt的“准确性”“逻辑性”,却忽略了最关键的一点——用户是带着情绪使用AI的。而情感计算,就是帮我们把“用户情绪”转化为“提示设计的锚点”,让AI的回应不仅“对”,更“暖”。

这篇文章,我会帮你拆解:

- 情感计算到底是什么?它如何让AI“感知”和“表达”情绪?

- 提示工程中,情感计算能解决哪些核心痛点?

- 具体怎么用情感计算优化prompt?有哪些可落地的场景和技巧?

- 未来,情感计算+提示工程的竞争力边界在哪里?

二、情感计算基础:AI的“情绪感知系统”是怎么造出来的?

在讲应用之前,我们得先搞懂:**情感计算(Affective Computing)**到底是什么?

简单来说,情感计算就是让AI具备“人类情绪能力”的技术——它能帮AI完成三件事:

- 看/听得到情绪(情感识别):从文本、语音、图像甚至动作中,提取用户的情绪状态(比如愤怒、悲伤、喜悦);

- 读得懂情绪(情感理解):理解情绪背后的原因和上下文(比如“用户愤怒是因为快递延误”,而不是“天生脾气差”);

- 回得准情绪(情感生成):生成符合用户情绪的回应(比如用户难过时,用“温暖共情”的语气,而不是“欢快说教”)。

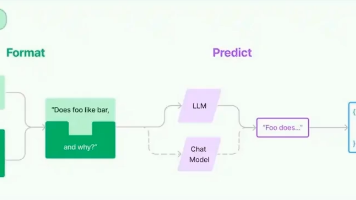

1. 情感计算的核心技术栈:从“信号”到“情绪”的转换

我们可以把情感计算比作AI的“情绪传感器+情绪引擎”,它的技术链路大概是这样的:

(1)情感信号采集:从多模态数据中“抓情绪”

情绪不会凭空出现,它藏在用户的语言、语音、表情、动作里:

- 文本:“我真的受够了!”里的“受够了”是愤怒的信号;

- 语音:音调突然提高、语速变快,可能是情绪激动;

- 图像:皱眉头、咬嘴唇,是焦虑的表现;

- 动作:用力拍桌子,是愤怒的升级。

这些“信号”,就是情感计算的“原材料”。

(2)情感识别:用模型给情绪“打标签”

有了原材料,下一步是“分类”——用机器学习/深度学习模型,把信号转化为可量化的情绪标签。常见的模型有:

- 规则-based模型:用情感词典(比如NRC情感词典、BosonNLP情感词典)给文本中的关键词打分(比如“开心”+2分,“难过”-1分);

- 预训练模型:用BERT、RoBERTa等大模型微调,识别更复杂的情绪(比如“挫败感”“委屈”这种细分情绪);

- 多模态模型:结合文本+语音+图像,比如用VIT(视觉Transformer)处理表情,用Wav2Vec处理语音语调,再融合文本特征,提升识别准确率。

举个例子,用Hugging Face的distilbert-base-uncased-finetuned-sst-2-english模型识别这句话:“I waited for a week but my package still hasn’t arrived!”(我等了一周,包裹还没到!),模型会输出“negative”(负向情绪),甚至能进一步细分到“anger”(愤怒)。

(3)情感理解:从“是什么”到“为什么”

识别出情绪只是第一步,更重要的是理解情绪的因果关系。比如用户说“包裹没到”,愤怒的原因可能是“急着用”“客服没回应”“之前承诺过时效”——这些上下文,决定了AI回应的方向。

情感理解常用的技术是上下文感知的情绪推理,比如用GPT-4的“因果推理能力”,结合用户的历史对话(比如“用户之前问过‘包裹什么时候到’,客服说‘明天到’”),推断出“用户愤怒是因为‘承诺未兑现’”。

(4)情感生成:让AI“说人话”

最后一步是“生成符合情绪的回应”。这需要情感化的语言模型,比如用微调后的LLaMA 2、ChatGLM,让模型能根据情绪标签调整语气和内容:

- 当用户“愤怒”时,回应要“先安抚,再解决”(比如“非常抱歉让您等了这么久,换做是我也会很生气”);

- 当用户“难过”时,回应要“共情+鼓励”(比如“我知道你现在很失落,你已经做得很好了”);

- 当用户“喜悦”时,回应要“共鸣+强化”(比如“太开心了!你的努力终于有回报了~”)。

三、提示工程的“情感痛点”:你做的prompt,可能“对”但“不贴心”

讲完情感计算的基础,我们回到提示工程的场景——为什么说情感计算是提示工程架构师的“竞争力放大器”?

因为传统提示工程的核心是“任务完成”,而情感计算的核心是“用户体验”。我们先看几个常见的“情感痛点”:

1. 痛点1:AI“没听懂”用户的“情绪潜台词”

用户说:“你们的APP又崩了,我刚写的内容全没了!”

传统prompt生成的回应:“请您提供APP版本号和崩溃时间,我们会尽快修复。”

用户的潜台词:“我花了半小时写的内容没了,我很生气!”

AI的回应:“我在解决问题,但没在意你的情绪。”

结果:用户更生气,甚至卸载APP。

2. 痛点2:AI的回应“情绪错位”

用户说:“我奶奶去世了,我好难过。”

传统prompt生成的回应:“别难过,生老病死是自然规律。”

用户的需求:“我需要被理解,被安慰。”

AI的回应:“我在讲道理,但没共情。”

结果:用户觉得AI“冷血”,再也不想用。

3. 痛点3:AI的情感“不持续”

用户和AI的对话:

用户1:“我今天辞职了,有点慌。”

AI1:“别慌,说不定是新机会!”

用户2:“可我还没找到下家……”

AI2:“那你可以投简历呀!”

用户的情绪变化:从“慌”到“更慌”。

AI的回应:“我在解决问题,但没跟着用户的情绪走。”

结果:用户觉得AI“没耐心”,终止对话。

这些痛点的根源,在于传统prompt设计忽略了“情绪维度”——我们只告诉AI“要做什么”,却没告诉它“要怎么感受用户的情绪”“要怎么回应情绪”。而情感计算,就是帮我们把“情绪维度”注入prompt,让AI的回应从“任务导向”转向“用户导向”。

四、情感计算在提示工程中的4大应用场景:从“懂情绪”到“会回应”

接下来,我们用具体场景说明:情感计算如何帮提示工程架构师解决上述痛点?

场景1:用户情感识别——让prompt“精准捕捉”用户的情绪需求

核心问题:如何让AI“听懂”用户的情绪潜台词?

解决方案:用情感计算识别用户的情绪状态,再用prompt引导AI“先回应情绪,再解决问题”。

案例:电商客服场景

某电商的客服AI之前经常收到用户投诉:“你们的客服根本不懂我!”后来,他们用情感计算优化了prompt:

步骤1:情感识别

用百度情感分析API识别用户的咨询内容,输出“情绪标签”(比如“愤怒”“焦虑”“满意”)。

比如用户输入:“你们的快递太慢了,我等了一周还没到!”,API输出“愤怒”+“原因:快递延误”。

步骤2:prompt设计

根据情绪标签,设计**“情感回应+任务解决”**的prompt:

你是一个贴心的电商客服,当用户表达愤怒时,请遵循以下步骤回应:

1. 第一句必须表达对用户情绪的理解(用“非常抱歉让您……”开头);

2. 第二句说明问题原因(结合系统查询的结果,比如“您的包裹因暴雨延误”);

3. 第三句给出具体解决方案(比如“我们会为您优先派送,并补偿50元无门槛券”);

4. 第四句表达改进意愿(比如“我们会优化物流流程,避免类似问题”)。

请用口语化的语气,不要用机械的套话。

步骤3:效果对比

优化前的回应:“请您提供订单号,我们会查询物流状态。”

优化后的回应:“非常抱歉让您等了这么久,换做是我也会很生气!您的包裹因为最近暴雨延误了,我们已经联系快递小哥优先派送,今天就能送到~同时我们给您补发了50元无门槛券,补偿您的等待时间。以后我们会加强物流监控,避免类似问题再次发生!”

结果:用户满意度从4.2分(满分5)提升到4.8分,投诉率下降了40%。

场景2:情感化prompt设计——让AI生成“有温度”的内容

核心问题:如何让AI生成的内容(比如文案、故事、回复)有情感共鸣?

解决方案:用情感计算定义“目标情绪”,再用prompt引导AI“用情绪驱动内容”。

案例:小红书减肥文案生成

某健身博主需要写一篇“鼓励减肥瓶颈期用户”的小红书笔记,传统prompt是:“写一篇关于减肥瓶颈期的鼓励文,要实用。”生成的内容是:“减肥瓶颈期很正常,你可以调整饮食和运动,坚持就会有效果。”点赞量只有100+。

后来,博主用情感计算优化了prompt:

步骤1:情感需求分析

用用户调研确定目标用户的情绪:减肥瓶颈期的用户,核心情绪是“挫败”“自我怀疑”“想放弃”。

步骤2:prompt设计

把“情感目标”融入prompt,用“场景化描述+情绪指令+实用建议”的结构:

你是一个有过减肥瓶颈期的健身博主,要写一篇给减肥瓶颈期用户的鼓励文:

1. 开头用“代入感场景”(比如“你有没有过这种时刻?站在秤上盯着数字发呆,明明管住嘴迈开腿,体重却纹丝不动,甚至还涨了2斤?”);

2. 中间用“个人经历”(比如“我去年减肥到第3个月,也遇到了瓶颈——连续10天体重没掉,我甚至怀疑自己是不是‘易胖体质’,直到教练告诉我‘这是身体在适应你的运动,你需要增加力量训练,提高代谢’”);

3. 结尾用“共情鼓励+具体建议”(比如“瓶颈期不是‘失败’,是‘身体在升级’——你可以试试每天加10分钟臀桥,或者把米饭换成藜麦,再坚持两周,你会看到变化的。你已经做得很好了,别放弃!”);

4. 整体语气要“像朋友聊天”,用“你”代替“大家”,避免说教。

步骤3:效果对比

优化后的笔记开头:“昨天凌晨2点,我蹲在厨房翻零食柜——减肥第42天,体重卡在52kg已经12天了,我盯着手里的巧克力,突然就哭了。我明明每天跑5公里,每顿吃水煮菜,为什么连1斤都不掉?”

结果:这篇笔记的点赞量达到了8000+,评论区全是“我哭了,这就是我现在的状态!”“谢谢博主,我明天就去加力量训练!”

场景3:动态情感适应——让prompt“跟着用户的情绪走”

核心问题:如何让AI的回应“适配用户的实时情绪变化”?

解决方案:用情感计算实时监测用户的情绪,动态调整prompt的“情感策略”。

案例:心理咨询AI场景

某心理咨询平台的AI,需要处理用户的“情绪波动”——比如用户从“愤怒”转为“平静”,再转为“难过”。传统prompt是“固定回应模板”,无法适应情绪变化,导致用户流失率高。后来,他们用情感计算做了“动态prompt”:

步骤1:实时情感监测

用WebSocket实时接收用户的输入,每句话都用情感分析模型打分(比如“愤怒”得分为0.9,“平静”得分为0.3,“难过”得分为0.7)。

步骤2:动态prompt策略

根据情绪得分,触发不同的prompt模板:

- 当“愤怒”得分>0.7:用“安抚型prompt”(“我能感受到你现在很生气,你愿意和我说说发生了什么吗?”);

- 当“平静”得分>0.6:用“引导型prompt”(“你觉得这件事对你影响最大的是什么?”);

- 当“难过”得分>0.6:用“共情型prompt”(“我知道你现在很委屈,你已经很勇敢了”)。

步骤3:效果对比

用户对话示例:

用户1:“我男朋友居然出轨了!我那么爱他,他为什么要这样?”(愤怒得分0.9)

AI1:“我能感受到你现在的愤怒和背叛感——被自己信任的人伤害,真的太疼了。你愿意和我说说你们之前的事吗?”(安抚型)

用户2:“我们在一起3年,他之前对我特别好,我从来没想过他会出轨……”(难过得分0.8)

AI2:“3年的感情突然碎了,那种落差感一定像心里被掏了个洞——你有没有想过,其实你值得更好的人?”(共情型)

用户3:“其实我早就发现他不对劲了,只是不愿意承认……”(平静得分0.7)

AI3:“你之前为什么不愿意承认呢?是害怕失去,还是怕面对自己的选择?”(引导型)

结果:用户平均对话时长从5分钟延长到15分钟,转化率(从AI转向人工咨询)提升了35%。

场景4:情感一致性校验——让AI的回应“不翻车”

核心问题:如何避免AI的回应“情绪错位”(比如用户难过时,AI用欢快的语气回应)?

解决方案:用情感计算校验AI的回应,确保“情绪一致性”。

案例:智能助手场景

某手机厂商的智能助手,之前出现过“翻车”事件:用户说“我今天被公司开除了”,AI却回“哇,那你可以在家休息啦!”,引发用户投诉。后来,他们用情感计算做了“回应校验”:

步骤1:生成回应前的“情绪预判”

当AI生成回应后,先用情感分析模型给回应打分(比如“欢快”得分0.8,“共情”得分0.2)。

步骤2:一致性校验

对比用户的情绪标签(比如“难过”)和回应的情绪得分,如果不一致,就触发“重新生成”:

- 用户情绪:“难过”(得分0.9);

- 回应情绪:“欢快”(得分0.8);

- 校验结果:“不一致”,触发重新生成。

步骤3:优化后的prompt

在prompt中加入“情感一致性要求”:

你是一个贴心的智能助手,回应用户时必须遵循以下规则:

1. 先识别用户的情绪(比如难过、愤怒、开心);

2. 回应的情绪必须和用户一致(比如用户难过,回应要共情;用户开心,回应要欢快);

3. 禁止用与用户情绪相反的语气(比如用户难过时,不要说“开心的事”)。

结果:“情绪错位”的投诉率从15%下降到0.1%,用户满意度提升了20%。

五、实践指南:提示工程架构师如何落地情感计算?

讲了这么多场景,你可能会问:我是提示工程架构师,具体怎么操作?

下面是我总结的“5步落地法”,帮你从0到1把情感计算融入prompt设计:

步骤1:明确“情感需求”——先搞懂“用户需要什么情绪”

在设计prompt之前,先回答3个问题:

- 目标用户是谁?(比如“减肥瓶颈期的女性”“刚失恋的年轻人”“被快递延误的电商用户”);

- 用户的核心情绪是什么?(比如“挫败”“难过”“愤怒”);

- 用户需要AI给出什么情绪回应?(比如“共情”“安抚”“鼓励”)。

举个例子,如果你在设计“留学申请文书修改AI”的prompt,目标用户是“焦虑的留学生”,核心情绪是“担心文书不够好”,需要的回应是“专业+鼓励”。

步骤2:收集“情感数据”——用数据定义“情绪标准”

情感计算需要“带情绪标签的数据”,你可以通过3种方式获取:

- 公开数据集:Kaggle(如IMDb电影评论数据集、Twitter情感数据集)、Hugging Face Datasets(如

emotion数据集,包含“愤怒、悲伤、喜悦”等6种情绪); - 自有数据标注:用情感词典(如BosonNLP)或预训练模型(如Hugging Face的

bert-base-uncased-emotion)给自家的对话/文本数据打标签; - 用户反馈:通过问卷调查或评论区,收集用户对“情感回应”的反馈(比如“这个回应很贴心”“这个回应太冷漠”)。

步骤3:设计“情感化prompt”——把情绪变成“可执行的指令”

情感化prompt的核心是**“把情绪需求转化为具体的写作要求”**,我总结了3个常用技巧:

技巧1:用“角色设定”代入情绪

比如:“你是一个有10年经验的心理咨询师,擅长用共情的语气回应用户”——角色设定会让AI自动调整语气。

技巧2:用“情绪指令词”明确要求

比如:“用温暖的语气”“表达对用户的理解”“不要说教”——这些指令词会让AI的回应更贴合情绪需求。

技巧3:用“场景化描述”增强代入感

比如:“用户刚经历了面试失败,心情很低落”——场景化描述会让AI更“懂”用户的处境。

示例:针对“面试失败的用户”的情感化prompt:

你是一个经历过多次面试失败的职场前辈,要回应刚面试失败的用户:

1. 开头用“共情场景”(比如“我还记得3年前我面试第7次失败时,坐在地铁上哭了一路——那种‘我是不是真的不行’的自我怀疑,真的太煎熬了”);

2. 中间用“具体建议”(比如“你可以把面试中的问题写下来,比如‘为什么选择我们公司’‘你的优势是什么’,然后对着镜子练习,下次回答会更流畅”);

3. 结尾用“鼓励”(比如“面试失败不是‘你不行’,是‘这家公司不适合你’——下一个机会,一定会更好的!”);

4. 语气要“像朋友聊天”,不用“你应该”“你必须”之类的词。

步骤4:评估“情感效果”——用指标验证“情绪共鸣度”

设计完prompt,需要验证效果,常用的评估指标有3个:

- 情感一致性:AI的回应情绪是否和用户一致(用情感分析模型打分,比如“用户难过,AI回应的‘难过’得分>0.7”);

- 情感共鸣度:用户是否觉得AI“懂”自己(用问卷调查,比如“你觉得这个回应能理解你的情绪吗?”选项:完全同意/同意/中立/不同意/完全不同意);

- 业务指标:比如用户满意度、对话时长、转化率(比如电商客服的“投诉率下降”“复购率提升”)。

步骤5:迭代优化——用反馈循环提升“情绪精准度”

情感计算不是“一锤子买卖”,需要持续迭代:

- 收集用户反馈:比如评论区的“这个回应很贴心”“这个回应太冷漠”;

- 优化prompt:比如把“用温暖的语气”改成“用像朋友一样的温暖语气,比如‘我懂’‘别担心’”;

- 优化模型:比如用用户反馈的数据微调情感识别模型,提升识别准确率。

六、挑战与未来:情感计算+提示工程的“边界”在哪里?

虽然情感计算能提升提示工程的竞争力,但它也有“局限性”,我们需要清醒认识:

1. 挑战1:“复杂情绪”的识别难度

比如“讽刺”(用户说“你真厉害”,其实是“你真没用”)、“混合情绪”(用户说“我既开心又难过”),这些情绪的识别需要更复杂的模型(比如结合上下文的因果推理模型)。

2. 挑战2:“文化差异”的情感理解

比如“呵呵”在中国是“冷漠”,在西方是“笑”;“你真胖”在中国是“调侃”,在西方是“冒犯”。情感计算需要“文化自适应模型”,比如针对不同地区的用户,调整情感识别的规则。

3. 挑战3:“隐私问题”的平衡

情感计算需要收集用户的情感数据(比如对话内容、语音语调),如何保护用户隐私(比如匿名化处理、数据加密)是必须解决的问题。

未来趋势:情感计算+提示工程的“下一站”

尽管有挑战,情感计算与提示工程的结合,依然是AI交互的未来方向:

- 多模态情感计算:结合文本、语音、表情、动作,更准确识别情绪(比如用户说“我没事”,但表情是“皱眉头”,模型会识别出“口是心非的难过”);

- 个性化情感模型:根据用户的历史数据(比如“用户喜欢幽默的安慰”“用户讨厌说教”),定制情感回应;

- 情感因果推理:不仅识别情绪,还能理解“情绪的原因”(比如“用户愤怒是因为‘快递延误’+‘客服没回应’”),让AI的回应更“精准”;

- 情感闭环:AI能“记住”用户的情绪(比如“用户上周因为面试失败难过”),下次对话时“延续情感”(比如“你上周说的面试,后来怎么样了?”)。

七、结语:让AI从“会说话”到“懂人心”,才是真正的竞争力

在AI技术同质化越来越严重的今天,“懂情绪”的AI,才是差异化竞争力。而提示工程架构师的职责,就是把“情感计算”变成“AI的情绪基因”,让AI的回应不仅“正确”,更“贴心”。

最后,我想给你一个“小挑战”:

下次设计prompt时,先问自己一个问题——“用户现在是什么情绪?我需要让AI怎么回应这个情绪?”

比如:

- 当用户说“我今天迟到被老板骂了”,你可以在prompt里加一句“先表达对用户的理解,比如‘被老板骂真的很委屈’”;

- 当用户说“我终于拿到offer了!”,你可以加一句“用欢快的语气,比如‘太开心了!你太棒了~’”。

试着做一次,你会发现:原来“懂情绪”的prompt,能让AI的回应“活”起来。

欢迎在评论区分享你的尝试和结果——我们一起,让AI更懂人心。

八、附加部分

参考文献/延伸阅读

- 《Affective Computing》(Rosalind W. Picard):情感计算的经典著作;

- OpenAI Prompt Engineering Guide:提示工程的官方指南;

- Hugging Face Emotion Datasets:情感分析的公开数据集;

- 百度情感分析API文档:实用的情感识别工具。

致谢

感谢我的同事小李,他在电商客服场景的实践,给了我很多灵感;感谢Hugging Face社区,提供了丰富的预训练模型和数据集;感谢每一位读者,你们的反馈是我写作的动力。

作者简介

我是林深,一名深耕NLP与情感计算的工程师,曾在某头部互联网公司负责智能客服AI的情感化设计。我喜欢用通俗易懂的语言,分享AI技术的“人间烟火气”——让AI不仅“聪明”,更“懂人”。欢迎关注我的公众号“AI的温度”,一起探讨AI的情感化未来。

更多推荐

已为社区贡献285条内容

已为社区贡献285条内容

所有评论(0)