峰哥爆肝整理:大模型微调进阶32问

本文分享了关于大模型微调的25个关键问题及解决方案,涵盖全量微调显存需求、SFT数据构建、领域模型训练、多轮对话微调等核心内容。作者指出,微调应注重数据质量而非数量,推荐使用LoRA等高效方法,并强调混合通用数据以防止灾难性遗忘。文章还探讨了预训练与微调的区别、优化器选择、batch size设置等技术细节,并提供了处理loss突刺等问题的实用技巧。最后总结了微调大模型的"终极心法&qu

原创 Ken 疯聊AI 2025年09月22日 17:20 北京

小编最近研究学习大模型微调,将学习过程中的问题整理成问题对,现予以分享,对大模型微调感兴趣,想上手一试的现在有机会免费试用我司大模型微调产品LLamaFactory online:https://www.llamafactory.online/。全程小助理手把手,心贴心。

Q1: 全量微调大模型需要多少显存?

A: 想给一个70亿参数的大模型"全身换骨"?这可不是给手机升级内存那么简单。

想象一下,你有一辆劳斯莱斯幻影(模型),你想把每一个螺丝、每一根电线、每一个传感器都换成新的(全参数更新)。光是存储这辆车本身,就需要一个巨大的仓库(显存)。再加上你每次测试时,都要记录它每个零件"哪里拧紧了"、"哪里松了"(梯度)、还要记下它的"驾驶习惯"(优化器状态),整个过程就像在同时运行几十台高精度3D扫描仪。

官方给的例子是:训练一个"Vicuna-7B"模型,推荐用"4张A100 40G显卡",加起来160G显存,才能跑得动。为啥这么夸张?因为除了模型本身,最大的"吃内存大户"是:

-

梯度:计算完损失后,系统要为每一个参数算出"错在哪",这占了大头。

-

优化器状态:像AdamW这种聪明的优化器,会记住每个参数过去怎么动的,以便下次"踩油门"更准,这也非常耗内存。

简单说:全参数微调 = 给一辆超级跑车拆开重装。没几百万预算和十几块顶级显卡,想都别想。

Q2: 为什么SFT之后感觉LLM傻了?

A: 这不是AI变笨了,而是你把它"逼得太狠"了!

SFT(指令微调)的本质,是让AI从"博学书呆子"变成"专业顾问"。它不是让你往脑子里硬塞新知识,而是"激发"它本就有的潜力。

如果你抱着"我要把所有医学知识都灌进去"的念头,只用几千条医疗问答去训它,那就像强迫一个顶尖钢琴家,每天只弹一首《小星星》,结果他不仅忘了贝多芬,连自己手指怎么放都快不会了——这就是"灾难性遗忘"。

真正有效的SFT,数据量通常在万级(比如Alpaca的5.2万条)。它教的是""如何听话"":"当用户问‘头痛怎么办’,你应该这样一步步思考并回答。" 它激活的是模型内在的推理能力,而不是取代它的记忆库。

关键点:别想着"灌输",要相信"唤醒"。你的任务是当个好教练,不是当个填鸭式老师。

Q3: SFT指令微调数据如何构建?

A: 构建SFT数据,就像给AI写一份"完美作业范本"。

你不能随便从网上扒一堆对话,然后扔给它。必须做到:

-

格式规范:每一条数据都是一个清晰的""问题 + 答案""对。

-

输入(Input):

描述计算机主板的功能 -

输出(Output):

计算机主板是计算机中的主要电路板,它是系统的支撑。

-

-

只算答案的分:在训练时,系统只关心"答案"这部分有没有写对。输入的问题部分,哪怕你写错了,也不扣分!这就意味着,你要确保"答案"是绝对精准、专业的。

-

干净利落:删掉"嗯"、"啊"、"那个..."这些口语垃圾;去掉不相关、低质量的内容。

-

真实场景:尽量模拟真实用户会怎么问。是医生问病历?是律师问条款?是客服问退换货?

比喻:你不是在教AI背课文,而是在训练它通过"司法考试"或"医师资格证"。每一道题,都是经过专家审核的"标准答案"。

Q4: 领域模型Continue PreTrain数据选取?

A: "继续预训练"就是让AI先"读透"这个领域的教科书,再开始做题。

选什么书?别信那些花里胡哨的新闻网站!

-

首选:"书籍、技术文档、学术论文"。这些是人类智慧的结晶,信息密度高、逻辑严谨、术语准确。就像学医,你要读《格氏解剖学》,而不是刷知乎上的"偏方帖"。

-

次选:领域内权威网站、行业报告。比如金融领域可以看证监会官网公告、券商研报。

为什么不用普通网页?因为互联网上99%的内容是"噪音"——段子、广告、口水战。它们会污染模型,让它学会"废话文学",而不是专业表达。

一句话总结:想让AI成为专家?先让它当个图书馆管理员,天天泡在专业文献里。

Q5: 领域数据训练后,通用能力往往会有所下降,如何缓解模型遗忘通用能力?

A: 这就是传说中的""灾难性遗忘""——学了新东西,旧本事全忘了。

解决办法只有一个:"混合喂养"!

不要只喂它"医学问答",也要时不时给它一点"通用知识":比如"巴黎在哪个国家?"、"牛顿是谁?"、"解释一下量子力学"。

比例怎么定?

-

如果你手里的领域数据不多(比如只有几千条),那就按 1份领域数据 : 5到10份通用数据 的比例混着喂。

-

这就像一个学霸,每天学专业课的同时,还得抽空看看《十万个为什么》,保持脑子不僵化。

注意:这是为了防止AI"走火入魔"。它得记住自己是个"通才",只是在某个领域特别擅长,而不是一个只会背特定答案的复读机。

Q6: 领域模型Continue PreTrain ,如何让模型在预训练过程中就学习到更多的知识?

A: 别把预训练和微调当成两件事!你可以"一鱼两吃"。

传统做法是:先预训练(读百科)→ 再微调(做题)。但有一种更聪明的方法叫 "MIP (Multi-Task Instruction PreTraining)"。

怎么做? 把你准备用来做SFT的那些"问答对",也"打包进预训练的数据集里"!

想象一下,孩子在学语文时,老师一边让他读《红楼梦》(预训练),一边让他做"分析林黛玉性格"的阅读理解题(SFT数据)。这样一来,孩子在读书的时候,就已经在潜意识里练习怎么"回答问题"了,效率翻倍!

效果:模型在预训练阶段,就开始吸收"任务意图",不再是一个懵懂的读者,而是一个带着目标去学习的学生。

Q7: 进行SFT操作的时候,基座模型选用Chat还是Base?

A:在监督微调(SFT)实践中,选择Chat模型还是Base模型作为基座,核心是匹配实际需求,而非绝对的"优劣之分"。两者的本质差异源于训练基础——Base模型是未经对话优化的"通用语言载体",Chat模型则是在Base模型之上,经对话数据微调(SFT)和人类反馈强化(RLHF)后的"对话专用版",需结合任务、数据、资源三要素判断。

从Base模型来看,它的核心优势是"无偏向性"和"高扩展性"。这类模型(如LLaMA-7B、GPT-2)仅在海量无标注文本上学习语言规律与世界知识,没有预设的对话逻辑或输出格式约束。因此,它特别适合"垂直领域任务":比如医疗问答需要注入病历、药典知识,法律咨询需整合法条与案例,Base模型可先通过"领域数据继续预训练"夯实专业基础,再用标注数据做SFT,避免Chat模型因通用对话优化导致的"领域知识稀释"。同时,面对大数据场景(如10万+样本的代码生成),Base模型能更充分地学习领域内的特殊规则(如代码语法、数学公式格式),泛化能力更强。不过,Base模型的短板也明显:若要做对话任务,需从头构建上下文理解、多轮交互逻辑,且小数据(1万样本以下)下易过拟合,对标注成本和计算资源要求更高。

Chat模型则是"对话任务的快捷工具"。它已具备成熟的对话能力——比如理解多轮上下文、遵循指令格式、输出符合人类偏好的礼貌回复(如客服场景的"您好""请补充信息"),典型代表如ChatGLM-6B、Vicuna。这类模型的核心价值是"降本提效":若任务是通用对话(如闲聊、智能助手、企业客服),且标注数据有限(1万样本以内),用Chat模型做SFT可直接复用已有对话逻辑,无需从零设计交互框架,快速实现部署。例如,某公司做产品咨询客服,仅需用5000条历史对话微调Chat模型,就能让模型掌握产品卖点和常见问题回复,成本远低于用Base模型从头训练。但Chat模型的局限在于"领域适配性弱":若用于医疗、金融等专业领域,其通用对话的预训练偏向可能干扰专业知识输出,且难以深度注入领域数据,容易出现"答非所问"(如用Chat模型做法律问答,可能优先保证语气流畅,而非法条准确性)。

选择时需聚焦三个关键维度:一是"任务类型",垂直领域(医疗、法律、代码)优先Base,通用对话(客服、闲聊)优先Chat;二是"数据规模",大数据(10万+样本)选Base以挖掘潜力,小数据(1万以下)选Chat以避免过拟合;三是"资源成本",若算力有限(如单卡3090),可用LoRA等"参数高效微调"技术压缩成本——Base模型用LoRA仅需训练1%参数,显存占用降低至全量微调的1/10,Chat模型则可进一步减少对话逻辑的训练量。此外,还要注意"灾难性遗忘"问题:Base模型微调时不易丢失通用知识,Chat模型若仅用领域数据微调,可能忘记基础对话能力,因此需混合10%-20%的通用对话数据,平衡专业度与流畅度。

实践中,"混合策略"常是最优解:比如做医疗咨询机器人,可先用Base模型学习医学文献(继续预训练),再用"医患对话数据+少量通用对话数据"做SFT,既保证专业知识准确,又保留对话流畅性;若做电商客服,直接用Chat模型微调商品咨询数据,再补充5%的通用礼貌用语数据,快速上线。最终,无需拘泥于"非此即彼",可通过小范围实验对比——比如用相同数据分别微调两种模型,评估回复准确性、流畅度,再结合部署成本,选择最适配当前需求的方案。

Q8: 领域模型微调指令&数据输入格式要求?

A: 让AI听懂你的话,关键是"说对暗号"。

如果你用的是"Chat模型"(比如ChatGLM),它有自己的"语言密码"。你必须"严格遵循它原有的输入格式"。

比如ChatGLM的格式是:

[用户]: 你好[助手]: 你好👋!我是人工智能助手 ChatGLM-6B...

你要是擅自改成 Question: ... Answer: ...,它可能会一脸懵,觉得你在说外星语。

更重要的一条建议:"千万别用全参数微调!"

全参微调就像把原厂引擎拆了重装,很容易把模型"弄傻"。用LoRA就够了,它像一个外挂加速器,既安全又高效。

记住:尊重模型的"原生语言"。你不是在改造它,而是在引导它。

Q9: 如何进行领域模型微调领域评测集构建?

A: 训练完不能只看loss,得考试!

你需要准备"两套试卷":

-

选择题试卷(自动评测):

-

准备几百道标准化的题目,答案明确。

-

用BLEU、ROUGE等指标自动打分。

-

作用:快速筛选出明显不合格的模型,像期中考试一样高效。

-

-

开放题试卷(人工评测):

-

找几个真实领域的专家(医生、律师、工程师),让他们出一些复杂、开放的问题。

-

让AI作答,专家们打分:是否专业?逻辑清不清楚?有无错误?

-

作用:发现自动评分发现不了的"细微错误"和"人情味缺失",像毕业答辩一样严苛。

-

真相:一个模型可能在自动评测中拿满分,但回答却冷冰冰、不实用。人工评测才是最终试金石。

Q10: 领域模型词表扩增是不是有必要的?

A: 扩充词表,就像给翻译官配一本《金融黑话词典》。

-

好处:"提升解码速度"!以前模型看到"ATP"要拆成"A-T-P"三个字猜,现在直接认作一个词,反应快多了,回答更流畅。

-

坏处:对模型"智商"的提升"非常有限"。它不会因此变得更聪明,只是说话更快了。

所以,这不是"必选项",而是"体验优化项"。

如果你的领域术语极多(比如生物、法律),值得做。如果只是几个新词,完全可以忽略。

结论:不是为了让AI"知道更多",而是为了让它"说更快"。优先级不高,但做了总比没做好。

Q11: 如何训练自己的大模型?

A: 造一个中文版GPT?分两步走,稳如老狗!

-

第一阶段:二次预训练。在强大的开源模型(如LLaMA-65B或通义千问3-32B)基础上,用"海量中文专业文本"(书籍、论文、行业报告)继续训练。让模型"浸"在中文的专业语境里,熟悉术语和句式。

-

第二阶段:指令微调(SFT)加上精心构造的"问答对"和"思维链(CoT)"数据,用"LoRA"进行微调。

低成本方案:全程用LoRA!第一阶段和第二阶段都用它,省下的钱够你买半年咖啡了。

Q12: 训练中文大模型有啥经验?

A: 中文模型的秘诀,藏在链家的技术报告里:

-

第一步:扩充词表加入金融、法律等领域的专业词汇,让模型"看得懂中文行话"。

-

第二步:高质量数据是王道数据质量 > 数量!一篇《Nature》论文,胜过一万条微博热搜。

-

第三步:纯中文数据必须足够即使你有英文数据,也要保证中文占比高。加了中文数据,效果立马起飞。

-

第四步:试试"预训练+微调"一体化把SFT的问答对拼成"文章",放进预训练阶段一起训,让模型提前"预习"任务。

-

第五步:别忘了RLHF微调后,一定要用人类反馈再优化一轮(RLHF),让AI的回答更有"人味儿",不那么机械。

结论:中文大模型不是梦,只要数据好、流程对,你也能做出媲美ChatGPT的模型。

Q13: 指令微调SFT的好处?

A: 指令微调,是你站在巨人的肩膀上,跳起来摘星星。

-

省时省钱:不用从零训练1750亿参数的模型,直接在成熟的开源模型(如Llama、Qwen)上微调,成本降90%。

-

解锁能力:模型原本就会"理解语言",SFT只是教会它"怎么听话"和"怎么回答"。结果是:它能泛化到"没见过的新任务"!

-

效果爆炸:OpenAI说,微调后的GPT-3,在特定任务上的准确率能从83%飙升到95%,错误率砍半!

本质:它不是在"教知识",而是在"教方法"——教AI如何成为一个高效的助手。

Q14: 预训练和微调哪个阶段注入知识的?

A: 这是个经典的"鸡生蛋还是蛋生鸡"问题。预训练阶段注入知识的。

-

预训练阶段:是"注入广博知识"的阶段。模型从万亿字节的文本中,学会了世界是怎么运转的:什么是水?什么是民主?什么是心跳?

-

微调阶段:是"注入应用技巧"的阶段。它不教你新知识,而是教你""如何用已有的知识解决问题""。

举个栗子:

预训练:让AI读完了《中国药典》《黄帝内经》→ 它知道了"高血压"是什么。

微调:教它"当患者说‘头晕’,你应该问哪些问题?" → 它学会了诊断的流程。

前者是知识库,后者是操作手册。

Q15: 想让模型学习某个领域或行业的知识,是应该预训练还是应该微调?

A: 理想情况是:"两者结合"。

-

如果有大量专业文档(成千上万页)→ 先做"二次预训练",让模型"浸泡"在领域语境中。

-

如果有高质量问答对(数千条)→ 再做"指令微调",让它学会"如何作答"。

但如果"你只有少量问答数据"?别纠结了!只做微调也完全OK!

因为现在的模型太强了,它们早已在预训练中"偷学"了海量常识。你给它一个精准的"任务指令",它就能调动已有知识,给出惊人回答。

别迷信"必须预训练"。很多时候,微调就是最好的"轻量级注入法"。

Q16: 多轮对话任务如何微调模型?

A: 多轮对话,就像一场"接力赛",不能每次都从头开始。

ChatGLM-6B的做法很简单粗暴:

把"上一轮的所有对话历史",统统塞进下一轮的输入里。

[用户]: 我最近失眠怎么办?[助手]: 建议规律作息,避免咖啡因。[用户]: 那我吃了安眠药还睡不着呢?

→ 下一轮输入:"我最近失眠怎么办?建议规律作息...那我吃了安眠药还睡不着呢?"

缺点:轮数越多,输入越长,显存爆了怎么办?

解决方案:

-

摘要法:把历史对话浓缩成一句精华:"用户主诉:长期失眠,安眠药无效"。

-

Embedding法:把历史对话变成一串数字向量,代表"对话主题"。

-

任务型法:如果是客服机器人,直接传递"用户意图=退款"、"槽位=订单号=12345"。

核心思想:别让AI记流水账,要让它记得"重点"。

Q17: 微调后的模型出现能力劣化,灾难性遗忘是怎么回事?

A: 就像一个天才画家,突然被迫天天画"苹果",结果他忘了怎么画人。

灾难性遗忘:模型学会了新技能(比如纠错拼写),却忘记了旧本领(比如回答"失眠怎么办")。

根本原因:

-

学习率太高,模型"用力过猛",把旧知识覆盖了。

-

新数据太少,模型以为"这才是全部世界"。

怎么治?

-

降低学习率:别用太大(建议 ≤ 2e-5)。

-

混合通用数据:1份新数据,配5~10份通用问答。

-

用LoRA:只改一点点,伤不到根基。

作者亲测:他自己微调时没遇到这个问题,因为他用了"合适的参数"。所以,不是AI不行,是你调参太莽!

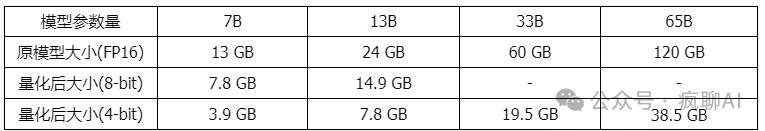

Q18: 微调模型需要多大显存?

A: 各参数量的大模型微调参数量需求:

真相:你不需要豪华配置,只要你用对了工具(如Llama Factory on line),几百块的GPU费用也能微调大模型。

Q19: 大模型LLM进行SFT操作的时候在学习什么?

A: SFT不是在"背答案",而是在"学套路"。

它学的是:

-

结构:什么样的问题,对应什么样的回答格式?

-

风格:该用正式语气,还是亲切口吻?

-

推理链:怎么一步步推导出答案?(比如:症状→检查→诊断→建议)

对比预训练:

-

预训练:猜下一个词 → "今天天气真______"

-

SFT:根据问题生成完整答案 → "请解释量子纠缠"

最关键的区别:SFT在计算损失时,"只关注"答案"部分",问题部分完全忽略。这意味着,模型学到的不是"匹配上下文",而是"完成指令"。

本质:SFT是让AI从"语言预测器",进化成"任务执行者"。

Q20: 预训练和SFT操作有什么不同?

A: 用一句话区分:

预训练是"猜词游戏",SFT是"答题考试"。

例子:

输入:描述计算机主板的功能

-

预训练:模型看到这句话,会试图预测下一个词,比如"是"、"主要"、"电路板"。损失计算:整句话每个词都要算误差。

-

SFT:你构建的样本是:

输入:描述计算机主板的功能输出:计算机主板是计算机中的主要电路板。它是系统的支撑 -

损失计算:"只算输出部分的误差"!输入部分是"考题",不扣分。

结果:SFT让模型学会""根据提示,生成指定内容"",这才是对话AI的核心能力。

Q21: 样本量规模增大,训练出现OOM错

A: OOM = Out of Memory,意思是"内存炸了"。

当你把数据从10万条猛增到300万条,GPU直接"罢工"。

解决方案:

-

数据分片加载:别一次性把300万条全塞进内存。把数据切成小块,每次只加载一块,训练完再换下一块。

-

动态加载:每个epoch(一轮训练)前,随机打乱数据顺序,只加载当前需要的部分。

-

向量化缓存:把处理好的数据(如tokenized)提前存好,下次直接读,省时间。

核心思想:"别贪心,一口吃不成胖子"。用"分批吃"的方式,让训练稳定运行。

Q22: 大模型LLM进行SFT如何对样本进行优化?

A: 优化样本,就是给AI喂"精致料理",而不是"剩饭剩菜"。

具体操作:

-

删废话:去掉"嗯"、"啊"、"那个..."等语气词。

-

删垃圾:删除涉及"转人工"、"投诉"等不相关或敏感内容。

-

加标签:给用户加特征标签,如年龄、性别、地域,让模型更懂"谁在问"。

-

左截断:多轮对话,只保留最近的N轮,防止超长输入。

-

多样化Prompt:同一个问题,用10种不同说法写出来,让模型更鲁棒。

目标:让每一条数据都像一颗钻石,剔除杂质,光芒四射。

Q23: 模型参数迭代实验

A: 这是"科学实验精神"的体现。

你想知道:历史对话越长越好吗?

于是你训练两个模型:

-

模型A:最多保留512个字符的历史

-

模型B:最多保留1024个字符的历史

然后对比:

-

Loss下降速度?

-

BLEU分数?

-

人工评估:哪个回答更自然?

结果:1024长度表现更好!说明模型能利用更长上下文。

启示:别凭直觉调参,用实验说话。每一次"变量控制",都在帮你离最优模型更近一步。

Q24: 微调大模型的一些建议

A: 这是实战经验的"武功秘籍":

-

模型结构:用Causal Decoder(因果解码器)+ LM(语言模型)架构,天生具备"零样本"能力。

-

归一化:用 "Pre-RMSNorm",效果优于传统LayerNorm。

-

激活函数:用 "GeGLU 或 SwiGLU",比ReLU更强。

-

嵌入层:"不要"在embedding后加LayerNorm,会破坏性能!

-

位置编码:用 "RoPE"(旋转位置编码),效果最好。

-

去偏置:去掉dense层和LayerNorm里的bias项,提升稳定性。

-

优化器:用 "AdamW",权重衰减设0.1。

-

学习率:先线性增长(warmup),再余弦衰减到最大值的10%。

-

梯度裁剪:设为1.0,防止梯度爆炸。

-

精度:用 "bfloat16",比float16更稳定。

-

崩溃挽救:训练中断?找一个"loss scale > 0"且"梯度波动小"的checkpoint,从那里重启。

一句话:细节决定成败。你用的每一个小技巧,都在悄悄提升模型的上限。

Q25: 微调大模型时,如果 batch size设置太小会出现什么问题?

A: Batch Size太小,就像一个人在暴风雪里划独木舟。

-

问题:每次更新方向不稳定,充满"噪声"。

-

后果:模型一会儿往东,一会儿往西,训练过程剧烈震荡,收敛慢,容易卡住。

-

比喻:你让一个新手司机,每次只看前方1米路开车,他肯定晃得厉害。

解决:适当加大batch size,让梯度更"平均",方向更稳定。

Q26: 微调大模型时,如果 batch size设置太大会出现什么问题?

A: Batch Size太大,就像用导弹轰蚊子——费劲,还不一定有效。

-

问题:大批次的梯度几乎等于"真实梯度",已经非常精确了。

-

后果:

-

增加batch size,"无法减少训练步数"。

-

每一步要处理的数据翻倍,"计算量(FLOPS)翻倍",训练时间反而更长。

-

可能导致模型收敛到"次优解",性能反而下降。

-

Google的经验:当batch size超过临界点,性能不升反降。"不是越大越好,而是"刚刚好"最好"。

Q27: 微调大模型时, batch size如何设置问题?

A: 找那个"黄金平衡点"。

OpenAI的研究指出:

-

更大的batch size,允许你使用更大的学习率。

-

但存在一个"收益递减点":再往上加,效率不增反降。

-

最佳策略:"动态调整"。比如从32K tokens开始,逐步增加到3.2M。

关键公式(简化版):

最优学习率 ∝ √(Batch Size)

意思是:"batch size翻倍,学习率可以开到√2倍"。

实操建议:先用中等大小(如128),观察loss曲线。如果震荡大,加大batch;如果太慢,尝试提高学习率。

Q28: 微调大模型时,优化器如何?

A: AdamW是目前的"王者",但别局限于此。

-

主流:"AdamW"(带权重衰减的Adam),稳定、高效,是标配。

-

进阶:可以试试 "Sophia"。它不靠"梯度方差"来调整步伐,而是用"梯度曲率"——更聪明地判断该踩多深油门。

-

原理:它像是一个老司机,能感知路面坡度,而不是只看车速。

建议:新人用AdamW,高手可探索Sophia等新锐优化器,说不定有惊喜。

Q29: 哪些因素会影响内存使用?

A: 显存消耗是"四大天王"联手造成的:

-

模型大小:参数越多,占内存越大。

-

批量大小(Batch Size):一次处理越多样本,内存越满。

-

LoRA参数数量:LoRA虽然省,但也不是零消耗。

-

序列长度(Sequence Length):输入/输出越长,占用内存越高。

救命技巧:缩短输入长度,能瞬间释放大量显存!比如把max_length从4096降到2048。

Q30: 进行领域大模型预训练应用哪些数据集比较好?

A: 数据质量,决定模型天花板。

首选:"书籍、学术论文、技术标准"

→ 信息密度高、逻辑严密、术语规范,像"专业教材"。

次选:权威行业网站、政府报告、专利文件

→ 质量虽略逊于论文,但覆盖广、时效性强。

慎用:新闻、社交媒体、论坛帖子

→ 噪音太多,易污染模型。

一句话:别指望用抖音热榜训练出一个诺贝尔奖得主。

Q31: 用于大模型微调的数据集如何构建?

A: 重申一遍:"数据质量 > 数量"!

构建建议:

-

专业性:答案必须来自领域专家。

-

多样性:涵盖各种问题类型、难度、表达方式。

-

纯净性:清洗无关词、错别字、敏感内容。

-

一致性:统一输入输出格式。

-

平衡性:多个子任务的数据量均衡,别让一个任务"压垮"其他任务。

记住:你不是在收集数据,你是在"铸造一把钥匙",用来打开AI的潜能之门。

Q32.1: 大模型训练loss突刺是什么?

A: Loss突刺,就像你家的温度计突然从25°C飙到50°C,然后又回落。

在训练过程中,Loss(损失值)本来平平稳稳地下降,突然某一步,它"啪!"地冲上天,形成一个尖峰。

后果:

-

模型可能需要很久才能恢复;

-

更糟的是,它再也回不去了——"训练彻底失败",模型再也收敛不了。

形象比喻:你正在爬山,突然脚下一滑,摔进了悬崖,再也没找到路回来。

Q32.2: 为什么大模型训练会出现loss突刺?

A: 罪魁祸首,是"Adam优化器"的"心理疾病"。

理论解释有点烧脑,但我们可以这样理解:

-

Adam优化器像个聪明管家,它会根据"过去的梯度"来决定下一步怎么走。

-

但在大模型里,"浅层网络"(靠近输入)长时间不动,而"深层网络"(靠近输出)一直在动。

-

某一天,浅层网络突然"苏醒",剧烈变动。

-

它和深层网络的状态严重脱节 → 整个系统陷入混乱 → Loss暴涨!

三大诱因:

-

浅层参数长时间未更新(梯度接近0)。

-

学习率太小 → 梯度更新太保守。

-

e值(Adam中的一个小常数)过大 → 导致优化器"误判"。

本质:不是数据不好,是优化器"内部失衡"了。

Q32.3: 大模型训练loss突刺如何解决?

A: 四招救命法:

-

减小学习率:最简单,治标不治本。

-

减小e值:把Adam中的epsilon参数调小,让优化器更敏感。

-

缩放浅层梯度:在GLM-130B中用的方法——"把浅层网络的梯度乘以一个小系数(如0.1)",让它"轻一点动"。

-

更换数据:一旦检测到突刺,立即换一批干净数据继续训练(PaLM用的方法)。

终极建议:"优先用"缩放浅层梯度""。这是目前最有效、最优雅的解决方案。

顺便提醒:fp16混合训练时,如果upscale设太小,会导致梯度下溢,也会加剧这个问题!记得调高它。

✅ 总结:微调大模型的终极心法

|

阶段 |

核心行动 |

比喻 |

|

选基座 |

数据少选Chat,数据多选Base |

买现成宝马 vs 从零造车 |

|

数据为王 |

质量>数量,格式规范 |

给AI喂钻石,不是沙子 |

|

用LoRA |

一律首选LoRA! |

给跑车加涡轮,不换引擎 |

|

防遗忘 |

混合通用数据(1:5~1:10) |

学医不忘背《新华字典》 |

|

训前准备 |

扩充词表、清理数据、设计Prompt |

洗澡、穿正装、带笔记本 |

|

训练过程 |

用AdamW,学习率≤2e-5,梯度裁剪1.0 |

开车不猛踩油门,不急转弯 |

|

监控异常 |

留意loss突刺,用梯度缩放 |

车上有仪表盘,有预警灯 |

|

评估验证 |

自动+人工双保险 |

期中考试+毕业答辩 |

|

终极目标 |

不是灌输知识,是唤醒能力 |

教会学生思考,不是背答案 |

你不需要成为AI科学家,只需要成为一位"聪明的驯兽师"。

掌握这套方法,你就能驯服庞然大物,让它为你所用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)