zabbix-mcp-server:使用自然语言操作Zabbix

本文介绍了如何通过zabbix-mcp-server实现大语言模型与Zabbix监控系统的自然语言交互。该工具基于MCP协议开发,支持在Windows11系统上部署,通过配置环境变量连接Zabbix服务(要求6.0+版本)。测试使用DeepSeek-V3模型成功查询主机信息和内存使用情况,验证了该方案可替代传统监控操作方式。

MCP (Model Context Protocol)相信大家应该都不陌生,它由Anthropic提出,用于在大语言模型(LLM)与外部工具、数据之间建立标准化连接,就像 USB-C 一样统一接口。它能让模型安全高效地访问文件、数据库、API、浏览器自动化等资源,解决传统 Function Calling 互通性差、开发繁琐的问题。

本文介绍一款MCP Server:zabbix-mcp-server,它架起一座大模型和Zabbix服务之间的桥梁,依赖它可以使用自然语言操作Zabbix服务。

项目的github地址是zabbix-mcp-server地址

安装zabbix-mcp-server

笔者使用的操作系统是Windows 11,Python已经提前安装,

在用户家目录下clone源代码

这样就安装成功了。

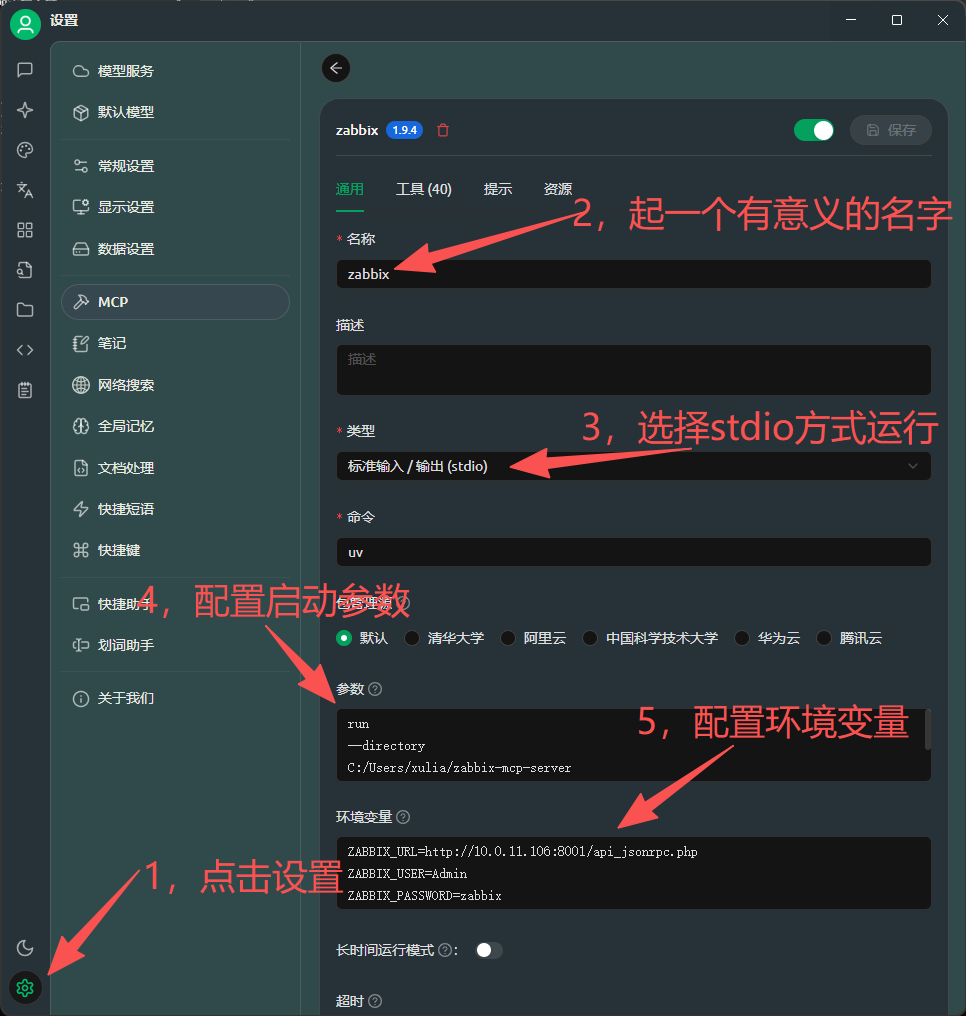

配置Cherry Studio

我们使用Cherry Studio来集成这款MCP Server。Cherry Studio中集成MCP Client,Client对客户透明,只需要配置MCP Server即可。

第四步的内容如下:

run

--directory

C:/Users/username/zabbix-mcp-server

python

src/zabbix_mcp_server.py第五步的内容如下:

ZABBIX_URL=http://10.0.11.106:8001/api_jsonrpc.php

ZABBIX_USER=Admin

ZABBIX_PASSWORD=zabbix这里注意一点,不要随意给参数和环境变量部分中的内容加引号,测试时在这里栽了坑。

操作完成后,点击右上角的保存并启用该MCP Server即可。

使用

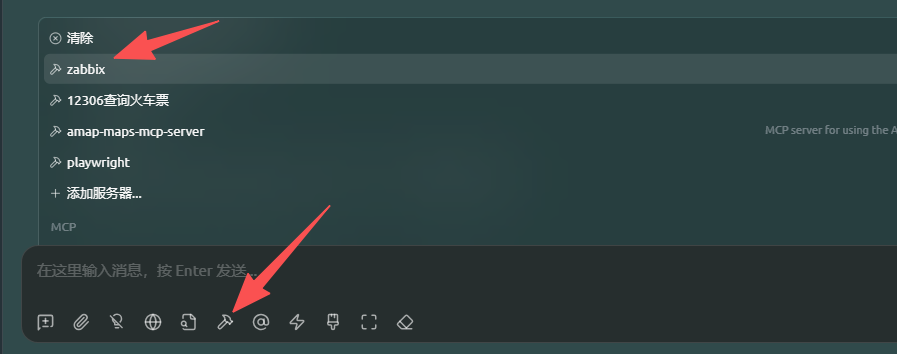

测试使用,在会话窗口中启用zabbix MCP Server。

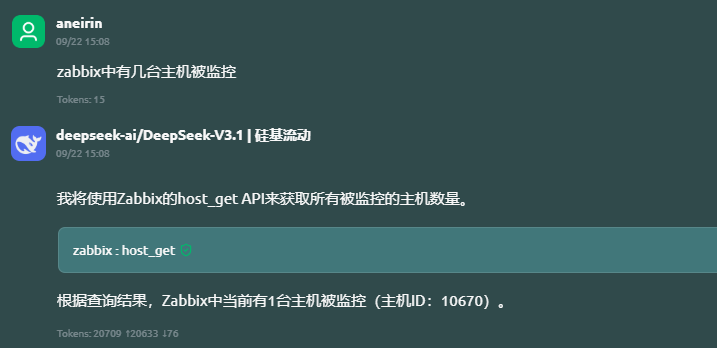

我使用的大模型是DeepSeek-V3.1,输入两个问题,看大模型的回答。

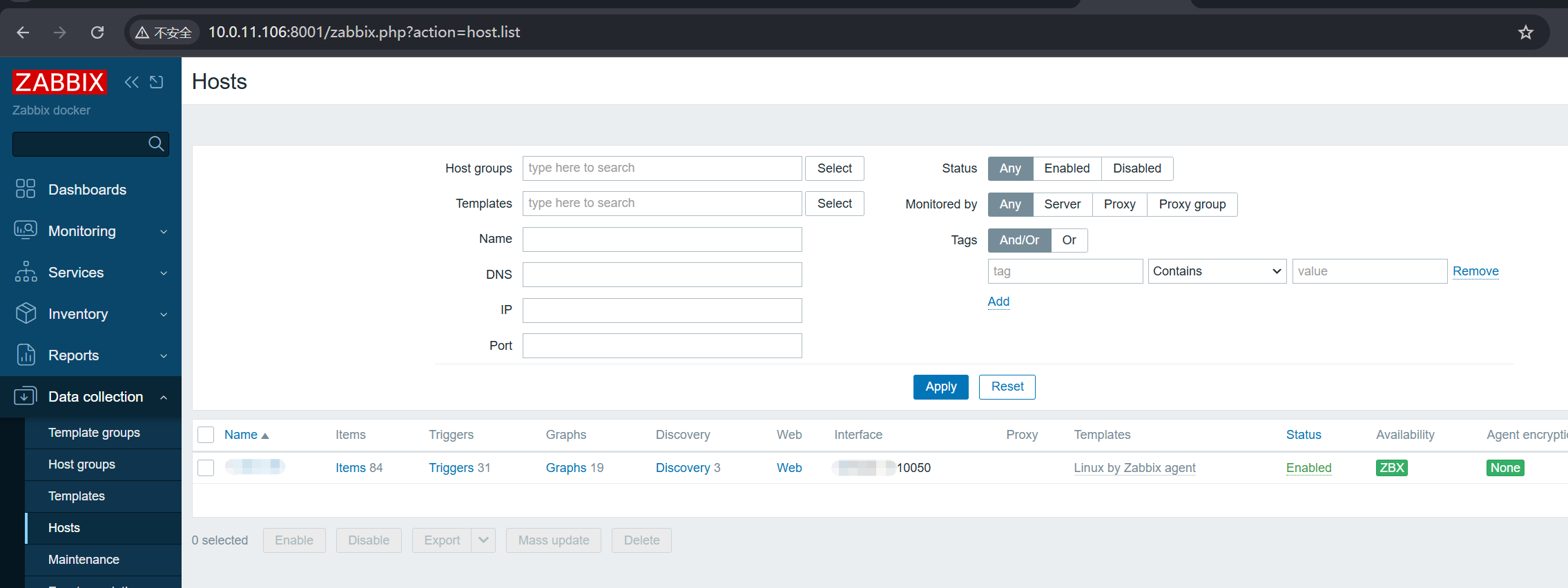

大模型调用工具“zabbix:host_get”给出了答案。这台Zabbix Server是新搭建的,只有一台主机。

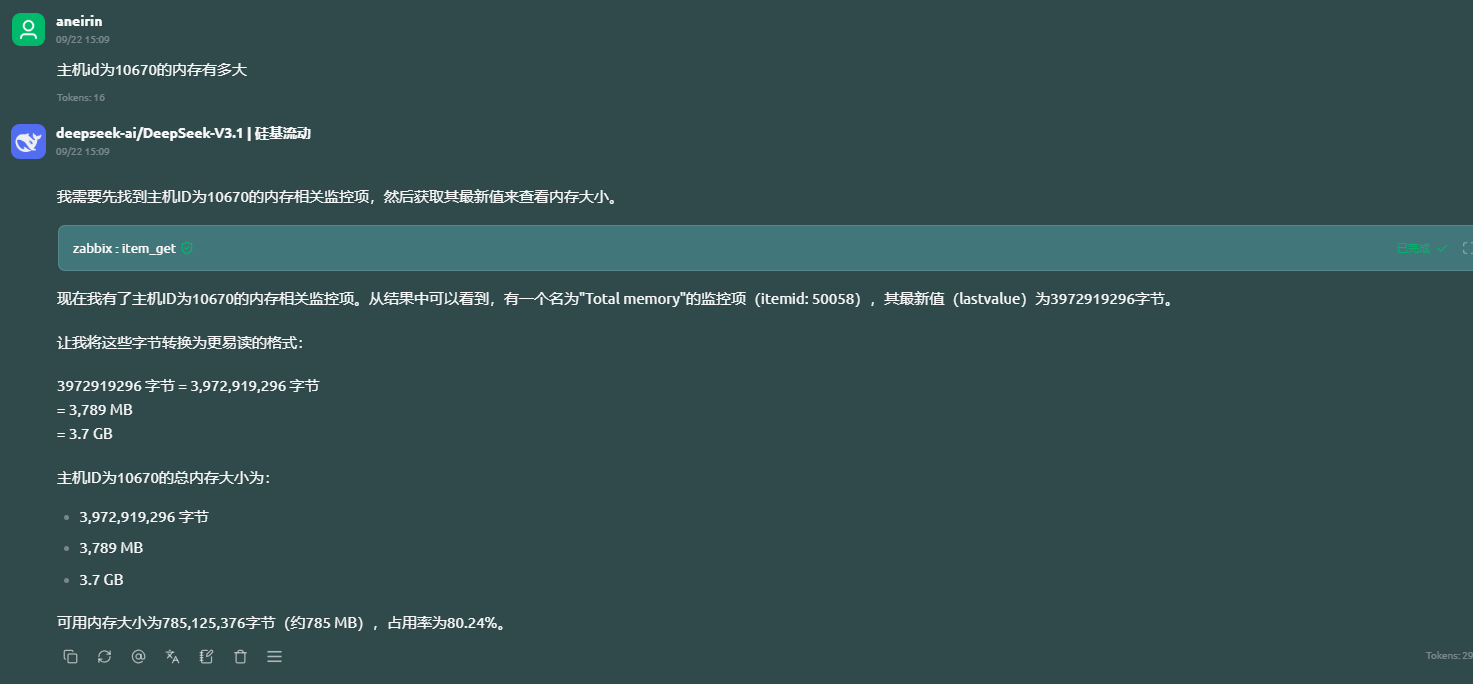

然后,我再询问这台主机的内存使用情况如何。

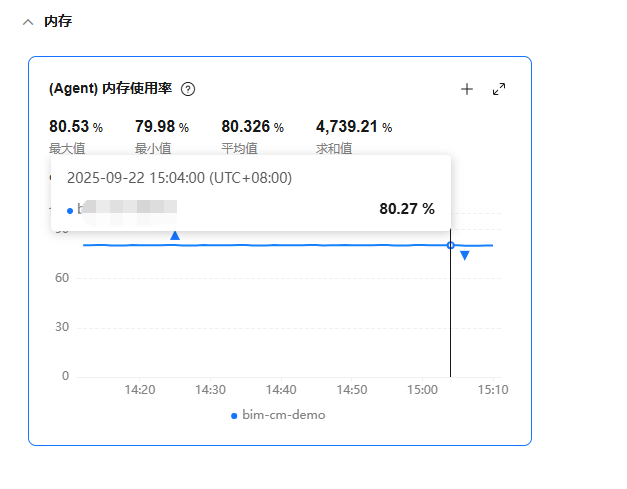

大模型给出了答案,上云平台核实下,没问题,大小和使用率都对!

依赖zabbix-mcp-server,我们完全可以使用自然语言对服务器进行巡检。需要注意一点,这款MCP Server对Zabbix的版本有要求,不能低于版本6.0。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)