Python实习模拟面试之大模型调优核心:深入解析提示词微调(Prompt-Tuning)技术

本质:在词向量空间学习可优化的“软提示”,引导模型行为。优势:参数极省、部署简单、任务隔离。局限:对提示长度敏感,初始性能较弱。适用场景:快速原型验证、多任务切换、资源受限环境。作为Python开发者,掌握Prompt-Tuning不仅是技术深度的体现,更是理解“如何高效利用大模型”这一核心命题的关键。在AI工程化道路上,这类参数高效方法将越来越重要。

关键词: Prompt-Tuning, 大模型微调, 参数高效微调, Python, 模拟面试, Soft Prompt, NLP

在大语言模型(LLM)广泛应用的今天,如何以低成本、高效率的方式让通用模型适应特定任务,已成为企业关注的核心问题。传统的全参数微调(Full Fine-tuning)虽然有效,但资源消耗巨大,不适合大多数场景。

而提示词微调(Prompt-Tuning) 作为一种参数高效微调(Parameter-Efficient Fine-Tuning, PEFT) 技术,仅通过优化少量“软提示”(Soft Prompts)即可实现接近全微调的性能,成为工业界和学术界的热点。

本文通过一场深度模拟面试,带你从基础概念到技术实现,全面掌握Prompt-Tuning的核心原理与实战技巧,直面面试官的连环追问,展现你在大模型调优领域的专业能力。

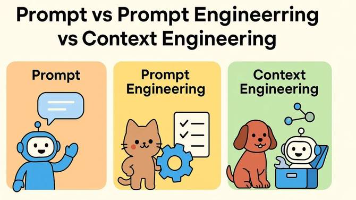

面试官提问:你在项目中是如何提升大模型在特定任务上的表现的?除了Prompt Engineering,还有别的方法吗?

我回答:

有的,面试官。除了传统的提示工程(Prompt Engineering)——也就是手动设计高质量的文本提示(Hard Prompt),我还深入研究并应用了提示词微调(Prompt-Tuning) 技术。

Prompt Engineering虽然简单直接,但存在明显局限:

- 依赖人工经验,难以系统化优化

- 提示词长度有限,表达能力受限

- 对模型输入敏感,鲁棒性差

而Prompt-Tuning是一种可学习的提示词优化方法。它的核心思想是:不再使用固定的文本提示,而是引入一组可训练的连续向量(即“软提示”),通过反向传播优化这些向量,使模型在特定任务上表现更好。

这种方法属于参数高效微调(PEFT) 的范畴,相比全参数微调,它只更新极小部分参数,成本低、速度快,非常适合资源有限的实习项目或企业快速迭代场景。

面试官追问:你提到“软提示”是连续向量,那它和普通的文本提示(Token)有什么区别?模型是怎么处理它的?

我回答:

非常好的问题,这涉及到Prompt-Tuning的技术本质。

我们先回顾一下传统文本提示(Hard Prompt)的流程:

- 文本 → 分词器(Tokenizer) → Token IDs(离散整数)

- Token IDs → 词嵌入层(Embedding Layer) → 词向量(Continuous Vectors)

- 词向量 → 输入模型

而软提示(Soft Prompt) 的不同在于:

- 它跳过了分词阶段,直接在词向量空间中定义一组可学习的向量。

- 这些向量不对应任何实际Token,而是作为“虚拟Token”参与模型计算。

具体实现流程如下:

- 初始化:随机初始化一组向量 P∈Rn×dP \in \mathbb{R}^{n \times d}P∈Rn×d,其中 nnn 是提示词长度,ddd 是模型的隐藏层维度(如768)。

- 拼接:将软提示向量 PPP 与输入文本的词向量 E(x)E(x)E(x) 拼接,形成新的输入:

Input=[P;E(x)] \text{Input} = [P; E(x)] Input=[P;E(x)] - 前向传播:模型正常计算损失。

- 反向传播:仅更新软提示 PPP 的参数,冻结整个预训练模型的参数。

- 优化:通过梯度下降不断调整 PPP,直到任务性能收敛。

这样,软提示就“学会”了如何最好地引导模型完成目标任务,而无需改动庞大的预训练模型。

面试官追问:Prompt-Tuning和LoRA、Adapter这些PEFT方法相比,有什么优缺点?

我回答:

这是个非常专业的对比问题。我们从参数量、灵活性、性能、部署几个维度来分析:

| 方法 | 参数位置 | 可训练参数量 | 优点 | 缺点 |

|---|---|---|---|---|

| Prompt-Tuning | 输入层(Input Embedding) | 极少(仅软提示) | - 成本最低 - 无需修改模型结构 - 任务隔离性好(不同任务用不同软提示) |

- 对提示长度敏感 - 初始性能较差 - 仅适用于Transformer类模型 |

| LoRA | 注意力层(Attention Matrices) | 少(约0.1%~1%) | - 性能接近全微调 - 适用于各种任务 - 支持合并,部署方便 |

- 需修改模型结构 - 训练稍复杂 |

| Adapter | 每层后插入小网络 | 中等(约3%~5%) | - 任务适应性强 - 可插拔设计 |

- 增加推理延迟 - 参数量相对较大 |

总结:

- 如果追求极致轻量化和快速实验,Prompt-Tuning是首选。

- 如果追求高性能和通用性,LoRA是更优选择。

- 在我们的项目中,我们先用Prompt-Tuning快速验证任务可行性,再用LoRA进行最终优化。

面试官追问:你能写一段代码,演示如何用Hugging Face实现Prompt-Tuning吗?

我回答:

当然可以。以下是一个使用 transformers 和 peft 库实现Prompt-Tuning的简化示例:

from transformers import AutoModelForSequenceClassification, AutoTokenizer

from peft import PromptTuningConfig, get_peft_model

import torch

# 1. 加载预训练模型和分词器

model_name = "bert-base-uncased"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForSequenceClassification.from_pretrained(model_name, num_labels=2)

# 2. 配置Prompt-Tuning

config = PromptTuningConfig(

task_type="SEQ_CLS", # 任务类型:序列分类

prompt_tuning_init="RANDOM", # 初始化方式

num_virtual_tokens=20, # 软提示长度

tokenizer_name_or_path=model_name

)

# 3. 包装模型,注入软提示

model = get_peft_model(model, config)

# 4. 查看可训练参数

model.print_trainable_parameters()

# 输出: trainable params: 15,360 || all params: 108,604,416 || trainable%: 0.0141

# 5. 训练流程(伪代码)

for batch in dataloader:

inputs = tokenizer(batch["text"], return_tensors="pt", padding=True, truncation=True)

labels = torch.tensor(batch["labels"])

# 前向传播

outputs = model(**inputs, labels=labels)

loss = outputs.loss

# 反向传播(只更新软提示)

loss.backward()

optimizer.step()

optimizer.zero_grad()

关键点:

num_virtual_tokens=20定义了软提示的长度。get_peft_model()自动在输入层注入可学习的嵌入向量。- 训练时,只有这20个向量的参数会被更新,其余1亿+参数完全冻结。

面试官追问:在实际应用中,Prompt-Tuning有没有什么挑战?你是如何解决的?

我回答:

有的,面试官。Prompt-Tuning虽然轻量,但也面临几个实际挑战:

挑战1:软提示长度(Prompt Length)的选择

- 问题:太短表达能力不足,太长增加训练难度且可能降低性能。

- 解决方案:通过实验确定最优长度。我们发现对于文本分类任务,10~20个虚拟Token效果最好。

挑战2:初始化方式影响收敛

- 问题:随机初始化可能导致训练不稳定。

- 解决方案:使用

prompt_tuning_init="TEXT",用实际文本(如任务描述)的嵌入向量初始化软提示,加速收敛。

挑战3:任务间的干扰(Task Interference)

- 问题:多个任务共享同一模型时,软提示可能相互干扰。

- 解决方案:为每个任务保存独立的软提示权重,推理时动态加载。

挑战4:对小数据集敏感

- 问题:在极小数据集上容易过拟合。

- 解决方案:结合数据增强或使用正则化(如Dropout在软提示层)。

总结:Prompt-Tuning——大模型时代的“轻量化调优”利器

通过这场模拟面试,我们系统梳理了Prompt-Tuning的核心知识体系:

- 本质:在词向量空间学习可优化的“软提示”,引导模型行为。

- 优势:参数极省、部署简单、任务隔离。

- 局限:对提示长度敏感,初始性能较弱。

- 适用场景:快速原型验证、多任务切换、资源受限环境。

作为Python开发者,掌握Prompt-Tuning不仅是技术深度的体现,更是理解“如何高效利用大模型”这一核心命题的关键。在AI工程化道路上,这类参数高效方法将越来越重要。

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)