云平台一键部署【embeddinggemma-300m】【RAG】高性能嵌入模型以及知识检索

RAG(检索增强生成)技术结合信息检索与语言模型,通过外部知识库检索增强AI的知识处理能力。趋动云推出基于【embeddinggemma-300m】嵌入模型和【qwen3-14b】生成模型的简易RAG项目示例,支持多语言、量化优化等功能。用户可一键部署体验,上传本地文档即可实现智能问答。项目提供快速开发环境,完成使用后需及时关闭避免额外费用。新用户可参与限时活动获取算力金奖励。

RAG(检索增强生成)是一种结合了信息检索技术与语言生成模型的人工智能技术。该技术通过从外部知识库中检索相关信息,并将其作为提示(Prompt)输入给大型语言模型(LLMs),以增强模型处理知识密集型任务的能力,主要包括文本向量化,向量化检索,大语言模型根据检索结果生成。

趋动云推出了基于【embeddinggemma-300m】文本嵌入模型和【qwen3-14b】文本生成模型的简易知识检索增强生成(RAG)项目示例。该示例为大家快速搭建定制化RAG系统提供了坚实基础,可在此基础上进一步扩展与优化,构建更完善、更专业的知识检索与生成应用。

模型关键特性

- 模型规模与上下文长度

参数量约为 308M,支持最长 2K tokens 的上下文窗口,默认输出向量维度为 768。 - 多语言支持

训练语料涵盖 100 多种语言。 - 嵌套

支持将 768 维的嵌入向量截断为 512/256/128 等更短维度,兼顾效率与效果。 - 工程优化

支持量化感知训练与设备端优化,量化后模型大小可控制在 200MB 以内。

官方链接:https://ai.google.dev/gemma/docs/embeddinggemma?hl=zh-cn

【embeddinggemma-300m】模型已经在趋动云『社区项目』上线,无需自己创建环境、下载模型,一键即可快速部署,快来体验 【embeddinggemma-300m】带来的精彩体验吧!

项目入口

视频教程

启动开发环境

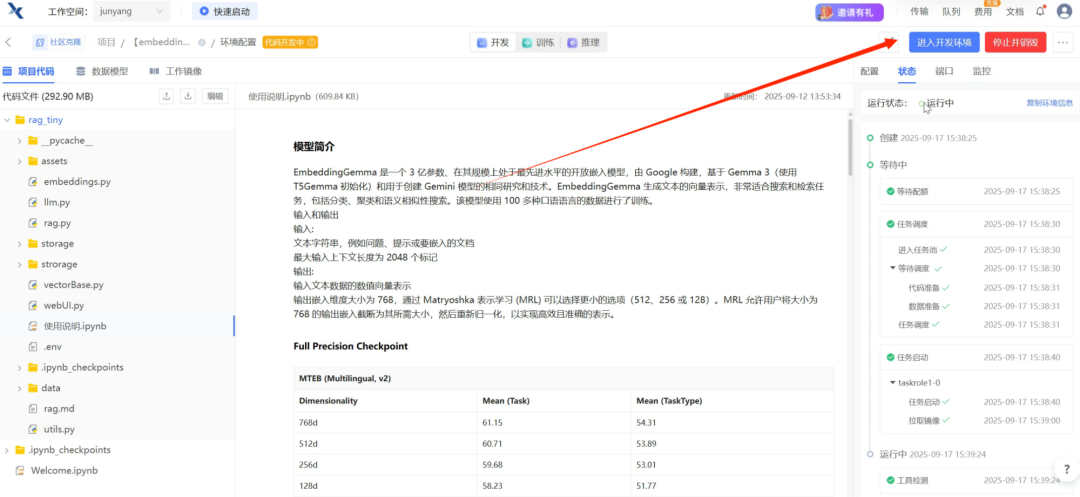

进入【embeddinggemma-300m】项目主页中,点击运行一下,将项目一键克隆至工作空间,『社区项目』推荐适用的算力规格,可以直接立即运行,省去个人下载数据、模型和计算算力的大量准备时间。

配置完成,点击进入开发环境,根据主页项目介绍进行部署。

使用方法

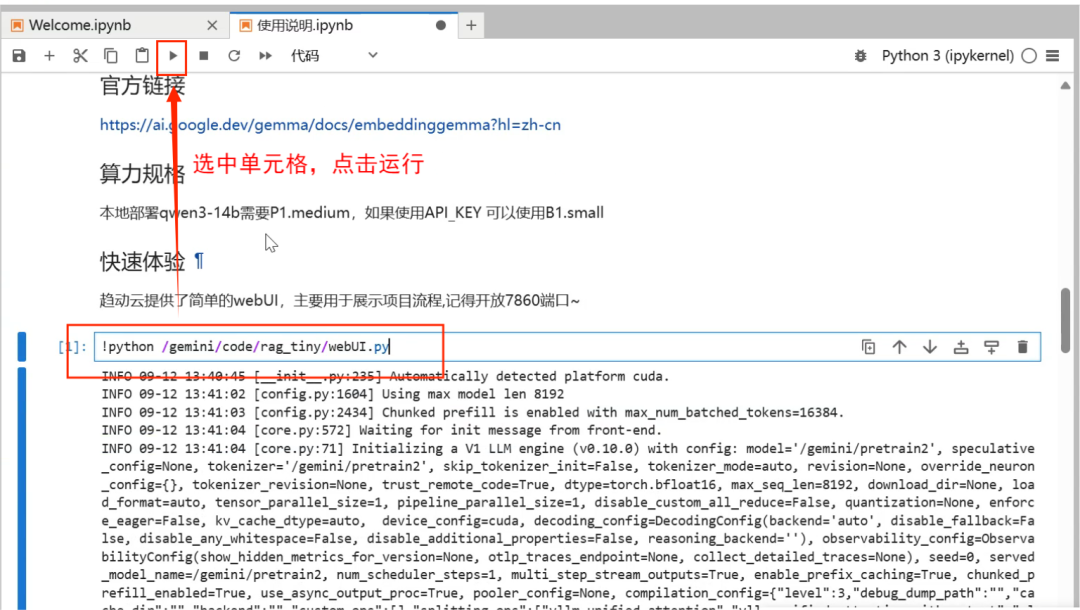

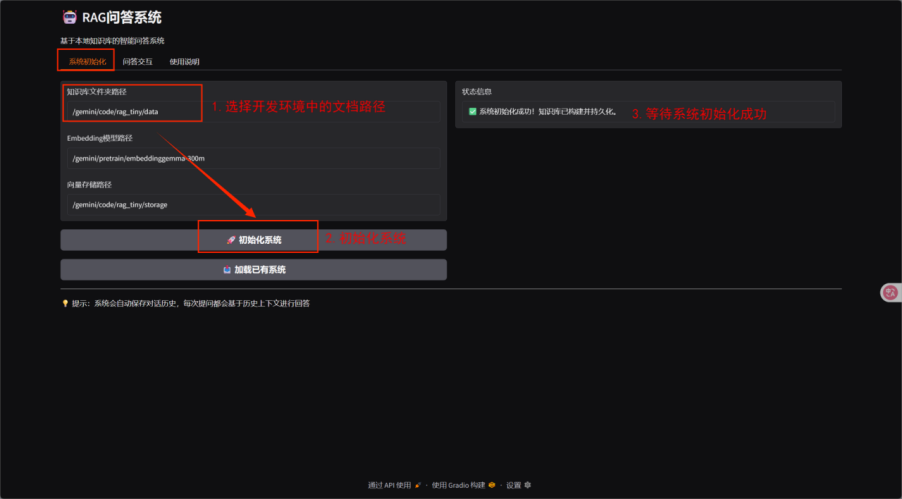

在gemini/code/rag_tiny中找到使用说明,选中使用说明单元格,点击运行。

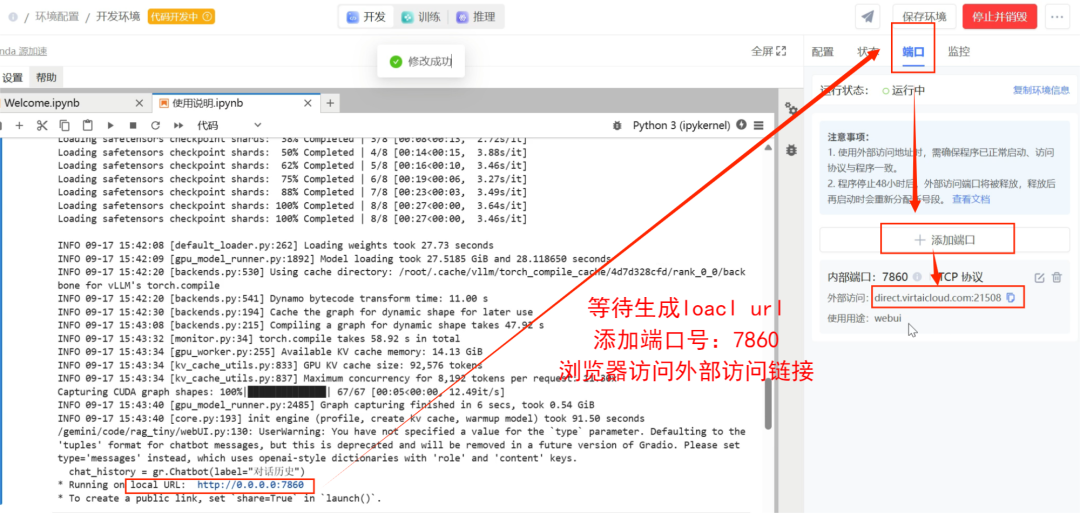

等待生成local URL,右侧添加端口7860。

使用前,将本地文档上传至开发环境,并在系统配置中指定这些文档所在路径(该路径必须是一个文件夹)。

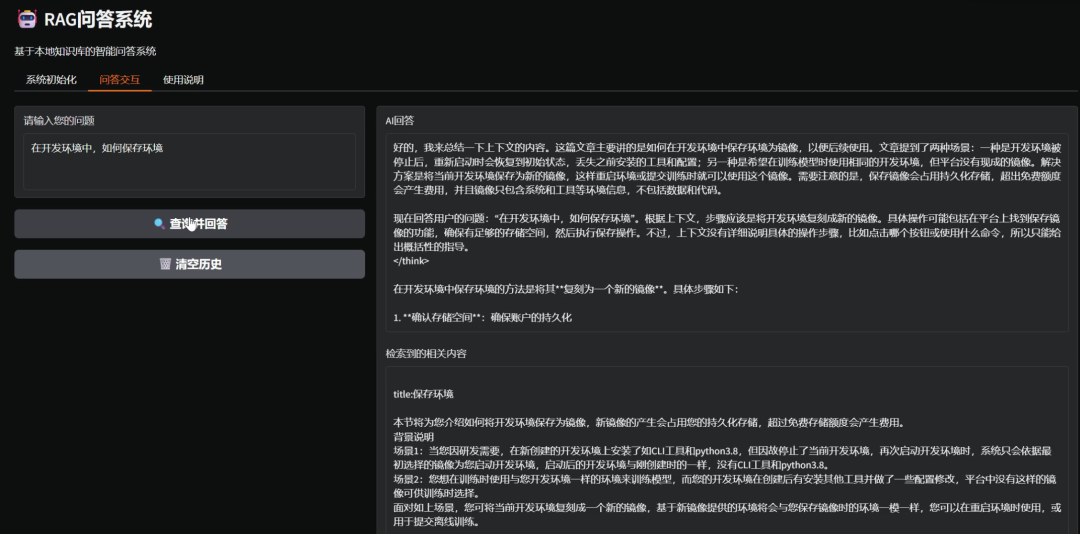

输入问题,点击“查询并回答”,即可完成智能问答。

示例展示

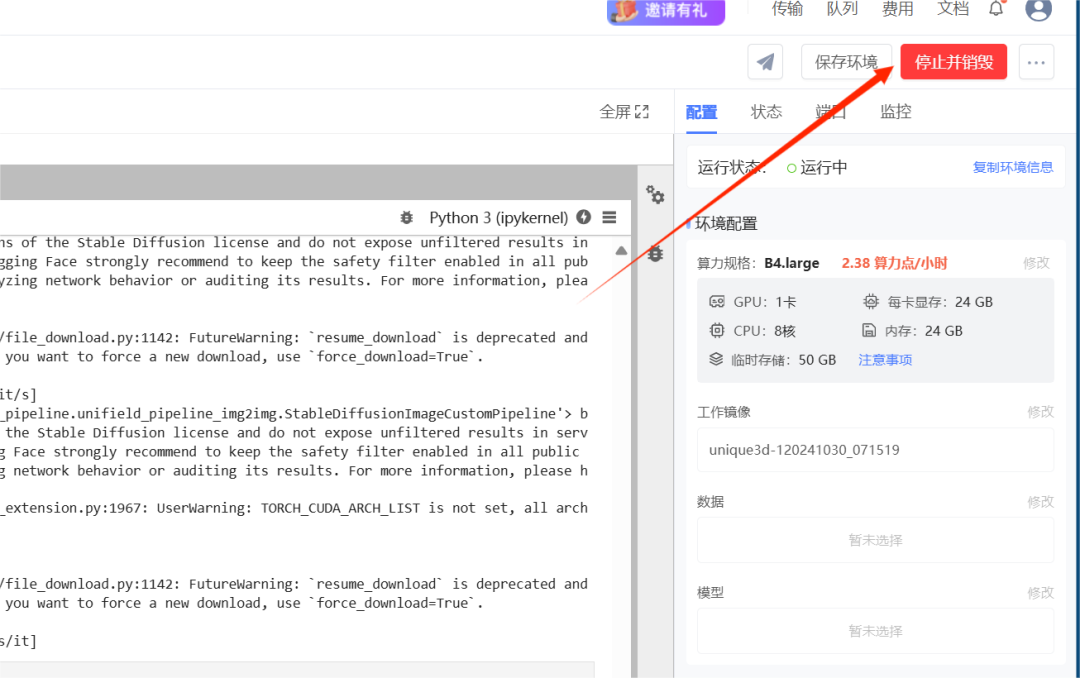

➫温馨提示: 完成项目后,记得及时关闭开发环境,以免继续产生费用!

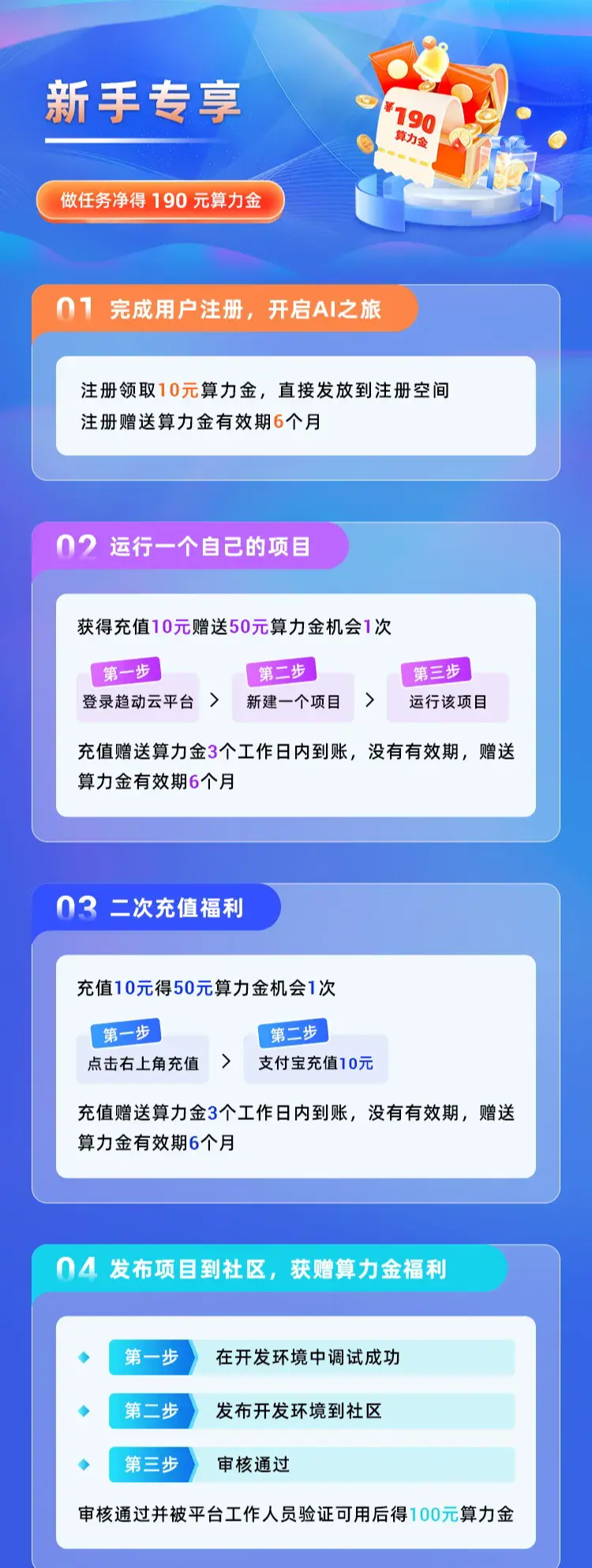

趋动云新客专享活动(限时有效)做任务净得190元算力金,点击下方👇👇👇海报了解活动详情,完成任务的小伙伴添加下方小助手提供完成截图领取赠送算力金。

智汇全球,趋动未来

『社区项目』汇聚全球智慧,是促进技术交流的宝贵平台,期待每一位AI爱好者体验一键部署功能的强大魅力。

同时,我们也热切盼望每一位码友加入,分享您的精品作品,共筑这个充满活力与创新的技术乐园。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)