【GitHub项目推荐--Firecrawl:AI就绪的Web数据API完全指南】

Firecrawl 是一个强大的Web数据提取API服务,专门设计用于将整个网站转换为AI就绪的markdown格式或结构化数据。它通过先进的爬取、抓取和数据提取能力,为开发者和AI应用提供高质量的Web内容处理解决方案。🔗 GitHub地址🚀 核心价值:Web数据提取 · AI就绪格式 · 智能爬取 · 开源核心项目背景:AI数据需求:解决AI应用需要高质量、结构化Web数

简介

Firecrawl 是一个强大的Web数据提取API服务,专门设计用于将整个网站转换为AI就绪的markdown格式或结构化数据。它通过先进的爬取、抓取和数据提取能力,为开发者和AI应用提供高质量的Web内容处理解决方案。

🔗 GitHub地址:

https://github.com/firecrawl/firecrawl

🚀 核心价值:

Web数据提取 · AI就绪格式 · 智能爬取 · 开源核心

项目背景:

-

AI数据需求:解决AI应用需要高质量、结构化Web数据的挑战

-

技术复杂性:简化Web爬取和数据提取的复杂性

-

开源精神:AGPL-3.0开源许可,促进透明和社区贡献

-

企业级服务:提供托管云服务 alongside 开源版本

技术特色:

-

🤖 AI集成:智能内容提取和结构化数据转换

-

🌐 全面覆盖:支持整个网站爬取和单个页面抓取

-

⚡ 高性能:快速、可靠的Web数据提取

-

🔧 开发者友好:简洁API和多种SDK支持

-

🛡️ 合规性:尊重robots.txt和网站政策

设计理念:

-

数据质量:提供干净、格式化的AI就绪数据

-

易用性:简单API接口,降低使用门槛

-

可扩展性:支持各种规模的数据提取需求

-

隐私保护:合规的数据处理和使用

-

持续创新:不断添加新功能和改进

主要功能

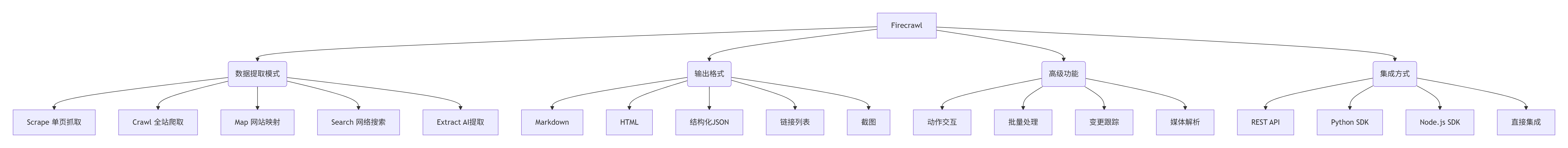

1. 核心功能架构

2. 功能详情

数据提取模式:

-

Scrape:抓取单个URL的内容,返回指定格式的数据

-

Crawl:爬取整个网站的所有可访问子页面,全面获取内容

-

Map:快速映射网站结构,获取所有URL列表

-

Search:执行网络搜索并提取搜索结果内容

-

Extract:使用AI从页面提取结构化数据(测试版)

输出格式支持:

-

Markdown:干净的markdown格式,适合LLM处理

-

HTML:原始HTML内容,保留完整结构

-

结构化JSON:AI提取的规范化数据结构

-

链接列表:页面中的所有链接和元数据

-

截图:页面可视化截图(可选)

高级能力:

-

动作交互:在页面上执行点击、输入、滚动等交互操作

-

批量处理:同时处理数千个URL的异步端点

-

变更检测:监控和检测网站内容随时间的变化

-

媒体解析:支持PDF、Word文档、图像等文件解析

-

身份验证:支持需要认证的网站访问

智能特性:

-

AI提取:使用大型语言模型智能提取结构化数据

-

模式支持:支持JSON Schema和自然语言提示提取

-

内容理解:智能识别和提取关键信息

-

格式转换:自动转换为LLM就绪的格式

-

质量优化:去除无关内容,保留核心信息

3. 技术规格

API端点:

# 主要API端点

Scrape: POST /v2/scrape

Crawl: POST /v2/crawl

Map: POST /v2/map

Search: POST /v2/search

Extract: POST /v2/extract

Batch: POST /v2/batch/scrape

# 作业状态检查

GET /v2/crawl/{job_id}输出格式选项:

{

"formats": [

"markdown",

"html",

{"type": "json", "schema": {...}},

{"type": "json", "prompt": "提取公司使命"},

"links",

"screenshot"

]

}性能指标:

# 处理能力

单请求URL数: 1-1000+ (批量端点)

爬取深度: 可配置的最大深度

并发处理: 支持高并发请求

处理速度: 取决于网站复杂度和规模

# 限制和配额

API速率限制: 基于方案层级

每日限额: 免费和付费方案不同

超时设置: 可配置请求超时时间

大小限制: 单个页面处理大小限制兼容性:

-

网站类型:静态网站、动态JavaScript渲染网站、单页应用

-

文件格式:HTML、PDF、DOCX、图像文件等

-

认证方式:基础认证、OAuth、Cookie-based认证

-

反爬措施:智能处理常见反爬机制

-

编码支持:多语言和字符编码支持

安装与配置

1. 环境准备

云服务使用(推荐):

# 无需安装,直接使用API

1. 访问 https://firecrawl.dev 注册账户

2. 获取API密钥

3. 直接调用REST API或使用SDK

# API密钥格式

fc-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx自托管准备(高级用户):

# 系统要求

Node.js: 18.x 或更高版本

Python: 3.8+ (可选,用于某些组件)

Docker: 可选,容器化部署

数据库: PostgreSQL (推荐) 或 SQLite

Redis: 用于缓存和会话管理

# 资源要求

内存: 4GB+ RAM (推荐8GB)

存储: 10GB+ 可用空间

网络: 稳定的互联网连接

CPU: 4核+ 现代处理器2. 安装步骤

使用Python SDK:

# 安装Python SDK

pip install firecrawl-py

# 或从源码安装

git clone https://github.com/firecrawl/firecrawl.git

cd firecrawl/python-sdk

pip install -e .使用Node.js SDK:

# 安装Node.js SDK

npm install @mendable/firecrawl-js

# 或使用yarn

yarn add @mendable/firecrawl-jsDocker部署:

# 使用Docker Compose部署

git clone https://github.com/firecrawl/firecrawl.git

cd firecrawl

docker-compose up -d

# 环境变量配置

cp .env.example .env

# 编辑.env文件设置数据库、Redis等配置源码部署:

# 克隆仓库

git clone https://github.com/firecrawl/firecrawl.git

cd firecrawl

# 安装依赖

npm install

# 或使用pnpm

pnpm install

# 构建项目

npm run build

# 启动服务

npm start3. 配置说明

API密钥配置:

# Python配置

from firecrawl import Firecrawl

firecrawl = Firecrawl(api_key="fc-YOUR_API_KEY")// Node.js配置

import Firecrawl from '@mendable/firecrawl-js';

const firecrawl = new Firecrawl({

apiKey: 'fc-YOUR_API_KEY'

});环境变量配置:

# 自托管环境变量

FIRECRAWL_API_KEY=your_api_key

DATABASE_URL=postgresql://user:pass@localhost:5432/firecrawl

REDIS_URL=redis://localhost:6379

NODE_ENV=production

PORT=3000爬取配置选项:

{

"url": "https://example.com",

"limit": 100,

"scrapeOptions": {

"formats": ["markdown", "html"],

"timeout": 30000,

"waitFor": 2000,

"proxy": null,

"headers": {

"User-Agent": "Firecrawl/1.0"

}

}

}高级配置:

// 动作交互配置

{

"actions": [

{"type": "wait", "milliseconds": 2000},

{"type": "click", "selector": "button.submit"},

{"type": "type", "selector": "input#search", "text": "query"},

{"type": "scroll", "pixels": 1000}

]

}使用指南

1. 基本工作流

使用Firecrawl的基本流程包括:API设置 → 请求配置 → 执行提取 → 处理结果 → 数据利用。整个过程设计为简单直观,开发者友好。

2. 基本使用

API直接调用:

# 使用curl进行Scrape请求

curl -X POST https://api.firecrawl.dev/v2/scrape \

-H 'Content-Type: application/json' \

-H 'Authorization: Bearer YOUR_API_KEY' \

-d '{

"url": "https://example.com",

"formats": ["markdown", "html"]

}'Python SDK使用:

from firecrawl import Firecrawl

# 初始化客户端

firecrawl = Firecrawl(api_key="fc-YOUR_API_KEY")

# 抓取单个页面

document = firecrawl.scrape(

"https://example.com",

formats=["markdown", "html"]

)

print(document.markdown) # 输出markdown内容

print(document.html) # 输出HTML内容

# 爬取整个网站

crawl_result = firecrawl.crawl(

"https://example.com",

limit=50,

scrape_options={"formats": ["markdown"]}

)

for page in crawl_result:

print(f"URL: {page.url}, Title: {page.metadata.title}")Node.js SDK使用:

import Firecrawl from '@mendable/firecrawl-js';

// 初始化客户端

const firecrawl = new Firecrawl({

apiKey: 'fc-YOUR_API_KEY'

});

// 抓取单个页面

const document = await firecrawl.scrape(

'https://example.com',

{ formats: ['markdown', 'html'] }

);

console.log(document.markdown); // 输出markdown内容

// 爬取整个网站

const crawlResult = await firecrawl.crawl(

'https://example.com',

{

limit: 50,

scrapeOptions: { formats: ['markdown'] }

}

);

crawlResult.data.forEach(page => {

console.log(`URL: ${page.url}, Title: ${page.metadata.title}`);

});作业状态检查:

# 检查爬取作业状态

curl -X GET https://api.firecrawl.dev/v2/crawl/JOB_ID \

-H 'Authorization: Bearer YOUR_API_KEY'3. 高级功能

AI数据提取:

# 使用AI提取结构化数据

from pydantic import BaseModel

class CompanyInfo(BaseModel):

name: str

description: str

founded_year: int

employees: int

# 提取结构化信息

result = firecrawl.extract(

urls=["https://example.com/about"],

schema=CompanyInfo,

prompt="提取公司基本信息"

)

print(result.data)批量处理:

# 批量处理多个URL

urls = [

"https://example.com/page1",

"https://example.com/page2",

"https://example.com/page3"

]

batch_result = firecrawl.batch_scrape(

urls=urls,

formats=["markdown"]

)

for result in batch_result:

print(f"Processed: {result.url}, Status: {result.status}")搜索集成:

# 网络搜索并提取内容

search_result = firecrawl.search(

query="人工智能最新发展",

limit=10,

scrape_options={"formats": ["markdown"]}

)

for item in search_result.data:

print(f"Title: {item.title}, URL: {item.url}")

print(f"Content: {item.markdown[:200]}...") # 预览内容交互式抓取:

# 使用动作交互抓取动态内容

document = firecrawl.scrape(

"https://example.com/dynamic",

formats=["markdown"],

actions=[

{"type": "wait", "milliseconds": 3000},

{"type": "click", "selector": "#load-more"},

{"type": "wait", "milliseconds": 2000},

{"type": "scroll", "pixels": 1000}

]

)应用场景实例

案例1:AI训练数据准备

场景:机器学习团队需要高质量的训练数据

解决方案:使用Firecrawl提取和准备AI训练数据。

实施流程:

from firecrawl import Firecrawl

import json

# 初始化Firecrawl

firecrawl = Firecrawl(api_key="fc-YOUR_API_KEY")

# 定义目标网站和内容类型

target_sites = [

"https://technews.com",

"https://research-blog.edu",

"https://industry-insights.org"

]

training_data = []

for site in target_sites:

try:

# 爬取网站获取技术文章

result = firecrawl.crawl(

site,

limit=100,

scrape_options={

"formats": ["markdown"],

"includePaths": ["/articles/", "/blog/"]

}

)

# 处理和组织数据

for page in result.data:

if page.markdown and len(page.markdown) > 500: # 确保足够长度

training_data.append({

"url": page.url,

"title": page.metadata.get('title', ''),

"content": page.markdown,

"source": site,

"language": page.metadata.get('language', 'en'),

"timestamp": page.metadata.get('date', '')

})

except Exception as e:

print(f"Error processing {site}: {e}")

# 保存训练数据

with open('training_data.jsonl', 'w', encoding='utf-8') as f:

for item in training_data:

f.write(json.dumps(item, ensure_ascii=False) + '\n')

print(f"成功收集 {len(training_data)} 篇训练文章")数据质量优化:

-

内容过滤:基于长度、质量和相关性过滤内容

-

格式统一:标准化markdown格式和结构

-

元数据丰富:添加来源、日期、语言等元数据

-

去重处理:移除重复或类似内容

-

质量验证:人工抽样验证数据质量

实施效果:

-

数据规模:快速收集数千篇高质量文章

-

成本效率:相比手动收集节省90%时间和成本

-

数据质量:干净、格式统一的AI就绪数据

-

可扩展性:轻松扩展更多数据源和类型

-

更新维护:定期更新保持数据新鲜度

案例2:竞争情报监控

场景:企业需要监控竞争对手的网站动态

解决方案:使用Firecrawl进行自动化竞争情报收集。

监控系统设计:

import schedule

import time

from datetime import datetime

from firecrawl import Firecrawl

class CompetitorMonitor:

def __init__(self, api_key):

self.firecrawl = Firecrawl(api_key=api_key)

self.competitors = {

"company_a": "https://companya.com",

"company_b": "https://companyb.com",

"company_c": "https://companyc.com"

}

self.previous_content = self.load_previous_data()

def daily_monitor(self):

"""每日监控任务"""

changes_detected = []

for name, url in self.competitors.items():

try:

# 抓取最新内容

current_content = self.firecrawl.scrape(

url,

formats=["markdown"],

includePaths=["/news/", "/blog/", "/products/"]

)

# 与之前内容比较

previous = self.previous_content.get(name)

if previous and previous != current_content.markdown:

changes = self.detect_changes(previous, current_content.markdown)

changes_detected.append({

"competitor": name,

"url": url,

"changes": changes,

"timestamp": datetime.now().isoformat()

})

# 更新存储内容

self.previous_content[name] = current_content.markdown

except Exception as e:

print(f"监控 {name} 时出错: {e}")

# 保存检测结果

self.save_changes(changes_detected)

return changes_detected

def detect_changes(self, old_content, new_content):

"""检测内容变化"""

# 简化的变化检测逻辑

# 实际实现可以使用diff算法或AI比较

changes = []

if len(new_content) > len(old_content) * 1.2:

changes.append("significant_content_addition")

elif len(new_content) < len(old_content) * 0.8:

changes.append("content_reduction")

# 这里可以添加更精细的变化检测

return changes or ["content_updated"]

def save_changes(self, changes):

"""保存变化记录"""

with open('competitor_changes.jsonl', 'a', encoding='utf-8') as f:

for change in changes:

f.write(json.dumps(change, ensure_ascii=False) + '\n')

def load_previous_data(self):

"""加载之前的数据"""

try:

with open('previous_content.json', 'r', encoding='utf-8') as f:

return json.load(f)

except FileNotFoundError:

return {}

def run_continuous_monitor(self):

"""启动持续监控"""

schedule.every().day.at("09:00").do(self.daily_monitor)

while True:

schedule.run_pending()

time.sleep(60)

# 启动监控

monitor = CompetitorMonitor("fc-YOUR_API_KEY")

monitor.run_continuous_monitor()监控功能:

-

内容变化检测:识别页面内容添加、删除或修改

-

新产品监控:检测新产品发布或页面添加

-

价格监控:跟踪价格变化和促销活动

-

新闻监测:捕获公司新闻和公告

-

自动告警:检测到重要变化时发送通知

情报价值:

-

市场洞察:了解竞争对手动态和战略

-

快速响应:及时应对市场变化和竞争动作

-

趋势分析:分析行业趋势和模式

-

决策支持:为商业决策提供数据支持

-

风险预警:早期发现潜在威胁和机会

案例3:内容聚合平台

场景:构建多源内容聚合平台

解决方案:使用Firecrawl聚合多个网站的内容。

聚合系统实现:

from firecrawl import Firecrawl

from datetime import datetime, timedelta

import hashlib

class ContentAggregator:

def __init__(self, api_key):

self.firecrawl = Firecrawl(api_key=api_key)

self.sources = [

{

"name": "科技新闻",

"url": "https://technews.com",

"categories": ["/news/", "/articles/"],

"update_frequency": "hourly"

},

{

"name": "学术博客",

"url": "https://research.edu/blog",

"categories": ["/posts/", "/research/"],

"update_frequency": "daily"

},

{

"name": "行业洞察",

"url": "https://industry.org/insights",

"categories": ["/insights/", "/reports/"],

"update_frequency": "weekly"

}

]

def fetch_new_content(self, hours=24):

"""获取指定时间范围内的新内容"""

all_content = []

cutoff_time = datetime.now() - timedelta(hours=hours)

for source in self.sources:

try:

# 爬取源网站

result = self.firecrawl.crawl(

source["url"],

limit=200,

scrape_options={

"formats": ["markdown"],

"includePaths": source["categories"],

"modifiedSince": cutoff_time.isoformat()

}

)

# 处理和组织内容

for page in result.data:

content_hash = self.generate_content_hash(page.markdown)

article = {

"id": content_hash,

"title": page.metadata.get('title', 'Untitled'),

"content": page.markdown,

"url": page.url,

"source": source["name"],

"published_date": page.metadata.get('date', ''),

"author": page.metadata.get('author', ''),

"categories": self.extract_categories(page),

"word_count": len(page.markdown.split()),

"fetch_time": datetime.now().isoformat()

}

all_content.append(article)

except Exception as e:

print(f"获取 {source['name']} 内容时出错: {e}")

return all_content

def generate_content_hash(self, content):

"""生成内容哈希值用于去重"""

return hashlib.md5(content.encode()).hexdigest()

def extract_categories(self, page):

"""从内容中提取分类"""

# 简化的分类提取逻辑

categories = []

metadata = page.metadata

if 'keywords' in metadata:

categories.extend(metadata['keywords'].split(','))

if 'categories' in metadata:

categories.extend(metadata['categories'].split(','))

return [cat.strip() for cat in categories if cat.strip()]

def deduplicate_content(self, content_list):

"""内容去重"""

seen_ids = set()

deduplicated = []

for item in content_list:

if item['id'] not in seen_ids:

seen_ids.add(item['id'])

deduplicated.append(item)

return deduplicated

def create_content_feed(self, hours=24, max_items=1000):

"""创建内容聚合feed"""

raw_content = self.fetch_new_content(hours)

unique_content = self.deduplicate_content(raw_content)

# 按时间排序

sorted_content = sorted(

unique_content,

key=lambda x: x.get('published_date', ''),

reverse=True

)

return sorted_content[:max_items]

# 使用聚合器

aggregator = ContentAggregator("fc-YOUR_API_KEY")

content_feed = aggregator.create_content_feed(hours=48, max_items=500)

print(f"聚合了 {len(content_feed)} 篇内容")

for item in content_feed[:5]:

print(f"{item['source']}: {item['title']}")聚合功能:

-

多源采集:从多个网站同步采集内容

-

智能去重:基于内容哈希值移除重复项目

-

分类组织:自动分类和标签化内容

-

时间过滤:按时间范围筛选相关内容

-

质量筛选:基于长度、完整性等指标过滤内容

平台价值:

-

内容丰富度:提供多样化的内容来源

-

更新及时性:近实时内容更新和同步

-

用户体验:统一格式和结构的阅读体验

-

可发现性:改进内容发现和推荐

-

分析洞察:内容趋势和性能分析

案例4:学术研究数据收集

场景:研究人员需要收集网络数据进行分析

解决方案:使用Firecrawl进行学术研究数据收集。

研究数据收集:

from firecrawl import Firecrawl

import pandas as pd

from typing import Dict, List

class ResearchDataCollector:

def __init__(self, api_key):

self.firecrawl = Firecrawl(api_key=api_key)

self.research_focus = {

"topic": "人工智能伦理",

"keywords": ["AI ethics", "responsible AI", "algorithmic bias"],

"sources": [

"https://aiethicsinstitute.org",

"https://responsible-ai.research",

"https://ethicsintech.com"

]

}

def collect_research_data(self, time_period="30d", max_pages=1000):

"""收集研究数据"""

research_data = []

for source in self.research_focus["sources"]:

try:

# 爬取学术资源

result = self.firecrawl.crawl(

source,

limit=max_pages // len(self.research_focus["sources"]),

scrape_options={

"formats": ["markdown"],

"timePeriod": time_period,

"contentFilter": {

"minLength": 1000, # 确保内容足够详细

"requiredKeywords": self.research_focus["keywords"]

}

}

)

# 处理学术内容

for page in result.data:

research_item = self.process_research_page(page)

if research_item:

research_data.append(research_item)

except Exception as e:

print(f"收集 {source} 数据时出错: {e}")

return research_data

def process_research_page(self, page):

"""处理研究页面内容"""

if not page.markdown or len(page.markdown.strip()) < 500:

return None

return {

"id": f"research_{hash(page.url)}",

"title": page.metadata.get("title", "Untitled"),

"abstract": self.extract_abstract(page.markdown),

"content": page.markdown,

"url": page.url,

"source": page.metadata.get("sourceURL", ""),

"publication_date": page.metadata.get("date", ""),

"authors": self.extract_authors(page.metadata),

"keywords": self.extract_keywords(page.markdown),

"citation_count": self.estimate_citation_count(page),

"academic_score": self.calculate_academic_score(page)

}

def extract_abstract(self, content):

"""从内容中提取摘要"""

# 简化的摘要提取逻辑

lines = content.split('\n')

for line in lines:

if len(line) > 100 and len(line) < 300:

return line.strip()

return content[:200] + "..."

def analyze_research_trends(self, research_data):

"""分析研究趋势"""

df = pd.DataFrame(research_data)

# 时间趋势分析

time_trends = df.groupby(pd.to_datetime(df['publication_date']).dt.to_period("M")).size()

# 关键词频率分析

keyword_freq = {}

for keywords in df['keywords']:

for keyword in keywords:

keyword_freq[keyword] = keyword_freq.get(keyword, 0) + 1

# 作者生产力分析

author_productivity = {}

for authors in df['authors']:

for author in authors:

author_productivity[author] = author_productivity.get(author, 0) + 1

return {

"time_trends": time_trends.to_dict(),

"keyword_frequency": dict(sorted(keyword_freq.items(), key=lambda x: x[1], reverse=True)[:20]),

"top_authors": dict(sorted(author_productivity.items(), key=lambda x: x[1], reverse=True)[:10]),

"total_publications": len(df),

"time_span": f"{df['publication_date'].min()} 至 {df['publication_date'].max()}"

}

def generate_research_report(self, research_data, output_format="markdown"):

"""生成研究报告"""

analysis = self.analyze_research_trends(research_data)

if output_format == "markdown":

report = self.generate_markdown_report(analysis, research_data)

elif output_format == "json":

report = analysis

else:

report = str(analysis)

return report

def export_research_data(self, research_data, format="jsonl"):

"""导出研究数据"""

if format == "jsonl":

with open('research_data.jsonl', 'w', encoding='utf-8') as f:

for item in research_data:

f.write(json.dumps(item, ensure_ascii=False) + '\n')

elif format == "csv":

df = pd.DataFrame(research_data)

df.to_csv('research_data.csv', index=False, encoding='utf-8')

return f"导出成功: {len(research_data)} 条记录"

# 使用研究数据收集器

researcher = ResearchDataCollector("fc-YOUR_API_KEY")

data = researcher.collect_research_data(time_period="90d", max_pages=500)

report = researcher.generate_research_report(data)

researcher.export_research_data(data, format="jsonl")

print(f"收集了 {len(data)} 篇研究文献")

print("研究趋势分析:", report["time_trends"])研究功能:

-

文献收集:自动化收集学术文献和研究资料

-

内容分析:提取关键信息和元数据

-

趋势分析:分析研究热点和发展趋势

-

质量评估:评估文献质量和影响力

-

数据导出:多种格式导出研究数据

学术价值:

-

研究效率:大幅提高文献收集和整理效率

-

全面性:覆盖多个来源的完整研究资料

-

数据分析:基于数据的趋势洞察和发现

-

可重复性:可重复的研究数据收集过程

-

知识管理:系统化的研究知识管理

生态系统与社区

1. 社区资源

获取帮助:

-

📚 官方文档:https://docs.firecrawl.dev

-

💬 社区讨论:GitHub Issues和讨论区

-

🐛 问题报告:通过GitHub Issues报告问题

-

💡 功能建议:提交新功能请求和改进建议

支持渠道:

-

GitHub Issues:主要的问题跟踪和功能请求

-

官方支持:通过Firecrawl网站获取支持

-

开发者社区:技术博客和教程分享

-

更新通知:关注仓库获取最新更新

贡献指南:

-

Fork项目仓库

-

创建特性分支 (

git checkout -b feature/AmazingFeature) -

提交更改 (

git commit -m 'Add some AmazingFeature') -

推送到分支 (

git push origin feature/AmazingFeature) -

发起Pull Request

2. 相关项目集成

AI生态系统:

-

LangChain:LLM应用开发框架集成

-

LlamaIndex:数据连接和检索增强

-

OpenAI:GPT模型集成和调用

-

Hugging Face:Transformer模型集成

-

向量数据库:Chroma、Pinecone等集成

开发工具:

-

Python数据科学生态:Pandas、NumPy、Scikit-learn

-

Jupyter Notebook:交互式数据分析和实验

-

Apache Airflow:工作流调度和自动化

-

Prefect:现代数据工作流编排

-

Dagster:数据编排和观测平台

云服务集成:

-

AWS:S3存储、Lambda函数、SageMaker

-

Google Cloud:BigQuery、Cloud Functions、AI Platform

-

Azure:Blob存储、Functions、Machine Learning

-

云函数:无服务器架构部署

-

容器服务:Docker和Kubernetes部署

总结

Firecrawl作为专为AI应用设计的Web数据提取API,提供了强大而灵活的数据获取能力。其核心价值在于将复杂的Web内容转换为干净、结构化的AI就绪数据,大幅降低了数据准备的门槛和成本。

核心优势:

-

🚀 AI就绪:专为LLM和AI应用优化的数据格式

-

🌐 全面能力:从单页抓取到整站爬取的完整解决方案

-

⚡ 高性能:快速、可靠的大规模数据处理能力

-

🔧 开发者友好:简洁API和多语言SDK支持

-

🛡️ 合规性:尊重网站政策和robots.txt规范

适用场景:

-

AI训练数据准备和增强

-

竞争情报和市场监控

-

内容聚合和知识管理

-

学术研究和数据收集

-

商业智能和数据分析

技术特色:

-

多模式提取:Scrape、Crawl、Map、Search、Extract

-

智能处理:AI驱动的结构化和内容理解

-

格式丰富:Markdown、HTML、JSON、Screenshot等输出

-

交互能力:页面动作和动态内容处理

-

批量处理:高并发和大规模数据处理能力

🌟 GitHub地址:

https://github.com/firecrawl/firecrawl

🚀 云服务:

📚 文档:

💬 社区:

通过GitHub Issues参与讨论和贡献

立即开始使用Firecrawl,释放Web数据的全部潜力!

最佳实践建议:

-

🏁 初学者:从Scrape API开始体验基本功能

-

🔧 开发者:探索SDK和高级功能集成

-

🏢 企业用户:评估云服务和企业级特性

-

📚 研究人员:利用数据收集和分析能力

-

🔍 架构师:设计基于Firecrawl的数据流水线

注意事项:

-

⚠️ 合规使用:尊重网站使用条款和robots.txt

-

🔒 数据隐私:注意数据隐私和合规要求

-

📋 速率限制:遵守API使用限制和配额

-

🐛 错误处理:实现健壮的错误处理和重试机制

-

📊 质量监控:监控数据质量和提取效果

Firecrawl持续演进和发展,欢迎加入社区共同打造更强大的Web数据提取工具!

更多推荐

已为社区贡献166条内容

已为社区贡献166条内容

所有评论(0)