weknora —— 基于大模型的文档理解检索框架

WeKnora 简介

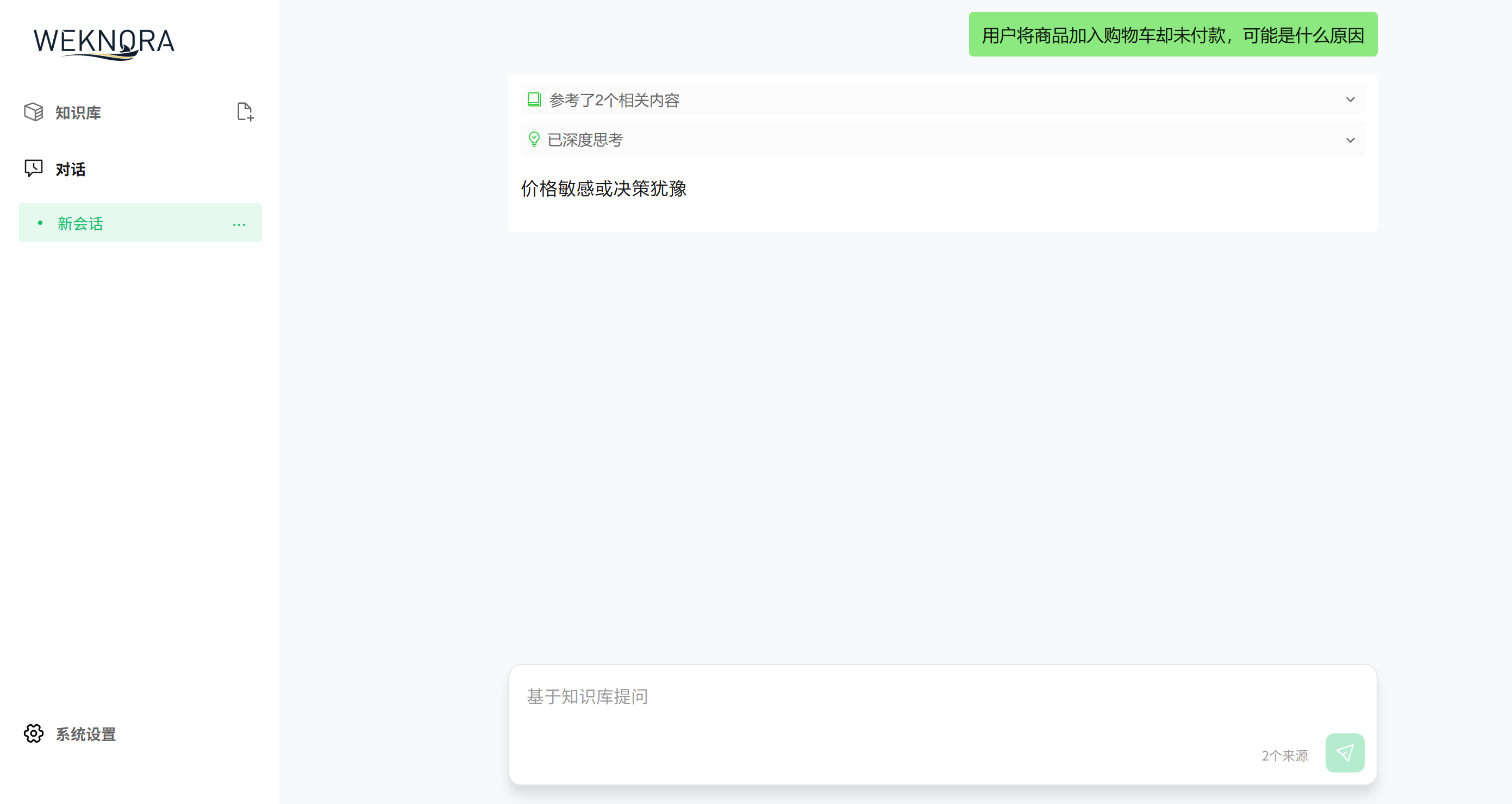

WeKnora是一个 打通多模态文档-召回-生成全流程 的 文档理解与语义检索框架 。

作为微信对话开放平台的核心技术框架,用户可通过微信对话开放平台,WeKnora 的智能问答能力可无缝集成到公众号、小程序等微信场景中,提升用户交互体验

WeKnora 采用模块化的设计思路,集成多模态预处理、语义向量索引、智能召回和大模型推理等能力,构建高效且可控的文档问答流程。其检索流程基于 RAG 机制,将上下文相关片段与大语言模型深度结合,从而实现高质量的语义回答。

WeKnora 亮点

1.开箱即用的交互体验

提供一键启动脚本和 可视化WebUI 界面,非技术用户也能轻松完成文档索引、智能问答等服务的部署与使用。

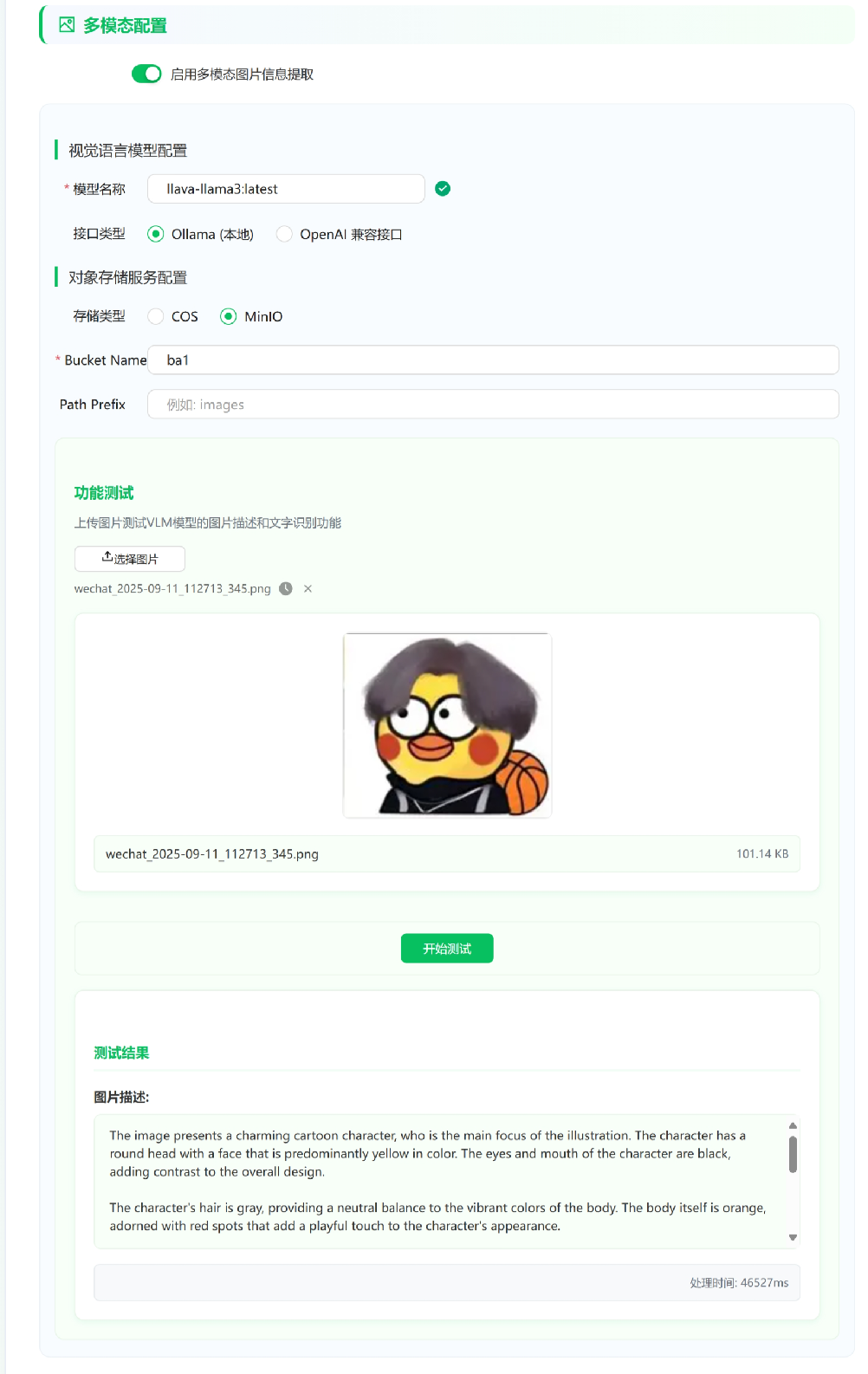

2.支持多模态

能够精准解析 PDF、Word、图片中的图文混排内容,提取文本、表格和图像语义。结合 OCR 与跨模态建模技术,构建统一的结构化知识中枢。

3.灵活的配置与扩展能力

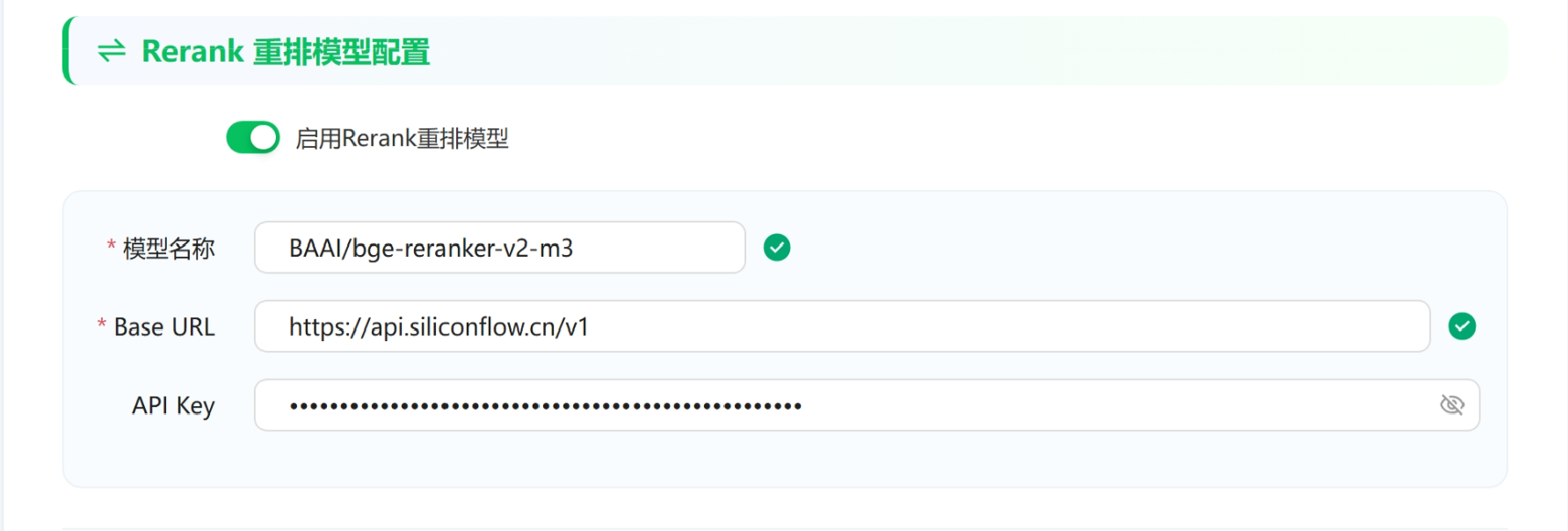

用户可在 WebUI 界面完成 LLM 模型、Embedding 模型、Rerank 模型、多模态解析及文档切分的配置。实现从解析、嵌入、召回到生成的全流程解耦,便于集成不同模块或进行定制化扩展。

4.支持MCP访问

通过 MCP 服务器即可访问已部署的 WeKnora,实现跨设备、跨平台的文档问答服务。

使用场景

WeKnora 在多个行业和应用场景中都有价值,包括但不限于:

| 应用场景 | 具体应用 | 核心价值 |

|---|---|---|

| 企业知识管理 | 内部文档检索、规章制度问答、操作手册查询 | 提升知识查找效率,降低培训成本 |

| 科研文献分析 | 论文检索、研究报告分析、学术资料整理 | 加速文献调研,辅助研究决策 |

| 产品技术支持 | 产品手册问答、技术文档检索、故障排查 | 提升客户服务质量,减少技术支持负担 |

| 法律合规审查 | 合同条款检索、法规政策查询、案例分析 | 提高合规效率,降低法律风险 |

| 医疗知识辅助 | 医学文献检索、诊疗指南查询、病例分析 | 辅助临床决策,提升诊疗质量 |

环境准备

1. 安装 Docker

在 Windows 上安装 Docker ,需要确保系统支持 Hyper-V 和 Linux 子系统 (WSL2)。

开启 Hyper-V

新建一个 Enable-hyper-v.bat 文件,将以下代码粘贴进去,右键以管理员权限运行:

pushd "%~dp0"

dir /b %SystemRoot%\servicing\Packages\*Hyper-V*.mum >hyper-v.txt

for /f %%i in ('findstr /i . hyper-v.txt 2^>nul') do dism /online /norestart /add-package:"%SystemRoot%\servicing\Packages\%%i"

del hyper-v.txt

Dism /online /enable-feature /featurename:Microsoft-Hyper-V-All /LimitAccess /ALL

启用所需功能

打开 PowerShell(管理员模式),逐条执行以下命令:

Enable-WindowsOptionalFeature -Online -FeatureName Microsoft-Hyper-V -All

Enable-WindowsOptionalFeature -Online -FeatureName VirtualMachinePlatform

Enable-WindowsOptionalFeature -Online -FeatureName Microsoft-Windows-Subsystem-Linux

再使用 cmd(管理员模式) 执行:

bcdedit /set hypervisorlaunchtype auto

安装 Ubuntu 子系统

到 Microsoft Store 下载 Ubuntu-22.04 LTS。首次运行时会提示设置用户名和密码(⚠️ 注意不要用 root)。

安装 Docker Desktop

前往官网下载安装包:Docker Desktop for Windows。

安装过程全部“下一步”,默认配置即可。

初次安装需要重启系统。建议至少 16GB 内存的机器体验更佳。

更多技术讲解及项目实战:赋范空间

2. 安装 Git

直接到官网下载 Git for Windows,安装完成后,将 git安装路径/cmd 添加到环境变量-系统变量的 PATH 中,最后在命令行中执行 git --version 验证。

运行 WeKnora

完成环境准备后,正式进入项目部署。

git clone https://github.com/Tencent/WeKnora.git

cd WeKnora

cp .env.example .env

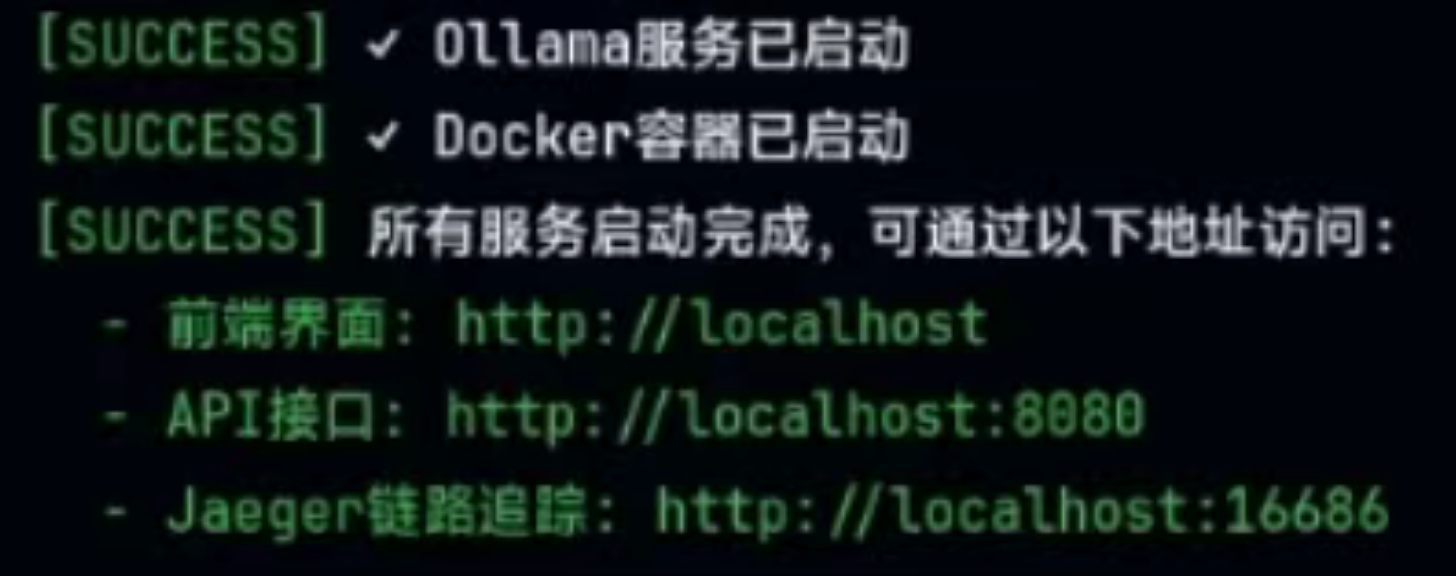

bash ./scripts/start_all.sh

执行后,Docker 会自动拉取相关依赖容器,并启动服务。

更多技术讲解及项目实战:赋范空间

配置 WeKnora

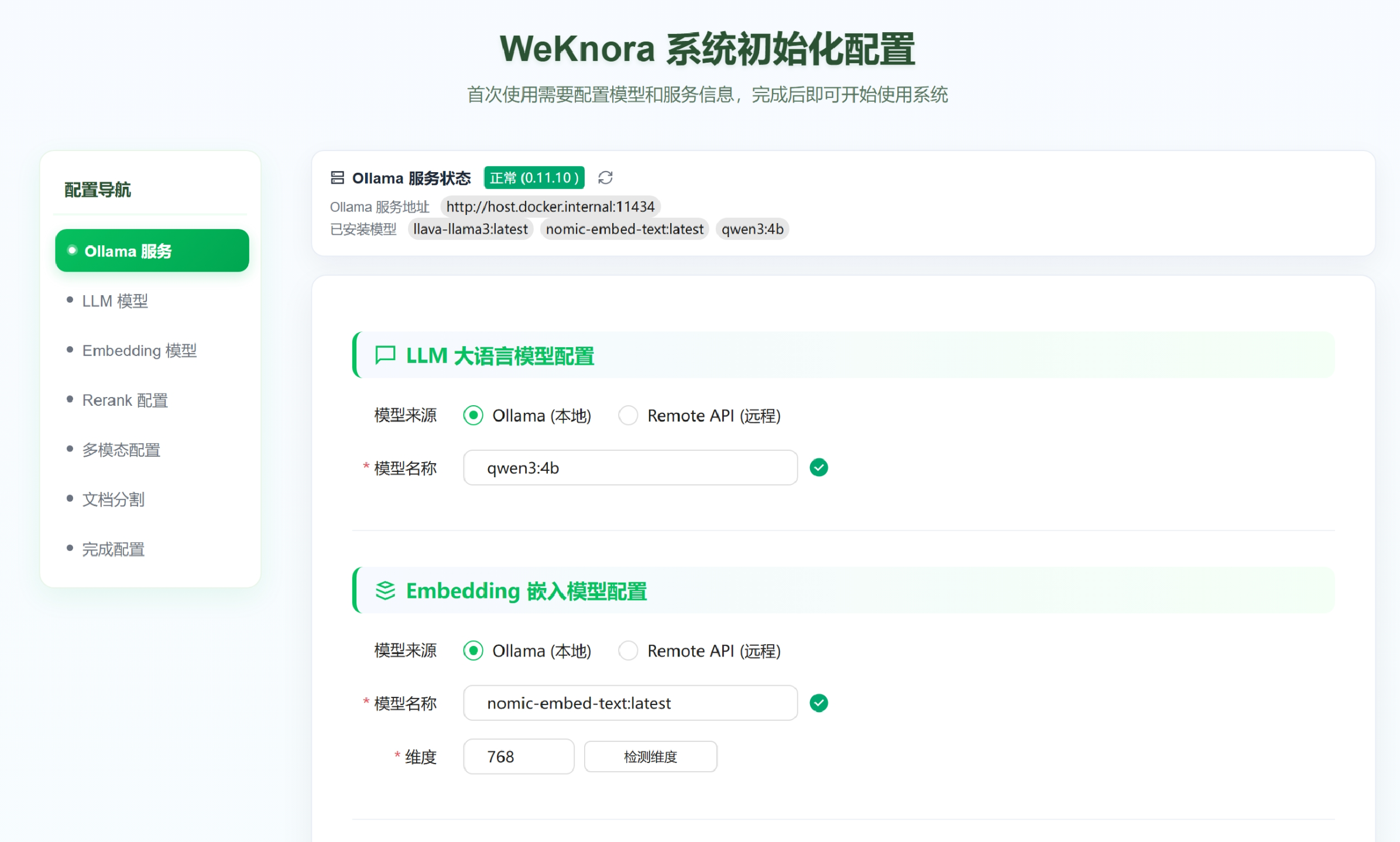

浏览器访问 http://localhost,会自动跳转到配置页面。

配置内容主要包括:

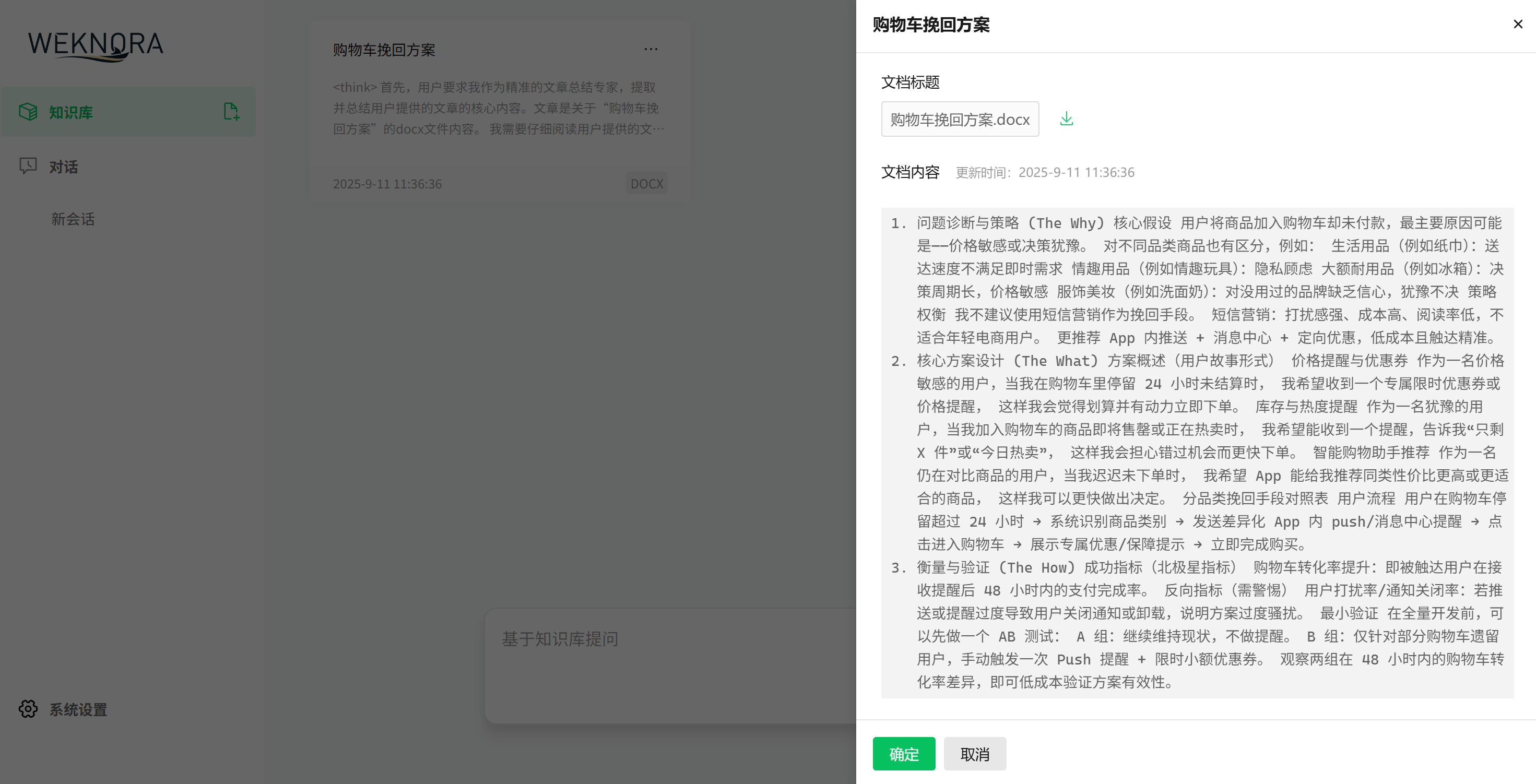

可参考下面我的配置示例(rerank和多模态可选):

完成配置后,即可进入 WeKnora 的交互页面。

总的来说,WeKnora 的界面简洁,配置流程清晰,操作简单,RAG效果也不错。

更多技术讲解及项目实战:赋范空间

MCP服务器访问已经部署好的WeKnora

mcp客户端配置服务器

{

"mcpServers": {

"weknora": {

"args": [

"path/to/WeKnora/mcp-server/run_server.py"

],

"command": "python",

"env":{

"WEKNORA_API_KEY":"填写sk开头的api key",

"WEKNORA_BASE_URL":"http(s)://你的weknora地址/api/v1"

}

}

}

}

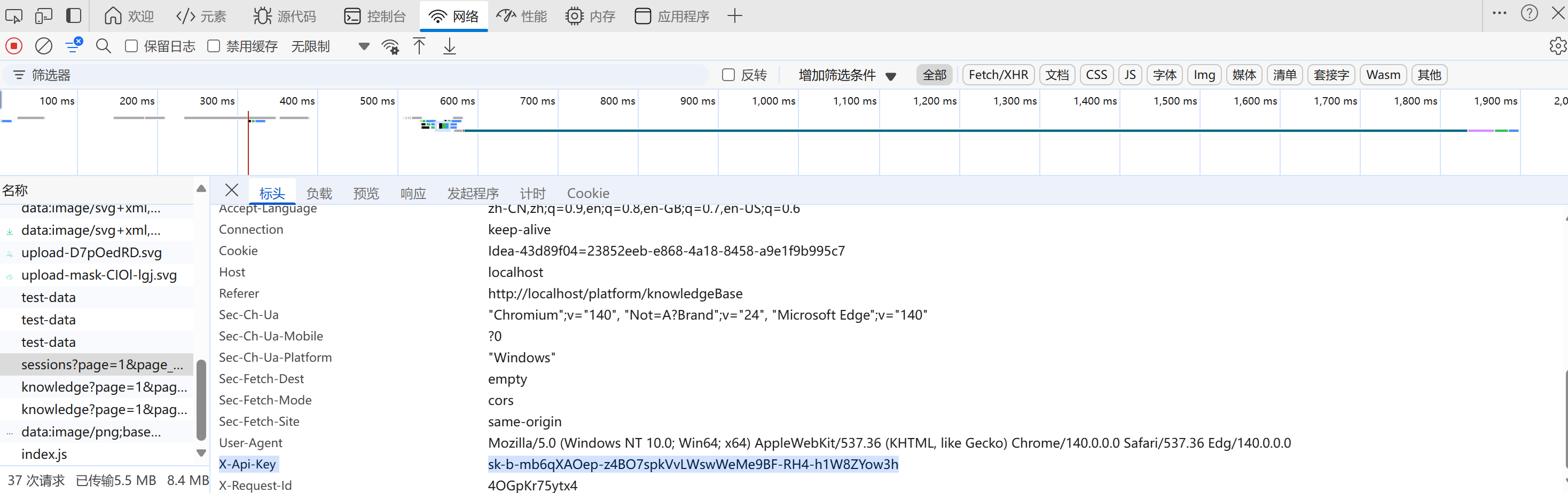

WEKNORA_API_KEY :浏览器打开weknora页面,F12打开开发者工具,网络里查看请求头x-api-key,以sk开头

使用stdio命令直接运行

pip install weknora-mcp-server

python -m weknora-mcp-server

er/%E5%BE%AE%E4%BF%A1%E5%9B%BE%E7%89%87_20250911135047_126_82.png)

使用stdio命令直接运行

pip install weknora-mcp-server

python -m weknora-mcp-server

更多技术讲解及项目实战:赋范空间

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)