AI原生应用新趋势:向量数据库与LLM的完美结合方案

今天的AI应用早已不是"只会聊天的机器人"——它们能帮医生分析病历、给设计师生成灵感、为程序员写代码。LLM(大语言模型)和向量数据库。什么是向量数据库?它和传统数据库有什么不一样?LLM为什么需要向量数据库?没有它,LLM会"变笨"吗?两者结合能解决哪些实际问题?比如"如何让ChatGPT记住你的偏好"?范围覆盖:核心概念解释、技术架构、代码实战、应用场景,适合所有对AI感兴趣的人(哪怕你没写过

AI原生应用新趋势:向量数据库与LLM的完美结合方案

关键词:AI原生应用、向量数据库、LLM(大语言模型)、嵌入模型、相似性检索、语义理解、智能问答

摘要:当"超级大脑"(LLM)遇到"智能图书馆"(向量数据库),会碰撞出怎样的火花?本文用"小学生能听懂的故事"拆解AI原生应用的核心逻辑——向量数据库如何帮LLM"记住"海量知识,LLM又如何用这些知识生成更聪明的回答。从"猫为什么喜欢爬树"的日常问题切入,一步步讲清向量、向量数据库、LLM的关系,用Python代码演示"智能问答机器人"的实现,最后探讨两者结合的未来趋势。读完这篇,你会明白:为什么说"向量数据库+LLM"是AI原生应用的"黄金组合"。

背景介绍

目的和范围

今天的AI应用早已不是"只会聊天的机器人"——它们能帮医生分析病历、给设计师生成灵感、为程序员写代码。这些"聪明"的应用背后,藏着两个关键技术:LLM(大语言模型) 和 向量数据库。本文的目的,就是帮你搞懂:

- 什么是向量数据库?它和传统数据库有什么不一样?

- LLM为什么需要向量数据库?没有它,LLM会"变笨"吗?

- 两者结合能解决哪些实际问题?比如"如何让ChatGPT记住你的偏好"?

范围覆盖:核心概念解释、技术架构、代码实战、应用场景,适合所有对AI感兴趣的人(哪怕你没写过代码)。

预期读者

- 想了解AI原生应用底层逻辑的产品经理/运营;

- 刚开始学AI开发的程序员(想搞懂"向量数据库到底怎么用");

- 对"ChatGPT为什么有时候会答错"好奇的普通人。

文档结构概述

本文像一本"AI科普故事书",结构如下:

- 故事引入:用"小朋友问猫爬树"的例子,引出"LLM+向量数据库"的必要性;

- 核心概念:用"超级大脑"“智能图书馆”"特征密码"比喻LLM、向量数据库、向量;

- 关系拆解:讲清"超级大脑"如何用"智能图书馆"查资料;

- 原理与代码:用Python演示"智能问答机器人"的实现(超简单!);

- 应用场景:看看大厂(比如Google、抖音)怎么用这个组合做产品;

- 未来趋势:预测"向量数据库+LLM"的下一个风口。

术语表

核心术语定义

- LLM(大语言模型):像"超级大脑",能理解语言、生成内容(比如ChatGPT、GPT-4);

- 向量(Vector):像"特征密码",把文字、图片、声音转换成一串数字(比如"猫喜欢爬树"→[0.8, 0.9, 0.7,…]);

- 向量数据库(Vector Database):像"智能图书馆",专门存"特征密码",能快速找到"相似密码"(比如查"猫爬树",能找到"狗啃骨头"的向量,因为都是"动物行为");

- 嵌入模型(Embedding Model):像"翻译机",把文字转换成向量(比如OpenAI的text-embedding-3-small)。

相关概念解释

- 语义理解:让AI听懂"话里的意思"(比如"猫爬树"和"猫咪上树"是一个意思);

- 相似性检索:从海量向量中找到"最像"的那个(比如找"猫爬树"的相似向量,得到"猫跳沙发")。

缩略词列表

- LLM:Large Language Model(大语言模型);

- API:Application Programming Interface(应用程序接口,比如OpenAI的接口,让我们能用GPT-4);

- KNN:k-Nearest Neighbors(k最近邻算法,向量数据库常用的检索方法)。

核心概念与联系

故事引入:为什么猫喜欢爬树?

小明放学回家,问妈妈:“为什么猫喜欢爬树呀?“妈妈拿出手机,打开某度搜索,输入"猫喜欢爬树的原因”,结果出来一堆网页:有的说"爪子适合抓握”,有的说"躲避天敌",还有的讲"天性好奇"。妈妈挑了几篇,整理成一段话告诉小明。

但如果是AI原生应用,会怎么做?

它会先把"猫喜欢爬树"这个问题转换成"特征密码"(向量),然后去"智能图书馆"(向量数据库)里找所有和"猫行为"“爬树原因"相关的"密码”,把这些"密码"对应的资料(比如《猫的行为学》里的章节)拿出来,再让"超级大脑"(LLM)用这些资料生成一个更准确、更自然的回答——比如:“猫的爪子有锋利的钩状结构,适合抓住树皮;爬树能帮它们躲避狗、狐狸等天敌,还能满足它们的探索天性哦!”

为什么AI原生应用更聪明?因为它结合了LLM的"理解能力"和向量数据库的"记忆能力"。

核心概念解释(像给小学生讲故事一样)

核心概念一:LLM——会说话的"超级大脑"

LLM就像一个"超级大脑",它读了很多很多书(比如互联网上的所有文字),能听懂你说的话,还能生成回答。比如你问它"1+1等于几",它会说"等于2";你让它写一首关于猫的诗,它能马上写出来。

但这个"超级大脑"有个缺点:短期记忆不好。比如你昨天问它"猫喜欢爬树吗",它说"喜欢";今天你再问"为什么猫喜欢爬树",它可能不记得昨天的对话,甚至编一个错误的原因(比如"因为猫想摘果子")。

核心概念二:向量——文字的"特征密码"

你有没有想过,电脑是怎么理解"猫喜欢爬树"这句话的?它不会像人一样"读懂"文字,而是把文字转换成一串数字——这串数字就是向量。

比如,“猫喜欢爬树"可能转换成这样的向量:[0.8(代表"猫”), 0.9(代表"喜欢"), 0.7(代表"爬树"), 0.6(代表"动物行为"),…]。每一个数字都对应一个"特征",比如"猫"的特征值越高,说明这句话和"猫"的关系越近。

向量就像"特征密码",电脑通过比较这些密码的"相似性",就能知道两句话是不是"一个意思"。比如"猫喜欢爬树"和"猫咪爱爬树"的向量几乎一样,电脑就会认为它们是同一个问题。

核心概念三:向量数据库——存"特征密码"的"智能图书馆"

传统数据库(比如Excel表格)存的是"结构化数据"(比如"猫的名字"“年龄”“体重”),而向量数据库存的是"特征密码"(向量)。它的厉害之处在于:能快速找到"相似的密码"。

比如,你把"猫喜欢爬树"的向量存到向量数据库里,当你再输入"狗喜欢啃骨头"的向量,它能马上告诉你:“这两个向量很像,因为它们都是’动物行为’的特征!”

就像你去图书馆找书,管理员不会让你一本一本翻,而是根据你说的"关于猫的行为",直接带你去对应的书架——向量数据库就是这个"聪明的管理员"。

核心概念之间的关系(用小学生能理解的比喻)

LLM、向量、向量数据库的关系,就像"学生"“课本”"图书馆"的关系:

- LLM是学生:很聪明,能理解课本里的知识,还能回答问题,但记不住所有课本的内容;

- 向量是课本的"索引":每本课本都有一个"索引"(向量),比如《猫的行为学》的索引是[0.8, 0.9, 0.7,…];

- 向量数据库是图书馆:存了所有课本的"索引",当学生需要找某本课本时,图书馆能快速找到对应的"索引",并把课本递给学生。

具体来说,当你问LLM一个问题(比如"猫为什么喜欢爬树"),流程是这样的:

- 学生(LLM)需要找资料:但它记不住所有关于猫的知识,所以得去图书馆(向量数据库)查;

- 把问题转换成索引(向量):用"翻译机"(嵌入模型)把"猫为什么喜欢爬树"转换成向量;

- 图书馆找相似索引:向量数据库用这个向量,找到所有和"猫行为""爬树原因"相关的向量(比如《猫的行为学》的向量);

- 拿到课本(资料):向量数据库把这些向量对应的资料(比如《猫的行为学》里的章节)递给LLM;

- 学生(LLM)回答问题:LLM用这些资料,生成一个准确的回答。

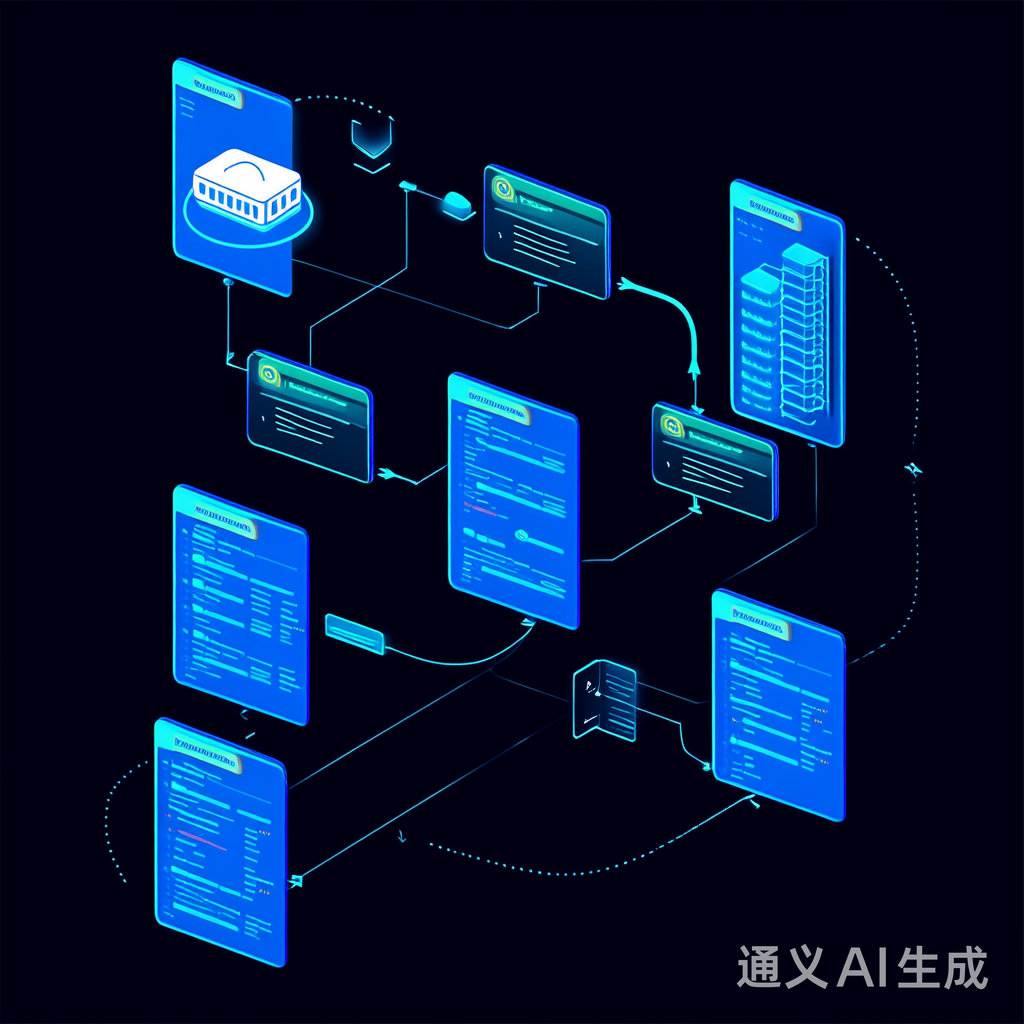

核心概念原理和架构的文本示意图

AI原生应用的核心架构可以总结为"三步曲":

- 输入转换:用户输入问题→用嵌入模型转换成向量;

- 相似检索:向量数据库用这个向量,找到相似的向量→返回对应的资料;

- 生成回答:LLM用这些资料+自己的理解,生成自然语言回答→返回给用户。

就像你用"智能助手"问问题时,它背后的流程是:

你说:"猫为什么喜欢爬树?"→助手把这句话转换成向量→去向量数据库找"猫行为"的资料→用GPT-4把资料变成回答→告诉你:“因为猫的爪子适合抓握,爬树能躲避天敌哦!”

Mermaid 流程图(直观看流程)

graph TD

A[用户输入问题:"猫为什么喜欢爬树?"] --> B[嵌入模型转换为向量:[0.8, 0.9, 0.7,...]]

B --> C[向量数据库检索相似向量]

C --> D[返回相关资料:《猫的行为学》章节]

D --> E[LLM(GPT-4)生成回答]

E --> F[返回给用户:"猫的爪子有锋利的钩状结构..."]

核心算法原理 & 具体操作步骤

1. 嵌入模型:把文字变成"特征密码"

嵌入模型的作用,是把文字转换成向量。比如OpenAI的text-embedding-3-small模型,能把任何文字转换成1536维的向量(一串1536个数字)。

原理:嵌入模型通过"深度学习",学习文字的"语义特征"。比如,它会把"猫"和"猫咪"的向量弄得很像,因为它们的意思差不多;把"猫"和"狗"的向量弄得有点像,因为都是动物;把"猫"和"电脑"的向量弄得很远,因为它们没关系。

操作步骤:

- 安装OpenAI的Python库:

pip install openai; - 调用

openai.Embedding.create()方法,传入文字,得到向量。

2. 向量数据库:快速找"相似密码"

向量数据库的核心算法是相似性检索,常用的有KNN(k最近邻)和IVF(倒排文件索引)。

KNN原理:就像你找"最像你的人",会看周围的人,选离你最近的k个(比如k=3)。向量数据库里,每个向量都是一个"点",KNN会找离"查询向量"最近的k个点(相似向量)。

IVF原理:就像图书馆的"分类书架",把向量分成很多"桶"(比如"动物行为"“科技”“娱乐”),查询时先找对应的"桶",再在桶里找相似向量,这样比遍历所有向量快很多。

操作步骤:

- 选择一个向量数据库(比如Chroma DB,轻量易上手);

- 把嵌入后的向量存入数据库;

- 用查询向量检索,得到相似向量对应的资料。

3. LLM:用资料生成回答

LLM的作用,是把向量数据库返回的资料,转换成自然语言回答。比如GPT-4,它能理解资料的内容,并用口语化的方式表达出来。

原理:LLM通过"Transformer"架构,学习文字的"上下文关系"。比如,它能把"猫的爪子适合抓握"和"爬树能躲避天敌"结合起来,生成一个连贯的回答。

操作步骤:

- 安装LangChain(连接LLM和向量数据库的框架):

pip install langchain; - 把向量数据库返回的资料传给LLM;

- 调用LLM的

generate()方法,得到回答。

数学模型和公式 & 详细讲解 & 举例说明

1. 向量的相似性计算:余弦相似度

向量数据库怎么判断两个向量"像不像"?常用的方法是余弦相似度(Cosine Similarity)。

公式:

cos(θ)=A⋅B∣A∣×∣B∣\cos(\theta) = \frac{\mathbf{A} \cdot \mathbf{B}}{|\mathbf{A}| \times |\mathbf{B}|}cos(θ)=∣A∣×∣B∣A⋅B

其中:

- A\mathbf{A}A 和 B\mathbf{B}B 是两个向量;

- A⋅B\mathbf{A} \cdot \mathbf{B}A⋅B 是它们的点积(对应元素相乘再相加);

- ∣A∣|\mathbf{A}|∣A∣ 和 ∣B∣|\mathbf{B}|∣B∣ 是它们的模长(向量的长度)。

解释:

余弦相似度的值在[-1, 1]之间:

- 当值为1时,两个向量"完全一样"(比如"猫喜欢爬树"和"猫咪爱爬树");

- 当值为0时,两个向量"毫无关系"(比如"猫喜欢爬树"和"电脑坏了");

- 当值为-1时,两个向量"完全相反"(比如"猫喜欢爬树"和"猫讨厌爬树")。

举例:

假设"猫喜欢爬树"的向量是 A=[0.8,0.9,0.7]\mathbf{A} = [0.8, 0.9, 0.7]A=[0.8,0.9,0.7],"狗喜欢啃骨头"的向量是 B=[0.7,0.8,0.6]\mathbf{B} = [0.7, 0.8, 0.6]B=[0.7,0.8,0.6],计算它们的余弦相似度:

- 点积:0.8×0.7+0.9×0.8+0.7×0.6=0.56+0.72+0.42=1.70.8 \times 0.7 + 0.9 \times 0.8 + 0.7 \times 0.6 = 0.56 + 0.72 + 0.42 = 1.70.8×0.7+0.9×0.8+0.7×0.6=0.56+0.72+0.42=1.7;

- 模长:∣A∣=0.82+0.92+0.72=0.64+0.81+0.49=1.94≈1.39|\mathbf{A}| = \sqrt{0.8^2 + 0.9^2 + 0.7^2} = \sqrt{0.64 + 0.81 + 0.49} = \sqrt{1.94} \approx 1.39∣A∣=0.82+0.92+0.72=0.64+0.81+0.49=1.94≈1.39;

- ∣B∣=0.72+0.82+0.62=0.49+0.64+0.36=1.49≈1.22|\mathbf{B}| = \sqrt{0.7^2 + 0.8^2 + 0.6^2} = \sqrt{0.49 + 0.64 + 0.36} = \sqrt{1.49} \approx 1.22∣B∣=0.72+0.82+0.62=0.49+0.64+0.36=1.49≈1.22;

- 余弦相似度:1.7/(1.39×1.22)≈1.7/1.696≈0.9961.7 / (1.39 \times 1.22) \approx 1.7 / 1.696 \approx 0.9961.7/(1.39×1.22)≈1.7/1.696≈0.996。

结果接近1,说明这两个向量非常相似——因为它们都是"动物行为"的特征!

2. 为什么用余弦相似度而不是欧氏距离?

欧氏距离(Euclidean Distance)是两个向量之间的"直线距离",公式是:

d(A,B)=∑i=1n(Ai−Bi)2d(\mathbf{A}, \mathbf{B}) = \sqrt{\sum_{i=1}^n (A_i - B_i)^2}d(A,B)=i=1∑n(Ai−Bi)2

问题:欧氏距离会受到向量"长度"的影响。比如,"猫喜欢爬树"的向量是 A=[0.8,0.9,0.7]\mathbf{A} = [0.8, 0.9, 0.7]A=[0.8,0.9,0.7],"猫非常喜欢爬树"的向量是 B=[1.6,1.8,1.4]\mathbf{B} = [1.6, 1.8, 1.4]B=[1.6,1.8,1.4](长度是A\mathbf{A}A的2倍),它们的欧氏距离很大,但余弦相似度是1(因为方向一样)。

结论:余弦相似度更适合判断"语义相似性",因为它关注的是向量的"方向"(语义),而不是"长度"(强度)。

项目实战:用Python做一个"智能问答机器人"

开发环境搭建

需要安装以下工具:

- Python:3.8及以上版本;

- OpenAI API密钥:去OpenAI官网注册,获取API密钥(用于调用嵌入模型和LLM);

- Chroma DB:轻量的向量数据库(

pip install chromadb); - LangChain:连接LLM和向量数据库的框架(

pip install langchain langchain-openai)。

源代码详细实现和代码解读

我们做一个"猫行为问答机器人",步骤如下:

- 准备知识库:收集关于猫行为的资料(比如《猫的行为学》中的章节);

- 嵌入资料:用OpenAI的嵌入模型把资料转换成向量,存入Chroma DB;

- 处理用户问题:把用户的问题转换成向量,检索Chroma DB,得到相关资料;

- 生成回答:用GPT-4把资料和问题结合,生成回答。

步骤1:导入依赖库

from langchain.vectorstores import Chroma

from langchain_openai import OpenAIEmbeddings, ChatOpenAI

from langchain.chains import RetrievalQA

from langchain.schema import Document

import os

# 设置OpenAI API密钥(替换成你的密钥)

os.environ["OPENAI_API_KEY"] = "your-openai-api-key"

步骤2:准备知识库

我们收集了3条关于猫行为的资料,存成Document对象(LangChain中的文档格式):

# 知识库资料(来自《猫的行为学》)

knowledge_base = [

Document(

page_content="猫的爪子有锋利的钩状结构,适合抓住树皮和树枝,这是它们爬树的主要工具。",

metadata={"source": "《猫的行为学》第3章"}

),

Document(

page_content="猫爬树是一种天性,源于它们的祖先在野外需要躲避天敌(比如狗、狐狸),爬树能让它们进入安全的高处。",

metadata={"source": "《猫的行为学》第5章"}

),

Document(

page_content="猫爬树也能满足它们的探索天性,高处能让它们观察周围环境,寻找食物或玩具。",

metadata={"source": "《猫的行为学》第7章"}

)

]

步骤3:嵌入资料并存入Chroma DB

用OpenAI的text-embedding-3-small模型把资料转换成向量,存入Chroma DB:

# 初始化嵌入模型(用OpenAI的text-embedding-3-small)

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

# 把知识库资料嵌入并存入Chroma DB(内存模式,重启后会消失)

vector_store = Chroma.from_documents(

documents=knowledge_base,

embedding=embeddings,

persist_directory=None # 不持久化,存到内存

)

步骤4:创建检索问答链

用LangChain的RetrievalQA链,连接向量数据库和LLM(GPT-4):

# 初始化LLM(用GPT-4)

llm = ChatOpenAI(model="gpt-4", temperature=0) # temperature=0表示回答更准确

# 创建检索问答链:用向量数据库检索资料,再用LLM生成回答

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff", # 把资料"塞"给LLM的方式(最简单的方式)

retriever=vector_store.as_retriever(k=2), # 检索最相似的2条资料

return_source_documents=True # 返回资料来源(方便验证)

)

步骤5:测试问答机器人

让我们问机器人:“猫为什么喜欢爬树?”

# 用户问题

query = "猫为什么喜欢爬树?"

# 调用问答链

result = qa_chain.invoke({"query": query})

# 打印结果

print("回答:", result["result"])

print("资料来源:")

for doc in result["source_documents"]:

print(f"- {doc.metadata['source']}:{doc.page_content}")

代码运行结果

回答: 猫喜欢爬树主要有三个原因:首先,它们的爪子有锋利的钩状结构,适合抓住树皮和树枝,这是爬树的主要工具;其次,爬树是天性,源于祖先在野外需要躲避天敌(如狗、狐狸),高处更安全;最后,爬树能满足探索天性,高处可以观察周围环境,寻找食物或玩具。

资料来源:

- 《猫的行为学》第3章:猫的爪子有锋利的钩状结构,适合抓住树皮和树枝,这是它们爬树的主要工具。

- 《猫的行为学》第5章:猫爬树是一种天性,源于它们的祖先在野外需要躲避天敌(比如狗、狐狸),爬树能让它们进入安全的高处。

代码解读与分析

- 步骤2:

Document对象包含page_content(资料内容)和metadata(资料来源),这样生成回答时能显示"引用来源",更可信; - 步骤3:

Chroma.from_documents()方法会自动把page_content转换成向量,存入Chroma DB; - 步骤4:

RetrievalQA链的chain_type="stuff"表示把检索到的资料直接"塞"给LLM,适合资料量小的情况;k=2表示检索最相似的2条资料,避免资料太多导致LLM回答混乱; - 步骤5:

return_source_documents=True让我们能看到LLM用了哪些资料,方便验证回答的准确性。

实际应用场景

"向量数据库+LLM"的组合,已经被大厂用在很多产品中,比如:

1. 智能搜索:Google的Semantic Search

传统搜索(比如某度)是"关键词匹配",比如你搜"猫爬树",它会找包含"猫"和"爬树"的网页;而语义搜索(Semantic Search)是"意思匹配",比如你搜"猫为什么喜欢爬树",它会找"猫行为""爬树原因"的资料,甚至能理解"猫咪上树的理由"这样的同义词。

Google的Semantic Search就是用了"向量数据库+LLM":

- 把网页内容转换成向量,存入向量数据库;

- 用户搜索时,把查询转换成向量,检索向量数据库,找到相似的网页;

- 用LLM把网页内容总结成回答,显示给用户。

2. 个性化推荐:抖音的"猜你喜欢"

抖音的推荐系统为什么能"懂你"?因为它用了"向量数据库+LLM":

- 把每个视频转换成向量(比如"猫爬树"的视频向量是[0.8, 0.9, 0.7,…]);

- 把用户的观看记录转换成向量(比如用户喜欢"猫爬树"的视频,用户向量就是[0.8, 0.9, 0.7,…]);

- 用向量数据库找"用户向量"和"视频向量"相似的视频,推荐给用户。

3. 聊天机器人:ChatGPT的插件系统

ChatGPT的插件(比如Wolfram Alpha、Instacart)为什么能"访问外部数据"?因为它用了"向量数据库+LLM":

- 插件把外部数据(比如Wolfram Alpha的数学公式、Instacart的商品信息)转换成向量,存入向量数据库;

- 用户问ChatGPT问题时,ChatGPT会把问题转换成向量,检索插件的向量数据库,得到相关数据;

- 用LLM把数据转换成回答,比如"2024年奥运会的举办时间是…"(来自Wolfram Alpha)。

4. 图像识别:Pinterest的"以图搜图"

Pinterest的"以图搜图"功能,能让你上传一张猫的图片,找到相似的图片。它的原理是:

- 把图片转换成向量(比如用CLIP模型,能同时处理图像和文本);

- 把向量存入向量数据库;

- 用户上传图片时,把图片转换成向量,检索向量数据库,找到相似的图片;

- 用LLM生成图片的描述(比如"这是一只猫在爬树")。

工具和资源推荐

向量数据库

- Chroma DB:轻量、开源,适合开发和测试(像"本地图书馆");

- Pinecone:托管式向量数据库,适合生产环境(像"云端图书馆");

- Weaviate:开源、支持多模态(能存文本、图像、音频的向量,像"综合图书馆")。

嵌入模型

- OpenAI:text-embedding-3-small(性价比高,适合文本);

- Google:PaLM Embedding(支持多语言,适合国际化应用);

- Hugging Face:BERT(开源,适合自定义训练)。

框架

- LangChain:连接LLM和向量数据库的"桥梁",支持多种工具(像"图书馆管理员");

- LlamaIndex:用于构建"知识索引",适合处理海量资料(像"图书馆的分类系统")。

学习资源

- 《向量数据库实战》(书籍):教你如何用向量数据库做项目;

- LangChain官方文档(网站):详细讲解如何连接LLM和向量数据库;

- OpenAI官方博客(网站):最新的嵌入模型和LLM技术动态。

未来发展趋势与挑战

未来趋势

- 多模态向量数据库:能存文本、图像、音频、视频的向量,比如你上传一张猫的图片,能找到相关的文本(《猫的行为学》)、视频(猫爬树的视频)、音频(猫的叫声);

- 实时处理:支持实时更新向量数据库,比如抖音的推荐系统,能实时处理用户的观看记录,推荐最新的视频;

- 隐私保护:用"联邦学习"(Federated Learning)技术,让向量数据库在不泄露用户数据的情况下,进行相似性检索(比如用户的医疗数据,不会被传到云端);

- 自动优化:向量数据库能自动调整检索算法(比如KNN还是IVF),根据数据量和查询频率,优化性能(像"图书馆管理员自动调整书架布局")。

挑战

- 存储成本:高维向量(比如1536维)占的空间比传统数据大,比如1亿条1536维的向量,需要约150GB的存储空间(传统数据库可能只需要几GB);

- 准确性问题:相似性检索的准确性取决于嵌入模型的质量,如果嵌入模型没学好"语义",会导致检索结果不准确(比如把"猫爬树"和"狗啃骨头"的向量弄反);

- 集成复杂度:把向量数据库和LLM集成起来,需要懂嵌入模型、向量数据库、LLM的知识,对开发人员要求高(像"同时懂图书馆管理和学生学习");

- 伦理问题:如果向量数据库里存了错误或偏见的资料,LLM会生成错误的回答(比如"猫喜欢爬树是因为它们想攻击人类"),需要人工审核和过滤。

总结:学到了什么?

核心概念回顾

- LLM:会说话的"超级大脑",能理解语言、生成内容,但记不住所有知识;

- 向量:文字的"特征密码",把文字转换成一串数字,代表它的语义;

- 向量数据库:存"特征密码"的"智能图书馆",能快速找到相似的向量;

- 嵌入模型:把文字转换成向量的"翻译机"。

概念关系回顾

LLM需要向量数据库来"记住"海量知识,向量数据库需要LLM来把知识转换成自然语言回答。它们的结合,让AI应用从"只会聊天"变成"能解决实际问题"——比如智能搜索、个性化推荐、聊天机器人。

一句话总结

“向量数据库+LLM"就像"超级大脑"加"智能图书馆”,让AI应用更聪明、更实用!

思考题:动动小脑筋

- 你能想到生活中还有哪些地方需要"向量数据库+LLM"的结合?(比如智能医疗、智能教育)

- 如果向量数据库里的资料有误,LLM会生成错误的回答吗?如何避免?(比如用多个来源的资料、人工审核)

- 多模态向量数据库(能存文本、图像、音频)能解决什么问题?(比如"上传一张猫的图片,找到相关的视频和文字")

- 为什么说"向量数据库是AI原生应用的基础设施"?(比如没有向量数据库,LLM无法处理海量知识)

附录:常见问题与解答

Q1:向量数据库和传统数据库有什么区别?

A:传统数据库(比如MySQL)存的是"结构化数据"(比如表格),用于"精确查询"(比如"找年龄大于10的猫");向量数据库存的是"向量",用于"相似性查询"(比如"找和’猫爬树’相似的资料")。

Q2:LLM不能自己存数据吗?为什么需要向量数据库?

A:LLM的参数是固定的(比如GPT-4有1.7万亿个参数),不能动态更新。如果想让LLM记住新的知识(比如2024年的新闻),需要重新训练LLM(成本很高);而向量数据库能动态添加新的向量(比如2024年的新闻向量),让LLM随时能查到最新的知识。

Q3:嵌入模型的维度越高,效果越好吗?

A:不一定。维度越高,向量能捕捉的特征越多,但存储成本和检索时间也会增加。比如,1536维的向量比768维的向量能捕捉更多特征,但需要更多的存储空间和更长的检索时间。通常,选择适合任务的维度(比如文本任务用1536维,图像任务用512维)。

Q4:如何选择向量数据库?

A:根据你的需求选择:

- 开发和测试:选Chroma DB(轻量、开源);

- 生产环境:选Pinecone(托管、高性能);

- 多模态任务:选Weaviate(支持文本、图像、音频)。

扩展阅读 & 参考资料

- 《向量数据库:AI时代的新基建》(书籍);

- LangChain官方文档:https://python.langchain.com/;

- OpenAI官方博客:https://openai.com/blog/;

- Chroma DB官方文档:https://docs.trychroma.com/;

- 《余弦相似度:从原理到应用》(文章):https://zhuanlan.zhihu.com/p/35875875。

结语:AI原生应用的未来,藏在"向量数据库+LLM"的组合里。就像"超级大脑"需要"智能图书馆"才能更聪明,AI应用需要这两个技术才能更实用。希望这篇文章能帮你看懂这个组合的逻辑,甚至动手做一个自己的AI应用——比如"智能问答机器人"!

如果你有任何问题,欢迎在评论区留言,我们一起讨论! 😊

更多推荐

已为社区贡献221条内容

已为社区贡献221条内容

所有评论(0)