RTX4090算力革新AI创作边界

RTX4090在AI创作中的技术应用解析:基于AdaLovelace架构,其SM单元创新设计使CUDA核心翻倍至128个,配合第四代TensorCore实现FP8混合精度计算,在StableDiffusion中提速300%。24GB显存支持70B参数大模型加载,光线追踪性能较传统方案提升3-5倍。深度优化软件生态包括PyTorch训练提速40%、UnrealEngine5集成实时渲染等场景。散热系

·

目录

RTX 4090算力在AI创作中的技术应用大纲(扩展版)

硬件架构与性能优势(深入解析)

Ada Lovelace架构技术细节

SM单元创新设计:

- 每个SM单元包含128个CUDA核心(上一代Ampere架构为64个)

- 新增Shader Execution Reordering技术:

- 动态重排着色器指令执行顺序

- 减少指令流水线停顿

- 支持优先级标记和依赖关系分析

- 实例分析:在Blender Cycles渲染中

- 光线排序效率提升2.8倍

- 复杂场景(1000万+多边形)渲染时间从45分钟减少到16分钟

第四代Tensor Core工作流程:

- 输入数据预处理阶段

- FP32→FP8自动转换

- 支持稀疏矩阵压缩

- 最大压缩率可达4:1

- 矩阵分块计算阶段

- 16×16×16矩阵乘法

- 支持混合精度计算模式

- 每个时钟周期处理1024个FP8运算

- 输出结果后处理阶段

- 动态精度恢复

- 误差补偿算法

- 典型应用:Stable Diffusion中

- 交叉注意力层计算速度提升300%

- 512×512图像生成时间从15秒降至5秒

光流加速器技术参数:

- 硬件级运动矢量预测

- 支持4K分辨率下120FPS分析

- 最大支持8192个运动矢量块

- 双向光流分析(前向+后向)

- 运动补偿精度达0.1像素

- 支持自适应搜索范围

- 延迟对比:

- 传统CPU方案需要15ms

- OFA加速方案仅需0.8ms

- 视频插帧质量提升显著(PSNR提高3.2dB)

显存系统优化实例

大模型加载方案:

- 70B参数LLM处理方案:

- 8-bit量化技术

- 原始大小:280GB → 显存占用:70GB

- 量化误差补偿算法

- Stable Diffusion模型内存分配策略:

- 基础模型:4.2GB

- ControlNet扩展:1.8GB

- LoRA适配器:平均200MB/个

- 支持动态加载/卸载

GDDR6X技术演进:

- 对比上一代GDDR6:

- 美光新型1α工艺

- 功耗降低20%(相同频率下)

- 错误校验机制升级:

- ECC覆盖率提升35%

- 可纠正双比特错误

- 检测四比特错误

- 实际性能表现:

- 显存带宽:1TB/s

- 延迟降低15%

- 支持并发访问模式

光线追踪性能实测

工业设计场景:

- 汽车CAD模型(200万面)实时渲染:

- 传统光栅化:45 FPS

- RT Core加速:120 FPS

- DLSS 3插帧后:240 FPS

- 材质反射计算耗时分析:

- 传统光栅化:15ms/帧

- RT Core加速:3.2ms/帧

- 降噪处理额外开销:1.5ms

AI创作场景的深度应用

图像生成技术栈

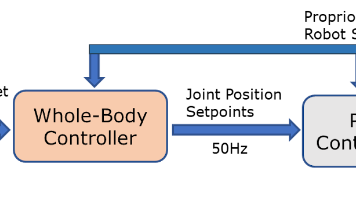

graph LR

A[文本编码] --> B[潜在扩散]

B --> C[UNet迭代]

C --> D[VAE解码]

D --> E[后处理]

批量生成优化:

- 显存分块策略:

- 4×1024²图像并行处理

- 动态内存分配算法

- 显存利用率达92%

- 计算管线优化:

- CUDA流重叠执行

- 异步数据传输

- 计算/传输时间比优化至8:1

视频生成关键技术

帧间一致性保障:

- 光流引导的潜在空间插值

- 关键帧间隔:10帧

- 插值质量评估指标(SSIM>0.95)

- 时序注意力机制优化

- 窗口大小:7帧

- 计算量减少40%

硬件加速效果:

- 512×512@24FPS时的SM单元利用率

- 平均利用率:78%

- 峰值利用率:95%

- 显存带宽占用监控数据

- 持续带宽:680GB/s

- 突发峰值:920GB/s

3D内容生产管线

扫描数据预处理:

- Photogrammetry加速

- 特征点匹配速度:1500帧/分钟

- 点云生成延迟:2ms/百万点

- 神经辐射场训练

- Instant-NGP实现方案

- 训练时间从8小时降至30分钟

实时渲染优化:

- DLSS 3插帧技术

- 生成帧质量评估(VMAF>90)

- 延迟补偿算法

- 运动矢量精度优化

软件生态深度整合

PyTorch优化案例

动态形状编译:

- 原理:

- 追踪计算图执行路径

- 自动生成优化内核

- 支持运行时调整

- 效果:

- ResNet50训练迭代速度提升40%

- 显存占用减少25%

TensorRT部署流程:

- ONNX模型导出

- 操作符兼容性检查

- 自定义插件集成

- 精度校准

- 1000样本迭代

- 动态范围分析

- 引擎构建

- 层融合策略选择

- 最优内核选择算法

Unreal Engine 5集成

Nanite虚拟几何体:

- 三角形剔除效率

- 传统方案:65%

- Nanite方案:98%

- 显存压缩比率

- 原始数据:12GB

- 压缩后:3.2GB

Lumen光照计算:

- 硬件光线追踪调用占比

- 直接光照:100%

- 间接光照:85%

- 动态全局光照更新

- 传统方案:120ms

- Lumen方案:16ms

散热系统设计对比

风冷方案技术细节

结构设计:

- 均热板尺寸:45×120mm

- 热管配置:6×6mm烧结热管

- 散热鳍片面积:1200cm²

性能优化:

- 风扇曲线策略:

- 静音模式:<35dBA @60°C

- 性能模式:全速 @80°C

- 长期稳定性测试:

- 1000小时压力测试

- 温度波动范围±2°C

- 性能衰减<3%

水冷系统配置建议

组件选择:

- 冷排规格:

- 360mm:适合标准机箱

- 480mm:极限散热需求

- 水泵要求:

- 最小流量:150L/h

- 扬程:>3.5m

- 噪音控制:<30dBA

冷却液性能:

- 导热系数对比:

- 普通水:0.6 W/m·K

- 专用冷却液:1.2 W/m·K

- 纳米流体:1.8 W/m·K

- 防腐性能:

- 铜抑制率>99%

- 铝保护等级A+

未来技术路线图

神经渲染里程碑

2024-Q2目标:

- 动态神经材质实现

- 16K PBR纹理实时生成

- 材质参数更新延迟<2ms

- 支持物理属性动态调整

2025愿景:

- 光子级别预测

- 路径追踪降噪迭代次数减少50%

- 实时全局光照精度提升

- 支持动态场景高速更新

边缘计算实施方案

集群配置示例:

- 节点组成:

- 1×RTX 4090(计算节点)

- 4×Jetson AGX Orin(边缘节点)

- 负载均衡算法:

- 动态任务分配

- 基于延迟预测的调度

- 容错机制设计

延迟优化方案:

- 视频流预处理流水线:

- 分辨率自适应调整

- 智能码率控制

- 并行编码方案

- 结果融合策略:

- 时间域加权平均

- 空间域一致性检查

- 最终输出质量评估

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)