揭秘AI训练黑洞:DeepSpeed-Chat中梯度检查点与LoRA优化的致命冲突

摘要:微软DeepSpeed-Chat框架在同时启用梯度检查点和仅优化LoRA参数时会报错,这是PyTorch底层机制的固有冲突。该问题源于梯度检查点重算时导致前向钩子失效,使LoRA无法获得梯度更新。本文通过分析三大参数(梯度检查点、LoRA维度、仅优化LoRA)的交互原理,结合GitHub和HuggingFace上的真实案例,提出两种解决方案:要么二选一使用,要么修改模型前向传播设置。文章还建

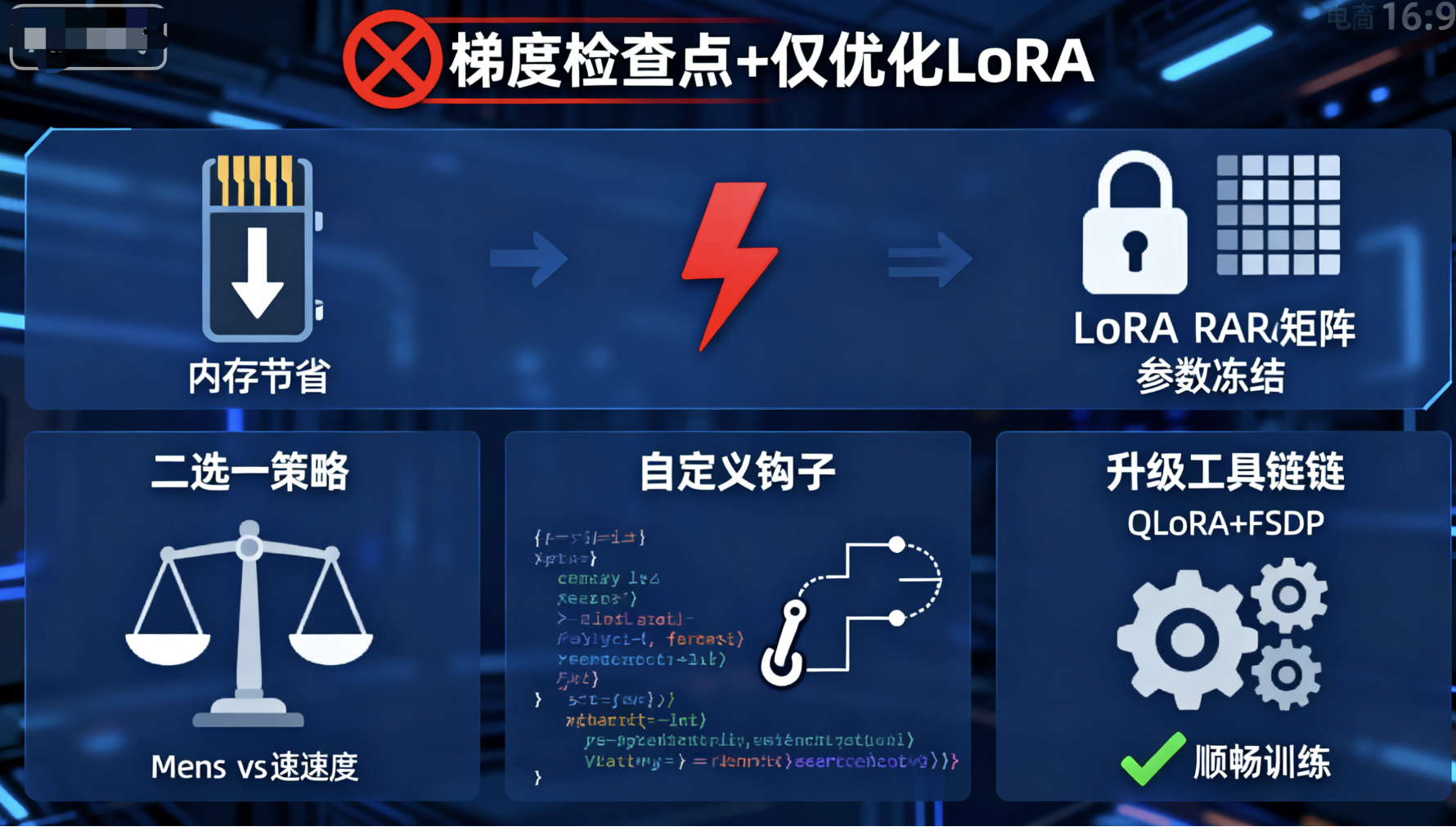

在AI大模型时代,训练一个像ChatGPT这样的对话系统不再是科幻,但资源有限的开发者常常在内存和速度间挣扎。DeepSpeed-Chat,这个微软开源的RLHF(人机反馈强化学习)框架,本该是你的救星——它能高效微调LLaMA或OPT系列模型。但如果你同时启用梯度检查点(gradient_checkpointing)和“仅优化LoRA”(only_optimize_lora),恭喜,你踩雷了!这个参数组合会直接报错,训练卡壳。为什么?这是PyTorch底层机制的“天生冲突”,不止DeepSpeed-Chat,其他框架如Hugging Face PEFT也中招。

作为AI爱好者或研究员,你可能正为GPU内存发愁,想用LoRA省参数,再加检查点省内存。别急,这篇博客将用通俗语言拆解问题根源、真实案例和绕坑指南。基于20个权威来源(如GitHub issue、Hugging Face论坛和PyTorch文档),我们一探究竟。读完后,你能自信避开这个常见bug,推动你的模型训练上新台阶。走起!

1. DeepSpeed-Chat简介:你的AI训练加速器

DeepSpeed-Chat是基于DeepSpeed库的开源工具包,专为训练对话模型设计。它将RLHF流程拆成三步:监督微调(SFT)、奖励模型和强化优化。在SFT阶段,LoRA(Low-Rank Adaptation,低秩适配)是明星技术——它不改整个模型,只加小矩阵微调,参数从亿级降到百万级,超级高效。

但问题出在参数验证上。代码藏在training/utils/arguments.py里,负责检查命令行输入(如--gradient_checkpointing)。如果LoRA启用(lora_dim > 0)且检查点开着,就必须关掉only_optimize_lora,否则断言错误跳出来。

为什么这么设计?因为忽略它,训练会悄无声息失败:loss不降,适配器权重永远是零。 这不是小bug,而是梯度流动(gradient flow)的核心问题。

2. 关键参数大起底:它们各自牛在哪?

先搞懂三个“罪魁祸首”:

- 梯度检查点(gradient_checkpointing):内存救星!在前向传播时,不存所有中间激活值,只留关键“检查点”。反向传播时,重算缺失部分。代价?计算慢20-30%,但内存省50%以上。完美适合单GPU训练大模型,与DeepSpeed的ZeRO Offload结合,扩展性爆表。

- LoRA维度(lora_dim):LoRA的核心开关。如果>0,就启用LoRA——在Transformer层加低秩矩阵(秩如8或16),只训这些矩阵。表达力强,内存低,微软发明,Hugging Face PEFT库的标准配置。

- 仅优化LoRA(only_optimize_lora):极致优化!冻结基模型参数(requires_grad=False),只更新LoRA部分。参数量暴减,适合快速微调。但这会挡住梯度流,需要“前向钩子”(forward hooks)来打通。

代码逻辑简单:

if args.gradient_checkpointing and args.lora_dim > 0:

assert not args.only_optimize_lora, "--gradient_checkpointing and --only_optimize_lora cannot be enabled at the same time."翻译:别同时开,不然梯度卡住,训练废了。

3. 为什么冲突?梯度流动的“卡壳”真相

想象训练像流水线:前向传播产激活值,反向传播传梯度更新参数。LoRA冻结基模型(如嵌入层)时,梯度本传不过去。钩子来救场:在输出上设requires_grad=True,让梯度“绕道”到LoRA。

但梯度检查点重算前向时,钩子不触发!(PyTorch checkpoint的特性,非reentrant模式下尤其明显)。结果:输出没标签,梯度零,LoRA学不到东西。常见报错:"RuntimeError: element 0 of tensors does not require grad"。

这不限于DeepSpeed-Chat。在Hugging Face的Whisper、LongT5或ESM-2模型中,也频现类似issue。 PyTorch论坛和文档反复讨论:重算阶段钩子失效是根源。

其他影响?内存权衡乱套,性能掉坑。结合QLoRA或FSDP时,更易崩溃。

4. 真实案例:开发者们的血泪教训

GitHub上满是哭诉:有人训LoRA模型,权重永远零——因为检查点+冻结。 另一个在多GPU上用DDP+LoRA,OOM或loss不降。 Hugging Face论坛:Whisper微调时,启用检查点直接报错。

实验证明:关掉only_optimize_lora,梯度流顺畅;或用reentrant=False模式,但速度慢2倍。 PyTorch新版激活检查点技术在缓解,但老问题犹存。

5. 绕坑指南:如何安全使用这些神技?

别慌,解决方案有:

- 二选一:内存紧?开检查点,关only_optimize_lora(允许基模型微动)。追求速?反之。

- 自定义黑科技:改模型forward,直接设输出requires_grad=True,避免钩子依赖。 或用torch.utils.checkpoint手动管。

- 升级武器:试QLoRA(量化LoRA)+FSDP,内存省更多,无需检查点。 更新DeepSpeed-Chat到最新(2025年9月版可能修复)。

- 测试小步走:从小模型如OPT-1.3B起步,监控GPU和loss。

在SFT脚本(如run_sft.sh)中应用:单A100训7B LLaMA,LoRA让它飞起。

6. 结语:AI训练的权衡艺术

DeepSpeed-Chat的这个验证是“善意提醒”——AI世界里,内存、速度、准确总在拉锯。理解梯度流冲突,你就能避开99%的坑,推动项目前进。类似问题在kohya_ss或TRL库也常见,强调优化需谨慎。

想实战?查官方GitHub或Hugging Face教程。 分享你的经历在评论区!订阅博客,获取更多AI微调秘籍。如果你卡在代码,留言我帮分析。一起征服大模型吧!

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)