零代码AI革命:万字实战指南,用Dify轻松构建企业级智能知识库

现在,轮到你来思考,如何利用这对强大的工具,去解决你所面临的问题,去创造属于你自己的价值了。幸运的是,主流的云服务商(如本文演示所用的平台)通常会提供预装了常用应用的“镜像市场”。知识库准备就绪,模型也已接入,现在我们需要将它们串联起来,设计一个完整的工作流程 (Workflow),告诉 AI 在收到用户问题后,应该如何一步步地思考和行动。我们直接在云服务器控制台进行重装或创建实例的操作,在选择操

前言

在当今这个信息爆炸的时代,数据已成为企业和个人的核心资产。然而,如何从浩如烟海的文档、报告、手册和笔记中,高效、精准地提取所需信息,已成为一个普遍存在的痛点。传统的关键词搜索,面对复杂和口语化的查询时常常显得力不从心,无法真正理解用户的深层意图。我们迫切需要一种更智能、更接近自然语言交互的解决方案。

当下普遍存在的几大痛点:

- 知识孤岛与检索困境: 企业内部的知识散落在不同的系统(如 Confluence, SharePoint, 本地文件夹)中,形成一个个信息孤岛。员工,尤其是新员工,为了找到一个问题的答案,可能需要在多个平台之间来回切换,耗费大量时间,效率低下。

- AI 技术应用门槛高昂: 大语言模型(LLM)的出现为解决上述问题带来了曙光。但对于大多数非 AI 专业的开发者和中小企业而言,从零开始部署、微调、管理一个大模型,并将其封装成可用的应用,涉及到复杂的后端开发、算法知识、GPU 资源管理和高昂的运维成本,是一项几乎不可能完成的任务。

- 模型性能与成本的博弈: 直接使用顶级模型的官方 API,虽然性能有保障,但其高昂的调用费用在规模化应用场景下会成为一笔巨大的开销。而寻找开源模型自行部署,又会陷入前述的技术门槛和运维困境中。如何在性能与成本之间找到最佳平衡点,是所有决策者面临的难题。

- 应用的僵化与定制难题: 许多成品的知识库软件功能固化,难以根据企业自身的业务流程进行定制化改造。例如,企业可能希望 AI 助手在回答问题的同时,还能调用内部 API 查询实时数据或执行特定操作,这种深度定制的需求往往难以被满足。

为了彻底解决这些痛点,本文将通过一个详尽的实战案例——从零开始搭建一个专属的《哈利·波特》全书知识问答系统——来展示如何将低代码 AI 应用开发平台 Dify 与高性能、高性价比的 蓝耘 MaaS (Model as a Service) 平台 完美结合,一站式构建出满足个性化需求的 AI 智能助手。这不仅仅是一个有趣的演示,其背后蕴含的方法论和技术栈,可以直接平移到企业内部文档、产品手册、法律条文、个人知识库等任何领域。

第一章:奠定基石 —— Dify 平台的云端快速部署

工欲善其事,必先利其器。构建 AI 应用的第一步,是拥有一个稳定、可扩展的开发与运行环境。Dify 作为一个功能强大的 AI 应用编排平台,我们选择将其部署在云服务器上,以获得最佳的性能、稳定性和可访问性。

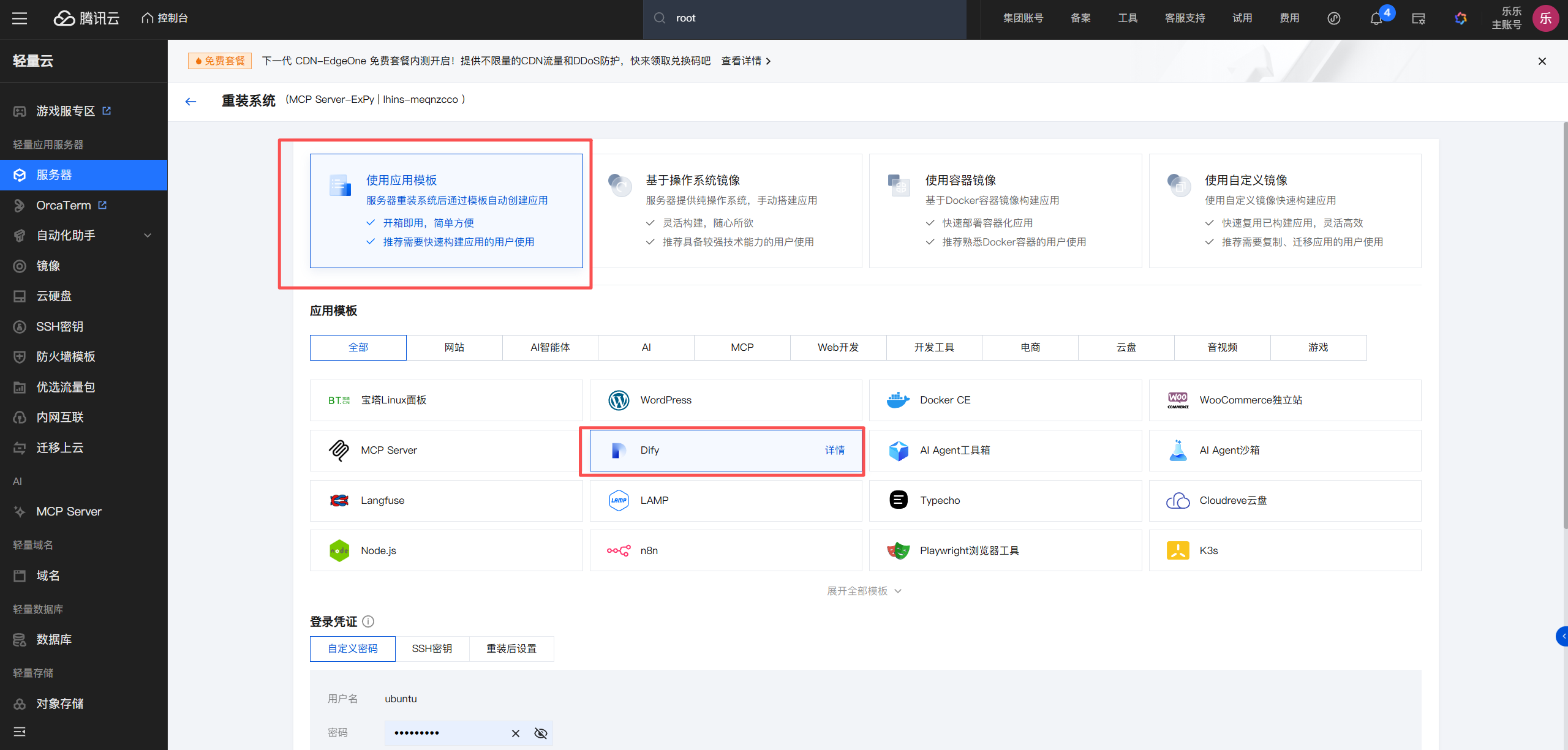

1. 云服务器选型与 Dify 镜像的妙用

对于初学者而言,从零开始在服务器上配置 Dify 的运行环境(包括 Docker、数据库等)是一项繁琐且容易出错的工作。幸运的是,主流的云服务商(如本文演示所用的平台)通常会提供预装了常用应用的“镜像市场”。

我们直接在云服务器控制台进行重装或创建实例的操作,在选择操作系统镜像时,放弃传统的 CentOS 或 Ubuntu,直接在镜像市场中搜索并选择“Dify”。

选择预装 Dify 镜像的好处是显而易见的:它将 Dify 运行所需的所有软件、依赖库和基础配置都打包在了一起。你无需执行任何复杂的命令行操作,服务器实例创建完成后,一个“开箱即用”的 Dify 环境就已经为你准备好了。这大大降低了入门门槛,让你能将精力完全集中在 AI 应用的构建上。

2. 访问 Dify 并完成初始化设置

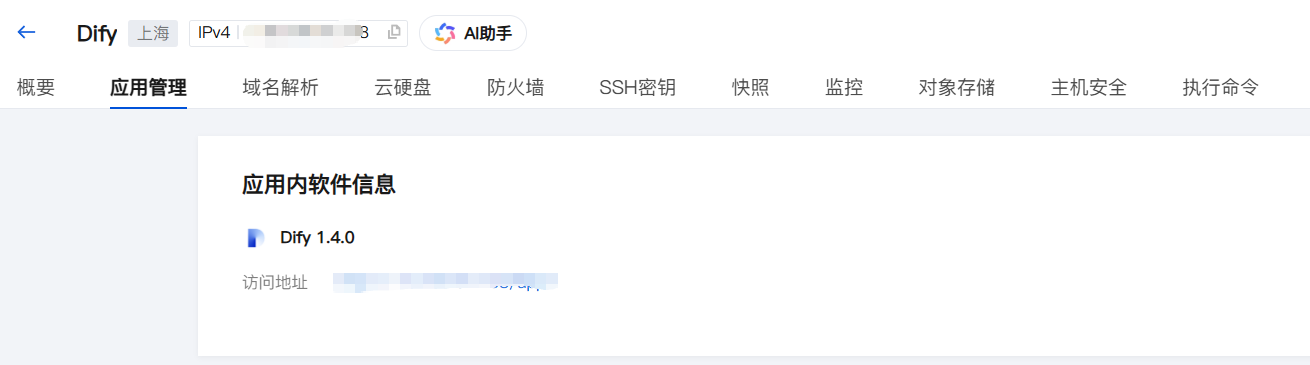

等待云服务器实例成功创建后,在服务器列表中点击进入该实例的详情页。

在实例详情页中,找到“应用管理”或类似的标签页。这里通常会展示预装应用的相关信息,最关键的就是 Dify 的后台访问地址。

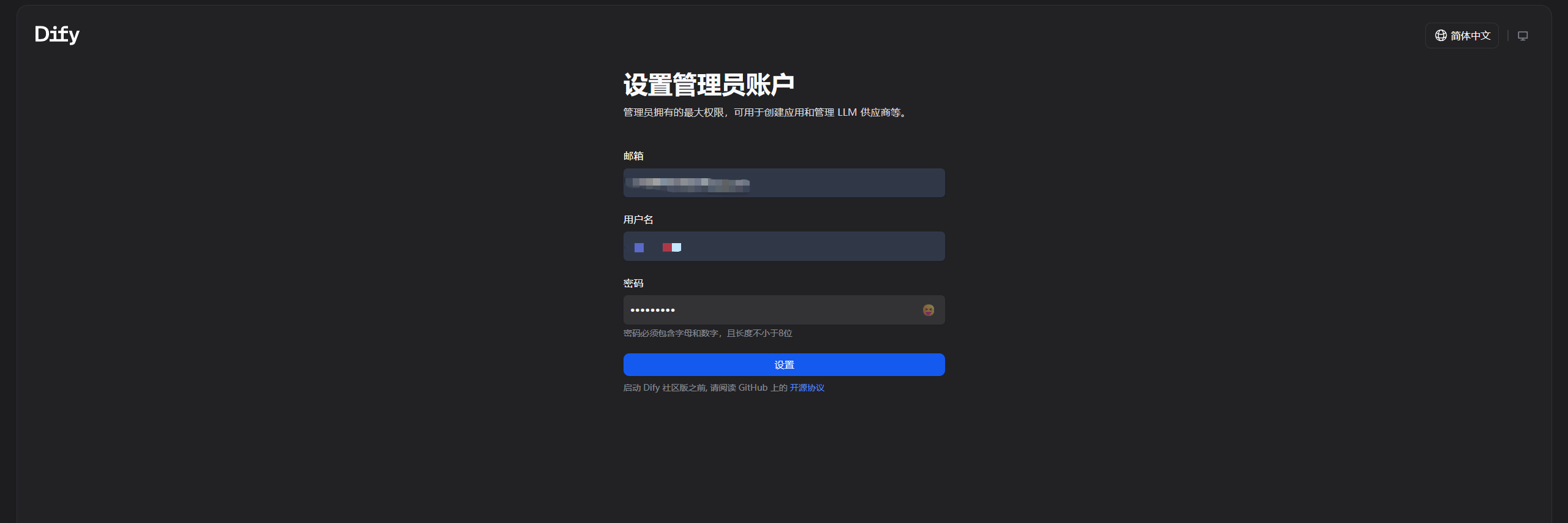

点击该访问地址,浏览器将带你进入 Dify 的初始化界面。首次访问时,系统会引导你创建一个管理员账户。请务必填写真实有效的邮箱,并设置一个安全的密码。这个账户将是你管理整个 Dify 平台、创建和维护所有 AI 应用的最高权限账户。

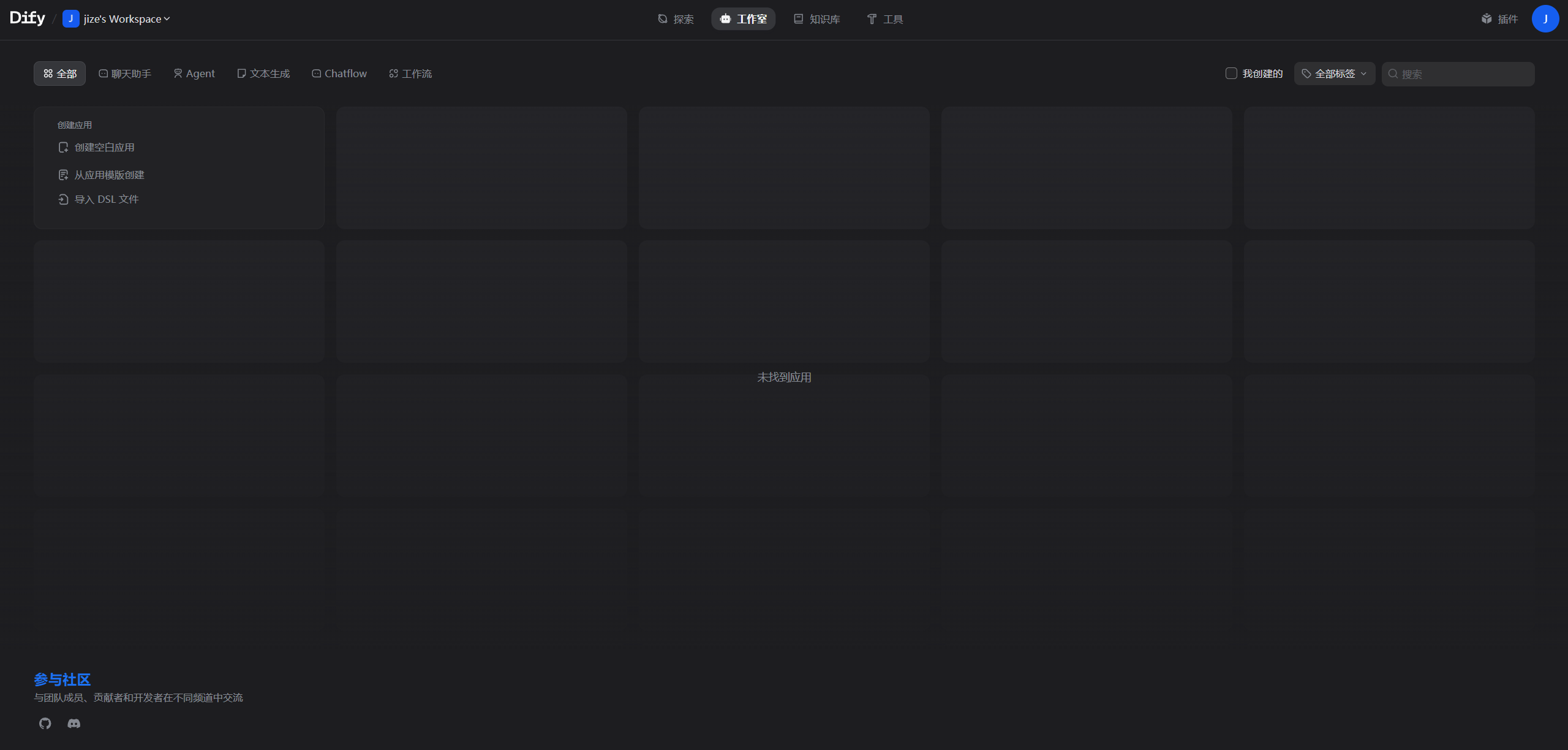

成功登录后,你将看到 Dify 的主界面。这是一个设计简洁且功能强大的工作台,你可以在这里开始探索和构建你的第一个 AI 应用了。

至此,我们的 AI 应用开发平台已经稳固地建立在云端,随时可以接入强大的语言模型,开始真正的创造之旅。

第二章:注入灵魂 —— 对接蓝耘 MaaS 平台的高性能大模型

Dify 如同一个精密的“大脑框架”,它擅长编排逻辑、管理数据和呈现交互,但真正的“思考”能力——也就是自然语言理解与生成——需要由大语言模型(LLM)来提供。Dify 支持接入多种模型供应商,而在这里,我们选择蓝耘 MaaS 平台作为我们 AI 应用的“动力引擎”。

选择蓝耘的核心原因在于其精准地解决了性能与成本的博弈难题:

- 极致的速度体验: 在问答、对话等交互式应用场景中,模型的响应速度直接决定了用户体验。一个需要等待数秒才有回应的机器人是难以接受的。蓝耘通过在国内部署的优化推理集群和高效的 API 网关,提供了毫秒级的接口响应速度,确保了对话的流畅自然。

- 卓越的成本效益: 蓝耘通过模型推理的批量处理和资源复用技术,大幅降低了单个 API 请求的成本。相比直接使用官方按Token计费的高昂价格,蓝耘为开发者提供了更具竞争力的定价,使得大规模、高频次的 AI 应用落地成为可能。

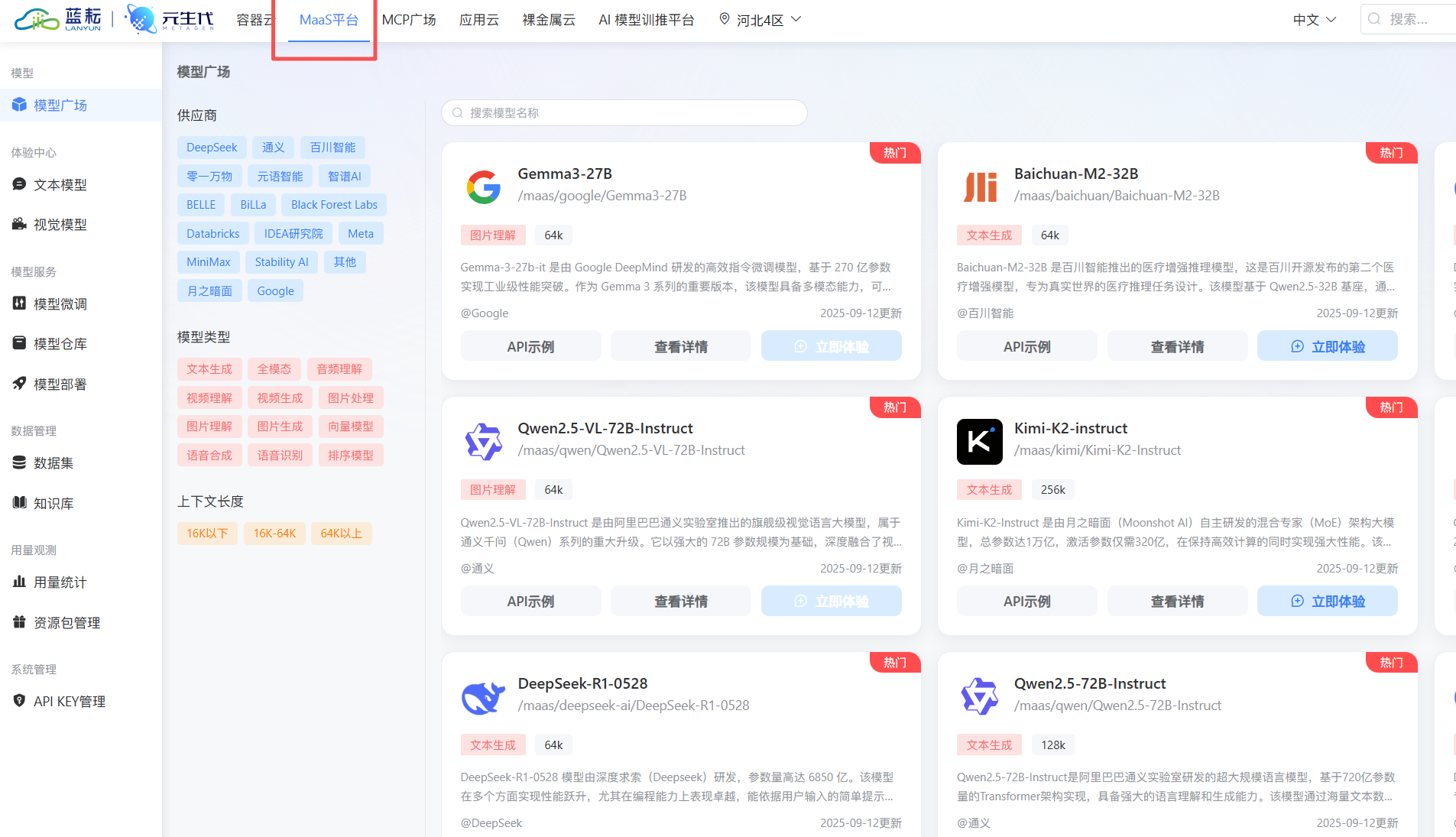

- 丰富的模型选择: 蓝耘平台聚合了包括 Kimi、文心一言、通义千问等在内的多款业界领先的大模型,你可以根据应用场景的具体需求(如长文本理解、代码生成、多语言支持等)灵活选择最合适的模型。

1. 注册蓝耘并获取核心凭证:API-Key

首先,我们需要访问并注册蓝耘平台。

打开蓝耘平台进行注册操作。

完成注册并登录后,在顶部导航栏找到“MaaS 平台”入口。在这里,你可以浏览平台支持的所有模型及其介绍。

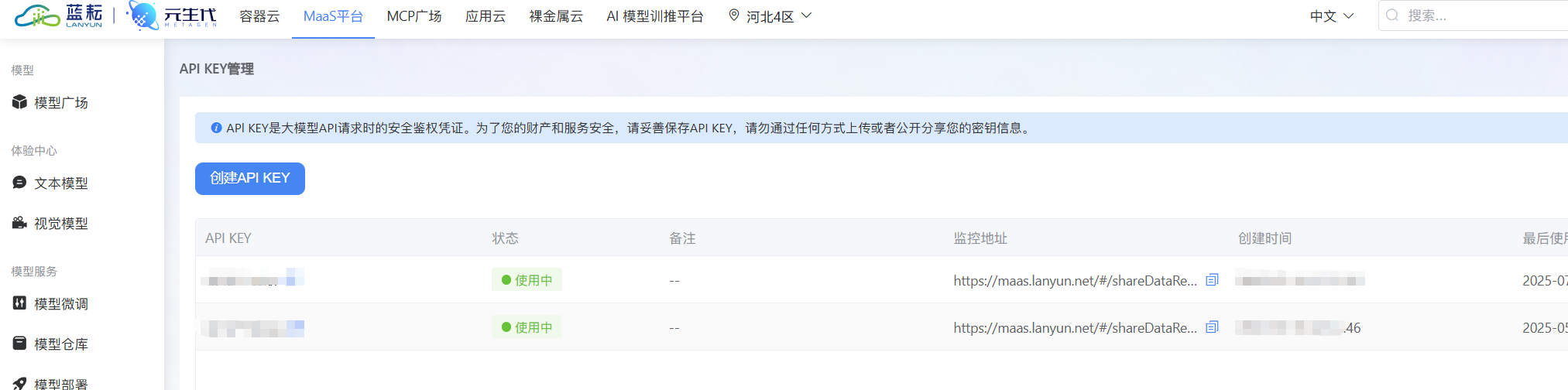

在正式使用模型之前,我们需要创建一个 API-Key。这相当于一把访问蓝耘模型服务的“钥匙”,后续在 Dify 中的配置会用到。请妥善保管好你的 API-Key,不要泄露给他人。

2. 在 Dify 中无缝集成蓝耘模型

现在,我们回到 Dify 的管理后台,将蓝耘的“动力引擎”安装进去。

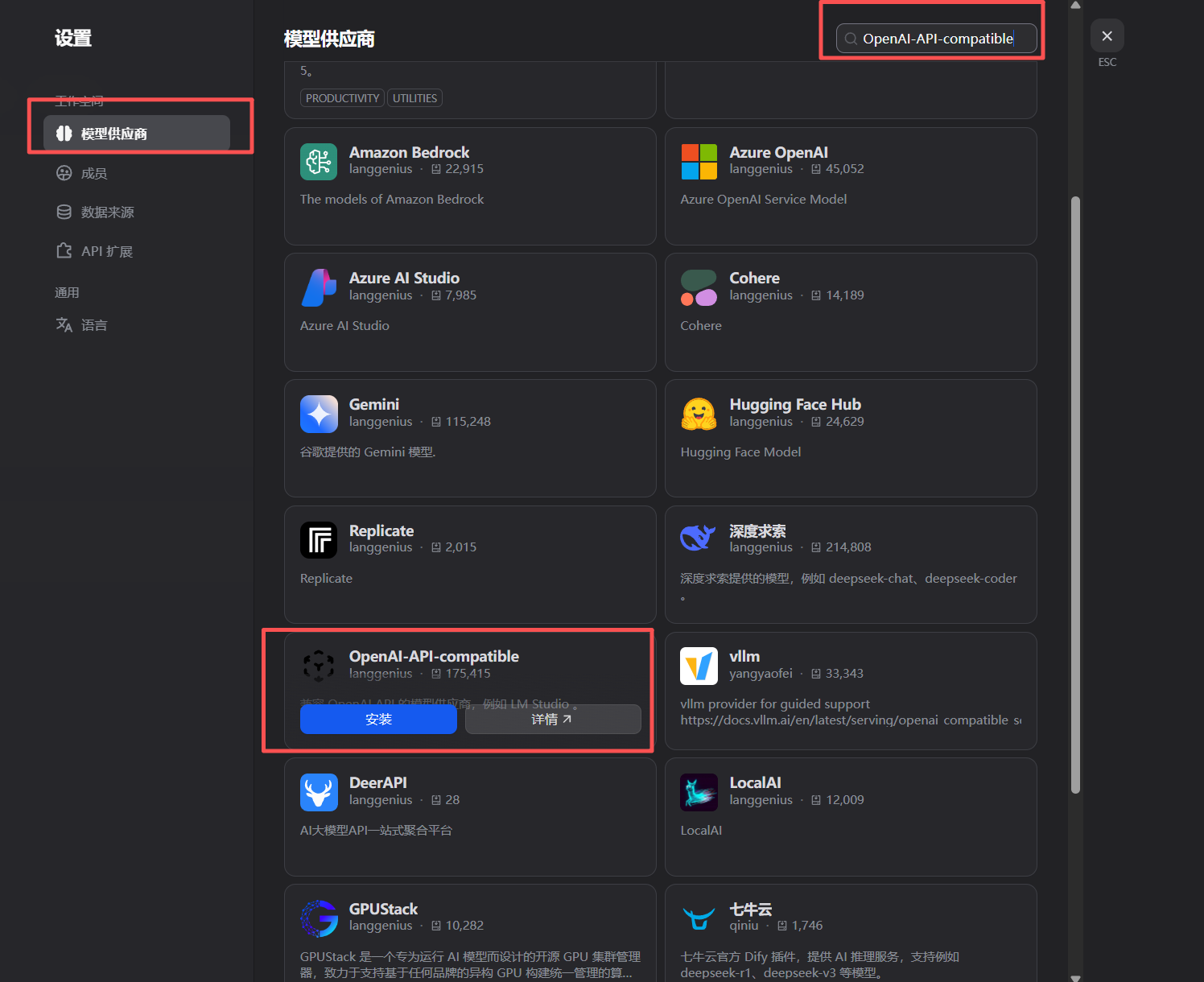

点击右上角的用户头像,在下拉菜单中选择“设置”。

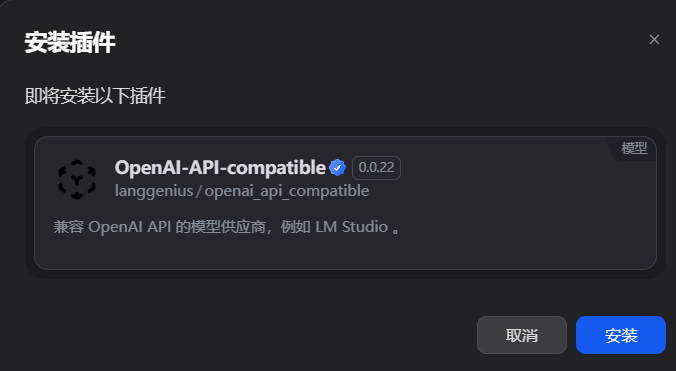

在设置菜单的左侧导航栏中,找到“模型供应商”。在正式添加蓝耘之前,我们需要先安装一个关键的插件,让 Dify 能够兼容类似 OpenAI API 格式的接口。点击“工具” -> “插件市场”,搜索并安装 OpenAI-API-compatible 插件。

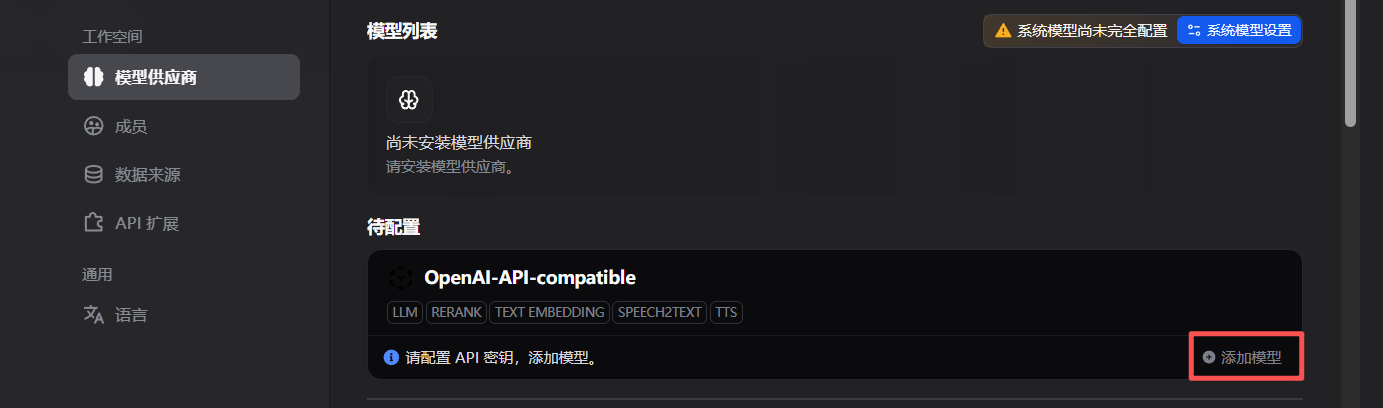

插件安装成功后,回到“模型供应商”页面,点击“添加模型”。

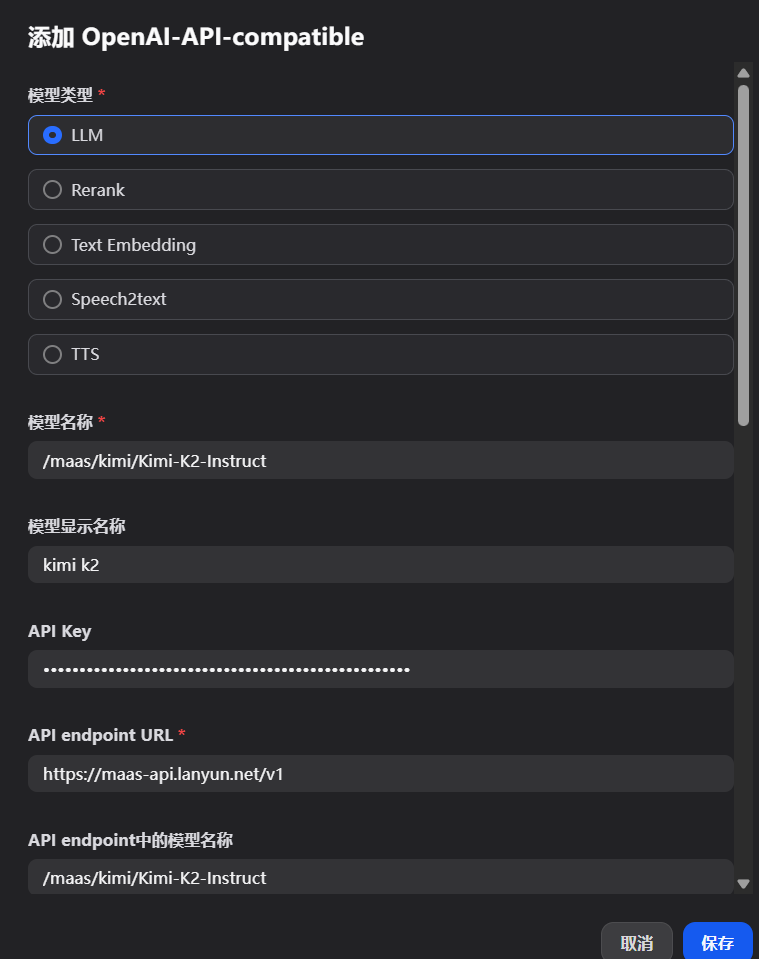

在弹出的配置窗口中,选择我们刚刚安装的 OpenAI-API-compatible 插件,然后填写以下关键信息:

- API Base URL: 这是蓝耘 MaaS 平台的 API 服务地址,统一填写

https://maas-api.lanyun.net/v1。 - API Key: 将你刚刚从蓝耘平台创建并复制的 API-Key 粘贴到这里。

- 模型名称: 为这个模型起一个自定义的、易于识别的名字,比如

lanyun-kimi-k2,方便后续在构建应用时选择。 - 模型 ID: 填写你希望使用的具体模型的标识符,这个标识符可以在蓝耘 MaaS 平台的模型列表中找到。例如,我们要使用 Kimi K2 Instruct 模型,就填写

/maas/kimi/Kimi-K2-Instruct。

填写完成后的效果如下图所示:

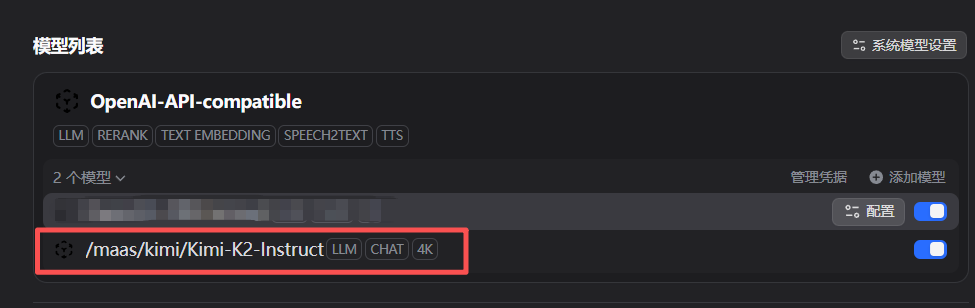

点击保存,蓝耘提供的 Kimi K2 模型就成功添加到了 Dify 的模型库中。

现在,我们的 Dify 平台不仅有了“大脑框架”,更拥有了一颗由蓝耘提供的、跳动强劲的“心脏”。

第三章:构建知识核心 —— 创建并填充专属知识库

有了平台和模型,接下来就是为我们的 AI 注入“知识”。Dify 的知识库功能是其核心亮点之一,它应用了当前最先进的 RAG (Retrieval-Augmented Generation) 技术。简单来说,它能将你上传的文档进行智能处理,变成大模型可以理解和检索的格式。

1. 创建知识库并上传原始资料

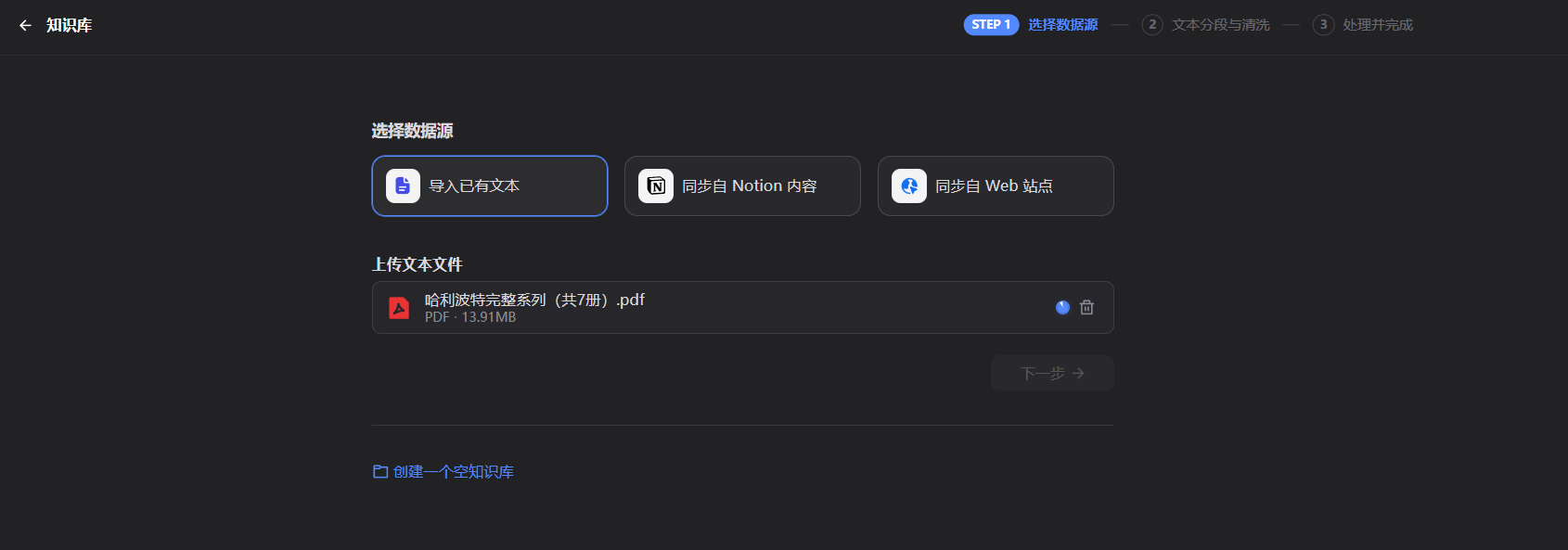

在 Dify 的主界面,点击左侧的“知识库”图标,然后点击“创建知识库”。我们将创建一个名为“哈利波特全书”的知识库。

接着,我们上传《哈利·波特》全套的原著文本文件。Dify 支持多种文件格式,包括 txt, pdf, docx 等。

2. 理解背后的技术:文本清洗、分段与索引

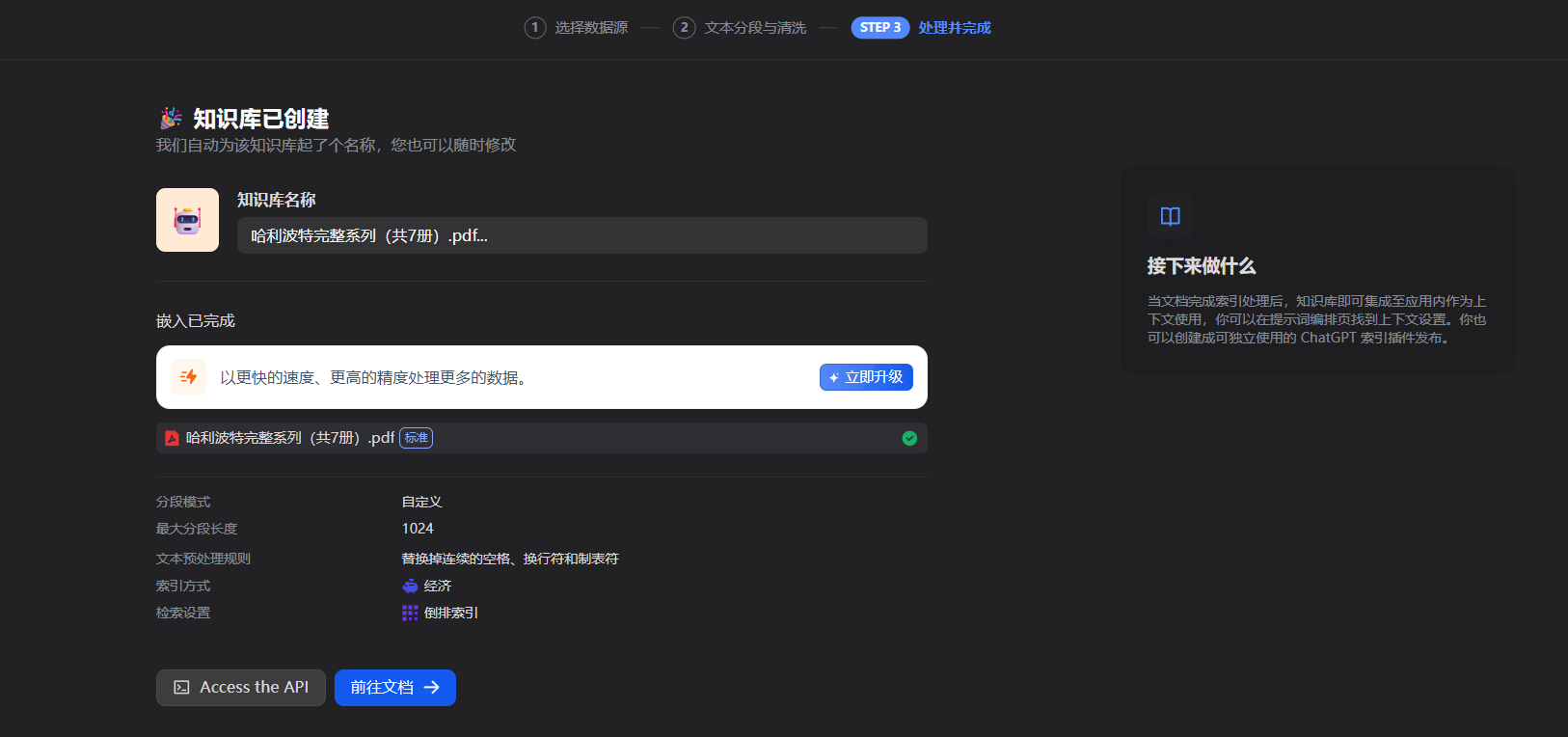

文件上传后,Dify 会引导你进行一系列的文本处理设置。这一步至关重要,直接影响到最终问答的准确性。

- 文本清洗: 自动去除文档中无关的页眉、页脚、多余的空行和特殊字符,保证输入给模型的文本是干净、高质量的。

- 分段与切块 (Segmentation & Chunking): 大语言模型一次能处理的文本长度(即“上下文窗口”)是有限的。因此,Dify 需要将长篇的文档(如一整本书)切分成若干个有意义的小段落(Chunk)。你可以选择自动分段,也可以自定义分段规则。合理的切块大小,既能保证每个段落包含足够的上下文信息,又不会超出模型的处理极限。

- 向量化与索引 (Embedding & Indexing): 这是 RAG 技术的核心。Dify 会将每一个文本块,通过一个特殊的“嵌入模型”(Embedding Model),转换成一串数字,即“向量”(Vector)。这个向量可以被认为是该文本块在多维空间中的“语义坐标”。所有的文本向量被存储在一个专门的“向量数据库”中。当用户提问时,Dify 同样会将问题转换成一个向量,然后在数据库中快速找到与之“语义最接近”的几个文本块向量,并将这些文本块作为上下文信息,提供给大模型去生成最终答案。

整个过程是全自动的,你只需根据引导完成设置。处理完成后,知识库的状态会显示为“可用”。

现在,我们已经将《哈利·波特》全书的知识,高效地“喂”给了我们的 AI 系统。

第四章:编排智能流程 —— 设计 AI 的“思考”方式

知识库准备就绪,模型也已接入,现在我们需要将它们串联起来,设计一个完整的工作流程 (Workflow),告诉 AI 在收到用户问题后,应该如何一步步地思考和行动。

1. 选择工作流模板

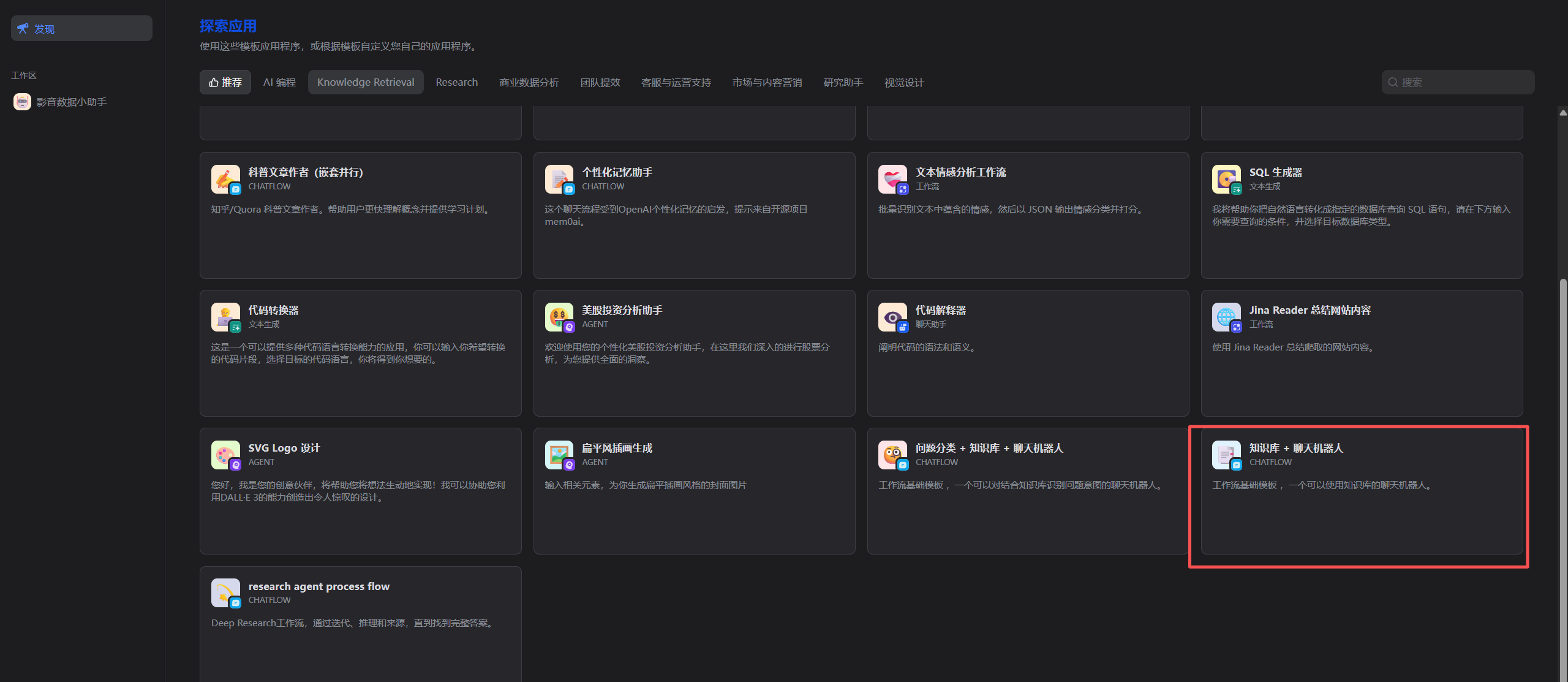

回到 Dify 主页,点击“创建应用”,选择“聊天机器人”类型。Dify 提供了多种预设的应用模板,我们直接选择“知识库+聊天机器人”这个最经典的模板。

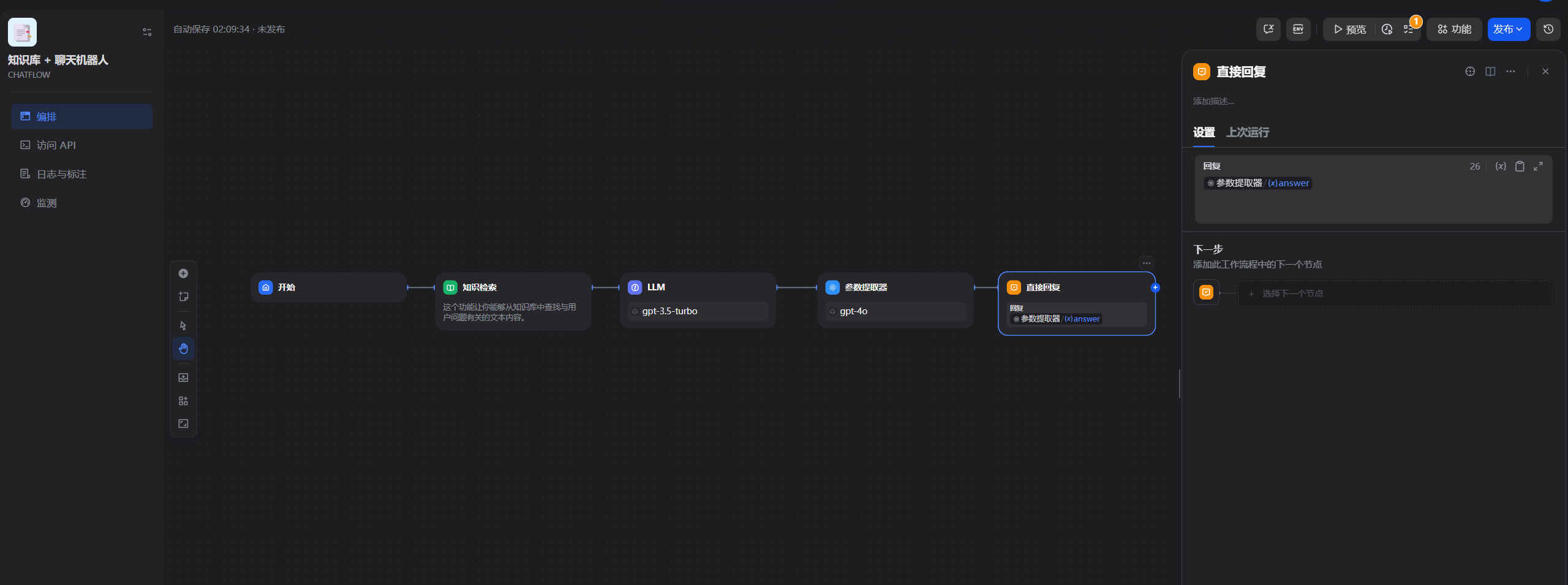

进入应用后,点击左侧的“编排”标签,你将看到一个可视化的工作流画布。

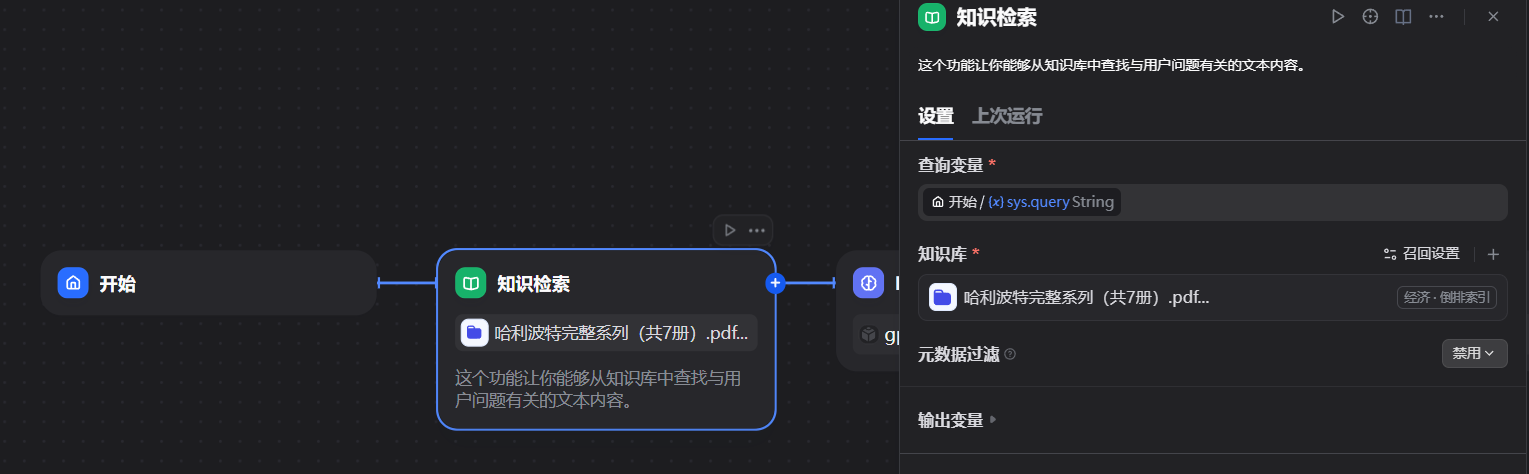

这个画布上已经预设了几个关键节点,代表了 AI 处理问题的标准流程:

- 开始: 接收用户的输入。

- 知识检索: 从知识库中查找与用户问题相关的信息。

- LLM (大语言模型): 将用户问题和检索到的知识整合起来,生成最终答案。

- 回复: 将生成的答案返回给用户。

2. 配置关键节点

我们的任务就是对这些节点进行配置,将我们之前创建的资源关联进来。

-

配置知识检索节点: 点击“知识检索”节点,在右侧的配置面板中,将“知识库”选项设置为我们刚刚创建的“哈利波特全书”。

-

配置 LLM 节点: 点击“LLM”节点(在模板中可能还有“参数提取器”等也需要配置),在模型选择下拉框中,选择我们之前配置好的

lanyun-kimi-k2模型。

-

精调 Prompt (提示词): 在 LLM 节点的配置中,最重要的就是 Prompt。这是我们给 AI 下达的“指令”,告诉它应该扮演什么角色,以及如何使用我们提供给它的知识。模板中已经有了一个不错的 Prompt,我们可以在此基础上进行微调:

你是一个乐于助人的哈利·波特百科专家。 请严格根据<context></context> XML标签内提供的《哈利·波特》原著内容来回答用户的问题。 <context> {{#context#}} </context> 当回答用户问题时: - 如果<context>中的内容足以回答问题,请直接回答。 - 如果<context>中的内容不包含答案,或者你不确定,请明确告知用户:“根据我所掌握的《哈利·波特》原著知识,我无法回答这个问题。” - 绝对不要编造或猜测答案。 - 避免提及你是从<context>或上下文中获取信息的,要让回答看起来就像你本身就是专家。 - 使用用户提问的语言进行回答。这里的

{{#context#}}是一个占位符,Dify 在实际运行时,会自动将从知识库中检索到的相关文本块填充到这里。

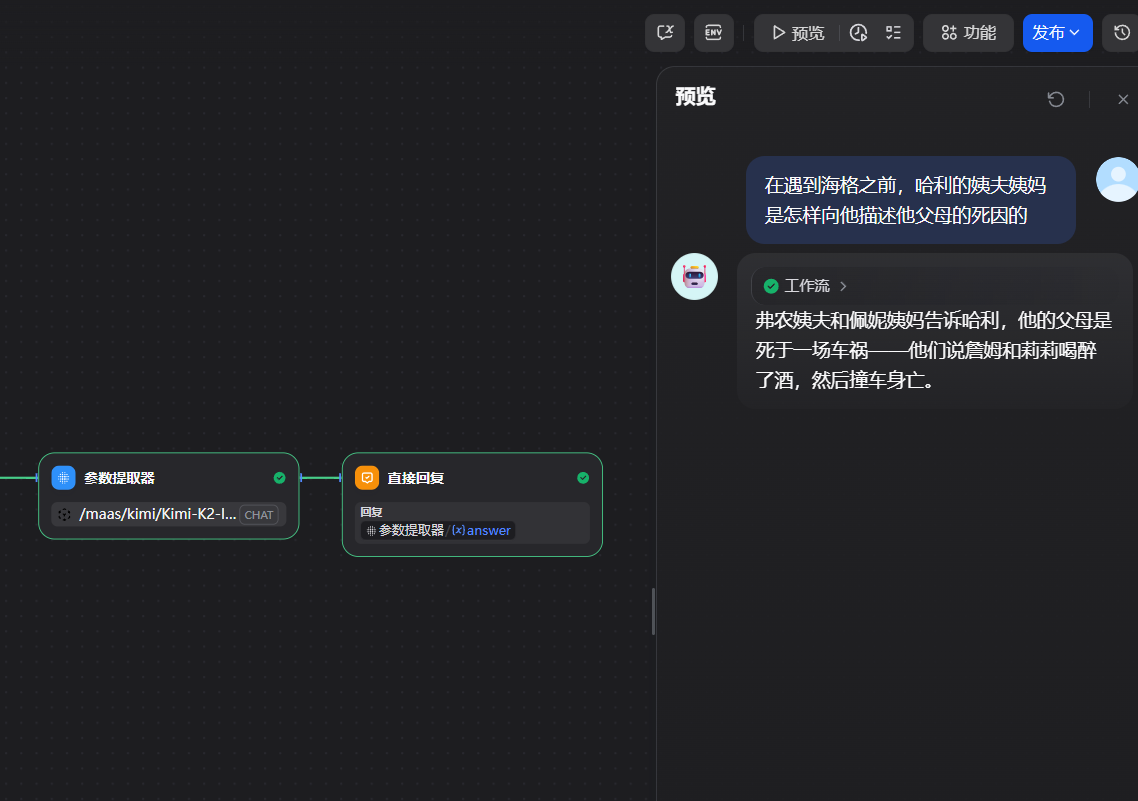

3. 调试与发布

配置完成后,可以直接在画布的右侧进行实时调试。输入一个关于哈利·波特的问题,例如“赫敏的守护神是什么?”,然后点击“运行”。

你可以看到工作流的每个节点都按顺序执行,并最终在“回复”节点输出了正确的答案:“水獭”。测试效果满意后,点击右上角的“发布”按钮,我们的 AI 问答机器人就正式上线了!

第五章:无缝集成 —— 将你的 AI 助手嵌入任何网站

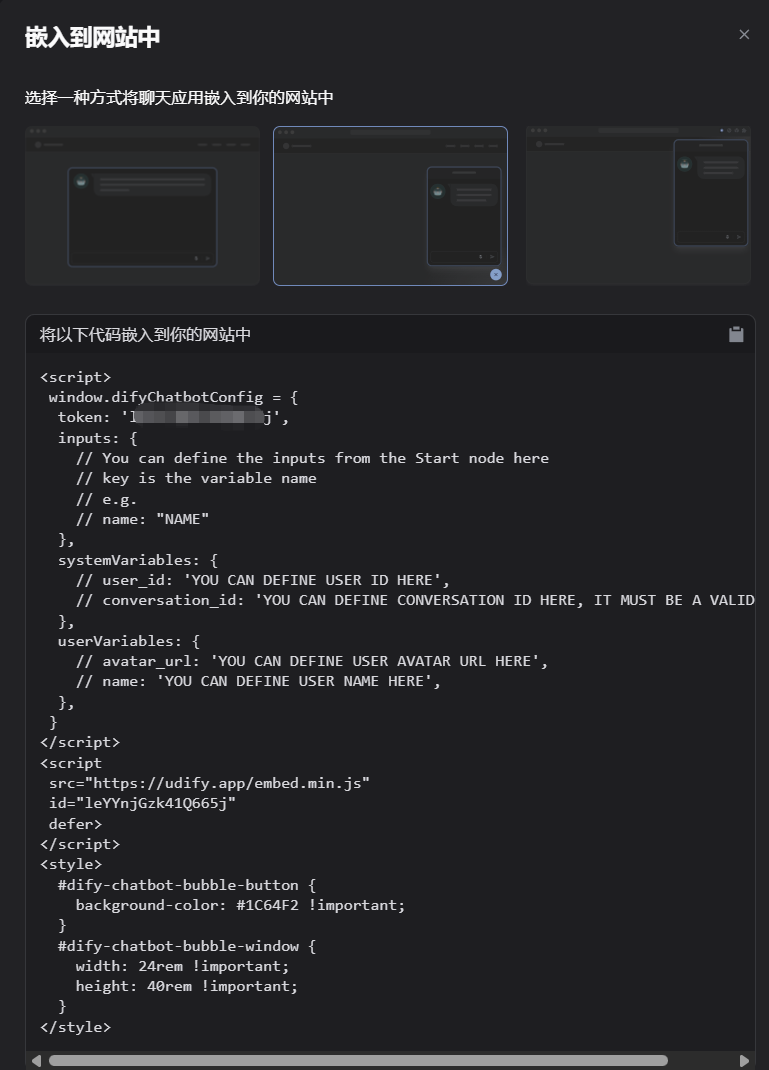

应用发布后,Dify 提供了多种集成方式,其中最便捷的就是“嵌入网站”。

1. 获取嵌入代码

在应用概览页面,找到并点击“嵌入网站”选项。

Dify 提供了几种嵌入样式,我们选择中间的“气泡式”聊天机器人。这会在网站的右下角生成一个可点击的聊天图标。

Dify 会自动生成一段 HTML 和 JavaScript 代码。这段代码就是连接你的网站和 AI 助手的桥梁。

<script>

window.difyChatbotConfig = {

token: '你的应用唯一token', // 这个token是自动生成的

// ... 其他配置

}

</script>

<script src="https://udify.app/embed.min.js" id="你的应用ID" defer></script>

<style>

/* 你甚至可以在这里自定义聊天窗口的样式 */

#dify-chatbot-bubble-button {

background-color: #7B1F2A !important; /* 改成格兰芬多红色 */

}

#dify-chatbot-bubble-window {

width: 24rem !important;

height: 40rem !important;

}

</style>

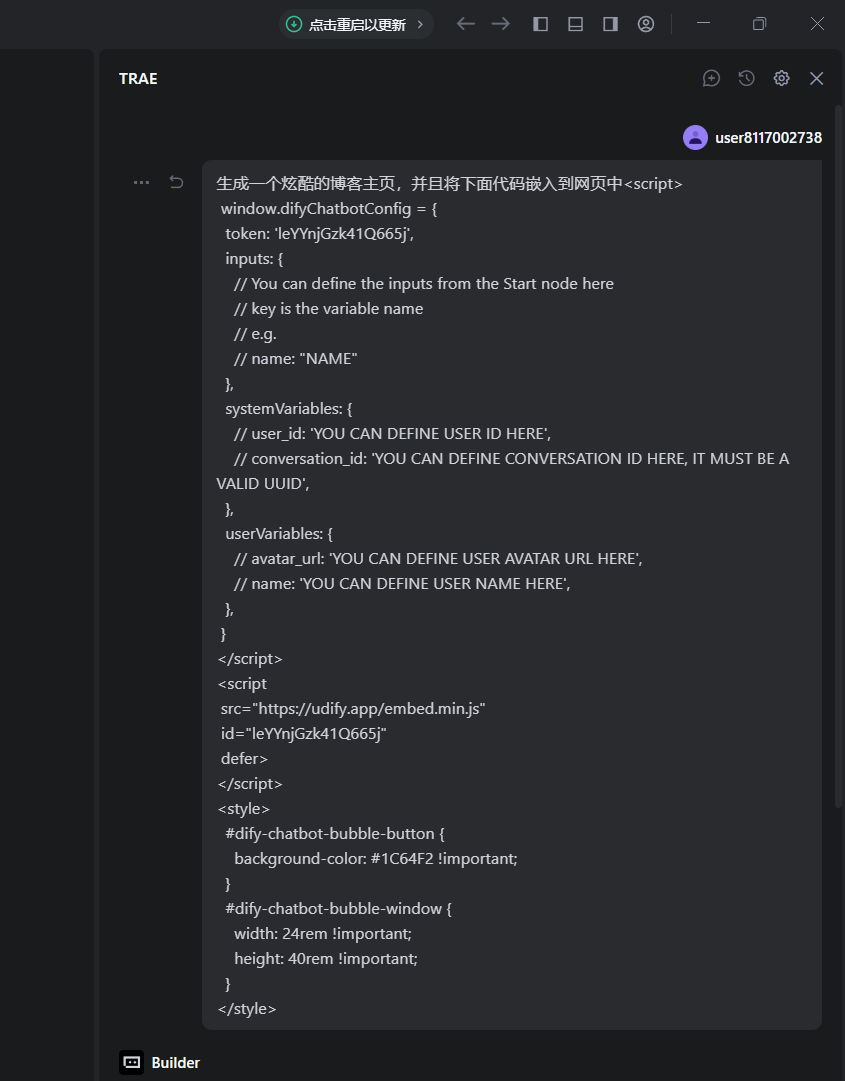

2. 在你的网站中嵌入代码

接下来,我们创建一个简单的博客网页(或在任何你已有的网站项目中),将上面生成的代码片段粘贴到网页的 <body> 标签结束之前。

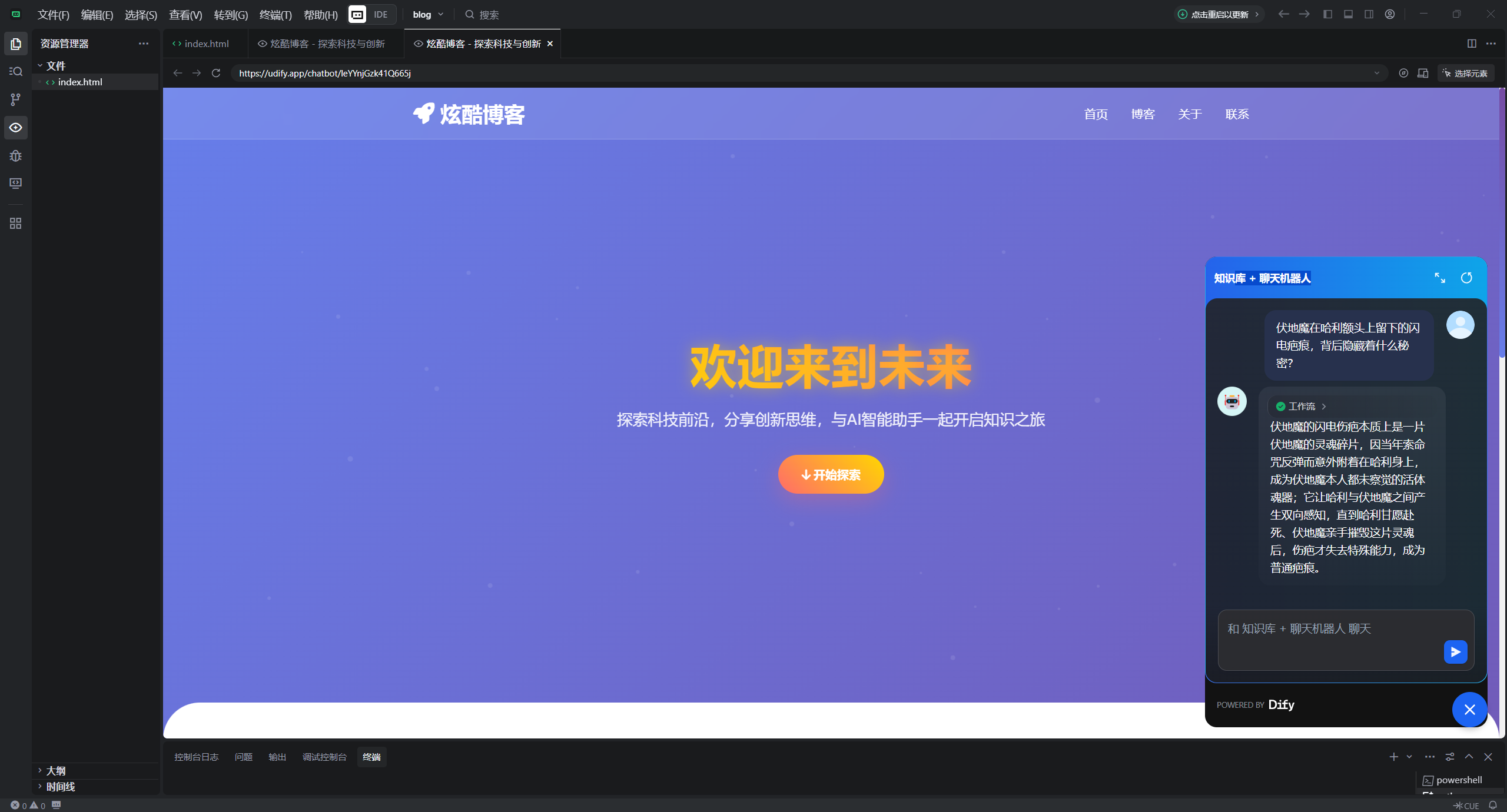

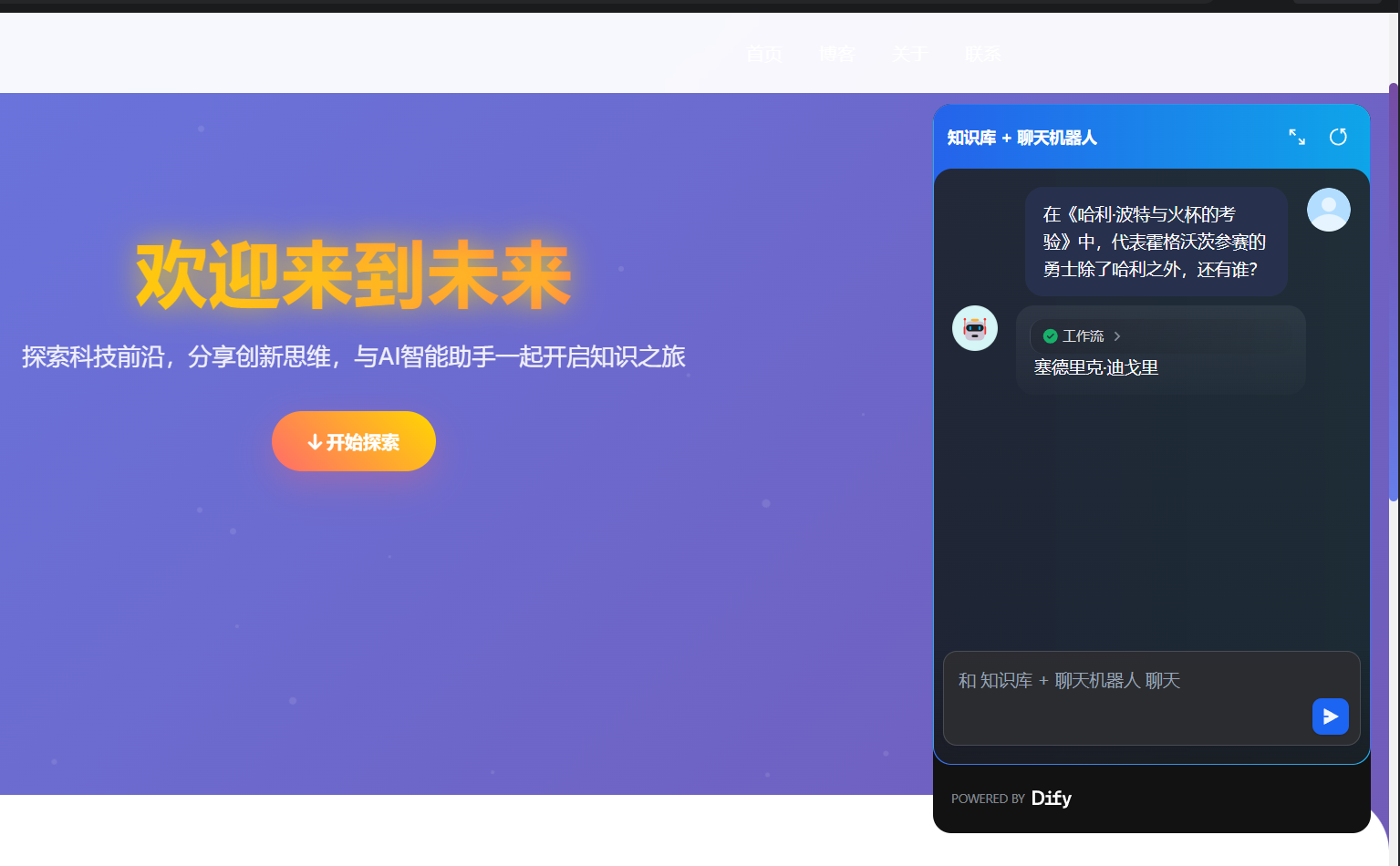

3. 本地测试与最终效果

为了在本地预览效果,我们可以使用 Python 启动一个简单的 Web 服务器。在你的网页文件所在的目录下,打开终端或命令行,输入以下命令:

python -m http.server 8000

然后打开浏览器,访问 http://localhost:8000。你将看到你的网页,并且在右下角出现了一个 Dify 聊天图标。

点击图标,一个精美的聊天窗口就会弹出。现在,任何访问你网站的用户都可以与你的哈利·波特专家进行实时问答了!

结论:蓝耘与 Dify 组合拳,开启 AI 应用新范式

回顾整个过程,我们没有编写一行复杂的后端代码,没有手动部署任何一个大模型,却成功构建并上线了一个功能完善、性能卓越、可无限扩展的 AI 知识问答应用。这正是 蓝耘 与 Dify 组合所带来的颠覆性价值:

- Dify 的“框架”之美: 它将构建 AI 应用所需的所有复杂组件——数据处理、模型编排、前端交互——都封装成了用户友好的可视化界面。它赋予了产品经理、运营人员甚至任何有创意的个体,将想法快速落地为 AI 应用的能力,真正实现了 AI 的“平民化”。

- 蓝耘的“引擎”之力: 它解决了 AI 应用中最核心、最棘手的“动力”问题。其高速的 API 响应,是保障用户体验的生命线;而极具竞争力的成本控制,则是决定一个 AI 应用能否从“玩具”走向“产品”,能否大规模推广的关键。蓝耘让开发者可以毫无后顾之忧地调用最顶尖的大模型能力,将全部精力投入到业务逻辑和应用创新上。

这套“Dify + 蓝耘”的黄金组合,其应用场景远不止于此:

- 企业内部: 可以将所有内部规章制度、产品文档、技术手册、入职指南导入 Dify,打造一个 7x24 小时在线的“超级员工”,即时解答所有员工的疑问,极大提升内部运营效率。

- 客户服务: 将官网的 FAQ、产品说明、售后条款构建成知识库,嵌入到网站或 App 中,形成一个智能客服机器人,可以解决 80% 以上的重复性客户咨询,释放人力去处理更复杂的问题。

- 教育培训: 将教材、课件、参考文献作为知识库,为学生打造一个专属的课程学习助教,随时随地答疑解惑。

- 个人知识管理 (PKM): 将你所有的读书笔记、网络文章、工作文档整合起来,构建一个真正“懂你”的第二大脑,通过对话即可快速回顾和关联你的知识。

总而言之,技术的进步正在以前所未有的速度,拆除创新的壁垒。蓝耘与 Dify 的出现,让构建强大、实用的 AI 应用不再是少数巨头公司的专利。现在,轮到你来思考,如何利用这对强大的工具,去解决你所面临的问题,去创造属于你自己的价值了。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)