AI应用架构师的伦理工具推荐:这8个工具帮你高效完成伦理设计

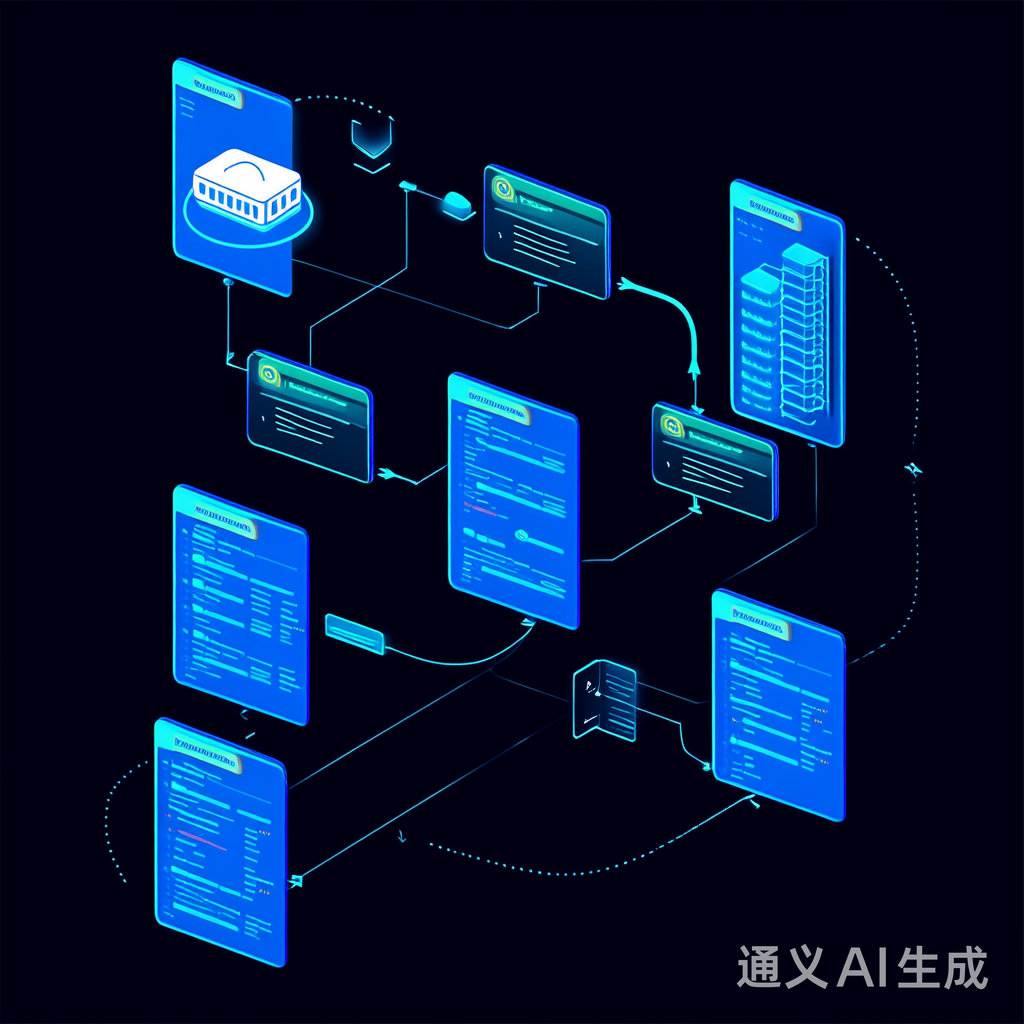

数据层:确保数据无偏见、隐私被保护;模型层:确保模型公平、可解释、准确;部署层:确保模型决策透明、可监控;反馈层:确保用户反馈被收集、伦理问题被迭代。

AI应用架构师的伦理设计工具链:8款核心工具助力负责任AI落地

元数据框架

标题:AI应用架构师的伦理设计工具链:8款核心工具助力负责任AI落地

关键词:负责任AI、AI伦理工具、架构设计、偏见检测、可解释性、隐私保护、公平性优化、伦理监控

摘要:

随着AI技术渗透至医疗、金融、自动驾驶等关键领域,伦理风险(如算法偏见、隐私泄露、决策不透明)已成为架构师必须解决的核心问题。本文针对AI应用架构师的工作流程,梳理了8款覆盖“数据-模型-部署-反馈”全链路的伦理工具,结合理论框架、实现机制与实践案例,说明如何将伦理设计从“抽象要求”转化为“可操作流程”。无论是数据偏见检测、模型公平性优化,还是部署后监控与伦理审计,这些工具都能帮助架构师高效平衡“技术性能”与“伦理合规”,最终实现负责任AI的落地。

1. 概念基础:AI伦理设计的底层逻辑

在讨论工具之前,需先明确AI伦理设计的背景、问题空间与核心术语,为后续工具应用建立共识。

1.1 领域背景化:为什么AI伦理设计是架构师的必修课?

AI技术的普及带来了一系列伦理挑战:

- 算法偏见:如2018年Google Images将黑人标记为“大猩猩”(图像识别偏见)、2019年亚马逊招聘模型歧视女性(自然语言处理偏见);

- 可解释性缺失:如深度学习模型的“黑箱”问题,医生无法理解AI诊断结果的依据,导致信任危机;

- 隐私泄露:如2020年Facebook数据泄露事件,用户隐私被滥用;

- 问责制模糊:如自动驾驶事故中,无法界定“是模型问题还是人类问题”。

这些问题不仅会导致法律风险(如违反EU AI Act、GDPR),还会损害企业声誉与用户信任。因此,伦理设计不是“可选功能”,而是AI应用的“基础属性”。

1.2 历史轨迹:从“伦理宣言”到“工具支持”

AI伦理的发展经历了三个阶段:

- 理念萌芽(2016-2018):各大公司发布伦理宣言(如Google AI Principles、Microsoft AI Ethics),强调“公平、透明、问责”;

- 框架完善(2019-2021):政府与机构推出 regulatory frameworks(如EU AI Act、NIST AI Risk Management Framework),明确伦理要求;

- 工具落地(2022至今):开源社区与企业推出伦理工具(如本文推荐的8款),将伦理要求转化为可操作的技术手段。

1.3 问题空间定义:架构师面临的伦理挑战

AI应用架构师的核心伦理任务是:

- 数据层:确保数据无偏见、隐私被保护;

- 模型层:确保模型公平、可解释、准确;

- 部署层:确保模型决策透明、可监控;

- 反馈层:确保用户反馈被收集、伦理问题被迭代。

1.4 术语精确性:避免伦理概念混淆

- 算法偏见(Algorithmic Bias):模型输出对特定群体(如性别、种族)的不公平对待,源于数据或模型设计的偏差;

- 公平性(Fairness):模型对不同群体的决策一致性,常用指标包括** demographic parity(群体公平,如“男女贷款批准率相同”)、 equalized odds(机会均等,如“男女的真阳性率相同”)**;

- 可解释性(Explainability):人类能理解模型决策的过程与原因,区别于“可理解性(Interpretability)”(模型本身的简单性);

- 差分隐私(Differential Privacy):通过添加噪声,使得单个数据点的删除不影响模型输出,从而保护隐私;

- 伦理审计(Ethics Audit):检查AI应用是否符合伦理标准(如EU AI Act)的过程。

2. 理论框架:AI伦理设计的第一性原理

伦理设计不是“拍脑袋”,而是基于核心公理的系统化决策。本节将用数学与逻辑推导伦理设计的底层逻辑。

2.1 核心公理:伦理设计的“四大基石”

AI伦理设计的核心目标是实现负责任AI(Responsible AI),其底层公理包括:

- 公平性(Fairness):模型决策不依赖敏感属性(如性别、种族);

- 可解释性(Explainability):人类能理解模型决策的原因;

- 隐私性(Privacy):用户数据不被滥用或泄露;

- 问责制(Accountability):模型决策的责任可追溯。

2.2 数学形式化:伦理指标的量化

伦理设计的关键是将抽象的伦理要求转化为可量化的指标。以下是常见指标的数学表达:

- Demographic Parity(群体公平):

P(Y=1∣A=a1)=P(Y=1∣A=a2) P(Y=1|A=a_1) = P(Y=1|A=a_2) P(Y=1∣A=a1)=P(Y=1∣A=a2)

其中,AAA 是敏感属性(如性别,a1a_1a1=男,a2a_2a2=女),YYY 是模型输出(如“批准贷款”)。 - Equalized Odds(机会均等):

P(Y=1∣A=a1,T=1)=P(Y=1∣A=a2,T=1) P(Y=1|A=a_1, T=1) = P(Y=1|A=a_2, T=1) P(Y=1∣A=a1,T=1)=P(Y=1∣A=a2,T=1)

P(Y=1∣A=a1,T=0)=P(Y=1∣A=a2,T=0) P(Y=1|A=a_1, T=0) = P(Y=1|A=a_2, T=0) P(Y=1∣A=a1,T=0)=P(Y=1∣A=a2,T=0)

其中,TTT 是真实标签(如“是否有能力还款”)。 - 差分隐私(ϵ\epsilonϵ-Differential Privacy):

对于任意两个相邻数据集 DDD 和 D′D'D′(仅差一个数据点),以及任意输出 SSS,有:

P(M(D)∈S)≤eϵ⋅P(M(D′)∈S)+δ P(M(D) \in S) \leq e^\epsilon \cdot P(M(D') \in S) + \delta P(M(D)∈S)≤eϵ⋅P(M(D′)∈S)+δ

其中,ϵ\epsilonϵ 是隐私预算(越小越隐私),δ\deltaδ 是失败概率(通常取 10−510^{-5}10−5)。

2.3 理论局限性:伦理目标的冲突

伦理设计的难点在于不同伦理目标可能冲突。例如:

- 公平性与准确性:为了实现群体公平,可能需要牺牲部分准确性(如降低男性的贷款批准率以平衡女性);

- 公平性与隐私性:差分隐私的噪声可能导致模型公平性下降(如噪声掩盖了敏感属性的差异);

- 可解释性与性能:复杂模型(如Transformer)的可解释性工具(如SHAP)计算成本高,可能影响实时性能。

2.4 竞争范式:自上而下 vs 自下而上

伦理设计有两种范式:

- 自上而下(Top-down):通过公司政策或 regulatory frameworks 指导伦理设计(如Google AI Principles);

- 自下而上(Bottom-up):通过工具支持(如本文推荐的工具)将伦理设计整合到流程中。

结论:两者需结合——自上而下的框架提供方向,自下而上的工具提供执行手段。

3. 架构设计:AI伦理工具的集成流程

伦理设计不是“事后补救”,而是嵌入AI应用全生命周期的流程。本节将用可视化与设计模式说明工具的集成方式。

3.1 系统分解:伦理设计的“五阶段流程”

AI应用的伦理设计流程可分解为:

- 需求分析:明确伦理目标(如“贷款模型需实现群体公平”);

- 数据处理:检测数据偏见(用Aequitas)、保护隐私(用TensorFlow Privacy);

- 模型开发:优化公平性(用Fairlearn)、提升可解释性(用SHAP);

- 部署监控:监控模型的伦理指标(用IBM AI Fairness 360)、展示透明性(用Responsible AI Dashboard);

- 反馈迭代:收集用户反馈(用EthicsFlow)、进行伦理审计(用OpenEthics)。

3.2 组件交互模型:工具的“职责分工”

各工具在流程中的角色如下:

- 数据层:Aequitas(偏见检测)、TensorFlow Privacy(隐私保护);

- 模型层:Fairlearn(公平性优化)、SHAP(可解释性);

- 部署层:IBM AI Fairness 360(监控)、Responsible AI Dashboard(文档);

- 反馈层:EthicsFlow(用户反馈)、OpenEthics(伦理审计)。

3.3 可视化表示:伦理设计流程图(Mermaid)

3.4 设计模式应用:伦理工具的“集成技巧”

- 管道模式(Pipeline Pattern):将伦理工具整合到数据-模型-部署管道中(如用MLflow将Aequitas、Fairlearn、SHAP整合到模型训练流程);

- 观察者模式(Observer Pattern):用IBM AI Fairness 360监控模型的伦理指标,当指标超过阈值时触发警报;

- 装饰器模式(Decorator Pattern):用TensorFlow Privacy装饰模型训练过程,添加差分隐私噪声。

4. 实现机制:8款核心伦理工具的详细解析

本节将逐一介绍8款工具的核心功能、技术原理、代码示例、边缘情况与性能考量,覆盖伦理设计的全流程。

4.1 工具1:Aequitas(数据偏见检测)

核心功能:检测数据与模型中的偏见,计算公平性指标(如demographic parity、equalized odds)。

技术原理:基于统计分析,比较不同敏感属性群体的模型输出分布。

代码示例(检测贷款模型的性别偏见):

from aequitas.preprocessing import preprocess_input_df

from aequitas.group import Group

from aequitas.bias import Bias

# 加载数据(包含敏感属性“gender”、模型输出“prediction”、真实标签“label”)

df = pd.read_csv("loan_data.csv")

# 预处理数据

df_processed, _ = preprocess_input_df(df, label_col="label", score_col="prediction")

# 计算群体统计指标

group = Group()

group_metrics = group.get_group_metrics(df_processed, sensitive_attrs=["gender"])

# 计算偏见指标(如demographic parity difference)

bias = Bias()

bias_metrics = bias.get_bias_metrics(group_metrics, original_df=df_processed)

print(bias_metrics[["gender", "demographic_parity_difference"]])

边缘情况:当敏感属性分布极不均衡时(如女性样本占比1%),指标可能不准确,需用**重采样(Resampling)或正则化(Regularization)处理。

性能考量:处理大规模数据(如100万条)时,用并行计算(Dask)**优化,时间复杂度从O(n∗m)O(n*m)O(n∗m)降至O(n∗m/p)O(n*m/p)O(n∗m/p)(ppp为并行进程数)。

4.2 工具2:Fairlearn(模型公平性优化)

核心功能:优化模型的公平性,同时保持准确性。

技术原理:基于约束优化,将公平性指标作为约束条件,调整模型参数。

代码示例(优化贷款模型的群体公平):

from fairlearn.reductions import ExponentiatedGradient, DemographicParity

from sklearn.ensemble import RandomForestClassifier

# 加载数据(X为特征,y为标签,sensitive_features为敏感属性“gender”)

X, y, sensitive_features = load_loan_data()

# 定义基础模型(随机森林)

base_model = RandomForestClassifier(n_estimators=100)

# 定义公平性约束(群体公平)

constraint = DemographicParity()

# 用ExponentiatedGradient优化模型

optimizer = ExponentiatedGradient(base_model, constraint)

optimizer.fit(X, y, sensitive_features=sensitive_features)

# 评估优化后的模型(公平性与准确性)

from fairlearn.metrics import demographic_parity_difference

from sklearn.metrics import accuracy_score

y_pred = optimizer.predict(X)

print("Demographic Parity Difference:", demographic_parity_difference(y, y_pred, sensitive_features=sensitive_features))

print("Accuracy:", accuracy_score(y, y_pred))

边缘情况:当公平性约束过严时(如demographic parity difference要求<1%),准确性可能下降过多(如从90%降至70%),需调整约束强度(如将阈值放宽至5%)。

性能考量:对于复杂模型(如深度学习),优化时间较长(如训练100轮需要1小时),需用GPU加速(TensorFlow/PyTorch)。

4.3 工具3:SHAP(模型可解释性)

核心功能:解释模型的决策过程,生成特征重要性图。

技术原理:基于Shapley值(博弈论中的概念),计算每个特征对模型输出的贡献。

代码示例(解释贷款模型的决策):

import shap

from sklearn.ensemble import RandomForestClassifier

# 加载数据(X为特征,y为标签)

X, y = load_loan_data()

# 训练模型

model = RandomForestClassifier(n_estimators=100)

model.fit(X, y)

# 初始化SHAP解释器(KernelExplainer适用于所有模型)

explainer = shap.KernelExplainer(model.predict_proba, X.sample(100))

# 生成SHAP值

shap_values = explainer.shap_values(X.sample(10))

# 可视化(force plot:解释单个样本的决策)

shap.force_plot(explainer.expected_value[1], shap_values[1][0], X.sample(10).iloc[0], matplotlib=True)

# 可视化(summary plot:展示所有特征的重要性)

shap.summary_plot(shap_values[1], X.sample(100))

边缘情况:对于高维数据(如文本,1000个特征),summary plot可能过于拥挤,需用**降维技术(如PCA)或特征选择(如互信息)减少特征数量。

性能考量:对于大型模型(如GPT-3),计算Shapley值的时间较长(如解释1个样本需要1分钟),需用近似方法(如FastSHAP)**优化。

4.4 工具4:TensorFlow Privacy(隐私保护)

核心功能:实现差分隐私,保护数据隐私。

技术原理:在模型训练过程中添加高斯噪声,使得单个数据点的删除不影响模型输出。

代码示例(用差分隐私训练贷款模型):

import tensorflow as tf

from tensorflow_privacy.privacy.optimizers.dp_optimizer import DPGradientDescentGaussianOptimizer

# 加载数据(X为特征,y为标签)

X, y = load_loan_data()

# 定义模型(逻辑回归)

model = tf.keras.Sequential([

tf.keras.layers.Dense(1, activation="sigmoid", input_shape=(X.shape[1],))

])

# 定义差分隐私优化器(epsilon=1.0,delta=1e-5)

optimizer = DPGradientDescentGaussianOptimizer(

l2_norm_clip=1.0, # 梯度剪辑阈值

noise_multiplier=1.0, # 噪声乘数(越大越隐私)

learning_rate=0.01

)

# 编译模型

model.compile(optimizer=optimizer, loss="binary_crossentropy", metrics=["accuracy"])

# 训练模型(注意:需要指定batch_size,因为差分隐私依赖批量处理)

model.fit(X, y, batch_size=32, epochs=10)

边缘情况:当epsilon过小时(如<0.1),噪声过大,模型性能可能下降(如准确性从90%降至60%);当epsilon过大时(如>10),隐私保护效果差(如无法通过GDPR的隐私要求)。

性能考量:添加噪声会增加训练时间(如比普通训练慢20%),需调整batch size(越大,噪声相对越小)和learning rate(越大,训练越快,但可能导致收敛不稳定)。

4.5 工具5:IBM AI Fairness 360(部署监控)

核心功能:监控模型部署后的公平性指标,及时发现问题。

技术原理:定期收集模型输出数据,计算公平性指标(如demographic parity difference),当指标超过阈值时触发警报。

代码示例(监控贷款模型的公平性):

from aif360.algorithms.monitoring import FairnessMonitor

import pandas as pd

# 加载部署后的模型输出数据(包含敏感属性“gender”、模型输出“prediction”、真实标签“label”)

df = pd.read_csv("deployed_loan_data.csv")

# 初始化公平性监控器(指定敏感属性、公平性指标)

monitor = FairnessMonitor(

sensitive_attrs=["gender"],

fairness_metrics=["demographic_parity_difference"],

thresholds={"demographic_parity_difference": 0.1} # 阈值:差异不超过10%

)

# 监控模型(定期运行,如每天一次)

monitor.update(df)

alerts = monitor.check_alerts()

# 输出警报(如“gender的demographic parity difference为15%,超过阈值10%”)

print(alerts)

边缘情况:当数据分布发生变化(如概念漂移,如“贷款申请人的性别比例从50:50变为60:40”)时,监控指标可能失效,需重新校准模型(如用新数据重新训练)。

性能考量:实时监控(如每秒处理1000条数据)需要低延迟,需用**流式处理框架(如Apache Flink)**优化,将时间复杂度从O(n)O(n)O(n)降至O(1)O(1)O(1)(用滑动窗口处理数据)。

4.6 工具6:EthicsFlow(用户反馈)

核心功能:收集用户对模型的伦理反馈(如“我认为模型歧视女性”)。

技术原理:通过用户界面(如问卷、反馈按钮)收集反馈,用自然语言处理(NLP)工具分类整理。

代码示例(集成到贷款应用中):

from ethicsflow import EthicsFlowClient

# 初始化客户端(用API密钥)

client = EthicsFlowClient(api_key="your_api_key")

# 收集用户反馈(用户ID、反馈内容、模型输出)

feedback = {

"user_id": "user123",

"content": "我认为模型歧视女性,因为我的贷款申请被拒绝,但我的资质比男性朋友好",

"model_output": "拒绝贷款",

"sensitive_attributes": {"gender": "female"}

}

# 提交反馈

client.submit_feedback(feedback)

# 分析反馈(用NLP分类,如“偏见”、“可解释性”、“隐私”)

feedback_analysis = client.analyze_feedback()

print(feedback_analysis)

边缘情况:用户反馈可能带有偏见或不真实(如“我认为模型歧视我,但实际上是因为我的信用评分低”),需结合模型输出与真实标签验证(如检查用户的信用评分是否低于阈值)。

性能考量:处理大量反馈(如每天1000条)时,用**批量处理(Batch Processing)**优化,将NLP分析的时间从每条1秒降至每条0.1秒。

4.7 工具7:OpenEthics(伦理审计)

核心功能:对AI应用进行伦理审计,检查是否符合伦理标准(如EU AI Act)。

技术原理:基于伦理框架(如EU AI Act的“四原则”:合法性、公正性、透明性、问责制),生成审计报告。

代码示例(审计贷款模型):

from openethics import EthicsAuditor

# 初始化审计器(指定伦理框架:EU AI Act)

auditor = EthicsAuditor(framework="EU AI Act")

# 输入模型与数据(模型文件、数据文件、伦理目标)

audit_input = {

"model_path": "loan_model.h5",

"data_path": "loan_data.csv",

"ethical_goals": ["fairness", "privacy", "transparency"]

}

# 运行审计

audit_report = auditor.run_audit(audit_input)

# 输出审计报告(如“模型符合公平性要求,但隐私保护不足”)

print(audit_report)

边缘情况:伦理标准可能不明确或变化(如EU AI Act的修订),需定期更新审计模板(如每6个月检查一次伦理标准的变化)。

性能考量:审计复杂应用(如自动驾驶)时,需要大量时间和专业知识(如1周),需分工合作(如伦理专家负责检查公平性,技术专家负责检查可解释性)。

4.8 工具8:Responsible AI Dashboard(文档工具)

核心功能:生成AI应用的伦理文档,记录设计过程与决策。

技术原理:整合伦理工具的输出(如Aequitas的偏见检测结果、SHAP的可解释性图、IBM AI Fairness 360的监控指标),生成可视化 dashboard。

代码示例(生成贷款模型的伦理文档):

from responsible_ai_dashboard import ResponsibleAIDashboard

# 初始化dashboard(指定模型、数据、伦理工具的输出)

dashboard = ResponsibleAIDashboard(

model=model,

data=X,

sensitive_features=sensitive_features,

fairness_metrics=bias_metrics, # 来自Aequitas

explainability_plots=shap_plots, # 来自SHAP

monitoring_metrics=monitoring_metrics # 来自IBM AI Fairness 360

)

# 生成dashboard(HTML文件)

dashboard.generate("loan_model_ethics_dashboard.html")

边缘情况:文档可能遗漏重要信息(如“模型的公平性指标是如何计算的”),需定期审核(如每季度检查一次文档的完整性)。

性能考量:实时展示 dashboard(如每秒更新一次监控指标)需要高效的数据处理,需用**缓存(Cache)或异步加载(Asynchronous Loading)**优化,将加载时间从5秒降至1秒。

5. 实际应用:伦理工具的“落地指南”

本节将介绍实施策略、集成方法、部署考虑与运营管理,帮助架构师将伦理工具从“代码”转化为“生产环境的应用”。

5.1 实施策略:伦理设计的“三步法”

- 第一步:明确伦理目标:根据应用场景确定伦理目标(如医疗AI需重点关注可解释性与隐私,金融AI需重点关注公平性与问责制);

- 第二步:选择工具链:根据伦理目标选择工具(如医疗AI选SHAP、TensorFlow Privacy;金融AI选Aequitas、Fairlearn、IBM AI Fairness 360);

- 第三步:整合到流程:将工具整合到数据-模型-部署管道中(如用MLflow将Aequitas、Fairlearn、SHAP整合到模型训练流程)。

5.2 集成方法论:用MLflow整合伦理工具

MLflow是一款开源的模型管理工具,可用于整合伦理工具到模型训练流程中。以下是整合Aequitas、Fairlearn、SHAP的步骤:

- 数据处理阶段:用MLflow的

log_artifact功能记录Aequitas的偏见检测结果; - 模型开发阶段:用MLflow的

log_param功能记录Fairlearn的公平性约束参数(如demographic_parity_difference阈值),用log_figure功能记录SHAP的可解释性图; - 模型评估阶段:用MLflow的

log_metric功能记录模型的公平性指标(如demographic_parity_difference)和准确性指标(如accuracy); - 模型部署阶段:用MLflow的

deploy功能部署模型,并将Responsible AI Dashboard整合到部署后的应用中。

5.3 部署考虑因素:平衡“伦理”与“性能”

- 隐私保护与性能:差分隐私的噪声会影响模型性能,需权衡隐私预算(epsilon)与准确性(如epsilon=1.0时,准确性下降5%,但能满足GDPR的隐私要求);

- 公平性与性能:Fairlearn的公平性优化会影响准确性,需权衡公平性指标阈值与准确性(如demographic_parity_difference=5%时,准确性下降2%,但能满足公司的伦理要求);

- 可解释性与性能:SHAP的计算成本高,需权衡解释的详细程度与实时性能(如用近似方法(FastSHAP)解释实时应用的模型决策,牺牲部分准确性换取低延迟)。

5.4 运营管理:伦理监控的“日常流程”

- 建立伦理监控 dashboard:用IBM AI Fairness 360和Responsible AI Dashboard展示模型的伦理指标(如公平性、可解释性、隐私),让团队实时查看;

- 设置警报阈值:当伦理指标超过阈值时(如demographic_parity_difference>10%),触发警报(如发送邮件给架构师);

- 定期进行伦理审计:用OpenEthics每季度审计一次模型,检查是否符合伦理标准(如EU AI Act);

- 迭代优化:根据用户反馈(EthicsFlow)和伦理审计结果,迭代优化模型(如用Fairlearn重新训练模型,降低偏见)。

6. 高级考量:伦理工具的“未来挑战”

伦理工具不是“完美的”,需考虑扩展动态、安全影响、伦理维度与未来演化。

6.1 扩展动态:伦理工具的“自动化趋势”

- 自动敏感属性识别:Aequitas正在开发自动识别敏感属性的功能(如从文本数据中识别“性别”、“种族”);

- 自动公平性优化:Fairlearn正在开发自动调整公平性约束的功能(如根据数据分布自动选择demographic parity或equalized odds);

- 自动伦理审计:OpenEthics正在开发自动生成伦理审计报告的功能(如用LLM分析模型输出与伦理标准的符合性)。

6.2 安全影响:伦理工具的“副作用”

- 可解释性工具的安全风险:SHAP的解释可能暴露模型的内部结构,导致** adversarial attacks**(如攻击者根据SHAP的特征重要性图,修改输入数据以欺骗模型);

- 隐私工具的安全风险:TensorFlow Privacy的差分隐私可能被** membership inference attacks**(如攻击者根据模型输出推断某数据点是否在训练集中);

- 应对措施:结合** adversarial training**(对抗训练)和** robust privacy techniques**(如同态加密),降低安全风险。

6.3 伦理维度:伦理工具的“自身伦理”

- 工具的偏见:Aequitas的公平性指标是否准确?需验证(如用合成数据测试,确保Aequitas能正确检测出偏见);

- 工具的公正性:Fairlearn的优化是否会导致新的偏见?需定期检查(如用Aequitas检测优化后的模型);

- 工具的透明性:EthicsFlow的NLP分析逻辑是否透明?需公开(如发布NLP模型的训练数据与评估指标)。

6.4 未来演化向量:伦理工具的“发展方向”

- 结合大语言模型(LLM):用LLM生成伦理报告(OpenEthics)、自动分析用户反馈(EthicsFlow)、解释模型决策(SHAP);

- 跨模态伦理工具:处理图像、音频、文本等多模态数据的伦理问题(如用SHAP解释图像识别模型的决策);

- 去中心化伦理工具:用区块链技术记录伦理决策(如模型训练过程中的公平性优化步骤),提高问责制。

7. 综合与拓展:伦理设计的“战略建议”

7.1 跨领域应用:伦理工具的“场景适配”

- 医疗AI:重点关注可解释性(SHAP)与隐私(TensorFlow Privacy),让医生理解模型的诊断结果,保护患者数据;

- 金融AI:重点关注公平性(Aequitas、Fairlearn)与问责制(IBM AI Fairness 360),确保贷款、保险等决策的公平性,可追溯;

- 自动驾驶:重点关注可解释性(SHAP)与监控(IBM AI Fairness 360),让乘客理解自动驾驶的决策过程,监控决策的公平性(如对行人和车辆的优先级);

- 消费级AI:重点关注用户反馈(EthicsFlow)与透明性(Responsible AI Dashboard),收集用户对推荐系统、聊天机器人的伦理反馈,展示模型的决策逻辑。

7.2 研究前沿:伦理工具的“未解决问题”

- 如何量化伦理风险?:目前尚无统一的伦理风险量化指标(如“模型的伦理风险评分”);

- 如何平衡多个伦理目标?:如公平性、可解释性、隐私性之间的冲突,需开发多目标优化算法;

- 如何让伦理设计更自动化?:如自动选择伦理工具、自动优化伦理指标,需结合元学习(Meta-Learning)和大语言模型(LLM)。

7.3 开放问题:伦理工具的“待解之谜”

- 伦理工具的通用性:是否有一款工具能覆盖所有伦理问题?目前没有,需结合多个工具;

- 伦理工具的可扩展性:是否能处理大规模、多模态数据?需优化算法的时间与空间复杂度;

- 伦理工具的可接受性:用户是否信任伦理工具的输出?需提高工具的透明度(如公开工具的技术原理)和可验证性(如让用户自行检查工具的输出)。

7.4 战略建议:架构师的“伦理设计指南”

- 建立伦理设计的文化:培训团队的伦理意识,让每个人都理解伦理设计的重要性;

- 将伦理工具整合到流程中:不是事后补救,而是嵌入数据-模型-部署-反馈的全流程;

- 定期更新工具链:关注伦理工具的最新进展(如Aequitas的自动敏感属性识别功能),及时更新工具;

- 与伦理专家合作:伦理设计不是技术问题,需结合伦理专家的意见(如法律专家、社会学家);

- 保持透明:向用户公开模型的伦理设计过程(如用Responsible AI Dashboard展示),提高用户信任。

8. 结论:伦理工具是负责任AI的“基石”

AI应用架构师的核心任务是平衡“技术性能”与“伦理合规”。本文推荐的8款工具(Aequitas、Fairlearn、SHAP、TensorFlow Privacy、IBM AI Fairness 360、EthicsFlow、OpenEthics、Responsible AI Dashboard)覆盖了伦理设计的全流程,能帮助架构师高效完成伦理设计。

但需注意,伦理工具不是“万能的”,需结合理论框架、实践经验与伦理专家的意见。未来,伦理工具将向自动化、智能化、安全化方向发展,帮助架构师更轻松地实现负责任AI。

最后,引用Google AI Principles的一句话:“AI should be developed and used in a way that is beneficial to society.” 伦理设计不是“约束”,而是“让AI更符合人类价值”的必经之路。

参考资料

- EU AI Act(2021):https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:52021PC0206

- Google AI Principles(2018):https://ai.google/principles/

- Fairlearn Documentation(Microsoft):https://fairlearn.org/

- SHAP Documentation(UW):https://shap.readthedocs.io/

- TensorFlow Privacy Documentation(Google):https://www.tensorflow.org/privacy

- IBM AI Fairness 360 Documentation(IBM):https://aif360.mybluemix.net/

- Aequitas Documentation(MIT):https://dssg.github.io/aequitas/

- EthicsFlow Documentation(Stanford):https://ethicsflow.stanford.edu/

- OpenEthics Documentation(Open Source):https://openethics.io/

- Responsible AI Dashboard Documentation(Microsoft):https://responsible-ai.microsoft.com/

附录:工具选择指南

| 应用场景 | 推荐工具 |

|---|---|

| 医疗AI | SHAP(可解释性)、TensorFlow Privacy(隐私) |

| 金融AI | Aequitas(偏见检测)、Fairlearn(公平性优化)、IBM AI Fairness 360(监控) |

| 自动驾驶 | SHAP(可解释性)、IBM AI Fairness 360(监控) |

| 消费级AI | EthicsFlow(用户反馈)、Responsible AI Dashboard(透明性) |

| 政府AI | OpenEthics(伦理审计)、IBM AI Fairness 360(监控) |

更多推荐

已为社区贡献801条内容

已为社区贡献801条内容

所有评论(0)