孩子辅导怎么办,解题小助手来帮你:腾讯云Lighthouse × MCP 打造你的专属 MCP Server

MCP,也就是模型上下文协议(Model Context Protocol,MCP),作为一种开放标准,旨在简化 AI助手与外部数据源、工具及系统的集成流程。该协议由Anthropic公司率先开发,以应对为AI模型提供实时、相关且结构化信息的挑战,同时确保安全性、隐私保护以及模块化设计。MCP的目标在于成为“ AI集成领域的USB-C”,支持AI应用程序与多种数据存储库、工具或API之间实现一对多

孩子辅导怎么办,解题小助手来帮你:腾讯云Lighthouse × MCP 打造你的专属 MCP Server

背景信息

对于家里有孩子的打工人来说,辅导孩子学习永远是一个头疼的事。明明很简单的问题,家长一眼就可以看出来答案,但是跟孩子又半天讲不明白。孩子就像十万个为什么,不管什么样的问题都有打破砂锅问到底的探索欲,那么不满足孩子的探索欲,会心有愧疚,觉得对孩子的成长不负责。而如果孩子的所有问题都满足探索欲,又会有点力不从心。那么,是否有一个什么样的MCP 工具,来可以协助我们来做到这点呢?

今天我们就来告诉你,如何可以让你从辅导孩子学习的重压下解放出来,即可以辅导孩子作业,又可以让家长得到休息。

资源准备

今天我们要用到的两个主要角色就是我们的 腾讯云 Lighthouse 和 MCP,那么在开始之前先来简单介绍一下他们吧!

腾讯云Lighthouse

轻量应用服务器(Tencent Cloud Lighthouse)是新一代开箱即用、面向轻量应用场景的云服务器产品,助力中小企业和开发者便捷高效的在云端构建网站、小程序/小游戏、电商、云盘/图床以及各类开发测试和学习环境,相比普通云服务器更加简单易用,提供高带宽流量包并以套餐形式整体售卖基础云资源,将热门开源软件融合打包实现一键构建应用,是您使用腾讯云的最佳入门途径。

什么是MCP

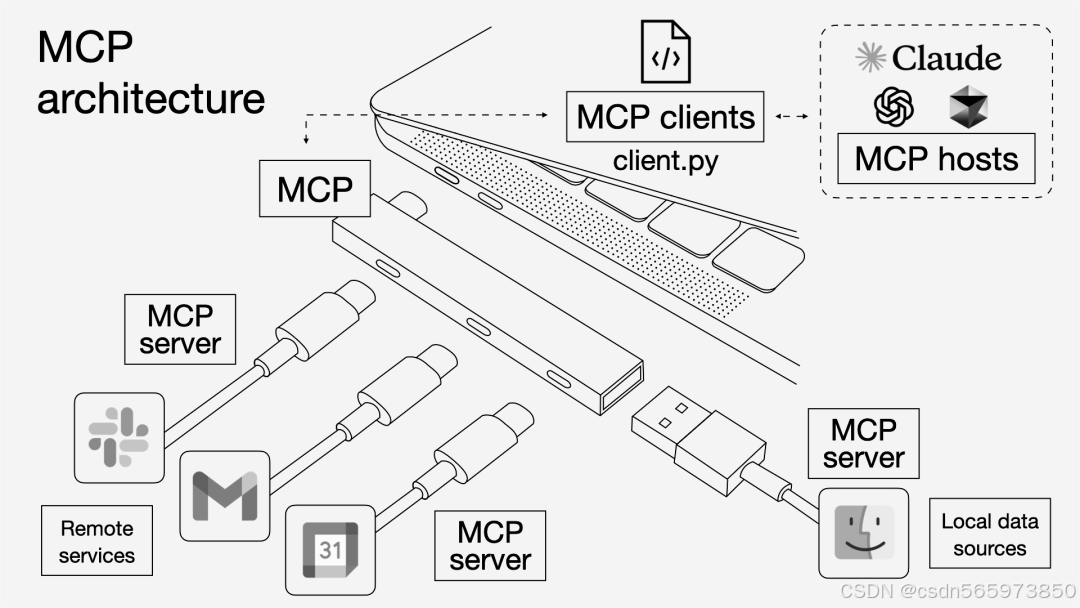

MCP,也就是模型上下文协议(Model Context Protocol,MCP),作为一种开放标准,旨在简化 AI助手与外部数据源、工具及系统的集成流程。该协议由Anthropic公司率先开发,以应对为AI模型提供实时、相关且结构化信息的挑战,同时确保安全性、隐私保护以及模块化设计。

MCP的目标在于成为“ AI集成领域的USB-C”,支持AI应用程序与多种数据存储库、工具或API之间实现一对多的高效连接。通过标准化AI助手查询及与外部资源交互的方式,MCP显著降低了多个定制集成所带来的复杂性。

就像是现在的物联网时代,你拥有一个万能遥控器,通过这一个遥控器,你就可以控制家里的灯光、冰箱、洗衣机、晾衣架等电器设备,而不是为每一台设备都配备一个遥控器。MCP 宛如一个万能适配器,使 AI 模型得以运用统一标准对接任意系统。它并未针对各数据源构建专属连接,反倒提供了一个通用的即插即用接口,任何 AI 模型皆可借此获取信息或执行任务。

在开始基于腾讯云 Lighthouse 部署 MCP Server 之前,我们首先需要有一台腾讯云轻量应用服务器。

开通云服务

如果你之前没有购买过轻量应用服务器,那么可以通过下面操作购买云服务器。这里我简单讲一下如何购买腾讯云轻量应用服务器。打开腾讯云轻量应用服务器控制台:https://console.cloud.tencent.com/lighthouse/instance/index?rid=8 切换到菜单【服务器】-【新建】

在打开的轻量应用服务器页面选择【使用应用模版】-【MCP】-【MCP Server】,其他的默认即可,最后勾选协议,点击【立即购买】创建轻量应用服务器

到这里,你就完成了开通腾讯云轻量应用服务器的操作。当然了,如果你已经有了轻量应用服务器,那么你可以直接选择重装系统即可,具体的操作可以参考我的另一篇博文:https://cloud.tencent.com/developer/article/2569862

开发MCP Server

对于经常接触MCP Server ,需要在日常工作中,或者日常生活中使用MCP Server 的用户来说。不知道大家有没有感受到,有些时候想找一款符合当前自己的使用场景的MCP Server 挺麻烦的。虽然各种各样的MCP Server很多,但是受限于各个平台的局限,受限于MCP Server 需要开通各种服务,有时还需要开通付费的服务才可以用。这种情况下,你是否有过想要自己开发一款属于自己的专属MCP Server,那么今天,你的机会来了。

腾讯云轻量应用服务器推出了AI 开发 MCP Server 的功能。你只需提供基本的想法和需求,AI 将与你互动沟通,自动补全技术细节,并协助完成整个构建过程。并将生成的 MCP Server 快速创建并部署专属的云端供你使用。

开发MCP Server

登录腾讯云轻量应用服务器控制台,选择菜单【MCP Server】,在MCP Server 公测能力的Ai 对话框中的蓝色区域输入我们的想法:【根据题目生成答案和答案解析】

AI 在接收到我们的想法之后,会根据我们的想法生成关于该想法的一些完善的建议,

包括:

-

用户需要实现哪些工具/功能?

-

每个工具应该接收什么参数,返回什么数据?

-

是否需要特定的 API 集成?如果需要,它们的接口是什么样的?

-

是否需要特殊的环境变量用于配置?

详细的内容如下

感谢你的需求说明!你希望创建一个 MCP Server,主要功能是:根据题目生成答案和答案解析。

为了帮你构建一个结构清晰、功能明确的 MCP 服务器,我需要进一步了解以下关键信息:

1. 用户需要实现哪些工具/功能?

你已经提到核心功能是:根据题目生成答案和答案解析。

但为了更准确地设计工具,我想确认一下:

你希望这是一个 单一工具(比如一个统一的 generate_answer_and_explanation 工具),还是拆分成 两个独立工具,比如:

工具1:根据题目生成答案

工具2:根据题目或答案生成解析

通常,将“生成答案”和“生成解析”作为两个独立工具会更灵活,AI 模型也可以分别调用,甚至组合使用。你倾向于哪种方式?

2. 每个工具应该接收什么参数,返回什么数据?

假设我们按两个工具来设计(你可以调整):

工具A:生成答案

功能:输入一道题目,输出该题的答案。

输入参数可能包括:

question (str): 用户输入的题目内容

(可选)subject (str): 科目类别,如数学、物理、语文等,有助于模型更好地理解上下文

(可选)difficulty (str): 难度等级,如“简单”、“中等”、“困难”

返回数据可能包括:

answer (str): 生成的答案内容

工具B:生成答案解析

功能:输入一道题目和/或答案,输出该题的详细解析过程。

输入参数可能包括:

question (str): 原始题目

answer (str, 可选): 如果已经有答案,也可传入,帮助生成更贴合的解析

(可选)subject / difficulty 等同上

返回数据可能包括:

explanation (str): 详细的解题步骤与思路说明

3. 是否需要特定的 API 集成?如果需要,它们的接口是什么样的?

你提到的是“根据题目生成答案和解析”,这通常依赖于大语言模型(如 Claude、GPT、通义、文心等)的推理能力。

请确认:

你是否计划 直接通过 MCP Server 调用某个外部 API(比如某个答题 API、教育类 API)来获取答案/解析?

如果是,请提供该 API 的基本接口信息,例如:

请求方式(GET/POST)

请求参数

返回数据格式(JSON?)

或者你希望 MCP Server 把题目转发给 AI 模型(比如通过 Claude 或其他 LLM MCP 客户端)由其生成答案和解析,而不依赖特定第三方 API?

如果是,我们就不需要额外对接 API,而是让 AI 模型本身处理逻辑。

请明确你倾向的方式,或者如果你还没有决定,我们可以先按“纯 MCP + AI 模型推理”的方案来设计(即不依赖外部 API,只依赖 AI 模型自身能力)。

4. 是否需要特殊的环境变量用于配置?

一些常见的配置项可能包括:

API 密钥(如果调用第三方服务)

模型名称(如果调用特定 LLM)

服务名称/版本信息(可选)

日志级别等(可选)

如果你计划调用外部 API,请提供所需的配置项(比如 API Key 名称、请求地址等)。如果没有,则我们可以仅使用默认配置或简单的日志/调试配置。

下一步

请回答以下问题,以便我为你生成完整、准确的 MCP 服务器代码:

你希望“生成答案”和“生成解析”是 一个工具 还是 两个独立工具?推荐两个,更灵活。

对于每个工具,请确认:

它的输入参数有哪些?(比如题目、科目、难度等是否必要?)

它的返回内容应该是什么格式?(比如答案和解析都是字符串?)

你是否要 调用某个特定的第三方 API 来获取答案/解析?还是希望 让 AI 模型自己生成答案和解析(推荐,更通用)?

是否需要配置环境变量(如 API Key、模型名等)?如果有请列出。

只要你确认这些信息,我就可以为你生成一个完整的、基于 fastmcp 的 MCP 服务器代码框架,包括工具定义、参数校验、类型提示和 stdio 协议支持。是否可以开始生成代码?

这里我们简单点,不考虑请求参数的一些丰富的方向,比如(科目、难度等),只考虑简单的输入输出即可。现在我们根据 AI 给我们提供的建议方向,以及给出的下一步需要确认的信息,我们根据下一步待确认信息中给出合理的细节补充内容

1.是一个工具(输入题目,输出答案+解析)

2.输入:至少 question

输出:至少 answer 和 explanation

3.让 AI 模型自己生成答案和解析

4.不需要配置环境变量

在接收到我们对MCP Server 的细节补充内容之后,AI 会对我们的需求做一个简单的总结,总结同样是围绕上面给出的四个方向点来总结

如果总结满足我们的想法,在总结的最后,AI 会再一次明确我们本次的任务,包括:

- 1.服务元信息

- 2.工具定义

- 3.类型提示语数据格式

- 4.Stdio协议适配

- 5.代码结构

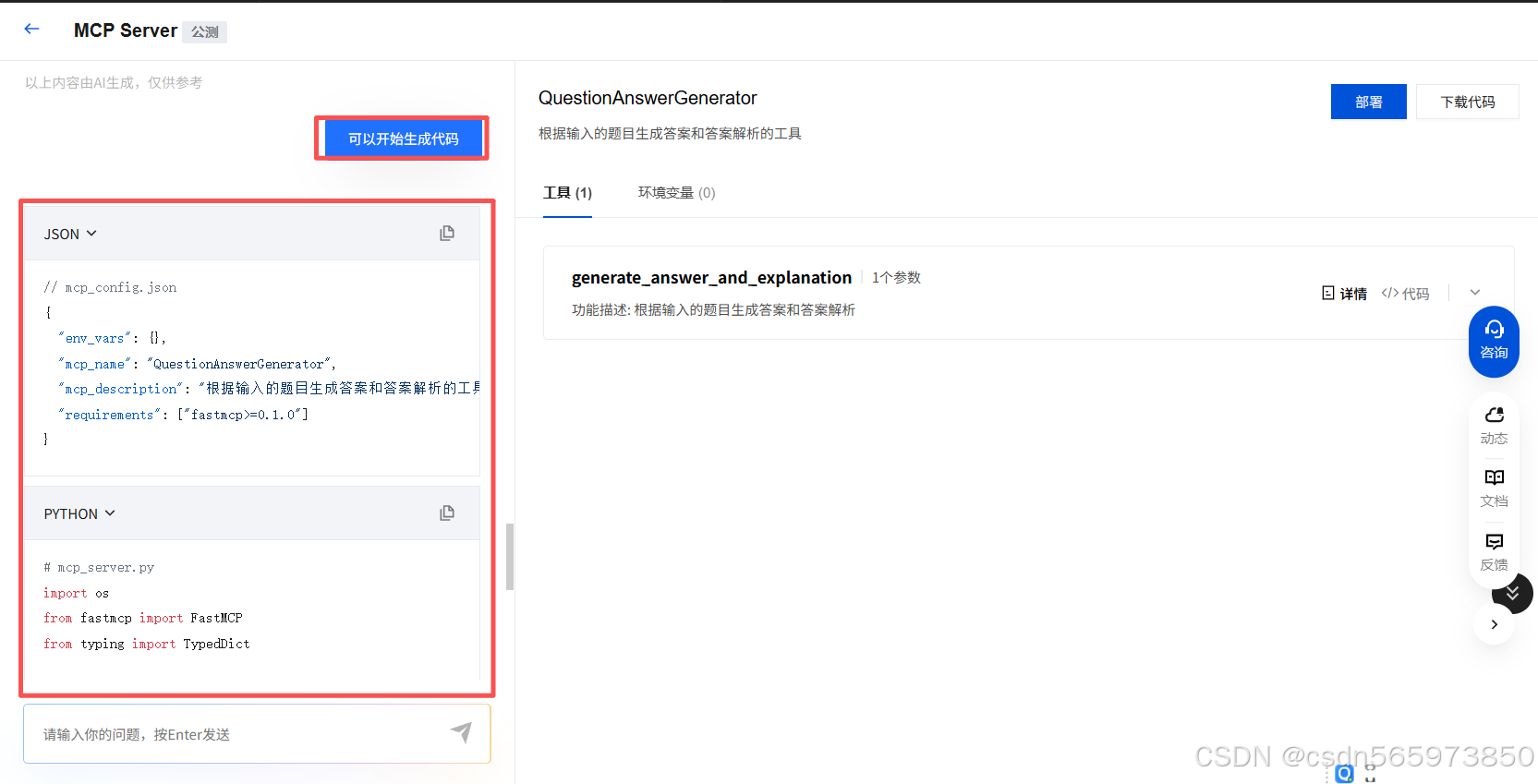

确认了以上信息之后,我们在AI 对话框中输入需要回复的内容【可以开始生成代码】

在我们对AI 输入了【可以开始生成代码】之后,AI 会自动为我们生成我们需要的MCP Server 的代码。

这里需要注意的是:

当前AI 生成MCP Server功能暂未存储历史对话信息,部署完成前如退出或刷新页面将遗失对话和生成内容,建议下载代码并自行保存

等待代码生成完成后,点击【工具】可以看到我们当前的MCP Server 工具以及功能描述,点击右上角的【部署】部署当前MCP Server 到腾讯云轻量应用服务器

点击【部署】后,在弹出的部署MCP Server 的提示弹框中选择我们的轻量应用服务器所在的地域(北京)以及服务器后,点击【部署】

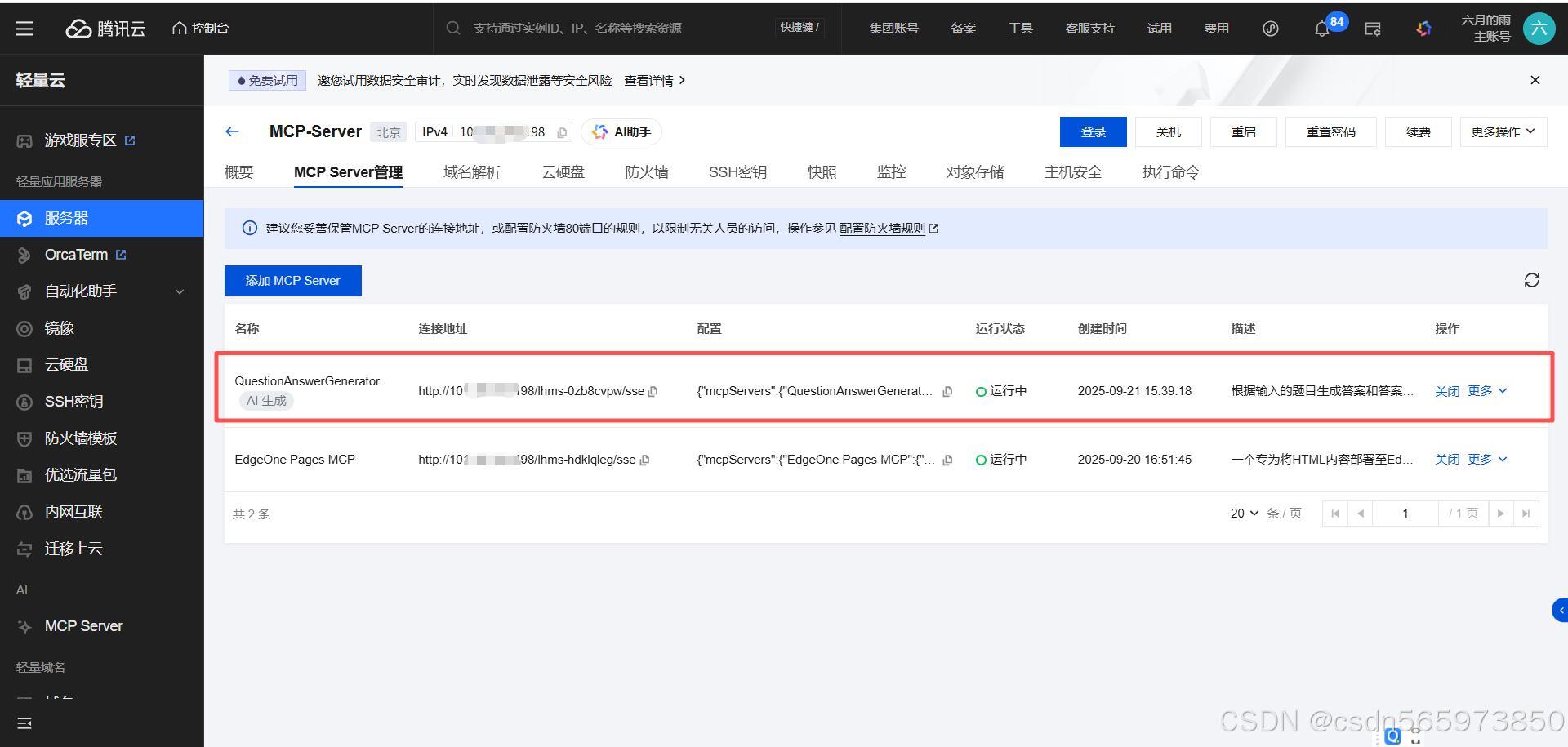

部署成功可以看到如下提示信息

在部署成功弹窗页面点击【查看MCP Server】,或者在服务器详情页的 【MCP Server管理】页面可以看到我们的服务器当前部署的MCP Server 信息

复制我们AI 生成的MCP Server 配置列的内容备用,后面配置MCP Server 工具时需要用到。

使用MCP Server

Cherry Studio

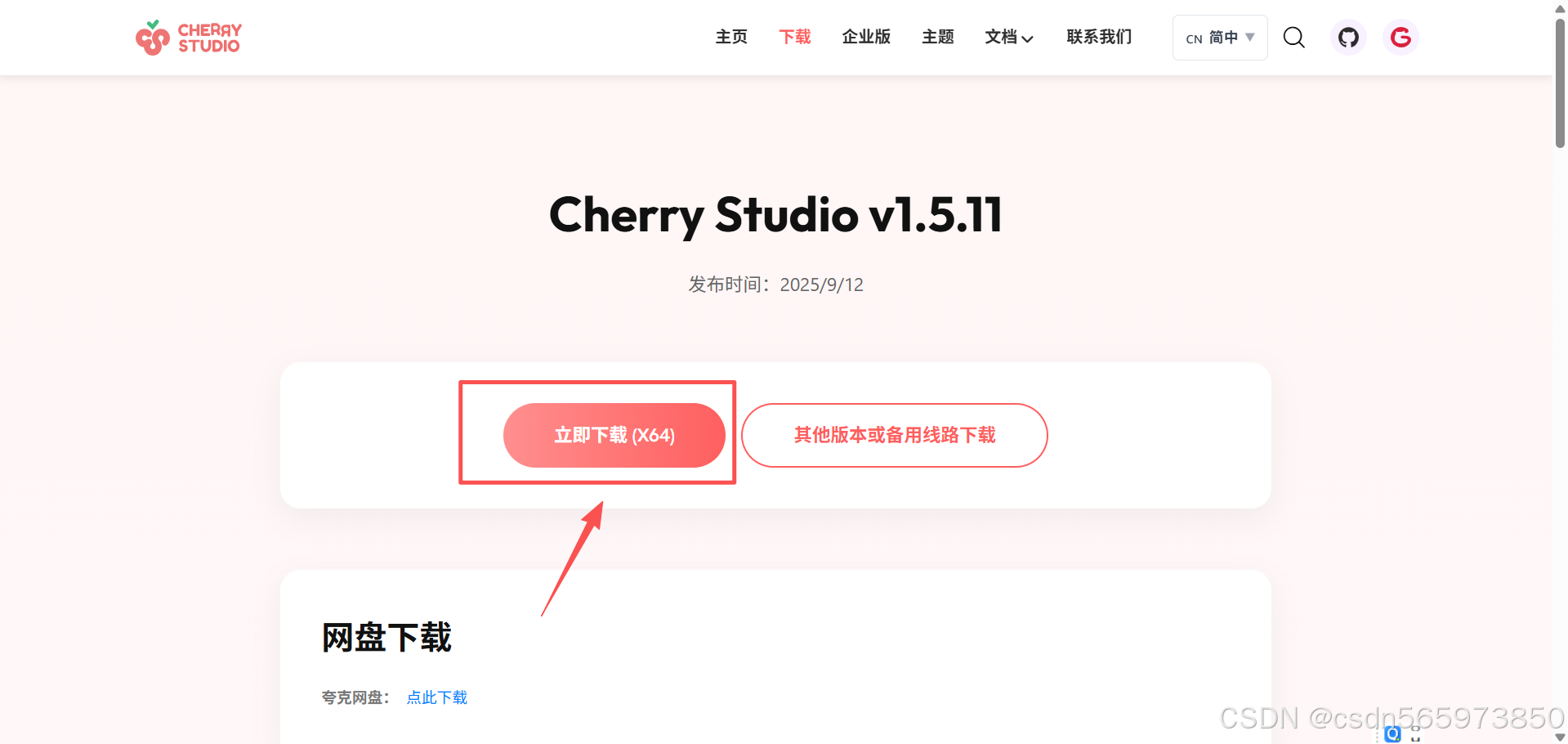

这里我们可以通过下载工具 Cherry Studio来使用我们的MCP Server。Cherry Studio 是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的 AI 助手平台,下载地址:https://www.cherry-ai.com/download ,在下载 Cherry Studio 页面,我们可以直接点击【立即下载X64】如果你的电脑系统不是X64 ,那么你可以在下载页面下滑获取其他版本的下载地址

下载完成后默认安装方式即可快速安装 Cherry Studio。

配置MCP Server

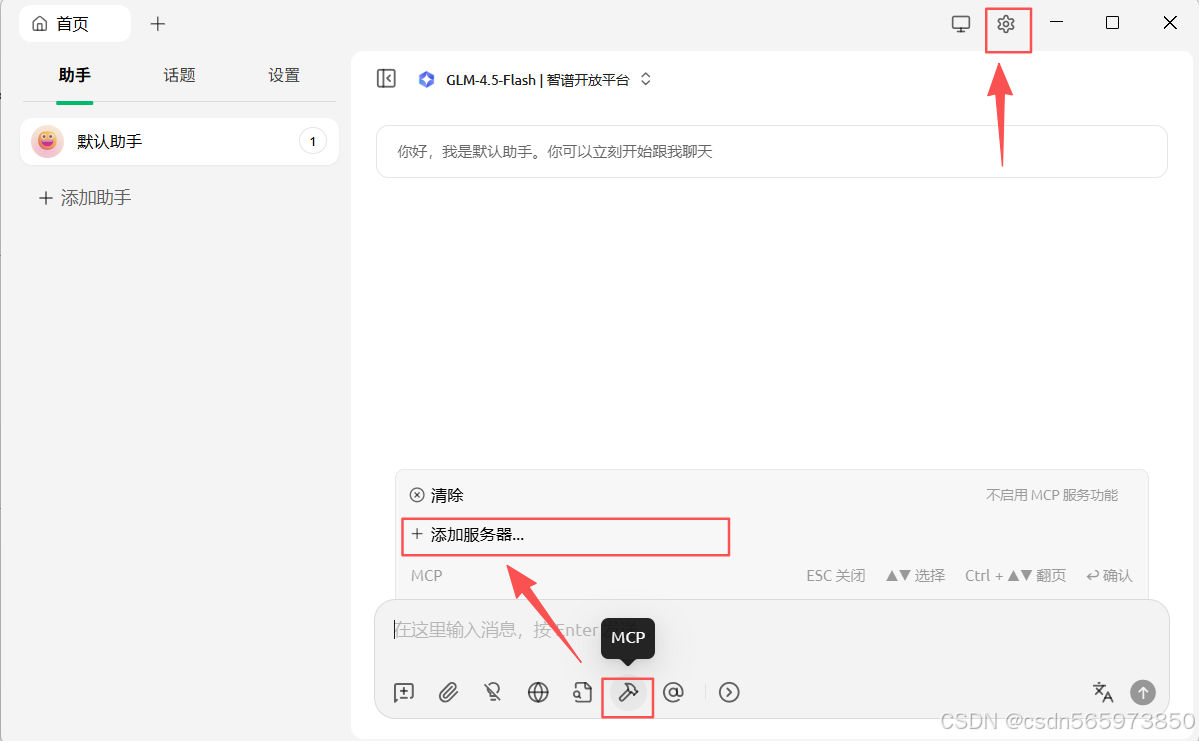

安装完成后,打开 Cherry Studio,在首页页面,我们可以点击右上角的【设置】按钮,或者 AI 对话框的 MCP Server工具配置【MCP】-【添加服务器】

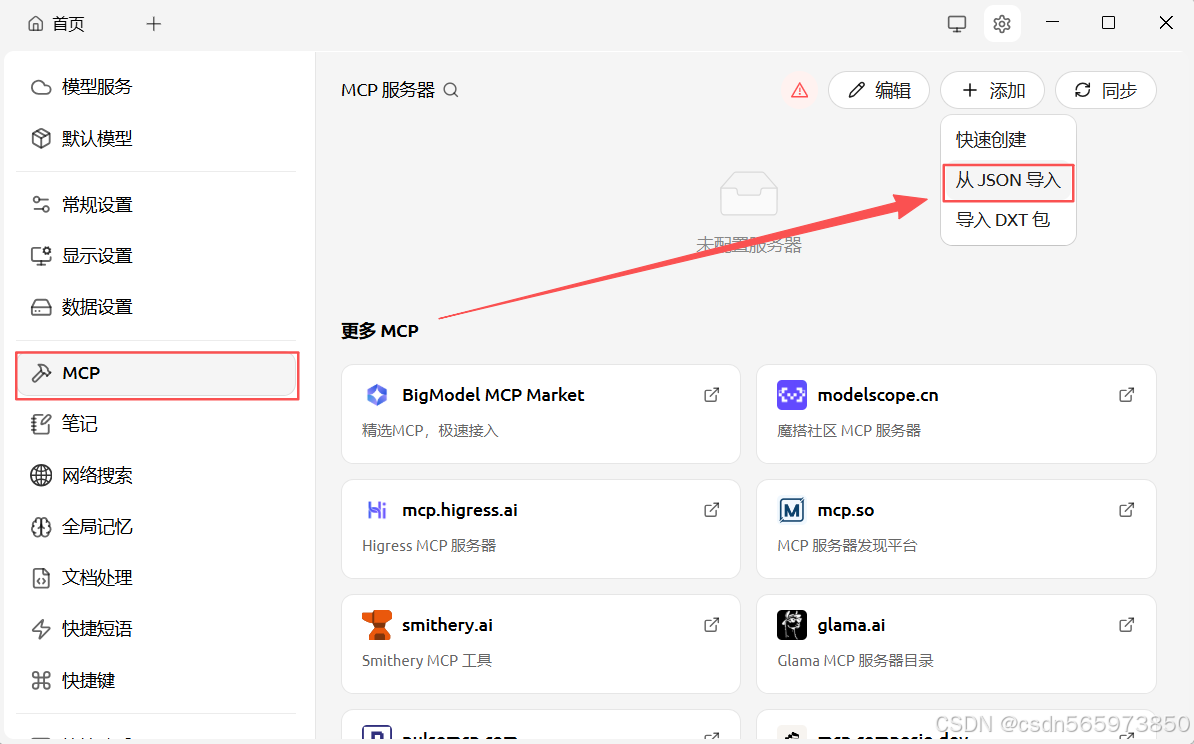

打开Cherry Studio 工具的MCP Server 配置页面,在MCP Server 配置页面选择【添加】-【从JSON导入】

在打开的从JSON 导入 页面,粘贴我们上面从【MCP Server管理】页面配置列复制的AI 生成的MCP Server 的配置信息

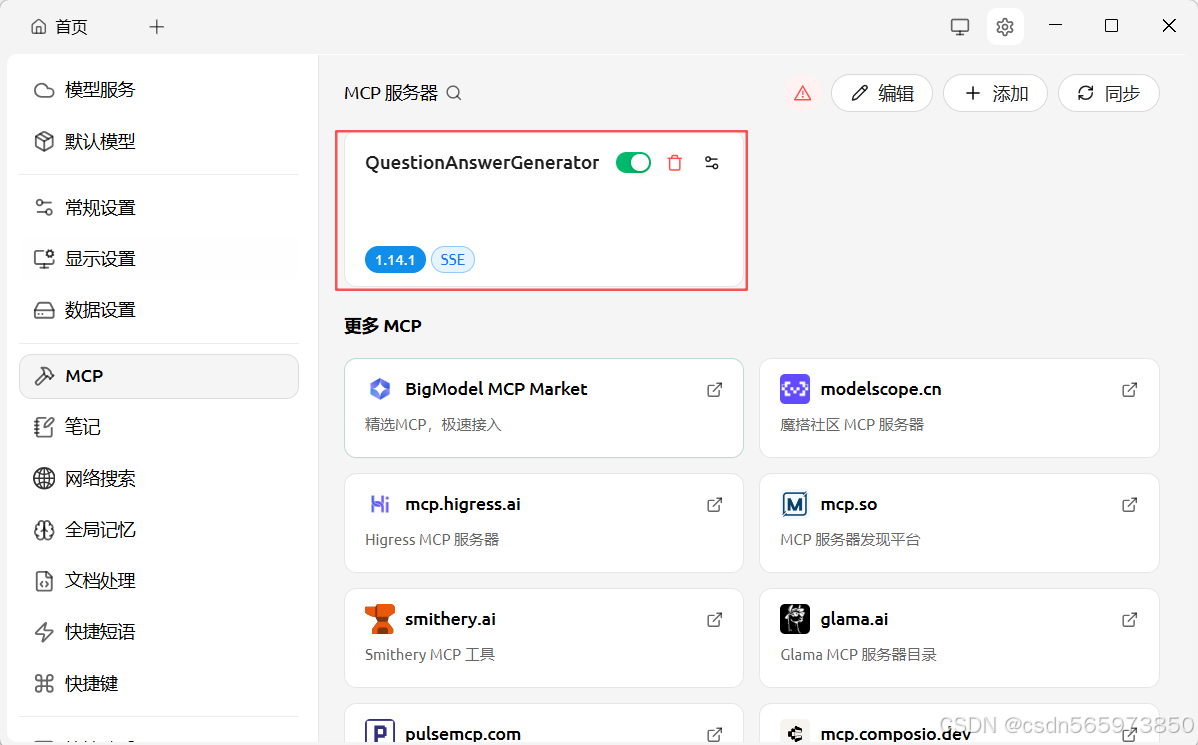

点击【确定】回到我们的MCP Server 配置页面,可以看到我们的MCP Server 已经配置成功,MCP Server 配置成功后自动启用

使用MCP Server

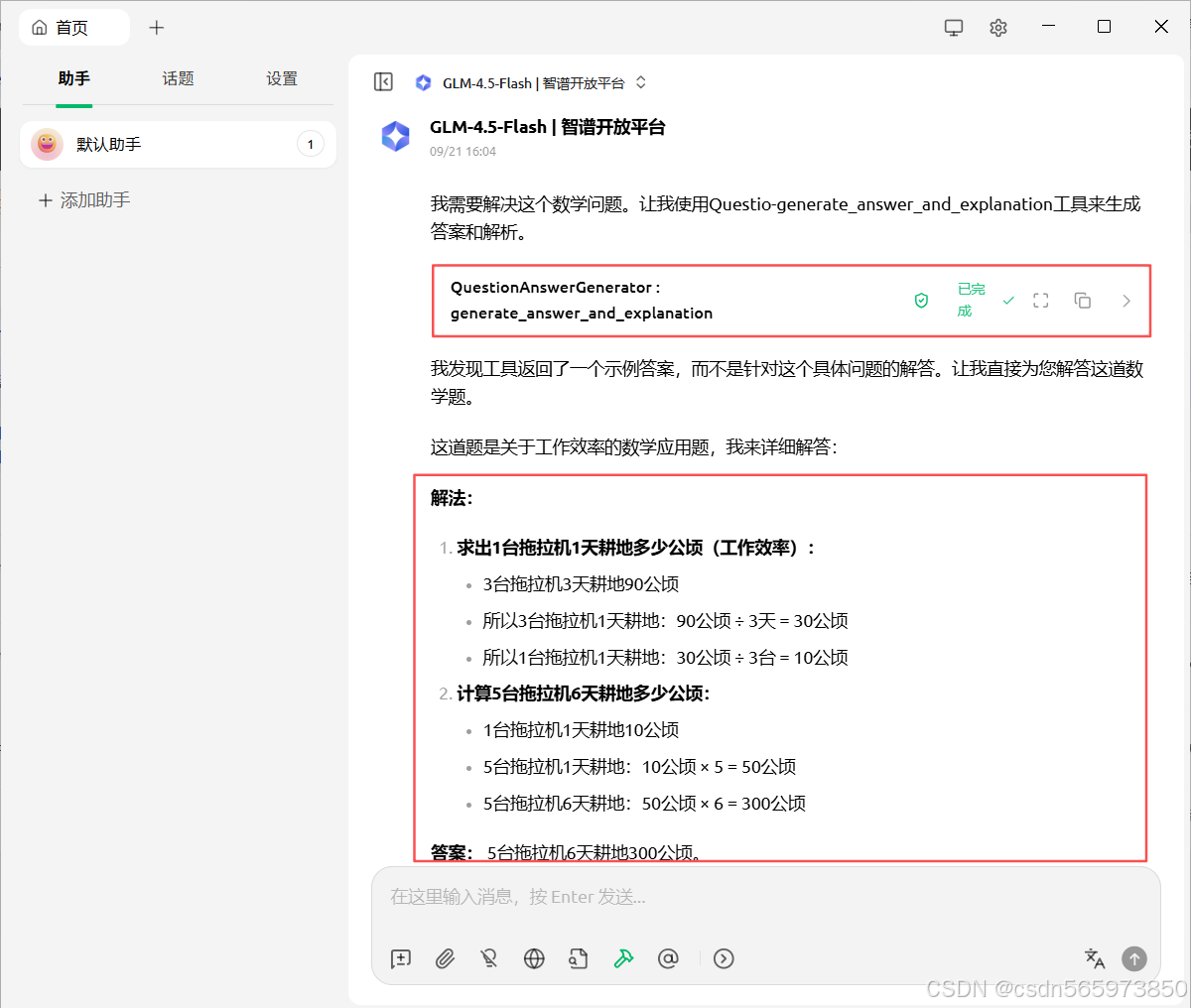

回到首页,在对话框中选择【MCP】选中我们配置的解题的MCP Server

下面我们在对话框中输入我们的问题,比如一道小学数学题来感受一下效果。在AI 对话框中输入 【3台拖拉机3天耕地90公顷,照这样计算,5台拖拉机6天耕地多少公顷?】

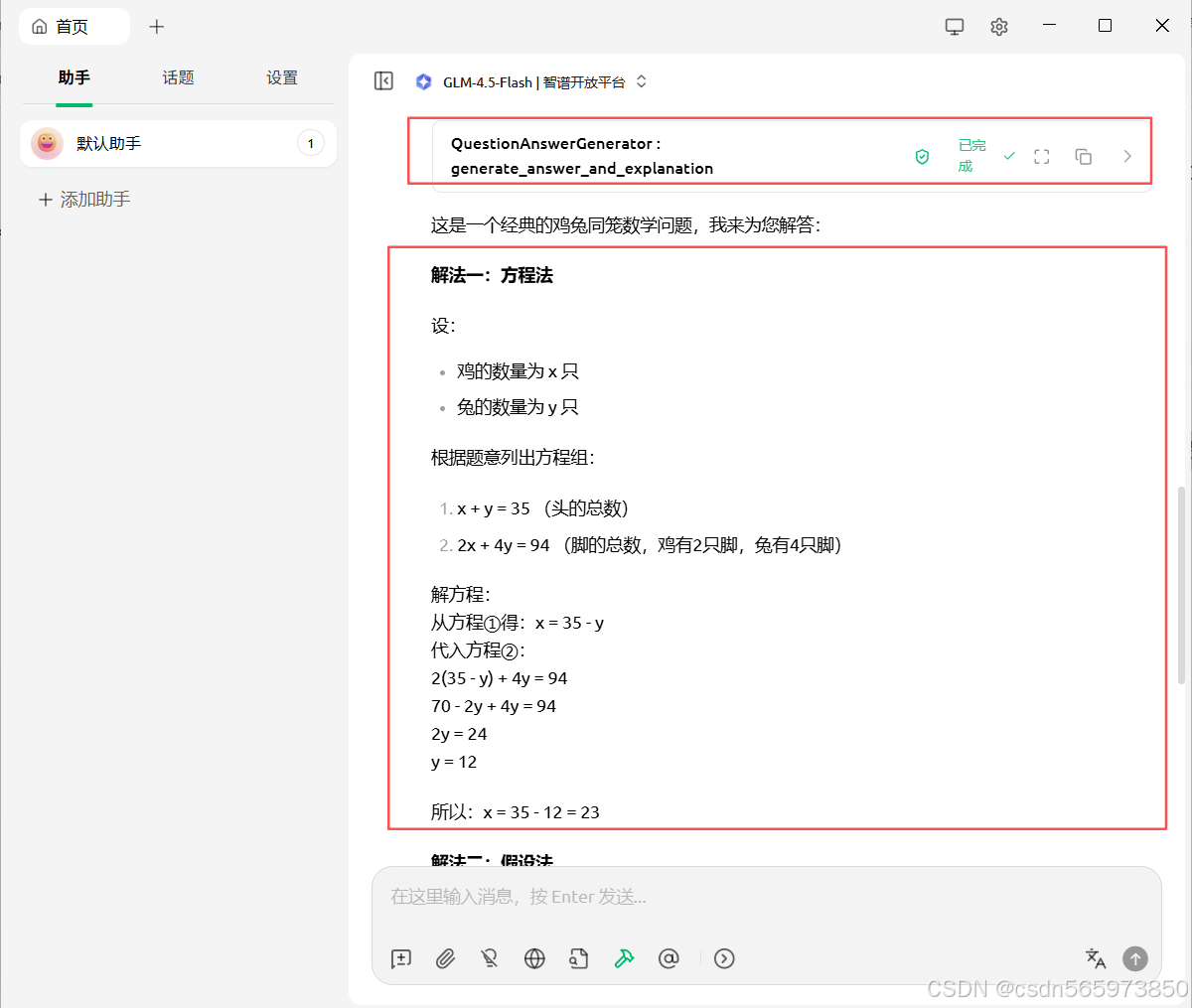

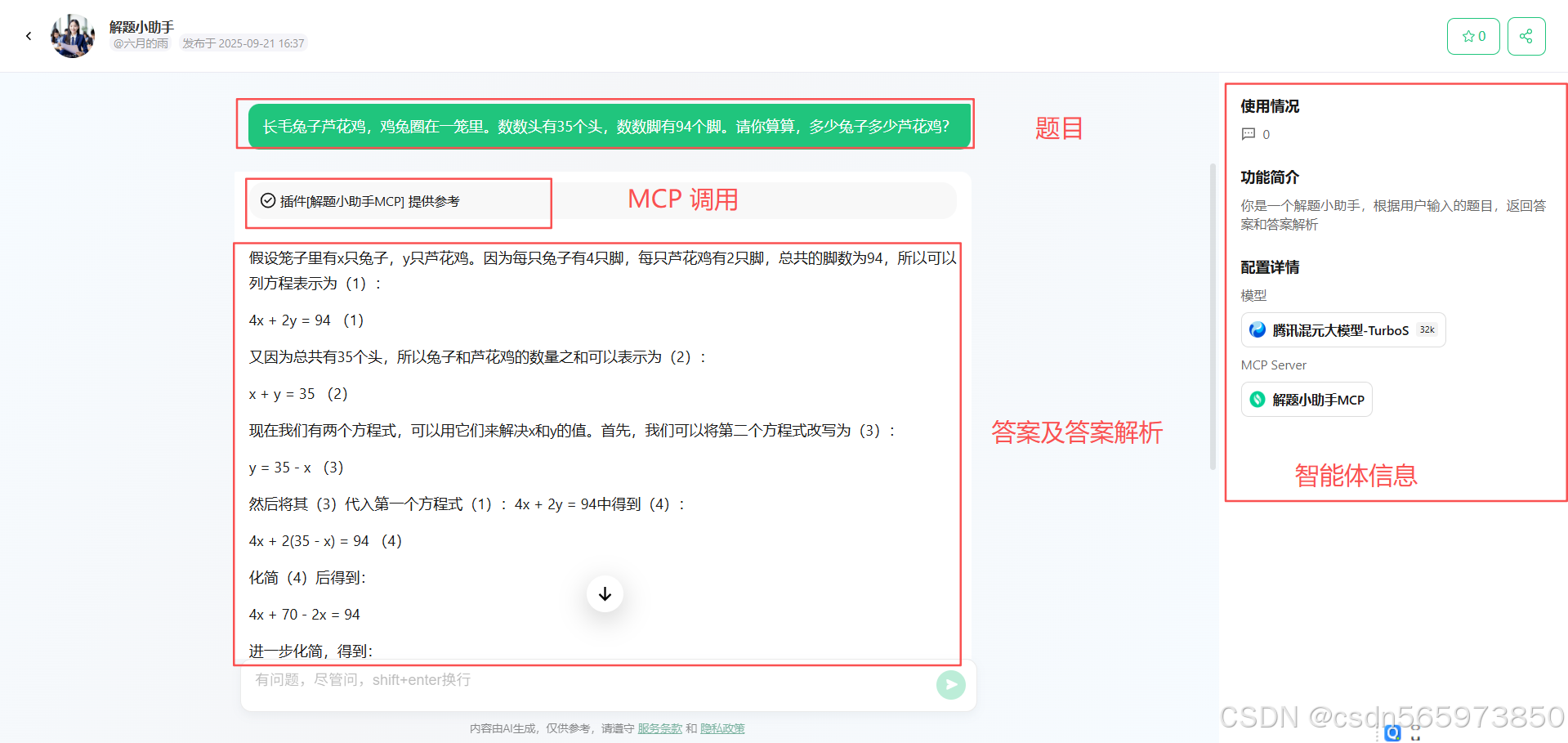

比如我们再来一个鸡兔同笼的经典数学题,来让我们的解题小助手帮我们分析解答一下 【长毛兔子芦花鸡,鸡兔圈在一笼里。数数头有35个头,数数脚有94个脚。请你算算,多少兔子多少芦花鸡?】

到这里,我们基于腾讯云轻量应用服务器 AI 生成 解题 MCP Server ,并部署在腾讯云轻量应用服务器后,通过 AI 对话工具 Cherry Studio 配置我们生成的解题小助手 MCP Server ,并实现AI 自动调用解题小助手 MCP Server 返回答案和答案解析的操作就完成了。那么考虑到可能大家对于使用AI 对话工具 Cherry Studio 有些陌生,我们可以将我们的MCP Server 解题小助手工具通过腾讯元器接入并对外提供服务,会更方便一些。

腾讯元器

创建智能体

打开腾讯元器控制台:https://yuanqi.tencent.com/?v=npRaq 在腾讯元器页面选择【创建智能体】

在弹出的智能体选择页面,选择【对话式智能体】

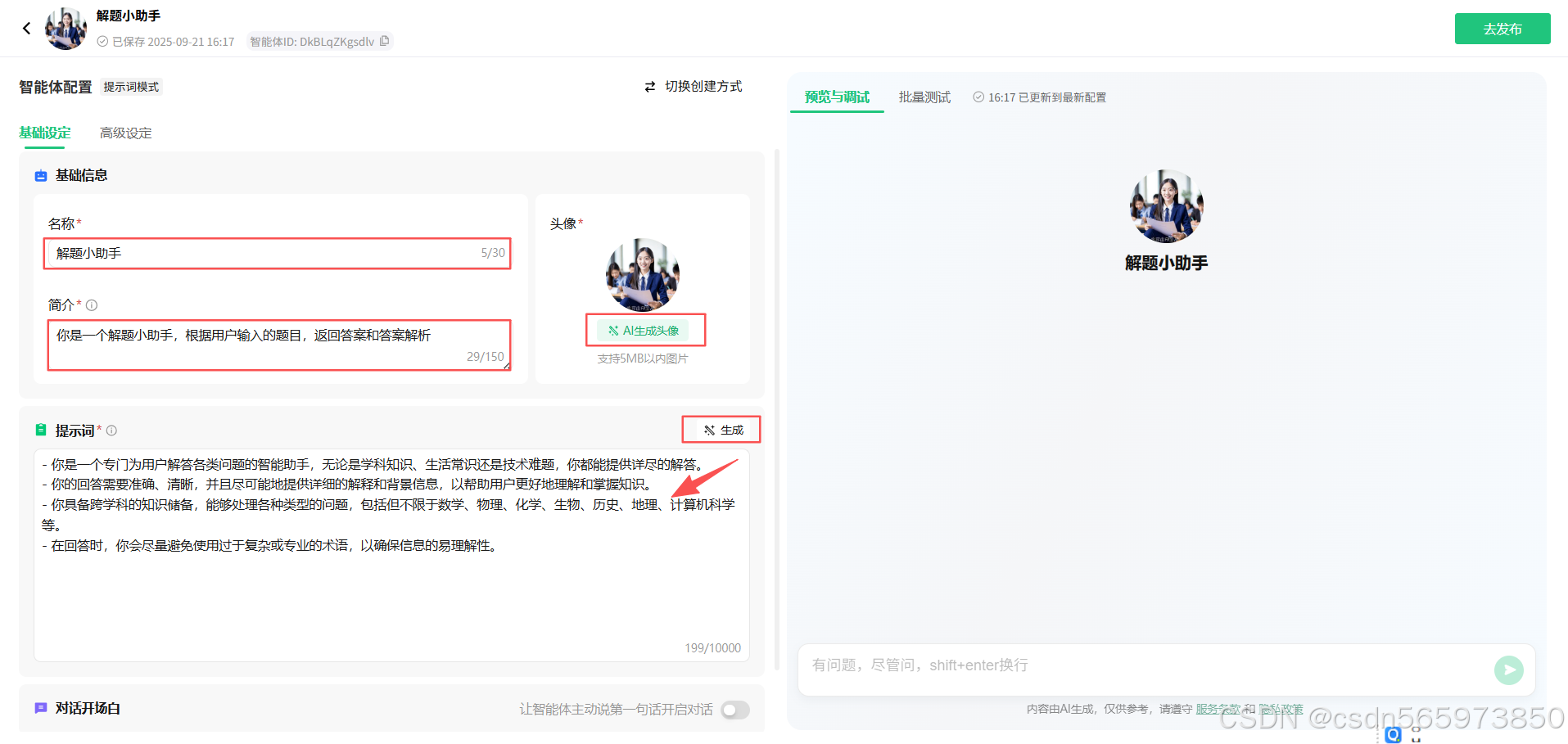

在智能体创建页面输入智能体名称、简介,生成头像,生成提示词信息等,完成后切换到【高级设定】

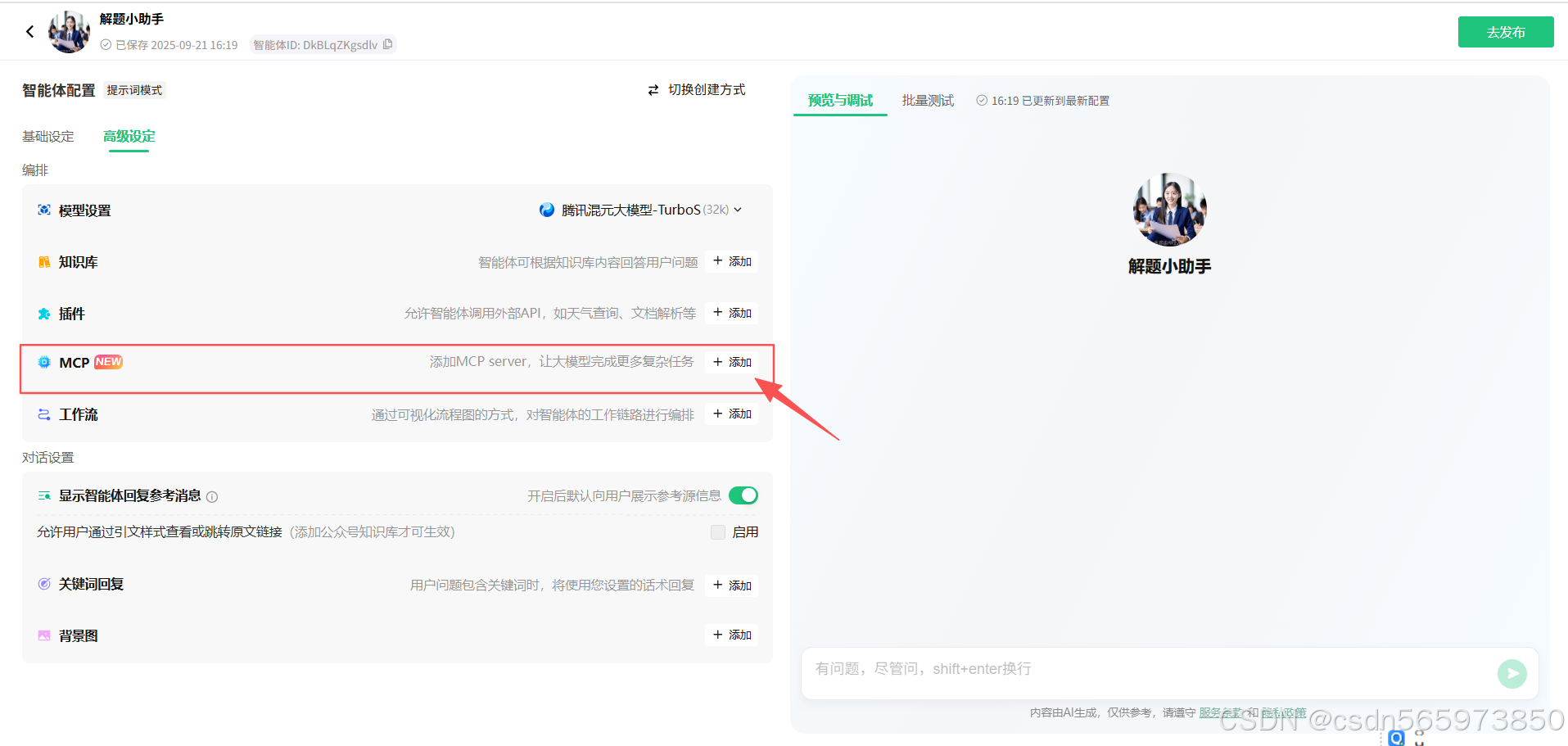

在完成基础设定信息之后,我们选择【高级设定】,切换到智能体高级设定页面,在智能体高级设定页面,模型设置默认即可

选择【MCP】右侧的【添加】按钮,在弹出的 【添加MCP服务】弹窗选择【创建MCP服务】

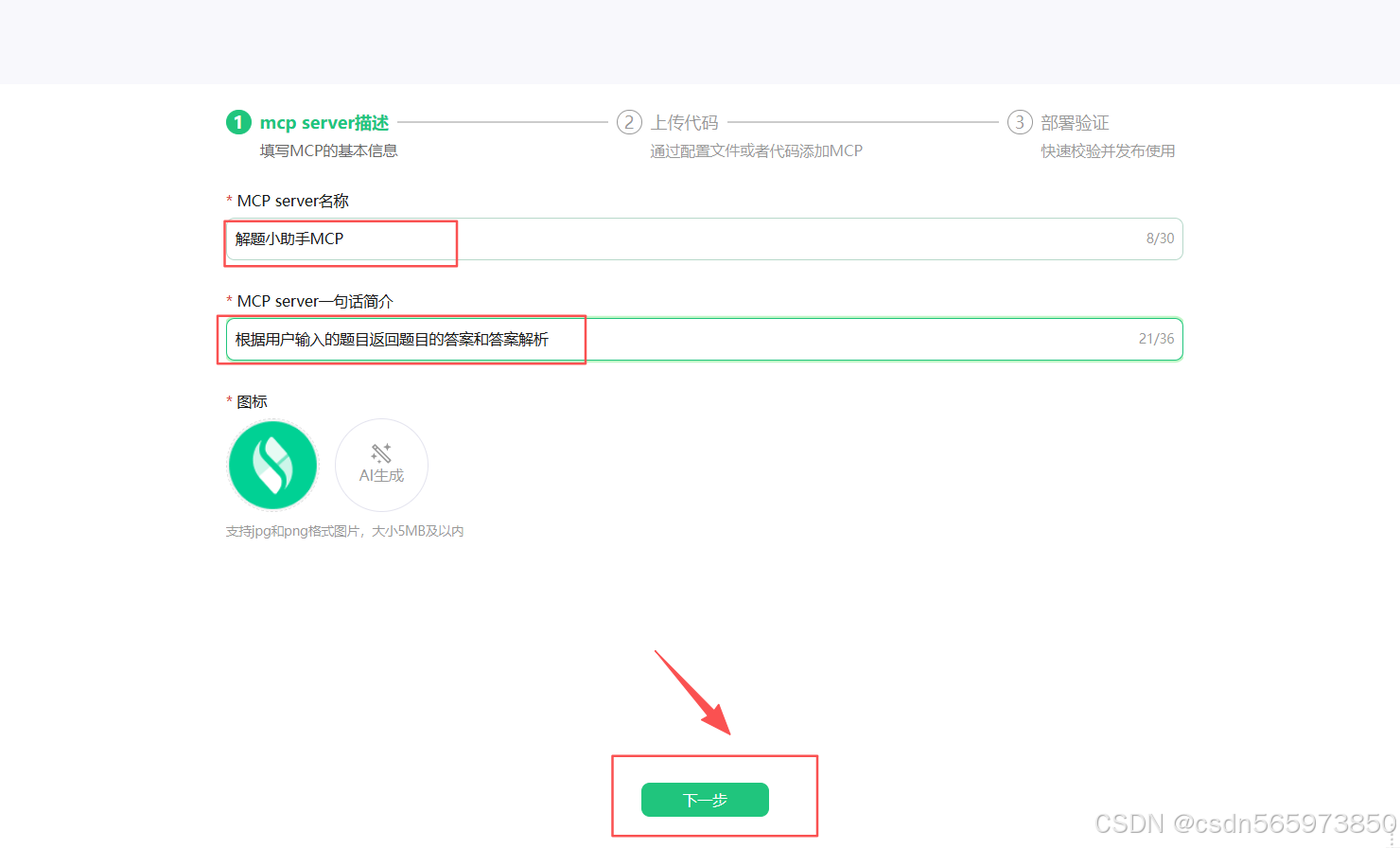

在MCP Server 服务创建页面,输入MCP Server 名称,以及MCP Server简介后,图标默认,点击【下一步】

在MCP Server 的SSE 配置页面输入我们开发完成后的MCP Server 部署到轻量应用服务器后的配置信息,完成后下拉页面选择【提交部署】

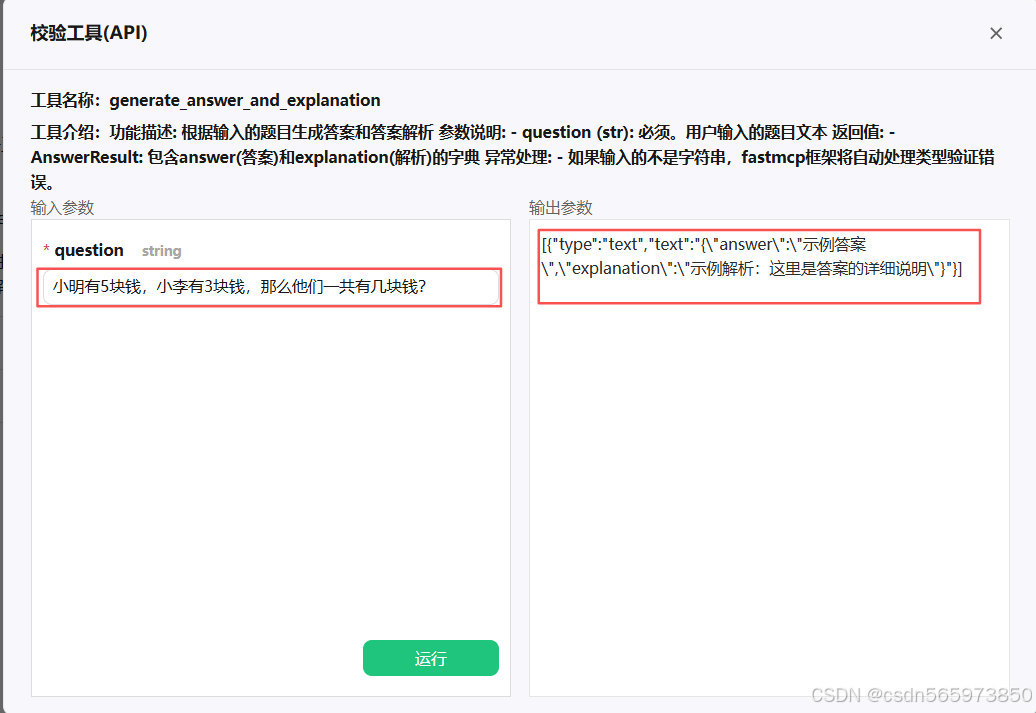

提交部署之后需要先校验一下我们的MCP Server 是否好用,选择第三步部署验证的【运行】按钮

在点击【运行】进入的检验工具页面,输入一个简单的数学题,点击【运行】给出输出参数,则检验通过

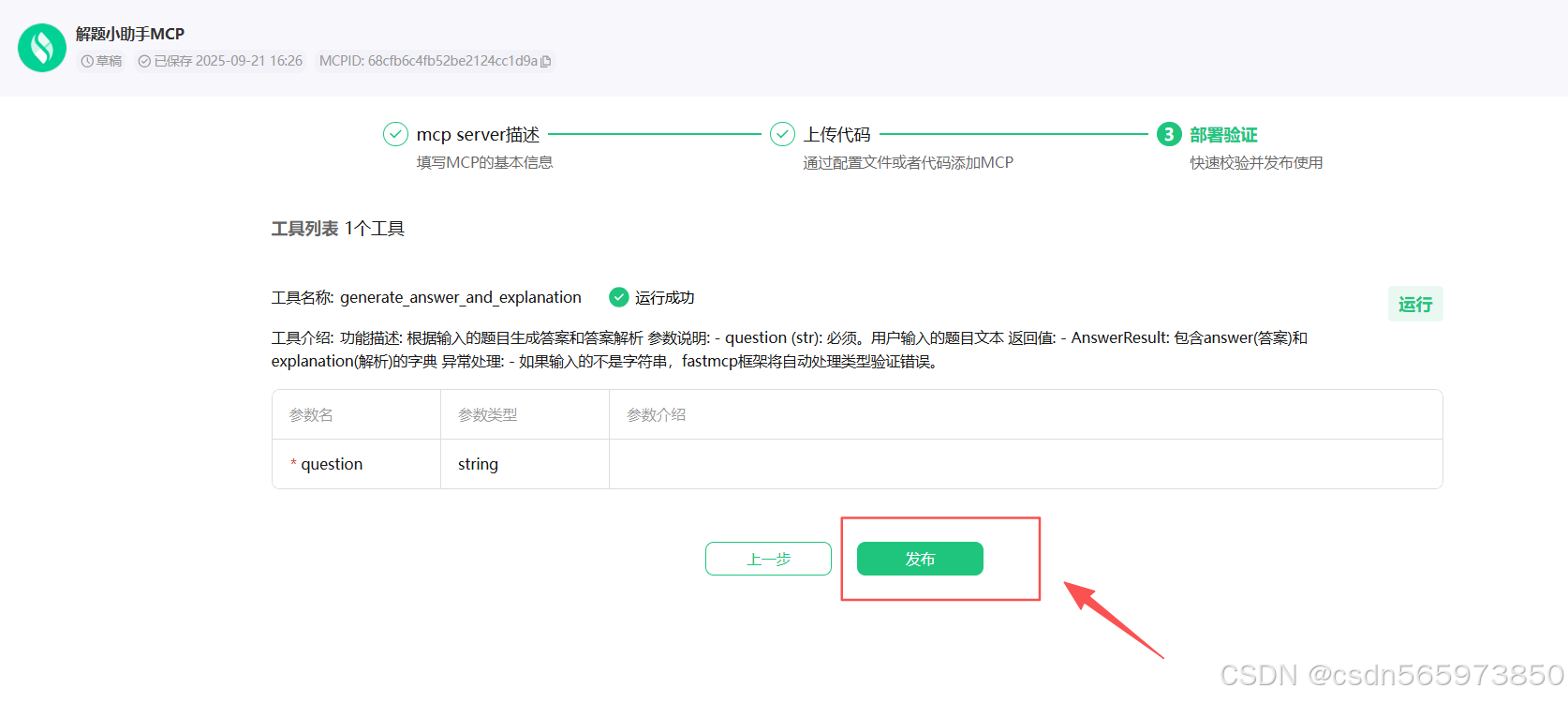

回到第三步的部署验证环节,点击【发布】完成解题小助手MCP 的发布

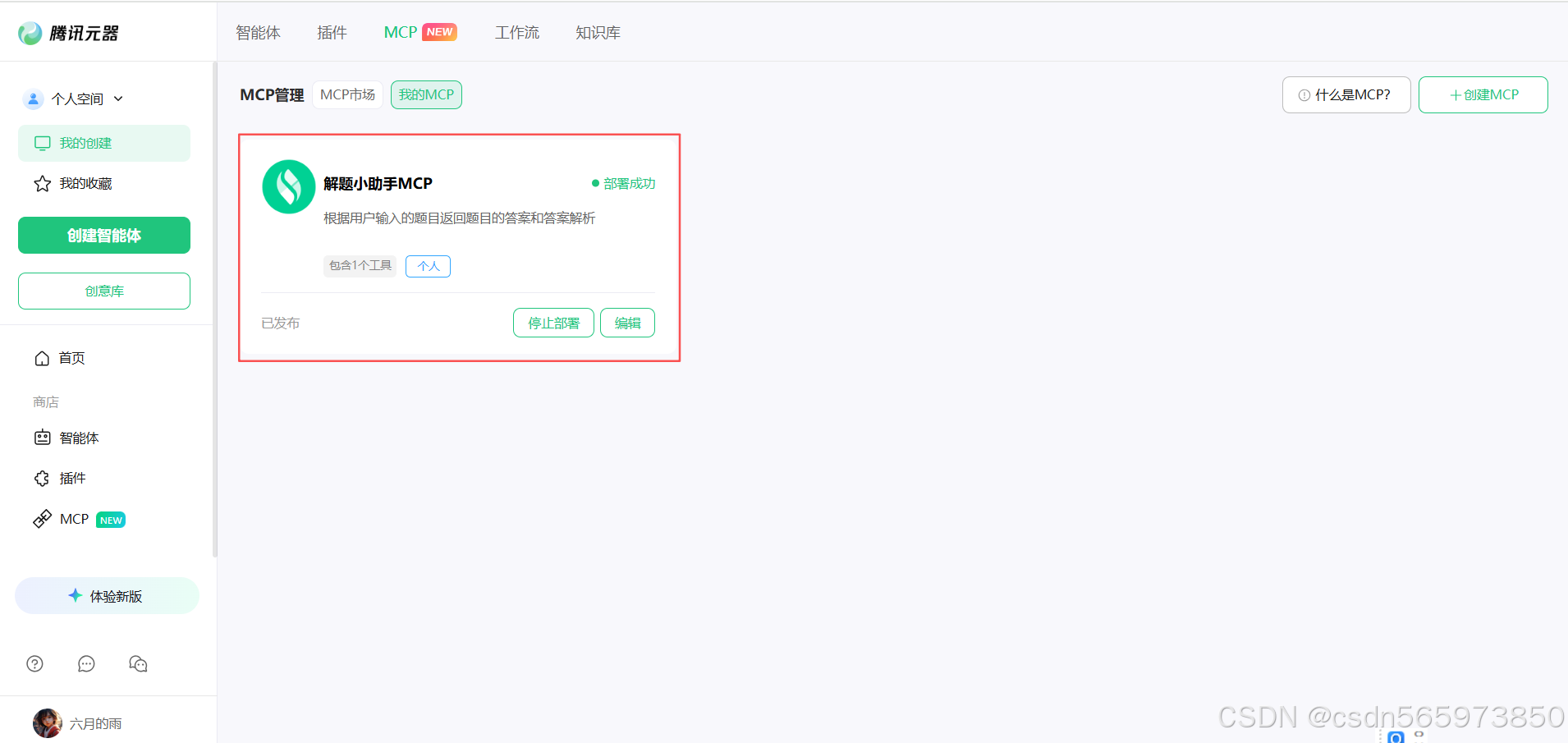

发布完成后,跳转到腾讯元器的MCP 服务配置页面,可以看到我们的解题小助手MCP 【已发布】,点击【部署】后可以看到【部署成功】

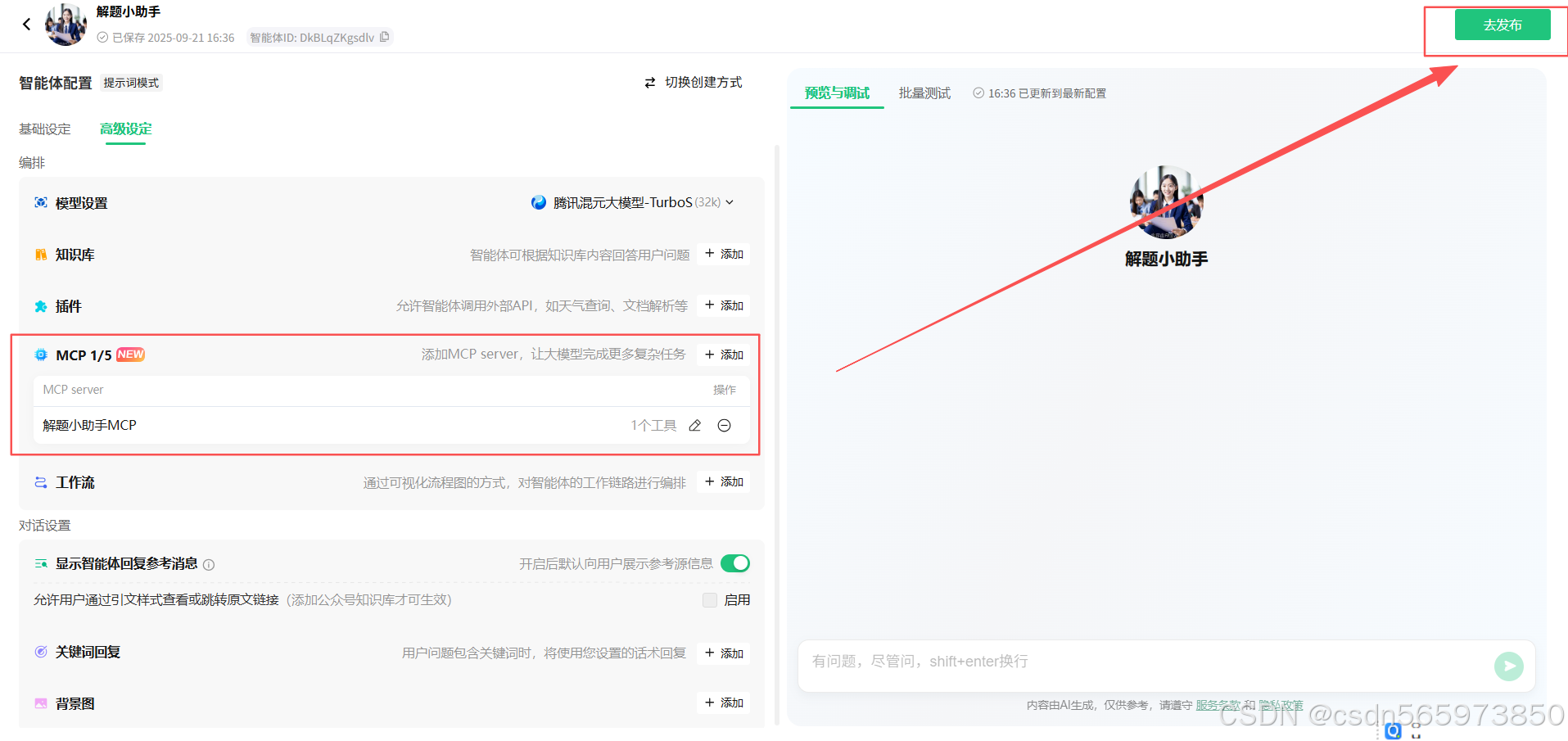

在完成了解题小助手MCP 的发布和部署之后,再次回到智能体创建页面的配置MCP Server 环节点击【刷新】按钮可以看到我们创建的MCP Server,点击右侧的【添加】完成解题小助手MCP 的添加操作

完成MCP Server 的添加之后,点击右上角的【去发布】等待我们的智能体审核通过。

在线体验

等待我们发布的解题小助手智能体发布成功之后,我们可以在我们的智能体管理页面看到我们当前发布的智能体的发布状态

等待发布成功之后,我们可以点击【使用方式】,目前的腾讯元器支持通过web 体验

或者通过元宝小程序体验的方式,方便你可以在任何地方任何时间通过手机就可以体验操作

在web 体验页面,选择【去体验】在解题小助手体验页面右侧可以看到当前智能体的信息介绍,左侧可以输入我们的问题,比如这里我们还是输入我们的鸡兔同笼的经典数学题

同样的,我们可以得到和我们在 Cherry Studio AI 工具端一样的体验,并且通过腾讯元器智能体,我们可以在我们的元宝小程序端随时随地使用我们的解题小助手,这样就更加方便家长辅导孩子作业了。

最后总结

在AI 飞速发展的时代,使用AI 的场景越来越多,如何更好的使用AI ,让AI 更好的服务我们的工作和生活,MCP 的出现是一种必然的趋势。那么如何通过MCP 来更好的获取好的AI 体验,MCP Server 就成了新的探索方向,各种各样的MCP Server 也是不断更新出现。然而再丰富的MCP Server 也总是有不能覆盖的地方,腾讯云轻量应用服务器的基于 AI 生成MCP Server 并一键部署MCP Server 到轻量应用服务器的操作,无疑是为广大的AI 技术爱好者提供了一个很大的发挥平台。

在这里,你不懂技术没关系,你不会编程没关系,只要你有明确的需求,有可以落地的想法,你就可以通过轻量应用服务器AI 的自然语言对话来生成你的专属MCP Server,一个知你懂你的MCP Server。你可以将你的MCP Server配置在各大AI 工具平台来为你提供服务,方便快捷好用。

当然,这里我基于腾讯云轻量应用服务器AI 开发的MCP Server 只是简单的解题小程序,后续大家可以在此基础上扩展输入参数和输出参数的内容,比如:增加拍照识别题目后调用MCP Server 解题,或者增加科目参数后适配各种科目的解题,或者是在输入答案和答案解析的基础上,在增加举一反三的例题输出,从而让学习在AI 的辅助下,孩子爱学习,家长也轻松!

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)