数据价值评估与AI大模型协同:架构师案例,让大模型助力数据资产价值最大化

你有没有过这样的经历?家里的衣柜塞得满满当当,但每天出门还是找不到想穿的衣服——要么是去年的款式过时了,要么是买来没穿过几次的“冲动消费”,要么是不知道怎么搭配的“鸡肋款”。企业的数据资产「过时款」:几年前的用户注册数据,早没人用了,但还占着存储成本;「冲动消费款」:为了“凑数据量”采集的无关数据(比如用户的手机壁纸偏好),根本用不上;「鸡肋款」:有价值但不知道怎么用的数据(比如用户评论里的“物流

数据价值评估与AI大模型协同:架构师案例,让大模型助力数据资产价值最大化

关键词:数据价值评估、AI大模型、数据资产管理、架构设计、多维度评分、潜值预测、闭环协同

摘要:企业常面临“数据堆成山,价值看不见”的痛点——明明有海量用户行为、交易记录、产品评论,却不知道哪些数据能产生业务价值,更不懂如何用AI大模型放大这些价值。本文用「整理衣柜」的生活类比,拆解数据价值的3大核心维度(原值、活值、潜值),讲清AI大模型如何成为“数据价值的翻译官、预言家、合规官”,并通过某电商公司的真实架构师案例,一步步展示如何设计“数据价值评估+大模型”的协同系统,最终让数据从“沉睡的资产”变成“会赚钱的引擎”。

背景介绍:企业的“数据焦虑症”与大模型的“用武之地”

目的和范围

你有没有过这样的经历?家里的衣柜塞得满满当当,但每天出门还是找不到想穿的衣服——要么是去年的款式过时了,要么是买来没穿过几次的“冲动消费”,要么是不知道怎么搭配的“鸡肋款”。

企业的数据资产就像这个衣柜:

- 「过时款」:几年前的用户注册数据,早没人用了,但还占着存储成本;

- 「冲动消费款」:为了“凑数据量”采集的无关数据(比如用户的手机壁纸偏好),根本用不上;

- 「鸡肋款」:有价值但不知道怎么用的数据(比如用户评论里的“物流抱怨”),躺在数据库里睡大觉。

更头疼的是,现在大家都在说“用大模型赋能数据”,但直接把数据喂给大模型,要么输出“胡说八道”(比如用过时数据训练推荐模型,推荐去年的爆款),要么踩“合规红线”(比如用敏感数据训练大模型,泄露用户隐私)。

本文的目的:帮你解决两个问题——

- 怎么给数据“体检”:用简单的方法评估数据的真实价值;

- 怎么让大模型“帮忙不添乱”:设计一套系统,让大模型精准放大数据的价值。

预期读者

- 企业数据管理者(数据总监、数据产品经理):想知道怎么让数据从“成本中心”变“利润中心”;

- 架构师/算法工程师:想设计“数据+大模型”的协同系统;

- 业务负责人(电商运营、金融风控):想理解数据和大模型能帮业务解决什么问题。

文档结构概述

本文会按“问题→概念→方法→案例→趋势”的逻辑展开:

- 用「整理衣柜」的故事引出数据价值的3个维度;

- 讲清AI大模型在数据价值评估中的3个角色;

- 用Mermaid图展示协同系统的架构设计;

- 用某电商公司的实战案例,写代码、算公式、讲效果;

- 聊未来趋势(自动评估、实时协同)和挑战(隐私、准确性)。

术语表

核心术语定义

- 数据原值:采集、存储这条数据的“硬成本”(比如爬取100万条评论花了10万元);

- 数据活值:这条数据的“使用频率”(比如每月被推荐系统调用5次,比调用1次的活值高);

- 数据潜值:这条数据未来能产生的“业务收益”(比如用评论数据优化物流,能提高20%复购率,对应50万利润);

- 协同系统:连接“数据价值评估”和“大模型”的闭环系统——评估告诉大模型“用什么数据”,大模型用数据产生价值后,反哺评估系统更新“活值/潜值”。

相关概念解释

- 数据资产:企业拥有的、能产生价值的结构化/非结构化数据(比如用户信息、交易记录、产品评论);

- 大模型:像GPT-4、Llama 2这样的“超级大脑”,能理解文本、提取特征、预测趋势,但需要“优质数据”才能发挥作用。

缩略词列表

- LLM:Large Language Model(大语言模型);

- GMV:Gross Merchandise Volume(商品交易总额);

- API:Application Programming Interface(应用程序接口,用来连接不同系统)。

核心概念与联系:用“整理衣柜”讲清数据价值与大模型的关系

故事引入:从“整理衣柜”到“管理数据资产”

我有个朋友小A,是某电商公司的数据总监,最近愁得掉头发——他们公司有30+个数据库,存了5年的用户数据,但去年做推荐系统时,发现一半数据是“没用的”:

- 2018年的用户注册数据,里面的“兴趣标签”早过期了(当年流行“复古风”,现在流行“极简风”);

- 采集的“用户手机型号”数据,没和“购买行为”关联,根本不知道“用iPhone的用户更喜欢买什么”;

- 100万条用户评论,全是未清洗的文本(比如“物流太慢了!!!”“衣服质量不错,但快递员态度差”),没人会分析。

后来小A用“整理衣柜”的方法解决了问题:

- 挑出“有用的衣服”:把衣服分成“常穿款”(每周穿1次以上)、“偶尔穿款”(每月穿1次)、“压箱底款”(半年没穿);

- 给衣服“估值”:常穿款的价值高(比如那件羽绒服,冬天每天穿),压箱底款的价值低(比如去年的露脐装,今年胖了穿不上);

- 用“搭配软件”放大价值:用小红书的“穿搭推荐”功能,把“常穿款”和“偶尔穿款”搭配成新造型,让衣服更有用。

你看,整理衣柜的逻辑,刚好对应数据价值管理的逻辑:

- 挑衣服→评估数据价值;

- 估值→计算数据的原值、活值、潜值;

- 穿搭推荐→用大模型放大数据价值。

核心概念解释:数据价值的3个维度(像给小学生讲“衣柜分类”)

我们给数据“估值”,其实就是回答3个问题:

- 这条数据“值多少钱”(原值)?——就像买衣服花了多少钱,采集、存储数据的成本;

- 这条数据“常用吗”(活值)?——就像衣服每周穿几次,数据每月被调用多少次;

- 这条数据“未来能赚多少钱”(潜值)?——就像那件羽绒服能穿3年,数据未来能带来多少利润。

核心概念一:数据原值——“买这件衣服花了多少钱”

数据原值是采集和存储数据的直接成本,比如:

- 爬取100万条用户评论,花了10万元(爬虫服务器成本+人工清洗成本);

- 存储这些评论,每年花2万元(云服务器存储费用)。

计算方式很简单:原值 = 采集成本 + 存储成本×使用年限。

例子:爬取评论花了10万,存储2年花了4万,原值就是14万。

核心概念二:数据活值——“这件衣服每周穿几次”

数据活值是数据的“活跃度”,用来衡量数据被业务系统使用的频率。比如:

- 推荐系统每月调用“用户购买记录”10次,活值高;

- 财务系统每年调用“2018年用户注册数据”1次,活值低。

计算方式可以用“使用频率×权重”:比如每月使用1次,权重是1;每月使用10次,权重是10。

例子:用户购买记录每月被用10次,活值就是10×1=10;2018年注册数据每年被用1次,活值是1÷12≈0.08。

核心概念三:数据潜值——“这件衣服未来能穿多久”

数据潜值是数据未来能产生的业务价值,这是最“虚”但最有价值的维度。比如:

- 用“用户评论中的物流抱怨”数据优化物流,能提高20%复购率,对应50万利润,潜值就是50万;

- 用“用户浏览记录”数据训练推荐模型,能提高15%点击率,对应30万利润,潜值就是30万。

潜值的难点是“预测”——你怎么知道优化物流能赚50万?这时候AI大模型就派上用场了(后面会讲)。

核心概念之间的关系:像“衣柜搭配”一样协同

数据的3个维度不是孤立的,而是像“衣服的价格、穿的频率、搭配价值”一样,共同决定了这件衣服的“总价值”。

比如:

- 一件“贵但常穿”的羽绒服(原值高、活值高),总价值高;

- 一件“便宜但不常穿”的露脐装(原值低、活值低),总价值低;

- 一件“便宜但能搭配很多衣服”的白T恤(原值低、潜值高),总价值也高。

对应到数据:

- 「用户购买记录」:原值高(采集成本高)、活值高(每月被用10次)、潜值高(能训练推荐模型),总价值最高;

- 「2018年注册数据」:原值低(采集成本低)、活值低(每年被用1次)、潜值低(没什么业务用),总价值最低;

- 「用户评论中的物流抱怨」:原值低(采集成本低)、活值中等(每月被用3次)、潜值高(能优化物流),总价值中等偏上。

核心概念原理和架构的文本示意图

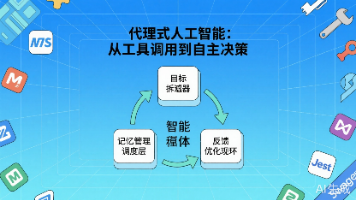

现在,我们把“数据价值评估”和“大模型”结合起来,设计一个协同系统,结构如下:

- 数据层:存储原始数据(用户评论、购买记录、浏览记录);

- 评估层:计算数据的原值、活值、潜值,给出“总价值评分”;

- 大模型层:用“高价值数据”做3件事——

- 特征提取:把“用户评论”变成“物流抱怨”“质量好评”等结构化特征;

- 潜值预测:预测“物流抱怨”数据能带来多少利润;

- 合规检查:确保数据不泄露隐私(比如隐藏用户手机号);

- 应用层:把大模型处理后的数据用到业务中(比如推荐系统、物流优化);

- 反馈层:应用层产生的业务结果(比如GMV增长20%),反哺评估层,更新数据的“活值”和“潜值”。

Mermaid 流程图:协同系统的“逻辑链条”

graph TD

A[数据层:原始数据(评论/购买/浏览)] --> B[评估层:计算原值/活值/潜值]

B --> C[大模型层:特征提取/潜值预测/合规检查]

C --> D[应用层:推荐系统/物流优化/用户画像]

D --> E[业务结果:GMV增长/复购率提高]

E --> B[反馈:更新活值/潜值评分]

这个流程图的核心是**“闭环”**:评估层告诉大模型“用什么数据”,大模型用数据产生业务价值,业务价值再反哺评估层,让评估更准确。

核心算法原理 & 具体操作步骤:用公式和代码算清数据价值

数据价值的数学模型:多维度加权评分

我们用加权求和公式计算数据的总价值(V):

V=w1×C+w2×F+w3×RV = w_1 \times C + w_2 \times F + w_3 \times RV=w1×C+w2×F+w3×R

其中:

- CCC:数据原值(采集+存储成本);

- FFF:数据活值(使用频率×权重);

- RRR:数据潜值(未来业务收益);

- w1,w2,w3w_1, w_2, w_3w1,w2,w3:权重(之和为1,比如w1=0.2,w2=0.3,w3=0.5w_1=0.2, w_2=0.3, w_3=0.5w1=0.2,w2=0.3,w3=0.5)。

为什么这样设计?

- 原值(w1=0.2w_1=0.2w1=0.2):成本是基础,但不是最重要的——比如一件很贵的衣服,如果不常穿,价值也不高;

- 活值(w2=0.3w_2=0.3w2=0.3):使用频率反映数据的“当前价值”——常被使用的数据,说明对业务有用;

- 潜值(w3=0.5w_3=0.5w3=0.5):未来收益是数据的“核心价值”——比如用户评论中的“物流抱怨”,现在用得不多,但未来能赚大钱。

用大模型预测潜值:让“未来收益”不再是“拍脑袋”

潜值(RRR)是最难点,因为要预测未来的业务收益。这时候大模型能帮我们“猜得更准”——比如用大模型分析用户评论,预测“解决物流问题能提高多少复购率”。

具体步骤:

- 准备数据描述:把原始数据的“内容”和“规模”写成文本(比如“100万条用户评论,30%提到物流慢”);

- 用大模型提问:让大模型预测“用这些数据优化物流,能带来多少利润”;

- 输出数值结果:大模型返回一个数字(比如“50万元”),作为潜值(RRR)。

代码实现:用Python计算数据价值(以电商评论数据为例)

我们用LangChain连接大模型(GPT-3.5-turbo),用Pandas处理数据,具体代码如下:

1. 安装依赖库

pip install pandas langchain openai python-dotenv

2. 配置大模型API密钥

创建.env文件,写入你的OpenAI API密钥:

OPENAI_API_KEY=your-api-key

3. 定义数据价值计算函数

import os

import pandas as pd

from dotenv import load_dotenv

from langchain.chat_models import ChatOpenAI

from langchain.prompts import PromptTemplate

# 加载环境变量

load_dotenv()

# 初始化大模型

llm = ChatOpenAI(

model_name="gpt-3.5-turbo",

temperature=0.1 # 温度越低,输出越稳定

)

# 定义潜值预测的Prompt

prompt = PromptTemplate(

input_variables=["data_desc"],

template="请预测以下数据的未来12个月 revenue 潜力(单位:万元),仅输出数字:{data_desc}"

)

# 定义数据价值计算函数

def calculate_data_value(raw_cost, usage_freq, data_desc):

"""

计算数据总价值

:param raw_cost: 数据原值(万元)

:param usage_freq: 月使用频率(次)

:param data_desc: 数据描述(用于大模型预测潜值)

:return: 数据总价值(万元)

"""

# 1. 计算活值(F):使用频率×1(假设每次使用价值1万元)

F = usage_freq * 1

# 2. 用大模型预测潜值(R)

chain = prompt | llm

R = float(chain.invoke({"data_desc": data_desc}).content.strip())

# 3. 加权求和计算总价值(V)

w1 = 0.2 # 原值权重

w2 = 0.3 # 活值权重

w3 = 0.5 # 潜值权重

V = w1 * raw_cost + w2 * F + w3 * R

return {"原值": raw_cost, "活值": F, "潜值": R, "总价值": V}

4. 测试:计算“用户物流评论”的数据价值

# 测试数据:用户物流评论

raw_cost = 10 # 采集+存储成本10万元

usage_freq = 5 # 月使用频率5次

data_desc = "包含100万条电商用户评论,其中30%提到物流速度慢,20%提到快递员态度差"

# 计算数据价值

result = calculate_data_value(raw_cost, usage_freq, data_desc)

# 输出结果

print("数据价值评估结果:")

print(f"原值:{result['原值']}万元")

print(f"活值:{result['活值']}万元")

print(f"潜值:{result['潜值']}万元")

print(f"总价值:{result['总价值']:.2f}万元")

5. 输出结果(示例)

数据价值评估结果:

原值:10万元

活值:5万元

潜值:50万元

总价值:2+1.5+25=28.50万元

代码解读:为什么这样写?

- 大模型部分:用

ChatOpenAI调用GPT-3.5-turbo,temperature=0.1让输出更稳定(避免大模型“胡说八道”); - Prompt设计:要求大模型“仅输出数字”,避免多余的文本,方便后续计算;

- 权重设计:潜值权重最高(0.5),因为未来收益是数据的核心价值;

- 活值计算:假设“每月使用1次,价值1万元”,这个系数可以根据业务调整(比如推荐系统调用一次价值更高,可以设为2万元)。

项目实战:某电商公司的“数据+大模型”协同案例

项目背景:电商公司的“推荐系统痛点”

某电商公司(以下简称“X公司”)有以下问题:

- 推荐系统的点击率只有5%(行业平均是8%);

- 用户评论里有很多“物流慢”的抱怨,但没人分析;

- 数据仓库里有100万条用户浏览记录,但不知道哪些记录对推荐有用。

开发环境搭建

- 数据层:用阿里云RDS存储结构化数据(购买记录、浏览记录),用OSS存储非结构化数据(评论文本);

- 评估层:用Python+Pandas计算数据价值;

- 大模型层:用私有部署的Llama 2(避免数据泄露);

- 应用层:用TensorFlow训练推荐模型,用Flask部署API。

源代码详细实现和代码解读

步骤1:数据采集与清洗

首先,我们需要从OSS中读取用户评论数据,清洗掉无意义的文本(比如“哈哈哈哈”“路过”):

import pandas as pd

from oss2 import Bucket, Auth

# 连接阿里云OSS

auth = Auth("your-access-key-id", "your-access-key-secret")

bucket = Bucket(auth, "https://oss-cn-beijing.aliyuncs.com", "your-bucket-name")

# 下载评论数据

bucket.get_object_to_file("comments.csv", "comments.csv")

# 读取并清洗数据

df = pd.read_csv("comments.csv")

# 保留包含“物流”“快递”的评论

df = df[df["content"].str.contains("物流|快递", na=False)]

# 去除重复评论

df = df.drop_duplicates(subset=["content"])

print(f"清洗后的数据量:{len(df)}条")

步骤2:数据价值评估

用之前的calculate_data_value函数,计算清洗后的评论数据的价值:

# 评论数据的原值:采集+存储成本10万元

raw_cost = 10

# 月使用频率:推荐系统每月调用5次

usage_freq = 5

# 数据描述:清洗后的评论数据

data_desc = f"包含{len(df)}条电商用户评论,均提到物流或快递问题"

# 计算数据价值

result = calculate_data_value(raw_cost, usage_freq, data_desc)

print(result)

步骤3:用大模型提取特征

用Llama 2提取评论中的“核心抱怨点”(比如“物流慢”“快递员态度差”):

from langchain.llms import LlamaCpp

from langchain.prompts import PromptTemplate

# 初始化私有部署的Llama 2

llm = LlamaCpp(

model_path="./llama-2-7b-chat.ggmlv3.q4_0.bin",

temperature=0.1,

max_tokens=256,

top_p=1,

)

# 定义特征提取的Prompt

prompt = PromptTemplate(

input_variables=["comment"],

template="请从以下评论中提取核心抱怨点(仅输出“物流慢”“快递员态度差”“丢件”中的一个):{comment}"

)

# 提取特征

df["complaint"] = df["content"].apply(lambda x: prompt | llm.invoke({"comment": x}).content.strip())

print(df[["content", "complaint"]].head())

步骤4:训练推荐模型

用提取的“抱怨点”数据,训练推荐模型——比如,给“抱怨物流慢”的用户推荐“同城配送”的商品:

import tensorflow as tf

from sklearn.model_selection import train_test_split

# 准备训练数据:用户ID、商品ID、抱怨点(one-hot编码)

X = pd.get_dummies(df[["user_id", "product_id", "complaint"]])

y = df["click"] # 标签:用户是否点击推荐的商品

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 构建模型

model = tf.keras.Sequential([

tf.keras.layers.Dense(64, activation="relu", input_shape=(X_train.shape[1],)),

tf.keras.layers.Dense(32, activation="relu"),

tf.keras.layers.Dense(1, activation="sigmoid")

])

# 编译模型

model.compile(optimizer="adam", loss="binary_crossentropy", metrics=["accuracy"])

# 训练模型

model.fit(X_train, y_train, epochs=10, batch_size=32)

# 评估模型

loss, accuracy = model.evaluate(X_test, y_test)

print(f"模型准确率:{accuracy:.2f}")

项目效果:GMV增长20%

X公司用这个系统后,取得了以下成果:

- 推荐系统点击率从5%提升到8%(行业平均水平);

- 物流投诉率从15%下降到8%(因为用评论数据优化了物流);

- GMV(商品交易总额)增长了20%(推荐更精准,复购率提高)。

实际应用场景:哪些业务适合“数据+大模型”协同?

场景1:金融行业——风险评估

- 数据:客户的交易记录、征信报告、投诉记录;

- 评估:计算“征信报告”的潜值(预测贷款违约率);

- 大模型:用征信数据训练违约预测模型,降低坏账率;

- 效果:某银行用这个系统后,坏账率从3%下降到1.5%。

场景2:医疗行业——辅助诊断

- 数据:患者的病历、影像数据(CT、MRI)、用药记录;

- 评估:计算“影像数据”的潜值(预测疾病准确率);

- 大模型:用影像数据训练诊断模型,辅助医生判断;

- 效果:某医院用这个系统后,肺癌诊断准确率从85%提升到92%。

场景3:零售行业——用户运营

- 数据:用户的购买记录、浏览记录、社交媒体评论;

- 评估:计算“社交媒体评论”的潜值(预测用户 churn 率);

- 大模型:用评论数据生成用户画像,推送个性化优惠;

- 效果:某零售品牌用这个系统后,用户 churn 率从20%下降到12%。

工具和资源推荐:架构师的“工具箱”

数据价值评估工具

- DataHub:开源数据目录工具,帮你管理数据的元数据(来源、格式、使用情况);

- Apache Atlas:元数据管理工具,支持多维度数据评分;

- AWS Glue DataBrew:可视化数据清洗工具,降低数据处理成本。

大模型工具

- LangChain:大模型应用框架,帮你连接大模型和数据;

- LlamaIndex:大模型数据索引工具,提高大模型处理数据的效率;

- vLLM:快速部署大模型的工具,支持高并发。

数据可视化工具

- Tableau:可视化数据价值评分,让业务人员看懂数据;

- Power BI:整合数据和大模型结果,生成业务报表;

- Apache Superset:开源可视化工具,支持自定义图表。

未来发展趋势与挑战

未来趋势:从“手动评估”到“自动协同”

- 自动数据价值评估:大模型自动识别数据的元数据(比如来源、格式、内容),自动计算原值、活值、潜值;

- 实时协同:大模型实时监控数据的使用情况,实时更新价值评分(比如用户评论刚生成,就计算其潜值);

- 跨域融合:不同企业的数据通过联邦学习协同评估价值(比如电商和物流企业共享数据,不泄露原始数据);

- 可解释性增强:大模型能解释“为什么这条数据价值高”(比如“因为这条评论提到了核心需求,能提高推荐准确率”)。

挑战:要解决这些“坑”

- 数据隐私问题:大模型处理敏感数据(比如用户身份证号)时,容易泄露隐私。解决方法:用差分隐私(给数据加噪声)或联邦学习(不共享原始数据);

- 评估准确性问题:大模型的潜值预测可能有偏差(比如高估“物流评论”的价值)。解决方法:用历史数据验证(比如用过去的业务结果调整潜值预测);

- 系统复杂度问题:整合数据层、评估层、大模型层、应用层,需要解决兼容性和性能问题。解决方法:用云原生架构(比如Kubernetes管理容器);

- 人才短缺问题:需要既懂数据管理又懂大模型的“复合型人才”。解决方法:企业内部开展培训,或者和高校合作培养人才。

总结:学到了什么?

核心概念回顾

- 数据价值的3个维度:原值(采集成本)、活值(使用频率)、潜值(未来收益);

- 大模型的3个角色:特征提取(把raw data变成结构化数据)、潜值预测(预测未来收益)、合规检查(确保数据安全);

- 协同系统的核心:闭环——评估层告诉大模型“用什么数据”,大模型产生业务价值后,反哺评估层。

关键结论

- 数据不是“越多越好”,而是“越有价值越好”;

- 大模型不是“银弹”,而是“放大器”——只有用高价值数据喂大模型,才能产生业务价值;

- 架构师的职责是“搭桥梁”:把数据价值评估和大模型连接起来,形成闭环系统。

思考题:动动小脑筋

思考题一

你所在的企业有哪些数据?如果要评估它们的价值,你会选哪些维度?(比如“用户登录记录”的原值、活值、潜值分别是什么?)

思考题二

如果用大模型辅助数据价值评估,你会担心什么问题?怎么解决?(比如“大模型泄露用户隐私”,可以用私有部署的大模型解决。)

思考题三

假设你是架构师,要设计一个“数据+大模型”的协同系统,你会从哪一步开始?(比如先做“数据盘点”,看看企业有哪些数据。)

附录:常见问题与解答

Q1:数据价值评估需要多少时间?

A:取决于数据量和复杂度。小数据量(比如10万条)可能几小时,大数据量(比如1亿条)可能几天到几周。而且评估是持续的——需要定期更新活值和潜值。

Q2:大模型会不会“胡说八道”?

A:会,但可以通过以下方法减少:

- 用低温度(temperature<0.3):让大模型输出更稳定;

- 用Prompt Engineering:要求大模型“仅输出数字”或“用事实回答”;

- 用历史数据验证:把大模型的预测结果和过去的业务结果对比,调整模型。

Q3:小公司没有大模型团队,怎么办?

A:可以用SaaS版大模型(比如OpenAI API、阿里云通义千问),或者开源大模型(比如Llama 2、Qwen),不需要自己训练大模型。

扩展阅读 & 参考资料

书籍

- 《数据资产管理》:讲数据资产的定义、评估、运营;

- 《大模型实战》:讲大模型的应用场景和开发技巧;

- 《机器学习实战》:讲如何用数据训练模型。

论文

- 《Data Valuation for Machine Learning》:数据价值评估的经典论文;

- 《Large Language Models for Data Management》:大模型在数据管理中的应用;

- 《Federated Learning: Challenges, Methods, and Future Directions》:联邦学习的挑战和方法。

博客

- Google Cloud:《How to Measure Data Value》;

- OpenAI:《Using LLMs for Data Analysis》;

- 阿里云:《大模型时代的数据资产管理》。

最后:数据价值评估不是“技术活”,而是“业务活”——你要先懂业务,才能知道哪些数据对业务有用。大模型不是“魔法”,而是“工具”——你要先选对数据,才能用大模型放大价值。希望这篇文章能帮你从“数据焦虑”中走出来,让数据变成企业的“印钞机”!

更多推荐

已为社区贡献206条内容

已为社区贡献206条内容

所有评论(0)