TCP/IP 互联网的真相:中心极限定理与二项分布右尾概率

我会在另一篇文章中导出这个结论,但这里要理清的是,正是 AIMD 的力量让中心极限定理的采样样本随 n 反比例缩放,保证其和的均值不变,而其方差则随 n 增加而减小,从而确保了资源的收敛。的作用下,最初给出的 PDF 图像随着 n 的增加,最终被塑造成了越来越瘦高的钟形,这就是中心极限定理,除了用概率解释 PDF 的性质,还可以使用卷积,每次卷积都进一步平滑和对称化分布,不再赘述。与解释中心极限定

本文尝试直观地而不是数学地解释中心极限定理和随机接入的二项分布右尾概率。

先看中心极限定理的平滑效应。人们惊讶于车水马龙的街市如此混乱,却又如此有序,人们总在几乎固定的时间上班到岗或下班到家,即便每天路上的所见所经历都不同。

中心极限定理在宏观上描述了统计复用的世界,确保了这类世界的自发秩序,我们生活的世界自混沌初开就是这样一个世界,互联网世界当然亦如此。当大量独立样本按照一定规则自发行为时,秩序即可涌现。

无论样本的原始分布如何,抽样后涌现的秩序均收敛于正态分布,就好像问题被故意简化了一样。到底是什么消除了混沌个体(可能还有自由意志)的不确定性。

仅用一个 PDF 图像就能定性推出中心极限定理,简述如下。

n 个数在 x 轴从左到右排序,y 轴表示 n 次抽样求和后的均值等于对应 x 轴数据的概率,那么用 x 表示的 y 就是随机变量 x 的 PDF,显然 y 的积分等于 1.

现对 x 进行抽样,并假设对抽样进行求和后取平均后的随机变量为 X’,按照中心极限定理该平均 X’ 随着抽样 n 的增加趋向于正态分布,且 n 越大,该正态分布的 PDF 越瘦高(此乃互联网可扩展性的理论基础),这个很容易用概率统计基础知识证明。

但我现在需要直观地推导出中心极限定理,而不是用它的结论去本末倒置地解释现象,以显示中心极限定理是多么自然而然,从而证明它是本质的,因为本质的往往最自然。

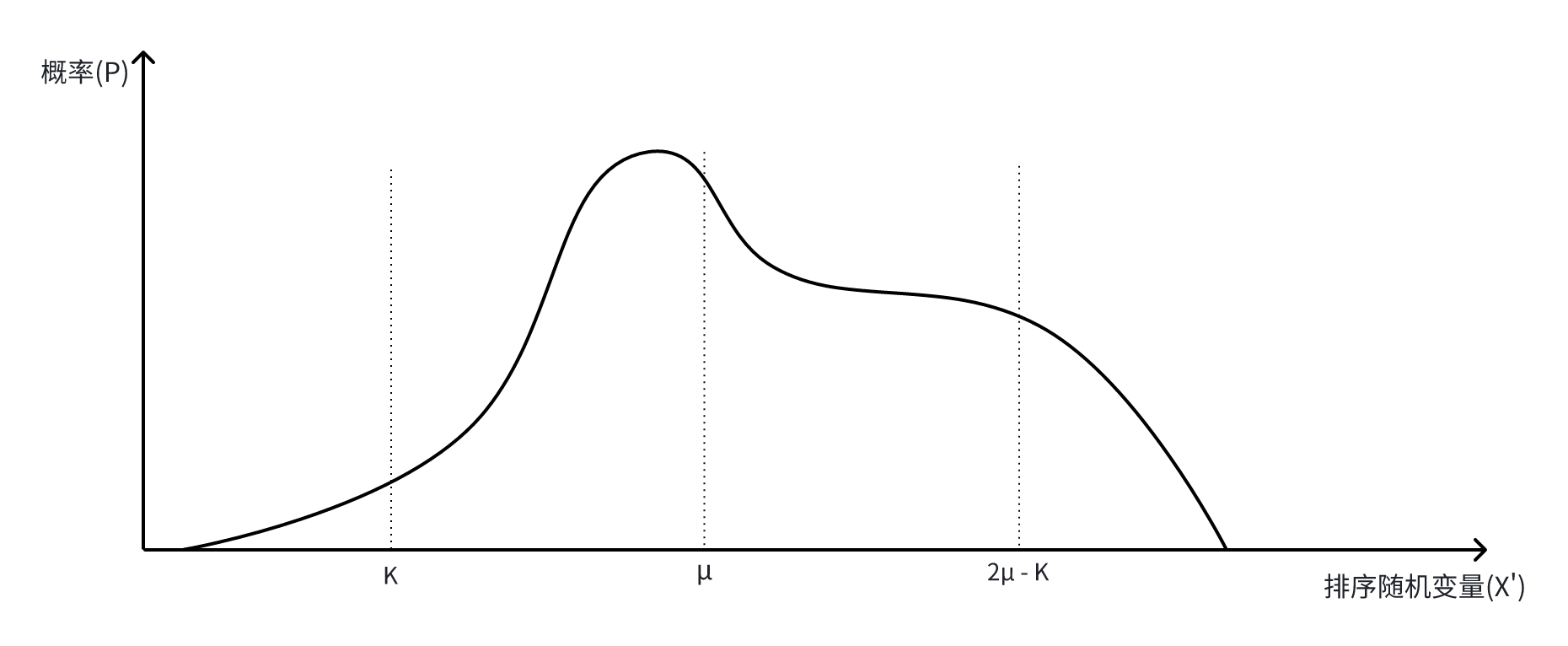

忘掉正态分布这类名词,因为我不是为了推导它的形式,只是希望直观展示它的性质。现在假设 X’ 的 PDF 如下图般不对称(反正不是正态分布):

由 PDF 的形状,上述不确定分布 PDF 曲线下包围的面积为 1,我们来看 X’ = K 的约束是什么。

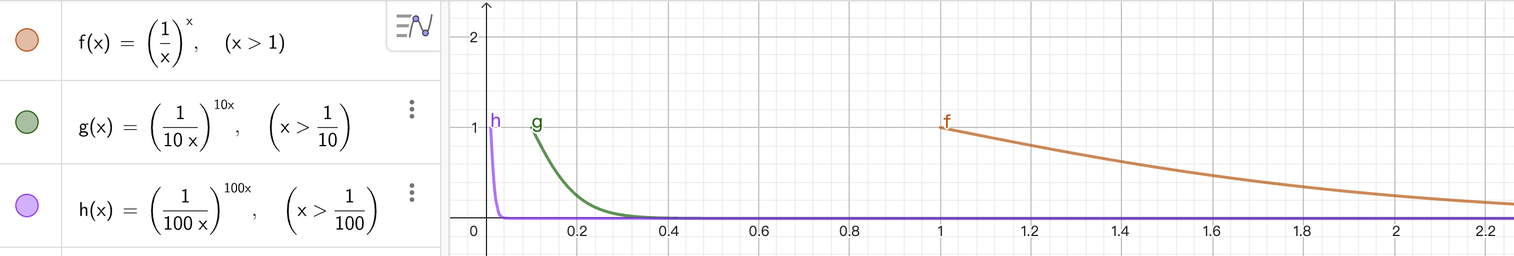

若要采样求和的均值为 K,就必须在原始样本 x 中 K 的左右侧按照与 K 的距离均匀采样,n 个数取样 n 次,某个特定的组合的概率为 ( 1 n ) n (\dfrac{1}{n})^n (n1)n,这说明 PDF 从两边开始随着 n 的增加快速 “摊平”,PDF 随 n 的增加越发难以 “积累”,同时任何凸起的位置将会在 n 的下一次增加后变平,直至凹陷,另一方面,我们知道 y = ( 1 a ⋅ x ) a ⋅ x y=(\dfrac{1}{a\cdot x})^{a\cdot x} y=(a⋅x1)a⋅x 随着采样数量的增加(a 的增加),它是快速趋缓的:

这同时塑造了抽样求和取平均后 PDF 的两个重要性质,越来越对称性,越来越瘦高,不管我们知不知道它是否就是正态分布,有这两个性质就可以解释收敛性,其它都无所谓了。

在 y = ( 1 n ) n y=(\dfrac{1}{n})^n y=(n1)n 的作用下,最初给出的 PDF 图像随着 n 的增加,最终被塑造成了越来越瘦高的钟形,这就是中心极限定理,除了用概率解释 PDF 的性质,还可以使用卷积,每次卷积都进一步平滑和对称化分布,不再赘述。

再看随机接入。

与解释中心极限定理一样,依然忘掉泊松分布这类名词,仅考虑概率表示形式,推导出性质,利用性质解释网络的本质。

设随机变量 X 表示节点发送数据这件事,C 为资源量,N 为节点数,p 为特定一个固定时间段节点发送数据的概率,那么系统超载的概率为:

P ( X > C ) = ∑ k = C + 1 N ( N k ) p k ( 1 − p ) N − k , 其中 X ∼ Binomial ( N , p ) P(X > C) = \sum_{k=C+1}^{N} \binom{N}{k} p^k (1-p)^{N-k}, \quad \text{其中 } X \sim \text{Binomial}(N, p) P(X>C)=∑k=C+1N(kN)pk(1−p)N−k,其中 X∼Binomial(N,p)

简单解释一下:

- 每个节点以概率 p 发送,k 个节点同时发送的概率为 p 的 k 次方;

- 每个节点不发送的概率为 1 - p,N - k 个节点不发送的概率为 1 - p 的 N - k 次方;

- 累加所有超过阈值 C 的情况的概率;

当 N 很大时,正态近似为:

P ( X > C ) ≈ 1 − Φ ( C + 0.5 − μ σ ) P(X > C) \approx 1 - \Phi\left(\frac{C + 0.5 - \mu}{\sigma}\right) P(X>C)≈1−Φ(σC+0.5−μ)

其中 μ = N p , σ = N p ( 1 − p ) , Φ 为标准正态分布的累积分布函数 \text{其中 } \mu = Np, \sigma = \sqrt{Np(1-p)}, \Phi\text{ 为标准正态分布的累积分布函数} 其中 μ=Np,σ=Np(1−p),Φ 为标准正态分布的累积分布函数。

这里只有最纯粹的概率知识,没有使用任何推论,代入具体数据观察 P(X > C) 分别随 N 和 p 的变化,结论是:

- P 对 N 的变化相对不敏感,在特定参数下,N 增加 1%,P(X > C) 增加约 2%;

- P 对 p 的变化非常敏感,在相同特定参数下,p 增加 1%,P(X > C) 增加约 10%;

这种敏感性差异意味着 p 的微小变化导致超载概率剧增,而 p 随时段而变化,这解释了为什么网络拥塞往往突然发生,而不是随节点数缓慢发生。这个实时也确定了互联网不需要控制节点数量(系统规模)和容量,只需要处理突发的大方向,但另一方面,在共享信道网络中,反而要严格限制节点数量,这就解释了重大活动现场网络质量很差的原因。

除了中心极限定理与二项分布右尾概率,本文应该还有一趴 AIMD,但这个以前说太多了,不再赘述。将 AIMD 置于最后的含义在于理解以下结论:

- 随着随机接入强度增加,数据包越发频繁地发生冲突,由突发而拥塞,这会发生在网络的任意地方,但另一方面,随着随机接入强度的增加,中心极限定理会越发平滑地淹没冲突。时间域发生的冲突在空间域以对等强度被平滑消除,这就是互联网可扩展性的核心。

我会在另一篇文章中导出这个结论,但这里要理清的是,正是 AIMD 的力量让中心极限定理的采样样本随 n 反比例缩放,保证其和的均值不变,而其方差则随 n 增加而减小,从而确保了资源的收敛。关于 AIMD,详见前文 主宰 TCP AIMD 的中心极限定理,无懈可击的 AIMD。

浙江温州皮鞋湿,下雨进水不会胖。

更多推荐

已为社区贡献26条内容

已为社区贡献26条内容

所有评论(0)