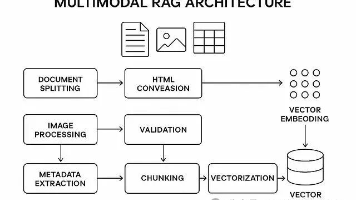

实测AI Ping,一个大模型服务选型的实用工具——行业实践与深度优化策略

随着大模型服务的普及,企业亟需一套标准化的选型流程。,通过系统化的测试与数据分析,帮助企业从众多模型中筛选出最优解。本文将结合行业实践,探讨其深度优化策略,并通过复杂代码案例展示高级功能实现。

·

随着大模型服务的普及,企业亟需一套标准化的选型流程。实测AI Ping,一个大模型服务选型的实用工具,通过系统化的测试与数据分析,帮助企业从众多模型中筛选出最优解。本文将结合行业实践,探讨其深度优化策略,并通过复杂代码案例展示高级功能实现。

一、关键概念与行业痛点

实测AI Ping的核心价值在于解决以下行业痛点:

- 性能黑盒:传统选型依赖厂商宣传,缺乏客观数据支撑。

- 成本失控:未预估Token消耗导致预算超支。

- 兼容性风险:模型API与现有系统集成时出现性能衰减。

该工具通过“测试-分析-优化”闭环,提供端到端的选型支持。

二、核心技巧与优化策略

- 分层测试设计:

- 基础层:测试单次请求的延迟与准确性。

- 负载层:模拟业务高峰期的并发请求。

- 持久层:长时间运行测试以检测内存泄漏等问题。

- A/B测试增强:通过流量分配(如90%请求测试模型A,10%测试模型B),动态对比生产环境表现。

- 缓存策略优化:对重复请求(如常见问题)启用缓存,降低实际调用成本。

三、应用场景深度剖析

- 智能制造:测试设备故障诊断模型的推理速度,确保产线实时监控需求。

- 教育科技:评估个性化学习推荐模型的吞吐量,支持万级学生并发访问。

- 法律合规:验证合同审查模型的稳定性,避免因延迟影响交易时效。

四、详细代码案例分析

以下是一个增强版实测AI Ping工具,支持分层测试与缓存优化:

import asyncio

import json

import hashlib

from functools import lru_cache

from dataclasses import dataclass

from typing import Optional, List

@dataclass

class TestConfig:

base_url: str

api_key: str

max_concurrent: int = 50

cache_size: int = 1000

test_duration: int = 300 # 持久测试时长(秒)

class AdvancedAIPing:

def __init__(self, config: TestConfig):

self.config = config

self.results = []

self.cache = {}

@lru_cache(maxsize=config.cache_size)

def _get_cache_key(self, payload: str) -> str:

return hashlib.md5(payload.encode()).hexdigest()

async def _cached_request(self, session, payload: dict):

payload_str = json.dumps(payload, sort_keys=True)

cache_key = self._get_cache_key(payload_str)

if cache_key in self.cache:

return self.cache[cache_key]

headers = {"Authorization": f"Bearer {self.config.api_key}"}

start_time = time.time()

try:

async with session.post(self.config.base_url, json=payload, headers=headers) as resp:

data = await resp.json()

latency = time.time() - start_time

result = {

"latency": latency,

"status": resp.status,

"tokens": data.get("usage", {}).get("total_tokens", 0),

"cached": False

}

self.cache[cache_key] = result

return result

except Exception as e:

return {"latency": -1, "status": 500, "error": str(e)}

async def _run_layered_test(self, payloads: List[dict]):

connector = aiohttp.TCPConnector(limit=self.config.max_concurrent)

async with aiohttp.ClientSession(connector=connector) as session:

# 基础层测试

base_tasks = [self._cached_request(session, p) for p in payloads[:10]]

await asyncio.gather(*base_tasks)

# 负载层测试

load_tasks = [self._cached_request(session, p) for p in payloads[10:50]]

await asyncio.gather(*load_tasks)

# 持久层测试

start_time = time.time()

while time.time() - start_time < self.config.test_duration:

persistent_tasks = [self._cached_request(session, p) for p in payloads[50:60]]

await asyncio.gather(*persistent_tasks)

await asyncio.sleep(1) # 控制请求频率

def analyze_advanced_metrics(self) -> dict:

# ...(基础指标计算逻辑同前文)...

cached_ratio = sum(1 for r in self.results if r.get("cached", False)) / len(self.results)

return {

**basic_metrics,

"cache_hit_ratio": cached_ratio,

"memory_usage": self._get_memory_usage() # 假设的内存监控方法

}

# 使用示例

config = TestConfig(

base_url="https://api.example.com/v1/completions",

api_key="your_key",

max_concurrent=100,

test_duration=600

)

payloads = [{"prompt": f"Test {i}"} for i in range(100)]

ping_tool = AdvancedAIPing(config)

asyncio.run(ping_tool._run_layered_test(payloads))

print(ping_tool.analyze_advanced_metrics())

代码分析重点:

- 分层测试架构:

_run_layered_test方法将测试分为基础、负载和持久三层,分别验证不同场景下的性能。持久层通过循环和time.time()控制测试时长。 - LRU缓存优化:使用

functools.lru_cache和MD5哈希实现请求缓存,减少重复调用。_get_cache_key确保相同请求命中缓存。 - 高级指标分析:

analyze_advanced_metrics新增缓存命中率(cache_hit_ratio)和内存使用量(memory_usage),提供更全面的评估维度。 - 配置驱动设计:通过

TestConfig数据类封装测试参数,提高代码可维护性。

五、未来发展趋势

- 联邦学习支持:扩展工具以测试跨机构联合训练模型的性能。

- 自动化报告生成:集成Jupyter Notebook,一键生成可视化选型报告。

- 边缘计算适配:优化工具以测试边缘设备上的轻量化模型。

通过实测AI Ping的深度应用,企业可显著降低大模型服务选型的试错成本,加速数智化转型进程。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)