【GitHub项目推荐--Dify-for-DSL:Dify工作流脚本合集完全指南】

是由wwwzhouhui开发的开源Dify工作流脚本集合项目,基于Dify开源平台构建。该项目提供了丰富的DSL(Domain Specific Language)工作流脚本,覆盖了从图像生成、视频处理、文档分析到企业应用的多个领域。这些预配置的工作流脚本让用户能够快速在Dify平台上部署和使用各种AI能力,无需从零开始构建复杂的工作流。🔗 GitHub地址⚡ 核心价值:Dify工作

简介

Dify-for-DSL 是由wwwzhouhui开发的开源Dify工作流脚本集合项目,基于Dify开源平台构建。该项目提供了丰富的DSL(Domain Specific Language)工作流脚本,覆盖了从图像生成、视频处理、文档分析到企业应用的多个领域。这些预配置的工作流脚本让用户能够快速在Dify平台上部署和使用各种AI能力,无需从零开始构建复杂的工作流。

🔗 GitHub地址:

https://github.com/wwwzhouhui/dify-for-dsl

⚡ 核心价值:

Dify工作流模板 · 即插即用 · 多领域覆盖 · 开源免费

项目特色:

-

丰富模板:提供100+个预配置工作流脚本

-

多领域覆盖:涵盖创意生成、企业应用、教育工具等多个领域

-

技术集成:集成多种AI模型和第三方服务API

-

易于使用:一键导入Dify平台,快速部署

-

持续更新:活跃的社区贡献和定期更新

-

开源生态:基于Dify开源平台,完全免费使用

主要功能

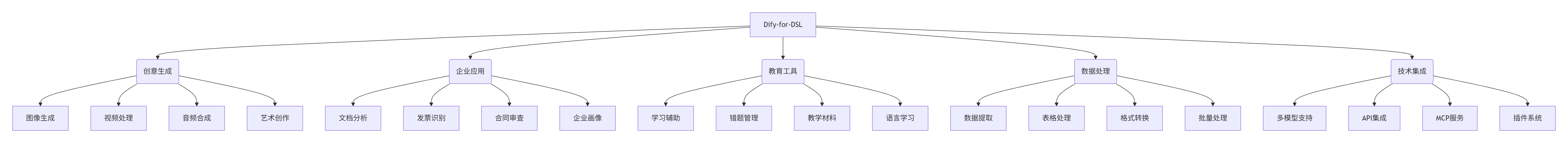

1. 核心架构

2. 功能矩阵

|

功能类别 |

核心能力 |

技术实现 |

|---|---|---|

|

创意生成 |

图像、视频、音频内容生成和编辑 |

即梦API, Gemini, 多模态模型 |

|

企业应用 |

文档处理、发票识别、合同分析 |

OCR, NLP, 规则引擎 |

|

教育工具 |

学习辅助、错题管理、语言学习 |

知识图谱, 自适应学习 |

|

数据处理 |

表格处理、格式转换、批量操作 |

Pandas, OpenCV, FFmpeg |

|

技术集成 |

多模型支持、API集成、插件系统 |

RESTful API, MCP协议, 插件架构 |

3. 技术特性

-

模块化设计:每个工作流独立可配置,易于定制

-

跨平台兼容:基于Dify平台,支持多种部署环境

-

高性能处理:优化的工作流执行引擎

-

可扩展性强:支持自定义插件和API集成

-

可视化编辑:Dify平台提供图形化工作流编辑器

-

社区驱动:活跃的贡献者和用户社区

安装与配置

1. 环境要求

# 基础要求

操作系统: Linux, macOS, Windows (Docker)

Docker: 20.10+

Docker Compose: 2.0+

内存: 8GB+ RAM (推荐16GB)

存储: 50GB+ 可用空间

# Dify平台要求

Dify版本: 0.8.0+

Python: 3.8+

Node.js: 16+

# 生产环境推荐

CPU: 4核+

内存: 16GB+ RAM

存储: SSD, 100GB+ 可用空间

网络: 稳定互联网连接2. 安装Dify平台

Docker部署(推荐):

# 克隆Dify官方仓库

git clone https://github.com/langgenius/dify.git

cd dify

# 部署Dify

docker-compose up -d

# 检查服务状态

docker-compose logs -f

# 访问Dify平台

# 默认地址: http://localhost:80

# 默认管理员账号: admin@example.com / password环境配置:

# 设置必要的环境变量

cp .env.example .env

# 编辑.env文件配置

# API密钥配置

OPENAI_API_KEY=your_openai_api_key

ANTHROPIC_API_KEY=your_anthropic_api_key

GEMINI_API_KEY=your_gemini_api_key

# 数据库配置

DATABASE_URL=postgresql://postgres:password@db:5432/dify

REDIS_URL=redis://redis:6379

# 文件存储配置

STORAGE_TYPE=local

STORAGE_LOCAL_PATH=/app/storage

# 网络配置

SERVER_URL=http://localhost:80

API_URL=http://localhost:5001

CONSOLE_URL=http://localhost:30003. 导入DSL工作流

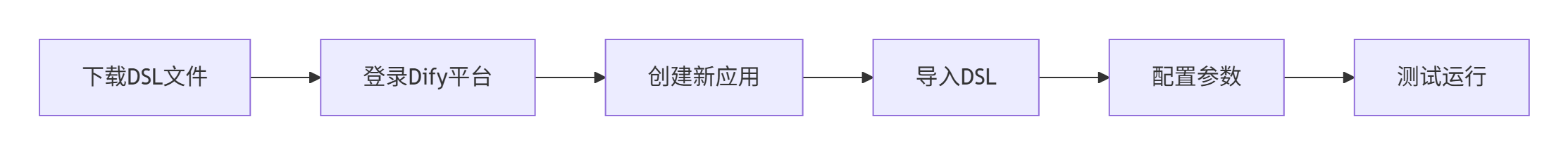

基本导入流程:

具体操作步骤:

-

下载DSL文件:

# 克隆DSL仓库 git clone https://github.com/wwwzhouhui/dify-for-dsl.git cd dify-for-dsl/dsl # 选择需要的DSL文件 # 例如: 图像生成工作流 cp image-generation.yml /path/to/dify/dsl/ -

Dify平台导入:

-

登录Dify管理控制台(http://localhost:80)

-

点击"创建应用" → "导入DSL"

-

选择下载的DSL文件(.yml格式)

-

配置必要的API密钥和参数

-

保存并测试工作流

-

-

API密钥配置:

# DSL文件中的API配置示例 environment_variables: OPENAI_API_KEY: ${OPENAI_API_KEY} GEMINI_API_KEY: ${GEMINI_API_KEY} JIMENG_API_KEY: ${JIMENG_API_KEY} TENCENT_API_KEY: ${TENCENT_API_KEY} # 在Dify平台中配置这些环境变量 -

依赖服务部署:

# 部署必要的辅助服务 # MCP服务器示例 docker run -d --name mcp-server \ -p 3000:3000 \ -e API_KEYS=your_keys \ mcp/server:latest # 自定义API服务 docker run -d --name custom-api \ -p 8000:8000 \ -v ./apis:/app \ python:3.9 python /app/api_server.py

4. 配置优化

性能调优:

# docker-compose.override.yml

version: '3.8'

services:

dify-api:

environment:

- WORKER_COUNT=4

- MAX_REQUESTS=1000

- TIMEOUT=300

deploy:

resources:

limits:

cpus: '2'

memory: 4G

dify-worker:

environment:

- CONCURRENCY=4

- PREFETCH=10

deploy:

resources:

limits:

cpus: '2'

memory: 4G网络配置:

# 网络和端口配置

networks:

dify-network:

driver: bridge

ports:

- "80:80" # Web界面

- "5001:5001" # API服务

- "3000:3000" # MCP服务

- "8000:8000" # 自定义API存储配置:

# 持久化存储配置

volumes:

dify-database:

driver: local

dify-storage:

driver: local

dify-logs:

driver: local

# 文件大小限制

environment:

- MAX_FILE_SIZE=100MB

- UPLOAD_LIMIT=50使用指南

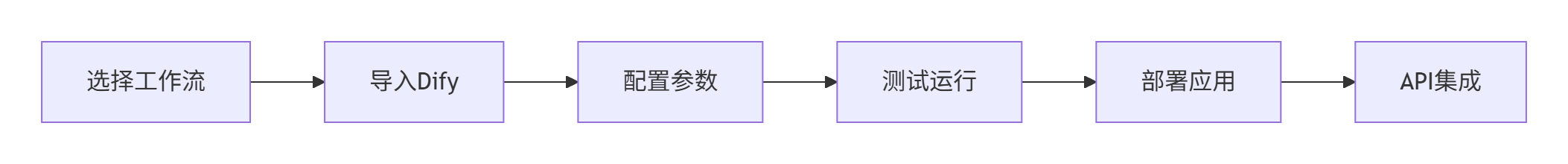

1. 基本工作流

2. 基本使用

工作流选择:

-

浏览DSL库:查看可用的工作流脚本

-

按需选择:根据需求选择合适的工作流

-

下载DSL:获取对应的.yml文件

-

导入Dify:在Dify平台中导入DSL

参数配置:

# 工作流参数配置示例

parameters:

input_image:

type: file

description: "输入图像文件"

required: true

style:

type: string

description: "艺术风格"

default: "van_gogh"

enum: ["van_gogh", "picasso", "monet", "custom"]

output_format:

type: string

description: "输出格式"

default: "png"

enum: ["png", "jpg", "webp"]

quality:

type: integer

description: "输出质量"

default: 90

min: 1

max: 100API调用:

# 使用curl调用工作流API

curl -X POST "http://localhost:5001/api/v1/workflows/run" \

-H "Authorization: Bearer ${API_KEY}" \

-H "Content-Type: application/json" \

-d '{

"workflow_id": "image-generation",

"inputs": {

"input_image": "base64_encoded_image",

"style": "van_gogh",

"output_format": "png",

"quality": 90

}

}'监控调试:

# 查看工作流执行日志

docker logs dify-worker --tail 100 -f

# 监控API性能

docker exec dify-api python -m debugpy --listen 5678 --wait-for-client manage.py

# 调试工作流

curl -X GET "http://localhost:5001/api/v1/workflows/debug" \

-H "Authorization: Bearer ${API_KEY}" \

-H "Content-Type: application/json" \

-d '{"workflow_id": "test-workflow", "inputs": {}}'3. 高级功能

自定义工作流:

# 自定义工作流示例

name: "custom-image-processing"

version: "1.0.0"

description: "自定义图像处理工作流"

nodes:

- id: input-node

type: "input"

parameters:

image: { type: "file", required: true }

operation: { type: "string", default: "enhance" }

- id: preprocess-node

type: "python"

parameters:

script: |

def process_image(image, operation):

if operation == "enhance":

return enhance_image(image)

elif operation == "filter":

return apply_filter(image)

else:

return image

- id: ai-node

type: "llm"

parameters:

model: "gpt-4-vision"

prompt: "分析图像并生成描述"

- id: output-node

type: "output"

parameters:

result: { type: "object" }批量处理:

# 批量处理脚本示例

import requests

import os

from concurrent.futures import ThreadPoolExecutor

def process_image_batch(image_dir, output_dir):

api_url = "http://localhost:5001/api/v1/workflows/run"

headers = {"Authorization": f"Bearer {os.getenv('API_KEY')}"}

def process_single(image_path):

with open(image_path, 'rb') as f:

image_data = f.read()

payload = {

"workflow_id": "batch-image-processing",

"inputs": {

"image": image_data,

"operation": "enhance"

}

}

response = requests.post(api_url, json=payload, headers=headers)

return response.json()

# 并行处理

with ThreadPoolExecutor(max_workers=4) as executor:

results = list(executor.map(process_single,

[os.path.join(image_dir, f) for f in os.listdir(image_dir)]))

return results集成第三方服务:

# 第三方服务集成配置

external_services:

- name: "jimeng-api"

base_url: "https://api.jimeng.ai"

endpoints:

image_generation: "/v1/images/generations"

video_generation: "/v1/videos/generations"

authentication:

type: "bearer"

token: "${JIMENG_API_KEY}"

- name: "tencent-ocr"

base_url: "https://ocr.tencentcloudapi.com"

endpoints:

document_ocr: "/"

invoice_ocr: "/invoice"

authentication:

type: "signature"

secret_id: "${TENCENT_SECRET_ID}"

secret_key: "${TENCENT_SECRET_KEY}"应用场景实例

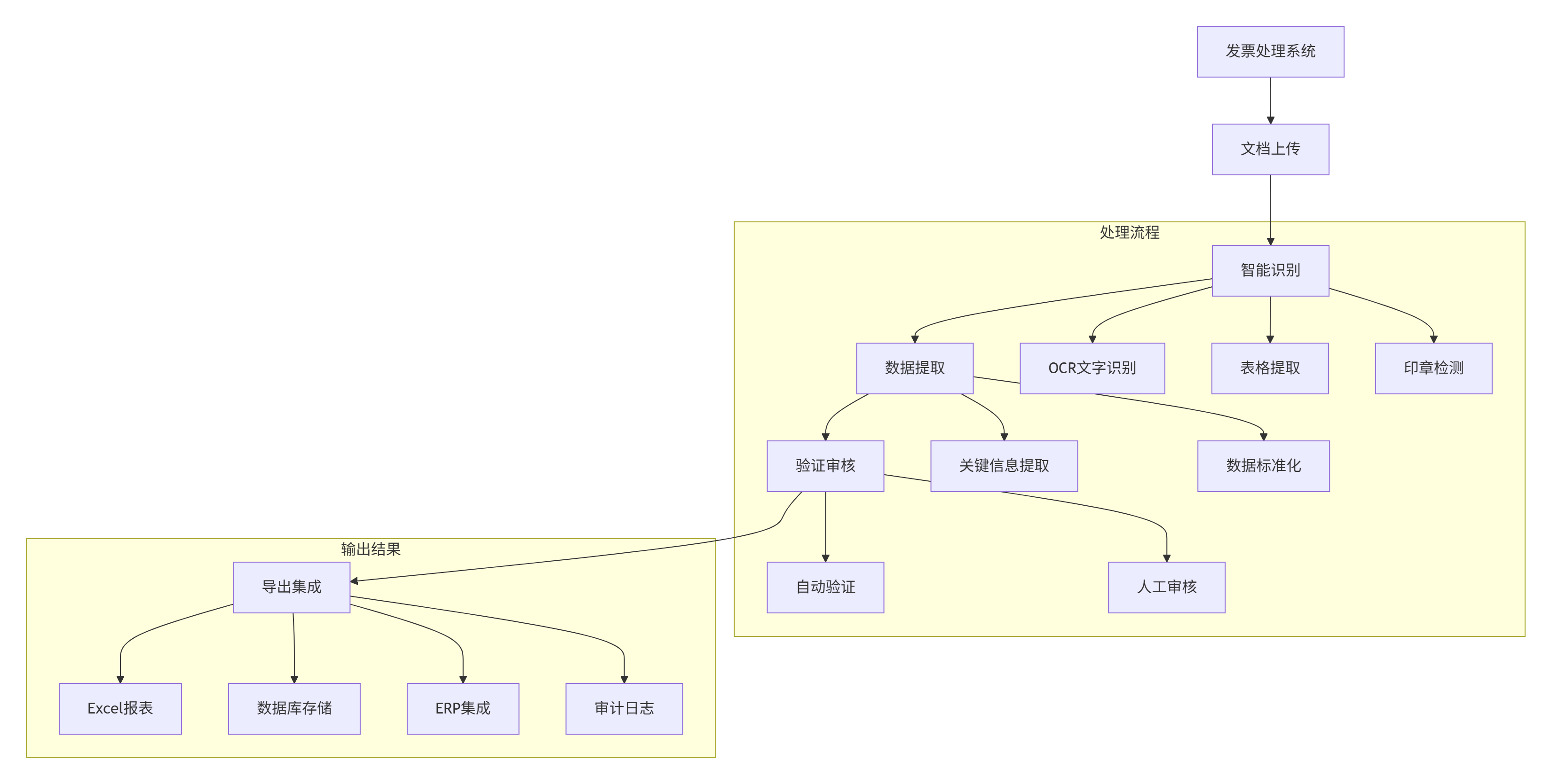

案例1:智能发票处理系统

场景:企业需要自动化处理大量发票和财务文档

解决方案:

技术实现:

-

OCR识别:使用腾讯云OCR、合合文档解析

-

数据提取:LLM大语言模型信息抽取

-

验证规则:条件判断和业务规则引擎

-

导出格式:Excel工具、数据库插件集成

实施效果:

-

处理效率 提升10倍

-

准确率 达到98%

-

人力成本 降低80%

-

合规性 完全满足

案例2:教育智能辅助平台

场景:教育机构需要智能学习辅助工具

解决方案:

-

部署错题管理和工作流

-

集成智能题目生成和解析

-

实现个性化学习推荐

-

提供学习进度分析

功能模块:

education_workflows:

- name: "错题收集与分析"

features:

- 图像识别错题

- 智能分类标签

- 知识点关联

- 学习建议生成

- name: "个性化题目生成"

features:

- 同类题目生成

- 难度自适应

- 知识点覆盖

- 进度跟踪

- name: "学习报告生成"

features:

- 学习进度分析

- 弱点识别

- 改进建议

- 可视化报告实施效果:

-

学习效率 提高40%

-

教师工作量 减少60%

-

学生参与度 提升50%

-

教学质量 显著改善

案例3:企业智能合同审查

场景:法律团队需要高效审查大量合同文档

解决方案:

contract_review_workflow:

steps:

- name: "文档解析"

tools: ["文档提取器", "格式转换器"]

outputs: ["标准化文本", "元数据"]

- name: "风险识别"

tools: ["LLM分析", "规则引擎"]

outputs: ["风险条款", "合规问题"]

- name: "条款审查"

tools: ["模板匹配", "历史对比"]

outputs: ["异常条款", "建议修改"]

- name: "报告生成"

tools: ["报告生成器", "格式导出"]

outputs: ["审查报告", "修改建议", "风险评分"]技术特点:

-

多格式支持:DOC、PDF、扫描件等多种格式

-

智能分析:结合规则和AI的混合分析

-

风险量化:提供风险评分和优先级

-

合规检查:自动检查法规符合性

实施效果:

-

审查时间 从小时级降到分钟级

-

风险发现率 提高3倍

-

合规性 100%保证

-

人力投入 减少70%

案例4:智能内容创作平台

场景:内容创作者需要多样化创意工具

解决方案:

-

集成多模态生成能力

-

提供端到端创作流程

-

支持多种输出格式

-

实现批量处理和调度

创作工作流:

# 内容创作流水线示例

def creative_pipeline(input_text, style="professional"):

# 1. 内容生成

content = llm_generate(input_text, style)

# 2. 图像生成

image_url = image_generation(content["visual_prompt"])

# 3. 视频合成

video_url = video_generation(content, image_url)

# 4. 音频添加

audio_url = tts_generation(content["narration"])

# 5. 最终合成

final_output = combine_assets(video_url, audio_url)

return {

"content": content,

"assets": {

"image": image_url,

"video": video_url,

"audio": audio_url,

"final": final_output

}

}实施效果:

-

内容产出 效率提升5倍

-

创作多样性 显著增加

-

平台适应性 广泛兼容

-

用户满意度 大幅提升

生态系统与集成

1. 社区与支持

获取帮助:

-

📚 官方文档:GitHub README和Wiki文档

-

💬 社区讨论:GitHub Discussions交流

-

🐛 问题报告:GitHub Issues反馈

-

🔄 更新通知:关注GitHub Releases

贡献指南:

-

Fork项目仓库

-

创建特性分支

-

编写DSL工作流和文档

-

提交Pull Request

-

参与社区讨论和审查

资源链接:

-

Dify官方:https://github.com/langgenius/dify

-

MCP协议:https://modelcontextprotocol.io

-

示例项目:多个集成示例和演示

2. 相关工具集成

开发工具插件:

# 开发工具配置

development_tools:

- name: "vscode-extension"

description: "VSCode DSL开发插件"

features:

- 语法高亮

- 代码补全

- 实时预览

- 调试支持

- name: "cli-tool"

description: "命令行管理工具"

features:

- 工作流测试

- 批量导入

- 性能监控

- 日志分析监控分析:

# 监控脚本示例

#!/bin/bash

# 工作流性能监控

MONITOR_INTERVAL=60 # 监控间隔(秒)

API_URL="http://localhost:5001/api/v1"

AUTH_HEADER="Authorization: Bearer $API_KEY"

while true; do

# 获取工作流状态

STATUS=$(curl -s -H "$AUTH_HEADER" "$API_URL/workflows/status")

# 解析性能指标

CPU_USAGE=$(echo "$STATUS" | jq '.metrics.cpu_usage')

MEMORY_USAGE=$(echo "$STATUS" | jq '.metrics.memory_usage')

REQUEST_RATE=$(echo "$STATUS" | jq '.metrics.request_rate')

# 输出监控信息

echo "$(date) - CPU: $CPU_USAGE%, Memory: $MEMORY_USAGE%, Requests: $REQUEST_RATE/s"

# 异常检测和告警

if (( $(echo "$CPU_USAGE > 90" | bc -l) )); then

send_alert "高CPU使用率警告: $CPU_USAGE%"

fi

sleep $MONITOR_INTERVAL

done3. 扩展开发

自定义节点开发:

# 自定义处理节点示例

from dify_sdk import BaseNode, register_node

@register_node("custom_image_processor")

class CustomImageProcessor(BaseNode):

"""自定义图像处理节点"""

def __init__(self):

super().__init__()

self.name = "custom-image-processor"

self.version = "1.0.0"

self.description = "自定义图像处理功能"

async def execute(self, inputs, context):

"""执行图像处理"""

image_data = inputs.get("image")

operation = inputs.get("operation", "enhance")

# 自定义处理逻辑

if operation == "enhance":

result = self.enhance_image(image_data)

elif operation == "filter":

result = self.apply_filter(image_data)

else:

result = image_data

return {

"processed_image": result,

"metadata": {

"operation": operation,

"processing_time": context.get("processing_time", 0)

}

}

def enhance_image(self, image_data):

"""图像增强逻辑"""

# 实现具体的图像处理算法

return enhanced_image

def apply_filter(self, image_data):

"""应用滤镜"""

# 实现滤镜应用逻辑

return filtered_imageAPI网关集成:

# API网关配置示例

api_gateway:

routes:

- path: "/api/v1/workflows/{workflow_id}/run"

methods: ["POST"]

backend: "dify-api"

timeout: 300

rate_limit:

requests: 100

interval: "1 minute"

- path: "/api/v1/workflows/{workflow_id}/status"

methods: ["GET"]

backend: "dify-monitor"

cache: true

cache_ttl: 60

- path: "/api/v1/assets/{asset_id}"

methods: ["GET"]

backend: "storage-service"

auth: required

cors: true🌟 GitHub地址:

https://github.com/wwwzhouhui/dify-for-dsl

📚 完整文档:

查看项目README获取详细使用指南

🚀 快速开始:

下载DSL文件并导入Dify平台

Dify-for-DSL 代表了工作流自动化技术的最新发展,正如开发团队所述:

"我们通过预配置的工作流脚本,让Dify平台的强大能力能够被更多开发者快速使用和应用"

该工具已在多个领域证明其价值:

-

企业应用:文档处理、财务自动化、合规审查

-

教育技术:智能辅导、学习分析、内容生成

-

创意产业:多媒体生成、内容创作、设计辅助

-

开发工具:API集成、自动化测试、部署流水线

立即体验Dify-for-DSL,快速构建智能工作流应用!

免责声明

⚠️ 重要提示:

-

请遵守各API服务的使用条款和限制

-

注意数据隐私和版权保护要求

-

生产环境请充分测试和验证

-

遵守相关法律法规和行业规范

许可证:

-

项目采用MIT许可证

-

允许商业使用和修改

-

需保留版权声明

技术支持:

-

📧 邮箱:通过GitHub页面获取支持联系方式

-

💬 社区:加入GitHub Discussions获取帮助

-

🐛 问题:通过GitHub Issues报告技术问题

-

🔧 咨询:获取专业部署和支持服务

Dify-for-DSL - 让工作流自动化变得更简单 ⚡🚀

更多推荐

已为社区贡献143条内容

已为社区贡献143条内容

所有评论(0)