收藏必备!一文搞懂多模态大模型:视觉-语言模型(VLM)原理与实现

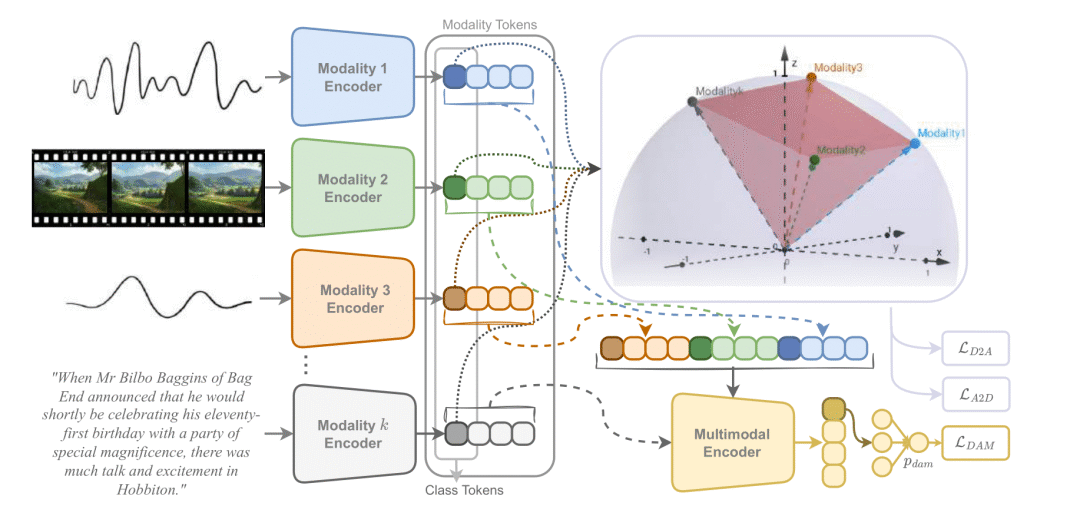

多模态AI实现"多感官协同"的关键在于解决对齐与融合两大核心问题。通过对比学习和共享表征空间建立跨模态对应关系,再采用早期、晚期或交叉融合策略整合信息。Transformer架构的token化处理和自注意力机制为多模态学习提供了统一框架,推动了GPT-4V等模型的突破性进展,使AI能够像人类一样关联理解图像、文字、声音等异构信息。这一技术演进正从简单特征拼接向深度语义理解转变。

多模态大模型让AI具备"多感官协同"能力,核心解决对齐与融合两问题。对齐通过对比学习建立不同模态间的对应关系,融合则采用早期、晚期或交叉策略整合信息。Transformer架构提供了理想框架,统一token化处理各模态,通过自注意力机制实现跨模态交互。这种统一建模思路推动了GPT-4V等新一代多模态AI的突破,使AI能同时理解和关联图像、文字、声音等不同类型的信息。

多模态学习就是让AI从"单一感官"进化到"多感官协同",像人类一样能够同时理解和关联图像、文字、声音等不同类型的信息。

但要实现这个目标,必须解决两个核心问题:多模态对齐和多模态融合。

一、多模态对齐

什么是多模态对齐****(MultiModalAlignment)********?****

简单说就是让AI知道"这个模态对应那个模态"。

- 图片中有一只橙色的猫

- 文字描述:“一只可爱的橘猫在晒太阳”

- 对齐就是让AI明白:图片中的那只猫 = 文字中的"橘猫"

多模态对齐使不同模态的数据(例如图像、文本、音频等)在特征、语义或表示层面上能够达到匹配与对应。

为什么多模态对齐这么难?

不同模态的信息表示方式完全不同:

- 图片:像素值组成的矩阵,比如 [255, 128, 64] 表示橙色

- 文字:符号序列,比如 “橘猫” 两个汉字

- 声音:频率和振幅的波形

这就像让一个只会中文的人和一个只会英文的人交流,需要找到共同的"语言"。

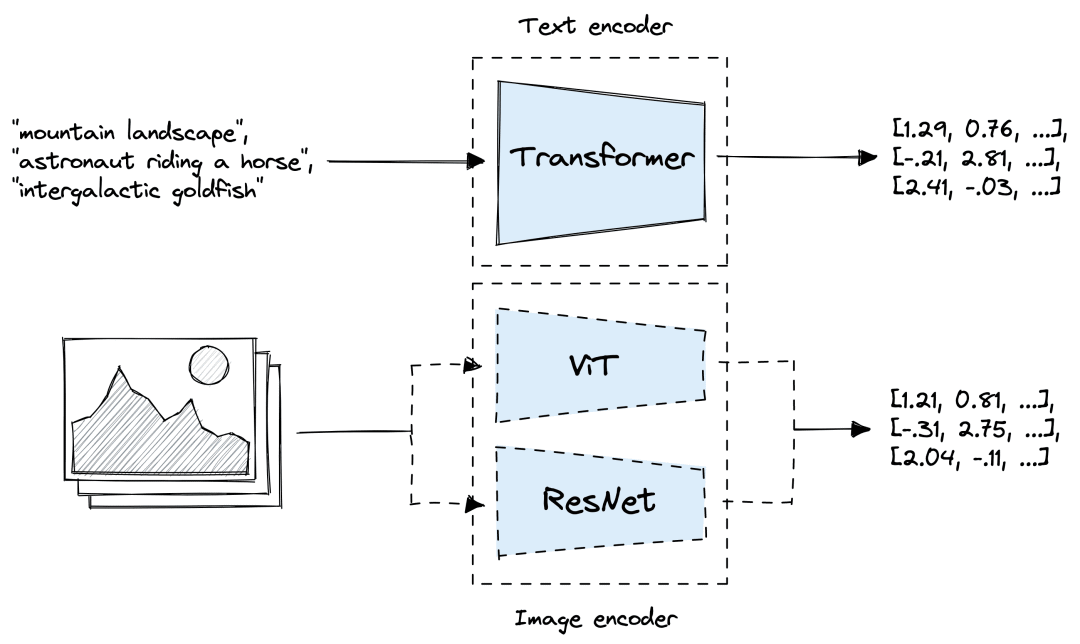

多模态对齐的核心方法是什么?

1. 对比学习(CLIP的突破)

想象教小孩认识动物的过程:

- 拿出猫的图片和"猫"字卡片,告诉孩子这两个是一对

- 拿出狗的图片和"狗"字卡片,告诉孩子这两个是一对

- 重复千万次,孩子就学会了图片和文字的对应关系

CLIP做的事情类似:通过大量配对数据学习对应关系

配对训练:

结果:AI学会了一个"翻译器",能把图片和文字都翻译成同一种"内部语言"。

2. 共享表征空间

把不同模态的信息都映射到同一个向量"空间"

原始空间:

在这个共享空间里,相关的图片和文字会靠得很近,无关的会离得很远。

二、多模态融合

什么是多模态融合******(MultiModal Fusion)**?****

多模态对齐解决了"对应关系",而多模态融合解决的是"怎么结合"。

就像做菜,有了食材(对齐后的多模态信息),还需要知道怎么搭配烹饪(融合策略)。

多模态融合能够充分利用各模态之间的互补优势,将来自不同模态的信息整合成一个稳定且全面的多模态表征。

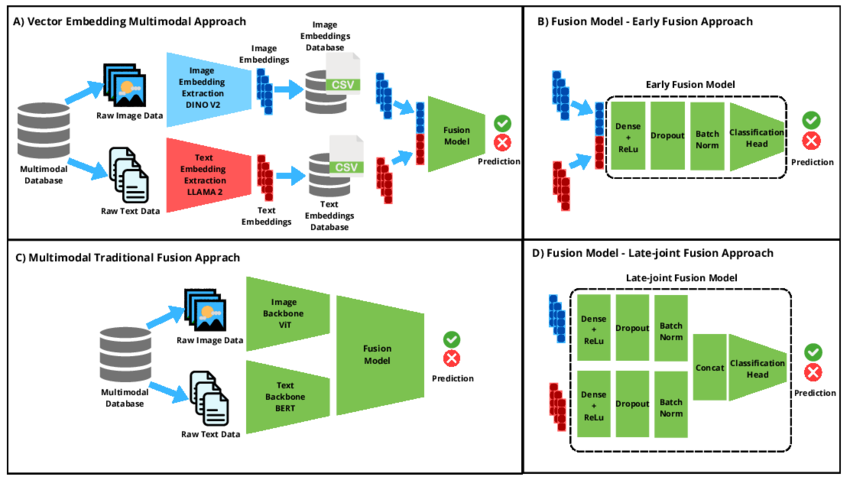

三种多模态融合策略是什么?

1. 早期融合:直接混合

思路:在处理的早期阶段就把不同模态信息混合在一起

图片特征:[1, 2, 3, 4]

优点:简单直接,能捕捉模态间的底层交互

缺点:如果某个模态质量很差,会影响整体效果

类比:就像做沙拉时把所有蔬菜直接混在一起

````实际应用:视频理解系统 ```code-snippet__js 输入:视频帧序列 + 对应音频片段 ```````

2. 晚期融合:分别处理再结合

思路:让每个模态独立处理,最后把结果综合

图片处理:图片 → 图片分析器 → "这是一只猫"

优点:稳定性好,单个模态的问题不会影响其他模态

缺点:可能错过模态间的深层互动信息

类比:就像分别烧几个菜,最后摆在一张桌子上

实际应用:医疗诊断、金融风控、内容审核

医疗诊断:影像AI和文本AI分别分析,最后综合得出诊断

3. 交叉融合:动态交互

思路:让不同模态在处理过程中互相"询问"和"帮助"

这就是注意力机制的威力:

图片看到一只动物 → 问文字:"你有描述动物的词吗?"

优点:能捕捉复杂的模态间关系,效果最好

缺点:计算复杂,需要更多资源

类比:就像炒菜时根据味道随时调整调料

````实现机制:交叉注意力网络 ```code-snippet__js 文本处理流程:文本输入 → BERT编码 → 交叉注意力层 → 文本特征 ```````

三、统一架构:Transformer

为什么Transformer架构这么适合多模态学习?

1. 统一的Token表示

Transformer把一切都当作"token"处理:

一句话:"我喜欢这只猫"

这样,图片和文字就用统一的方式来处理了!

2. 自注意力机制实现完美交互

注意力机制让每个token都能"看到"并"询问"其他所有token:

当处理"猫"这个词时:

这就是跨模态的动态交互!

3. 位置编码处理不同的"顺序"

- 文字有前后顺序:我 → 喜欢 → 这只 → 猫

- 图片有空间位置:左上角 → 右上角 → 左下角 → 右下角

- 音频有时间顺序:第1秒 → 第2秒 → 第3秒

Transformer的位置编码能同时处理这些不同的"排列方式"。

以GPT-4V为例,来看看现代多模态模型的工作流程

输入:[图片] + "这张图片里有什么?"

一文搞懂多模态大模型:视觉-语言模型(VLM)

多模态学习让AI具备"多感官协同"能力,其技术核心围绕两个递进的问题展开。

首先是对齐问题:要让AI理解不同模态信息的对应关系。就像教孩子认识世界一样,需要建立图片中的猫与文字"猫"之间的联系。CLIP等模型通过对比学习,将图像、文字等异构信息投影到统一表征空间,让相关内容聚集。

解决了对应关系后,接下来是融合问题:如何有效整合多模态信息。这里有三种策略:早期融合简单直接但容易受单模态质量影响;晚期融合稳定可靠却可能错失深层关联;交叉融合通过动态交互获得最佳效果,但计算更复杂。

Transformer架构的出现为多模态学习提供了理想的统一框架。它将所有模态统一token化处理,让图片、文字能够"说同一种语言",再通过自注意力机制实现跨模态的动态交互。这种统一建模的思路推动了GPT-4V等新一代多模态AI的重大突破。

从技术演进看,多模态学习正在从简单的特征拼接向深度语义理解转变,统一建模已成为这个领域的主流发展趋势。

日拱一卒,让大脑不断构建深度学习和大模型的神经网络连接。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献172条内容

已为社区贡献172条内容

所有评论(0)