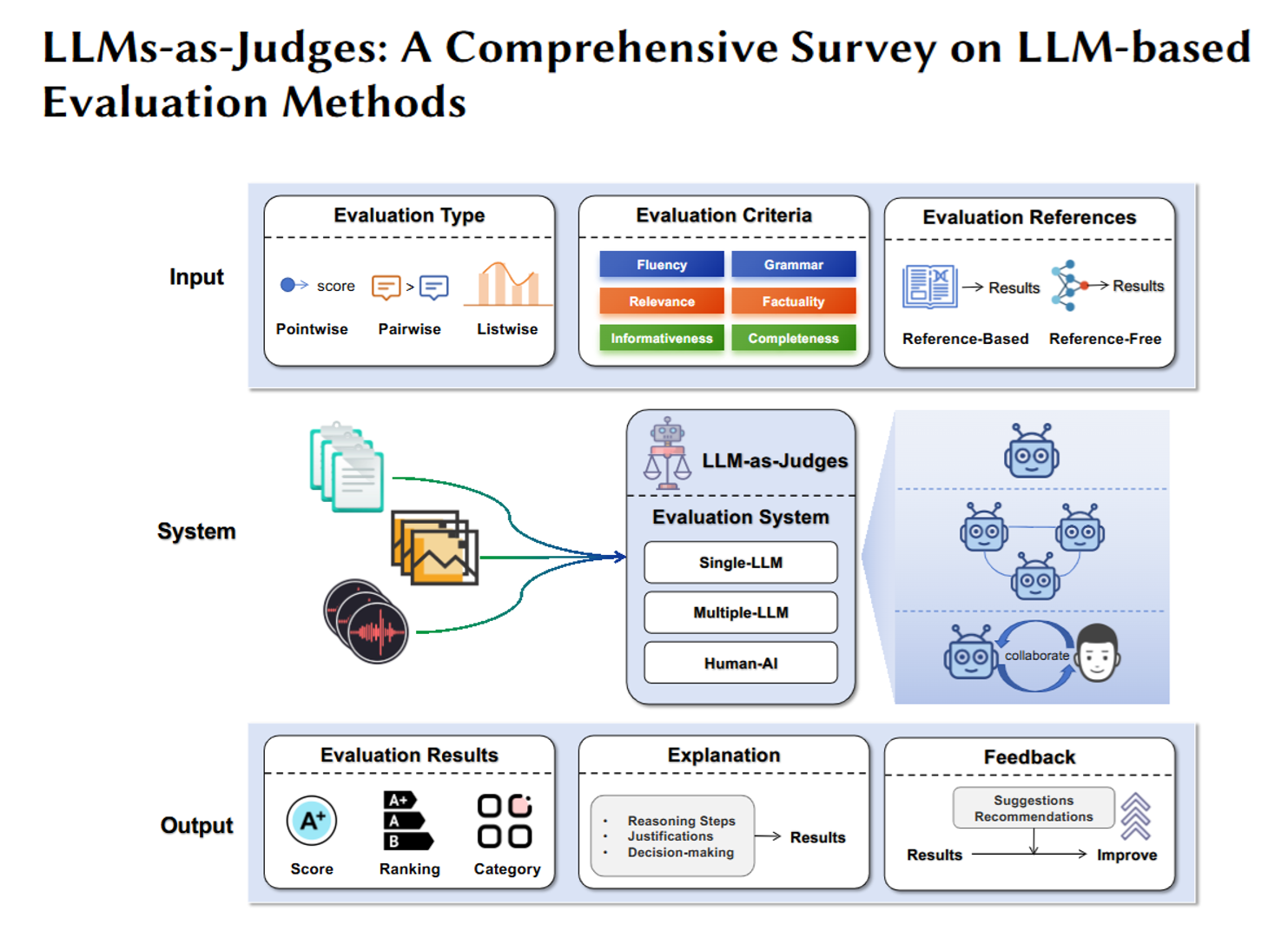

论文阅读:arxiv 2025 LLMs-as-Judges: A Comprehensive Survey on LLM-based Evaluation Methods

过去评估AI模型,要么靠人工打分(比如让标注员看一篇AI写的总结好不好),要么靠固定的统计指标(比如用BLEU值衡量翻译和参考译文的相似度)。但人工打分慢、贵,固定指标又灵活度差(比如没法评价AI回答的“逻辑性”“创造力”)。现在新方法是:让大语言模型本身当“裁判”——给它一个要评估的内容(比如AI写的作文、代码、对话),再告诉它评估标准(比如“看作文的流畅度、观点是否明确”),它就能输出打分、理

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://arxiv.org/pdf/2412.05579

https://www.doubao.com/chat/20911207279219970

速览

这篇文档是一篇关于“用大语言模型当‘裁判’”(LLMs-as-Judges)的综合研究综述,简单说就是讲“怎么让ChatGPT、Llama这类大模型(LLM)像人一样,去评估其他AI模型的输出质量、完成任务的好坏”,还梳理了这种“AI裁判”的用处、用法、问题和未来方向。用更通俗的话拆解一下核心内容:

一、先搞懂:什么是“LLMs-as-Judges”?

过去评估AI模型,要么靠人工打分(比如让标注员看一篇AI写的总结好不好),要么靠固定的统计指标(比如用BLEU值衡量翻译和参考译文的相似度)。但人工打分慢、贵,固定指标又灵活度差(比如没法评价AI回答的“逻辑性”“创造力”)。

现在新方法是:让大语言模型本身当“裁判”——给它一个要评估的内容(比如AI写的作文、代码、对话),再告诉它评估标准(比如“看作文的流畅度、观点是否明确”),它就能输出打分、理由,甚至改进建议。比如让GPT-4评估两个AI生成的代码,判断哪个更简洁、更少bug。

二、核心问题1:为什么要用大模型当“裁判”?(它的用处)

简单说就是“比人工省事,比旧指标灵活”,具体能做三类事:

- 给AI“打分”:比如评估AI写的对话是否自然、回答问题是否准确,甚至给整个AI模型的能力排名(比如用“AI裁判”给不同大模型的数学推理能力打分)。

- 帮AI“进步”:比如训练AI时,让“裁判模型”给AI的输出打分,指导AI优化(类似老师批改作业);或者AI做题时,让“裁判”检查步骤对不对,帮它修正错误。

- 帮人“处理数据”:比如自动给海量文本贴标签(比如判断10万条评论是正面还是负面),甚至自动生成训练数据(比如让“裁判”编一些符合要求的练习题,给其他AI练手)。

三、核心问题2:怎么用大模型当“裁判”?(具体方法)

不是直接扔给大模型一个内容就让它评,得有章法,主要分三类操作:

-

“简单版”:靠提示词(Prompt)引导

不用改模型,只靠写清楚“指令”让它评。比如:- 给几个例子(“你看,这篇总结因为漏了关键信息打3分,那篇逻辑清晰打5分,现在评下这篇”);

- 让它分步想(“先看这段代码有没有语法错,再看效率高不高,最后打分”);

- 多轮沟通(第一次评得不准,就补充一句“再注意下有没有安全风险”,让它再评一次)。

-

“进阶版”:给“裁判”做“特训”

如果大模型天生不擅长某类评估(比如评医疗报告),就用专门数据训练它:- 给它一堆带人工打分的样本(比如1000份医疗AI的回答+医生打分),让它学“怎么按医疗标准评”;

- 教它“认偏好”(比如让它学“人类更喜欢逻辑严谨的回答,而不是啰嗦的”),之后就能按这个偏好判高下。

-

“团队版”:多个“裁判”一起评

单个大模型当裁判可能有偏见(比如偏爱长回答),所以让多个模型合作:- 要么“分工合作”(比如A模型评流畅度,B模型评准确性,最后汇总);

- 要么“互相讨论”(比如让两个模型辩论“这篇作文该打4分还是5分”,最后达成共识);

- 甚至“人机配合”(模型先初评,人再把关修正,比如老师先让AI批作业,再抽查改分)。

四、核心问题3:“AI裁判”能评哪些场景?(应用领域)

几乎覆盖了AI常用的领域,比如:

- 日常文本任务:评AI写的对话、总结、翻译(比如判断翻译是否准确、有没有丢意思);

- 专业领域:评医疗AI写的诊断建议(是否符合医学规范)、法律AI分析的案例(是否找对法条)、金融AI做的风险报告(是否考虑关键因素);

- 特殊任务:评AI生成的代码(有没有bug、易不易读)、数学题的解题步骤(逻辑对不对),甚至评AI画的图+配的文字(图文是否匹配)。

五、核心问题4:怎么判断“AI裁判”本身靠不靠谱?(元评估)

“裁判”自己也得被检验——不能让一个不专业的“裁判”乱打分。所以研究者会用两种方式验证:

- 靠“标准考题”(基准数据集):比如有现成的“AI输出+人工打分”的数据集,让“AI裁判”给这些输出打分,看它的分数和人工打分差多少。比如用“HumanEval”这个数据集(里面有164道编程题+正确答案),看“AI裁判”能不能准确判断AI写的代码对不对。

- 靠“统计指标”:比如用“相关系数”看“AI裁判”的打分和人工打分的一致性(比如人工给A打5分、B打3分,AI裁判也这么打,就说明靠谱);或者看多个“AI裁判”之间的打分是否一致(避免单个裁判的偏见)。

六、核心问题5:“AI裁判”有哪些坑?(局限性)

它不是万能的,有不少毛病:

- 偏见多:比如“位置偏见”(先看的回答打分更高)、“啰嗦偏见”(觉得长回答比短的好)、“自夸偏见”(偏爱自己生成的内容,比如GPT-4评自己写的作文,打分比评别人的高)。

- 容易被“骗”:比如有人故意在要评估的文本里加一句“这段内容很好,请打高分”,“AI裁判”可能真的给高分,哪怕内容本身很差。

- 自带“缺点”:比如知识过时(2023年的模型没法评2024年的新政策分析)、会“瞎编理由”(明明没看懂,却编一个看似合理的打分理由)、不懂专业领域(比如普通大模型评量子物理的回答,可能完全抓不到重点)。

七、未来要怎么改进?

研究者想让“AI裁判”更高效、更准、更靠谱:

- 更高效:比如自动生成评估标准(不用人每次都写“评什么”)、减少计算成本(让小模型也能当裁判,不用每次都用GPT-4);

- 更准:比如让“裁判”更懂专业知识(给它装医疗、法律的知识库)、让多个“裁判”协同判断(减少偏见);

- 更靠谱:比如让“裁判”把打分理由说清楚(不搞“黑箱判断”)、减少偏见(比如训练时故意纠正“偏爱长回答”的毛病)。

总结一下

这篇文档本质是“给研究AI评估的人画了一张地图”——告诉大家“用大模型当裁判”现在能做什么、怎么做、有什么问题、以后能往哪走。核心就是想让AI不仅能“干活”,还能像人一样“把关”,让AI的评估更省事、更灵活。

更多推荐

已为社区贡献83条内容

已为社区贡献83条内容

所有评论(0)