看不懂代码如何一键部署大模型?三步完成大模型本地使用!

还在为“低显存大模型部署”发愁?觉得没块RTX 4090就不配玩本地AI?命令行看不懂、环境配不动、模型跑不起来……别焦虑!时代变了——现在,哪怕你用的是6G显存的轻薄本、三年前的办公机,也能在10分钟内,把DeepSeek、文心一言、豆包这些顶级大模型稳稳装进自己电脑!不写一行代码、不碰一个终端、不用查任何教程,小白也能秒变“本地AI大神”。一、为什么“低显存大模型部署”是普通用户的刚需?别再被

还在为“低显存大模型部署”发愁?觉得没块RTX 4090就不配玩本地AI?命令行看不懂、环境配不动、模型跑不起来……

别焦虑!时代变了——现在,哪怕你用的是6G显存的轻薄本、三年前的办公机,也能在10分钟内,把DeepSeek、文心一言、豆包这些顶级大模型稳稳装进自己电脑!不写一行代码、不碰一个终端、不用查任何教程,小白也能秒变“本地AI大神”。

一、为什么“低显存大模型部署”是普通用户的刚需?

别再被“必须32G显存”的谣言吓退!本地部署大模型,不是极客的专利,而是每个追求效率、注重隐私、想省钱的职场人、学生党、创作者的必备技能:

① 数据100%锁在本地,老板看了都安心

所有对话、文档、代码、创意,全程在你电脑里运行,不上传、不联网、不经过任何第三方服务器。商业方案、论文草稿、私人日记,从此彻底告别“云端泄露”风险。

② 6G显存也能跑!专为轻薄本/老电脑优化

【AI Agent本地部署大师】内置“低显存模式”,自动为你的硬件匹配最佳量化版本,4G显存可跑1.5B小模型,6-8G显存流畅驾驭7B主流模型,笔记本也能变身AI工作站!

③ 响应快到飞起,对话丝滑无延迟

本地推理省去网络请求,输入即回,思考秒答,写代码、改文案、做PPT效率翻倍,体验感碾压绝大多数在线AI!

二、懒人工具登场:【AI Agent本地部署大师】

它不是命令行,不是Python脚本,而是一个“点点鼠标就能装AI”的图形化神器!支持一键部署三大国民级模型:DeepSeek(代码之王)、文心一言(中文最强)、豆包(多模态新秀),总有一款适合你!

三步操作,手把手教学,包教包会:

第一步:下载安装,30秒准备就绪

访问【AI Agent本地部署大师】官网,点击“立即下载Windows版”,安装过程像装微信一样简单。

重要提示:安装路径请选择D盘或E盘等大容量分区,模型动辄5-20GB,别让C盘爆红!

第二步:选模型 → 开低显存模式 → 一键部署

打开软件,点击“模型市场”,三大王牌任你选:

✅ DeepSeek:擅长代码、逻辑推理,程序员最爱

✅ 文心一言:中文语义理解天花板,写作/办公神器

✅ 豆包:支持图文多模态,创意设计好帮手

重点来了!如果你显存≤8G,请务必勾选 👉【低显存优化模式】!

系统将自动为你匹配4-bit或5-bit量化版模型,体积缩小70%,运行内存占用降低50%,老电脑也能丝滑运行!

选择安装路径,点击那个醒目的——“点击立即部署”,然后泡杯咖啡,坐等自动完成:下载、解压、配置、启动……全自动,零代码!

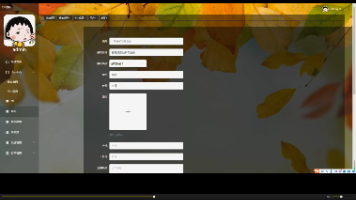

第三步:打开对话框,马上开聊!

部署完成,软件自动弹出清爽对话界面。无需任何设置,直接开问:

“用Python写一个自动整理桌面文件的脚本” → DeepSeek秒回

“帮我润色这份年终总结,语气要谦虚专业” → 文心一言出手

“根据这张产品图,生成三条小红书爆款文案” → 豆包图文联动

低显存部署硬件指南(必看!)

虽然工具极简,但合理配置才能发挥最大效能:

① 显卡(GPU)是核心!显存决定你能跑多“大”的模型:

→ 4-6GB显存:推荐运行1.5B-3B轻量模型(如Phi-3、Qwen1.5-1.8B)

→ 6-8GB显存:可流畅运行7B主流模型(DeepSeek-Coder 7B、文心一言-7B)

→ 12GB+显存:13B-34B大模型随便跑,体验更强大推理能力!

② 内存(RAM):8GB是底线,16GB体验更佳,避免多任务卡顿。

③ 硬盘空间:预留至少15GB-50GB(视模型大小),强烈建议SSD,加载速度飞升!

④ 操作系统:完美支持 Windows 10/11,Mac版即将上线!

还在觉得“低显存大模型部署”是遥不可及的技术神话?无论你是学生、打工人、自由职业者,还是AI爱好者,现在都能在自己的电脑上,拥有一个安全、免费、高速的私人AI助手。

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)