万字解析!一文带你了解深度学习中经典神经网络结构--CNN、RNN、LSTM、Transformer!原创JOYCE_Leo16AI评论员2025年06

与传统神经网络不同,RNN通过隐藏状态(hidden state)的循环连接,将前一个时间步的输出作为当前时间步的输入,从而实现对序列数据的时序建模。另外想结合AI发文发刊,但不知道怎么做创新的同学,我们team磨练出了一套系统且专业的传统学科交叉AI科研入门方案,可带学生发paper,已迭代五次(持续迭代中),我们会根据你的研究方向来规划学习路径,并且根据你的实验数据分为了时序、图结构、影像三大

大家好,今天我们来总结下深度学习中一些经典的神经网络结构,包括了CNN、RNN、LSTM、Transformer,接下来就直接进入正题吧!

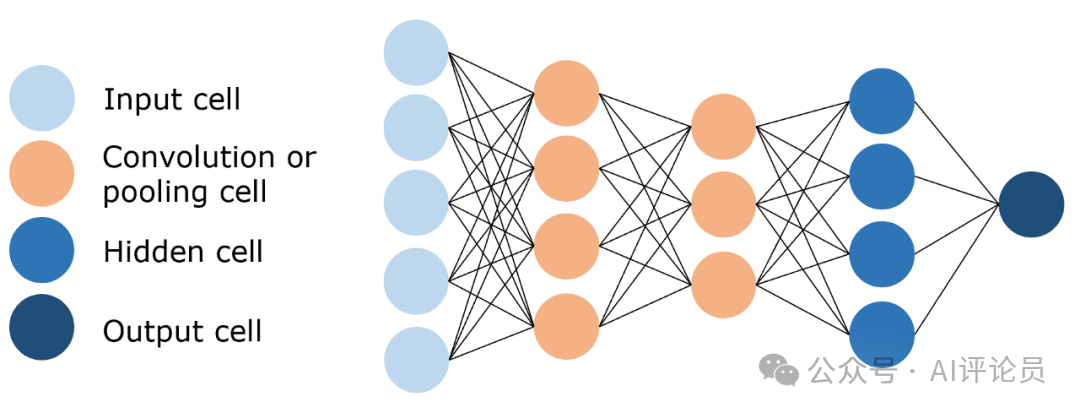

1 卷积神经网络(CNN)

一种专用于图像处理的深度学习模型。其核心是卷积层,通过可学习的滤波器提取局部特征(如边缘、纹理),并利用参数共享降低计算量。池化层(如最大池化)进行下采样,减少数据维度并增强平移不变性。通过多层卷积-池化堆叠,CNN逐步构建层次化特征(从局部到全局),最后经全连接层完成分类。这种结构大幅减少参数量,使CNN在图像分类、目标检测等任务中高效且鲁棒。

网络结构

-

卷积层:用来提取图像的局部特征

-

池化层:用来大幅降低参数量级,实现数据降维。

-

全连接层:用来输出想要的结果。

解决问题:

-

提取特征:卷积操作提取图像特征,如边缘、纹理等,保留图像特征。

-

数据降维:池化操作大幅降低参数量级,实现数据降维,大大减少运算量,避免过拟合。

工作原理

-

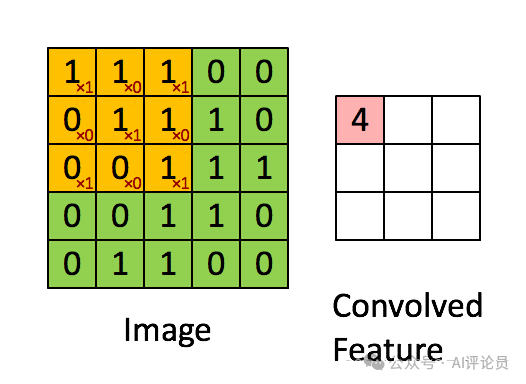

卷积层:通过卷积核的过滤提取出图片中局部的特征,类似初级视觉皮层进行初步特征提取。

使用一个过滤器(卷积核)来过滤图像的各个小区域,从而得到这些小区域的特征值

-

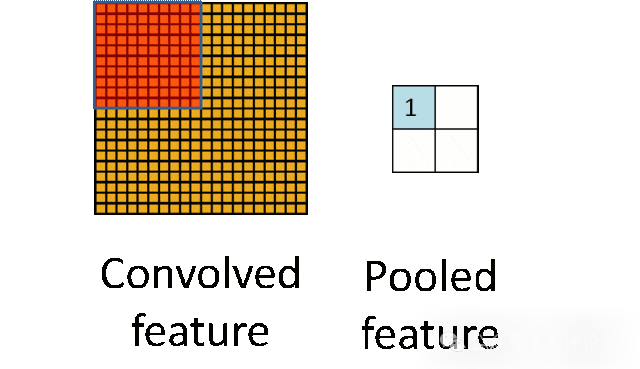

池化层:下采样实现数据降维,大大减少运算量,避免过拟合。

原始是20*20,进行下采样,采样为10*10,从而得到2*2大小的特征图

-

全连接层:经过卷积层和池化层处理过的数据输入到全连接层,得到最终想要的结果。

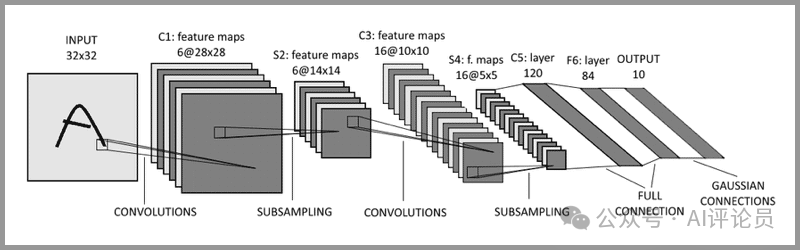

LeNet-5:被誉为卷积神经网络的“Hello World”,是图灵奖获得者Yann LeCun(杨立昆)在1998年提出的CNN算法,用来解决手写识别的问题。

LeNet-5通过引入卷积层、池化层和全连接层等关键组件,构建了一个高效且强大的图像识别网络,为后续卷积神经网络的发展奠定了基础。

-

输入层:INPUT

-

三个卷积层:C1、C3和C5

-

两个池化层:S2和S4

-

一个全连接层:F6

-

输出层:OUTPUT

输入层-卷积层-池化层-卷积层-池化层-卷积层-全连接层-输出层

实际应用

-

图像分类:可以节省大量的人工成本,将图像进行有效的分类,分类的准确率可以达到95%+。典型场景:图像搜索。

-

目标定位:可以在图像中定位目标,并确定目标的位置及大小。典型场景:自动驾驶。

-

目标分割:简单理解就是一个像素级的分类。典型场景:视频裁剪。

-

人脸识别:非常普及的应用,戴口罩都可以识别。典型场景:身份认证。

【为初学者整理】另外我根据自己的入门经历和阅读经验,整理了一份针对机器学习深度学习新手的书单,总共有12本优质书籍!不仅包含了入门前需要掌握的前置知识,还兼顾了python编程语言、深度学习框架、常用第三方库、理论、实战,以及必读的经典论文

如果需要全套书籍的高清电子版和代码

文章中所有的数据和资料,可添加小助手无偿分享~

扫码添加小助手即可无偿获取~

也可以关注“AI技术星球”公众号,关注后回复“221C”获取。

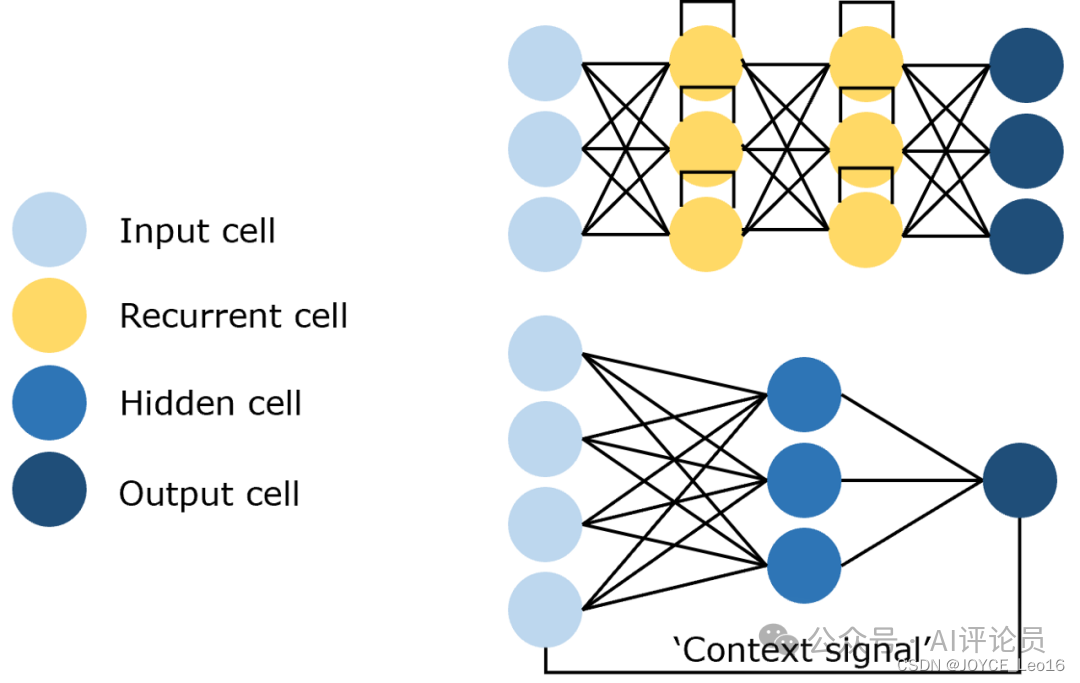

2 循环神经网络(RNN)

是一种专门处理序列数据的神经网络架构,其核心特点是具有记忆能力,能够存储历史信息并影响当前决策。与传统神经网络不同,RNN通过隐藏状态(hidden state)的循环连接,将前一个时间步的输出作为当前时间步的输入,从而实现对序列数据的时序建模。这种结构使RNN能够捕捉数据中的时间依赖性,适用于自然语言处理、语音识别、时间序列预测等任务。典型的RNN变体包括LSTM和GRU

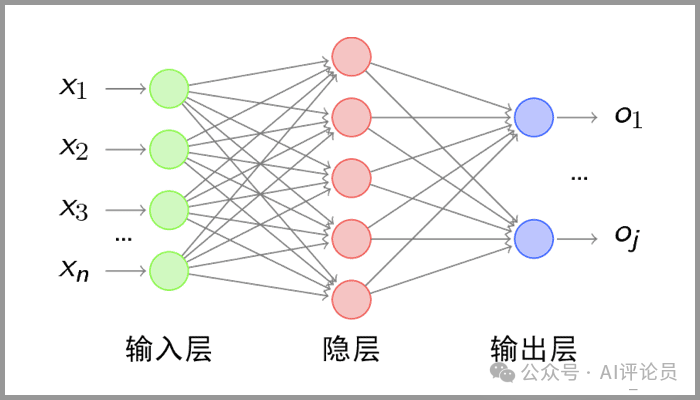

网络结构

-

输入层:接收输入数据,并将其传递给隐藏层。输入不仅仅是静态的,还包含着序列中的历史信息。

-

隐藏层:核心部分,捕捉时序依赖性。隐藏层的输出不仅取决于当前的输入,还取决于前一时刻的隐藏状态。

-

输出层:根据隐藏层的输出生成最终的预测结果。

解决问题

-

序列数据处理:RNN能够处理多个输入对应多个输出的情况,尤其适用于序列数据,如时间序列、语音或文本,其中每个输出与当前的及之前的输入都有关。

-

循环连接:RNN中的循环连接使得网络能够捕捉输入之间的关联性,从而利用先前的输入信息来影响后续的输出。

工作原理

-

输入层:先对句子“what time is it ?”进行分词,然后按照顺序输入。

-

隐藏层:在此过程中,我们注意到前面的所有输入都对后续的输出产生了影响。圆形隐藏层不仅考虑了当前的输入,还综合了之前所有的输入信息,能够利用历史信息来影响未来的输出。

-

输出层:生成最终的预测结果:Asking for the time。

应用场景

(1)处理数据

-

文本数据:处理文本中单词或字符的时序关系,并进行文本的分类或翻译。

-

语音数据:处理语音信号中的时许信息,并将其转换为相应的文本。

-

时间序列数据:处理具有时间序列特征的数据,如股票价格、气候变化等。

-

视频数据:处理视频帧序列,提取视频中的关键特征。

(2)实际应用

-

文本生成:填充给定文本的空格或预测下一个单词。典型场景:对话生成。

-

机器翻译:学习语言之间的转换规则,并自动翻译。典型场景:在线翻译。

-

语音识别:将语音转换成文本。典型场景:语音助手。

-

视频标记:将视频分解为一系列关键帧,并为每个帧生成内容匹配的文本描述。典型场景:生成视频摘要。

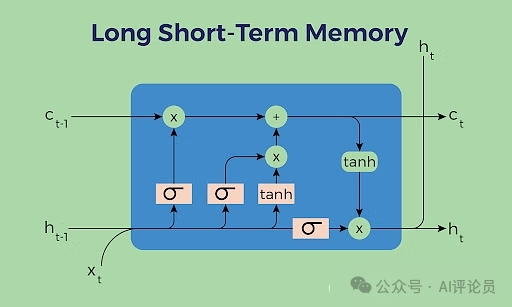

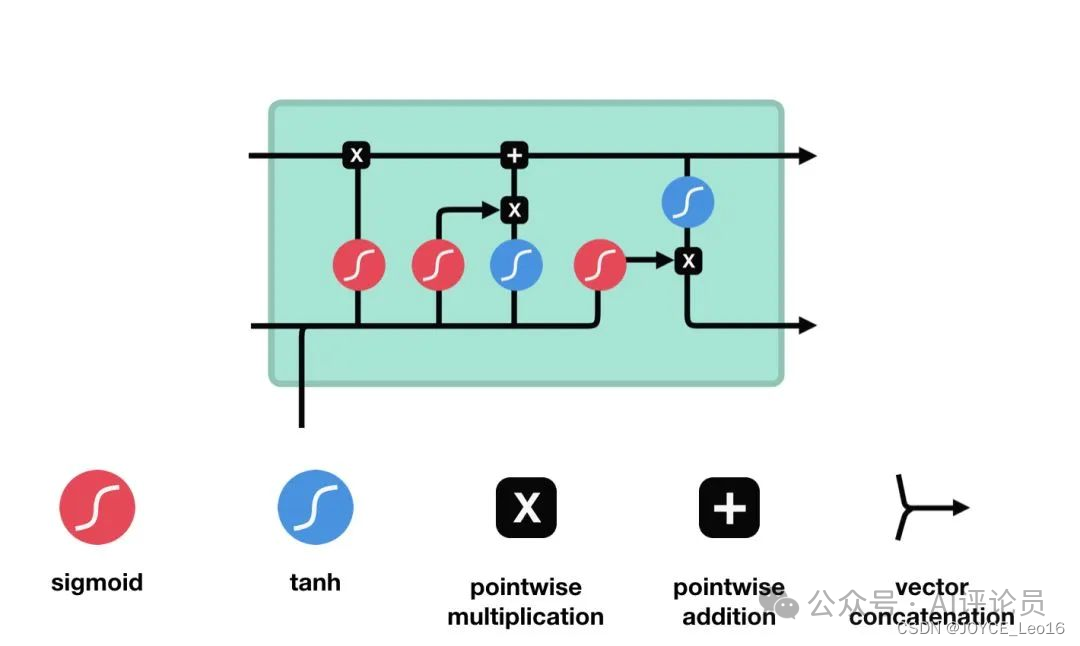

3 长短期记忆网络(LSTM)

一种改进的循环神经网络,通过输入门、遗忘门和输出门控制信息流动,并利用细胞状态保存长期记忆。这种门控机制有效解决了传统RNN的梯度消失问题,使其能够学习长序列中的依赖关系,在机器翻译、语音识别等时序任务中表现优异,显著优于标准RNN

网络结构

-

细胞状态(Cell state):负责保存长期依赖信息。

-

门控结构:每个LSTM单眼包含三个门:输入门、遗忘门和输出门。

-

遗忘门(Forget Gate):决定从细胞状态中丢弃哪些信息。

-

输入门(Input Gate):决定哪些新信息被加入到细胞状态中。

-

输出门(Output Gate):基于细胞状态决定输出的信息。

解决问题

-

短时记忆:RNN难以捕捉和利用序列中的长期依赖关系,从而限制了其在处理复杂任务时的性能。

-

梯度消失/梯度爆炸:在RNN的反向传播过程中,梯度会随着时间步的推移而逐渐消失(变得非常小)或爆炸(变得非常大)。

工作原理

-

输入门:决定哪些新信息应该被添加到记忆单元中

由一个sigmoid激活函数和一个tanh激活函数组成。sigmoid函数决定哪些信息是重要的,而tanh函数则生成新的候选信息。

-

遗忘门:决定哪些旧信息应该从记忆单元中遗忘或移除

遗忘门仅由一个sigmoid激活函数组成

-

输出门:决定记忆单元中的哪些信息应该被输出到当前时间步的隐藏状态中。

输出门同样由一个sigmoid激活函数和一个tanh激活函数组成。sigmoid函数决定哪些信息应该被输出,而tanh函数则处理记忆单元的状态以准备输出。

应用场景

(1)机器翻译

应用描述:

-

LSTM在机器翻译中用于将源语言句子自动翻译成目标语言句子。

关键组件:

-

编码器(Encoder):一个LSTM网络,负责接收源语言句子并将其编码成一个固定长度的上下文向量。

-

解码器(Decoder):另一个LSTM网络,根据上下文向量生成目标语言的翻译句子。

流程:

-

源语言输入:将源语言句子分词并转换为词向量序列。

-

编码:使用编码器LSTM处理源语言词向量序列,输出上下文向量。

-

初始化解码器:将上下文向量作为解码器LSTM的初始隐藏状态。

-

解码:解码器LSTM逐步生成目标语言的词序列,直到生成完整的翻译句子。

-

目标语言输出:将解码器生成的词序列转换为目标语言句子。

优化:

-

通过比较生成的翻译句子与真实目标句子,使用反向传播算法优化LSTM模型的参数,以提高翻译质量。

(2)情感分析

应用描述:

-

LSTM用于对文本进行情感分析,判断其情感倾向(积极、消极或中立)。

关键组件:

-

LSTM网络:接收文本序列并提取情感特征。

-

分类层:根据LSTM提取的特征进行情感分类。

流程:

-

文本预处理:将文本分词、去除停用词等预处理操作。

-

文本表示:将预处理后的文本转换为词向量序列。

-

特征提取:使用LSTM网络处理词向量序列,提取文本中的情感特征。

-

情感分类:将LSTM提取的特征输入到分类层进行分类,得到情感倾向。

-

输出:输出文本的情感倾向(积极、消极或中立)。

优化:

-

通过比较预测的情感倾向与真实标签,使用反向传播算法优化LSTM模型的参数,以提高情感分析的准确性。

4 Transformer

一种革命性的神经网络架构,其核心是自注意力机制。它通过并行计算处理序列数据,利用多头注意力同时关注不同位置的信息,有效捕捉长距离依赖关系。结合位置编码和前馈网络,Transformer实现了对序列数据的多层特征抽取。这种架构不仅解决了RNN的顺序计算瓶颈,还在机器翻译、文本生成等NLP任务中取得突破性进展,成为BERT、GPT等前沿模型的基础框架。

网络结构

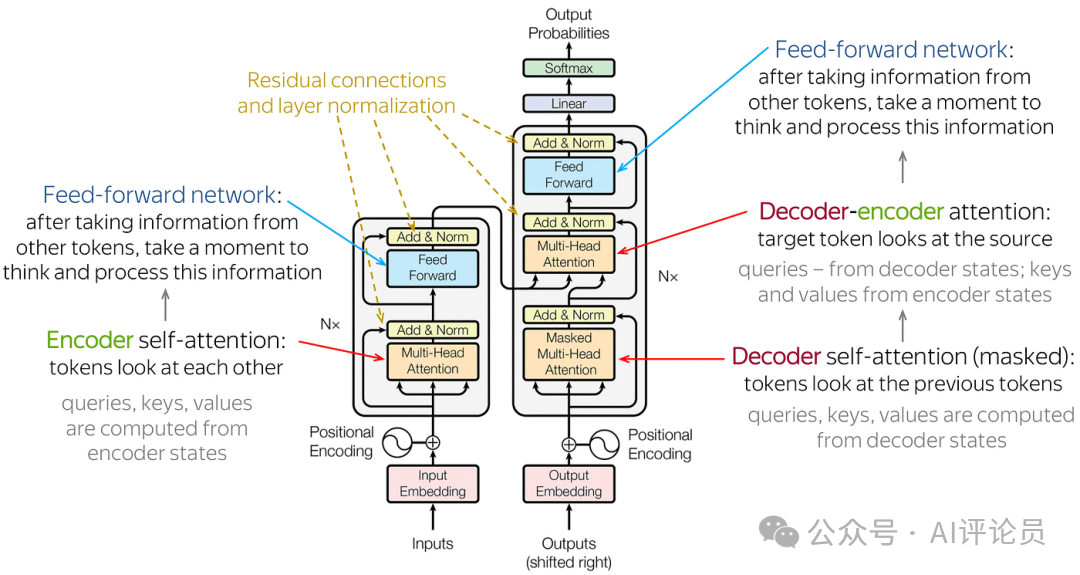

由输入部分输入输出嵌入与位置编码)、多层编码器、多层解码器以及输出部分(输出线性层与Softmax)四大部分组成。

输入部分:

-

源文本嵌入层:将源文本中的词汇数字表示转换为向量表示,捕捉词汇间的关系。

-

位置编码器:为输入序列的每个位置生成位置向量,以便模型能够理解序列中的位置信息。

-

目标文本嵌入层(在解码器中使用):将目标文本中的词汇数字表示转换为向量表示。

编码器部分:

-

由N个编码器层堆叠而成。

-

每个编码器层由两个子层连接结构组成:第一个子层是多头自注意力子层,第二个子层是一个前馈全连接子层。每个子层后都接有一个规范化层和一个残差连接。

解码器部分:

-

由N个解码器层堆叠而成。

-

每个解码器层由三个子层连接结构组成:第一个子层是一个带掩码的多头自注意力子层,第二个子层是一个多头自注意力子层(编码器到解码器),第三个子层是一个前馈全连接子层。每个子层后都接有一个规范化层和一个残差连接。

输出部分:

-

线性层:将解码器输出的向量转换为最终的输出维度。

-

Softmax层:将线性层的输出转换为概率分布,以便进行最终的预测。

解决问题

-

长期依赖问题:在处理长序列输入时,传统的循环神经网络(RNN)会面临长期依赖问题,即难以捕捉序列中的远距离依赖关系。Transformer模型通过自注意力机制,能够在不同位置对序列中的每个元素赋予不同的重要性,从而有效地捕捉长距离依赖关系。

-

并行计算问题:传统的RNN模型在计算时需要按照序列的顺序依次进行,无法实现并行计算,导致计算效率较低。而Transformer模型采用了编码器-解码器结构,允许模型在输入序列上进行编码,然后在输出序列上进行解码,从而实现了并行计算,大大提高了模型训练的速度。

-

特征抽取问题:Transformer模型通过自注意力机制和多层神经网络结构,能够有效地从输入序列中抽取丰富的特征信息,为后续的任务提供更好的支持。

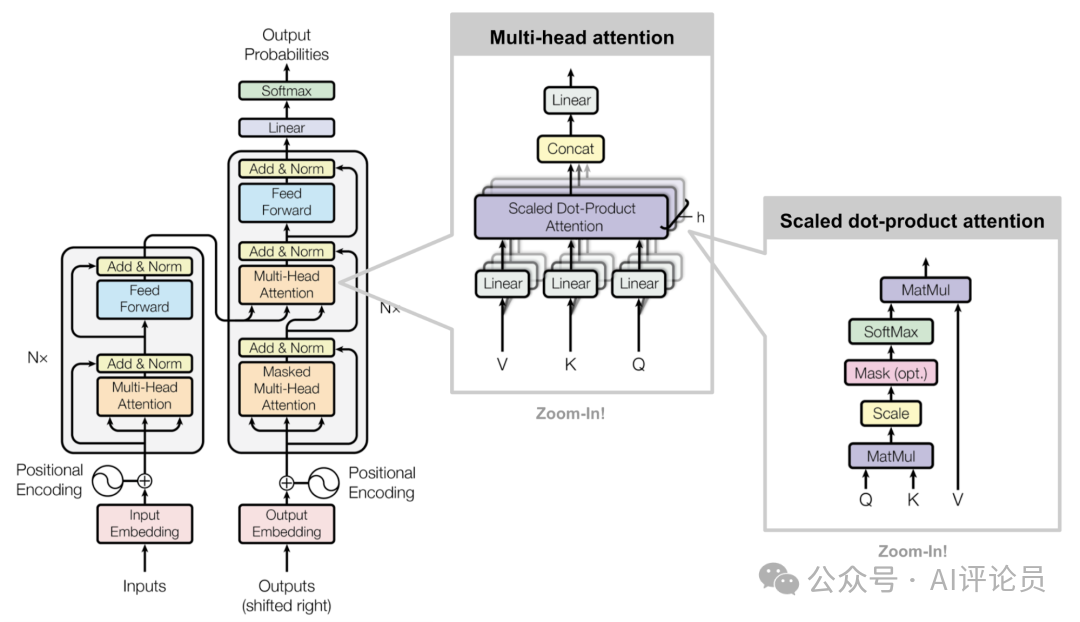

工作原理

-

输入线性变换:对于输入的Query(查询)、Key(键)和Value(值)向量,首先通过线性变换将它们映射到不同的子空间。这些线性变换的参数是模型需要学习的。

-

分割多头:经过线性变换后,Query、Key和Value向量被分割成多个头。每个头都会独立地进行注意力计算。

-

缩放点积注意力:在每个头内部,使用缩放点积注意力来计算Query和Key之间的注意力分数。这个分数决定了在生成输出时,模型应该关注Value向量的部分。

-

注意力权重应用:将计算出的注意力权重应用于Value向量,得到加权的中间输出。这个过程可以理解为根据注意力权重对输入信息进行筛选和聚焦。

-

拼接和线性变换:将所有头的加权输出拼接在一起,然后通过一个线性变换得到最终的Multi-Head Attention输出。

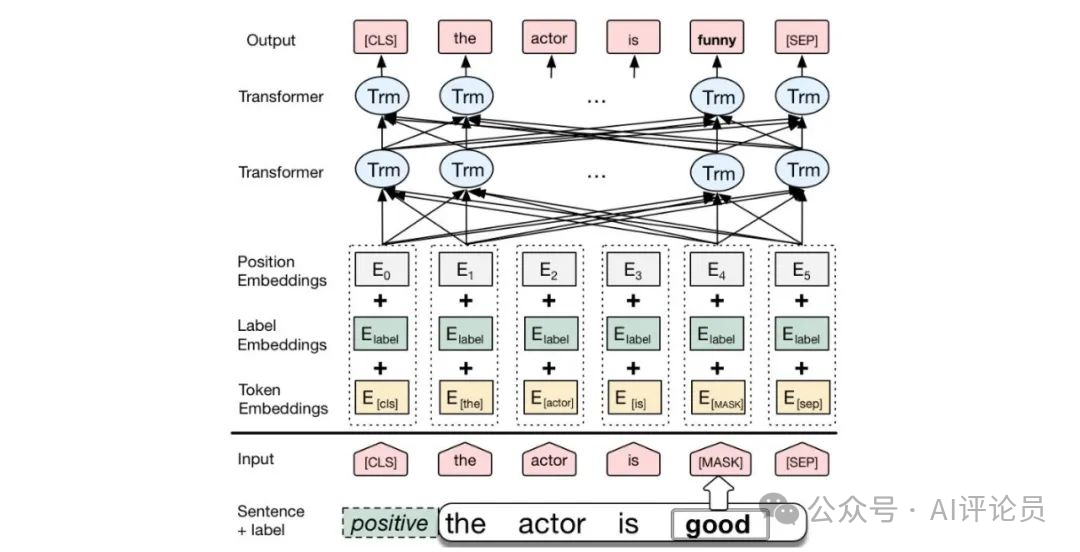

BERT

BERT是一种基于Transformer的预训练语言模型,它的最大创新之处在于引入了双向Transformer编码器,这使得模型可以同时考虑输入序列的前后上下文信息。

1. 输入层(Embedding):

-

Token Embeddings:将单词或子词转换为固定维度的向量。

-

Segment Embeddings:用于区分句子对中的不同句子。

-

Position Embeddings:由于Transformer模型本身不具备处理序列顺序的能力,所以需要加入位置嵌入来提供序列中单词的位置信息。

2. 编码层(Transformer Encoder):

-

BERT模型使用双向Transformer编码器进行编码。

3. 输出层(Pre-trained Task-specific Layers):

-

MLM输出层:用于预测被掩码(masked)的单词。在训练阶段,模型会随机遮盖输入序列中的部分单词,并尝试根据上下文预测这些单词。

-

NSP输出层:用于判断两个句子是否为连续的句子对。在训练阶段,模型会接收成对的句子作为输入,并尝试预测第二个句子是否是第一个句子的后续句子。

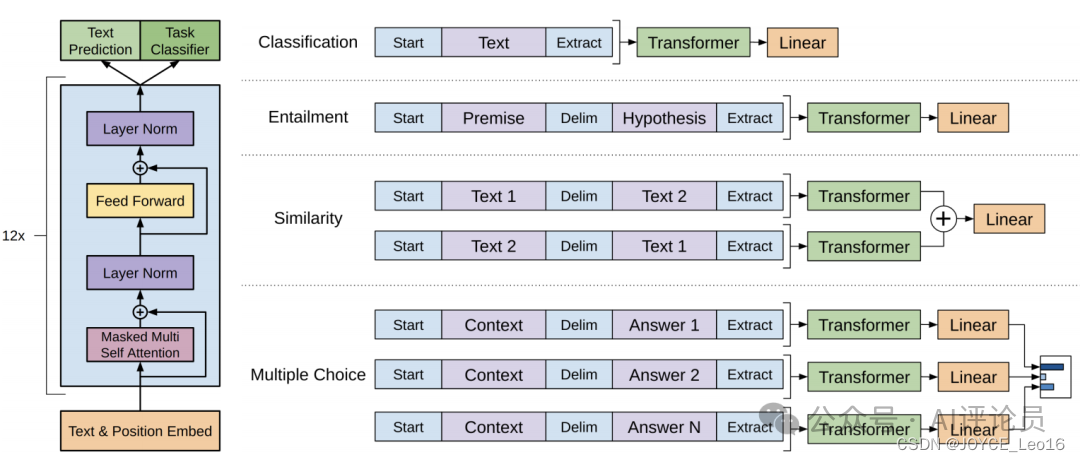

GPT

GPT也是一种基于Transformer的预训练语言模型,它的最大创新之处在于使用了单向Transformer编码器,这使得模型可以更好地捕捉输入序列的上下文信息。

1. 输入层(Input Embedding):

-

将输入的单词或符号转换为固定维度的向量表示。

-

可以包括词嵌入、位置嵌入等,以提供单词的语义信息和位置信息。

2. 编码层(Transformer Encoder):

-

GPT模型使用单向Transformer编码器进行编码和生成。

3. 输出层(Output Linear and Softmax):

-

线性输出层将最后一个Transformer Decoder Block的输出转换为词汇表大小的向量。

-

Softmax函数将输出向量转换为概率分布,以便进行词汇选择或生成下一个单词。

放在最后:

另外想结合AI发文发刊,但不知道怎么做创新的同学,我们team磨练出了一套系统且专业的传统学科交叉AI科研入门方案,可带学生发paper,已迭代五次(持续迭代中),我们会根据你的研究方向来规划学习路径,并且根据你的实验数据分为了时序、图结构、影像三大实验室

文章中所有的数据和资料,可添加小助手无偿分享~

扫码添加小助手即可无偿获取~

也可以关注“AI技术星球”公众号,关注后回复“221C”获取。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)