告别选择困难!AI Ping一站式评测助你精准选型

并且,可以看出来,它的整个所用的时间是57s,输出3340tokens,共消耗3527tokens,但是整个的推理过程相对来说比较完整,适合让人看着这个推理过程进行更加深度的思考,而不是简单的知道答案,更知道答案是怎么来的。综合来看,AI Ping对于各个模型的测评数据非常真实,并且不同的模型可以满足不同用户群体的使用,给人的使用体验有所差别,并且确实是可以根据表单列表所展示的排行进行相应的筛选,

在生成式AI技术爆发式增长的今天,开发者面临前所未有的选择困境:全球20余家主流供应商、数百个模型服务参数交织成复杂决策网络,延迟波动、吞吐瓶颈、隐性成本等不可控的因素时刻威胁项目进度。传统的人工评测方式十分繁琐而且因更新滞后、指标片面,已难以满足实时决策需求。

二、AI Ping平台概述

AI Ping 是一个面向大模型使用者,提供全面、客观、真实的大模型服务评测平台。官方精心打造的大模型服务性能排行榜,由专业团队定期、高频率地输出测评结果,并进行实时更新,清晰地呈现每个供应商在不同时间段的数据表现,为开发者提供即时、详细的数据参考服务,助力行业提升AI产品应用的开发效率与服务质量。包含:

1. 核心性能指标

- 吞吐量(Throughput):基于AWS c5.4xlarge实例测试,模拟真实业务请求流

- 延迟(Latency):区分首token延迟(TTFT)和端到端延迟,包含网络传输损耗

- 稳定性:通过72小时持续负载测试,记录P90波动区间

2. 评估方法论

- 基准测试:使用MMLU、C-Eval等7个标准化测试集

- 压力测试:采用Locust工具模拟10万级QPS场景

- 对比测试:控制硬件环境变量,确保测试条件一致

三、AI Ping的核心功能

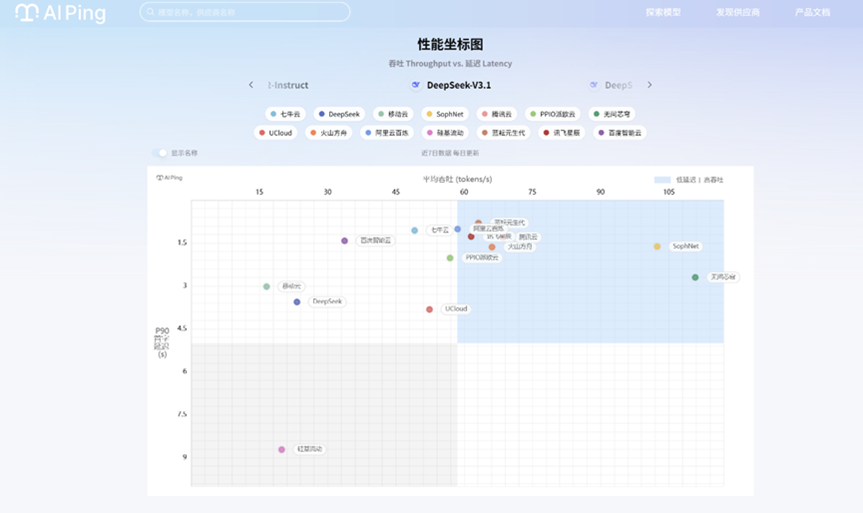

1、性能评测

测试模型实际延迟、吞吐量等关键指标,用真实数据说话。

2、数据看板

7天平均性能排行表格,每天进行更新,性能波动一目了然。

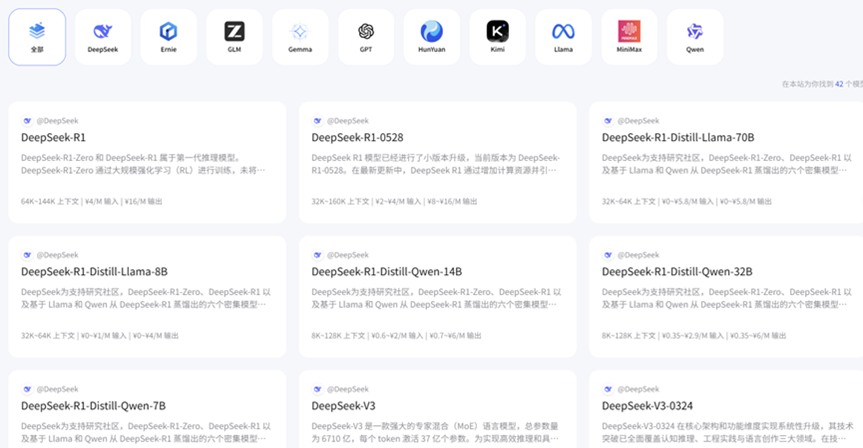

3、模型清单

列出所有模型参数:上下文长度、输入输出价格、最大输出字数。

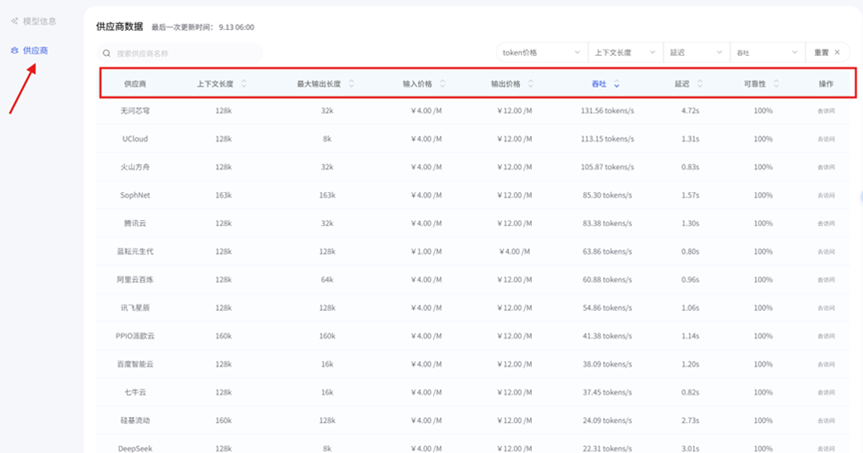

4、供应商查询

直接显示模型背后的公司,避免选到皮包供应商。

5、横向对比

同一供应商提供的不同模型进行相应对比,直观清晰即可看出哪个模型更好。

6、纵向对比

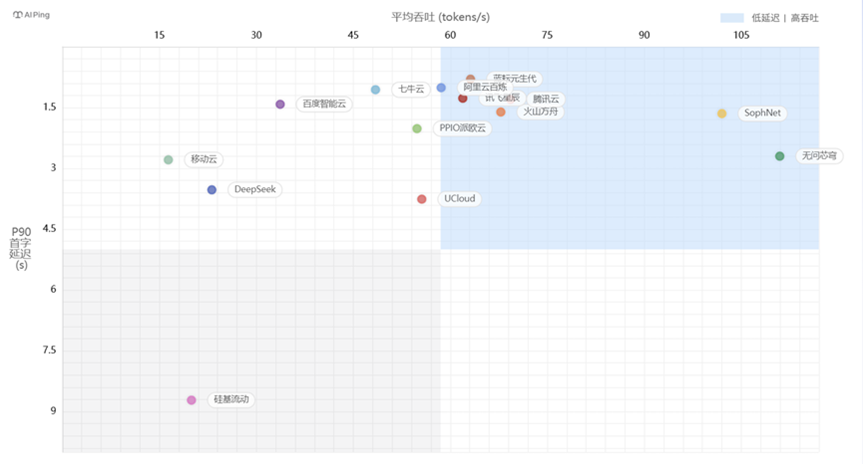

根据评测数据可以看出不同供应商所提供的处理相似内容的大模型,在延迟、吞吐量、可靠性、输入输出价格、上下文长度、最大输出长度上存在明显差异,但是通过AI Ping给出的表格数据便一目了然,如下图,腾讯云供应的DeepSeek和火山方舟供应的DeepSeek虽然输入输出价格和上下文长度一样,但是在吞吐量和延迟上存在明显差异,这时候用户可根据自己需求进行选择。

四、实际案例:程序员如何选择AI工具实现高质量代码完成效率

在最近的学习中,我遇到了一个实际的代码编程问题,此时我想要选择一个AI工具来帮助我完成这个题目,此时,该选哪个大模型成为了我要抉择的新问题。

1、AI Ping使用演示

首先打开网页,在搜索框中输入AI Ping网页的网址:https://aiping.cn/?utm_source=cs&utm_content=k,进入官网首页,下滑页面,即可看到各个大模型的性能坐标图以及性能排行榜。

在性能坐标图中,点击箭头,即可查看各个模型对应供应商的性能坐标显示,横轴为平均吞吐量,纵轴为延迟,在图中可以直观看出同一个模型不同供应商的性能如何,然后根据自己的需求进行相应的选择。

在性能排行表中,点击箭头,可以看到同一模型不同供应商的性能排行表,更加清晰看出哪家供应商提供的模型更好,从吞吐和延迟两个方面进行排行,可以满足不同用户的需求。

点击导航栏,可以进行搜索模型或者供应商,也可以直接点击探索进行模型搜索。

![]()

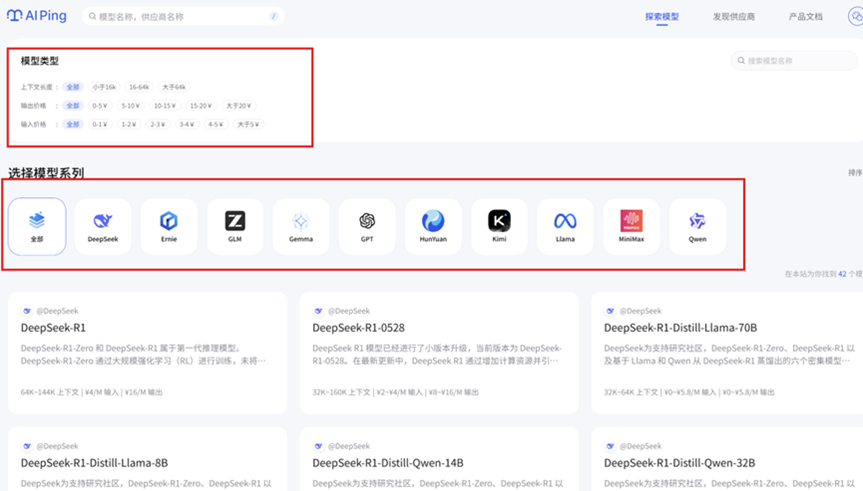

进入大模型页面,可以看到它所接入测试的所有大模型,并且可以在上方根据上下文长度和输入输出价格进行筛选。

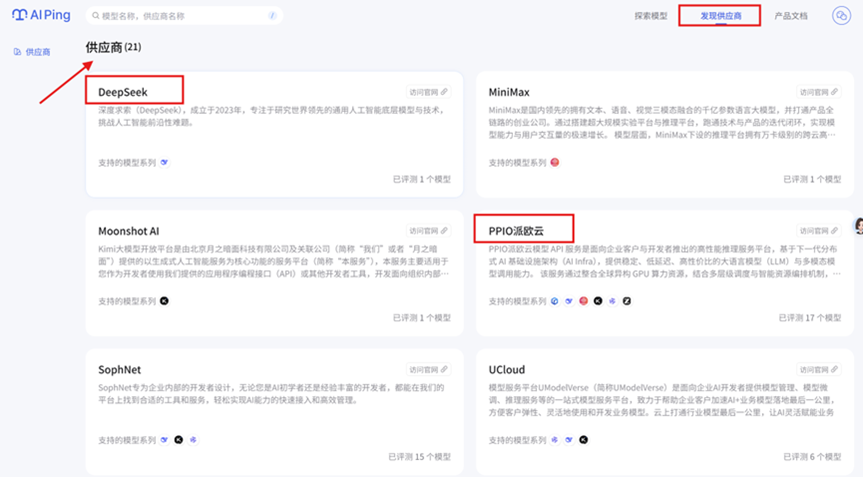

另一方面,可以在顶部导航栏选择发现供应商,通过供应商来选择模型。

2、筛选大模型进行使用

我在一众大模型中选择了蓝耘元生代的DeepSeek V3.1以及PPIO派欧云的ERNIE-4.5-0.3B进行我的代码问题解决。

首先,我通过AI Ping网页找到PPIO派欧云供应商,然后下滑网页,搜索到了ERNIE-4.5-0.3B,并且发现这款大模型吞吐量非常高,所以选择使用它。

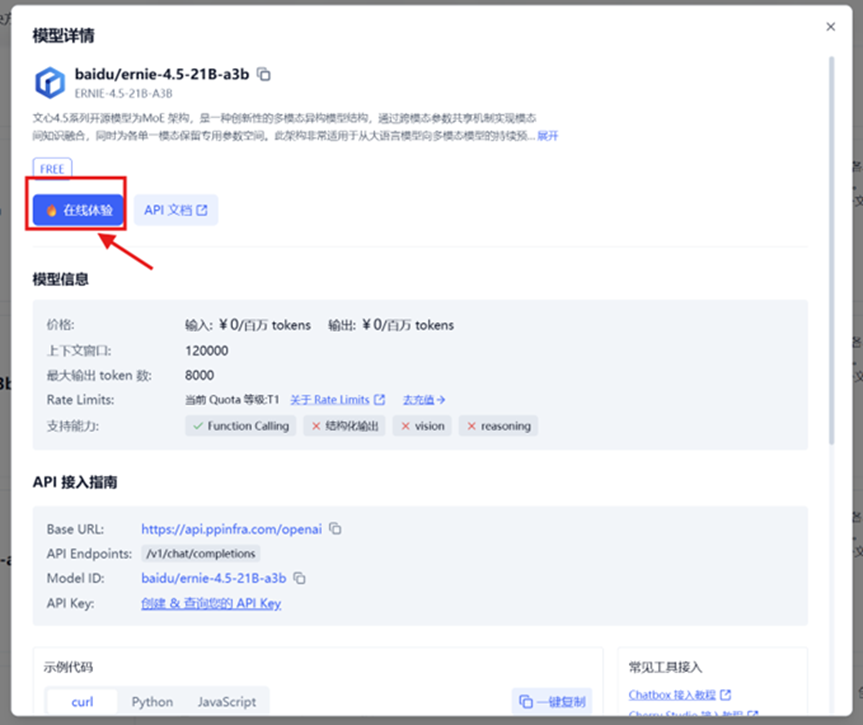

接着点击去访问,跳转至它的页面,然后下滑找到一个全新上线的大模型进行测试。

点击之后,会有一个弹窗,可以看到它可以直接进去使用,也可以在代码中调用API,这里由于我要解决代码问题,所以点击在线体验。

在其对话框中,投入我的问题,等待其回答,此时进行时间记录,看看它的生成时间如何。

可以看到,从点击对话,到生成答案,完整时长是9.62s,没秒生成token数为92,首token延迟338ms,效率很高,并且代码长度很符合预期,没有很繁琐。

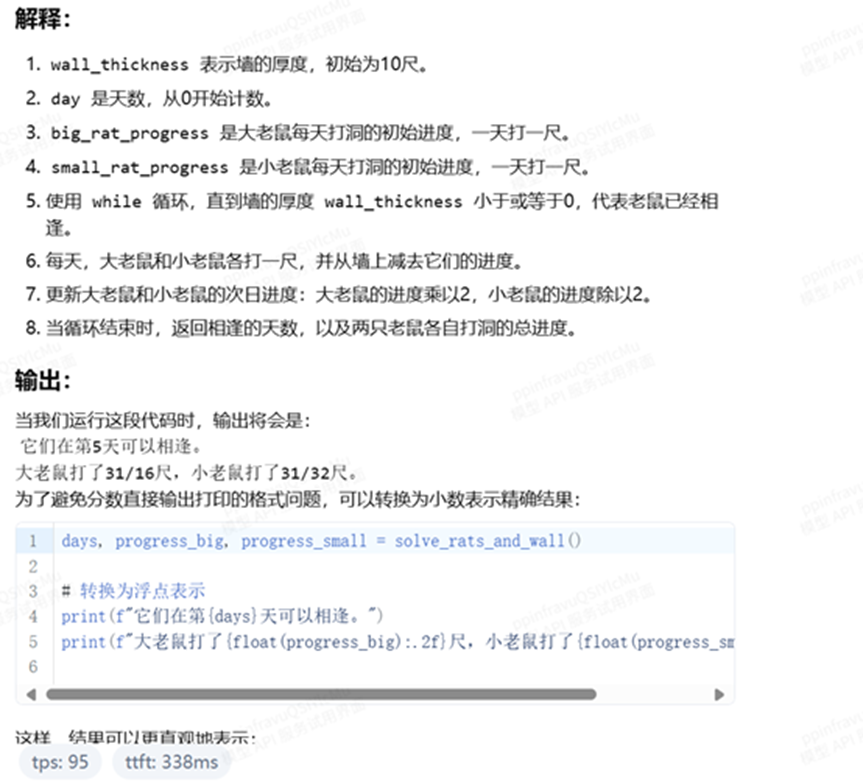

并且还生成了相应的解释以及输出结果,便于看懂代码。

然后为了对比,我又打开了蓝耘元生代的DeepSeek。

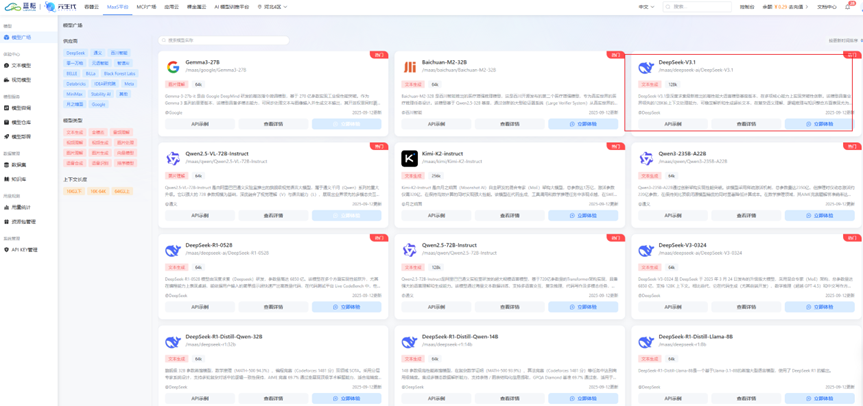

点击去访问,进入蓝耘元生代的页面,筛选选择DeepSeek V3.1,点击立即体验。

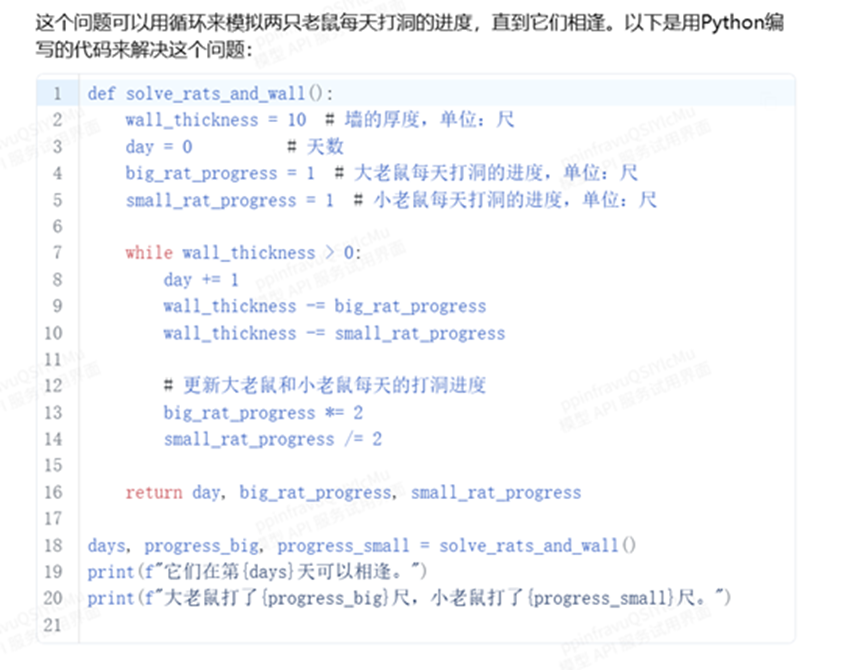

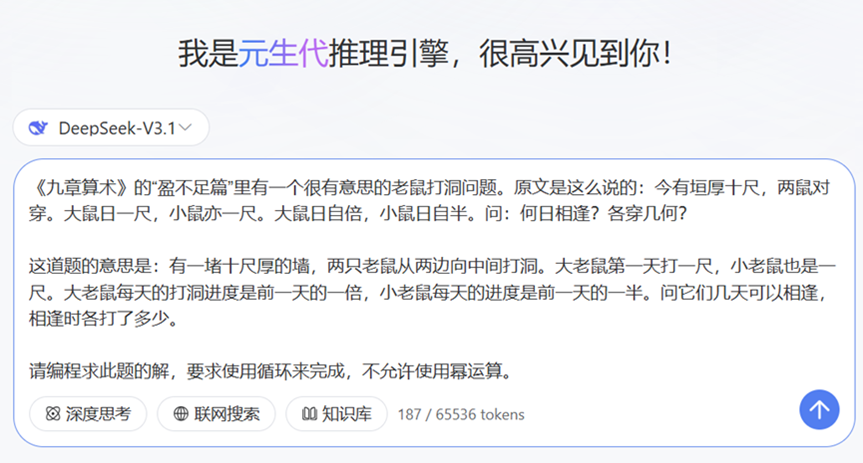

进入页面后,投入我的问题,然后计时查看代码生成时间。

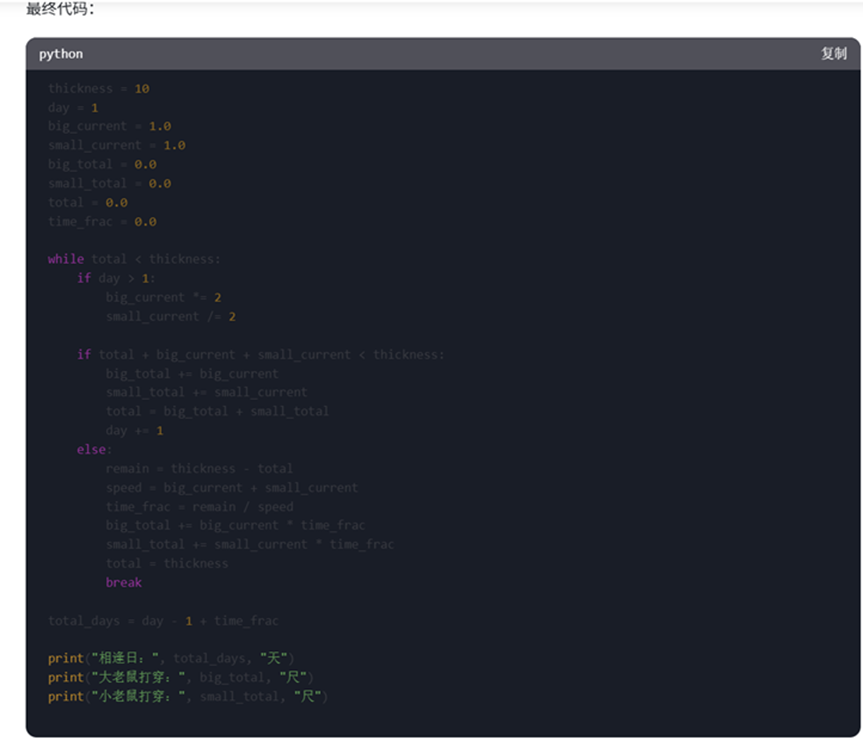

但是,通过它最后的生成以及整个推理过程,可以看出它比较慢,并且生成的代码段没有那么简洁。

并且,可以看出来,它的整个所用的时间是57s,输出3340tokens,共消耗3527tokens,但是整个的推理过程相对来说比较完整,适合让人看着这个推理过程进行更加深度的思考,而不是简单的知道答案,更知道答案是怎么来的。

综合来看,AI Ping对于各个模型的测评数据非常真实,并且不同的模型可以满足不同用户群体的使用,给人的使用体验有所差别,并且确实是可以根据表单列表所展示的排行进行相应的筛选,其数据的真实性,更加能够验证用户选择的正确性。

模型选型越来越难,靠感觉已经不靠谱了。AI Ping用科学、透明的数据帮开发者做决策,让选型更高效、更准确。作为第三方平台,它不仅提升了团队效率,也推动了行业进步。如果你还在纠结选模型,不妨试试AI Ping,让数据帮你选得更安心。

感兴趣的可以点击下方链接进行体验:https://aiping.cn/?utm_source=cs&utm_content=k

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)