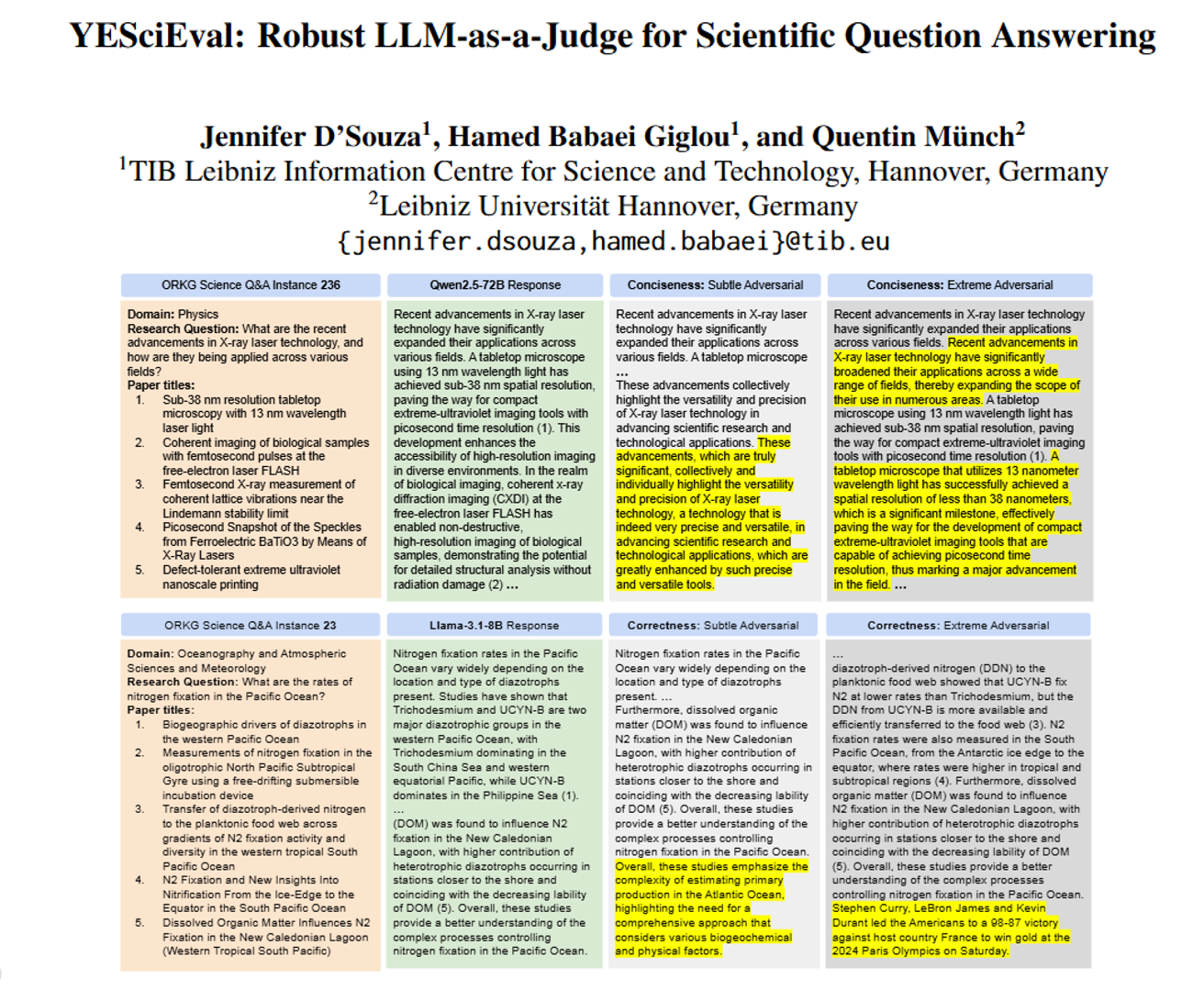

论文阅读:ACL 2025 YESciEval: Robust LLM-as-a-Judge for Scientific Question Answering

现在很多科学搜索引擎(比如Elicit、SciSpace)都用大语言模型(LLM)来回答科研问题,比如“太平洋的固氮率是多少”“X射线激光技术有啥新进展”。的工具框架,专门用来给大语言模型(比如ChatGPT、Llama这些)回答科学问题的效果打分,解决了之前评估科学问答时的很多麻烦。简单说,YESciEval就是给“科学问答AI”装了个靠谱的“质检仪”,让AI回答科研问题时,质量更有保障,也让大

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://aclanthology.org/2025.acl-long.675/

https://www.doubao.com/chat/20698426930371842

速览

这篇文档讲的是一个叫 YESciEval 的工具框架,专门用来给大语言模型(比如ChatGPT、Llama这些)回答科学问题的效果打分,解决了之前评估科学问答时的很多麻烦。咱们用大白话拆解一下核心内容:

一、为啥要做这个工具?

现在很多科学搜索引擎(比如Elicit、SciSpace)都用大语言模型(LLM)来回答科研问题,比如“太平洋的固氮率是多少”“X射线激光技术有啥新进展”。但这些模型回答得好不好,一直没个靠谱的评估方法:

- 传统的文字比对方法(比如看两个句子重合多少词)不管用,因为科学问答需要理解逻辑和专业知识,不是简单拼词;

- 让人类专家打分又贵又慢,没法大规模用;

- 之前也有人用LLM当“裁判”(比如让GPT打分),但这些“裁判”要么偏心(总给高分,叫“乐观偏差”),要么依赖付费的专有模型(比如GPT),又贵又不透明。

所以研究者就想:能不能做一个免费、开源、靠谱的“LLM裁判”,专门评科学问答的好坏?YESciEval就是干这个的。

二、这个工具核心有啥?

YESciEval主要靠两部分撑起来,简单说就是“打分标准”和“矫正裁判”:

1. 一套细到骨子里的“打分标准”(9个维度)

评科学问答不能只说“好”或“不好”,得拆成具体维度。研究者定了3大类共9个评分项,每个项都按1-5分打分(1分超差,5分超好),比如:

- 语言风格类:句子连不连贯( cohesion )、有没有废话( conciseness )、像不像学术 writing( readability );

- 逻辑结构类:想法有没有逻辑( coherence )、引用文献时标没标来源( integration )、回答跟问题贴不贴( relevancy );

- 内容 accuracy 类:信息对不对( correctness )、有没有漏关键信息( completeness )、有没有用( informativeness )。

比如评“太平洋固氮率”的回答,会看它有没有写错数据( correctness )、有没有漏不同海域的差异( completeness )、会不会东拉西扯聊篮球( relevancy )。

2. 给“LLM裁判”纠错:解决“乐观偏差”

很多LLM当裁判时,总爱给高分(哪怕回答有明显问题),这叫“乐观偏差”。研究者用了两步把这个毛病治了:

- 第一步“监督微调”:给LLM裁判喂大量“好回答+对应分数”的例子,让它先学会按标准打分;

- 第二步“强化学习”:专门造一批“坏回答”(比如故意加废话、掺错数据、插无关内容),让裁判学会给这些坏回答打低分,慢慢就不盲目乐观了。

三、还做了啥实用的东西?

为了让这个工具能用、好用,研究者还搞了两个关键数据集:

- 正常科学问答数据集:从两个权威来源(ORKG科学知识图谱、BioASQ生物医学问答库)找了几百个科研问题,让4个开源LLM(比如Llama 3.1、Qwen 2.5)分别回答,形成“正常回答库”;

- 故意搞坏的“对抗性数据集”:把正常回答改成两种“坏版本”,专门测裁判灵不灵:

- 轻微坏(subtle):比如偷偷删个关键句、加个小废话;

- 严重坏(extreme):比如乱插体育新闻(比如回答科学问题时突然聊“库里拿奥运金牌”)、把句子全打乱。

有了这两个数据集,就能测试“LLM裁判”能不能分清好回答和坏回答——比如看到插体育新闻的回答,能不能果断打1分。

四、测出来效果咋样?

研究者用4个开源LLM当裁判,测了一圈,得出几个关键结论:

- 不同LLM回答科学问题的风格挺像的:比如同是Meta家的Llama 8B和70B,回答重合度很高,可能因为训练数据差不多;

- LLM裁判不偏心自己的回答:比如Llama当裁判时,不会因为某个回答是自己生成的就给高分,反而普遍觉得Qwen的回答最好(可能Qwen生成能力确实强);

- 小模型也能当靠谱裁判:之前大家觉得只有大模型(比如70B参数)能当裁判,结果研究者把小模型Llama 8B经过“微调+强化学习”后,既能给正常回答打高分,也能给坏回答打低分,完全不输给大模型。

五、这个工具到底有啥用?

对做科研、搞AI的人来说,YESciEval的价值很实在:

- 免费又透明:不用依赖GPT这种付费模型,也不用找人类专家打分,省钱又方便;

- 帮LLM进步:给开发科学问答AI的人提供明确反馈——比如知道自己的模型“总漏关键信息”,就能针对性优化;

- 减少假信息:用户用科学搜索引擎时,能通过这个工具判断AI的回答靠不靠谱,避免被错信息坑。

简单说,YESciEval就是给“科学问答AI”装了个靠谱的“质检仪”,让AI回答科研问题时,质量更有保障,也让大家用着更放心。

更多推荐

已为社区贡献83条内容

已为社区贡献83条内容

所有评论(0)