战略推理AI Agents:组装LLM+因果推断+SHAP

本篇文章从黑箱到玻璃箱:使用SHAP在混合AI代理上实现可解释AI的实用指南适合希望理解可解释人工智能(XAI)和SHAP的读者。文章的亮点在于通过具体案例展示了如何将复杂的混合AI代理转变为透明的“玻璃箱”,增强了决策的可解释性。适用场景包括金融风险评估和业务决策等高风险领域。实际案例中,作者展示了如何使用SHAP解释CausalForestDML模型的输出,使得用户能够理解模型决策背后的因素,从而建立信任。

首先:

- 项目地址: GitHub

文章目录

在快速发展的 AI 领域,我们经常面临一个关键的悖论:我们的模型越强大,它们往往就越不透明。

这个**“黑箱”**问题是 AI 在高风险、任务关键型领域部署的最大障碍之一。

如果你无法信任 AI 做出决策的_原因_,你真的能信任决策本身吗?

本文是一份实用的、代码优先的指南,旨在解决这个问题。我们将从我称之为奇美拉项目(Project Chimera)的复杂混合 AI 智能体中,系统地将其从黑箱转变为透明的“玻璃箱”。

- 什么是混合神经-符号-因果智能体。

- 为什么**可解释性(XAI)**对此类智能体至关重要。

- 什么是 SHAP 及其工作原理,简单解释。

- 一个逐步的 Python 教程,用于在复杂因果模型上实现 SHAP。

1 案例研究 — 什么是奇美拉项目?

在我们深入解决方案之前,让我们先了解一下我们试图解释的系统。

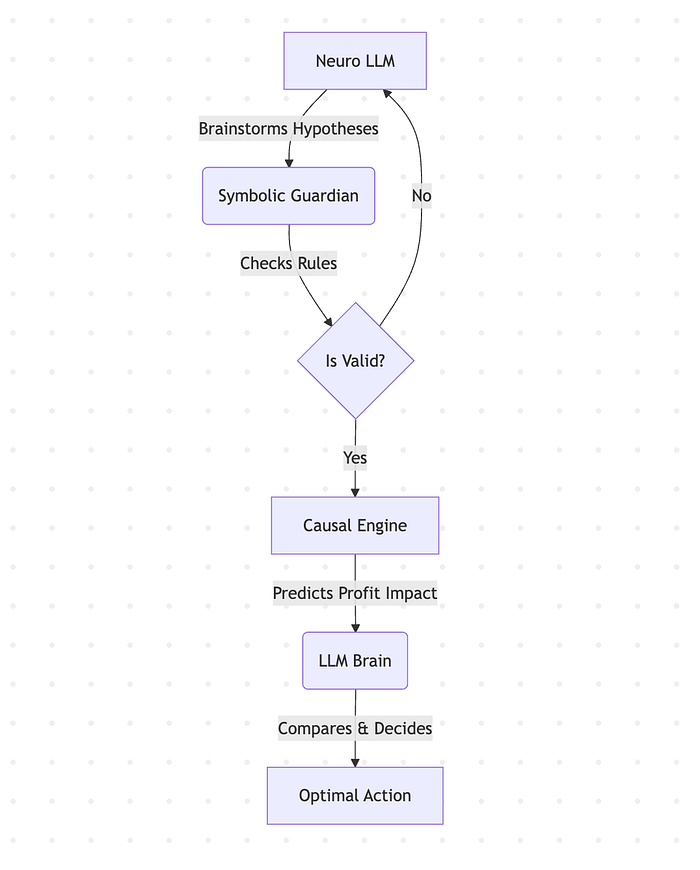

奇美拉项目不是一个标准的 LLM(大型语言模型)。

它是一个基于混合架构构建的自主智能体,旨在克服 LLM 在战略业务环境中的常见弱点。

它建立在三个支柱之上:

- 神经(GPT-4o): 作为创造性核心,理解自然语言目标并生成多样化的战略假设。

- 符号(自定义规则引擎): 充当“守护者”,确保每个提议的行动都符合一组预定义的不可变业务规则(例如,“每周广告支出增幅不得超过 1000 美元”)。这保证了安全性。

- 因果(EconML 的 CausalForestDML): 这是战略大脑。它评估每个有效假设的_长期因果影响_,使智能体能够选择最大化复杂价值函数(而不仅仅是即时利润)的行动。

这种架构功能强大,但也带来了新问题。因果引擎会输出一个决定性的数字——“长期价值分数”——但没有给出理由。它有效,但不可解释。

观看奇美拉的实际操作:

奇美拉实时演示

有关奇美拉项目的更多信息,你可以查看这些资源:

GitHub

该项目的最新更新:

- 多假设推理:该智能体在做出基于数据的推荐之前,会积极进行头脑风暴并评估多种策略。

- 从经验中动态学习:该智能体的因果引擎(CausalEngineV6)会定期根据自身性能数据重新训练,使其能够适应并改进。

- 先进的可解释人工智能套件:超越 “黑箱” 预测,具备以下功能:

- 逐个决策可解释性:一个基于SHAP的面板,展示推动每个特定决策的因素。

- 交互式 “假设分析” 模拟器:一种通过改变市场条件并实时观察其预测如何变化来探究智能体思维的工具。

- 先进的经济模拟器:一个复杂的模拟环境,具有价格弹性和收益递减等非线性动态特性。

- 交互式策略实验室:一个功能齐全的Streamlit应用程序(app.py),用于实时交互和分析。

- 自动化基准测试套件:一个强大的研究脚本(benchmark.py),用于严格比较不同的智能体架构。

2 可解释性的需求 — 什么是 SHAP?

可解释人工智能(XAI)是一套工具和框架,帮助我们理解机器学习模型所做的决策。我们为此任务选择的工具是 SHAP (SHapley Additive exPlanations)。

本质上,SHAP 基于合作博弈论中的一个概念,称为Shapley 值。其思想是将模型的预测视为一场“游戏”,将输入特征视为这场游戏中的“玩家”。

SHAP 计算每个“玩家”(特征)对最终结果(预测)的精确贡献。

它回答了这个问题:

“每个特征对将模型的预测推离平均预测的贡献有多大?”

2.1 代码教程 — 将 SHAP 集成到因果引擎中

现在我们开始动手实践。

我们的目标是解释 CausalForestDML 模型的 .effect() 方法的输出。这并非易事,因为它不是一个标准的 .predict() 函数。

2.2 第 1 步 — 挑战与包装函数

SHAP 的解释器期望一个函数,该函数接收一个特征数据集并返回一个预测。然而,我们的 model.effect() 方法期望上下文 (X) 和动作 (T0, T1) 的单独参数。

为了解决这个问题,我们创建了一个**“包装”**函数,作为 SHAP 和我们的模型之间的翻译器。

def explain_decision(self, context: Dict[str, Any], action: Dict[str, Any]) -> Dict[str, Any]:

def prediction_wrapper(data_numpy):

X_context = data_numpy[:, :4]

T1_action = data_numpy[:, 4:]

T0_noop = np.zeros_like(T1_action)

return self.model.effect(X_context, T0=T0_noop, T1=T1_action)

2.3 第 2 步 — 提供背景数据

SHAP 需要一个**“基线”或“背景”**数据集来比较预测。这为它提供了一个参考点。

最佳实践是使用模型训练时所用数据的代表性样本。

background_data_sample = self.initial_train_history.sample(min(100, len(self.initial_train_history)))

feature_names = ["initial_price", "initial_brand_trust", "initial_ad_spend", "season_phase", "price_change", "ad_spend"]

background_data_numpy = background_data_sample[feature_names].values

2.4 第 3 步 — 初始化解释器并获取值

现在我们可以将所有部分组合在一起。我们将翻译函数和背景数据提供给 shap.Explainer。

instance_numpy = pd.DataFrame([instance_data], columns=feature_names).values

explainer = shap.Explainer(prediction_wrapper, background_data_numpy)

shap_values_obj = explainer(instance_numpy)

explanation = {

"features": feature_names,

"shap_values": shap_values_obj.values[0].tolist(),

"base_value": shap_values_obj.base_values[0]

}

return explanation

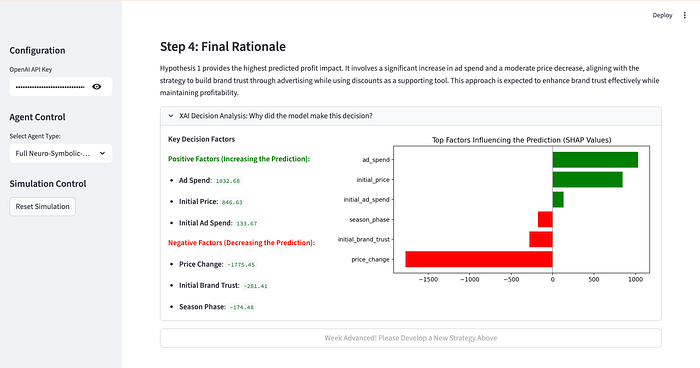

2.5 第 4 部分 — 在 Streamlit 中可视化解释

后端逻辑完成后,在我们的 Streamlit 应用程序中显示结果就变得简单了。我们创建一个扩展器,显示关键的积极和消极因素,并附带一个条形图,以提供清晰的视觉摘要。

if "explanation" in st.session_state.last_decision_info:

with st.expander("XAI Decision Analysis: Why did the model make this decision?", expanded=True):

col1, col2 = st.columns([1, 2])

with col1:

st.markdown("**Key Decision Factors**")

with col2:

st.pyplot(fig)

这会生成一个简洁、直观的面板,即时揭示智能体的推理:

XAI 集成截图

3 结论:玻璃箱的价值

通过集成 SHAP,我们不仅仅是在用户界面中添加了一个图表。

我们从根本上将我们的智能体从一个强大的工具升级为值得信赖的合作伙伴。

我们现在可以:

- 更智能地调试: 当智能体做出令人惊讶的决策时,我们可以立即看到是哪些因素导致了它。

- 建立信任: 利益相关者不再被要求盲目信任一个数字。他们可以看到每个战略选择背后的理由。

- 获得更深入的洞察: 解释通常会揭示我们数据中可能遗漏的微妙关系。

将黑箱变成玻璃箱在 AI 开发中不再是奢侈品;它是一种必需品。

它是将一个仅仅智能的系统与一个真正有用的系统连接起来的桥梁。

要探索奇美拉项目的完整源代码并自行运行该智能体,请访问:

- GitHub 仓库: https://github.com/akarlaraytu/Project-Chimera

- 体验实时演示: https://project-chimera.streamlit.app/

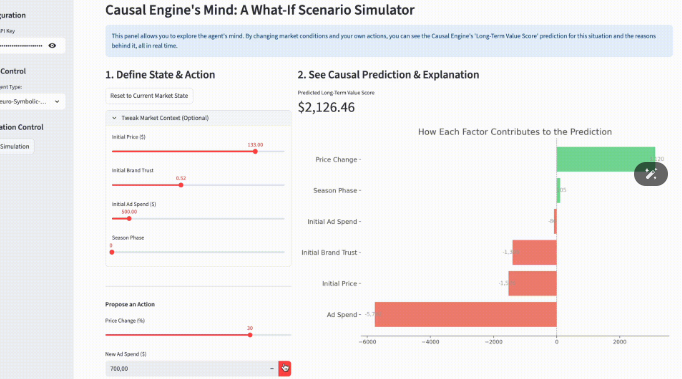

3.1 下一步:从“玻璃箱”到“对话”

我们已经成功构建了一个“玻璃箱”,让我们能够在决策时刻窥视 AI 智能体的“思想”。但查看静态报告是一回事。

如果我们能与智能体的思想互动呢?如果我们能实时挑战它的假设呢?

如果我们能问:“好的,我明白了你的推理。但如果我们的品牌信任度更高,你会预测什么?如果我决定更积极地投入广告支出呢?”

在本系列的下一篇文章中,我们将准确地做到这一点。

我们将把这个可解释性面板转换成一个完全交互式的“假设情景模拟器”——一个战略“作战室”,我们可以在其中测试反事实,探索模型的敏感性,并真正与我们的 AI 合作伙伴协作。

更多推荐

已为社区贡献92条内容

已为社区贡献92条内容

所有评论(0)