大模型RAG技术精讲:查询扩展与多模态GraphRAG页面逻辑方案详解,值得收藏

文章系统梳理了知识图谱增强的查询扩展技术,包括KGQE、CL-KGQE、KAR和QSKG等方法,通过实体链接、关系挖掘和动态图谱构建提升检索效果。同时介绍了MoLoRAG方案,通过页面图构建和多跳推理解决长文档理解中页面逻辑连接缺失问题,结合VLM评分和微调实现精准检索。两类技术均强调控制知识注入粒度、去噪优化和跨语言适配等关键点,为提升大模型检索能力提供了实用方法论。

文章详细介绍了大模型检索增强技术,重点探讨了查询扩展中的知识图谱增强策略,包括KGQE、CL-KGQE、KAR和QSKG等方法。同时介绍了多模态GraphRAG页面逻辑方案MoLoRAG,通过页面图构建和多跳推理解决长文档理解中页面缺乏逻辑连接的问题。文章强调了知识图谱增强查询扩展的关键技术和注意事项,以及MoLoRAG的构图和检索实现方法,为提升大模型检索效果提供了实用指导。

一、检索召回中的查询扩展技术总结:重点看知识图谱增强策略

查询扩展Query Expansion是RAG应用中很广泛的技术点,尤其是以实体中心和长尾查询这类场景。

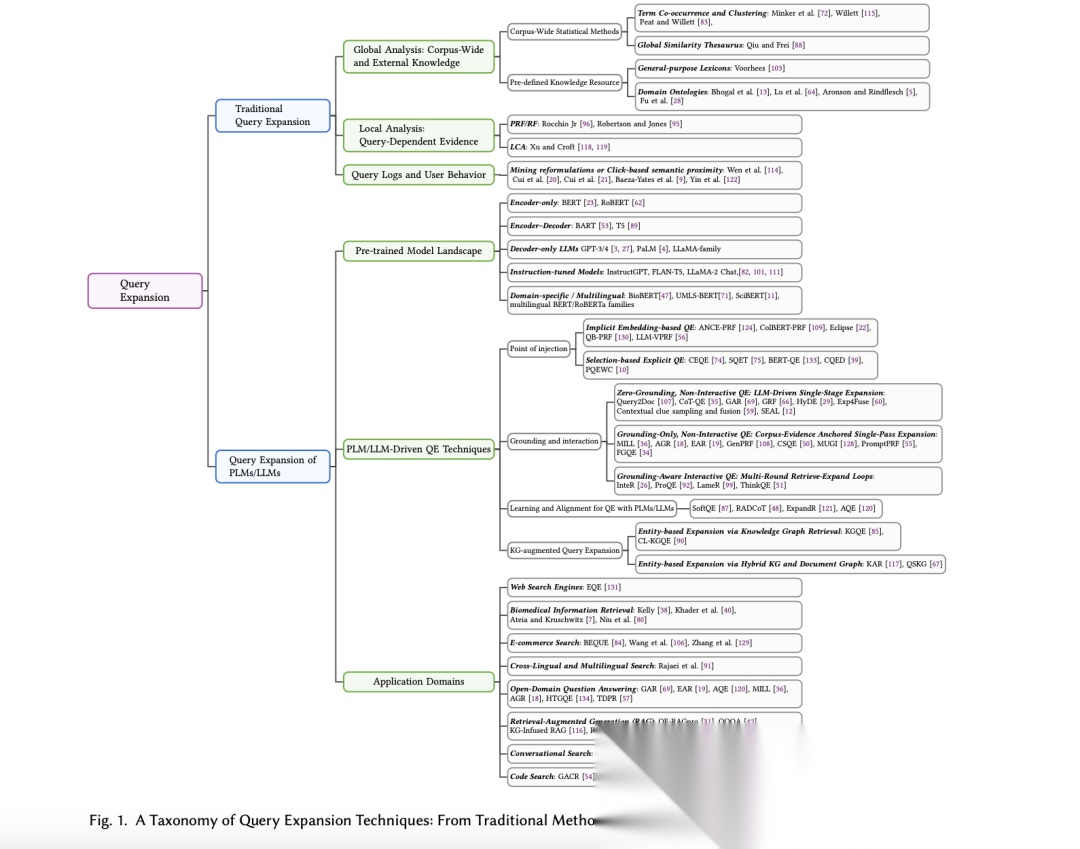

所以,来看一个技术总结,《Query Expansion in the Age of Pre-trained and Large Language Models: A Comprehensive Survey》(https://arxiv.org/pdf/2509.07794),这个工作不错,从传统基于统计/词典的方法(如PRF、本体扩展),到现代基于PLM/LLM的扩展方式,可以看看,这放在RAG当中也是适用的。

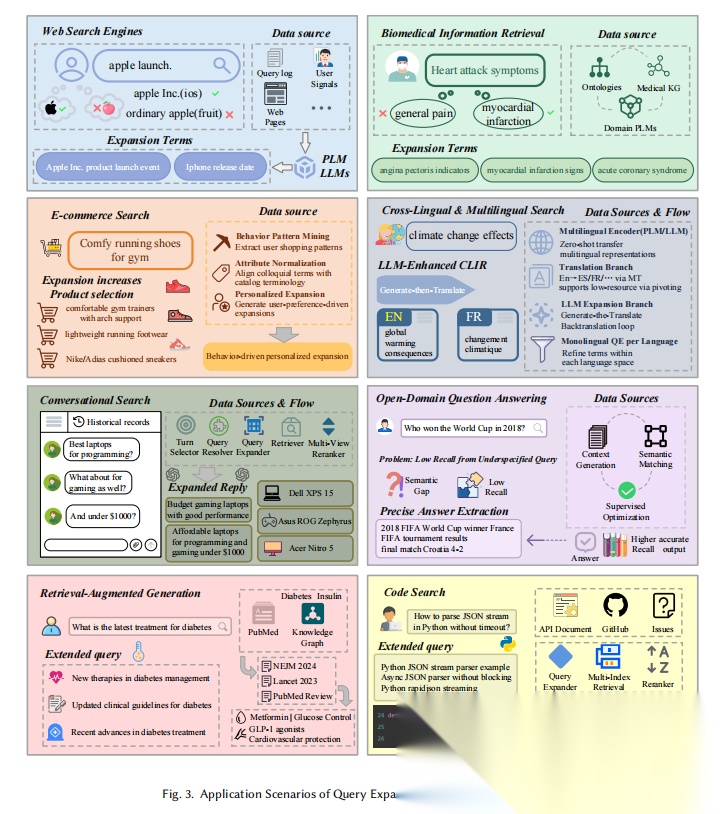

在检索中的query扩展应用场景如下,

是蛮多的。

其中重点看,基于知识图谱的查询增强。

先做个抽象建模,知识图谱G=(V,E,R),其中包含实体节点V、关系类型R和边E⊆V×R×V。

给定一个查询q,设Eq表示从q中提取的实体(通过LLM提取),EL(q)⊆V表示通过命名实体识别和实体链接从q中链接的实体,Nh(v)表示v∈V的h-跳邻域,用text(v)表示一个实体的文本字段(标签、别名或描述),用concat(⋅)表示文本连接。

核心就是这些变量。

其本质,用结构化知识补全查询的语义缺口。通过将查询中的关键词与知识图谱中的实体和关系相匹配,从而更准确地理解查询的意图,并生成更相关的扩展查询。

例如:解决实体歧义(通过注入实体类型/属性,明确查询意图,如“Apple”→“科技公司”);补充关系信息(挖掘查询中未显式提及的实体关系,如“iPhone”→“iOS”);适配垂直领域(结合领域KG,如医疗领域的UMLS(https://www.nlm.nih.gov/research/umls/index.html),提升专业术语扩展的准确性。

里面提到几个思路,总结一下,包括基于知识图谱检索(Knowledge Graph Retrieval)以及基于混合检索和文档图谱的检索( Hybrid KG and Document Graph)两个大类。

1、基于知识图谱检索的实体扩展(Entity-based Expansion via Knowledge Graph Retrieval)

首先从查询中提取实体,然后检索它们在知识图谱中的邻近节点或关系,以丰富查询表示。

有几种方式:

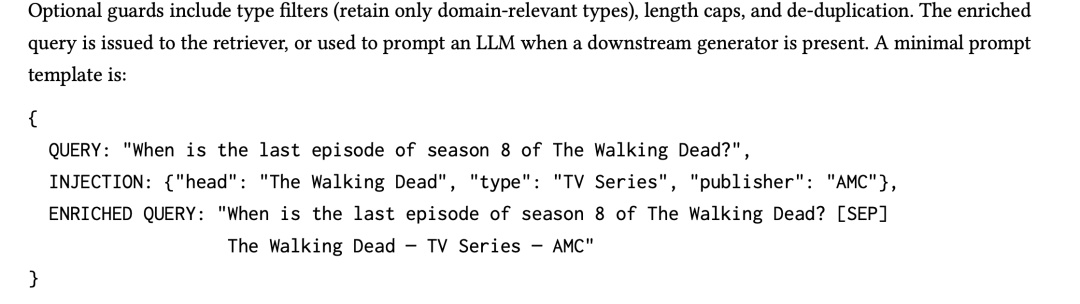

1)KGQE(Knowledge Graph Query Expansion),从查询中提取实体,然后从知识图谱中获取这些实体的相关信息(如标签、类型、描述等),并将这些信息注入到查询中,通过注入具体的实体信息,可以减少查询的歧义。

不过,不是什么都往里塞,可以加一些类型过滤(仅保留领域相关的类型)、长度限制和去重机制,然后送入到prompt中,如下:

上面是直接注入两个一个三元组事实的例子。其实,可以想到,对于歧义性问题,引入“Apple Inc.-Tech Company-Cupertino”,将“Apple”解释为公司而非水果,是有一定约束意义的。

但是,这种比较依赖于图谱自身的丰富性,在小众医学子领域中就不好办了,知识图谱覆盖稀疏时会遇到困难,在这种情况下,所以,需要混合方案,例如,KGQE+BioBERT术语选择。又是一个补丁操作了。

从应用场景上看,其适用于需要精确匹配的场景,如生物医学信息检索。

2)CL-KGQE(Cross-lingual Knowledge Graph Query Expansion),其思路在于,跨语言知识图谱查询扩展。将输入查询从语言翻译或跨语言链接到目标知识图谱中的实体,然后结合查询词的word embedding、知识图谱类别或类型,如DBpedia dct:subject),以及实体词的上下位词或下位词术语来扩展。

这样的好处是,处理不同语言之间的术语差异,提高跨语言检索的召回率,适用于多语言环境下的信息检索。

2、基于混合知识图谱和文档图的实体基础扩展(Entity-based Expansion via Hybrid KG and Document Graph)

这类方法,形式化起来就是,查询中的每个实体e∈Eq,首先链接到一组包含e的相关文档,记为D(e)。然后构建一个文档级图,其中节点对应这些文档,边表示引用、或实体共现等关系,然后,通过选择函数g(⋅)从图节点中获得扩展项,也就是文档图中提取最相关的项,与原始查询连接。

这种方案也有包括两个思路。

1)KAR(KG-guided Retrieval and Generation),

利用结构邻域来进行扩展。在链接Eq后,检索h-跳子图Sq,并将文档与节点/边对齐,从Sq构建关系片段文档三元组,然后提示LLM写一个简短的、以知识为依据的扩展,最终扩展后的查询。

2)QSKG(Query-Specific Knowledge Graph),其思想在于,动态构建一个小型的任务特定知识图谱。

具体的,首先对q进行检索,将这些文档中的实体链接并添加为节点,通过文档内共现或知识图谱链接创建边,迭代扩展形成Gq。

通过在Gq上的简单中心性或TF-IDF分数计算节点显著性(主要用于排序筛选),排序之后,将得分较高的实体和关系转化为简短的扩展,并和查询拼接,最终送llm进行扩展。

其的价值在于,利用语料库特定的词汇和含义,通过基于图的显著性提高多义或多面查询的召回率,同时通过图限制漂移。

但是,知识图谱增强的查询扩展提高了消歧和覆盖能力,但引入了关于范围和控制的选择,图谱一直是这样,引入的过程中要把握粒度,是机会,也是噪声。

所以,也正如文章所言,有一些借鉴的点:

例如,保持注入文本简短(标签、类型和1-2个有区别的事实);

又如,优先选择实体链接置信度和类型过滤以减少漂移,这是去噪的操作,应该如此;

又如,在KAR/QSKG中,限制图半径并使用显著性选择少量超级节点,不然会爆炸。

又如,对于跨语言场景,选择在语言间转移质量较高的的知识图谱类别和词汇网络(wordnet, babelnet等)。

二、多模态GraphRAG做页面逻辑方案-MoLoRAG

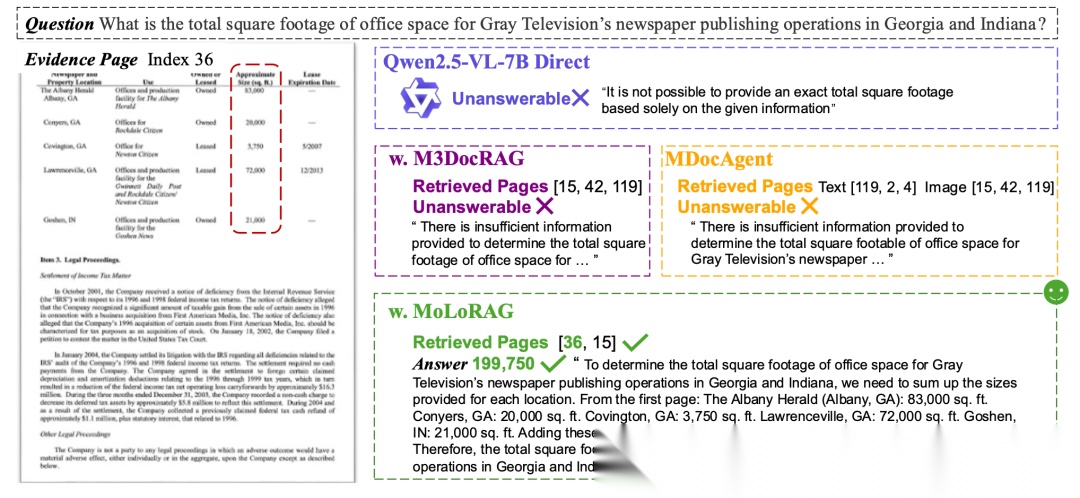

继续来看多模态RAG进展,看一个工作《MoLoRAG: Bootstrapping Document Understanding via Multi-modal Logic-aware Retrieval》(https://arxiv.org/pdf/2509.07666)这个工作,讲的故事是缓解长文档理解中页面之间缺乏逻辑连接的问题,页面之间也可以拉关系。

文中提到两个场景,这个是故事的地点。

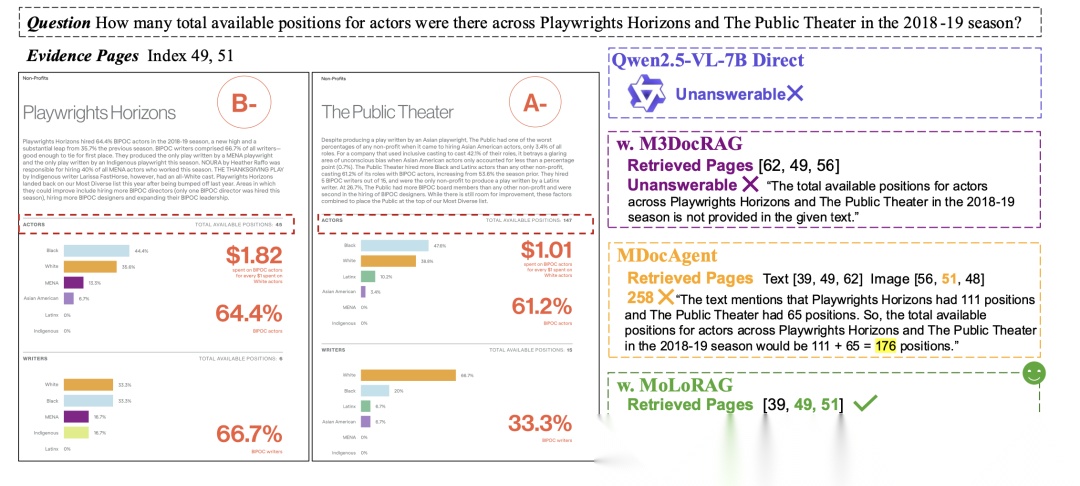

一个是单问题多页面推理,查询 “Gray Television 在乔治亚州和印第安纳州的报纸出版业务总办公面积” 时,LVLM直接推理因输入限制无法回答,M3DocRAG/MDocAgent 检索不到关键页面;MoLoRAG成功检索到第36页,汇总5 个地点的面积(83,000+20,000+3,750+72,000+21,000),得出正确答案199,750平方英尺。

一个是跨页面推理,查询“2018-19 赛季 Playwrights Horizons 和 The Public Theater 的演员总可用职位数” 时,MoLoRAG 检索到第49页(45个职位)和第51页(147 个职位),求和得到192;而MDocAgent仅检索到1个页面,得出错误答案176。

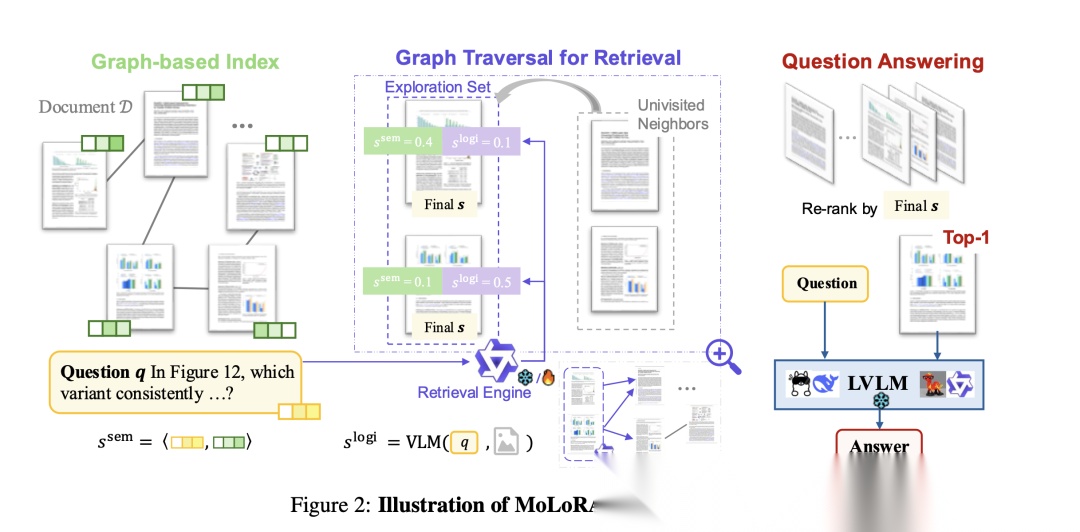

问题就是缺少关联,所以做了page-level的graph化,思路很简单,如下图:

两个阶段。

一个是构图阶段,使用ColPali作为文档编码器,将每个页面转为嵌入表示,然后,以页面为节点(V),当两页面嵌入的内积相似度超过阈值θ时建立边(E),这就是构图结束。

一个是检索阶段。如下图所示:

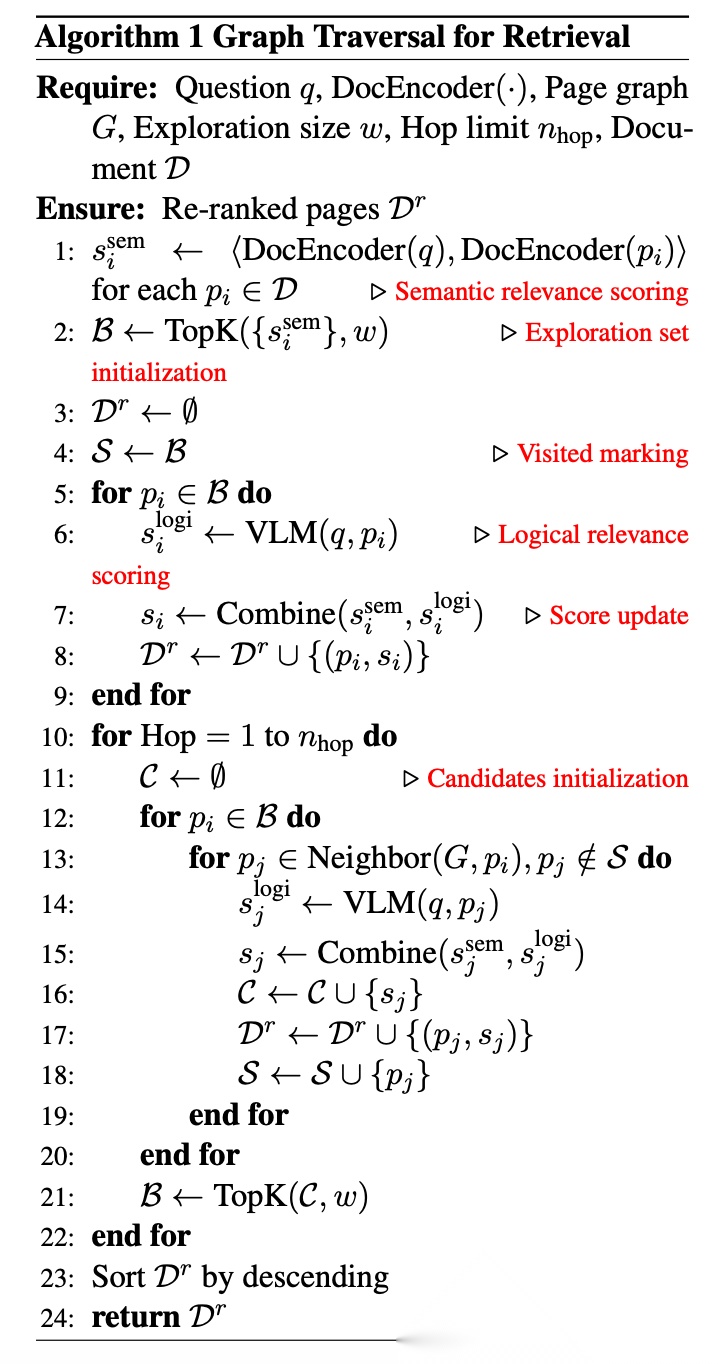

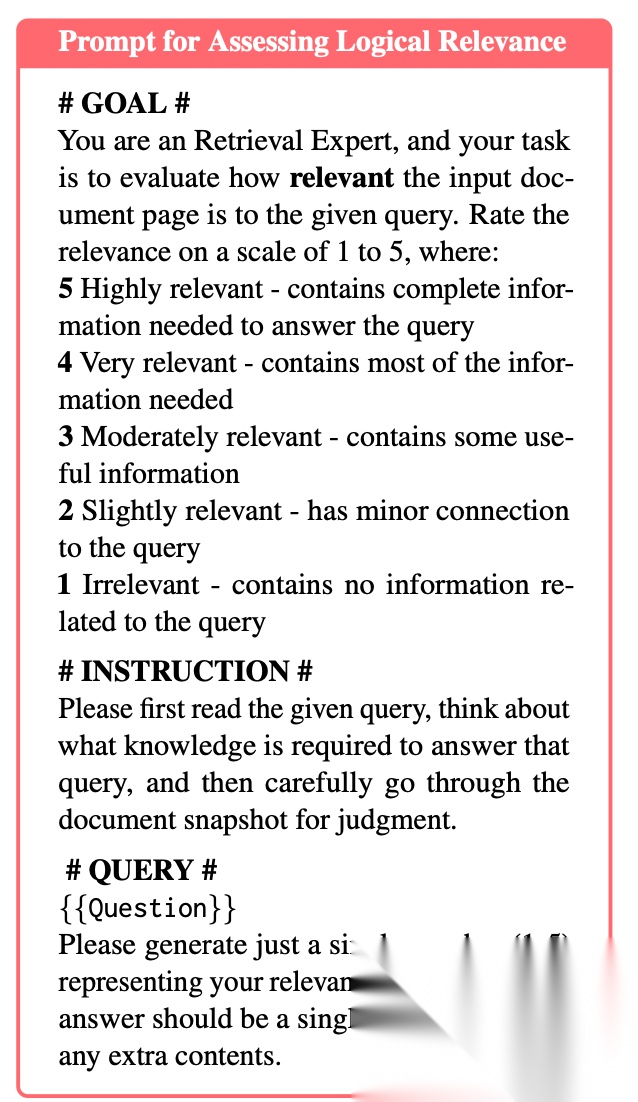

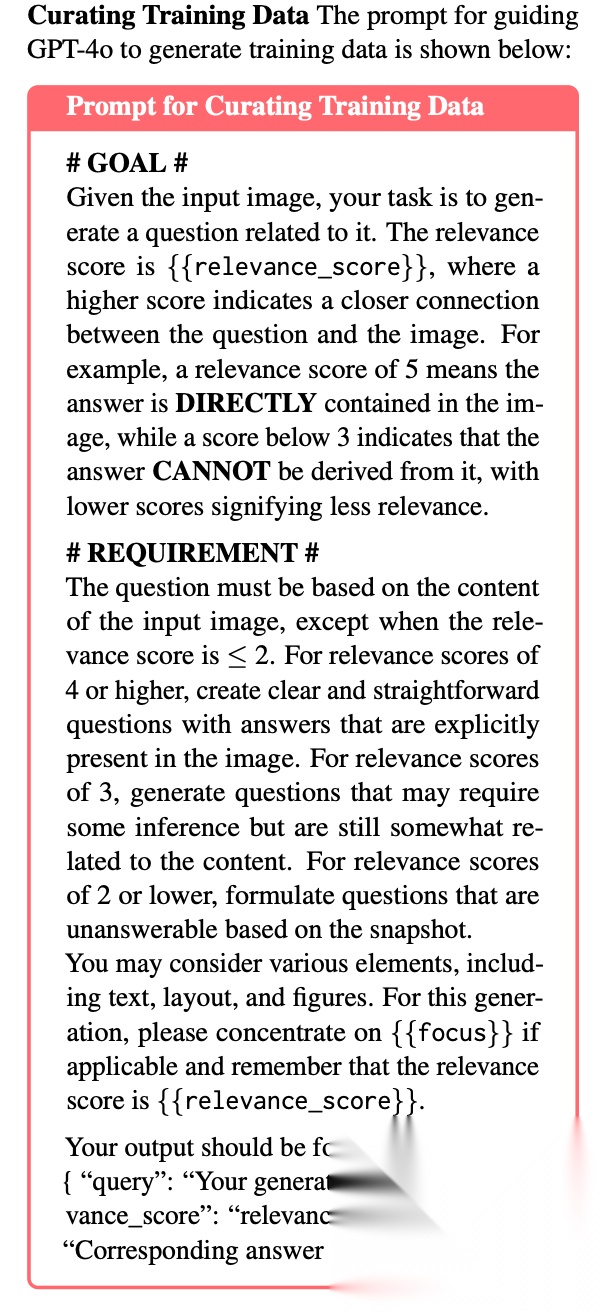

在检索阶段,通过VLM(如Qwen2.5VL-3B)作为检索引擎,在页面图上进行多跳推理,计算问题与各页面的语义相关性得分,这里的步骤是,选取Top-w个页面作为初始结合,然后对于每个页面,VLM通过提示词评估其与问题的逻辑相关性得分(1-5分制),提示词如下:

问题来了,相关性得分计算问题,搞了个微调,为了提升逻辑相关性判断能力, 让GPT-4o生成⟨Question,Image,Relevance_Score⟩三元组(蒸馏大法),仅保留预测得分与目标得分误差≤1 的样本,并经人工验证,最终得到3519个高质量样本,然后基于LoRA微调Qwen2.5VL-3B。

然后通过加权平均等方式融合为最终得分,每次迭代将探索集的未访问邻居作为候选集,重复评分过程,仅保留Top-w个页面更新探索集,直至候选集为空或达到最大跳数,最终按得分重排选取Top-K页面。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献156条内容

已为社区贡献156条内容

所有评论(0)