Meta发布MobileLLM-R1:小参数模型进入高效推理时代,手机端AI迎来新突破

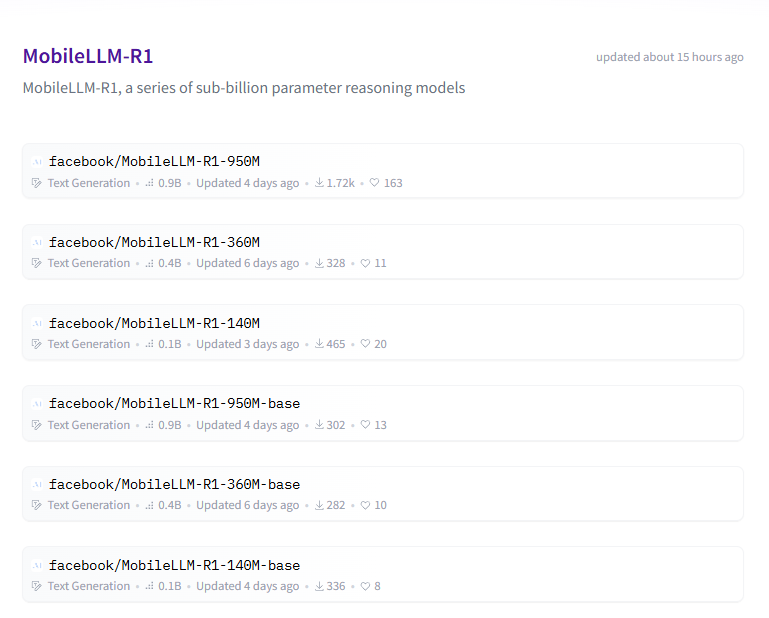

Meta AI团队正式推出MobileLLM-R1系列模型,这是专为高效推理设计的新型小参数语言模型,标志着端侧AI进入新阶段。该系列包含基础模型(140M/360M/950M参数)及其监督微调版本。值得注意的是,这些并非通用聊天模型,而是专门针对数学、编程和科学问题优化的SFT模型。最引人瞩目的是950M模型的表现:仅用不到5T token训练,在MATH、GSM8K等基准测试中性能媲美使用36

Meta发布MobileLLM-R1:小参数模型进入高效推理时代,手机端AI迎来新突破

Meta AI团队正式推出MobileLLM-R1系列模型,这是专为高效推理设计的新型小参数语言模型,标志着端侧AI进入新阶段。

该系列包含基础模型(140M/360M/950M参数)及其监督微调版本。值得注意的是,这些并非通用聊天模型,而是专门针对数学、编程和科学问题优化的SFT模型。

最引人瞩目的是950M模型的表现:仅用不到5T token训练,在MATH、GSM8K等基准测试中性能媲美使用36T token训练的Qwen3 0.6B模型。在数学推理方面,其准确率比Olmo 1.24B高出约五倍,比SmolLM2 1.7B提升两倍,在编程基准测试中更是创下开源模型新纪录。

技术突破核心在于三大架构创新:

- 采用"深而窄"结构:125M模型深度增至30-42层,显著提升抽象概念捕捉能力

- 极致权重共享:嵌入层共享节省20%参数,GQA技术压缩注意力机制

- 相邻块权重共享:创新性地让相邻Transformer模块共享参数,实现深度翻倍而几乎不增加延迟

特别值得关注的是终端设备优化:权重共享设计使125M模型执行时间仅增加2.6%,而非共享方案延迟会增加86%。这种设计真正考虑了手机设备的内存和功耗限制。

Meta同时公开了完整训练方案和数据源,为社区研究提供支持。随着训练成本下降和架构优化,小参数模型正展现出巨大潜力,让高性能AI真正走向终端设备成为可能。

核心亮点

MobileLLM-R1系列的核心突破在于:用架构创新弥补参数规模劣势,实现「小模型、高性能」的终端适配突破。

其核心亮点可概括为三点:

深而窄结构

实验证明,在总参数量不变的情况下,增加层数、减少宽度能显著提升小模型表现。例如125M模型加深至30层甚至42层,效果远超传统12层结构,说明深度对小模型抽象能力至关重要。

嵌入层共享省参不减效

输入/输出嵌入层共享权重,节省约20%参数量,几乎不影响精度,极大提升参数利用效率。

相邻块权重共享:终端推理加速的关键创新

让相邻Transformer块共享同一套参数,存储体积不变而计算深度翻倍。借助SRAM缓存复用,避免了频繁读写DRAM,实测推理延迟仅增2.6%,远超非共享结构的86%延迟增长,真正实现终端设备的高效部署。

整体思路

通过结构优化和权重复用,在严格控制参数和计算预算的前提下,最大化模型有效深度与表达能力,使小模型同样具备强推理能力,且真正适配手机等端侧设备。

模型评估

在预训练模型性能评估方面,该系列中参数规模最大的 MobileLLM-R1-950M 模型,仅使用了约 2T 的高质量 token 进行预训练,总训练 token 数量不到 5T。然而,在 MATH、GSM8K、MMLU 和 LiveCodeBench 等多个权威基准测试中,其性能表现与使用 36T token 训练的 Qwen3-0.6B 模型相当,甚至更优。

与当前其他完全开源模型相比,MobileLLM-R1-950M 在参数规模显著更小的前提下,展现出显著更强的能力。在 MATH 基准测试中,其准确率达到了 Olmo-1.24B 模型的约五倍,同时约为 SmolLM2-1.7B 模型的两倍。此外,在代码生成相关的基准测试中,MobileLLM-R1-950M 的表现也大幅领先于 Olmo-1.24B 和 SmolLM2-1.7B,在完全开源模型中取得了当前最高水平。

社区地址

关于 OpenCSG

OpenCSG 是全球领先的开源大模型社区平台,致力于打造开放、协同、可持续生态,AgenticOps 是人工智能领域的一种AI原生方法论。由OpenCSG(开放传神)提出。AgenticOps是Agentic AI的最佳落地实践也是方法论。核心产品 CSGHub 提供模型、数据集、代码与 AI 应用的一站式托管、协作与共享服务,具备业界领先的模型资产管理能力,支持多角色协同和高效复用。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)